生成式人工智能訓(xùn)練數(shù)據(jù)風險的規(guī)制路徑研究

邢露元,沈心怡,王嘉怡

(1.南京大學 法學院,江蘇 南京 210046;2.倫敦政治經(jīng)濟學院 法學院,英國 倫敦 WC2A 2AE;3.東北農(nóng)業(yè)大學 文理學院,黑龍江 哈爾濱 150030)

1 生成式人工智能中的訓(xùn)練數(shù)據(jù)風險

不同于以往僅能進行分類、預(yù)測或?qū)崿F(xiàn)特定功能的模型,生成式人工智能大模型(Large Generative AI Models,LGAIMs)經(jīng)過訓(xùn)練可生成新的文本、圖像或音頻等內(nèi)容,且具有強大的涌現(xiàn)特性和泛化能力[1]。訓(xùn)練數(shù)據(jù)表示為概率分布,LGAIMs可以實現(xiàn)自行學習訓(xùn)練數(shù)據(jù)中的模式和關(guān)系,可以生成訓(xùn)練數(shù)據(jù)集之外的內(nèi)容[2]。同時,LGAIMs與用戶之間進行人機交互所產(chǎn)生的數(shù)據(jù)還會被用于大模型的迭代訓(xùn)練。LGAIMs的開發(fā)者往往需要使用互聯(lián)網(wǎng)上公開的數(shù)據(jù)以及和用戶的交互數(shù)據(jù)作為訓(xùn)練數(shù)據(jù),而這些數(shù)據(jù)可能存在諸多合規(guī)風險,例如數(shù)據(jù)來源風險、歧視風險和質(zhì)量風險。事實上,數(shù)據(jù)中任何潛在的偏見、侵犯隱私、侵犯知識產(chǎn)權(quán)或其他不公平的情況都會影響到未來無數(shù)可能的模型應(yīng)用。此外,在LGAIMs運行和再訓(xùn)練的過程中,也可能引發(fā)其他的數(shù)據(jù)安全風險,導(dǎo)致個人信息、商業(yè)秘密的泄露或影響國家安全。

1.1 數(shù)據(jù)來源風險

在訓(xùn)練數(shù)據(jù)的創(chuàng)造者不知情、未授權(quán)、未確認或未補償?shù)那闆r下,訓(xùn)練數(shù)據(jù)來源合法性的問題尤為凸顯。具體而言,訓(xùn)練數(shù)據(jù)的采集和使用可能涉及以下風險:一是侵犯知識產(chǎn)權(quán)的風險。若相關(guān)數(shù)據(jù)受知識產(chǎn)權(quán)的保護,收集和使用此類數(shù)據(jù)可能侵犯權(quán)利人的知識產(chǎn)權(quán)。二是侵犯個人信息的風險。若相關(guān)數(shù)據(jù)屬于受保護的個人信息和數(shù)據(jù),同樣可能侵犯信息數(shù)據(jù)主體的相關(guān)權(quán)利。三是侵犯商業(yè)秘密的風險,如非法獲取甚至泄漏商業(yè)秘密。四是獲取數(shù)據(jù)手段可能違法的風險。生成式人工智能數(shù)據(jù)收集和語料庫構(gòu)建高度依賴數(shù)據(jù)爬蟲[3],違法使用爬蟲進行數(shù)據(jù)爬取,可能構(gòu)成不正當競爭或其他侵權(quán)行為,甚至可能違反相關(guān)刑事法律。

1.2 數(shù)據(jù)質(zhì)量風險

數(shù)據(jù)質(zhì)量風險是指訓(xùn)練數(shù)據(jù)不具備準確性、真實性、客觀性、代表性等性質(zhì)的風險,數(shù)據(jù)質(zhì)量風險是機器學習的核心問題。LGAIMs訓(xùn)練使用的大量數(shù)據(jù)都來自互聯(lián)網(wǎng),當不準確不完善的信息作為訓(xùn)練數(shù)據(jù)進入大模型時,會導(dǎo)致輸出不正確的模型預(yù)測。

在數(shù)據(jù)質(zhì)量風險中,生成式人工智能系統(tǒng)受到偏見和歧視影響的風險最為突出,偏見可能為基礎(chǔ)數(shù)據(jù)集所固有,可能為開發(fā)人員所引入,亦可能在運行中產(chǎn)生。在可能產(chǎn)生歧視的情形中,存在訓(xùn)練數(shù)據(jù)具有民族、信仰、國別、地域、性別、年齡、職業(yè)、健康等歧視的風險。人工智能系統(tǒng)提供的結(jié)果將增加、延續(xù)和擴大現(xiàn)有的歧視,對特定群體的基本權(quán)利造成負面影響。

1.3 數(shù)據(jù)泄露風險

在LGAIMs的全生命周期中,數(shù)據(jù)都存在安全風險。模型可能在應(yīng)用時受到網(wǎng)絡(luò)攻擊,攻擊者通過注入中毒或污染數(shù)據(jù)來操縱訓(xùn)練數(shù)據(jù)集,產(chǎn)生數(shù)據(jù)中毒(Data Poisoning)和數(shù)據(jù)泄漏的風險。同時,有研究表明,生成式人工智能較為容易受到反向攻擊(AI Inversion Attcks)的影響[4],攻擊者可通過模型反轉(zhuǎn)獲取和重新識別訓(xùn)練數(shù)據(jù),侵犯數(shù)據(jù)主體的合法權(quán)益。即使沒有直接的攻擊,個人數(shù)據(jù)和商業(yè)秘密也存在因技術(shù)問題而泄露的可能。若用戶使用境外生成式人工智能系統(tǒng),即涉及數(shù)據(jù)出境,未經(jīng)審批許可會存在數(shù)據(jù)合規(guī)及安全隱患。模型訓(xùn)練還可能涉及國家數(shù)據(jù),存在通過危害國家數(shù)據(jù)安全進而影響國家安全的風險[5]。

本文通過與歐盟對訓(xùn)練數(shù)據(jù)合規(guī)風險規(guī)制的具體法規(guī)進行對比研究,對我國法律的完善提出相關(guān)建議。

2 我國相關(guān)法律規(guī)定及評述

2.1 總述

對于生成式人工智能,我國世界領(lǐng)先地出臺了《生成式人工智能服務(wù)管理暫行辦法》(以下簡稱《暫行辦法》)。目前,我國形成了以《暫行辦法》、《個人信息保護法》(以下簡稱《個保法》)、《數(shù)據(jù)安全法》為核心的數(shù)據(jù)合規(guī)體系。

2.2 規(guī)范梳理及評述

2.2.1 針對數(shù)據(jù)來源風險

(1)不得侵犯知識產(chǎn)權(quán)

《暫行辦法》第七條第(二)款僅籠統(tǒng)地規(guī)定了訓(xùn)練數(shù)據(jù)不得侵害知識產(chǎn)權(quán)。實踐中,知識產(chǎn)權(quán)的問題多發(fā)于生成式人工智能研發(fā)者通過文本和數(shù)據(jù)挖掘獲取訓(xùn)練數(shù)據(jù)的過程中。根據(jù)著作權(quán)法第10、49、53條,未經(jīng)權(quán)利人許可,挖掘他人享有著作權(quán)的作品作為訓(xùn)練數(shù)據(jù),可能構(gòu)成對著作權(quán)的侵權(quán)。在過去的司法實踐中,法院對出于商業(yè)目的的文本和數(shù)據(jù)挖掘大多會做出侵權(quán)的判決,即使出于非商業(yè)目的也有被認定為侵權(quán)的可能[6]。這主要涉及文本和數(shù)據(jù)挖掘行為是否構(gòu)成合理使用的認定。《著作權(quán)法》第三次修改完善了合理使用制度,在法定情形后增加了一條兜底條款,為科技和時代發(fā)展下的其他合理使用行為留下了空間。但我國的合理使用制度仍基于法定主義,生成式人工智能挖掘具有知識產(chǎn)權(quán)的內(nèi)容很難構(gòu)成合理使用[7],具有較大的侵權(quán)風險。

生成式人工智能的發(fā)展與國家之間的科技競爭息息相關(guān),未來是否仍以保守地態(tài)度對待生成式人工智能訓(xùn)練數(shù)據(jù)挖掘的行為,值得商榷。

(2)不得侵犯個人信息

生成式人工智能使用個人信息作為訓(xùn)練數(shù)據(jù),應(yīng)當具備合法性基礎(chǔ)并滿足透明性要求,即滿足《個保法》第13條規(guī)定的合法性條件,并履行第17條規(guī)定的告知義務(wù)。知情同意規(guī)則是我國個人信息保護的核心規(guī)則,然而在生成式人工智能收集和處理海量數(shù)據(jù)的背景下,該規(guī)則難以實操,基本被架空[3]。不過,第13條第(六)項及第27條給予了生成式人工智能收集處理已公開個人信息的合法性基礎(chǔ),只要滿足以下三個條件:①在合理范圍內(nèi)處理;②信息主體未明確拒絕;③處理不會對個人權(quán)益產(chǎn)生重大影響,否則應(yīng)取得同意。也就是說,研發(fā)者可以在合理范圍內(nèi)處理爬取的已公開的個人數(shù)據(jù)是默認規(guī)則,推定信息主體同意,同時賦予信息主體拒絕的權(quán)利,即選擇退出機制(Opt-out Mechanism)。該處理規(guī)則體現(xiàn)了公開個人信息權(quán)益保護和個人信息資源利用的協(xié)調(diào)[8],有利于生成式人工智能的發(fā)展。此外,若涉及敏感個人信息,則必須取得個人的單獨同意,還需滿足處理具有特定的目的和充分的必要性,采取嚴格的保護措施,同時履行額外的告知義務(wù),告知處理敏感個人信息的必要性以及對個人權(quán)益的影響。然而,在上述規(guī)范中,是否屬于“合理范圍”、是否“對個人權(quán)益產(chǎn)生重大影響”、是否具有“特定的目的和充分的必要性”的標準并不明確,判斷本身就存在較大的不確定性,由此會導(dǎo)致較大的合規(guī)風險。

《暫行辦法》的第十一條也強調(diào)不得收集非必要的個人信息。然而,由于生成式人工智能需要海量訓(xùn)練數(shù)據(jù),很容易導(dǎo)致個人信息處理目的和用途不明確、收集個人信息超出必要范圍、信息處理期限不明確等問題[3]。例如,關(guān)于處理目的,《個保法》第14條規(guī)定變更處理目的應(yīng)當重新取得個人同意。由于生成式人工智能獲取公開個人信息作為訓(xùn)練數(shù)據(jù),往往與最初個人同意的處理目的不同,如果完全要求處理目的和最初的公開目的相同,對于生成式人工智能應(yīng)用明顯并不合理。因此,應(yīng)當解釋為,個人信息處理與公開時用途具有合理的關(guān)聯(lián)性,且符合個人的合理預(yù)期,則屬于在合理范圍內(nèi)處理[8]。但對于生成式人工智能使用個人信息作為訓(xùn)練數(shù)據(jù),個人信息與模型訓(xùn)練的目的是否具有合理關(guān)聯(lián)性、個人是否真的能夠?qū)€人信息用于人工智能訓(xùn)練存在合理預(yù)期等解釋難題,會使正當、必要原則在生成式人工智能的語境下無法有效發(fā)揮其作用。若寬泛地認為屬于“合理范圍”內(nèi)的處理,可能無法妥善保障信息主體的權(quán)利。

此外,個人信息主體更正權(quán)、刪除權(quán)的行使也存在合規(guī)難題。由于生成式人工智能的“算法黑箱”,很難明確識別單一訓(xùn)練數(shù)據(jù)對整體模型的影響,因此若想對單一個人信息進行更正和刪除,技術(shù)上很難做到完全消除痕跡[7]。

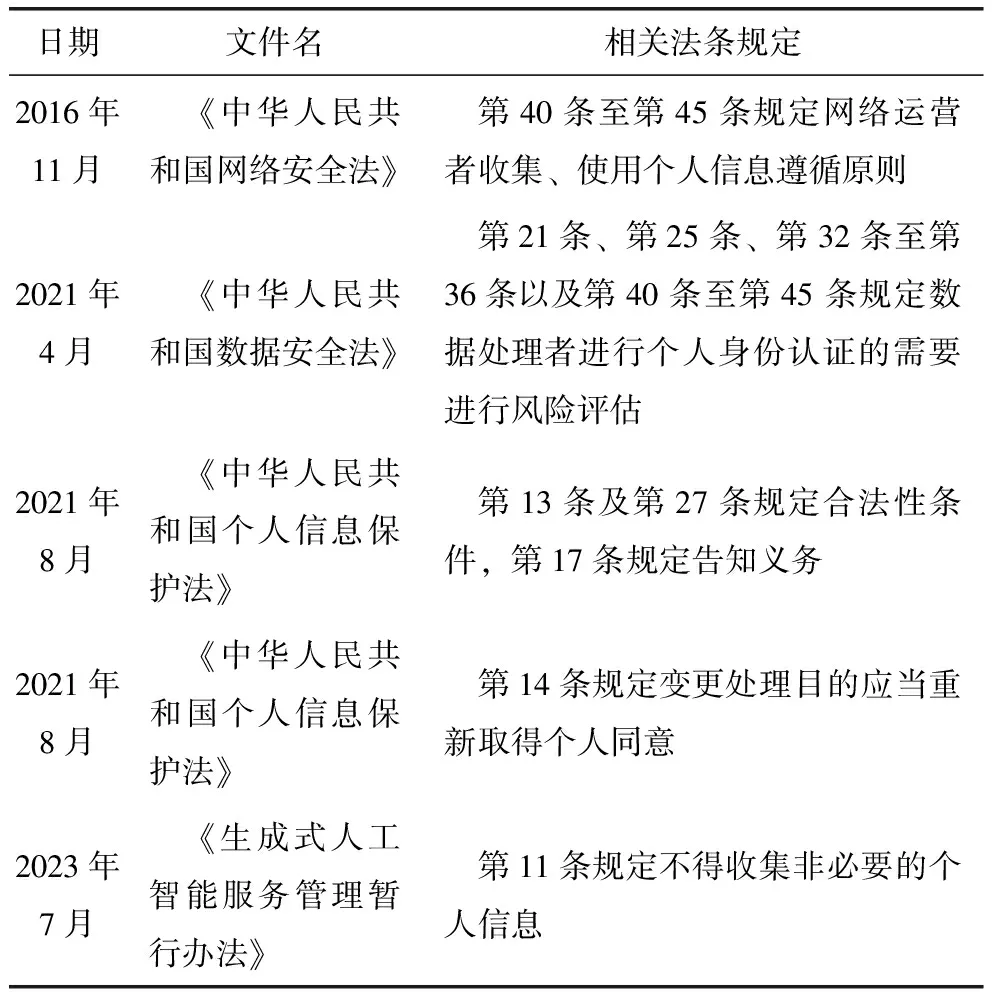

現(xiàn)行法中使用個人信息作為訓(xùn)練數(shù)據(jù)的相關(guān)規(guī)定如表1所示。

表1 現(xiàn)行法中使用個人信息為訓(xùn)練數(shù)據(jù)的相關(guān)規(guī)定

(3)不得侵犯商業(yè)秘密

《暫行辦法》第四條第(三)項規(guī)定了“尊重商業(yè)道德,保守商業(yè)秘密”。生成式人工智能侵犯商業(yè)秘密主要存在兩種可能,一是爬取訓(xùn)練數(shù)據(jù)時侵犯商業(yè)秘密,二是在交互中用戶自行輸入構(gòu)成商業(yè)秘密的信息,該信息被用于模型的迭代訓(xùn)練,并在輸出中泄露商業(yè)秘密。對于前者,以不正當手段“獲取”商業(yè)秘密的行為本身即構(gòu)成侵權(quán),使用商業(yè)秘密作為訓(xùn)練數(shù)據(jù)將造成更加嚴重的后果。對于后者,主要依靠公司采取合理措施保護商業(yè)秘密,如與生成式人工智能提供者、員工、承包商和其他第三方簽訂相關(guān)協(xié)議。

(4)不得違法使用數(shù)據(jù)爬蟲

目前,我國在違法使用爬蟲獲取數(shù)據(jù)的法律責任方面已積累了較多的實務(wù)案例。民事方面,主要集中在反不正當競爭法的適用。爬取競爭對手數(shù)據(jù)屬于“不勞而獲”、擾亂競爭秩序的行為,可能構(gòu)成不正當競爭行為,需要承擔侵權(quán)責任[9]。

違反網(wǎng)站經(jīng)營者設(shè)置的Robots協(xié)議,繞過各類保護措施,接觸、保存甚至披露他人的商業(yè)秘密,可能構(gòu)成對他人商業(yè)秘密的侵權(quán)。另外,如果爬蟲突破了網(wǎng)站經(jīng)營者設(shè)置的保護措施,爬取具有知識產(chǎn)權(quán)的作品和用戶個人信息,則可能構(gòu)成對著作權(quán)和個人信息權(quán)益的侵權(quán)。

刑事方面,根據(jù)使用爬蟲的行為和結(jié)果適用不同的刑法罪名。爬蟲沒有授權(quán)、超越授權(quán)進入特定計算機信息系統(tǒng),可能構(gòu)成非法侵入計算機信息系統(tǒng)罪。爬蟲抓取不同數(shù)據(jù)可構(gòu)成不同的犯罪,如抓取個人信息,可能構(gòu)成侵犯公民個人信息罪;如抓取具有創(chuàng)造性的數(shù)據(jù),可能構(gòu)成侵犯著作權(quán)罪;如抓取涉及商業(yè)秘密的數(shù)據(jù),可能構(gòu)成侵犯商業(yè)秘密罪;抓取除上述數(shù)據(jù)以外的數(shù)據(jù),可能構(gòu)成非法獲取計算機信息系統(tǒng)數(shù)據(jù)罪。爬取行為導(dǎo)致計算機系統(tǒng)破壞,可能構(gòu)成破壞計算機信息系統(tǒng)罪。刑法通過提前規(guī)制數(shù)據(jù)的不當收集與獲取行為來降低數(shù)據(jù)濫用風險,而對是否存在非法獲取行為進行判斷需要有明確的數(shù)據(jù)收集方式和范圍。然而,生成式人工智能的數(shù)據(jù)收集范圍難以確定,導(dǎo)致判斷非法獲取行為存在困難[10]。而另一方面,若刑法對收集范圍進行限縮,又會阻礙生成式人工智能的發(fā)展,生成式人工智能還可能由于收集數(shù)據(jù)不足造成數(shù)據(jù)歧視等其他問題。此外,《暫行辦法》第四條第(二)項針對數(shù)據(jù)歧視風險強調(diào),在訓(xùn)練數(shù)據(jù)選擇中應(yīng)當采取有效措施防止歧視。目前對于防止數(shù)據(jù)歧視的要求仍然較少,主要以技術(shù)規(guī)范為主。

2.2.2 針對數(shù)據(jù)質(zhì)量風險

《暫行辦法》第七條第(四)項實際上對訓(xùn)練數(shù)據(jù)的“真實性、準確性、客觀性、多樣性”提出了鼓勵性而非強制性的要求,即增強數(shù)據(jù)質(zhì)量,而非一定要達到這些要求。這體現(xiàn)了“讓產(chǎn)業(yè)向高質(zhì)量方向發(fā)展”的政策導(dǎo)向,但現(xiàn)階段限于產(chǎn)業(yè)實踐并不做出強制性要求。此外,第八條則針對數(shù)據(jù)標注做出明確規(guī)定,提出制定“清晰、具體、可操作的標注規(guī)則;開展數(shù)據(jù)標注質(zhì)量評估,抽樣核驗標注內(nèi)容的準確性”,以提高數(shù)據(jù)標注質(zhì)量。

2.2.3 針對數(shù)據(jù)泄露風險

基礎(chǔ)模型的訓(xùn)練過程中,生成式人工智能服務(wù)提供者作為數(shù)據(jù)處理者,應(yīng)依據(jù)《數(shù)據(jù)安全法》履行數(shù)據(jù)安全保障義務(wù)。我國《人工智能安全標準化白皮書》指出,一方面,人工智能模型日益龐大,開發(fā)過程日益復(fù)雜,數(shù)據(jù)泄露風險點更多、隱蔽性更強,人工智能所使用開源庫漏洞引發(fā)數(shù)據(jù)泄露的情況也很難杜絕。另一方面,交互式人工智能的應(yīng)用降低了數(shù)據(jù)流入模型的門檻。用戶在使用交互式人工智能時往往會放松警惕,更容易透露個人隱私、商業(yè)秘密、科研成果等數(shù)據(jù)。在人工智能通常收集用戶輸入數(shù)據(jù)用于訓(xùn)練的背景下,如何保障用戶輸入數(shù)據(jù)的安全亟需技術(shù)標準,需要落實法律法規(guī),提出可以切實解決用戶輸入數(shù)據(jù)安全問題的相關(guān)標準規(guī)范[11]。

我國《數(shù)據(jù)安全法》對數(shù)據(jù)實行分類分級保護,其中國家高度重視對重要數(shù)據(jù)的保護,“對關(guān)系國家安全、國民經(jīng)濟命脈、重要民生、重大公共利益等國家核心數(shù)據(jù),實行更加嚴格的管理制度。”因此,訓(xùn)練數(shù)據(jù)不宜使用重要數(shù)據(jù)和核心數(shù)據(jù),以免帶來巨大的安全隱患。

目前,涉及數(shù)據(jù)出境監(jiān)管的主要則是個人信息的跨境流動。無論是境外開發(fā)者直接面向境內(nèi)服務(wù)使用者提供服務(wù),還是服務(wù)提供者連接入境API接口后向境內(nèi)服務(wù)使用者提供服務(wù),均可能涉及將服務(wù)使用者個人信息傳輸至境外。目前《個人信息保護法》《數(shù)據(jù)出境安全評估辦法》《個人信息出境標準辦法》均對個人信息出境提出合規(guī)要求,應(yīng)準確識別個人信息出境場景,選擇出境合法機制(標準合同/安全評估/認證),開展個人信息保護影響評估;于隱私政策等文本中披露跨境情形,并具備相應(yīng)合法性基礎(chǔ)。《暫行辦法》第四章“監(jiān)督檢查和法律責任”第二十條特別提及來源于境外生成式人工智能服務(wù)的場景,可以預(yù)見這將是未來監(jiān)管的重點之一。

2.3 總評

我國對于網(wǎng)絡(luò)與算法相關(guān)的法律責任主要存在三類主體——技術(shù)支持者、服務(wù)提供者以及內(nèi)容生產(chǎn)者。算法和人工智能監(jiān)管的重點一直都在于服務(wù)提供者,對于技術(shù)支持者,一般而言以倫理約束為主,盡量不做直接干預(yù)。然而,生成式人工智能的技術(shù)結(jié)構(gòu)的三個層次,即基礎(chǔ)模型、專業(yè)模型和服務(wù)應(yīng)用的區(qū)分,使得現(xiàn)有網(wǎng)絡(luò)與算法治理的三類責任主體的分類已難以適用,因為這三者的角色錯綜復(fù)雜,在不同的層次上共同發(fā)揮作用。生成式人工智能的大模型將三者功能合三為一,可以通過模型即服務(wù)的形式為企業(yè)提供技術(shù)服務(wù),也可以通過例如ChatGPT問答的方式直接生成內(nèi)容與用戶進行交互[12]。因此,應(yīng)當基于生成式人工智能的獨特技術(shù)架構(gòu)進行分層治理,而對于訓(xùn)練數(shù)據(jù)治理,則應(yīng)當主要關(guān)注模型開發(fā)者負責的基礎(chǔ)模型層和由服務(wù)提供者負責的專業(yè)模型。

3 歐盟相關(guān)法律規(guī)定及評述

3.1 總述

目前,歐盟形成了以《人工智能法案》(AIAct,以下簡稱AIA。除非另有說明,本文所有提及AIA的內(nèi)容均指歐盟理事會于2022年12月6日通過的一般方法)、《通用數(shù)據(jù)保護條例》(General Data Protection Regulation,以下簡稱GDPR)為核心的的人工智能數(shù)據(jù)合規(guī)規(guī)范體系。AIA中,由于生成式人工智能一般沒有專門的使用目的,適用對于通用目的人工智能系統(tǒng)(General-Purpose AI System,GPAIS)的規(guī)定。

此前,AIA主要根據(jù)風險程度對人工智能進行分類分級,分為不可接受的風險、高風險、有限風險、極低風險或無風險四種類型,并采取不同的監(jiān)管措施,風險類別越高,監(jiān)管要求越嚴格。但ChatGPT的橫空出世,造成了這種風險分類標準的適用困境。根據(jù)AIA,風險分類取決于提供商設(shè)想的人工智能的使用目的,所有在法案附件三規(guī)定的領(lǐng)域和場景下(例如教育、就業(yè)、基礎(chǔ)設(shè)施等)使用的人工智能系統(tǒng)都被視為高風險系統(tǒng)。然而,ChatGPT這樣的通用型生成式人工智能根據(jù)使用者使用目的的不同會涉及不同的應(yīng)用領(lǐng)域和場景,從而落入不同的風險類別中。2023年2月,歐盟議會試圖將生成式人工智能整體歸于高風險人工智能系統(tǒng)。6月14日,歐盟議會通過了其對《人工智能法》的談判立場,歐盟議會將根據(jù)該談判立場與歐盟理事會和歐盟委員會通過三方對話程序進行談判,就議會和理事會(即歐盟共同立法者)均可接受的立法提案達成臨時協(xié)議。最后,臨時協(xié)議必須由這兩個機構(gòu)各自的正式程序通過。即《人工智能法》的歐盟議會版本(以下簡稱AIA EP Version),最終放棄這一做法,但在AIA EP Version中對GPAIS和生成式人工智能系統(tǒng)進行了進一步規(guī)范,包括對其數(shù)據(jù)風險的規(guī)制。

在AIA中,第10條專門規(guī)定了數(shù)據(jù)治理(Data Governance)要求,但僅針對高風險的人工智能系統(tǒng)。

3.2 規(guī)范梳理及評述

3.2.1 針對數(shù)據(jù)來源風險

(1)不得侵犯知識產(chǎn)權(quán)

顯然,若相關(guān)數(shù)據(jù)受知識產(chǎn)權(quán)法的保護,數(shù)據(jù)只有在獲得許可或?qū)儆诶獾那闆r下才能用于生成式人工智能的訓(xùn)練。《數(shù)字化單一市場指令》(Digital Single Market Directive,DSMD)中規(guī)定了文本和數(shù)據(jù)挖掘的兩種例外情形。

DSMD第3(1)條規(guī)定了科研例外,若研究組織和文化遺產(chǎn)機構(gòu)出于科學研究目的,可以對其合法獲取的作品或其他素材進行文本和數(shù)據(jù)挖掘。首先,研究機構(gòu)必須不以營利為目的,將全部利潤再投資于研究事業(yè),或承擔政府承認的實現(xiàn)公共利益的任務(wù),而受商業(yè)性質(zhì)的企業(yè)決定性影響的組織不包括在內(nèi)。因此,以營利為目的的公司,即使進行科研并在期刊上發(fā)表具有影響力的研究成果,也不能援引第3(1)條的規(guī)定。其次,合法獲取是指,基于開放獲取政策或通過合同(例如訂閱)等合法渠道獲取。也就是說,該類機構(gòu)可以對合法獲取的素材進行提取、復(fù)制和預(yù)處理,并用于生成式人工智能的訓(xùn)練。再次,立法說明進一步強調(diào),在該例外情形下,相關(guān)機構(gòu)無須對權(quán)利人進行補償。

DSMD第4條則規(guī)定了一般例外,值得特別關(guān)注。在研究范圍之外進行文本和數(shù)據(jù)挖掘,需要滿足兩個條件:①必須通過合法渠道獲取內(nèi)容;②其權(quán)利人未以明確、適當?shù)姆绞铰暶鞅A簦坏脤ζ湮谋净驍?shù)據(jù)庫進行挖掘。因此,只要權(quán)利人未聲明保留,生成式人工智能研發(fā)者和提供者不管出于任何使用目的,都可以對網(wǎng)絡(luò)公開數(shù)據(jù)進行挖掘。對于權(quán)利人而言,這是典型的選擇退出機制。根據(jù)DSMD第4(3)條,以適當?shù)姆绞奖A簦袄缭诰W(wǎng)上公開提供內(nèi)容的情況下以機器可讀的方式”表達保留,似乎要求當保留聲明所涉及的作品在互聯(lián)網(wǎng)上向公眾提供時,保留聲明必須可以被機器自動閱讀(如寫入Robots協(xié)議)。實際上,在合同中加入適當?shù)臈l款也可以產(chǎn)生選擇退出的效果,因為DSMD并沒有將第4條列入強制性規(guī)則。對比第3條,第3條未給權(quán)利人提供選擇退出的方式,對于科研目的的挖掘不可通過合同聲明的方式排除[13]。

對于權(quán)利人利益保護和鼓勵科技創(chuàng)新之間的利益衡量,歐盟明顯選擇了后者。當然,歐盟立法者給權(quán)利人提供了選擇退出的可能性,為權(quán)利人主動保護知識產(chǎn)權(quán)提供了法律基礎(chǔ)。但問題在于,權(quán)利人群體是否有能力“以適當?shù)姆绞奖A簟保还苁峭ㄟ^在網(wǎng)絡(luò)上以機器可讀的方式公開聲明保留,還是通過合同條款,這都意味著權(quán)利人需要付出一定的成本。其次,對于生成式人工智能系統(tǒng)的研發(fā)者和提供者是否會根據(jù)權(quán)利人的聲明保留即調(diào)整挖掘方式或放棄挖掘[14],該條款在多大程度上能夠保護權(quán)利人的利益存在疑問。

此外,AIA EP Version中新增了針對生成式人工智能的條款,規(guī)定生成式人工智能模型的研發(fā)者和系統(tǒng)的提供者應(yīng)當披露訓(xùn)練數(shù)據(jù)中包含版權(quán)的內(nèi)容,記錄并公開受版權(quán)法保護的培訓(xùn)數(shù)據(jù)的使用情況,并提供足夠詳細的摘要。公開訓(xùn)練中擁有版權(quán)的內(nèi)容的確有助于權(quán)利人維權(quán),但這可能導(dǎo)致研發(fā)者承擔過重的合規(guī)義務(wù),因為必須對大量的訓(xùn)練數(shù)據(jù)中所有可能涉及版權(quán)的訓(xùn)練數(shù)據(jù)進行法律調(diào)查。同時,版權(quán)的判定也具有一定的難度,對于研發(fā)者并非易事。該披露義務(wù)具體如何實施,需要實施到什么程度,都需要進一步明確,避免造成過大的合規(guī)成本。

(2)不得侵犯個人信息

個人數(shù)據(jù)是個人信息的載體[9],歐盟對于個人信息的保護主要通過GDPR對個人數(shù)據(jù)的保護實現(xiàn)。首先,生成式人工智能使用和處理個人數(shù)據(jù)作為訓(xùn)練數(shù)據(jù)需要具有合法性基礎(chǔ),即滿足GDPR第6條中規(guī)定的至少一種情形。一般而言,生成式人工智能處理個人數(shù)據(jù)都沒有獲得個人的同意,除GDPR第89條規(guī)定的個人數(shù)據(jù)處理的科研例外情形外,需要滿足第6(1)(f)條的利益平衡測試(The Balancing Test)和第6(4)條的目的轉(zhuǎn)換測試(The Purpose Change Test)[2]。平衡測試是為了保護權(quán)利人的優(yōu)先性權(quán)利和基本權(quán)利與自由,一般包含三個部分:①個人數(shù)據(jù)的處理行為是必要的;②數(shù)據(jù)控制者或第三方追求的是正當利益;③該正當利益沒有被數(shù)據(jù)主體的優(yōu)先性權(quán)利或基本權(quán)利與自由推翻。目前,歐盟并未規(guī)定具體通用的平衡性測試,因此在數(shù)據(jù)控制者利益和數(shù)據(jù)主體利益的衡量上有較大的自由裁量空間。但平衡性測試在生成式人工智能的數(shù)據(jù)合規(guī)上具有極其重要的作用,是生成式人工智能使用個人數(shù)據(jù)合法性的前提,也是生成式人工智能個人數(shù)據(jù)處理問責的一部分。同時,由于生成式人工智能采集數(shù)據(jù)的目的和原始數(shù)據(jù)被收集的目的不同,因此還需滿足目的轉(zhuǎn)換測試判斷上述兩種目的具有兼容性,以保障權(quán)利人的數(shù)據(jù)權(quán)利。此外,若涉及個人敏感數(shù)據(jù),由于一般禁止處理敏感數(shù)據(jù),除了滿足第6條,還需要滿足第9(2)條規(guī)定的可以處理敏感數(shù)據(jù)的例外情形。

生成式人工智能若要使用網(wǎng)絡(luò)上采集的個人數(shù)據(jù)作為訓(xùn)練數(shù)據(jù),即當個人數(shù)據(jù)并非從數(shù)據(jù)主體手中獲取時,須承擔GDPR第14條的透明性義務(wù),對數(shù)據(jù)主體提供第14條規(guī)定的數(shù)據(jù)處理的相關(guān)信息,包括數(shù)據(jù)處理者的身份、聯(lián)系方式以及個人數(shù)據(jù)處理的目的等。但對于生成式人工智能,用戶作為數(shù)據(jù)主體可以在交互界面輸入個人數(shù)據(jù),此時則構(gòu)成了第14(5)條的例外情形,生成式人工智能研發(fā)者和提供者應(yīng)當履行第13條規(guī)定的透明性義務(wù),給用戶提供相關(guān)信息,尤其是個人數(shù)據(jù)處理的目的、合法性基礎(chǔ)、正當利益等。對于第14條的透明性義務(wù),由于生成式人工智能訓(xùn)練數(shù)據(jù)的龐大性,要通知到數(shù)量龐大且身份不明的數(shù)據(jù)主體可能會需要極大的努力,甚至形成目的和手段的不成比例的局面[15]。

(3)不得侵犯商業(yè)秘密

商業(yè)秘密受歐盟相關(guān)指令保護。生成式人工智能侵犯商業(yè)秘密的主要方式是,上游在交互階段輸入商業(yè)秘密相關(guān)數(shù)據(jù),相關(guān)數(shù)據(jù)進入訓(xùn)練數(shù)據(jù)集,并最終在下游泄露。該問題主要需要通過企業(yè)對于部署和使用生成式人工智能進行限制。例如,企業(yè)與生成式人工智能研發(fā)者或提供者同意,該企業(yè)員工上傳的信息將只允許該企業(yè)的用戶訪問[16]。

(4)不得使用違法手段獲取數(shù)據(jù)

使用爬蟲收集訓(xùn)練數(shù)據(jù),除侵犯知識產(chǎn)權(quán)和個人數(shù)據(jù)外,還可能存在以下合規(guī)風險:因違反被爬取網(wǎng)站的使用條款而違約;如果網(wǎng)絡(luò)爬取導(dǎo)致系統(tǒng)性能下降或出現(xiàn)性能問題構(gòu)成侵權(quán);由于網(wǎng)站經(jīng)營者在開發(fā)和運營網(wǎng)站方面付出了巨大努力,對網(wǎng)站經(jīng)營者的付出和工作成果“搭便車”可構(gòu)成不公平競爭[16];如果爬蟲規(guī)避訪問控制機制,違反歐盟知識產(chǎn)權(quán)指令中有關(guān)技術(shù)保護措施的規(guī)定。

3.2.2 針對數(shù)據(jù)質(zhì)量風險

歐盟反歧視法(Anti-discrimination Law)規(guī)定,在特定領(lǐng)域如就業(yè)、教育或公開提供的商品和服務(wù)等領(lǐng)域中不得歧視。反歧視法并未明確規(guī)定人工智能中訓(xùn)練數(shù)據(jù)處理的反歧視要求,但有學者認為,在這些領(lǐng)域中應(yīng)用的生成式人工智能滿足以下條件時,其數(shù)據(jù)處理需要受到反歧視法的約束:(1)訓(xùn)練數(shù)據(jù)被用于反歧視法規(guī)定的特定領(lǐng)域;(2)數(shù)據(jù)和模型對人工智能在這些領(lǐng)域的應(yīng)用起到?jīng)Q定性作用;(3)訓(xùn)練數(shù)據(jù)在這些領(lǐng)域應(yīng)用的信息公開[17]。

反歧視法是否能直接適用于通用型生成式人工智能的數(shù)據(jù)處理同樣存在爭議,因為適用反歧視法前提條件是生成式人工智能必須直接應(yīng)用于反歧視法所覆蓋的領(lǐng)域,而通用型的生成式人工智能并沒有專門的使用目的,其數(shù)據(jù)處理和模型訓(xùn)練難以直接用反歧視法進行規(guī)制。有學者認為,若生成式人工智能模型的研發(fā)者預(yù)先設(shè)定了生成式人工智能將在這些特定場景中應(yīng)用,這意味著研發(fā)者并非單純的技術(shù)提供中介,同樣需要受到反歧視法的約束[2]。

不過,即使反歧視法可以適用,也存在執(zhí)行困難。首先,主張反歧視法的適用和執(zhí)行幾乎完全需要由受害人提出,對于受害人來說無疑會產(chǎn)生巨大的成本。其次,即使適用舉證責任倒置的條款,受害方仍然通常無法舉出證明不同群體在統(tǒng)計意義上的不平等待遇的表面證據(jù),因為這可能需要獲取訓(xùn)練數(shù)據(jù)和算法模型[17]。因此,反歧視法并非有效的合規(guī)激勵規(guī)范,亦非有效的問責機制。

如果生成式人工智能屬于AIA中的高風險系統(tǒng),應(yīng)當核查數(shù)據(jù)和模型中可能存在的偏見,尤其當偏見可能會影響自然人基本權(quán)利或產(chǎn)生歧視性結(jié)果。AIA EP Version第10(5)條規(guī)定了負面偏見的檢測和糾正,同時新增了處理包含種族、性取向等內(nèi)容的個人敏感數(shù)據(jù)的7項條件作為防止偏見的保障措施。第29a條新增要求對高風險系統(tǒng)進行“基本權(quán)利影響評估”,并考慮人工智能系統(tǒng)對邊緣群體的潛在負面影響。此外,若訓(xùn)練數(shù)據(jù)屬于個人數(shù)據(jù)且數(shù)據(jù)處理隱含歧視,可以適用GDPR第5(1)(a)條,因其違反了公平處理原則。

若生成式人工智能屬于AIA中的高風險系統(tǒng),根據(jù)AIA第10(3)和(4)條,數(shù)據(jù)集應(yīng)當具有相關(guān)性、代表性,并盡最大可能地無誤和完整,具有適當?shù)慕y(tǒng)計屬性,同時,數(shù)據(jù)集應(yīng)在預(yù)期目的要求的范圍內(nèi),考慮到高風險人工智能系統(tǒng)預(yù)期使用的特定地理、行為或功能環(huán)境所特有的特征或要素。AIA中并未對明確規(guī)定這些特征和要素的內(nèi)涵和外延,可能會導(dǎo)致數(shù)據(jù)是否符合要求缺乏客觀性標準。AIA EP Version在立法說明第44條中新增強調(diào)了高質(zhì)量數(shù)據(jù)集的重要性,并指出可通過第三方提供的合規(guī)認證服務(wù),例如對數(shù)據(jù)集完善性的驗證來滿足數(shù)據(jù)治理相關(guān)的要求。

GDPR第5(1)(d)條對個人數(shù)據(jù)提出了準確性原則,個人數(shù)據(jù)必須準確且在必要時保持更新,第16條進而要求數(shù)據(jù)主體有權(quán)要求更正不準確的數(shù)據(jù)。根據(jù)GDPR,違反第5條的規(guī)定不僅要承擔第82條規(guī)定的法律責任,還要承擔第83(5)條規(guī)定的高達全球年營業(yè)額4%的罰款。然而,GDPR準確性原則的適用首先具有一個核心前提,也就是訓(xùn)練數(shù)據(jù)屬于“個人數(shù)據(jù)”,需要滿足“可識別性”的條件。這意味著,若通過刪除直接可識別的信息或使用去標識化技術(shù)進行匿名化處理,可能會排除準確性原則對相關(guān)訓(xùn)練數(shù)據(jù)的適用[17]。

3.2.3 針對數(shù)據(jù)泄露風險

針對和數(shù)據(jù)安全相關(guān)的網(wǎng)絡(luò)安全風險,AIA指出高風險人工智能系統(tǒng)應(yīng)具有韌性,具有抵御惡意第三方利用系統(tǒng)漏洞改變其使用、行為、性能或破壞其安全屬性的能力。AIA第15(4)條特別要求應(yīng)通過技術(shù)手段預(yù)防和解決惡意第三方操縱數(shù)據(jù)集使數(shù)據(jù)中毒的問題。另外,由于生成式人工智能較為容易受到反向攻擊的影響[18],因此存在較大的個人數(shù)據(jù)的泄漏風險。如上文所述,處理個人信息需要滿足GDPR第6(1)(f)條的利益平衡測試,此時必須充分考慮模型的預(yù)期目的、使用的個人數(shù)據(jù)類型、模型反轉(zhuǎn)的可能性以及重新識別具體數(shù)據(jù)主體的可能性,若存在較大的模型反轉(zhuǎn)的風險,則天平應(yīng)當傾向于個人數(shù)據(jù)保護,不得使用個人數(shù)據(jù)作為訓(xùn)練數(shù)據(jù)。

數(shù)據(jù)傳輸方面,GDPR第五章規(guī)定了個人數(shù)據(jù)跨境傳輸?shù)南嚓P(guān)要求。原則上,只有在接收國或接收組織提供充分的數(shù)據(jù)保護時,才能轉(zhuǎn)移個人數(shù)據(jù),而歐盟委員會有權(quán)決定第三國是否提供充分的數(shù)據(jù)保護。若沒有充分性決定,如果實施了適當?shù)谋U洗胧?例如使用標準合同條款),數(shù)據(jù)傳輸仍可以進行。

3.3 總評

總體而言,由于歐盟對人工智能監(jiān)管和數(shù)據(jù)保護的立法已有較多成果,人工智能數(shù)據(jù)合規(guī)體系已較為完善,規(guī)范較為詳細。盡管部分規(guī)范仍有可推敲完善之處,在生成式人工智能的數(shù)據(jù)合規(guī)的諸多方面都給予了我們啟發(fā)。不過,AIA規(guī)定的風險治理模式并非為生成式人工智能“量身定制”,對于生成式人工智能存在適用難題。

生成式人工智能與AIA最初針對的傳統(tǒng)人工智能系統(tǒng)存在兩個重大差異:動態(tài)使用場景和龐大用戶規(guī)模。生成式人工智能并非針對特定的使用環(huán)境或條件,其開放性和易使用性使它擁有了前所未有的用戶規(guī)模,這尤其對對適用目前AIA靜態(tài)的風險分類的制度提出了挑戰(zhàn)[1]。通用型生成式人工智能根據(jù)使用者使用目的的不同會涉及不同的應(yīng)用領(lǐng)域和場景,從而落入不同的風險類別中,而非直接根據(jù)研發(fā)者或提供者設(shè)想的使用目的直接適用不同風險類別的規(guī)范。AIA第4(c)(1)條規(guī)定了高風險條款適用的例外情形,即提供者在使用說明中明確排除所有高風險用途,可不適用高風險條款。然而,對于生成式人工智能,大規(guī)模的用戶才是決定用途的人,因此事實上難以排除具有高風險用途的情況。且提供者也應(yīng)當了解,生成式人工智能系統(tǒng)一旦投入使用,極有可能會在某些高風險情景下使用,例如在醫(yī)療場景下利用語言模型進行總結(jié)病例甚至是智慧診斷。在這種情況下,提供者即使排除也是非善意的。因此,生成式人工智能還是會落入高風險系統(tǒng)的類別之中,需要履行全部的高風險系統(tǒng)合規(guī)義務(wù),包括識別和分析所有“已知和可預(yù)見的最有可能危及健康、安全和基本權(quán)利的風險”。正是因為生成式人工智能的用途十分廣泛,這樣的制度會使提供者等主體承擔過重的合規(guī)義務(wù)而導(dǎo)致資源浪費,結(jié)合人工智能責任制度,相關(guān)主體還面臨著巨大的責任風險。除了過度監(jiān)管的問題外,直接將生成式人工智能歸為高風險系統(tǒng)還會因為對相對體量較小的模型和應(yīng)用提供者造成過重的負擔而不利于競爭,靜態(tài)的風險治理模式應(yīng)對生成式人工智能動態(tài)的系統(tǒng)性風險會存在滯后[19]。因此,風險分類治理模式不能完全匹配生成式人工智能的監(jiān)管需求。

生成式人工智能的數(shù)據(jù)合規(guī)同樣受到這種風險分類治理方式的影響,AIA中大多數(shù)數(shù)據(jù)合規(guī)的規(guī)定都只適用于高風險的人工智能系統(tǒng)。若生成式人工智能根據(jù)目前的規(guī)范推理完全落入高風險的分類中,會引發(fā)上述問題;但若不適用AIA中數(shù)據(jù)治理的相關(guān)規(guī)定,又會存在大量的數(shù)據(jù)風險,因此,針對人工智能的數(shù)據(jù)治理規(guī)范如何適用于生成式人工智能,仍然值得推敲,歐盟的靜態(tài)風險治理范式并非最優(yōu)解。也許正是因為如此,AIA EP Version新增第28b條規(guī)制人工智能基礎(chǔ)模型,依據(jù)人工智能的技術(shù)結(jié)構(gòu)對其進行規(guī)制。其中,第28b(2)(b)條對基礎(chǔ)模型的數(shù)據(jù)處理提出了要求,基礎(chǔ)模型只處理和納入采用適當數(shù)據(jù)管理措施的數(shù)據(jù)集,尤其要求審查數(shù)據(jù)來源的適宜性、可能存在的偏見和實施減輕偏見的措施。

4 對我國相關(guān)規(guī)范的完善建議

4.1 貫徹落實審慎包容的規(guī)制方向

《中華人民共和國科學技術(shù)進步法》第三十五條規(guī)定了包容審慎原則,在科技和科技監(jiān)管競爭日益激烈的當下,明確總體治理理念,推動生成式人工智能在內(nèi)的人工智能技術(shù)發(fā)展,是形成我國國家優(yōu)勢的重要之舉。具體到生成式人工智能的訓(xùn)練數(shù)據(jù)風險規(guī)制,應(yīng)當在促進數(shù)據(jù)利用科技創(chuàng)新和數(shù)據(jù)權(quán)益保護之間有所衡量有所側(cè)重,充分發(fā)揮數(shù)據(jù)資源的社會價值。

如前所述,當前我國的技術(shù)支持者、服務(wù)提供者和內(nèi)容生產(chǎn)者三類主體分類并不適用于生成式人工智能,而歐盟的風險分類分級治理模式也難以直接適用于這一領(lǐng)域。就像歐盟在其最新的AIA EP Version中重新對GPAIS的基礎(chǔ)模型進行規(guī)范治理一樣,我國也應(yīng)根據(jù)生成式人工智能的技術(shù)結(jié)構(gòu),即區(qū)分基礎(chǔ)模型、專業(yè)模型和服務(wù)應(yīng)用,為其制定不同層次的治理規(guī)范。針對訓(xùn)練數(shù)據(jù)的風險,基礎(chǔ)模型層的規(guī)制應(yīng)以推進技術(shù)開發(fā)為主目標,圍繞科技倫理、數(shù)據(jù)選取以及模型參數(shù)等因素展開;專業(yè)模型層的規(guī)制則應(yīng)以規(guī)避實際使用場景中存在的風險問題為主目標,圍繞專業(yè)領(lǐng)域的特點根據(jù)個案分析。

4.2 制定敏捷性治理方案

生成式人工智能技術(shù)的發(fā)展具有高度的不可預(yù)測性和發(fā)散性,不可預(yù)見的新風險可能隨著其應(yīng)用的拓展和技術(shù)的升級隨時出現(xiàn)。因此,對于人工智能領(lǐng)域的治理需要支持推進決策創(chuàng)新的人工智能決策實驗室、鼓勵企業(yè)在監(jiān)管沙盒中測試新產(chǎn)品并積極參與行業(yè)標準制定,以及發(fā)展技術(shù)手段提高治理的敏捷性,從而適應(yīng)不斷變化的情況。

在當代社會中,法律的滯后性與現(xiàn)實的快速發(fā)展使得二者之間的張力尤其明顯。除了提高立法修法的頻率,還可以將法律與科技相結(jié)合,將科學技術(shù)和政府監(jiān)管納入法律體系,以更廣義的方式應(yīng)對科技發(fā)展所帶來的挑戰(zhàn)[20]。對于生成式人工智能的數(shù)據(jù)風險,必須結(jié)合科技標準來進行規(guī)制。在完善法律法規(guī)的同時,還需要制定相關(guān)的技術(shù)標準。

4.3 針對數(shù)據(jù)來源風險

為了降低訓(xùn)練數(shù)據(jù)挖掘中的知識產(chǎn)權(quán)風險,我國可以采納類似歐盟的方法,為人工智能的開發(fā)調(diào)整現(xiàn)有的的知識產(chǎn)權(quán)制度,以確保基礎(chǔ)模型層能夠合法的獲取大量訓(xùn)練數(shù)據(jù)。目前,主流的觀點是訓(xùn)練數(shù)據(jù)的“合理使用”有助于推動人工智能產(chǎn)業(yè)的長期發(fā)展。人工智能領(lǐng)域正在利用互聯(lián)網(wǎng)上過去十年積累下來的數(shù)據(jù)、數(shù)據(jù)庫和代碼等資源來進行大模型的訓(xùn)練,各國的政策法規(guī)也在積極跟進人工智能的飛速發(fā)展。在涉及個人信息的情況下,開發(fā)者必須保證在充分利用這些信息資源的同時,保護信息主體的合法權(quán)益。在這一方面,可以考慮借鑒歐盟的平衡性測試和目的轉(zhuǎn)換測試,以確保合法權(quán)益的充分保護,達到信息主體和數(shù)據(jù)使用者之間的平衡。

4.4 針對數(shù)據(jù)質(zhì)量風險

首先,應(yīng)制定相關(guān)技術(shù)標準,以確保數(shù)據(jù)質(zhì)量能得到有效的保障。其次,應(yīng)當加快生成式人工智能基礎(chǔ)模型的數(shù)字基礎(chǔ)設(shè)施建設(shè)。建設(shè)數(shù)字基礎(chǔ)設(shè)施需要法律框架的支持,以確保開發(fā)者可以通過合法獲取有效的獲取所需數(shù)據(jù)。在數(shù)字基礎(chǔ)設(shè)施中,建立高質(zhì)量的公共訓(xùn)練數(shù)據(jù)池對于訓(xùn)練出高質(zhì)量的生成式人工智能基礎(chǔ)模型至關(guān)重要。這可以通過建立有效的數(shù)據(jù)管理制度來促進數(shù)據(jù)的充分利用。同時,建立高質(zhì)量的公共訓(xùn)練數(shù)據(jù)池可以推動整個產(chǎn)業(yè)的發(fā)展。為了提升生成式大模型水平,聚集不同領(lǐng)域的高質(zhì)量數(shù)據(jù)庫可以實現(xiàn)一加一大于二的效果。因此,利用好國家數(shù)據(jù)資源庫,尤其是涵蓋了公共衛(wèi)生、科技等不同專業(yè)領(lǐng)域的數(shù)據(jù),是構(gòu)建高質(zhì)量的公共訓(xùn)練數(shù)據(jù)池的重要途徑。

可以借鑒歐盟最新立法,就數(shù)據(jù)歧視和系統(tǒng)歧視問題進行以下方面的評估:

(1)明確概述使用該系統(tǒng)的預(yù)期目的;

(2)系統(tǒng)使用的預(yù)期地理和時間范圍的清晰輪廓;

(3)可能受系統(tǒng)使用影響的自然人和群體的類別;

(4)核查該系統(tǒng)的使用是否符合有關(guān)基本權(quán)利的歐盟和國家法律;

(5)投入使用高風險人工智能系統(tǒng)對基本權(quán)利的可合理預(yù)見的影響;

(6)可能影響邊緣化人群或弱勢群體的具體傷害風險;

(7)可合理預(yù)見的使用該系統(tǒng)對環(huán)境的不利影響;

(8)關(guān)于如何減輕已查明的危害和對基本權(quán)利的負面影響的詳細計劃;

(9)部署者將建立的管理制度,包括人的監(jiān)督、投訴處理和補救措施。

4.5 針對數(shù)據(jù)泄露風險

首先,生成式人工智能服務(wù)提供者應(yīng)當履行安全保障責任的法律義務(wù)。此外,如上所述,需要建立一種敏捷的數(shù)據(jù)安全風險治理機制。對于出現(xiàn)在基礎(chǔ)模型層和專業(yè)模型層的數(shù)據(jù)風險事件,技術(shù)研發(fā)者應(yīng)當被要求立即采取緊急的離線修復(fù)和模型停用等措施,以防止風險進一步擴大,并且應(yīng)當及時履行通知用戶(包括企業(yè)和個人)以及向監(jiān)管機構(gòu)報告的義務(wù)。針對服務(wù)應(yīng)用層的風險事件,首先需要初步評估風險的起因。如果風險事件是由用戶行為引發(fā)的,除了履行緊急糾正和通知的義務(wù)外,服務(wù)提供者還需考慮對用戶采取相關(guān)的限制和處罰措施。例如,如果風險事件是由用戶進行“數(shù)據(jù)投毒”行為而導(dǎo)致的,那么應(yīng)該追究用戶的責任,并在事后采取相應(yīng)措施。但如果風險事件并非由用戶引發(fā),那么需要向更高級別的源頭追溯,以進一步確定是基礎(chǔ)模型層還是專業(yè)模型層存在問題,從而明確履行事后應(yīng)對義務(wù)和責任承擔的主體。