基于深度學習的目標說話人語音提取

2024-06-01 02:48:13王志雄

電腦知識與技術 2024年10期

王志雄

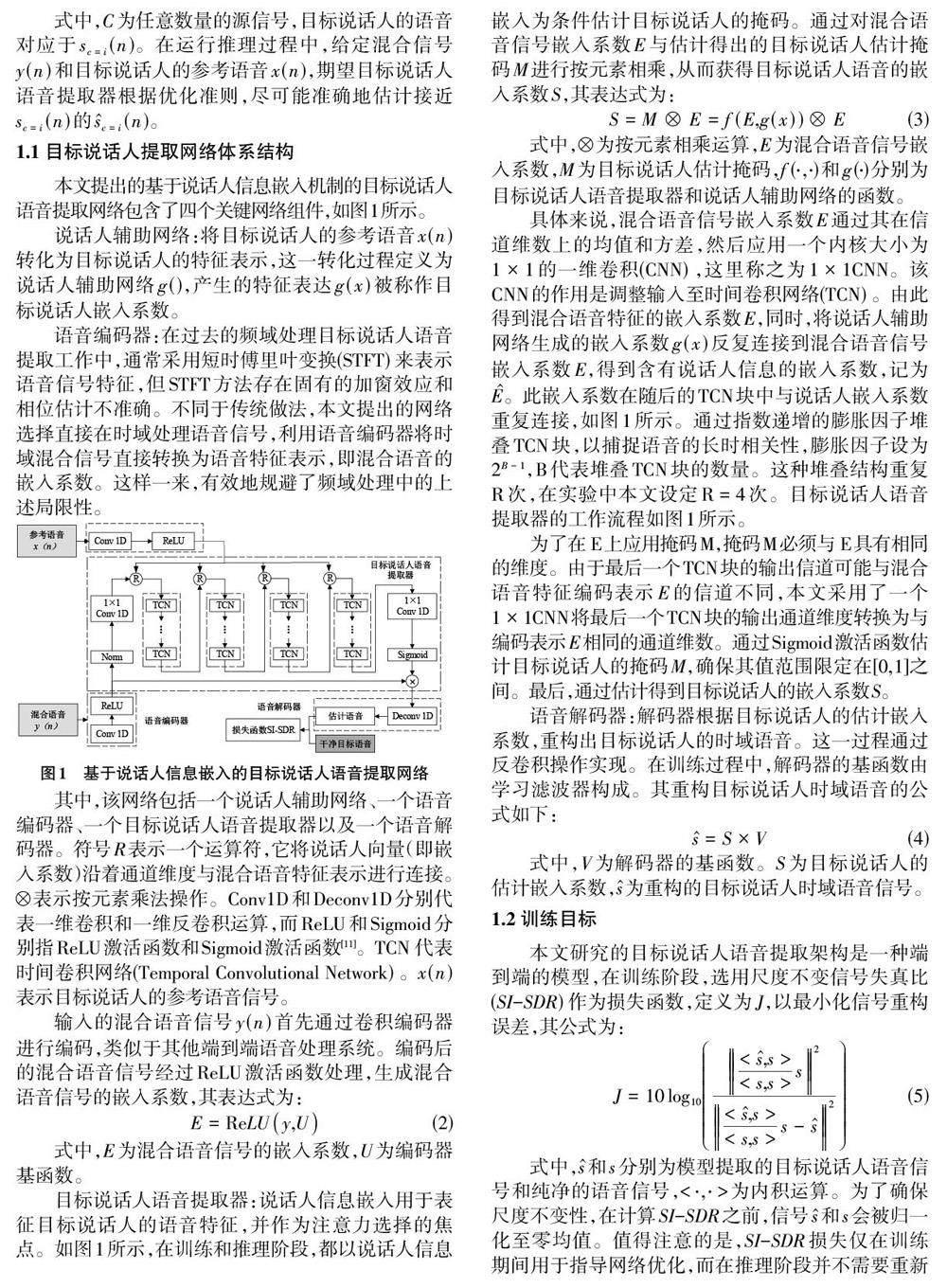

摘要:人類能夠在多人交談的復雜環境中專注并識別目標說話人的語音,而現有機器技術尚未完全達到這一水平。針對這一實際應用場景,本文提出了一種時域目標說話人語音提取網絡架構,該架構無需將混合語音分解為幅度譜和相位譜,而是直接將其轉換為嵌入系數,從而規避了復雜的相位估計。該網絡由四個關鍵部分構成,即說話人輔助網絡、語音編碼器、目標說話人語音提取器以及語音解碼器。具體而言,語音編碼器負責將混合語音轉化為嵌入系數;說話人輔助網絡則通過學習以說話人嵌入形式表示目標說話人特征;目標說話人語音提取器以嵌入系數與目標說話人嵌入作為輸入,進而估計出一個接收掩模;最后,語音解碼器根據處理過的嵌入系數重新構造出目標說話人的語音。實驗結果顯示,在開放評測環境下,相較于基準模型,所提方法在SDR(Signal-to-Distortion Ratio) 和SI-SDR(Source-to-Interference Signal-to-Distortion Ratio) 指標上分別取得了相對提升2.62dB和2.52dB的成績。實驗結果有力證明了該方法具有更好的抗干擾性和泛化性能。

關鍵詞:單通道;目標說話人語音提取;時域語音信號;泛化性;語音編碼器;語音解碼器

中圖分類號:TP311 文獻標識碼:A

文章編號:1009-3044(2024)10-0037-04