價(jià)格引導(dǎo)雙流自注意力序列推薦模型

孫克雷 呂自強(qiáng)

【摘?? 要】?? 針對傳統(tǒng)序列推薦算法捕獲交互序列中的長期依賴性能力較弱,以及由于數(shù)據(jù)稀疏性導(dǎo)致推薦結(jié)果缺乏個性化的問題,提出了一種價(jià)格引導(dǎo)雙流自注意力序列推薦模型。通過融合項(xiàng)目價(jià)格信息分析用戶價(jià)格偏好并輔助計(jì)算項(xiàng)目相似度,提高推薦結(jié)果的個性化程度;將兩種信息輸入到兩個獨(dú)立的自注意力機(jī)制,學(xué)習(xí)不同位置的重要性、提取其特征,并將輸出進(jìn)行拼接后輸入到門控單元學(xué)習(xí)時(shí)間依賴性,提高模型的長期依賴性建模能力。在三個公開數(shù)據(jù)集上驗(yàn)證了模型的有效性,命中率和歸一化折損累積增益最低提升1.11%,最高提升5.34%。

【關(guān)鍵詞】?? 推薦算法;序列推薦;項(xiàng)目價(jià)格;自注意力機(jī)制;長期依賴性

Price-guided Dual Self-attention Sequential Recommendation Model

Sun Kelei, Lyu Ziqiang*

(Anhui University of Science and Technology, Huainan 232001, China)

【Abstract】??? Aiming at the problem that the traditional sequential recommendation algorithm has a weak ability to capture the long-term dependence in the interaction sequence, and the lack of personalization of the recommendation results due to data sparsity, this paper proposes a Price-guided Dual Self-attention Sequential Recommendation (PG-DSASR). By integrating item price information to analyze user price preference and assist in calculating item similarity, the personalized degree of recommendation results is improved. The two kinds of information are input into two independent self-attention mechanisms to learn the importance of different positions and extract their features, and the output is spliced and input into the gated unit to learn the time dependence, so as to improve the long-term dependence modeling ability of the model. The effectiveness of the model is verified on three public datasets. The hit rate and the cumulative gain of normalized loss are increased by 1.11% at the minimum and 5.34% at the maximum.

【Key words】???? recommendation algorithm; sequential recommendation; item price; self-attention mechanism; long-term dependence

〔中圖分類號〕 TP391????????????? ?? ????? ???〔文獻(xiàn)標(biāo)識碼〕? A????? ???????????? 〔文章編號〕 1674 - 3229(2024)02- 0029 - 07

[收稿日期]?? 2023-10-27

[基金項(xiàng)目]?? 國家自然科學(xué)基金項(xiàng)目(61703005);安徽省高校科研重點(diǎn)項(xiàng)目(2022AH050821)

[作者簡介]?? 孫克雷(1980- ),男,博士,安徽理工大學(xué)計(jì)算機(jī)科學(xué)與工程學(xué)院副教授,研究方向:推薦系統(tǒng)。

[通訊作者]?? 呂自強(qiáng)(2000- ),男,安徽理工大學(xué)計(jì)算機(jī)科學(xué)與工程學(xué)院碩士研究生,研究方向:推薦系統(tǒng)。

0???? 引言

隨著互聯(lián)網(wǎng)的迅猛發(fā)展和廣泛應(yīng)用,數(shù)據(jù)呈現(xiàn)爆炸性增長,為了有效處理海量信息,個性化推薦系統(tǒng)[1-2]迅速嶄露頭角。早期的推薦模型主要采用協(xié)同過濾[3]的方式來挖掘用戶交互序列中的靜態(tài)變化,然而隨著時(shí)間推移,用戶的興趣會逐漸演變。為了更準(zhǔn)確地捕捉用戶在一段時(shí)間內(nèi)的興趣變化,序列推薦模型[4]應(yīng)運(yùn)而生。從最初的馬爾可夫鏈模型[5]到基于循環(huán)神經(jīng)網(wǎng)絡(luò)、卷積神經(jīng)網(wǎng)絡(luò)以及自注意力機(jī)制[6]的模型,序列推薦領(lǐng)域百花齊放。目前,基于自注意力機(jī)制的序列推薦模型成為該領(lǐng)域的研究熱點(diǎn),但仍然存在一些問題。數(shù)據(jù)稀疏一直是序列推薦領(lǐng)域難以回避的難題。單一的交互序列嵌入輸入的信息受限,難以有效支持網(wǎng)絡(luò)中大量參數(shù)的更新,從而影響推薦精度。在自注意力機(jī)制中,直接拼接輔助信息與項(xiàng)目嵌入則可能引入額外噪聲。此外,獨(dú)立的自注意力網(wǎng)絡(luò)難以很好地捕獲交互序列中的長期依賴性。

基于以上分析,考慮到用戶在購物時(shí)通常關(guān)注商品的性價(jià)比,而價(jià)格與用戶期望不符的商品在一定程度上可視為噪聲,價(jià)格信息作為一種重要的輔助信息能夠有效反映用戶的興趣偏好,可以通過引入價(jià)格信息來緩解數(shù)據(jù)稀疏性問題。為了避免直接拼接異構(gòu)信息引入額外噪聲的問題,設(shè)計(jì)了雙流自注意力網(wǎng)絡(luò),分別用于學(xué)習(xí)項(xiàng)目和價(jià)格的轉(zhuǎn)換模式。隨后,將雙流自注意力網(wǎng)絡(luò)與GRU進(jìn)行融合,提高模型對用戶序列中長期依賴性的捕獲能力,提出一種價(jià)格引導(dǎo)雙流自注意力序列推薦模型(Price-Guided Dual Self-Attention Sequential Recommendation Model,PG-DSASR)。為了證明模型的有效性,在三個公共數(shù)據(jù)集上進(jìn)行了對比試驗(yàn),證明模型在命中率和歸一化折損累積增益的4個指標(biāo)上有一定的提高。

1???? 相關(guān)工作

序列建模的目的是分析用戶歷史交互數(shù)據(jù)并從中提取特征和規(guī)律,從而實(shí)現(xiàn)符合用戶偏好的推薦。早期的基于馬爾科夫鏈的模型假設(shè)用戶的下一次交互受到前一個或者前幾個交互的影響,這使得它能夠捕獲序列中的短期相關(guān)性。然而基于這種假設(shè),它在捕獲用戶-項(xiàng)目交互的復(fù)雜的長序列關(guān)系時(shí)存在較大的局限性。進(jìn)入深度學(xué)習(xí)時(shí)代,神經(jīng)網(wǎng)絡(luò)被引入到序列推薦領(lǐng)域,它們不僅可以挖掘數(shù)據(jù)中更深層次的信息,而且具有十分靈活的網(wǎng)絡(luò)結(jié)構(gòu)特征。基于循環(huán)神經(jīng)網(wǎng)絡(luò)的序列推薦算法[7]能夠從全局的角度考慮整個交互序列,在對用戶的長期偏好進(jìn)行建模方面具有較大優(yōu)勢,然而RNN無法很好地長期記憶,它會遺忘之前的信息。受到卷積神經(jīng)網(wǎng)絡(luò)的啟發(fā),將交互序列的嵌入看成圖像并進(jìn)行卷積操作從而達(dá)到提取項(xiàng)目之間局部依賴關(guān)系的目的,進(jìn)而提出了Caser模型[8]。自注意力機(jī)制會給那些與下一個交互相關(guān)性較大的物品分配較大的注意力權(quán)重,反之則分配較小的權(quán)重。基于自注意力機(jī)制,Kang等[9]提出了SASRec模型。后來Sun等[10]進(jìn)一步利用雙向Transformer和掩碼預(yù)測任務(wù),提出了BERT4Rec模型用于序列推薦。Li等[11]提出TiSASRec模型,在SASRec的基礎(chǔ)上添加了項(xiàng)目的時(shí)間間隔信息。除此之外,一些模型針對點(diǎn)擊注意力機(jī)制的計(jì)算局限進(jìn)行了改良,例如STOSA模型[12]使用沃瑟斯坦距離來衡量兩個項(xiàng)目之間的相似度。此外,Gholami等[13]提出可解釋性模型PARSRec,它通過融合自注意力機(jī)制和循環(huán)神經(jīng)網(wǎng)絡(luò),來挖掘物品之間的深層關(guān)系以提高推薦質(zhì)量。

盡管上述序列推薦模型考慮到了引入輔助信息以緩解數(shù)據(jù)稀疏性的問題,但卻忽略了直接拼接異構(gòu)信息可能帶來的額外噪聲,同時(shí)在捕獲交互序列的長期依賴性方面存在一定不足。因此,PG-DSASR通過將雙流自注意力網(wǎng)絡(luò)與GRU進(jìn)行融合,不僅成功引入價(jià)格信息以緩解數(shù)據(jù)稀疏性問題,還有效解決了直接拼接異構(gòu)信息可能產(chǎn)生的額外噪聲,同時(shí)提升了模型對長期依賴性的建模能力。

2???? 模型框架

PG-DSASR模型框架如圖1所示,模型的結(jié)構(gòu)包括四個部分,分別為嵌入層、雙流自注意力網(wǎng)絡(luò)、長期依賴性建模以及預(yù)測層。其中嵌入層將模型輸入轉(zhuǎn)化為低維嵌入表征;雙流自注意力網(wǎng)絡(luò)通過使用兩個多頭自注意力模塊分別提取交互項(xiàng)目信息以及項(xiàng)目價(jià)格信息的嵌入表征,然后進(jìn)行表征融合;長期依賴性建模則通過GRU的重置門將雙流自注意力網(wǎng)絡(luò)的輸出[vj]和上一層的隱藏狀態(tài)[?j]相結(jié)合,并通過更新門進(jìn)行信息的更新;預(yù)測層根據(jù)輸出計(jì)算用戶下一項(xiàng)可能感興趣的項(xiàng)目。模型的外部結(jié)構(gòu)采用串聯(lián)設(shè)計(jì)的方法,即每個模塊接收一個隱藏狀態(tài)和一個輸入,并產(chǎn)生一個輸出和下一個隱藏狀態(tài)。

2.1?? 問題定義

序列推薦的任務(wù)是利用用戶的歷史行為來預(yù)測未來可能感興趣的項(xiàng)目。為了便于表述,將I={[iu1,iu2,iu3,…,iu|I|]}定義為項(xiàng)目集,將P={[pi1,pi2],…,[pim]}定義為項(xiàng)目的價(jià)格信息合集,將U={[u1],[u2,u3,…,u|U|]}定義為用戶集。[|I|]表示數(shù)據(jù)集中不重復(fù)項(xiàng)目的數(shù)量,m表示價(jià)格信息的數(shù)量,[|U|]表示數(shù)據(jù)集中不重復(fù)用戶的數(shù)量。模型的目標(biāo)是預(yù)測用戶在t+1時(shí)刻可能交互的項(xiàng)目。

2.2?? 雙流自注意力網(wǎng)絡(luò)

雙流自注意力網(wǎng)絡(luò)由兩個獨(dú)立的自注意力機(jī)制構(gòu)成,因此可以通過學(xué)習(xí)兩個嵌入表示的相似性來識別對下一個商品產(chǎn)生重大影響的商品,而不用考慮它們之間的位置關(guān)系,且從表征的多個子空間學(xué)習(xí)比從單個表征學(xué)習(xí)更靈活。雙流自注意力網(wǎng)絡(luò)使用不同的多頭注意力機(jī)制處理不同類別的輸入信息,并將輸出的嵌入表征進(jìn)行拼接,然后輸入到線性層以調(diào)整維度和壓縮語義,如圖2所示。

模型在計(jì)算鍵K、值V和查詢Q之間的點(diǎn)積的過程中,K和V是相同的,它們的行均是項(xiàng)目的嵌入和項(xiàng)目價(jià)格信息嵌入。然而矩陣Q是不同的,它是由用戶嵌入和上一個隱藏狀態(tài)拼接而成的。為了緩解過擬合,提高穩(wěn)定性,并加快訓(xùn)練過程,網(wǎng)絡(luò)架構(gòu)添加了層歸一化(LN)和Dropout。

[MultiHead(Q,K,V)=FC(Concat(?eadl1,?eadl2,… ,?eadlh)⊙Concat(?eadp1,?eadp2,… ,?eadph))]???? ? (1)

[?eadi=Attention(QWQi,KWKi,VWVi)]????? (2)

[Attention(Q,K,V)=Softmax(QKTd/?)V]???? (3)

其中,F(xiàn)C是全連接層,[⊙]表示對多頭自注意力機(jī)制的輸出表征進(jìn)行拼接,h表示head的數(shù)量,[WQi∈Rdq×dq],[WKi∈Rdk×dq],[WVi∈Rdv×dq]是模型學(xué)習(xí)得到的參數(shù),[dk]是健和值的維度,[dq]是查詢的維度。第m行的健、值和查詢分別為:

[Q=Concat(EU,?j)]?????? (4)

[m_throw(KI)=m_throw(VI)=EIi(S)m]?????? (5)

[m_throw(Kp)=m_throw(Vp)=EPp(S)m]??? (6)

在處理多維稠密數(shù)據(jù)集中的豐富結(jié)構(gòu)和互動關(guān)系時(shí),單層的雙流注意力網(wǎng)絡(luò)的模型容量可能會受到限制,導(dǎo)致編碼和表示能力不足。通過引入更多的注意層,模型能夠逐步學(xué)習(xí)和捕捉數(shù)據(jù)中更豐富、更復(fù)雜的關(guān)系,可以很好地解決上述問題。每一層的注意力機(jī)制都可以專注于不同層次的特征和關(guān)聯(lián),從而提供更全面的編碼和表示。具體而言,可以使用相同的查詢Q來堆疊多個注意層,并將上一層的輸出作為下一層的鍵K和值V,使模型可以建立起更深入的理解和上下文依賴。

2.3?? 長期依賴性建模

模型中將雙流自注意力網(wǎng)絡(luò)與門控循環(huán)單元相結(jié)合,有助于幫助模型更好地捕獲交互序列中的長期依賴關(guān)系。雙流自注意力網(wǎng)絡(luò)的輸出作為GRU模塊的輸入,并且將查詢Q作為隱藏狀態(tài)輸入到GRU內(nèi)部,計(jì)算過程如公式(7)~(10)所示:

[zt=σ(Wz?[?t-1,vt])]???? (7)

[rt=σ(Wr?[?t-1,vt])]????? (8)

[?t=tanh (W?[rt⊙?t-1,vt])]?? (9)

[st=(1-zt)⊙st-1+zt⊙?t] (10)

其中,[σ]表示sigmoid激活函數(shù),用該函數(shù)可以將數(shù)據(jù)映射到0到1之間的范圍,從而充當(dāng)門控信號,[zt]和[rt]分別為更新門和重置門,[vt]是t時(shí)刻自注意力層的輸出,在此作為門控循環(huán)單元的輸入,[?t]是當(dāng)前時(shí)刻的候選隱藏狀態(tài),[st]代表了用戶在t時(shí)刻的偏好狀態(tài)。

隱藏狀態(tài)攜帶用戶信息和序列的當(dāng)前狀態(tài),為了確保它不會隨著數(shù)據(jù)的更新而消失,模型在每一步都將用戶嵌入連接到隱藏狀態(tài)。初始隱藏狀態(tài)對交互歷史進(jìn)行編碼,這是用戶歷史操作中嵌入項(xiàng)目的加權(quán)平均值。隨后,將這些信息提供給GRU可以提高模型的預(yù)測精度,其中的更新門負(fù)責(zé)保存適量的記憶信息,重置門負(fù)責(zé)將記憶信息與雙流自注意力網(wǎng)絡(luò)的輸出信息融合。

2.4?? 預(yù)測層

在每一步使用GRU的輸出來預(yù)測下一個項(xiàng)目。將GRU的輸出乘以[EI],得到一個大小為|V|的相似向量。具有較高值的索引表示接下來更有可能與之交互的項(xiàng),對這個向量進(jìn)行排序,并在此基礎(chǔ)上進(jìn)行下一個項(xiàng)目的推薦。模型采用交叉熵函數(shù)作為損失函數(shù):

[L=-log(exp (y[target])kexp(y[k]))2]??? (11)

其中,y是輸出,target是要預(yù)測的真實(shí)項(xiàng)目[V'j+1]。

3???? 模型驗(yàn)證

3.1?? 數(shù)據(jù)集

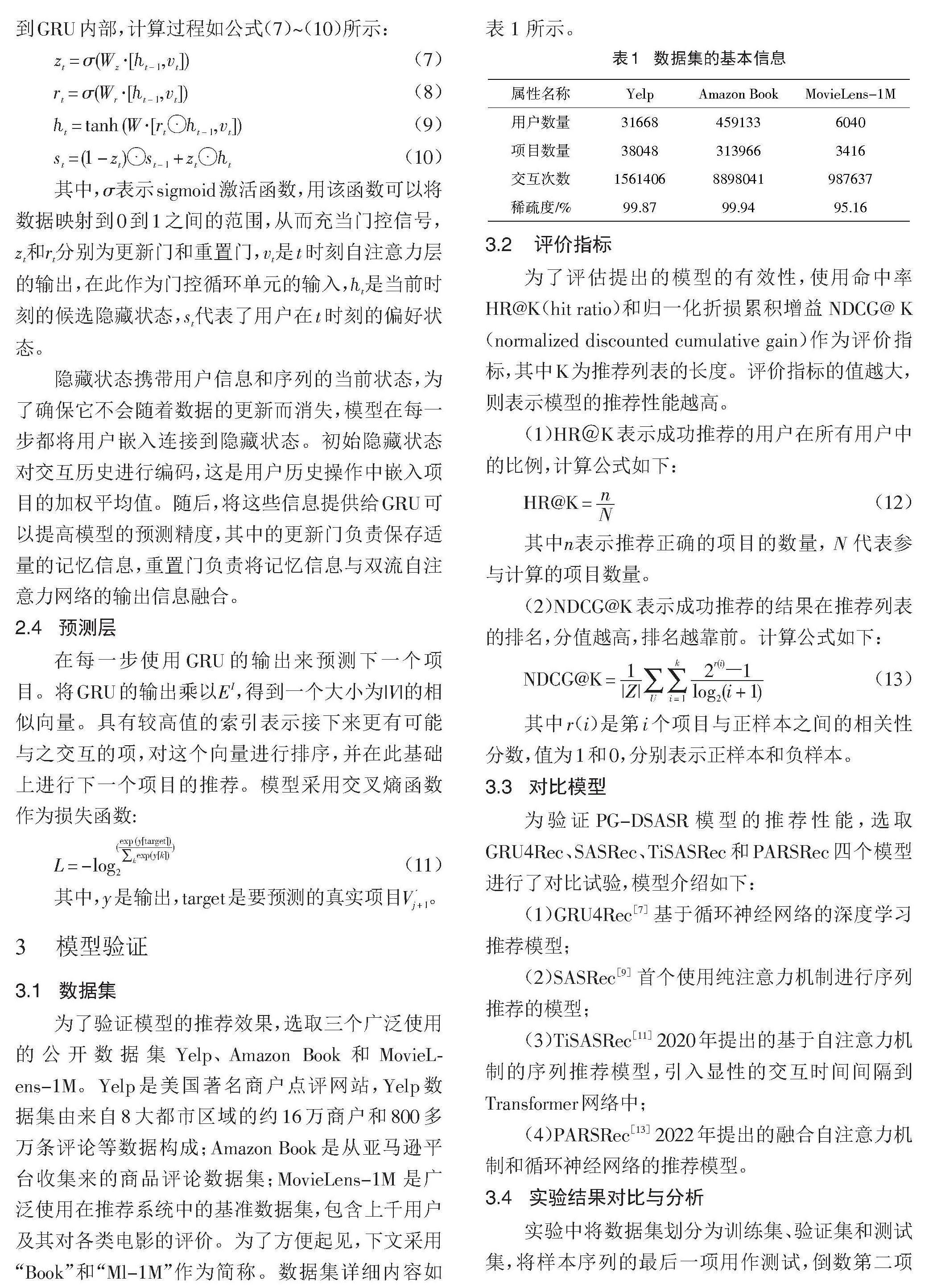

為了驗(yàn)證模型的推薦效果,選取三個廣泛使用的公開數(shù)據(jù)集Yelp、Amazon Book和MovieLens-1M。Yelp是美國著名商戶點(diǎn)評網(wǎng)站,Yelp數(shù)據(jù)集由來自8大都市區(qū)域的約16萬商戶和800多萬條評論等數(shù)據(jù)構(gòu)成;Amazon Book是從亞馬遜平臺收集來的商品評論數(shù)據(jù)集;MovieLens-1M 是廣泛使用在推薦系統(tǒng)中的基準(zhǔn)數(shù)據(jù)集,包含上千用戶及其對各類電影的評價(jià)。為了方便起見,下文采用“Book”和“Ml-1M”作為簡稱。數(shù)據(jù)集詳細(xì)內(nèi)容如表 1 所示。

3.2??? 評價(jià)指標(biāo)

為了評估提出的模型的有效性,使用命中率HR@K(hit ratio)和歸一化折損累積增益 NDCG@ K(normalized discounted cumulative gain)作為評價(jià)指標(biāo),其中K為推薦列表的長度。評價(jià)指標(biāo)的值越大,則表示模型的推薦性能越高。

(1)HR@K表示成功推薦的用戶在所有用戶中的比例,計(jì)算公式如下:

[HR@K=nN]? (12)

其中[n]表示推薦正確的項(xiàng)目的數(shù)量,[N]代表參與計(jì)算的項(xiàng)目數(shù)量。

(2)NDCG@K表示成功推薦的結(jié)果在推薦列表的排名,分值越高,排名越靠前。計(jì)算公式如下:

[NDCG@K=1|Z|U i=1k 2r(i)?1log2(i+1)]???? (13)

其中r(i)是第i個項(xiàng)目與正樣本之間的相關(guān)性分?jǐn)?shù),值為1和0,分別表示正樣本和負(fù)樣本。

3.3?? 對比模型

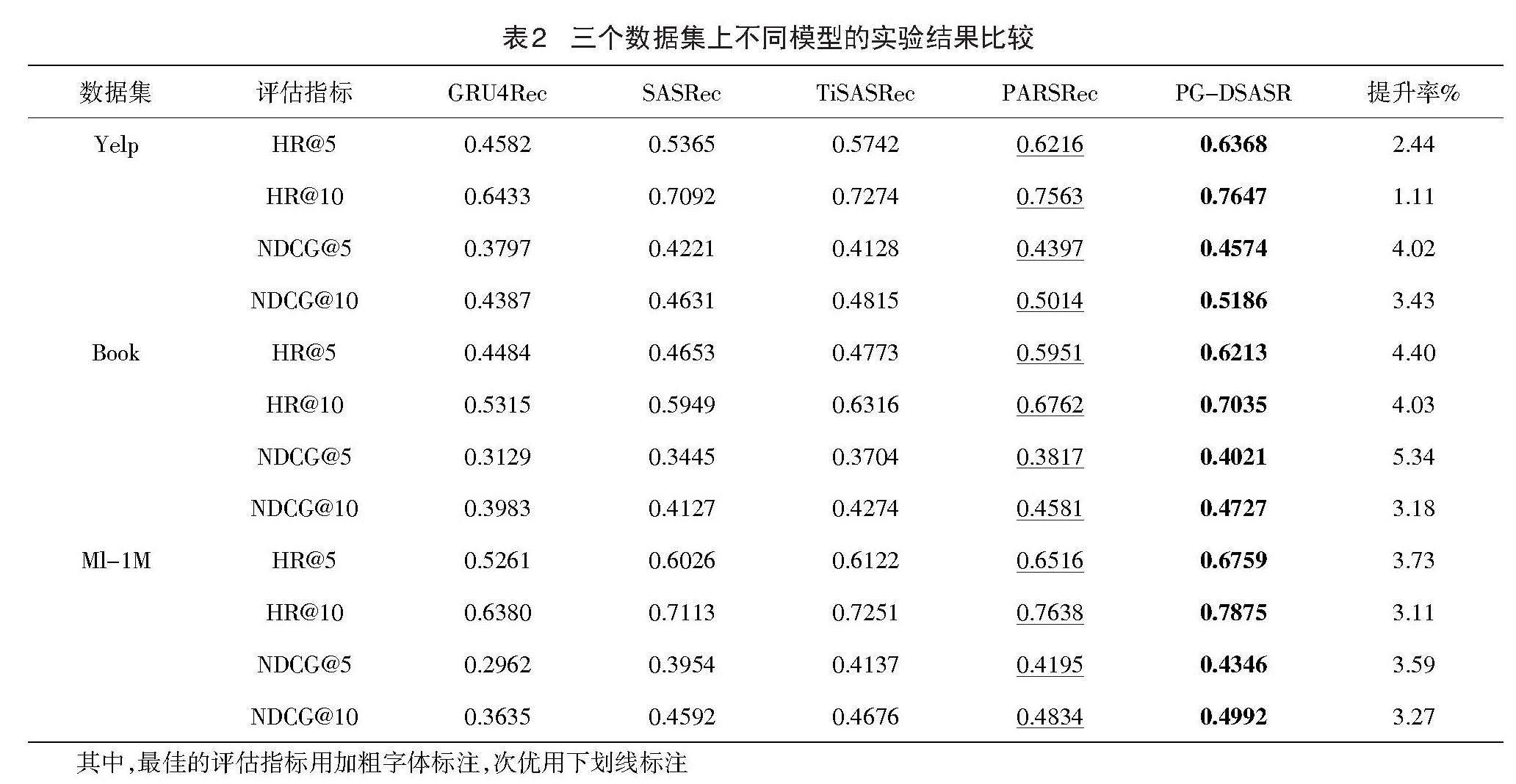

為驗(yàn)證PG-DSASR模型的推薦性能,選取GRU4Rec、SASRec、TiSASRec和PARSRec四個模型進(jìn)行了對比試驗(yàn),模型介紹如下:

(1)GRU4Rec[7] 基于循環(huán)神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)推薦模型;

(2)SASRec[9] 首個使用純注意力機(jī)制進(jìn)行序列推薦的模型;

(3)TiSASRec[11] 2020年提出的基于自注意力機(jī)制的序列推薦模型,引入顯性的交互時(shí)間間隔到Transformer網(wǎng)絡(luò)中;

(4)PARSRec[13] 2022年提出的融合自注意力機(jī)制和循環(huán)神經(jīng)網(wǎng)絡(luò)的推薦模型。

3.4?? 實(shí)驗(yàn)結(jié)果對比與分析

實(shí)驗(yàn)中將數(shù)據(jù)集劃分為訓(xùn)練集、驗(yàn)證集和測試集,將樣本序列的最后一項(xiàng)用作測試,倒數(shù)第二項(xiàng)用于驗(yàn)證,其余則為訓(xùn)練使用。在訓(xùn)練過程中采用學(xué)習(xí)率為0.001、[β1]=0.9、[β2]=0.999的Adam和Sparse Adam優(yōu)化器進(jìn)行優(yōu)化,各項(xiàng)實(shí)驗(yàn)參數(shù)采用原論文中的默認(rèn)值,超參數(shù)根據(jù)實(shí)際情況調(diào)整,評估指標(biāo)的K值分別取5和10。表2顯示了所有模型在三個數(shù)據(jù)集上的模型性能。實(shí)驗(yàn)結(jié)果分析如下。

PG-DSASR模型在三個數(shù)據(jù)集上都展示出了最好的性能,在Yelp數(shù)據(jù)集中與次優(yōu)模型相比,HR@5和HR@10分別提升了2.44%和1.11%,NDCG@5和NDCG@10分別提升了4.02%和3.43%;在Book數(shù)據(jù)集中與次優(yōu)模型相比,HR@5和HR@10分別提升了4.40%和4.03%,NDCG@5和NDCG@10分別提升了5.34%和3.18%;在Ml-1M數(shù)據(jù)集中與次優(yōu)模型相比,HR@5和HR@10分別提升了3.73%和3.11%,NDCG@5和NDCG@10分別提升了3.59%和3.27%。評估指標(biāo)的提升說明:PG-DSASR模型使用雙流自注意力網(wǎng)絡(luò)分別提取交互項(xiàng)目信息和項(xiàng)目價(jià)格信息,避免了直接融合異構(gòu)信息而產(chǎn)生噪聲,并且融合了門控循環(huán)單元的網(wǎng)絡(luò)結(jié)構(gòu),可以同時(shí)學(xué)習(xí)交互項(xiàng)目之間的時(shí)間依賴性和不同位置的重要性。GRU4Rec相比于PG-DSASR推薦效果不佳的原因是傳統(tǒng)的循環(huán)神經(jīng)網(wǎng)絡(luò)架構(gòu)參數(shù)較少,無法很好地捕獲序列特征,序列建模能力較弱。SASRec相比于PG-DSASR推薦效果不佳的原因是沒有解決數(shù)據(jù)稀疏問題,而且單純的自注意力網(wǎng)絡(luò)結(jié)構(gòu)在捕獲交互序列中的長期依賴性方面效率較低。TiSASRec相比于PG-DSASR推薦性能不佳的原因是:直接將序列信息與時(shí)間間隔信息融合進(jìn)行注意力計(jì)算會產(chǎn)生額外噪聲,并且網(wǎng)絡(luò)結(jié)構(gòu)單一,無法很好地捕獲交互序列中的長期依賴性。PARSRec的推薦性能優(yōu)于SASRec和TiSASRec的原因是:將自注意力機(jī)制與RNN融合,提高了模型在挖掘交互數(shù)據(jù)深層次信息方面的能力,但是它沒有考慮緩解數(shù)據(jù)稀疏問題,且RNN存在遺忘性無法很好地保留信息,最終導(dǎo)致推薦效果不佳。通過表2可以看出PG-DSASR在Book數(shù)據(jù)集上評估指標(biāo)的提升最明顯,因?yàn)锽ook相比于Yelp和Ml-1M數(shù)據(jù)更稀疏,驗(yàn)證了模型考慮價(jià)格信息對緩解數(shù)據(jù)稀疏性的有效性。

3.5?? 消融實(shí)驗(yàn)

3.5.1??? 模型結(jié)構(gòu)分析

為了了解模型的各個組成部分對整體性能的影響,進(jìn)行了一系列的消融實(shí)驗(yàn)。表3總結(jié)了最優(yōu)模型和其變體在三個數(shù)據(jù)集上的性能,變體如下:

(1)PG-DSASR-P 去除價(jià)格信息輸入;

(2)PG-DSASR-D 使用單一的自注意力網(wǎng)絡(luò);

(3)PG-DSASR-G 使用普通RNN代替門控循環(huán)單元。

通過對比結(jié)果,可以得知價(jià)格信息在反映用戶偏好方面起著關(guān)鍵作用。如果將價(jià)格信息排除在用戶畫像之外,可能導(dǎo)致用戶畫像的不完整,進(jìn)而影響推薦結(jié)果的個性化程度。此外,去除價(jià)格信息后數(shù)據(jù)稀疏性問題變得更加突出,進(jìn)而影響推薦結(jié)果的質(zhì)量。因此,可以看出引入價(jià)格信息有助于提升模型的推薦能力。將價(jià)格信息與項(xiàng)目交互嵌入進(jìn)行線性拼接,并輸入自注意力機(jī)制,發(fā)現(xiàn)最終模型性能下降,原因在于直接融合異構(gòu)信息進(jìn)行點(diǎn)積自注意力計(jì)算會引入額外的噪聲。因此,使用雙流自注意力機(jī)制分別提取異構(gòu)信息可以顯著提高模型的推薦質(zhì)量。

另外,采用普通的RNN模塊會導(dǎo)致模型性能下降,因?yàn)樵趯?shí)際運(yùn)用中,RNN存在梯度爆炸的問題,導(dǎo)致忘記較遠(yuǎn)的信息。相比之下,GRU通過其精妙的門結(jié)構(gòu),合理地遺忘和保留信息,信息能夠長期傳遞下去。因此,選擇GRU能夠有效解決梯度爆炸的問題,有助于提升模型的長期依賴建模能力。

3.5.2?? 模型各組件對評估指標(biāo)的影響

測試模型中各個組件以及網(wǎng)絡(luò)設(shè)計(jì)的一些變化對模型性能的影響,結(jié)果如表4所示。

根據(jù)表4的數(shù)據(jù)可以得知,Dropout在降低過度擬合的風(fēng)險(xiǎn)、增強(qiáng)模型的泛化能力方面發(fā)揮了積極作用。另外,Layer Normalization(LN)的使用有助于減少不同樣本之間的浮動,提高模型的穩(wěn)定性和訓(xùn)練速度。數(shù)值表明,移除Dropout和LN都導(dǎo)致模型的總體性能下降,進(jìn)一步證明它們的存在對提高推薦模型的質(zhì)量起到關(guān)鍵作用。

此外,從LN中移除Q同樣會降低推薦性能。這是因?yàn)镼中包含了用戶的歷史記錄信息,而通過殘差操作將其添加到GRU輸入中有助于提升推薦性能。因此,可以看出Q的存在對于充分利用用戶的歷史信息、提高推薦性能至關(guān)重要。

3.5.3?? 雙流自注意力網(wǎng)絡(luò)層數(shù)對評估指標(biāo)的影響

圖3展示了雙流自注意力網(wǎng)絡(luò)不同層數(shù)的設(shè)置對模型推薦性能的影響。對網(wǎng)絡(luò)層數(shù)從1到4分別進(jìn)行了消融實(shí)驗(yàn),評估指標(biāo)采用NDCG@10。

根據(jù)圖3的觀察結(jié)果,可以得知增加雙流自注意力網(wǎng)絡(luò)的層數(shù)對模型整體性能的影響并不十分顯著。當(dāng)層數(shù)達(dá)到2時(shí),評估指標(biāo)達(dá)到峰值,相較于其他層數(shù)只有輕微的提升。這表明一層雙流自注意力網(wǎng)絡(luò)已經(jīng)能夠捕獲大部分的數(shù)據(jù)信息,而增加到兩層時(shí)信息挖掘的能力已經(jīng)趨于飽和。進(jìn)一步增加層數(shù)反而可能導(dǎo)致性能下降,說明層數(shù)的繼續(xù)增加并不會帶來額外的正面效果。

4???? 結(jié)論

本文提出的價(jià)格引導(dǎo)雙流自注意力序列推薦模型通過引入價(jià)格信息成功緩解了數(shù)據(jù)稀疏問題。該模型采用了兩個獨(dú)立的自注意力機(jī)制,分別處理價(jià)格信息和序列信息,以避免產(chǎn)生額外的噪聲。通過將自注意力機(jī)制和門控循環(huán)單元融合,分別學(xué)習(xí)交互序列的時(shí)間依賴性和不同位置的重要性,從而對長期依賴關(guān)系進(jìn)行有效的建模,最終提高了模型的個性化推薦能力。在三個真實(shí)數(shù)據(jù)集上的評價(jià)指標(biāo)相較于近期提出的基線模型均取得了顯著的提升。未來的工作將著重研究如何更好地捕獲用戶的短期興趣,并將其融入模型,以進(jìn)一步提升推薦性能。這個方向的深入研究將有助于模型更全面、準(zhǔn)確地理解用戶興趣動態(tài),從而更好地滿足個性化推薦的需求。

[參考文獻(xiàn)]

[1] 劉姍姍, 游健強(qiáng), 史家朋, 等. 網(wǎng)絡(luò)信息爆炸時(shí)代消費(fèi)行為決策的公眾評價(jià)效應(yīng)分析——以大眾點(diǎn)評為例[J]. 內(nèi)蒙古科技與經(jīng)濟(jì), 2022(13):64-66.

[2] 劉君良, 李曉光. 個性化推薦系統(tǒng)技術(shù)進(jìn)展[J]. 計(jì)算機(jī)科學(xué), 2020, 47(7):47-55.

[3] Linden G, Smith B, York J. Amazon. com recommendations: Item-to-item collaborative filtering[J]. IEEE Internet computing, 2003, 7(1):76-80.

[4] 于蒙, 何文濤, 周緒川, 等. 推薦系統(tǒng)綜述[J]. 計(jì)算機(jī)應(yīng)用, 2022, 42(6):1898-1913.

[5]? Steffen? Rendle,? Christoph? Freudenthaler,? Lars? Schmidt-

Thieme. Factorizing personalized Markov chains for next-basket recommendation[A]. Proceedings of the 19th International Conference on World Wide Web[C]. New York: Association for Computing Machinery, 2010: 811-820.

[6] Ashish V, Noam S, Niki P, et al. Attention Is All You Need[A]. Proceedings of the 31st International Conference on Neural Information Processing Systems[C]. Red Hook:Curran Associates Inc, 2017:6000-6010.

[7] Hidasi B, Karatzoglou A, Baltrunas L, et al. Session-based recommendations with recurrent neural networks[J]. arXiv preprint arXiv:1511.06939, 2015.

[8] Tang J, Wang K. Personalized top-n sequential recommendation via convolutional sequence embedding[A]. Proceedings of the Eleventh ACM International Conference on Web Search and Data Mining[C]. New York:Association for Computing Machinery, 2018: 565-573.

[9] Kang W C, McAuley J. Self-attentive sequential recommendation[A]. 2018 IEEE International Conference on Data Mining (ICDM)[C]. Singapore:IEEE, 2018:197-206.

[10] Sun F, Liu J, Wu J, et al. BERT4Rec: Sequential Recommendation with Bidirectional Encoder Representations?? from Transformer[A]. Proceedings of the 28th ACM International Conference on Information and Knowledge Management[C]. New York:Association for Computing Machinery, 2019:1441-1450.

[11] Li J, Wang Y, McAuley J. Time interval aware self-attention for sequential recommendation[A]. Proceedings of the 13th International Conference on Web Search and Data Mining[C]. New York:Association for Computing Machinery, 2020:322-330.

[12] Fan ZW, Liu ZW, Yu W, et al. Sequential Recommendation via Stochastic Self-Attention[A]. Proceedings of the ACM Web Conference 2022[C]. New York:Association for Computing Machinery, 2022:2036-2047.

[13] Ehsan Gholami, Mohammad Motamedi, Ashwin Aravindakshan. PARSRec: Explainable Personalized Attention-fused Recurrent Sequential Recommendation Using Session Partial Actions[A]. Proceedings of the 28th ACM SIGKDD Conference on Knowledge Discovery and Data Mining[C]. New York:Association for Computing Machinery, 2022: 454-464.