基于YOLOv7x的接觸網吊弦缺陷檢測方法

王曉明 陳智宇 董文濤 姚道金 黃貽鳳

收稿日期:2023?08?28

基金項目:國家自然科學基金項目(52165069);江西省教育廳科技項目(GJJ2200621)

文章編號:1005-0523(2024)03-0065-09

摘要:【目的】針對鐵路運行時由于接觸網吊弦缺陷造成的安全隱患問題,提出一種基于改進YOLOv7x的接觸網吊弦缺陷識別方法。【方法】首先在主干特征提取層的末端引入Swin Transformer網絡替換原有的擴展高效層聚合網絡模塊,提高網絡掌握全局信息的能力,再引用SIoU(SCYLLA-IoU)損失函數替換原網絡的損失函數,為預測框收斂過程添加方向懲罰機制,最后使用coordinate attention(CA)注意力機制融合頸部層中的擴展高效層聚合網絡模塊,增強頸部網絡模塊的全局感受野。【結果】仿真結果表明,此改進算法訓練出的模型精度達到95.9%,相較于原YOLOv7x算法檢測精度提高了4.7%,檢測速度也達到了52 幀/s。【結論】改進算法解決了在吊弦缺陷識別領域檢測效率低下的問題,在實際作業中能夠提高接觸網吊弦缺陷排查工作的效率。

關鍵詞:接觸網吊弦缺陷檢測;YOLOv7x;Swin Transformer;SIoU損失函數;CA

中圖分類號:U225.4 文獻標志碼:A

本文引用格式:王曉明,陳智宇,董文濤,等. 基于YOLOv7x的接觸網吊弦缺陷檢測方法[J].華東交通大學學報,2024,41(3):65-73.

Detection Method of Catenary Hanging String Based on YOLOv7x

Wang Xiaoming1, Chen Zhiyu1, Dong Wentao1, Yao Daojin1, Huang Yifeng2

(1. School of Electrical and Automation Engineering, East China Jiaotong University, Nanchang 330013, China;

2. School of Civil Engineering and Architecture, East China Jiaotong University, Nanchang 330013, China)

Abstract: 【Objective】Aiming at the potential risk caused by overhead contact wire defects during railway operation, an improved YOLOv7x method for overhead contact wire defect identification is proposed. 【Method】Firstly, Swin Transformer network is introduced at the end of the backbone feature extraction layer to replace the original extended and efficient layer aggregation network module, so as to improve the ability of the network to grasp global information. Then the SIoU(SCYLLA-IoU) loss function is used to replace the original network loss function, and the direction penalty mechanism is added to the convergence process of the prediction frame. Finally, CA is integrated with the extended and efficient layer aggregation network module to enhance the global receptive field of the neck network module. 【Result】Experimental simulation results show that the accuracy of the model trained with the improved algorithm reaches 95.9%, which is 4.7% higher than that of the original YOLOv7x algorithm, and the detection speed reaches 52 frames per second. 【Conclusion】The improved algorithm solves the problem of low detection efficiency in hanging strings defect identification, which may improve the efficiency of detection of hanging strings defect in practice.

Key words: detection of catenary hanging string defects; YOLOv7x; Swin Transformer; SIoU loss function ; CA

Citation format: WANG X M, CHEN Z Y, DONG W T, et al. Detection method of catenary hanging string based on YOLOv7x[J]. Journal of East China Jiaotong University, 2024, 41(3): 65-73.

【研究意義】接觸網是高速鐵路的重要組成部分,受電弓通過接觸網完成對列車的電力輸送,接觸網的各部分狀態的好與壞時時刻刻影響著鐵路的運行安全。吊弦作為接觸網重要的一部分,對輸電線路起到承重與支撐的作用,吸收和緩沖承力索及定位點所受的振動沖擊,一旦發生斷裂,將導致接觸網幾何參數發生變化,影響列車安全運行[1-2],因此對吊弦狀態進行常態化檢測是必要的。

【研究進展】往年一般采用人工對接觸網各部分進行檢測,這項檢測方式十分耗費人力物力,檢查效率也不盡如人意,而機器視覺作為當前熱門技術,在許多領域都有應用這項先進技術解決檢測難題的高質量論文,同時也有許多學者將此技術帶到了接觸網缺陷檢測方面。如Han等[3]提出一種基于YOLOX的針對絕緣子缺陷檢測的視覺檢測算法,屈志堅等[4]提出一種基于YOLOv3的針對接觸網鳥巢檢測與識別的檢測方法。基于深度學習的目標檢測算法由于具有良好的泛化能力和從復雜背景中提取特征的能力,在接觸網缺陷檢測領域得到廣泛應用。應用于接觸網目標檢測的算法一般分為兩類:一階段算法(One-state)和二階段算法(Two-state)。二階段目標檢測算法大多使用RPN(region proposal network)來減少復雜背景對目標及其缺陷檢測的干擾。其主要流程是對圖像先進行區域生成,再通過卷積神經網絡進行樣本分類。劉杰等[5]提出使用Faster R-CNN神經網絡模型對吊弦缺陷圖片數據進行訓練。Tan等[6]提出了基于Faster R-CNN算法的吊弦缺陷檢測模型,實現了吊弦的定位和識別以及彎曲松弛和斷裂吊弦的故障檢測。【關鍵問題】雖然上述二階段改進算法可以使接觸網部件檢測的檢測精度達到很可觀的數值,但效率低、速度慢的問題是不容忽視的。

一階段目標檢測代表算法有YOLO系列和SSD等。它可以通過單次檢測生成物體的位置坐標和類別概率,能夠快速準確地完成檢測任務。張姝等[7]提出一種利用SSD定位并識別巡檢圖像中螺栓缺陷的檢測方法,雖然SSD檢測算法在速度上有很大提升,但是犧牲了過多的精度,并不適合用于缺陷排查。顧桂梅等[8]提出使用Transformer模塊替換原YOLOv5s算法主干網絡末端的C3模塊,以此來強化主干網絡的全局特征信息提取能力,但該模塊自注意力計算方式會帶來龐大的計算量,給模型檢測速度帶來較大影響。上述方法相較于二階段目標檢測方法能夠提升檢測速度,但是在檢測精度上還有提升空間。

【創新特色】基于以上提到的不足,提出一種基于改進YOLOv7x的接觸網吊弦缺陷檢測方法;引入新的骨干網絡Swin Transformer替換主干特征提取層末端的擴展高效層聚合網絡(extended efficient layer aggregation networks,ELAN)模塊,通過自注意力的計算以此來提高模型的檢測精度。引入SIoU(SCYLLA-IoU)損失函數替換YOLOv7x所采用的CIoU(Complete-IoU),在原有的基礎上引入了方向懲罰機制,相較于網絡原損失函數CIoU提高了訓練效率。最后在網絡的頸部層引入CA(coordinate attention)注意力機制,加強了通道與通道之間的聯系。原網絡經過改進后能夠有效提高檢測精度。

1 YOLOv7x算法原理

YOLO是當前目標檢測領域最優算法之一,具有檢測速度快、檢測精度高且滿足實時性的優勢。而YOLOv7[9]作為目前YOLO最先進的目標檢測算法,在5~160 FPS(frames per second)的范圍內,其速度和精度已經超過了所有的物體檢測器。YOLOv7x在YOLOv7的基礎上進行了模型縮放,使得訓練后的模型精度更高。

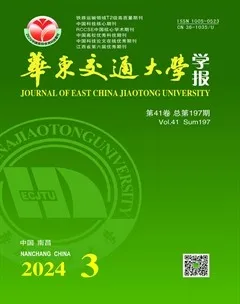

YOLOv7x網絡分別由輸入層,主干特征提取層和頸部層組成。主干特征提取層由多個不同參數的卷積標準化激活函數和池化函數拼接而成,用來提取輸入的圖像特征。該層主要的兩個模塊ELAN與MPConv的結構如圖1(a),圖1(b)所示。頸部層不同于主干特征提取層多了池化模塊(SPPCSPC)、反卷積模塊(Unsample),如圖1(c)所示。

該層通過上采樣和下采樣將不同層次的特征圖融合在一起,生成具有多尺度信息的特征圖,以此來提高檢測的準確率。經過上述一系列卷積和最大池化后向檢測頭部分輸出3種不同尺度的特征圖像,與已經標注好的圖片數據進行對比,計算出此輪訓練的損失函數,損失函數包括:定位損失、分類損失、置信度損失。根據訓練情況調整模型參數,從而使模型更加精確。

2 YOLOv7x的改進

針對YOLOv7x網絡結構提出以下幾點改進。

1) 引入Swin Transformer網絡替換主干特征提取層底部的ELAN模塊,以犧牲些許檢測速度的代價來提高模型的檢測精度。

2) 替換網絡原有的損失函數CIoU為SIoU,有助于模型快速收斂,提高模型的訓練效率與檢測精度。

3) 在頸部層添加CA注意力機制,增強網絡模型特征學習能力能夠提升模型精度,且參數量少不會帶來過多的計算量。

在原YOLOv7x網絡基礎上改進后的網絡框架如圖2所示。

2.1 替換新骨干網絡Swin Transformer

由于YOLOv7x缺乏獲取全局信息的能力,網絡提取目標特征的能力也會相應減弱[10],為彌補這方面不足,在原骨干網絡末端引入新的模塊SWT(swin transformer),SWT是Liu等[11]提出的一種新的視覺轉換器,它是基于VIT(vision transformer)改進后提出的一種具有多頭自注意力機制的計算方法,SWT的網絡如圖3所示。

該網絡使用多個自注意力層來代替YOLOv7x中的部分空間卷積層,網絡通過多頭自注意力計算能夠獲得更多的上下文信息、建立全局的依賴關系,擴大圖像的感受野[12]。不同于Transformer在整個圖像中計算全局自注意力,計算復雜程度如式(1)所示,SWT首先使用了類似于卷積操作的層次化構建方法,將特征圖劃分為多個不重疊式的“小窗口”,在每個小窗口內計算自注意力,如圖3中的W-MSA(window multi-head self-attention)多頭自注意力模塊,該方法計算復雜程度如式(2)所示。

[θMSA=4hwC2+2(hw)2C] (1)

[θW-MSA=4hwC2+2M2hwC] (2)

式中:[M2]為[M*M]像素大小的小窗口;C為特征圖深度。

可見在實際計算過程中,如果圖片為640*640的大小,全局自注意力計算方式的計算量將非常龐大,在局部窗口內分別計算自注意力可以大大減少計算量。但是如果只是僅在每個獨立的小窗口單獨計算各自的自注意力會限制了網絡建模能力,無法為網絡提供完整的全局感受野。圖3中SW-MSA(shift-window multi-head self-attention)多頭自注意力模塊解決了該缺陷,算法流程如圖4所示。圖4(a)對窗口進行移動得到了圖4(b),過程可以看作每個小窗口向右側和下方移動了[M/2]個像素,之后通過平移分割后的小窗口得到圖4(c),合并相鄰同大小的小窗口,這樣又和圖4(a)一樣是4個M*M像素大小的窗口。這種方式既能夠使小窗口之間互相通信,打破獨立窗口對全局建模的限制,也能保證計算量不變。之后在自注意力計算時通過掩碼的方式隔絕不同區域的信息,計算完成后復原圖片,至此完成了SW-MSA多頭自注意力計算操作。

SWT在計算網絡的自注意力時需要對每個頭部添加相對位置偏執B為

[Attention(Q,K,V)=softmax(QKtdk+B)V] (3)

式中:[B∈RM2+M2];[Q,K,V∈RM2×d]分別為查詢、鍵和值向量矩陣;[d]為查詢向量矩陣維度;[M2]為每個小窗口的像素。

2.2 替換損失函數SIoU

損失函數是模型改進與優化的重要指標,針對不同模型選取一個合適的損失函數可以優化模型訓練效果。在實際檢測過程中,預測框的少量偏移與縮放對模型的精度都會有很大影響。YOLOv7x采用的是CIoU損失函數,相較于IoU、GIoU、DIoU損失函數加入了長寬比的懲罰項,但該損失函數收斂并沒有考慮到預測框與目標框之間相對方向的因素,這樣會使預測框在訓練的過程中盲目運動從而使得模型收斂速度變慢效率變低。而吊弦缺陷識別模型需要訓練大量圖像數據,若在訓練過程中預測框無法高效率的收斂,將會造成大量的資源浪費并可能導致最終訓練出的模型效果變差。針對這種問題本網絡引入損失函數SIoU[13],該損失函數基于CIoU損失函數引入了方向懲罰機制,在預測框收斂過程中將所需回歸之間的向量角度納入考量標準,這樣能夠有效控制預測框回歸的自由度,相較于其他損失函數提高了訓練效率。SIoU損失函數方向懲罰機制原理如圖5所示,將預測框與目標框放在坐標軸上,圖中B方塊為預測框,BGT為目標框。

為解決預測框在訓練過程盲目運動的問題,收斂過程首先嘗試最小化[α],如果[α≤π4],則最小化[β=π2-α]。為了實現這一點,引入損失函數,定義角度損失[Λ]為

[Λ=1-2×sin2arcsinx-π4] (4)

式中:[x=Chσ=sinα];[σ=(bgtcx-bcx)2+(bgtcy-bcy)2];[Ch=max(bgtcy,bcy)-min(bgtcy,bcy)]。

由于角度損失的變化,需重新定義距離損失,距離損失公式為

[Δ=t=x,y(1-e-γρt)] (5)

式中:[ρx=(bgtcx-bcxcw)2];[ρy=(bgtcy-bcych)2];[γ=2-Λ]。

預測框形狀損失函數定義為

[Ω=t=w,h(1-e-ωt)θ] (6)

式中:[ωw=w-wgtmax(w,wgt)];[ωh=h-hgtmax(h,hgt)]。形狀損失函數中的[θ]是一個非常重要的自定義參數,該參數控制著對形狀損失的注意力程度,將[θ]的值設置為4。

整體SIoU損失函數定義為

[Lbox=1-IoU+Δ+Ω2] (7)

式中:[IoU=B?BGTB?BGT]。

2.3 添加注意力機制CA

在視覺神經網絡模型訓練中,計算機需要處理大量圖像數據,但每張圖片信息中只有一部分是模型訓練所需要的,盲目訓練使得計算機資源浪費,訓練效率下降。為解決這類問題,采用向YOLOv7x網絡引入注意力機制的方法來提高模型的訓練效率。目前流行的注意力機制有SENet,CBAM等。CBAM不僅像SENet一樣考慮了特征通道之間的關系,還同時考慮了特征通道的位置信息,但CBAM利用位置信息的方法是通過減少輸入通道數,然后通過一次卷積計算空間注意力,如圖6(a)所示。卷積函數只能捕獲局部關系,沒有提取長距離間依賴關系的功能,長距離間關系對視覺模型訓練任務是至關重要的。

為讓模型訓練時充分利用到通道與通道之間以及更遠距離間的聯系,引入CA注意力機制[14],它的工作結構主要分為坐標信息嵌入和坐標注意力兩部分。該注意力機制可以通過將位置信息嵌入到通道注意力機制中,使網絡能夠捕獲大范圍的位置信息而不會帶來過多的計算量,結構如圖6(b)所示。而且CA注意力機制方法輕便,易于插入到YOLOv7x網絡結構中。

注意力機制CA不同于SE,首先將全局池轉化為一維特征編碼,經過輸入給定X,沿水平坐標以及垂直坐標兩個方向聚合特征,生成方向感知圖。通道a高度為h的輸出可以表示為式(8),同理可得通道a寬度為w的輸出可以表示為式(9)。如下

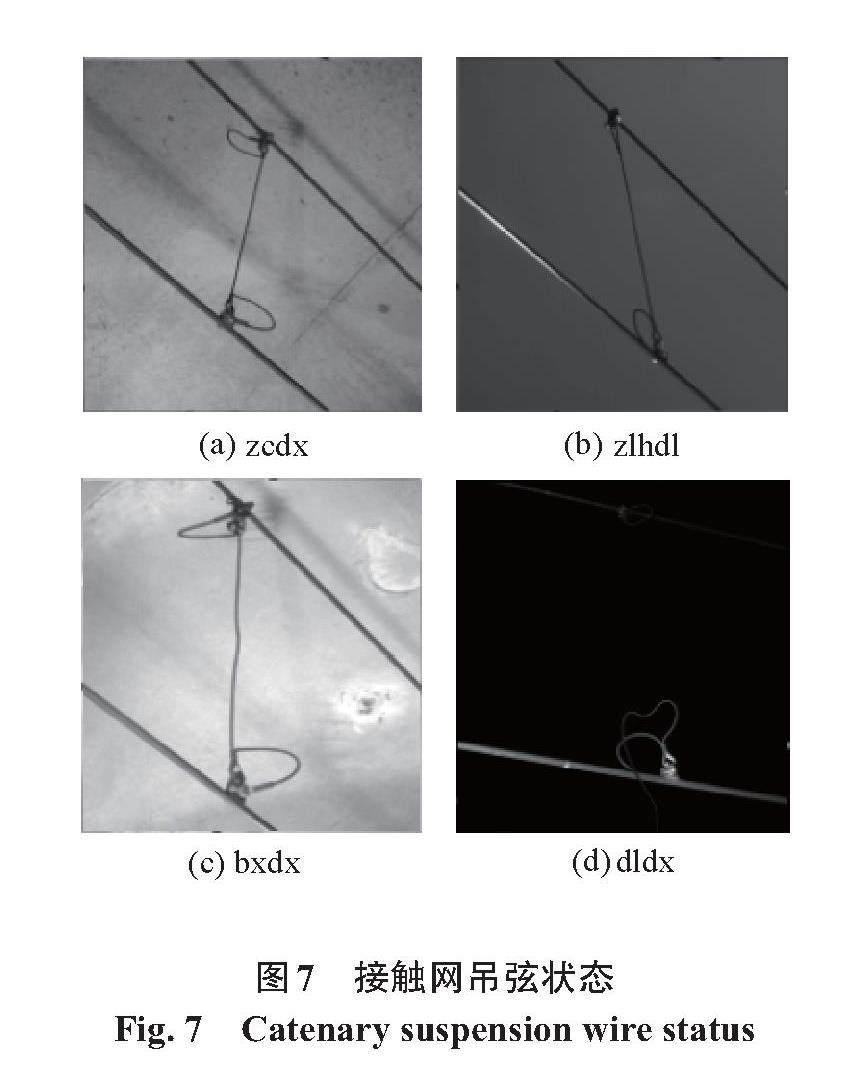

[zhc(h)=1W0≤i [zwc(w)=1H0≤j 式中:W與H分別為水平和垂直兩個空間范圍的極值。 3 實驗結果及分析 3.1 實驗環境 為驗證本文改進算法的可行性,本文的對比實驗是在同一個環境下進行,編譯環境為Pytorch,CPU型號為Intel(R) Xeon(R) Platinum 8157 CPU @ 2.30 GHz,GPU型號為NVIDIA GeForce RTX 3090 24 GB顯存,運行內存為86 GB。 3.2 實驗數據集來源及預處理 本實驗數據集來源于南昌鐵路局使用軌道檢測車裝置拍攝接觸網各零件的高清圖像集,分辨率為5 120*5 120,其中包含吊弦的圖片一共有1 600張,通過LabelImg軟件對圖片進行標注。本文主要將吊弦狀態分為正常吊弦(zcdx)、載流環斷裂(zlhdl),變形吊弦(bxdx)和斷裂吊弦(dldx)共4種,如圖7所示。由于變形吊弦與斷裂吊弦的圖像數量較少,為提高模型的泛化能力以及防止模型過擬合,在模型訓練前通過數據增強方法,使各類型吊弦圖像數量比例合理。按照8:1:1的比例隨機劃分出訓練集,測試集和驗證集供模型訓練。 3.3 實驗設計及評價指標 為證明本文網絡改進后在模型性能上有相應的提升,本實驗進行以下消融實驗。通過模型訓練獲得的[mAP@0.5](mean average precision)來作為評判模型精確度的標準,訓練出的模型每秒檢測出的圖片數量作為該訓練模型檢測速度評判標準,用FPS(frames per second)表示。輸入圖像分辨率設置為640*640。訓練輪次為200,步長設置為16,各實驗結果如表1所示。表1中,√代表采用該改進方法,?代表未采用該改進方法。 由消融實驗結果可以證實:① 在YOLOv7x的主干網絡末端替換SWT后,模型精度增加3.3%,檢測速度也相應的減少了3幀,這樣的結果符合前文介紹所提到的SWT替換網絡后的效果;② 在替換新的網絡損失函數SIoU后,檢測精度增加0.4%且檢測速度大致不變,可見在添加新的方向懲罰機制后能夠在不增加計算量的同時優化模型推理過程,提高檢測精度;③ 在頸部網絡的ELAN模塊融合CA注意力機制后相較于原網絡精度增加1.5%,檢測速度降低4幀,符合預期。改進后的算法相較于原YOLOv7x算法檢測速度略微降低6幀,但是檢測精度增加4.7%。圖8是本文改進算法與原YOLOv7x算法分別訓練200輪次的檢測精度隨訓練輪次變化的曲線對比圖,兩種算法在85輪訓練后精度都趨于穩定,原始算法[mAP@0.5]在91%左右趨于穩定,最優效果達到的91.2%,改進后的算法[mAP@0.5]穩定在95.6%左右,效果最好達到95.9%,由圖8可知兩種算法沒有出現過擬合或欠擬合現象且本文改進后算法要優于原始算法。 為證實本文算法的優越性,本實驗選取熱門目標檢測算法Faster R-CNN、SSD和YOLOv5s與本文改進后效果進行對比實驗,模型評判標準依舊不變,[mAP@0.5]作為模型的精度標準,FPS作為模型的檢測速度標準。訓練結果如表2所示。 由實驗結果可以得出,二階段檢測算法在檢測速度上要遠低于一階段檢測算法,但是在檢測精度上要優于一階段檢測算法。YOLOv5s和SSD算法在速度上要優于YOLOv7x算法,原因在于YOLOv7x網絡結構更復雜,運算量更大,所以YOLOv7x在精度上要高于YOLOv5s及SSD。 為了驗證實驗結果的可靠性,分別采用表2中的5種算法訓練出的模型權重檢測同一組的圖片,結果如圖9所示。 由圖9檢測結果可知,本文改進算法在檢測置信度上要高于其他一階段目標檢測算法,檢測部分圖片的置信度要高于二階段目標檢測算法,而且由表2可知本文檢測算法在檢測速度上要遠高于二階段目標檢測算法。本文改進后的算法在檢測精度上有明顯優勢,檢測速度達到了可觀的效果。結合以上幾點,本文的改進算法更適合完成鐵路上的接觸網吊弦缺陷檢測任務。 4 結論 1) 通過在原網絡的主干特征提取層底部使用Swin Transformer模塊替代ELAN模塊,并在頸部層添加CA注意力機制,以及使用SIoU替換原網絡的損失函數,可以改善模型并提高檢測精度。 2) 實驗結果顯示,經過改進的YOLOv7x網絡的檢測精度達到了95.9%,相較于原網絡提高4.7%。在檢測速度方面達到了52 幀/s,領先于其他目標檢測算法。 3) 研究結果表明,改進算法在檢測效率上有很大提升,滿足了接觸網吊弦缺陷檢測的實時性需求。 參考文獻: [1]?? 吳文江, 李響, 高占鳳, 等. 基于有限元法的高速鐵路接觸網吊弦動態特性研究[J]. 鐵道學報, 2020, 42(7): 65-72. WU W J, LI X, GAO Z F, et al. Research on dynamic characteristics of dropper of high-speed railway catenaries based on finite element method[J]. Journal of the China Railway Society, 2020, 42(7): 65-72. [2]?? 洪曉斌,何永奎,周建熹,等.承力索錨結線夾絞線區域損傷的超聲導波監測[J].華南理工大學學報(自然科學版),2017,45(5):1-8. HONG X B, HE Y K, ZHOU J X, et al. Ultrasonic-guided wave monitoring for strands damage in anchor clamp zone of messenger wire[J]. Journal of South China University of Technology (Natural Science Edition), 2017, 45(5): 1-8. [3]?? HAN G J, LI T, LI Q, et al. Improved algorithm for insulator and its defect detection based on YOLOX[J]. Sensors, 2022, 22(16): 6186. [4]?? 屈志堅, 高天姿, 池瑞, 等. 基于改進的YOLOv3接觸網鳥巢檢測與識別[J].華東交通大學學報, 2021, 38(4): 72-80. QU Z J, GAO T Z, CI R. Detection and recognition of bird nests in overhead catenary systems based on improved YOLOv3[J]. Journal of East China Jiaotong University, 2021, 38(4): 72-80. [5]?? 劉杰, 許建國, 高春麗, 等. 基于機器視覺的接觸網吊弦缺陷檢測研究[J]. 鐵道工程學報, 2022, 39(5): 91-97. LIU J, XU J G, GAO C L, et al. Machine vision-based research on the inspection of dropper defects of overhead contact line[J]. Journal of Railway Engineering Society, 2022, 39(5): 91-97. [6]?? TAN P, LI X F, WU Z G, et al. Multialgorithm fusion image processing for high speed railway dropper failure–defect detection[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2021, 51(7): 4466-4478. [7]?? 張姝, 王昊天, 董驍翀, 等. 基于深度學習的輸電線路螺栓檢測技術[J]. 電網技術, 2021, 45(7): 2821-2829. ZHANG S, WANG H T, DONG X C, et al. Bolt detection technology of transmission lines based on deep learning[J], Power System Technology, 2021, 45(7): 2821-2829. [8]?? 顧桂梅, 賈耀華, 溫柏康. 基于YOLOv5s的接觸網吊弦線和載流環缺陷識別算法[J]. 鐵道科學與工程學報, 2023, 20(3): 1066-1076. GU G M, JIA Y H, WEN B K. Defect identification algorithm of dropper line and current-carrying ring of catenary based on YOLOv5s[J]. Journal of Railway Science and Engineering, 2023, 20(3): 1066-1076. [9]?? WANG C Y, BOCHKOVSKIY A, LIAO H Y M, et al. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]// Vancouver: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2023. [10] LU S L, LIU X Y, HE Z X, et al. Swin-Transformer-YOLOv5 for real-time wine grape bunch detection[J]. Remote Sensing, 2022, 14(22): 5853. [11] LIU Z, LIN Y T, GAO Y, et al. Swin Transformer: Hierarchical bision transformer using shifted windows[C]//Montreal: Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021. [12] NIU Z, ZHONG G, YU H. A review on the attention mechanism of deep learning[J]. Neurocomputing, 2021, 452: 48-62. [13] GEVORGYAN Z. SIoU loss: More powerful learning for bounding box regression[EB/OL]. (2022-05-25)[2023-08-28)]. https://doi.org/10.48550/arXiv.2205.12740. [14] HOU Q B, ZHOU D Q, FENG J S, et al. Coordinate attention for efficient mobile network design[C]// Nashville: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021. 第一作者:王曉明(1978—),男,副教授,碩士生導師,研究方向為人工智能,機器視覺,柔性傳感器,物聯網技術及應用。E-mail:2501@ecjtu.edu.cn。 通信作者:董文濤(1987—),男,副教授,碩士生導師,研究方向為傳感器與智能檢測。E-mail:wentao_dong@163.com。