可信的圖神經網絡節點分類方法

徑向基函數計算節點間距離,得到各類節點質心后,根據距離分配與未標記節點最近質心的類別標簽提高節點分類性能,同時定義未標記節點和質心之間的距離為模型輸出的不確定性,并使用梯度懲罰損失加強輸入變化的可檢測性,可以有效地檢測分布外節點樣本。在Cora、Citeseer 和Pubmed 這3 個公開網絡數據集上的結果表明:模型在分類任務的AUROC 指標分別達到81.5%、76.2%和74.6%,在分布外樣本檢測任務中AUROC 指標分別達到83.6%、72.8%和70.6%,證明了所提算法在提高節點分類性能的同時,可以有效檢測分布外的節點樣本,提高了節點分類的可信性。

關鍵詞: 圖神經網絡;節點分類;分布外檢測;不確定性估計;梯度懲罰

中圖分類號:TP183 文獻標志碼:A 文章編號:1671-024X(0024)01-0082-07

Node classification method based on trusted graph neural network

LIU Yanbei1,2,MA Xiran3,WANG Wen1,2

(1. School of Life Sciences,Tiangong University,Tianjin 300387,China;2. Tianjin Key Laboratory of Optoelectronic De-

tection Technology and System,Tiangong University,Tianjin 300387,China;3. School of Electronics and Information

Engineering,Tiangong University,Tianjin 300387,China)

Abstract:In order to study the influence of uncertainty of node feature representation on node classification,a nodeclassification method based on trusted graph neural network was proposed. The algorithm used the radial basisfunction to calculate the distance between nodes,and after obtaining the centroid of various nodes,the classifi-cation label of the nearest centroid was allocated according to the distance to improve the classification performa-nce. Additionally, the distance between unlabeled nodes and centroids is defined as the uncertainty of the model憶soutput. A gradient penalty loss is employed to strengthen the detectability of input variations,loss to strengthenthe detectability of input changes,which can effectively detect the distributed outer node samples. The results inclassification task are 81.5%,76.2% and 74.6% in terms of AUROC on three public network datasets of Cora,Citeseer and Pubmed,respectively. And the results in the out-of-distribution sample detection task are 83.6%,72.8% and 70.6% in terms of AUROC on three public network datasets of Cora,Citeseer and Pubmed,respectively. It proves that the proposed algorithm can effectively detect the node samples outside the distributionand improve the credibility of node classification,while improving the node classification performance.

Key words:graph neural network; node classification; extra-distribution detection; uncertainty estimation; gradient penalty

圖在日常生活中廣泛存在,且作為一種靈活的數據形式可以表示不同特征對象之間復雜的連接關系,例如交通網絡、社交網絡、生物化學網絡等。由于圖可以包含較多的數據信息,例如節點的屬性信息和鏈接信息,導致圖數據相對復雜,因此對圖數據進行分析具有一定的挑戰。近年來,圖神經網絡(GNN)[1-2]在數據分析方面受到了極大的關注,逐漸成為學術界的一個熱點研究領域。圖數據的分析任務包括了節點分類[3-4]、圖分類[5-6]、鏈接預測[7]等。在圖節點分類任務中,輸入1個圖,模型根據學習輸入節點和類別標簽的對應關系,預測未知節點的類別標簽。盡管圖神經網絡在半監督節點分類方面表現優異,但圖神經網絡分類器不僅需要得到準確的預測值,更需要得到可信或者低不確定的預測值,其中可信性[8]是指模型能夠檢測出分布外樣本數據的能力。對于測試數據中沒有參與訓練的樣本數據模型給出一個較高置信度的預測值,這意味著模型是不可信的,但現有模型往往對沒有參與訓練的樣本數據給出較高的置信度,因此現有模型往往具有較大的不確定性[9]。

有效地估計不確定性在許多重要的應用中仍然是一個懸而未決的問題,例如在強化學習領域[10]中探索不確定性,在主動學習中選擇數據點以獲得標簽從而估計不確定性[11]。到目前為止,深度學習中估計不確定性的大多數方法±賴于深度集成(deep ensemble)[12]或蒙特卡羅采樣(Monte Carlo dropout)法[13]。Kendall 等[14]提出了一個貝葉斯深度學習框架應用于回歸任務和分類任務的同時估計任意不確定性和認知不確定性。Malinin 等[15]就訓練數據和測試數據分布之間的分布不匹配問題定義了分布不確定性。Gal 等[16]在貝葉斯神經網絡中得到認知不確定性時使用了Dropout 變分推理進行近似推理,此思想和DropEdge 模型[17]的思想是類似的。但上述模型估計的不確定性在分布外樣本檢測任務上仍然存在缺陷。

本文提出了一種可信的圖神經網絡節點分類算法。該模型能夠估計單次前向傳播中的不確定性,所得出的不確定性既可以獲得未標記節點與質心間的距離度量,還能夠檢測出分布外的數據,從而有效提高分類模型的可信性。具體地講,模型由圖神經網絡模型、質心模塊以及徑向基函數(RBF)[18]模塊組成,首先,輸入的圖數據經過一個基礎編碼器進行特征學習,質心由所得特征向量中有標簽的節點樣本獲得。其次,特征向量中未標記節點利用核函數獲得與質心的距離度量從而判斷其所屬類別標簽,其中具有核函數的模塊被稱為徑向基函數(RBF)模塊。特征向量和質心之間利用RBF 模塊預測獲得的距離定義為不確定性。本文模型方法是利用未標記節點與錯誤質心的距離最大化,與正確質心的距離最小化進行訓練的,以此來拉近和正確質心之間的距離,將節點特征放在距離正確質心較近的區域。然而,未訓練節點數據的任何信息如果輸入到模型中,無論節點數據有無標簽,都將導致特征崩塌現象(分布外數據會映射到分布內的特征表示中) 的發生,也就是分布外的節點樣本進入分布內節點樣本的嵌入表示中。因此,為了避免特征崩塌的發生,本模型加入了梯度懲罰損失項,這可以確保模型對輸入的特征向量變化足夠敏感并可靠地檢測出分布外的樣本數據。

本文的工作如下:

(1)本文研究了圖節點分類的可信性問題,提出了一種結合度量距離的徑向基函數和梯度懲罰損失的圖神經網絡模型,模型通過度量距離獲得的不確定性以提高模型分類的可信性,該工作能夠提高分類準確率,有效檢測分布外的圖節點數據。

(2)本文所提算法建立在RBF 模塊度量距離的思想上,采用一種新的損失函數來進行訓練,通過使用梯度懲罰來加強輸入變化的可檢測性,抑制輸入變化。

(3)為了驗證模型的分類性能和分布外樣本檢測性能,使用3 個圖公開數據集完成2 類實驗。另外,將所提出框架的性能與其他現有的框架進行比較,驗證本模型算法的性能指標有所提高。

1 模型建立

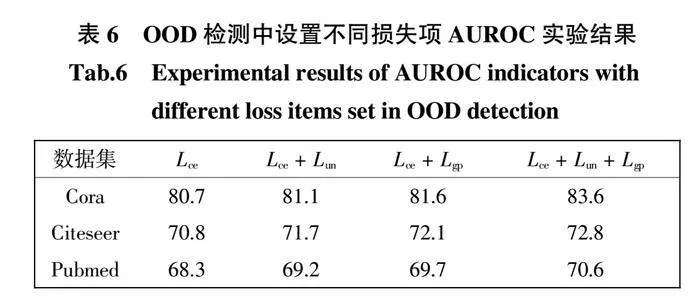

本文研究了一個通過可信的神經網絡模型進行圖數據分類的方法,模型框架如圖1 所示。模型主要由3 個部分組成,分別是圖卷積神經網絡(GCN)[1]基礎編碼器部分、質心獲取模塊和RBF 模塊,其中的工作重點是后2 個模塊,也就是圖1 中紅色。虛線框所標模塊。輸入的圖數據經過GCN 得到節點的嵌入表示,其中有標簽的特征向量經過求平均值的計算獲得每類節點的質心,RBF 模塊計算未標記節點與質心的距離度量,同時將所求距離定義為不確定性。最終區分所有無標簽的節點,賦予未標記節點對應的類別標簽從而歸到所屬類別。

2 實驗結果與分析

2.1 數據集

本文選擇了3 個引文網絡圖數據集驗證所提模型在分類任務和分布外(OOD)樣本檢測任務上的有效性,分別為Cora、Citeseer 和Pubmed[22],表1 為節點分類任務數據集的相關信息設置情況,表2 為OOD檢測任務的數據集信息設置情況。

表1 中數據集都是引文網絡數據集,其中節點表示文獻,邊是文獻之間的引用關系,這意味著當A 文獻引用B 文獻時存在邊,反之亦然。為了簡單起見,數據集不區分邊連接的方向,將引文的連接視為無向邊,并構造一個二進制對稱鄰接矩陣,且訓練集每個類有20 個節點標有它所屬的類別,即每類20 個節點具有標簽。

對于基于半監督節點分類的OOD 檢測任務,每個數據集隨機選取1~3 個類別作為OOD 類別,僅使用未被選取的剩余類別節點對模型進行訓練。在這種情況下,訓練了一個用于半監督節點分類任務的模型,其中只有部分類別節點沒有用于訓練,即模型沒有訓練OOD 類別,所以模型只輸出參與訓練的類別的表示。例如,Cora 數據集中使用4 類和80 個節點訓練模型,測試樣本中類別有7 類節點數量有1 000個,其中有3 類分布外(OOD)樣本,4 類分布內(ID)樣本。OOD 占比率是所有測試節點中OOD 節點的所占比率。

2.2 基準

本文對所提出的模型和幾個基線模型進行對比和性能分析,基準模型同樣可以獲得不確定性,所選對比模型如下:

(1)GCN[1]。它是一種半監督圖卷積神經網絡模型,能夠聚集來自鄰居節點的輸入信息以學習節點表示。過程大致是輸入的特征矩陣和鄰接矩陣通過兩層圖卷積,輸出特征向量通過softmax 分類器估計類別信息;

(2)Drop-GCN。它通過將Monte Carlo dropout[16,23]和GCN 模型相結合的方法獲得不確定性,Monte Carlodropout 是將神經網絡中dropout 訓練作為高斯過程中的近似貝葉斯推理。此理論是用dropout 網絡對不確定性進行建模,從現有模型中提取信息,這樣有效緩解了深度學習中估計不確定性的問題。

(3)EDL-GCN。它通過將EDL 模型[24]和GCN 相結合的方法估計不確定性,EDL 模型使用主觀邏輯理論對不確定性建模,由于類別概率是通過狄利克雷分布求得的,因此將神經網絡的預測作為主觀意見并通過確定性的神經網絡訓練模型從數據中估計和獲得不確定性。

(4)DPN-GCN。它通過將DPN[25]模型和GCN 相結合的方法估計不確定性。DPN 模型是一種新的預測不確定性的建模框架,它主要針對分布不確定性建模。

2.3 實驗設置

在實驗部分,本文考慮了4 個基線算法。對于GCN、Drop-GCN、EDL-GCN、DPN-GCN 使用了與GCN[1]相同的超參數。實驗采用兩層GCN 作為主要的圖編碼器,模型使用Glorot[26]進行初始化,使用Adam 優化器[27]以0.01 的學習率訓練迭代200 次對模型進行優化,圖編碼器和預測器的潛在維度設置為16。Drop-GCN 設置蒙特卡羅采樣次數為100 次,丟失率設置為0.5。為了防止實驗具有偶然性,實驗時當測試結束獲得相應的結果指標,記錄下10 次測試結果取得平均數值作為最終模型精度。

2.4 分類實驗

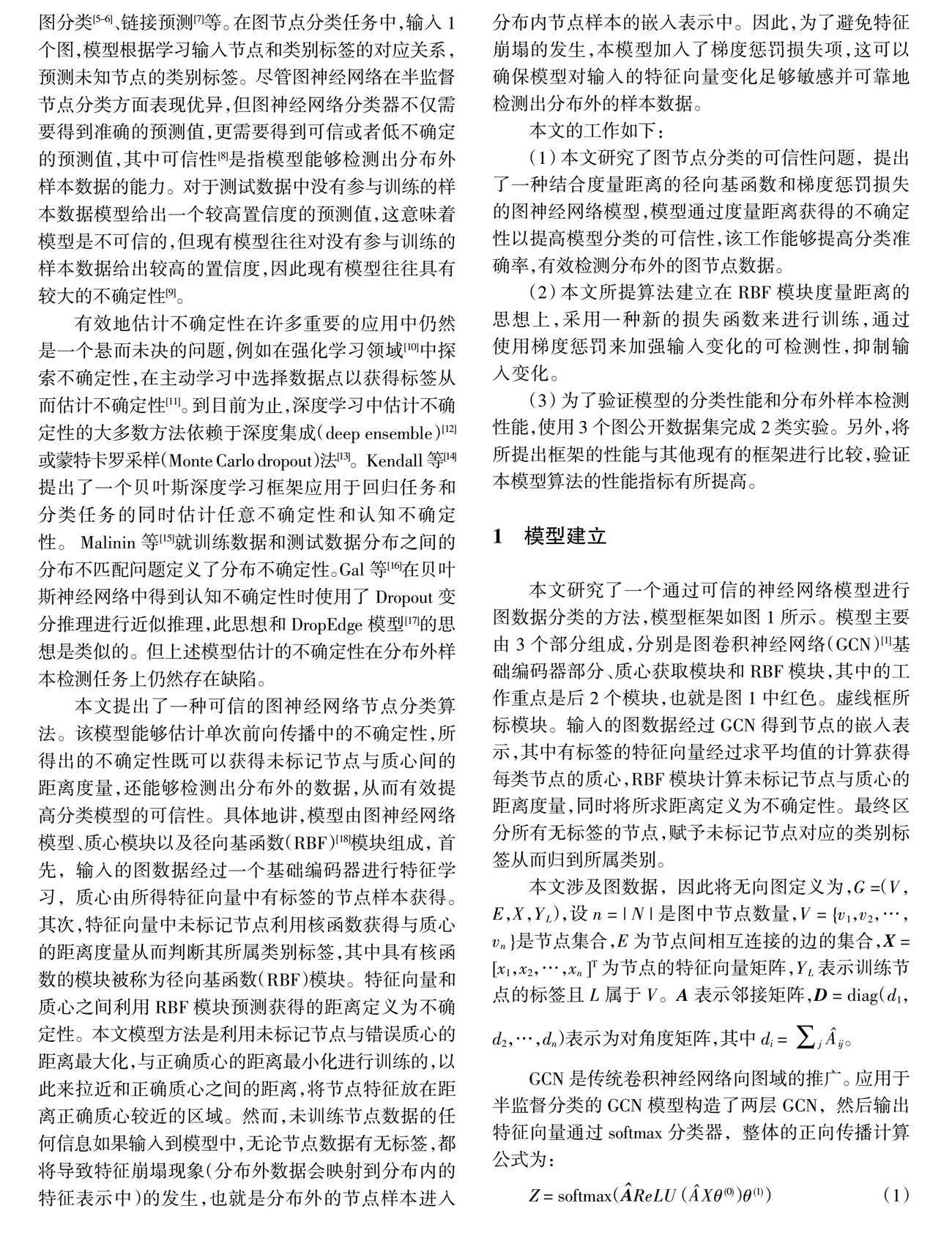

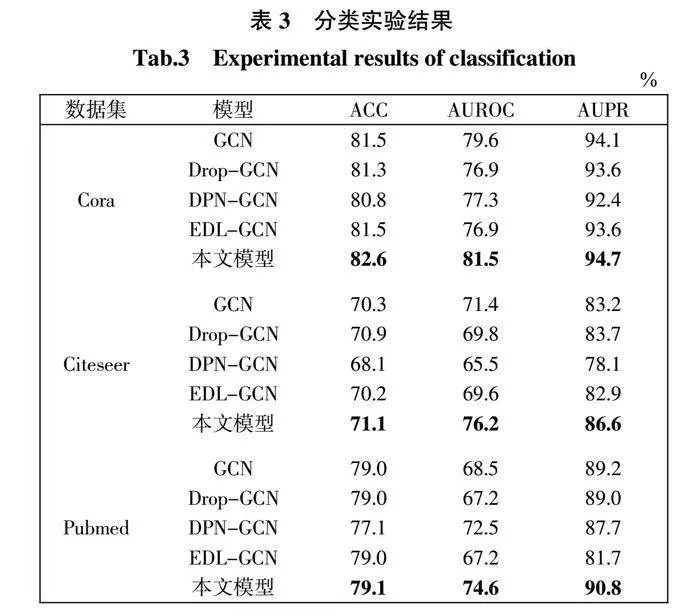

分類實驗中使用到的評估指標有準確率ACC、AUROC 和AUPR[28]。AUROC 表示ROC 曲線下的面積,其中x 軸代表假陽性率(FPR),y 軸代表真陽性率(TPR),解釋為正例獲得比反例更高的檢測得分的概率[29]。此指標=大模型分類效果=好,完美模型對應的AUROC 指標為100%。AUPR 曲線是表示精度值(Pre-cision)和召回率(Recall)的曲線圖,AUPR 表示Preci-sion-Recall 曲線下的面積,理想情況下,Precision 為1,Recall 為1。因此利用所描述的指標評估所有模型的性能,具體結果如表3 所示。

表3 中3 個引文網絡數據集在分類實驗各個指標結果中,加粗的結果表示最佳的結果。從表3 可以看出,本文模型對比4 個基準模型每個指標都有不同程度的提高,一致高于基線方法。充分驗證了本文所提模型對于預測未標記節點的能力,模型能夠預測出未標記節點的真實標簽,RBF 模塊更有助于完成節點分類任務。表明本文模型可以從訓練集中學習并區分節點特征,獲得節點類型。

2.5 OOD 檢測實驗

OOD 檢測實驗是利用不確定性估計來檢測輸入是否是分布外樣本數據。評估指標有AUROC、AUPR[28]。

對于半監督節點分類,隨機選擇1~3 個類別作為OOD類別,并根據剩余類別的節點對模型訓練。3 個數據集不同模型的指標結果如表4 所示。

從表4 可以看出,本文所提模型各項指標結果優于對比的大多數模型的指標結果,證明了本模型對分布外樣本檢測的有效性,這些實驗結果同時也驗證了加入梯度懲罰損失對OOD 任務的有效性。

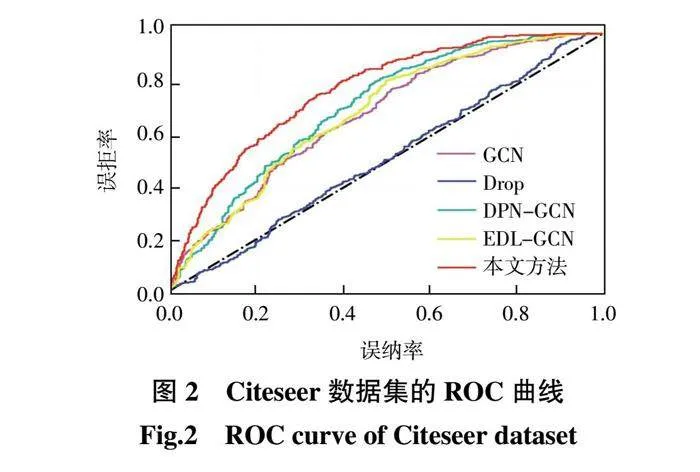

為了表明本文所提模型對分布外節點樣本數據檢測的可信性,使用Citeseer 數據集得到ROC 曲線,圖2 所示為本文模型和其他基線模型的ROC 曲線圖。所有方法使用Citeseer 數據集時均是以固定的3 類作為訓練數據集也就是ID 數據集,另外其他的3 類作為OOD 數據集,主要使用ID 和OOD 進行評估,判斷模型對OOD 節點的敏感程度。從圖2 可以明顯看出,使用ROC 曲線進行對比時本文方法均優于其他基線方法。

2.6 消融實驗

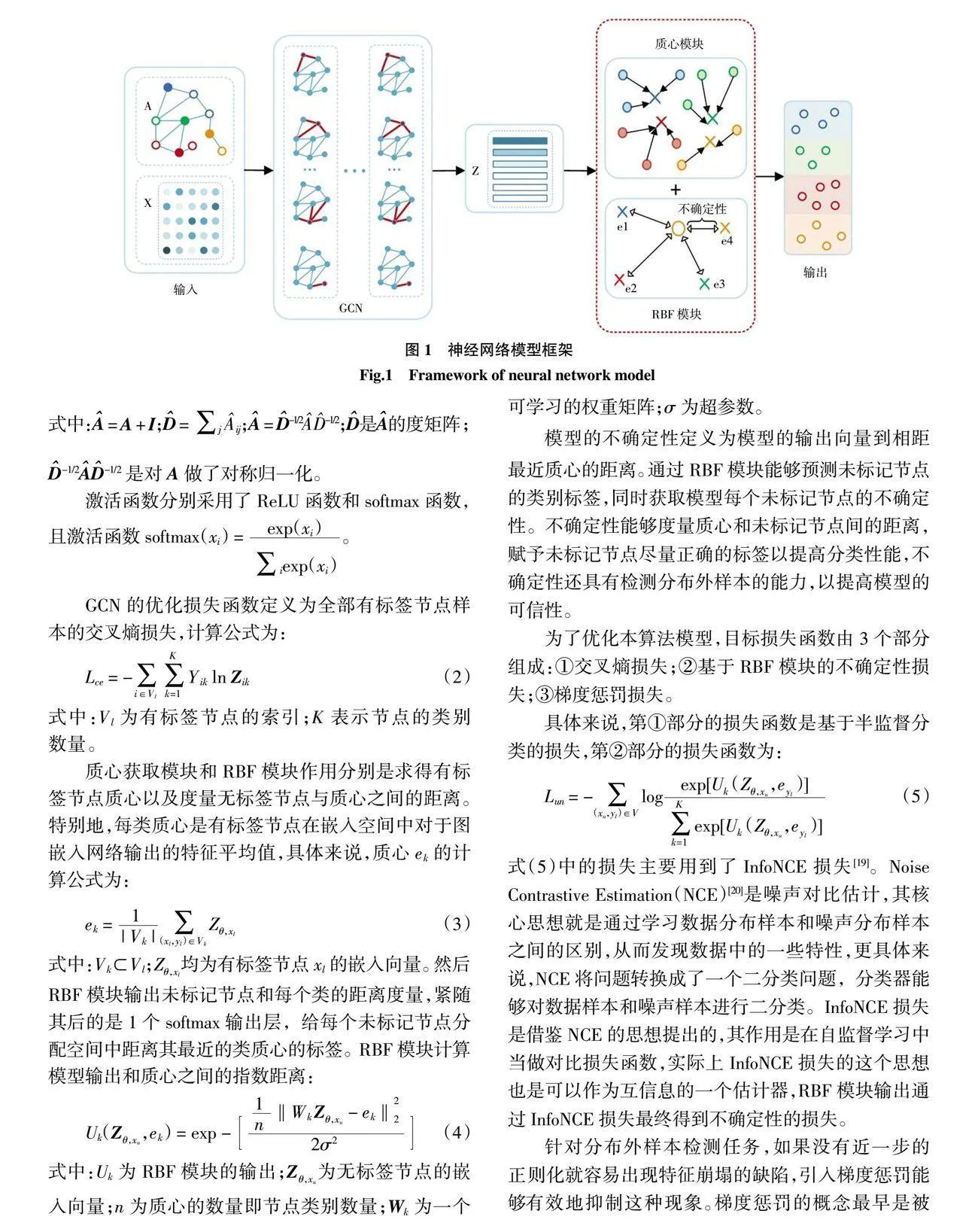

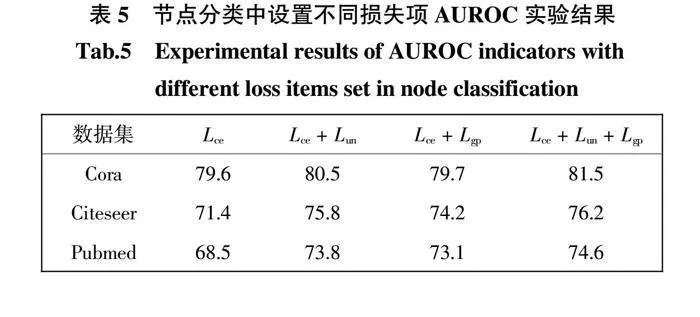

考慮到加入了2 項不同于GCN 交叉熵損失的損失項,需要驗證所加損失項是否有助于提高本算法的性能。因此消融實驗主要研究節點分類任務和分布外樣本檢測任務在不同數據集不同損失項的AUROC 指標結果,如表5 和表6 所示。

從表5、表6 可以看出,損失項包括交叉熵損失(Lce)、不確定性損失(Lun)和梯度懲罰損失(Lgp),利用上述3 項損失分別設置了4 種情況:第1 種情況去掉不確定性損失和梯度懲罰損失即Lce;第2 種情況只去掉了梯度懲罰損失即Lce + Lun;第3 種情況只去掉不確定性損失即Lce + Lgp;第4 種情況保留了全部3 項損失即Lce + Lun + Lgp。

由表5 可知,分別在3 個數據庫Cora、Citeseer、Pubmed 數據集上進行分類任務的損失項消融實驗,從表中能夠明顯地看出:

(1)損失設置中加入1 項或2 項損失的AUROC值均高于只使用交叉熵損失(Lce)時所得AUROC 值。

(2)損失設置的前3 種情況中去掉任意1 種或2種損失AUROC 指標均有所下降,第4 種情況即3 項損失(Lce + Lun + Lgp)都保留時,AUROC 指標實驗結果是最優的,證明2 項損失同時存在對整個模型性能具有一定的貢獻。

(3)表格數據進行橫向對比,在設置交叉熵損失基礎上加入不確定性損失(Lce + Lun)比加入梯度懲罰損失(Lce + Lgp)的AUROC 指標更高,證明分類任務中不確定性損失(Lun)對模型的貢獻高于梯度懲罰損失(Lgp)的貢獻。

不確定性損失(Lun)本質是通過學習未標記節點樣本和有標記樣本之間的區別,發現未標記節點樣本的細節特征。它有助于準確預測未標記節點標簽,利用迭代訓練模型學習到更多細節部分從而優化模型。因此不確定性損失(Lun)在分類未標記節點樣本時的能力優于梯度懲罰損失(Lgp)。

由表6 可知,分別在3 個數據庫Cora、Citeseer、Pubmed 數據集上進行分布外樣本檢測任務的損失項消融實驗,從表中能夠明顯地看出:

(1)損失設置中加入1 項或2 項損失的AUROC值均高于只使用交叉熵損失(Lce)時所得AUROC 值。

(2)如果缺少2 項損失中的任何一項,模型在3個不同數據集的性能會下降,3 項損失(Lce + Lun + Lgp)均存在時AUROC 指標最高,實驗結果是最優的,這表明2 項損失對模型完成分布外樣本檢測任務時的性能具有一定的貢獻。

(3)對于分布外樣本檢測任務,交叉熵損失和梯度懲罰損失(Lce + Lgp)的AUROC 值比交叉熵損失和不確定性損失(Lce + Lun)的AUROC 值更高,該實驗結果能夠說明在分布外樣本檢測任務中梯度懲罰損失(Lgp)的貢獻更大。

梯度懲罰損失(Lgp)主要解決分布內節點樣本的特征表示中出現了分布外節點樣本特征表示的現象,有效防止未參與訓練的節點數據信息輸入到模型中,從而檢測出分布外樣本的節點,提高OOD 檢測任務的性能指標。因此梯度懲罰損失(Lgp)在檢測分布外樣本節點時的能力優于不確定性損失(Lun)。

3 結 論

本文提出了一種可信的圖神經網絡節點分類模型。在嵌入過程中,模型使用求平均值的方法獲取每類節點質心的信息,在RBF 徑向基函數的指導下捕獲節點間的距離,設計并引入了不確定性損失和梯度懲罰損失2 種損失函數,不確定性損失采用噪聲對比估計算法發現未標記節點的細節特征以優化模型提高節點分類任務指標,同時采用梯度懲罰損失有效防止未參與訓練的節點數據信息輸入到模型中以優化算法提高分布外樣本檢測任務指標,并在Cora、Citeseer、Pubmed 這3 個真實引文網絡數據集上驗證了所提出模型的有效性。結果表明:

(1)在節點分類任務中,本文模型在3 個數據集上的AUROC 值分別達到81.5%、76.2%和74.6%,優于所有對比算法。

(2)在Citeseer 數據集的分布外樣本檢測任務中,本文模型的AUROC 得分比EDL-GCN、DPN-GCN和Drop-GCN 分別提高了1.054、1.048 和1.032 倍。

(3)本文算法在保留了從更深層次獲取節點和質心間的距離信息后,所學習的節點樣本信息可以更好地完成后續各種分類或者檢測任務。

參考文獻:

[1] KIPF T N,WELLING M. Semi-supervised classification withgraph convolutional networks [J]. 2016. DOI:10.48550/arX-iu.1609.02907.

[2] VELIC 姚 KOVIC ú P,CUCURULL G,CASANOVA A,et al. Graphattention networks [EB/OL]. 2017. DOI:10.48550/arXiu.1710.10903.

[3] XUB,SHENH,CAOQ,et al. Graph wavelet neural network[J].2019. DOI:10.48550/arXiu.1904.07785.

[4] XU B B,SHEN H W,CAO Q,et al. Graph convolutional net-works using heat kernel for semi-supervised learning [C]//Pro-ceedings of the Twenty-Eighth International Joint Conference onArtificial Intelligence. California: International Joint Confer-ences on Artificial Intelligence Organization,2019: 1928-1934.

[5] WU J,HE J R,XU J J. DEMO-net: Degree-specific graphneural networks for node and graph classification[C]//Proceed-ings of the 25th ACM SIGKDD International Conference onKnowledge Discovery amp; Data Mining. New York: ACM,2019:406-415.

[6] ZHANG M H,CUI Z C,NEUMANN M,et al. An end-to-enddeep learning architecture for graph classification[J]. Proceed-ings of the AAAI Conference on Artificial Intelligence,2018,32(1): 4438-4445.

[7] CEN K T,SHEN H W,GAO J H,et al. ANAE: Learning nodecontext representation for attributed network embedding [J] .2019. DOI:10.48550/arXiu.1906.08745.

[8] GENG Y,HAN Z B,ZHANG C Q,et al. Uncertainty-awaremulti-view representation learning[J]. Proceedings of the AAAIConference onArtificial Intelligence,2021,35(9): 7545-7553.

[9] AMERSFOORT J V,SMITH L,TEH Y W,et al. Uncertaintyestimation using a single deep deterministic neural network[C]//Proceedings of the International Conference on MachineLearning. [s.l.:s.n.],2020: 9690-9700.

[10] OSBAND I,BLUNDELL C,PRITZEL A,et al. Deep explor-ation via bootstrapped DQN[J]. 2016. DOI:10.48550/ arXiu.1602.04621.

[11] HOULSBY N,HUSZáR F,GHAHRAMANI Z,et al. Bayesianactive learning for classification and preference learning[J]. 2011.DOI:10.48550/arXiu.1112.5745.

[12] LAKSHMINARAYANAN B,PRITZEL A,BLUNDELL C. Si-mple and scalable predictive uncertainty estimation using deepensembles[J]. 2016. DOI:10.48550/arXiu.1612.01474.

[13] GAL Y,GHAHRAMANI Z. Dropout as a Bayesian approxima-tion: representing model uncertainty in deep learning[J]. 2015.DOI:10.48550/arXiu.1506.02142.

[14] KENDALL A,GAL Y. What uncertainties do we need in Baye-sian deep learning for computer vision? [C]//Proceedings of the31st International Conference on Neural Information Process-ing Systems. New York: ACM,2017: 5580-5590.

[15] MALININ A,GALES M. Predictive uncertainty estimation viaprior networks[C]//Proceedings of the 32nd International Con-ference on Neural Information Processing Systems. New York:ACM,2018: 7047-7058.

[16] GAL Y,GHAHRAMANI Z. Dropout as a Bayesian approxima-tion: Representing model uncertainty in deep learning[J]. 2015.DOI:10.48550/arXiu.1506.02142.

[17] RONG Y,HUANG W B,XU T Y,et al. DropEdge: Towardsdeep graph convolutional networks on node classification[EB/OL].2019. DOI:10.48550/arXiu.1907.10903.

[18] LECUN Y,BOTTOU L,BENGIO Y,et al. Gradient-basedlearning applied to document recognition[J]. Proceedings of theIEEE,1998,86(11): 2278-2324.

[19] OORD A,LI Y,VINYALS O. Representation learning withcontrastive predictive coding[J]. DOI:10.48550/arXiu.1807.03748.

[20] GUTMANN M,HYV魧RINEN A. Noise -contrastive estima-tion: A new estimation principle for unnormalized statisticalmodels[C]//Proceedings of the Thirteenth International Confer-ence on Artificial Intelligence and Statistics. [S.L.:s.n.],2010:297-304.

[21] DRUCKER H,LE CUN Y. Improving generalization perfor-mance using double backpropagation[J]. IEEE Transactions onNeural Networks,1992,3(6): 991-997.

[22] SEN P,NAMATA G,BILGIC M,et al. Collective classifica-tion in network data[J]. AI Magazine,2008,29(3): 93-106.

[23] RYU S,KWON Y,KIM W Y. Uncertainty quantification ofmolecular property prediction with Bayesian neural networks[J].2019. DOI:10.48550/arXiu.1903.08375.

[24] SENSOY M,KAPLAN L,KANDEMIR M. Evidential deeplearning to quantify classification uncertainty [C]//Proceedingsof the 32nd International Conference on Neural InformationProcessing Systems. New York: ACM,2018: 3183-3193.

[25] MALININ A,GALES M. Predictive uncertainty estimation viaprior networks[J]. 2018. DOI:10.48550/arXiu.1802.10501.

[26] GLOROT X,BENGIO Y. Understanding the difficulty of train-ing deep feedforward neural networks [C]//Proceedings of theThirteenth International Conference on Artificial Intelligenceand Statistics. [S.L.:s.n.],2010: 249-256.

[27] KINGMA D P,BA J. Adam: a method for stochastic optimiza-tion[EB/OL]. 2014. DOI:10.48550/arXiu.1412.6980. https://arxiv.org/abs/1412. 6980.pdf

[28] HENDRYCKS D,GIMPEL K. A baseline for detecting mis-classified and out-of-distribution examples in neural networks[J]. 2016. DOI:10.48550/arXiu.1610.02136.

[29] FAWCETT T. An introduction to ROC analysis[J]. Pattern Re-cognition Letters,2006,27(8): 861-874.

本文引文格式:

劉彥北,馬夕然,王雯. 可信的圖神經網絡節點分類方法[J].天津工業大學學報,2024,43(1):82-88.

LIU Y B,MA X R,WANG W. Node classification methodbased on trusted graph neural network[J]. Journal of TiangongUniversity,2024,43(1):82-88(in Chinese).