基于改進Swin-Unet的遙感圖像分割方法

摘 要:針對遙感圖像數據本身存在分辨率高、背景復雜和光照不均等特性導致邊界分割不連續、目標錯分漏分以及存在孔洞等問題,提出了一種基于改進Swin-Unet 的遙感圖像分割方法。在編碼器末端引入空洞空間金字塔池化(AtrousSpatial Pyramid Pooling,ASPP) 模塊,用于捕獲多尺度特征,增強網絡獲取不同尺度的能力,充分提取上下文信息;將解碼器端的Swin Transformer Block 替換為殘差Swin Transformer Block,不僅保留了原始信息,又能夠緩解模型出現梯度彌散現象;在跳躍連接中引入殘差注意力機制,可以讓模型更加關注特征圖中的重要特征信息,抑制無效信息,從而提高模型分割的準確率。在自建數據集上進行實驗,結果表明,改進后的網絡平均交并比(mean Intersection over Union,mIoU) 達到了80. 55% ,提高了4. 13 個百分點,證明改進后的網絡可以有效提高遙感圖像分割的精度。

關鍵詞:遙感圖像;語義分割;SwinUnet;空洞空間金字塔池化;殘差注意力機制

中圖分類號:TP751 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3106(2024)05-1217-09

0 引言

遙感圖像包含豐富的地物特征信息[1],通過遙感圖像分割技術,可以幫助人們自動提取出關鍵信息,為合理分析和利用土地資源提供應用指導,已廣泛應用于軍事、農業、城市規劃、自然災害監測、道路分析和森林植被等各個領域。然而,由于遙感圖像的分辨率高、紋理信息豐富、同物異譜和異物同譜現象明顯[2],給遙感圖像分割帶來了很大挑戰。

近年來,越來越多的學者針對如何提高遙感圖像分割精度的問題展開了研究[3]。閾值分割算法通過選取合適的閾值來實現目標和背景的分離,算法難度小、實現簡單,能夠實現圖像的快速分割[4],但對噪聲比較敏感[5],不適用于復雜場景下的遙感圖像分割。聚類分割算法具有分割速度快、拓展性強、無監督、高效等特性[6],但初始聚類中心和聚類數量難以確定,對噪聲也較為敏感[7]。支持向量機(Support Vector Machine,SVM)方法可以排除大量冗余樣本,具有較好的魯棒性[8],但耗時較長,并且只能用于小型數據集,對空間的信息利用率不高[9]。閾值、聚類和SVM 分割方法屬于傳統圖像分割方法,對于復雜的遙感圖像來說,傳統分割方法時間效率低、分割的精度并不能滿足實際需要。Unet是由Ronneberger 等[10]提出的一種對稱的編碼-解碼結構,它可以融合淺層和深層次的語義信息[11],并且簡單靈活,可以在較小的數據集上獲得良好的分割效果[12],但仍會由于空間和細節信息的丟失而導致邊緣分割模糊[13]。深度學習方法可以更深層次地提取遙感圖像的特征,但不能充分利用遙感圖像豐富的上下文信息,仍然會存在細節丟失、邊界模糊等問題。

將U 型網絡與Transformer 結合已經成為近2 年來的研究熱點之一[14]。Swin-Unet[15]是一種以Transformer 為骨干網絡的U 型網絡,它可以利用Transformer 來彌補Unet 本身在捕獲長距離依賴上的缺陷。Gao 等[16]改進了Swin-Unet 以解決糖尿病視網膜病變黃斑水腫區域分割不準確的問題,結果表明,改進后的網絡不僅提高了視網膜黃斑水腫的整體語義分割精度,還進一步提高了多尺度、多區域水腫區域的語義分割效果。張文康[17]針對云區域識別精度低的問題,采用了Swin-Unet 模型對云圖進行識別,結果表明,該模型可以從遙感圖像中提取更多的語義信息,獲得更好的識別效果,雖然云的邊緣和細節仍存在一定的誤差,但整體上提高了對云圖的識別精度。Yao 等[18]針對遙感圖像同物異譜和同譜異物問題,提出將改進后的Swin-Unet 模型作為一個純Transformer 模型和新的預處理方式。實驗結果證明,該模型能夠更有效地提升遙感圖像分割的精度,相比于傳統模型更有優勢。然而,Swin-Unet 提取的遙感圖像仍然存在邊緣模糊、目標漏分等問題。

針對遙感圖像背景復雜、分辨率高導致遙感圖像的分割結果不理想的問題,本文設計了一種基于改進Swin-Unet 圖像分割算法。本文的主要貢獻如下:① 標注新的遙感數據集,并進行數據增強等一系列預處理操作;② 在編碼器末端引入空洞空間金字塔池化,充分提取多尺度遙感圖像特征,增大感受野;③ 將殘差思想引入解碼器端的Swin TransformerBlock,防止模型出現過擬合現象;④ 在跳躍連接中引入殘差注意力機制,增強重要特征,抑制不重要特征。

1 基于改進Swin-Unet 的遙感圖像分割網絡

1. 1 網絡結構

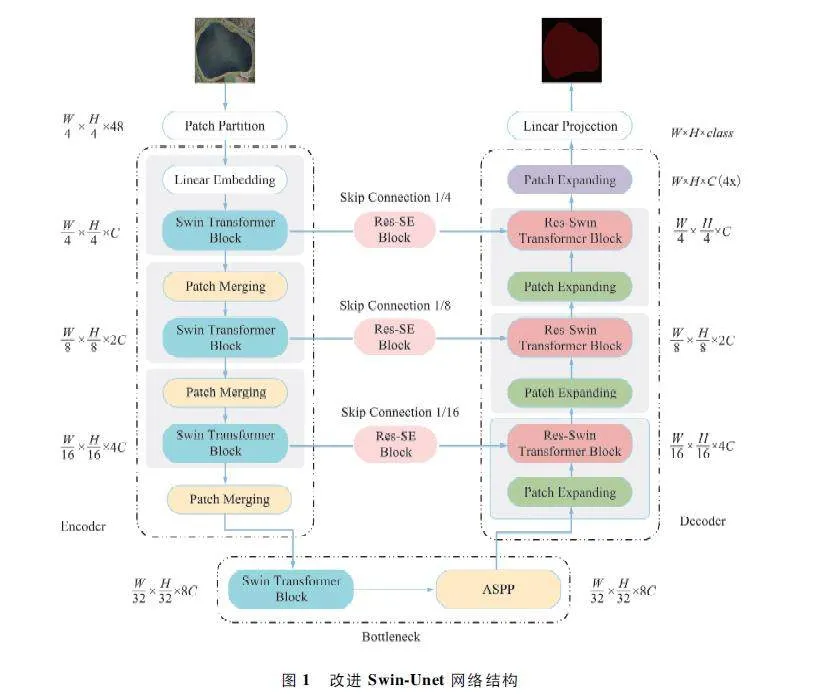

本文在Swin-Unet 的基礎上加以改進來實現遙感圖像分割,改進Swin-Unet 網絡結構如圖1 所示。改進后的Swin-Unet 網絡包括編碼器、解碼器和跳躍連接3 個部分。在編碼器部分,輸入圖像先通過圖像分塊處理(Patch Partition)操作,將輸入圖像劃分為一個個大小相等的分塊,再通過線性嵌入(Linear Embedding)改變每個分塊的通道數目。將這些分塊輸入多個Swin Transformer Block 和圖像塊合并層(Patch Merging)中,在編碼器的末端引入空洞空間金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)模塊,用于提取不同尺度信息,增大感受野,提取更多細節信息。其中,Swin Transformer Block可以提取圖像特征,Patch Merging 操作的主要作用是下采樣,可以將特征圖的長寬變為原來的一半,同時通道數增加為原來的2 倍。解碼器部分包括了多個殘差Swin Transformer 模塊(Res-Swin TransformerBlock)和圖像塊擴展層(Patch Expanding)。Res-Swin Transformer Block 中引入了殘差思想,可以有效防止模型出現過擬合現象,提升模型的泛化能力。Patch Expanding 的主要作用是上采樣,可以將特征圖的長寬變為原來的2 倍,通道數減半。最后一個Patch Expanding 將特征圖的長寬變為原來的4 倍,通道數不變,最后經過一個線性映射得到最終的遙感圖像分割結果。在跳躍連接部分,將編碼器端的Swin Transformer Block 與解碼器端的Res-Swin Trans-former Block 進行跨層連接,彌補了信息的丟失,同時在跳躍連接中加入了殘差通道注意力模塊(Res-SE Block),可以關注特征圖中重要的信息,抑制不重要的信息,以提升圖像的分割精度。

1. 2 ASPP

圖像分割網絡大多是基于編碼器-解碼器的結構,在通過下采樣擴大感受野、上采樣恢復至原圖的過程中,很容易丟失一些重要的語義特征信息,并且未能充分考慮上下文信息,往往會造成很大的精度損失。ASPP 模塊是由Chen 等[19]在DeepLab V2 中首次提出的,它可以利用不同膨脹率的空洞卷積并行捕獲圖像的不同尺度特征,獲得不同的感受野特征,并將其進行融合,充分考慮了上下文信息,同時提高了網絡對細節特征的提取能力。

ASPP 模塊主要包括5 條分支,第1 條分支為1 個1×1 的卷積,第2、3、4 條分支為空洞率分別為3、6、12 的3×3 空洞卷積,第5 條分支為全局平均池化(Global Average Pooling,GAP)。其中,空洞卷積可以在不增加模型參數量的同時,增大特征圖的感受野[20]。最后通過雙線性差值將圖像還原至原始圖像大小。ASPP 模塊如圖2 所示。本文在SwinUnet 編碼器的末端加入ASPP 模塊,可以充分提取多尺度信息,增大感受野,同時也有助于解碼器恢復細節信息。

1. 3 Res-Swin Transformer Block

隨著深度學習網絡模型層數的不斷增加,網絡模型很容易出現過擬合和網絡退化的問題,進一步限制了網絡模型精度的提升。為了解決這一問題,He 等[21]提出了ResNet 模型,它通過一條有向快捷連接,將輸入直接越層連接到輸出,在不增加參數量的前提下,有效緩解了網絡出現梯度彌散的現象,同時捕獲了更加豐富的語義特征,提高了圖像識別的精度。

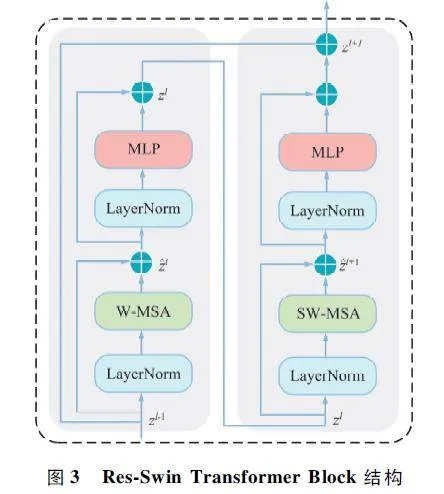

受到ResNet 的啟發,本文將殘差思想引入SwinTransformer Block,用一條快捷連接,連接SwinTransformer Block 的頭尾,通過恒等映射來防止網絡模型出現梯度消失的現象。本文將成對帶有Window Multi-Head Self Attention (W-MSA)和ShiftWindows Multi-Head Self-Attention(SW-MSA)的模塊作為一個Swin Transformer Block,Res-Swin TransformerBlock 結構如圖3 所示。實驗中發現,將解碼器端的Swin Transformer Block 替換為Res-Swin TransformerBlock 后,可以有效提高模型對遙感圖像分割的準確率。

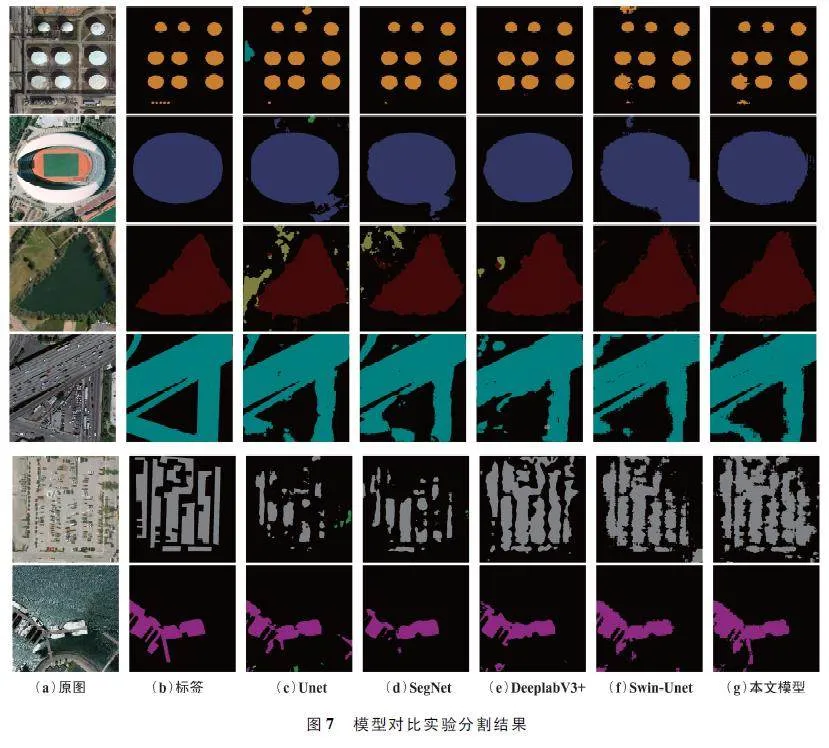

1. 4 殘差注意力機制

跳躍連接能夠通過將編碼器端的低層次特征與解碼器端的高層次特征進行拼接,進一步彌補信息的丟失。然而,低層次特征中包含大量冗余的信息,同時缺少特定的語義信息,可能會影響遙感圖像分割的精度。為此,本文將殘差注意力機制引入跳躍連接中,可以強化重要的特征區域,減弱冗余的特征區域,從而提高遙感圖像分割的準確率。

注意力機制[22]是在2017 年提出的,它的基本思路是從特征通道角度入手,增強重要的特征通道信息,弱化不重要的特征通道信息。壓縮與激勵(Squeeze & Excitation,SE)模塊主要包括壓縮和激勵兩部分。壓縮(Squeeze)部分將特征圖進行GAP操作,生成1×1×C 的向量;激勵(Excitation)部分使用2 個全連接層來得到每個特征通道的通道權重,最后進行Scale 操作,將得到的權重與原有的特征圖進行相乘,得到最后的輸出結果。

殘差注意力機制首先對Swin Transformer Block輸出特征圖進行Reshape 操作,將其從L×C 形狀改變為H×W×C 形狀。接著,對特征圖進行GAP、全連接等一系列操作,并將得到的特征圖通過Scale 操作與原特征圖相乘;然后,通過一條快捷連接將改變形狀后的Swin Transformer Block 直接與Scale 操作后得到的特征圖相加,得到新的特征圖;最后,再通過Reshape 操作,將其從H×W ×C 形狀重新恢復為L×C 形狀大小。殘差注意力機制既沒有增加模型的參數量,又保留了原始信息,同時也防止模型出現過擬合問題。殘差注意力機制結構如圖4 所示。

2 實驗

2. 1 數據集制作及預處理

WHU-RS19 數據集[23]是從Google Earth 中提取的遙感影像圖像,包含機場、沙灘、橋梁、沙漠、農田和足球場等19 個場景類別,每一類大約有50 張圖像,共計1 005 張圖像,每張圖像尺寸為600 pixel×600 pixel。由于受尺度、方向和照明等因素影響,該數據集更為復雜。

RSC11 數據集[24]是中科院于2016 年發布的開源高分辨率遙感影像,涵蓋了美國多個城市的影像圖片,包含了港口、居民區、鐵路、立交橋、儲罐、密林和疏林等11 個類別,圖像尺寸為512 pixel ×512 pixel,每一類大約有100 張圖像,整個數據集總共有1 232 張圖像。

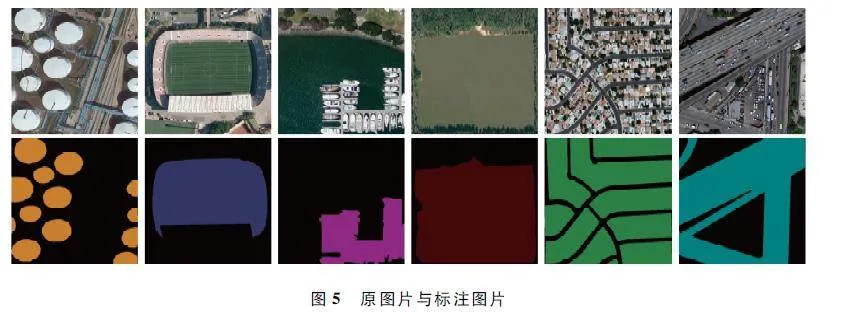

本文從WHU-RS19 和RSC11 數據集內篩選出了一些具有明顯特征的類別,去除了相似、重復和單一背景的類別,形成遙感圖像分類數據集。通過使用Python 腳本,將數據集內所有圖像的后綴名修改為png 并調整圖像大小為512 pixel × 512 pixel。然而,由于遙感圖像分類數據集屬于圖像分類數據集,缺乏語義分割標簽,因此需要Labelme 手動標注圖像,生成遙感圖像分割數據集。標注完成后,通過“labelme2voc”腳本將標注完成后所生成的json 文件批量轉換為語義分割數據集,并將語義分割數據集內的RGB 彩色標簽轉換為對應的單通道數字標簽。最后采用水平翻轉、垂直翻轉、對比度增強、旋轉和添加噪聲等一系列數據增強方法,最終得到的遙感圖像分割數據集總共有3 528 張圖像,其中選取3 000 張作為訓練集,528 張作為測試集。原圖片與標注圖片(部分數據集)展示如圖5 所示。

2. 2 實驗環境

本文的實驗環境基于Ubuntu 18. 04 系統,采用的深度學習框架為Pytorch。實驗所用的GPU 為單卡的NVIDIA RTX_3090,CUDA 的版本為11. 7。預訓練權重使用在ImageNet 數據集上預先訓練好的swin_tiny_patch4_window7_224. pth 權重,初始學習率為0. 01,動量為0. 9,優化算法為隨機梯度下降(Stochastic Gradient Descent,SGD)方法。訓練模型的epoch 設置為300 個,batch size 大小為12,窗口大小為8。

2. 3 損失函數

本文使用的損失函數為經典的交叉熵損失(Cross Entropy Loss,CE Loss)和骰子損失(DiceLoss)相結合的損失函數。二者結合的損失函數公式為:

Loss(y,ypred ) = 0. 4Lossce(y,ypred )+ 0. 6LossDice(y,ypred ),(1)

CE Loss 是經典的語義分割中常用的損失函數,可以很好地優化類間距離,同時還可以緩解DiceLoss 訓練造成的震蕩問題,其公式為:

由于遙感圖像的前景與背景之間存在不平衡的問題,Dice Loss 可以減輕復雜背景對分割結果的影響,衡量前景與背景之間的重疊部分,很好地解決部分圖像中前景所占比例較小的問題,用來計算真實值和預測值之間的相似度,其公式為:

式中:n 為遙感圖像分割的類別數。

2. 4 評價指標

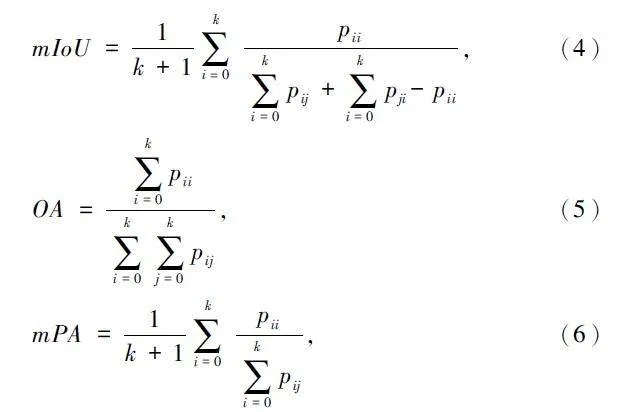

為了驗證改進網絡的有效性,本文采用平均交并比(mean Intersection over Union,mIoU)、總體準確率(Overall Accuracy,OA)和平均像素精度(meanPixel Accuracy,mPA)作為評價指標來評估模型對遙感圖像的分割效果,具體計算公式如下:

式中:k 表示遙感圖像分割的類別數(不包含背景),pii 表示真正例,即實際為類別i 且被正確地預測為類別i 的像素數量;pij 表示假正例,即實際為類別i卻被錯誤地預測為類別j 的像素數量;pji 表示假負例,即實際為類別j 卻被錯誤地預測為i 的像素數量。

3 實驗結果與分析

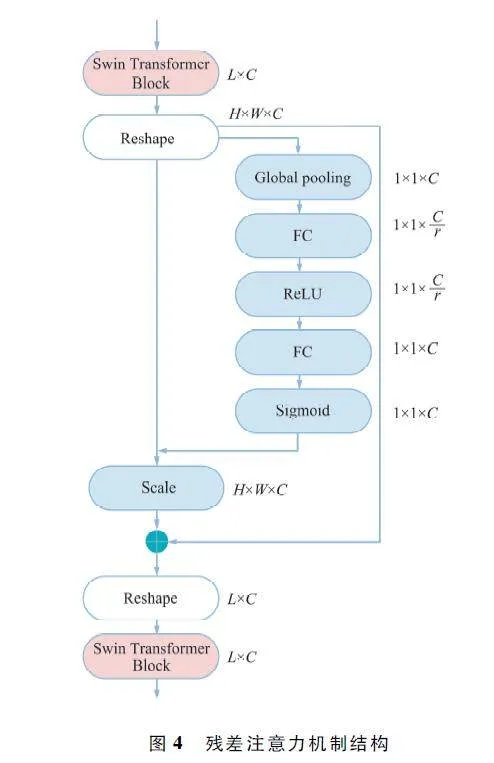

3. 1 消融實驗結果與分析

為了驗證所引入模塊的有效性,本文依次將Res-Swin Transformer Block、殘差注意力機制以及ASPP 疊加到基線模型中進行消融實驗,并通過評價指標結果評估每個模塊對模型性能的影響效果。消融實驗評估結果對比如表1 所示。其中,Res_SE表示殘差注意力機制,Res _ Swin 表示Res-SwinTransformer Block,ASPP 表示空洞空間金字塔池化。

從表1 可以看出,引入Res-Swin TransformerBlock 后,相較于基線模型,模型的mIoU 提升了1. 12 個百分點。在此基礎上,進一步添加殘差注意力機制,mIoU 提高了1. 93 個百分點,最后引入ASPP 模塊,模型的mIoU、OA 和mPA 分別提高了4. 13、1. 76、5. 5 個百分點,進一步驗證了本文所提的3 個模塊均可以有效提升遙感圖像分割的精度。

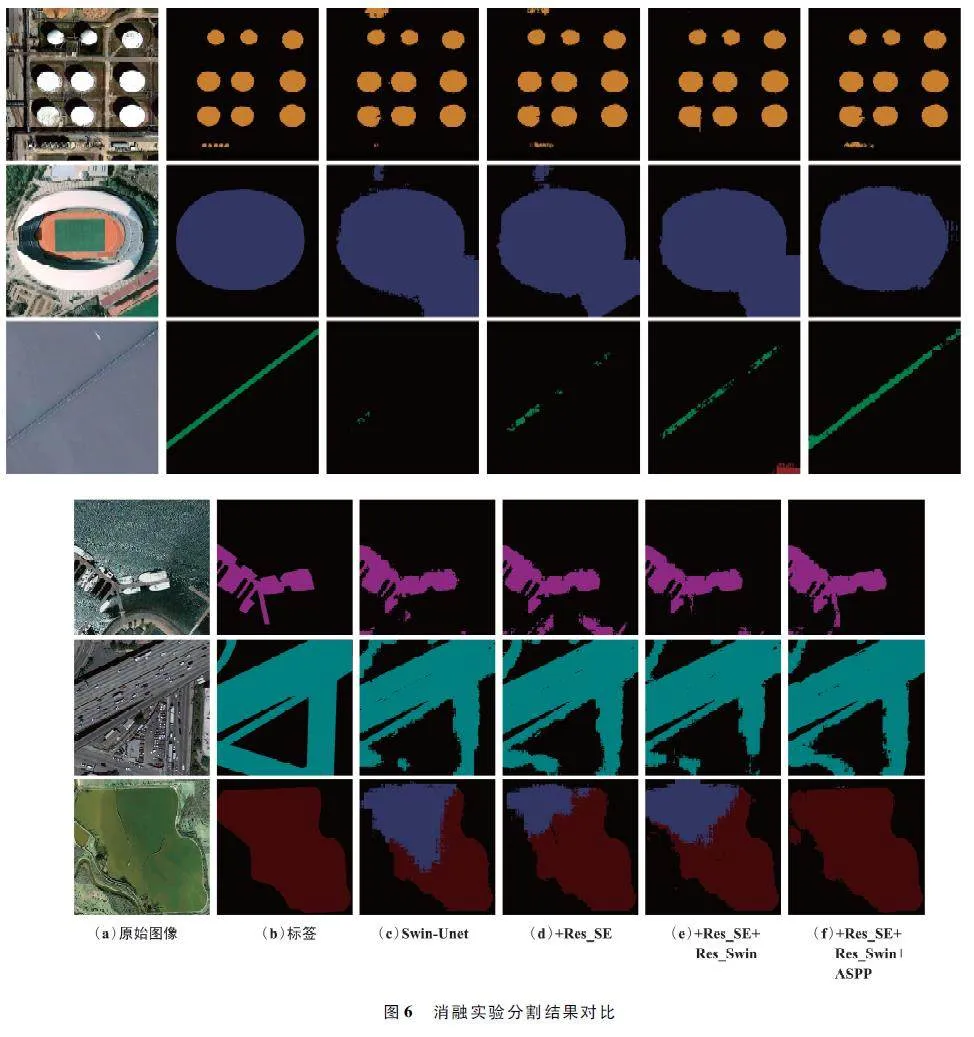

為了更直觀地比較各個模塊對分割結果的影響,本文對消融實驗結果進行了可視化,消融實驗分割結果對比如圖6 所示。從圖6 可以看出,原始的Swin-Unet 模型存在著明顯的漏分和錯分問題,但隨著Res_Swin、Res_SE 和ASPP 等模塊的逐步引入,目標輪廓變得更加準確和清晰,模型的分割效果與真實標簽更加接近,目標誤分、漏分的現象也有所減少,這充分證明了本文所提模型能夠有效地改善遙感圖像分割的結果。

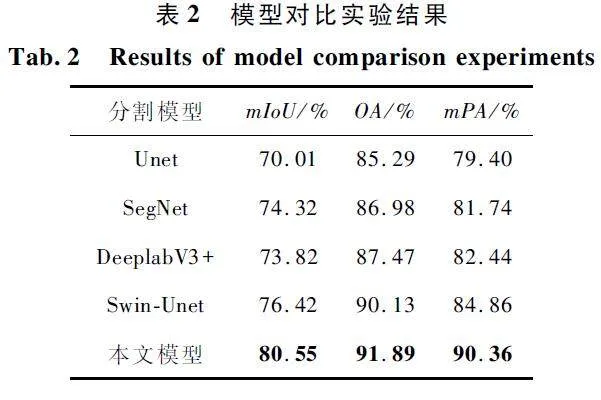

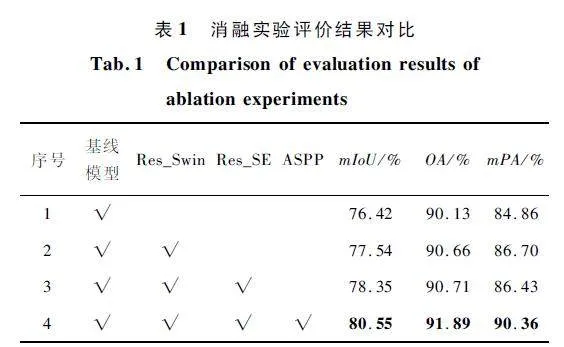

3. 2 模型對比實驗結果與分析

為了驗證本文所提模型的優越性,本文分別將測試圖片輸入到訓練好的Unet、SegNet、DeeplabV3 +、Swin-Unet 以及本文所提模型中進行對比實驗,并隨機選擇了幾張預測圖像進行了可視化,模型對比實驗分割結果如圖7 所示。模型對比實驗除了改變網絡模型外,其余實驗條件均保持一致,包括數據集、數據增強方式等。

從圖7 可以看出,Unet 能夠基本還原物體輪廓,但存在較多噪聲和多分類識別錯誤現象;相比之下,SegNet 表現有所提升,噪聲和誤分類現象得到一定改善;DeeplabV3 +能夠識別更大的區域,噪聲也有所減少,但在邊緣輪廓識別方面仍有待提高;Swin-Unet 能夠準確識別目標物體,但仍存在未被識別和錯誤識別的像素;而本文所提模型更接近真實標簽,能夠準確分割出更為精細的遙感目標,顯著改善了目標錯分和漏分現象,分割效果最佳。

為了客觀評估不同方法對遙感圖像分割效果的影響,本文通過3 個評價指標來對不同方法進行定量評估。各個方法的模型對比實驗結果如表2 所示。

由表2 可知,本文所提的模型在各項評價指標中均取得了較大的提升。本文模型的mIoU 為80. 55% ,相比于其他模型分別提高了10. 54% 、6. 23% 、6. 73%和4. 13% ;OA 為91. 89% ,比其他模型分別提升了6. 6% 、4. 91% 、4. 42% 和1. 76% ;mPA 為90. 36% ,分別提升了10. 96% 、8. 62% 、7. 92% 和5. 5% ,提升效果顯著。由此可以證明,本文提出的模型分割效果最好,驗證了融合多尺度提取更細節的特征、引入殘差減少過擬合、引入殘差注意力機制關注重要特征的有效性,優化了遙感圖像分割的效果。

4 結束語

本文提出了一種基于改進Swin-Unet 的遙感圖像分割方法,并用于自建的遙感圖像分割數據集,以解決遙感圖像分割邊界模糊、目標漏分等問題。在原有Swin-Unet 的基礎上,引入ASPP 模塊,融合不同尺度遙感圖像特征,增大感受野;使用Res-SwinTransformer Block,不僅保留了原始特征信息,還有效防止了模型出現過擬合問題;在跳躍連接中引入殘差注意力機制,增強重要特征信息,弱化冗余背景特征信息。實驗結果表明,改進后的Swin-Unet 網絡分割結果與真實標簽更為接近,相比于其他模型,分割效果均有所提升,證明了本文所提模型的優越性和有效性。雖然本文所提方法取得了較好的提升效果,但Swin-Unet 模型復雜度較高。未來將進一步優化Swin-Unet 網絡,降低其復雜度,并設計更加輕量化的網絡模型。

參考文獻

[1] WU Z H,GAO Y M,LI L,et al. Semantic Segmentation ofHighresolution Remote Sensing Images Using Fully Convolutional Network with Adaptive Threshold[J]. ConnectionScience,2018,31(2):169-184.

[2] WANG C,XU W,PEI X F,et al. An Unsupervised Multiscale Segmentation Method Based on Automated Parameterization [J]. Arabian Journal of Geosciences,2016,9(15):1-10.

[3] JIANG B D,AN X Y,XU S F,et al. Intelligent Image Semantic Segmentation:A Review Through Deep LearningTechniques for Remote Sensing Image Analysis [J ].Journal of the Indian Society of Remote Sensing,2023,51:1865-1878.

[4] 黃旭,張世義,李軍. 圖像分割技術研究綜述[J]. 裝備機械,2021(2):6-9.

[5] 閔蕾,高昆,李維,等. 光學遙感圖像分割技術綜述[J]. 航天返回與遙感,2020,41(6):1-13.

[6] 何瀚志,朱紅,王競. 基于聚類分析的醫學圖像分割綜述[J]. 中國科技信息,2017(15):43.

[7] 王怡,涂宇,羅斐,等. 彩色圖像分割方法綜述[J]. 電腦知識與技術,2020,16(23):183-184.

[8] LU W Z,LIANG L X,WU X S,et al. An Adaptive Multiscale Fusion Network Based on Regional Attention for Remote Sensing Images [J ]. IEEE Access,2020,8:107802-107813.

[9] ZHANG L B,LI A X,LI X W,et al. Remote SensingImage Segmentation Based on an Improved 2D GradientHistogram and MMAD Model[J]. IEEE Geoscience andRemote Sensing Letters,2015,12(1):58-62.

[10] RONNEBERGER O,FISCHER P,BROX T. UNet:Convolutional Networks for Biomedical Image Segmentation[C]∥Medical Image Computing and Computerassisted InterventionMIGGI 2015. Munich:Springer,2015:234-241.

[11] ZHANG Z X,LIU Q J,WANG Y H. Road Extraction byDeep Residual UNet[J]. IEEE Geoscience and RemoteSensing Letters,2018,15(5):749-753.

[12] SU Z B,LI W,MA Z,et al. An Improved UNet Methodfor the Semantic Segmentation of Remote Sensing Images[J]. Applied Intelligence,2022,52(3):3276-3288.

[13] 黃杰,蔣豐. 遙感影像中建筑物的Unet 分割改進[J].計算機系統應用,2021,30(10):319-324.

[14] 傅勵瑤,尹夢曉,楊鋒. 基于Transformer 的U 型醫學圖像分割網絡綜述[J]. 計算機應用,2023,43 (5 ):1584-1595.

[15] CAO H,WANG Y Y,CHEN J,et al. SwinUnet:UnetlikePure Transformer for Medical Image Segmentation[C]∥Computer VisionECCV 2022 Workshops. Tel Aviv:Springer,2022:205-218.

[16] GAO Z J,CHEN L. Research on Semantic SegmentationMethod of Macular Edema in Retinal OCT Images Based onImproved SwinUnet[J]. Electronics,2022,11(15):2294.

[17] 張文康. 基于SwinUnet 的云分割算法的研究[J]. 儀器儀表用戶,2022,29(4):5-9.

[18] YAO J Y,JIN S G. Multicategory Segmentation ofSentinel2 Images Based on the Swin UNet Method[J].Remote Sensing,2022,14(14):3382.

[19] CHEN L C,PAPANDREOU G,SCHROFF F,et al. Rethinking Atrous Convolution for Semantic Image Segmentation[EB/ OL]. (2017 -12 -05)[2023 -06 -06]. https:∥arxiv. org / abs / 1706. 05587.

[20] 姚慶安,張鑫,劉力鳴,等. 融合注意力機制和多尺度特征的圖像語義分割[J]. 吉林大學學報(理學版),2022,60(6):1383-1390.

[21] HE K M,ZHANG X Y,REN S Q,et al. Deep ResidualLearning for Image Recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition(CVRR). Las Vegas:IEEE,2016:770-778.

[22] HU J,SHEN L,SUN G. SqueezeandExcitation Networks[C]∥2018 IEEE / CVF Conference on Computer Visionand Pattern Recognition. Salt Lake City:IEEE,2018:7132-7141.

[23] SHENG G F,YANG W,XU T,et al. Highresolution Satellite Scene Classification Using a Sparse Coding BasedMultiple Feature Combination[J]. International Journal ofRemote Sensing,2012,33(8):2395-2412.

[24] ZHAO L J,TANG P,HUO L Z. Feature Significancebased Multibagofvisualwords Model for Remote SensingImage Scene Classification[J]. Journal of Applied RemoteSensing,2016,10(3):035004.

作者簡介

張 越 女,(1998—),碩士研究生。主要研究方向:圖像處理、計算機視覺。

王 遜 女,(1973—),碩士,副教授。主要研究方向:數據挖掘、軟件工程、機器學習。