基于柵格粒子濾波的人體頭肩三維姿態估計

劉晨光,劉家鋒,黃劍華,唐降龍

(哈爾濱工業大學,計算機科學與工程系,哈爾濱15001,liu.cg@live.cn)

目前基于單目視頻的三維人體姿態估計方法主要分為兩類:1)使用三維人體模型、人體約束與運動學(Kinematics)過程相結合的方法[1-2].此類方法將人體在圖像平面上的投影與三維人體模型進行相似性匹配,并結合人體約束,使用運動學過程計算三維人體姿態.由于人體運動的復雜性,該類方法通常需要大量不同姿態的三維人體模型,具有一定的局限性.2)使用人體運動學和形狀信息估計人體肢體三維姿態并進行“組裝”的方法[3-7].此類方法由于獨立地跟蹤不同的肢體,能夠更好地適應人體運動的復雜性.而人體頭肩的跟蹤和三維姿態獲取,為其他肢體的跟蹤和姿態獲取提供了前提條件.文獻[6,7]首先使用Adaboost 方法檢測到頭部位置,并以此位置作為初始值,使用若干二維頭-肩輪廓模型作為候選匹配,然后估算出圖像中人體肩部位置.

為此本文提出了一種新的粒子濾波方法,使用三維頭肩模型來描述人體頭肩三維姿態,利用了粒子濾波的多模特性使得頭部位置、肩部位置以及頭肩部的三維姿態參數可以同時被估算出來.在跟蹤人體頭部和兩肩的位置的同時,估計出人體頭肩部三維姿態.不僅為分析人的行為提供了基礎,還為人體三維姿態估計方法中其他肢體的運動信息獲取提供了前提.

1 基于三維模型的柵格粒子濾波器

如圖1 所示,首先建立一個三維頭-肩模型集合,然后將所有的三維模型向圖像平面投影獲得相應的二維模板集合.在輸入的視頻圖像中,通過背景減除和邊緣檢測獲得圖像的觀測.從二維模板集合中逐一取出二維模板并在觀測圖像中進行匹配操作計算相似度.找出相似度最大的二維模板,其位置作為跟蹤到的頭部位置,與之一一對應的三維模型作為頭肩三維姿態估計結果.顯然,這一過程由于窮盡了模板集合中的所有模板來搜索最優結果,當模板集合較大時將非常耗時.

圖1 未優化的算法流程圖

為了避免窮盡所有模板的搜索過程,提出了基于三維模型的柵格粒子濾波方法.該方法利用了人體姿態在連續兩幀間變化不大的特點,在離散的狀態空間中跟蹤人體頭肩的姿態變化軌跡.它保留了典型粒子濾波的非高斯、非線性且多模的特點,沒有使用任何運動模型,而是在一個離散化的狀態空間內,以上一時刻的系統狀態為中心,取得一個超橢球體并取其內部包含的粒子作為當前時刻的新粒子,每一個新粒子都和三維模型庫中的一個頭-肩三維模型相對應.通過限定超橢球體的體積就可以將粒子數限制在一個合理的范圍內,優化了粒子的搜索空間,提高了執行效率.

1.1 頭-肩三維模型

與文獻[6]中使用的頭-肩、頭-背部二維模型相比,頭-肩三維模型更好地描述了人體的生理結構特征,因而在跟蹤過程中能夠提供更為可靠的三維信息.本文使用兩個相互連接的橢球體構 造 了 人 體 頭-肩 三 維 模 型 ψ(ν,θy,θz)(圖2),兩橢球的參數由人體固有的比例關系確定,它們在三維空間中的相對位置關系保持不變.模型ψ 具有3 個自由度,ν 為縮放尺度,θy為模型繞YW軸旋轉角度,θz為模型繞ZW軸旋轉角度.

模型所在的三維空間坐標系W 與圖像坐標系F 間的關系如圖3 所示,W 中的XwOwYw坐標平面與F 中的XFOFYF平面是平行的.這樣,就可以通過將三維模型ψ(ν,θy,θz)向圖像平面投影得到圖像平面內的二維模板κ(x,y,ν,θy,θz),其中,x 和y 分別為模板κ 在圖像中位置的橫、縱坐標,ν,θy,θz為模板κ 對應的三維模型ψ 的3 個自由度.

于是,可以定義5 維狀態空間中的粒子φ(x,y,ν,θy,θz,ω),其中,ω 為該粒子的權重(通過粒子濾波的測量過程被賦值),向量(ν,θy,θz)對應一個三維模型ψ,而(x,y)為ψ 對應的二維模板在圖像中的位置.頭部和肩部的位置在二維模板中的坐標是已知的,因此跟蹤結果的(x,y)分量確定后便可以計算出頭部和肩部在原圖像中的二維坐標.

圖2 人體頭-肩三維模型

由頭-肩三維模型的建立過程可見,通過改變模型ψ(ν,θy,θz)3 個自由度的值獲得模型在三維空間中的不同姿態,所有不同的姿態的集合構成了一個三維模型庫S.縮放尺度ν、角度θy和角度θz的采樣率分別為Δν、Δθy和Δθz,模型庫S 為

式中:P,G 和Q 分別為相應自由度的取值集合,共有N=NP×NG×NQ個頭-肩三維模型.

模型庫S 的建立優化了粒子濾波中粒子的搜索空間,為狀態空間離散化為柵格狀態空間提供了前提條件.為了避免動態地生成二維模板圖像,提高系統運行速度,將模型庫S 中每個三維模型對應的二維投影模板圖像都存放在外存中并進行索引,每次系統啟動時讀入內存中備用.

圖3 三維模板空間坐標系W 與圖像平面坐標系F 關系圖

1.2 柵格粒子濾波器

柵格粒子濾波器將粒子φ(x,y,ν,θy,θz,ω)所在的五維狀態空間進行離散化后作為粒子的搜索空間.狀態空間中每一個離散化的點都對應了一個粒子,在各維度上等間隔排列的N 個點對應了N 個粒子.這樣,連續的五維狀態空間就離散化成為柵格狀態空間,離散化程度取決于各維度上間隔(采樣率)的大小.離散化程度越大,粒子濾波所需的粒子數越少,系統的運行效率越高,而三維姿態估計的精度越低,反之亦然.

本文方法不需要人工初始化過程,而是使用基于分層次搜索的方法獲得第一幀圖像的系統狀態.首先進行背景減除操作以獲得人體位置所在的矩形區域作為粒子φ(x,y,ν,θy,θz,ω)對應的二維模板位置(x,y)的搜索區域.(ν,θy,θz)在整個3 維模型庫S 中取值;最后在相應的取值范圍內應用粒子濾波的測量過程獲得第一幀圖像的系統狀態,并以此作為后續粒子濾波過程的初始狀態.

柵格粒子濾波器在t 時刻包括下述3 個主要步驟(圖4):

1)選擇過程.在上一個時間步(t-1 時刻)產生的粒子集Φt-1中選擇權重最大的M 個粒子.

2)預測過程.t-1 時刻的跟蹤過程結束后,通過該時刻的測量過程可以得到t-1 時刻的最優粒子.考慮到兩幀圖像間的人體姿態變化很小,使用來預測t 時刻粒子狀態.方法是在五維柵格狀態空間中,以粒子為中心取得一個五維的超橢球體Ω.該超橢球體包圍的Nt個粒子作為新粒子,其體積決定了Nt的大小,而該體積是由Ω 在各個維度上的寬度決定的.通過設置各維度寬度來限定粒子數量,以提高計算效率.

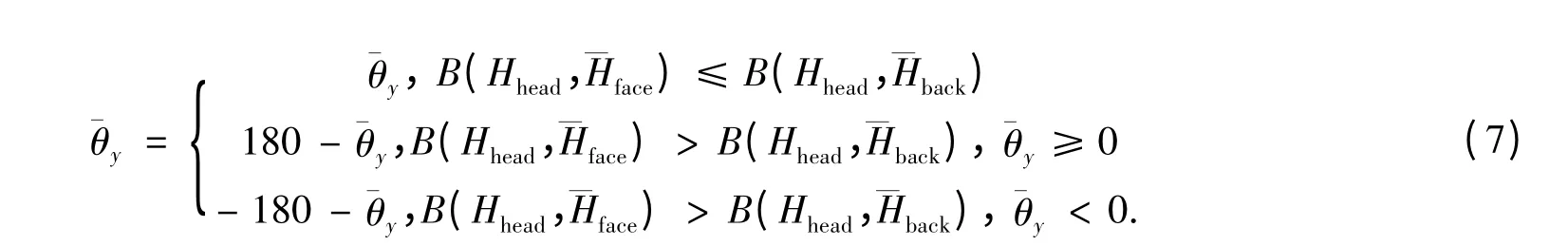

式中:η 為某一維度上的取值,Ω 在該維度上的寬度為2w+1,狀態空間離散化時各粒子間的間隔為Δη.

3)測量過程.每個新粒子φt(x,y,ν,θy,θz,ω)都唯一地與一個二維模板κt(x,y,ν,θy,θz)相對應.以t-1 時刻獲得頭部位置為中心取得一個矩形區域作為t 時刻二維模板κt的搜索區域,該區域的大小由縮放尺度ν 來進行調整.在此搜索區域內滑動二維模板κt,并計算二維模板κt對應粒子φt的權重.當Nt個粒子的權重都計算完成,便形成了t 時刻的粒子集Φt.通過計算Φt中權重最大的M個粒子的均值獲得t 時刻的系統狀態.

圖4 柵格粒子濾波器的執行過程

1.3 相似性度量

在t 時刻圖像中,令φt(x,y,ν,θy,θz,ω)為一個新粒子,其對應的二維模 板為κt(x,y,ν,θy,θz).根據文獻[8]中介紹的方法,將粒子濾波的測量過程中二維模板κt搜索區域對應的圖像轉換為距離變換圖(圖5),然后計算該二維模板邊緣圖像的Chamfer 距離,以該距離的倒數作為粒子φt的權重:

式中:n 為二維模板κt邊緣圖像邊緣像素點個數;Vi為二維模板κt邊緣圖像上第i 個邊緣像素點對應的距離變換圖上相應位置像素點值.

圖5 生成距離變換圖

2 頭肩三維姿態估計

根據人體結構特征,人體的兩肩姿態能夠反映人體上半身即頭肩部的姿態.經過柵格粒子濾波過程,獲得了第t 幀圖像的系統狀態向量().其中,向量)為當前人體頭-肩結構的空間姿態.頭-肩三維模型向圖像平面投影生成相應的二維模板時,由于深度歧義性,會發生兩個三維模型對應同一個二維模板的情況(圖6).為了不引起混淆,本文使用的頭-肩三維模型庫中不包括含有人體背部信息的模型(θy[-90,90]).

考慮到人頭部前后顏色差異比較明顯,本文使用顏色信息來解決這一問題.具體方法為:通過學習獲得人臉和后腦的HSV 顏色空間中S-V 二維顏色直方圖和.經過粒子濾波過程可以獲得頭部和肩部的位置,同時計算出頭部區域的S-V 二維顏色直方圖Hhead.然后使用Bhattacharyya 距離[9]計算Hhead與兩直方圖間的距離B(Hhead,)和B(Hhead).最 后 對系統狀態向量進行更正(圖6).

圖6 深度歧義性示意圖(攝像機拍攝方向與Zw 軸方向相同)

3 實驗結果與分析

使用本文方法對布朗大學的人體姿態數據庫[10]中的部分數據進行了實驗.選取數據庫中視頻集S2 內包括行走(walking)、慢跑(jog)、揮手(gestures)和拳擊(box)等4 段視頻進行了頭部、肩部的二維跟蹤和人體頭肩三維姿態估計.本文的目標是依據單目攝像機的視頻序列進行跟蹤,因此只選擇了攝像機C1 拍攝的彩色圖像序列進行實驗.

在生成三維模型庫時,取ν ∈[0.9,1.9],θy∈[-90,90]和θz∈[-20,20],相應采樣率的取值分別為Δν=0.1,Δθy=45 和Δθz=5,這樣三維模型庫中共有450 個模型.在進行粒子濾波的預測過程時,各維度上的取值如表1 所示.

實驗中使用的真值是通過在測試視頻上進行手工標記獲得的.表2 為使用本文方法進行頭部和肩部二維跟蹤的誤差均值和標準差.

文獻[6]中,對頭部跟蹤的平均誤差為9.28 像素(約為3.3 mm),對肩部跟蹤的平均誤差為9.09 像素(約為3.2 mm),在Intel-Xeon 2.8 GHz計算機上的處理速度>2 s/幀(只是確定人體位置和方向所用時間,未計算頭部和肩部跟蹤所用時間).而本文的相應平均誤差分別為7.80 像素(約為2.7 mm)和11.60 像素(約為4.1 mm),頭-肩二維跟蹤在Intel Core2 2.0 GHz計算機上平均處理速度為0.17 s/幀.可見本文方法與文獻[6]相比具有近似的結果但具有更好的運行效率.

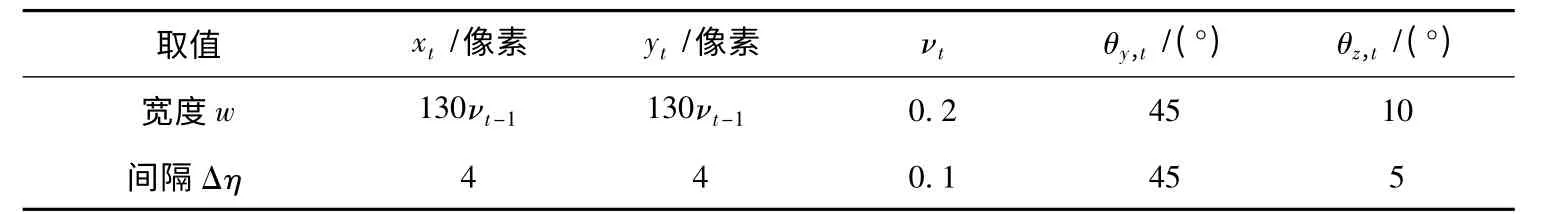

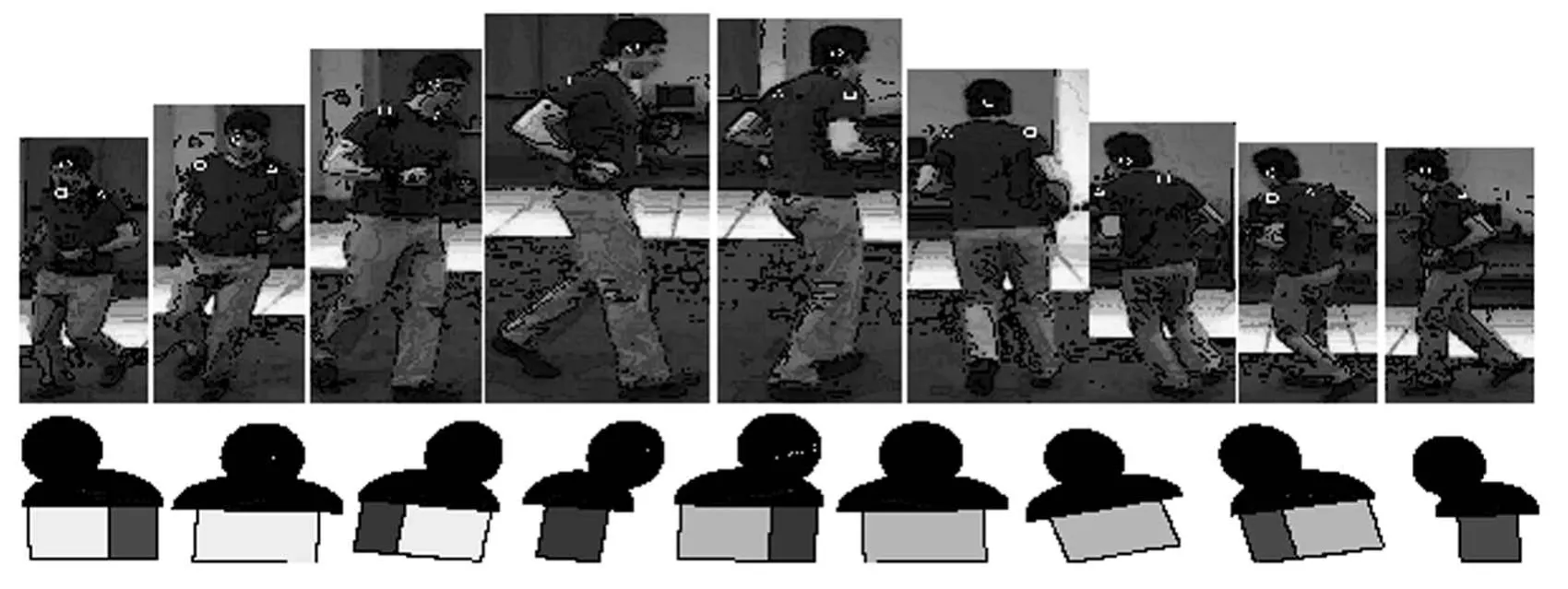

本文實驗過程所使用的平臺為Intel Core2 2.0GHz CPU,對每一段視頻進行頭-肩二維跟蹤的平均處理速度如表2 所示.圖7 顯示了對“慢跑”視頻片段中人體頭肩部分三維姿態估計的結果.從圖7 中可以看出,即使當肩部被完全遮擋,本文方法仍能夠正確跟蹤到頭部和肩部的位置,并進行比較精確的三維姿態估計.另外,本文方法還具有較強的魯棒性——當由于嚴重的遮擋而出現跟蹤失敗時能夠在遮擋消失后迅速恢復(圖8).

表1 粒子濾波預測過程中t 時刻各維度上的取值

表2 二維跟蹤的誤差及計算速度統計表

圖7 “慢跑”視頻片段的實驗結果

圖8 “拳擊”視頻片段的實驗結果

4 結 論

1)建立了一個頭肩三維模型;通過調整該模型的參數,并向圖像平面投影,獲得不同尺度下的若干二維模板,用來進行邊緣相似性匹配;應用柵格粒子濾波搜索狀態空間,獲得視頻數據中人體頭肩位置和三維姿態.

2)從實驗結果可以看出,本文方法具有較高的效率和較強的魯棒性.該算法不需要任何人工初始化過程,有效降低了跟蹤過程中使用的粒子數量,實現了快速的跟蹤和姿態估計.

[1]WACHTER S,NAGEL H H.Tracking persons in monocular image sequences[J].Computer Vision and Image Understanding,1999,74(3):174-192.

[2]SMINCHISESCU C,TRIGGS B.Kinematic jump processes for monocular 3D human tracking[C]//Proceedings 2003 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.[s.l.]:[s.n.],2003:16-22.

[3]LEE M W,COHEN I.Proposal maps driven MCMC for estimating human body pose in static images[C]//Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington:IEEE Xplore,2004.

[4]NAVARATNAM R,THAYANANTHAN A,TORR P H S,et al.Hierarchical part-based human body pose estimation[C]//In the 16th British Machine Vision Conference.[s.l.]:[s.n.],2005.

[5]MOESLUND T B.Pose estimating the human arm using kinematics and the sequential monte carlo framework[C]//Chapter 4 in part IX of Cutting Edge Robotics.KORDIC V,LAZINICA A,MERDAN M.Published by Pro Literatur Verlag,2005.

[6]LEE M W,NEVATIA R.Body part detection for human pose estimation and tracking[C]//Proceedings of the IEEE Workshop on Motion and Video Computing.Washington:IEEE Computer Society,2007:23.

[7]LEE M W,COHEN I.A model-based approach for estimating human 3D poses in static images[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(6):905-916.

[8]BORGEFORSG.Hierarchical chamfer matching:A parametric edge matching algorithm[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1988,10(6):849-865.

[9]AHERNE F,THACKER N,ROCKETT P.The bhattacharyya metric as an absolute similarity measurefor frequency coded data[J].Kybernetika,1998,34(4):363-368.

[10]SIGAL L,BLACK M J.Humaneva:Syncronized video and motion capture dataset for evaluation of articulated human motion[R].Providence:Brown Univertsity TR,2006.