基于子空間的目標跟蹤算法研究

李靜宇,王延杰

(中國科學院 長春光學精密機械與物理研究所,吉林 長春 130033)

1 引 言

目標跟蹤算法本質上是將非平穩的、隨時間變化的目標和背景圖像流進行處理,提取出感興趣的目標在圖像中的位置和速度等信息。末制導跟蹤階段,導彈的飛行姿態,彈體與目標的距離以及目標自身的運動姿態和形態均會發生較大的變化,從而導致拍攝到的目標發生旋轉、縮放、甚至變形,極大地增加了對目標進行持續穩定跟蹤的難度[1-3]。大多數現有的算法盡管能夠在受控的環境中或者較短的時間周期內跟蹤目標,但是當目標發生形態變化或者周圍光照發生改變時,通常跟蹤失敗[4-6]。原因是這類算法通常采用固定的外觀模型表達目標,這種模型外觀在跟蹤初始階段一旦建立就不再改變,因而忽略了大量的跟蹤過程中的信息(如形狀的變化或特定的照明條件)。

為了改善對目標外觀模型變化的適應性,Ross[7]等提出了一種可以在線更新的子空間作為目標的外觀表達模型,取得了很好的效果。本章借鑒其思想,提出一種新的基于粒子濾波的子空間跟蹤算法,在跟蹤過程中有效地學習和更新用來表示目標對象的低維子空間。具有以下優點:用一組正交的稀疏子空間特征向量表示目標模型,而不是用單個模板,提供了一個緊湊和便于區分的目標表達方式,降低了圖像數據的維度;采用增量方法不斷更新子空間模型,以適應由于目標內在和外在因素所造成的在外觀上的變化,從而提高跟蹤精度;采用八參數的動態模型估計目標的運動狀態,更接近真實情況;增量更新的子空間,采用在線學習的方式創建目標模型,不需要事先準備訓練圖像數據庫;采用重要性采樣算法以及最大似然估計,解決復雜的優化問題,取代了傳統的梯度下降法,從而縮短了算法的運行時間。此外,該算法不需要背景的先驗知識,當攝像機和背景圖像發生相對運動時,仍然能夠實現持續、穩定的跟蹤,提高了末制導跟蹤的穩定性和魯棒性。

2 基于子空間的目標跟蹤算法

2.1 稀疏矩陣特征提取

眾所周知,圖像是一個由大量像素組成的二維數組,給后續的處理帶來了大量的數據量[8-9]。為了減小計算量,并不影響識別與跟蹤性能,本文采用稀疏矩陣提取目標的特征。假設目標在相鄰兩幀中的運動滿足透視變換[10],即

(1)

其中:(x,y,1),(x′,y′,1)分別為相鄰兩幀目標圖像的齊次坐標表示,H為透視變換矩陣,是一個3×3矩陣,去掉歸一化系數w,共有8個自由度,可分解為如下形式:

(2)

定義1:(tx,ty,sxsy,θ,α,β,γ)為目標的八參數表述。tx,ty表示目標的中心位置,sx,sy表示目標縮放的比例因子,θ,α,β,γ表示目標發生旋轉、斜切和梯形變換的角度。

定義2:稀疏矩陣特征提取:已知目標圖像I的實際大小為H×W,稀疏圖像T的維度為N×M,坐標系為直角坐標系,圖像的左上角為坐標原點,向右向下為正,表達式、為稀疏矩陣特征提取過程

T(n,m)=I(h,w),

(3)

(4)

圖1 稀疏矩陣特征提取Fig.1 Sparse matrix feature extraction

其中:m=1,2,…,M,n=1,2,…,N,w=1,2,…,W,h=1,2,…,H、?為歸一化系數。

圖1分別給出了8×8、16×16、32×32和64×64的稀疏矩陣特征提取結果。

2.2 子空間的建立與更新

假設已經得到n幅空間配準的目標圖像,每個圖像應用2.1節中的方法,生成一個大小為M×N維的稀疏矩陣。將所有像素按列重新排成一列,將有n個p=M×N維向量(I1,I2,…,In),它們可以被看成是隨機向量I的樣本,其期望為μ。

(5)

(6)

(7)

圖2 目標子空間的建立Fig.2 Establishment of the target subspace

2.3 系統動態模型

如前所述,目標在圖像中的定位可以采用八參數表述(X=(tx,ty,sxsy,θ,α,β,γ)T)。

一般情況下,可以假設目標在相鄰幀中做隨機布朗運動[11-12],目標在t時刻的狀態Xt以t-1時刻的狀態Xt-1為中心,滿足高斯分布:

pXtXt-1=NXt;Xt-1,Ψ,

(8)

其中:Ψ為對角矩陣,對角線上的元素為相應的透視變換參數的方差:

(9)

2.4 系統觀測模型

目標圖像的觀測值It可以通過目標圖像均值μ和子空間特征向量集U表示:

p(ItXt)=N(It;μ,UUT+εI),

(10)

其中ε→0,I為單位陣,εI為系統的觀測噪聲。因此觀測值It的似然概率:

UUT+εI-1It-μ,

(11)

其中:

(12)

2.5 最大似然估計

目標的狀態X是潛在的變量,我們無法知道它真實值的大小。但是我們可以有效地采用抽樣方法近似估計目標的狀態。根據目標的動態模型,進行隨機抽樣,對于每一個樣本狀態Xi,我們計算它的似然概率p(It|Xi)。使似然概率取得最大值時的樣本狀態,將作為新的目標狀態。

(13)

3 結果與討論

實驗一為采用加拿大多倫多大學機器學習實驗室的“dudek”視頻序列所做的跟蹤實驗,實驗結果如圖3所示。

圖3 跟蹤實驗一Fig.3 Tracking experiment one

圖中藍色細線框為Ross 的IVT算法跟蹤結果,紅色粗線框為本文跟蹤結果,黃色的“x”為標志特征點的實際位置,紅色“x”為本文算法估計的位置。同樣采用300個粒子,從圖中可以看出IVT算法在第295幀之后發生偏移。原因是由于本文采用八參數的目標稀疏表述方法更接近目標運動的真實情況,當目標發生部分遮擋(104幀和492幀),旋轉(107幀、194幀和561幀),以及光線變化(398幀)時均能夠實現穩定的跟蹤。

圖4為本文算法和IVT算法的跟蹤誤差比較曲線。橫坐標代表幀號,縱坐標代表標志特征點的實際位置與估計取值的均方誤差。本文算法僅在被部分遮擋的104幀和492幀出現誤差峰值,之后便能迅速恢復穩定跟蹤。

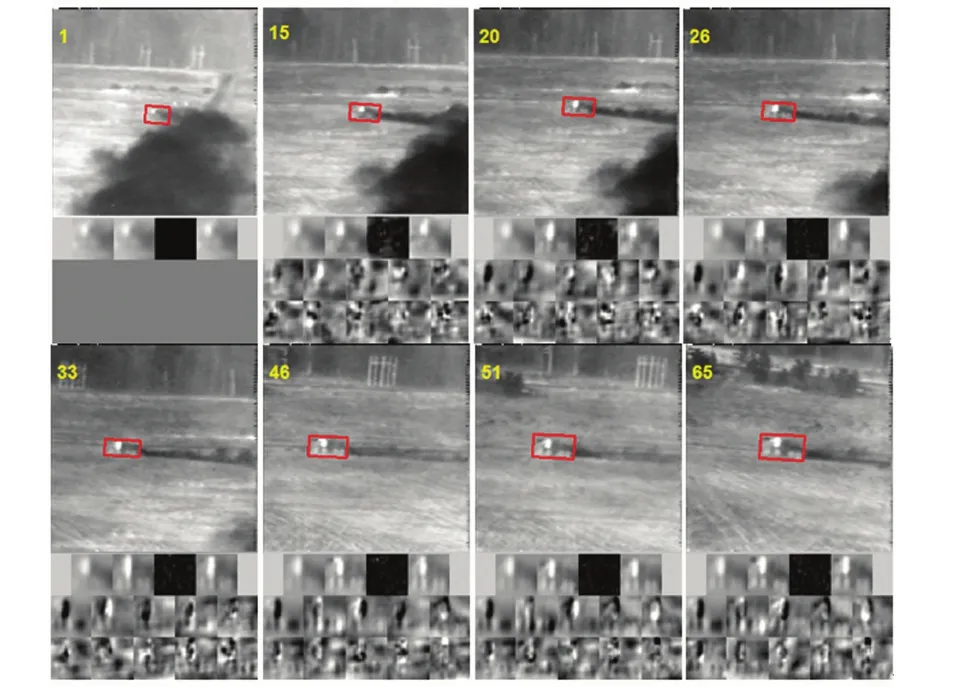

實驗二為外場試驗的跟蹤結果,如圖5所示。每一幅圖由15幅子圖組成,最大的一幅為當前幀的跟蹤結果,紅色框為目標在當前幀的運動狀態。

下面的四幅子圖為目標的平均值、當前跟蹤窗內的目標圖像、目標在子空間投影的誤差圖像和目標重建圖像。最下面的十幅為目標子空間基圖像。跟蹤過程中目標尺度迅速變大,并且受到尾氣的干擾,本文算法能夠實現對其穩定跟蹤。

圖4 跟蹤誤差比較Fig.4 Comparison of tracking error

圖5 跟蹤實驗二Fig.5 Tracking experiment two

4 結 論

本文提出的基于子空間的目標跟蹤算法采用增量的形式更新目標子空間模型,為目標的描述構造了一個低維的子空間模型,該算法能夠適應目標外觀的時變特征。實驗結果證明,當目標發生旋轉、縮放以及亮度變化和部分遮擋等情況時,仍然能夠實現對目標的長時間魯棒跟蹤,平均跟蹤誤差小于10個像素。基本滿足末制導跟蹤系統的穩定性和魯棒性等要求。

[1] 陳尚峰. 成像末制導目標檢測與跟蹤技術研究 [D]. 長沙:國防科學技術大學,2009.

Chen C F. Research on targets detecting and tracking for image homing guidance [D]. Changsha:National University of Defense Technology,2009. (in Chinese)

[2] 朱秋平,顏佳,張虎,等. 基于壓縮感知的多特征實時跟蹤[J]. 光學 精密工程,2013,21(2):437-444.

Zhu Q P,Yan J,Zhang H,etal. Real time tracking using multiple features based on compressive sensing [J].Opt.PrecisionEng.,2013,21(2):437-444. (in Chinese)

[3] 賈平,徐寧,張葉. 基于局部特征提取的目標自動識別[J]. 光學 精密工程,2013,21(7):1898-1905.

Jia P,Xu N,Zhang Y. Automatic target recognition based on local feature extraction [J].Opt.PrecisionEnginee-ring,2013,21(7):1898-1905. (in Chinese)

[4] Li J Y,Wang Y L,Wang Y J. Visual tracking and learning using speeded up robust features [J].PatternRecognitionLetters,2012,33(16):2094-2101.

[5] 王田,劉偉寧,韓廣良,等. 基于改進MeanShift的目標跟蹤算法 [J]. 液晶與顯示,2012,27(3):396-400.

Wang T,Liu W N,Han G L,etal. Target tracking algorithm based on improved Meanshift [J].ChineseJournalofLiquidCrystalsandDisplays,2012,27(3):396-400. (in Chinese)

[6] 劉揚,張云峰,董月芳. 復雜背景下抗遮擋的運動目標跟蹤算法 [J]. 液晶與顯示,2010,25(6):890-895.

Liu Y,Zhang Y F,Dong Y F. Anti-occlusion algorithm of tracking moving object in clutter background [J].ChineseJournalofLiquidCrystalsandDisplays, 2010,25(6):890-895. (in Chinese)

[7] Ross D A,Lim J,Lin R,etal. Incremental learning for robust visual tracking [J].InternationalJournalofComputerVision,2008,77(1-3):125-141.

[8] 葛微,程宇奇,劉春香,等. 基于子空間分析的人臉識別方法研究 [J].中國光學與應用光學,2009,2(5):377-387.

Ge W,Cheng Y Q,Liu C X,etal. Research of face recognition methods base on subspace analysis [J].ChineseJournalofOpticsandAppliedOptics,2009,2(5):377-387. (in Chinese)

[9] 孫曉燕,常發亮. 梯度特征稀疏表示目標跟蹤 [J]. 光學 精密工程,2013,21(12):3191-3197.

Sun X Y,Chang F L. Object tracking based on sparse representation of gradient feature [J].Opt.PrecisionEng.,2013,21(12):3191-3197. (in Chinese)

[10] 李忠新.圖像鑲嵌理論及若干算法研究 [D].南京:南京理工大學,2004.

Li Z X. On the theory of image mosaicing and its related algorithms [D]. Nanjing:Nanjing University of Science and Technology,2004. (in Chinese)

[11] 錢誠. 增量型目標跟蹤關鍵技術研究 [D].杭州:浙江大學,2011.

Qian C. Research on key techniques of incremental object tracking [D]. Hangzhou:Zhejiang University,2011. (in Chinese)

[12] 杜超,劉偉寧,劉戀. 一種基于卡爾曼濾波及粒子濾波的目標跟蹤算法 [J]. 液晶與顯示,2011,26(3):384-389.

Du C,Liu W N,Liu L. Target tracking algorithm based on kalman filter and particle filter [J].ChineseJournalofLiquidCrystalsandDisplays, 2011,26(3):384-389 . (in Chinese)