基于近似結構風險的ELM隱層節點數優化

黃重慶,徐哲壯,黃宴委,賴大虎

(福州大學電氣工程與自動化學院,福州350108)

基于近似結構風險的ELM隱層節點數優化

黃重慶,徐哲壯,黃宴委,賴大虎

(福州大學電氣工程與自動化學院,福州350108)

隱層節點數是影響極端學習機(ELM)泛化性能的關鍵參數,針對傳統的ELM隱層節點數確定算法中優化過程復雜、容易過學習或陷入局部最優的問題,提出結構風險最小化-極端學習機(SRM-ELM)算法。通過分析VC維與隱層節點數量之間的關聯,對VC信任函數進行近似改進,使其為凹函數,并結合經驗風險重構近似的SRM。在此基礎上,將粒子群優化的位置值直接作為ELM的隱層節點數,利用粒子群算法最小化結構風險函數獲得極端學習機的隱層節點數,作為最優節點數。使用6組UCI數據和膠囊缺陷數據進行仿真驗證,結果表明,該算法能獲得極端學習機的最優節點數,并具有更好的泛化能力。

極端學習機;結構風險;VC信任;粒子群優化;隱層節點數

1 概述

極端學習機(Extreme Learning Machine,ELM)[1]是一種單隱層前饋神經網絡,具有運算速度快、泛化性能好等特點。與普通的前饋神經網絡一樣,ELM為保證良好的泛化性能,確定合適的隱層節點數量尤為重要。文獻[2]指出,ELM雖然避免了梯度下降法存在的問題,但如何確定最優隱層節點數,避免反復試驗調節,依然是個亟待解決的問題。文獻[3]針對稀疏數據學習問題提出了RCGA-ELM算法,利用遺傳算法,優化ELM的隱層節點數、權重w和偏置b,由于涉及多重算子,算法復雜,耗費大量時間。為了降低算法復雜度,提出了S-ELM算法,以5倍交叉驗證來選擇S-ELM的最佳參數w和b值。PSO-ELM[4], IPSO-ELM[5]和ICGA-SRM-ELM[6]均提出基于粒子群優化(Particle Swarm Optimization,PSO)算法對ELM進行改進,其中,PSO-ELM以均方根誤差為優化目標針對ELM中的w和b進行自動選擇與優化。IPSO-ELM與ICGA-SRM-ELM類似,強調優化ELM的w和隱層節點數,但IPSO-ELM強調優化ELM的w值,并未涉及隱層節點數的優化問題,而且優化目標函數及迭代選擇標準與E-ELM[7]無實質差別。ICGA-SRM-ELM則針對在經驗風險最小化原則下對隱層節點數進行分析,但沒給出具體形式。文獻[8]提出一種能自動確定隱層節點的OP-ELM算法,但是需通過多元稀疏回歸和留一(LOO)算法,把開始設定的大隱層節點數刪減到最佳值,這與EM-ELM和μGELM[9]一樣,需要多重判斷標準機制來選擇增加或刪減節點,使整個算法趨于復雜。此外,μG-ELM用遺傳算法優化隱層節點數,給出的優化目標函數僅僅是經驗風險最小化,容易出現過學習。這些工作對ELM的可調參數優化研究都做出了或多或少的貢獻,但還是存在一些不足之處:(1)沒有給出具體的優化目標函數;(2)優化目標函數為經驗風險,容易出現過學習或陷入局部最優;(3)利用遺傳、差分進化算法優化過程復雜。

本文提出一種SRM-ELM算法,改進VC信任函數以獲得凹函數,與經驗風險構成近似的結構風險最小化(Structural Risk Minimization,SRM)函數,利用PSO算法尋找SRM最小化時的ELM隱層節點數,為最佳的隱層節點數量。最后,由6組UCI數據和膠囊缺陷數據來仿真驗證SRM-ELM的可行性與性能。

2 ELM基本原理

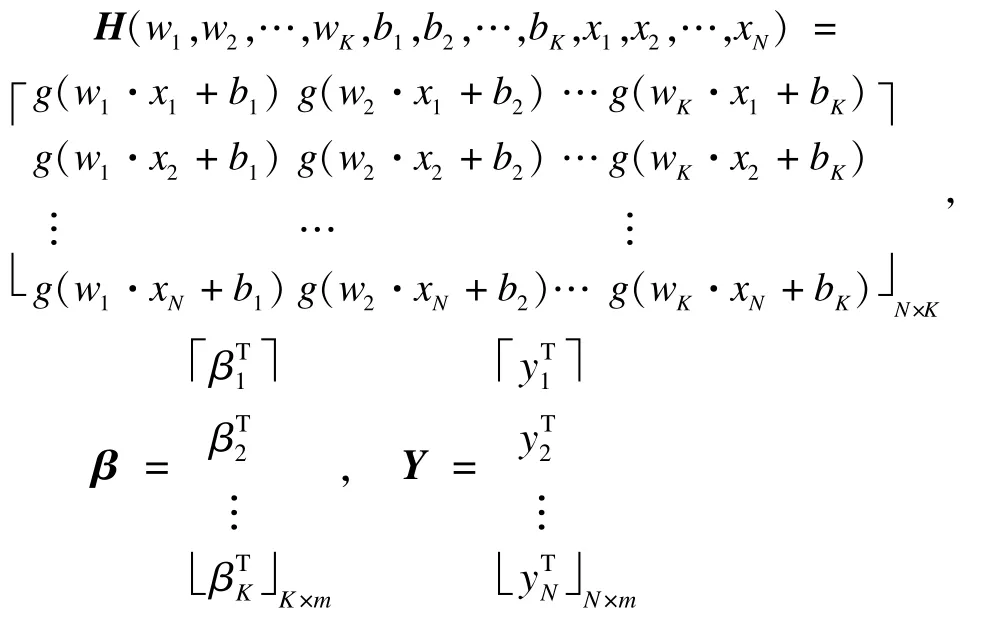

給定N個訓練樣本(xi,yi),xi=[xi1,xi2,…, xin]T∈Rn,yi=[yi1,yi2,…,yim]T∈Rm,i=1,2,…, N。令隱層節點數量為K,激活函數為g(w,x,b),可構造一個單隱層網絡,則ELM模型為:

其中,i=1,2,…,N;j=1,2,…,K;wj=[wj1,wj2,…,wjn]T是連接輸入節點到第j個隱層節點的輸入權重;βj=[βj1,βj2,…,βjm]T是連接第j個隱層節點到輸出節點的輸出權重;bj是第 j個隱層節點的閾值。

把N個學習樣本分別代入式(1)中可得:

其中:

H稱為網絡隱層輸出矩陣。在一般情況下,隱層節點數遠小于訓練樣本數,即K?N,H就可能不是一個方陣,因此需求H的偽逆,即Moore-Penrose廣義逆。在式(2)中,任意人為給定w和b,以及激活函數g(w,x,b),由Moore-Penrose廣義逆定理求得廣義逆H+,從而β的解為:

與傳統的梯度下降法比較,ELM具有運算速度快和不需反復調整權值等特點[10],但隱層節點數K成為影響ELM泛化性能的重要因素之一,如何自動選擇參數K為本文研究重點。

3 SRM-ELM算法

3.1 SRM原理

為克服經驗風險最小化存在的過學習問題,文獻[11]提出了SRM[11],有如下結論:

對于來自具有有限VC維h的完全有界函數集0≤Q(z,α)≤B,α∈Λ的所有函數,則:

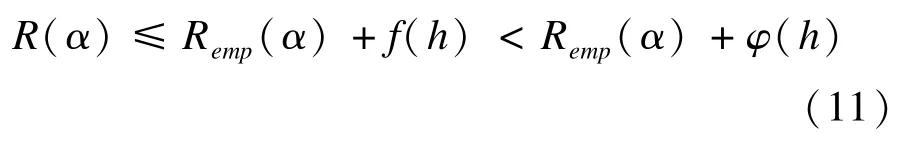

成立的概率至少為1-η。式中R(α)為期望風險;Remp(α)為經驗風險,且:

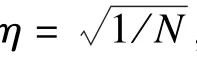

其中,N為樣本數量,0<a≤4,0<b≤2,η∈(0,1],兩類問題中B=1,式(4)右邊第2項稱為VC信任或VC置信區間。由SRM原則,為使R(α)最小,則必須使Remp(α)和VC信任總和最小。而在給定樣本情況下,VC信任取決于整個函數集的VC維h。從文獻[12-14]可知,隱層激活函數為sigmoid的神經網絡VC維為:

其中,λ為網絡的權值個數;l為網絡的隱層數;n0為隱層神經元和輸出層神經元的總數。

由式(6)可知,h均與λ有關,對ELM來講,l= 1,則:

其中,n為ELM輸入維數;m為ELM輸出維數;n和m由樣本確定。在n和m已知情況下,由式(7)可知VC維h為隱層節點數K的函數。

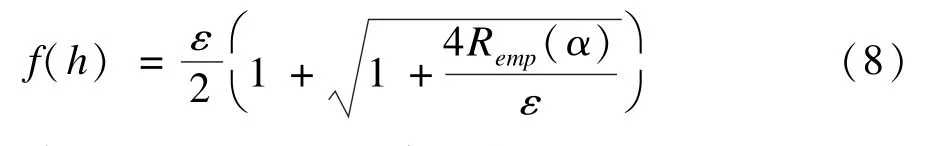

根據統計學習理論,令式(4)中B=1,則VC信任可寫成:

令a=4,b=1,對h求一次導得:

由式(9)可知,h=N時為僅有的極大值點,即h=N時f(h)取得最大值。

3.2 VC信任函數的改進

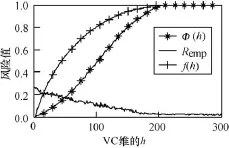

利用UCI數據庫中的Haberman數據進行VC信任函數式(9)特性分析。圖1為VC信任函數f(h)與h的關系。在h∈[0,N]時f(h)為凸函數(經過歸一化),則式(4)右邊兩項的和很難求出全局最小值,相反很容易陷入局部最小值,為此需要對f(h)進行改進。

不難發現,對于任意h,滿足下列公式:

則式(4)寫成:

另一方面,由式(4)得出概率:

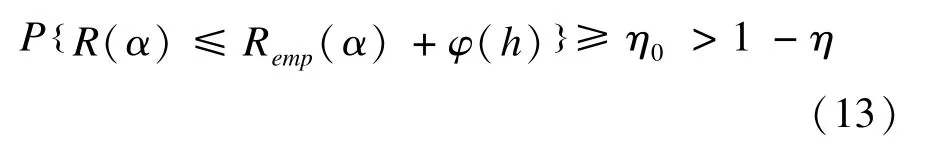

由式(11)和式(12),得:

其中,η0∈(0,1],η∈(0,1]。即不等式:

成立的概率至少為1-η。

同樣利用UCI數據庫中的Haberman數據對改進后的VC信任函數φ(h)與VC維h之間的關系進行分析,如圖1所示。從圖1可知,改進后VC信任φ(h)為VC維h的凹函數,式(14)是VC維h的函數,可近似獲得ELM的泛化能力:

圖1 f(h)、φ(h)與h的關系

3.3 PSO基本原理

本文把PSO的位置值直接作為ELM的隱層節點數,PSO每迭代一次相當于ELM訓練一次,迭代完畢后即獲得最優隱層節點數。

基于慣性權重的粒子速度v和位置p更新公式為:

其中,是粒子i在第k次迭代中的第d維位置;是粒子i在第k次迭代中的第d維速度;為粒子i在第k次迭代中第d維達到的最好位置;為粒子群在第k次迭代中第d維達到的最優位置,d=1,2,…,N;c1,c2為學習因子,一般c1=c2=2;rand1,rand2介于(0,1)之間。

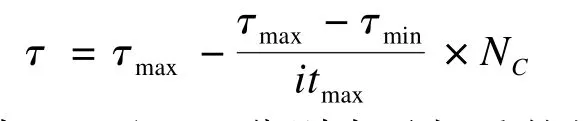

慣性權重τ計算公式為:

其中,τmax和τmin分別表示權重的最大值和最小值;itmax表示最大的迭代次數;NC表示當前迭代的次數。粒子在搜索過程中都有一個最大最小速度和最大最小位置,設置規則見PSO-ELM[4]。

PSO算法的優勢在于結構簡單,容易實現,且沒有過多參數需要調整,可以直接把粒子的位置參數替換成需要優化的決策變量。SRM-ELM直接把PSO的位置值當作隱層節點數,粒子群最終達到的最佳位置就是所要尋找的最優節點數。

3.4 SRM-ELM算法流程

SRM-ELM算法步驟如下:

Step 1 粒子種群初始化。

Step 2 粒子的位置量p直接作為隱層節點數K賦予ELM。

Step 3 在ELM訓練的過程中,根據每個粒子的位置值(隱層節點數)計算對應的目標函數R(α,h)。

Step 4 更新粒子最優位置pbest和粒子群最優位置gbest。如果當前粒子的R(α,h)比上一代小,則對應的位置作為目前粒子到達的最優位置;如果當前粒子群的最小R(α,h)比上一代的小,則對應的位置作為目前粒子群到達的最優位置。否則不更新。

Step 5 更新粒子位置p和速度v。根據式(16)和式(17)重新計算粒子的位置和速度。

Step 6 迭代終止。如果NC>itmax,則優化結束,最后得到的粒子群最優位置即所求的最優隱層節點數K。否則轉到Step2循環操作。

PSO和ELM的結合關鍵在于PSO把位置值賦予ELM,作為隱層節點于ELM主體中,同時把目標函數R(α,h)植入ELM,隨著PSO算法的迭代,逐漸接近最好的位置,即逐漸優化出最佳隱層節點數。

4 仿真實驗

4.1 參數設置

4.2 UCI數據

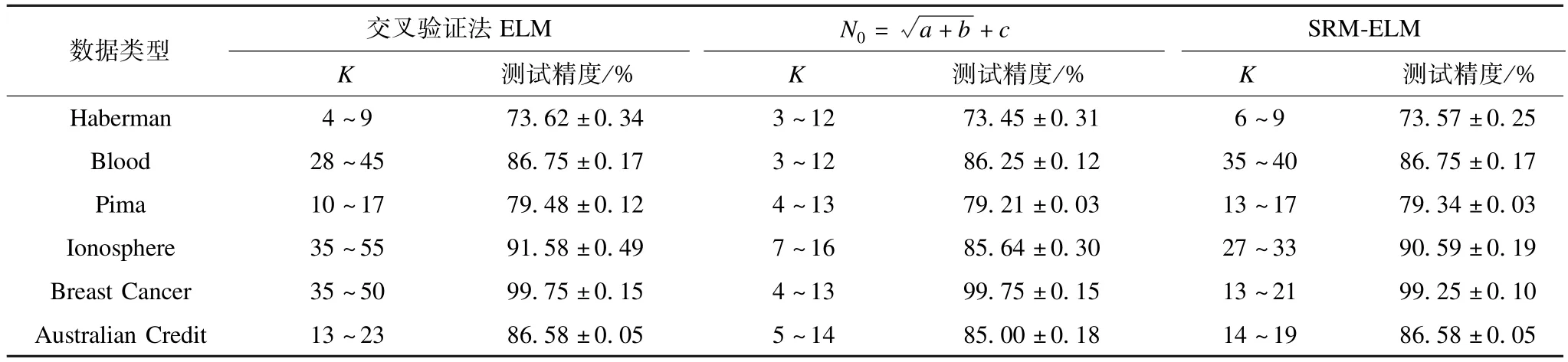

本文分別用UCI數據庫中的6組2類數據來驗證SRM-ELM算法,6組數據如表1所示。

表1 數據信息

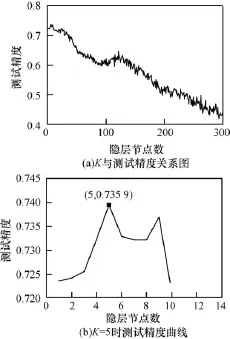

在ELM設計時,一般利用交叉驗證法在K值預設定的范圍內確定最佳隱層節點數K。由Haberman數據進行仿真,假設令K從1~300遞增,依次得到對測試樣本的分類精度如圖2(a)所示,圖2(b)為最高測試精度為0.739 6所對應的隱層節點數K=5。從圖2可知隨著K值繼續增加,ELM的測量精度總體上是遞減的,當4≤K≤9時,ELM具有很好的測試精度。

利用SRM-ELM算法對6組數據分別連續重復仿真50次,求平均值確定最佳隱層節點數K完成ELM網絡設計。圖3為Haberman數據的仿真結果,其中圖3(a)為50次仿真所得到的隱層節點數K,從50次仿真可知,K值主要集中于6≤K≤9,落在交叉驗證法得到K的范圍中。圖3(b)為第10次仿真中隱層節點數K收斂情況,K從1遞增到10,在第16代時收斂于7。對比圖3與圖2可知,由SRMELM算法所獲得K值能夠很好地符合由交叉驗證法得到的K值。

圖2 ELM對Haberman數據的測試精度

圖3 隱層節點數K分布

表2 SRM-ELM、ELM與試湊公式N0= +c的性能比較

表2 SRM-ELM、ELM與試湊公式N0= +c的性能比較

數據類型 交叉驗證法ELM N0= a+b+c SRM-ELMK測試精度/% K 測試精度/% K 測試精度/% Haberman 4~9 73.62±0.34 3~12 73.45±0.31 6~9 73.57±0.25 Blood 28~45 86.75±0.17 3~12 86.25±0.12 35~40 86.75±0.17 Pima 10~17 79.48±0.12 4~13 79.21±0.03 13~17 79.34±0.03 Ionosphere 35~55 91.58±0.49 7~16 85.64±0.30 27~33 90.59±0.19 Breast Cancer 35~50 99.75±0.15 4~13 99.75±0.15 13~21 99.25±0.10 Australian Credit 13~23 86.58±0.05 5~14 85.00±0.18 14~19 86.58±0.05

4.3 膠囊外觀缺陷檢測

圖4 正常膠囊和各種缺陷膠囊

表3 膠囊缺陷檢測結果

5 結束語

本文針對隱層節點數量影響ELM泛化性能的問題,提出一種SRM-ELM算法。SRM-ELM在結構風險最小化原則下,建立隱層節點數與泛化能力的關系函數,利用PSO簡單高效的全局搜索能力,優化ELM的隱層節點數,避免了傳統方法反復調節實驗的繁瑣。由6組標準數據實驗結果顯示,利用SRMELM計算得到的最優隱層節點數均落在交叉驗證法得到的ELM最優隱層節點數范圍內,保證了良好的泛化性能,與試湊法比較顯現出準確性高、推廣性好的優勢,并且可將該方法用于膠囊外觀缺陷檢測中。

[1] Huang Guangbin,ZhuQinyu,Siew C K.Extreme Learning Machine:A New Learning Scheme of Feed Forward Neural Networks[C]//Proc.of IEEE International Joint Conference on Neural Networks. [S.l.]:IEEE Press,2004:985-990.

[2] Feng Guorui,Huang Guangbin,Lin Qingping.Error Minimized Extreme Learning Machine with Growth of Hidden Nodes and Incremental Learning[J].IEEE Transactions on NeuralNetworks,2009,20(8): 1352-1357.

[3] Suresh S,Saraswathi S,Sundararajan N.Performance Enhancement of Extreme Learning Machine for Multicategory Sparse Cancer Classification[J].Engineering Applications of Artificial Intelligence,2010,23(7): 1149-1157.

[4] Xu You,Shu Yang.Evolutionary Extreme Learning Machine Based on Particle Swarm Optimization[C]// Advances in Neural Networks.[S.l.]:Springer,2006: 644-652.

[5] Han Fei,YaoHaifen,LingQinghua.AnImproved Extreme Learning Machine Based on Particle Swarm Optimization[C]//Proc.of the 7th International Conference on IntelligentComputing.Zhengzhou, China:[s.n.],2012:699-704.

[6] Saraswathi S,Sundaram S,Sundararajan N.ICGA-PSOELM Approach for Multiclass Cancer Classification Resulting Reduced Gene Sets in Which Genes Encoding Secreted Proteins are Highly Represented Inaccurate[J]. IEEE/ACM Transactions on Computational Biology and Bioinformatics,2010,8(2):452-463.

[7] Zhu Qinyu,Qin A K,Suganthan P N.Evolutionary Extreme Learning Machine[J].Pattern Recognition, 2005,38(10):1759-1763.

[8] Miche Y,Sorjamaa A,Bas P.OP-ELM:Optimally Pruned Extreme Learning Machine[J].IEEE Transactions on Neural Networks,2010,21(1):158-162.

[9] Lahoz D,Lacruz B,Mateo P M.A Biobjective Microgenetic Extreme Learning Machine[C]//Proc.of IEEE Workshop on Hybrid Intelligent Models and Applications.[S.l.]:IEEE Press,2011:68-75.

[10] Huang Guangbin,ZhuQinyu,Siew C K.Extreme Learning Machine[J].Neurocomputing,2006,70(1): 489-501.

[11] Vapnik V N.Statistical Learning Theory[M].New York, USA:Wiley,1998.

[12] Koiran P,Sontag E D.Neural Networks with Quadratic VC Dimension[J].Journal of Computer and System Science,1997,54(1):190-198.

[13] Bartlett P L,Maiorov V,Meir R.Almost Linear VC Dimension Bounds for Piecewise Polynomial Networks [J].Neural Computation,1998,10(8):2159-2173.

[14] Karpinski M,Macintyre A.Polynomial Bounds for VC Dimension of Sigmoidal and General Pfaffian Neural Networks[J].JournalofComputerand System Sciences,1997,54(1):169-176.

[15] 朱啟兵,劉 杰,李允公,等.基于結構風險最小化原則的奇異值分解降噪研究[J].振動工程學報,2005, 18(2):204-207.

編輯 顧逸斐

Optimization for Hidden Nodes Number of ELM Based on Approximate Structure Risk

HUANG Chong-qing,XU Zhe-zhuang,HUANG Yan-wei,LAI Da-hu

(College of Electrical Engineering&Automation,Fuzhou University,Fuzhou 350108,China)

The number of hidden nodes is a critical factor for the generalization of Extreme Learning Machine(ELM). There exists complex optimization process,over learning or traps in local optimum in traditional algorithm of calculating the number of hidden layer of ELM.Aiming at the problems,Structural Risk Minimization(SRM)-ELM is proposed. Combining empirical risk with VC confidence,this paper proposes a novel algorithm to automatically obtain the best one to guarantee good generalization.On this basis,the Particle Swarm Optimization(PSO)position value is directly treated as ELM hidden layer nodes,which employs the PSO in the optimizing process with Structural Risk Minimization(SRM) principle.The optimal number of hidden nodes is reasonable correspond to 6 cases.Simulation results show that the algorithm can obtain the extreme learning machine optimal nodes and better generalization ability.

Extreme Learning Machine(ELM);structural risk;VC confidence;Particle Swarm Optimization(PSO); hidden nodes number

1000-3428(2014)09-0215-05

A

TP18

10.3969/j.issn.1000-3428.2014.09.043

教育部博士點新教師基金資助項目(20113514120007);福建省教育廳科技基金資助項目(JA10034)。

黃重慶(1989-),男,碩士研究生,主研方向:圖像處理,智能系統;徐哲壯(通訊作者),講師、博士;黃宴委,副教授、博士;賴大虎,碩士。

2013-08-12

2013-10-10E-mail:297964854@qq.com