基于雙權(quán)重聚合的立體匹配算法

何 凱,朱程濤,姚靜嫻

(天津大學(xué) 電子信息工程學(xué)院,天津300072)

0 引 言

立體匹配算法主要是通過建立一個能量代價函數(shù),通過此能量代價函數(shù)最小化來估計像素點視差值[1]。由視差圖得到深度信息,再將深度信息用于三維場景的重建。立體匹配算法的實質(zhì)就是一個最優(yōu)化求解問題,通過建立合理的能量函數(shù),增加一些約束,采用最優(yōu)化理論的方法進行求解,這也是目前病態(tài)問題常用的求解方法。

目前國內(nèi)外學(xué)者已經(jīng)提出了許多立體匹配方法,如基于局部約束的立體匹配算法[2-5]以及全局約束的立體匹配算法[6-7]。局部立體匹配算法是利用興趣點周圍的局部信息進行計算,涉及信息量較少,相應(yīng)的計算復(fù)雜度較低;其優(yōu)點是算法速度快、效率高;缺點是其對噪聲較敏感,對低紋理區(qū)域、深度不連續(xù)區(qū)域效果不理想。

本文將所有鄰近像素的匹配代價與權(quán)值相結(jié)合,得到參考像素的聚合匹配代價;并采用文獻[8]中提出的SWS 方法進行快速匹配代價聚合減少計算復(fù)雜度。同時,在視差精煉階段,提出了基于聚合匹配代價平滑的精煉策略。

1 傳統(tǒng)局部立體匹配算法

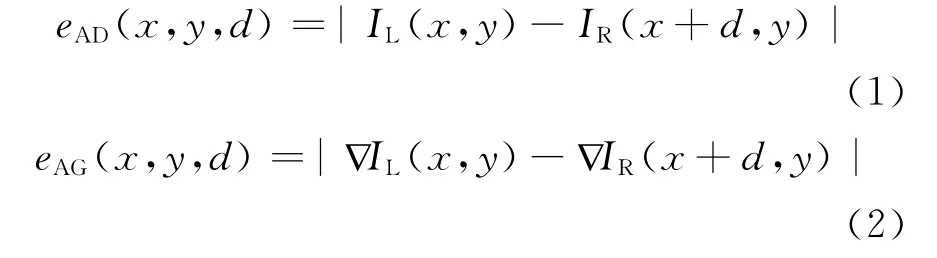

傳統(tǒng)算法通常采用AD、AG、NCC[9]等匹配代價:

式中:x、y 分別為像素點P 所在的列數(shù)、行數(shù);d為視差;IL、IR分別代表左、右圖;?IL、?IR分別代表左、右兩圖的梯度圖。

代價聚合則通常采用窗口聚合,即

式中:N(x,y)為參考像素(x,y)的鄰近區(qū)域;ek(i,j,d)代表某種類型的匹配代價;wk(i,j)為相應(yīng)的權(quán)重。

2 本文算法

提出了一種新的權(quán)重匹配代價聚合方法,以及基于該匹配代價的視差精煉方法。

2.1 匹配代價計算方法

式中:n 代表圖像R、G、B 三個通道;?xILn、?yILn分別代表左圖R、G、B 通道的水平、豎直方向梯度圖;?xIRn、?yIRn分別代表右圖R、G、B 通道的水平、豎直方向梯度圖;TD、TG是截斷閾值。與傳統(tǒng)方法采用灰度信息做匹配代價相比,本文采用3個通道的亮度信息,以提高匹配效率。

2.2 匹配代價聚合

為了提高匹配精度,必須采用一定的權(quán)重匹配代價方法進行聚合[10-12]。本文將參考像素周圍所有像素的匹配代價加以適當(dāng)權(quán)值,以得到參考像素的聚合匹配代價。

灰渣粒徑 60~100 目、投放量 2.5g·L-1、溫度 20℃,改變pH值,按1.3試驗方法對染液進行吸附處理。實驗結(jié)果見圖3。

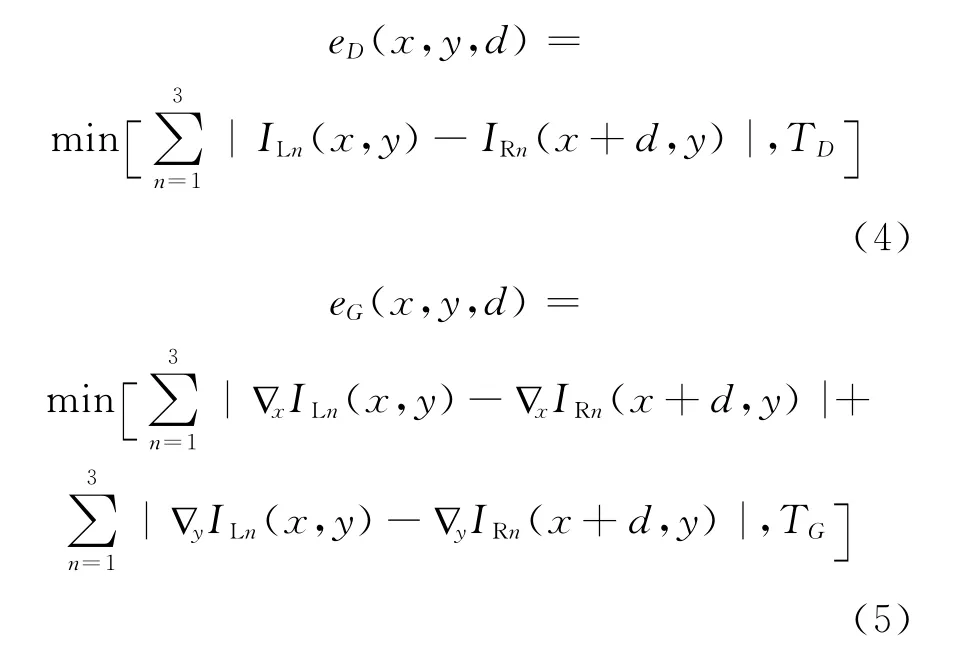

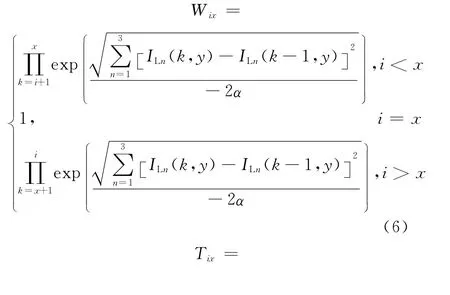

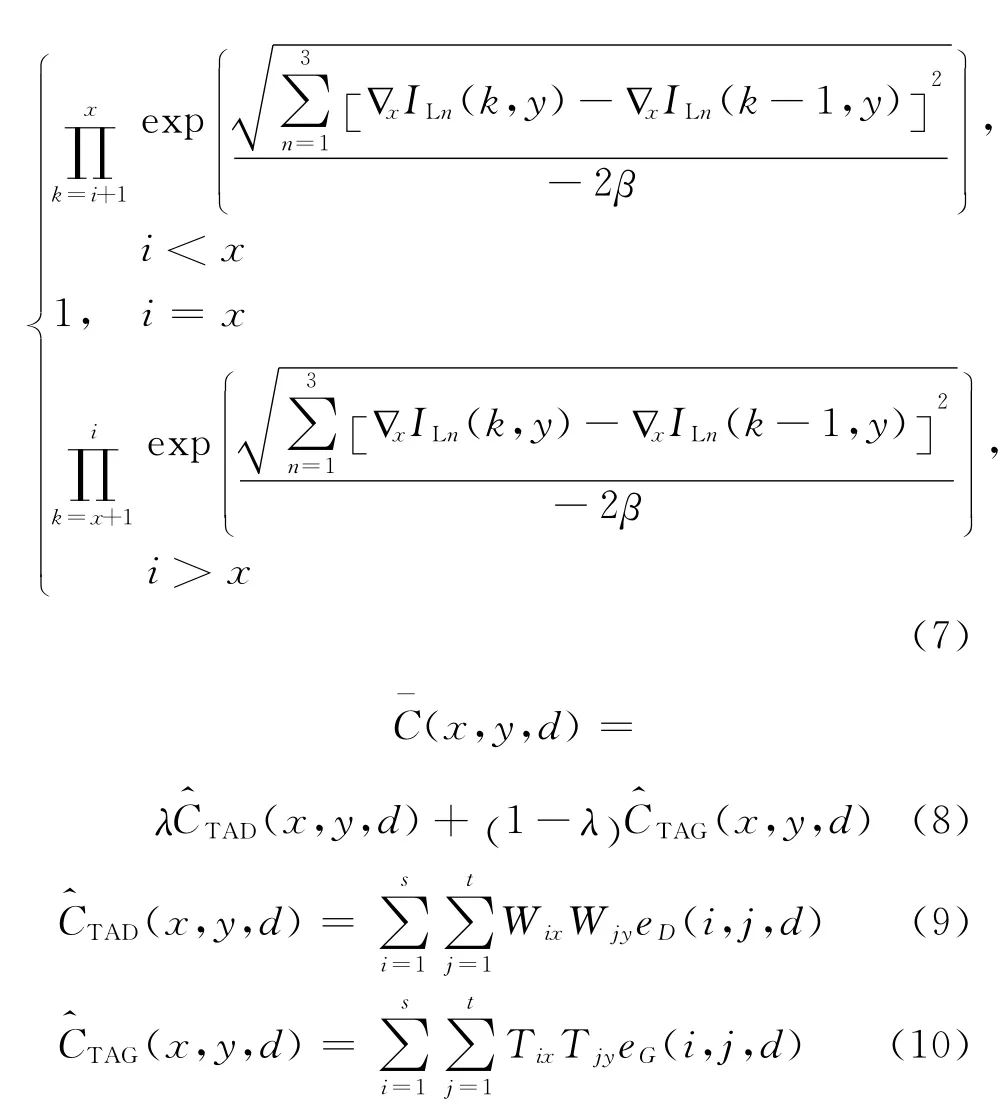

權(quán)重的設(shè)置根據(jù)雙邊濾波的原則,即與參考像素亮度越相近的像素,TAD 聚合代價權(quán)重Wix、Wjy設(shè)置得越大;與參考像素梯度值越相近的像素,TAG 聚合代價權(quán)重Tix、Tjy設(shè)置得越大。此外,雙邊濾波中權(quán)重還考慮到空間信息,即離參考像素越近權(quán)重越大;任意一點像素到參考像素的聚合代價權(quán)重可以分解為橫向和縱向的權(quán)重乘積,即總權(quán)重是隨著空間距離的增大而減小。

本文將兩種不同聚合匹配代價的權(quán)值分開來考慮,即TAD 匹配代價的聚合權(quán)重依賴于亮度信息的差異,TAG 匹配代價的聚合權(quán)重依賴于梯度信息的差異,這樣的聚合權(quán)重設(shè)置更能反映不同權(quán)值對不同匹配代價的影響,且權(quán)重的設(shè)置使用R、G、B 三個通道的信息,較使用單一通道信息更為可靠。

類似地,Wjy、Tjy可分別參考Wix、Tix。匹配代價聚合的計算相當(dāng)于二維卷積,為了減少計算復(fù)雜度,可根據(jù)文獻[8]提出的降維算法,利用SWS(Successive weighted summation)將每個二維卷積運算分解為4個一維卷積,分別為匹配代價由左至右卷積、由右至左卷積、由上至下卷積、由下至上卷積。

2.3 視差精煉

視差值的計算一般采用WTA(Winner takes all)策略,即為

式中:S(d)是搜索視差集合,即S(d)={0,1,…,dmax}。

得到初始視差圖后,利用左右一致性檢測方法檢測視差異常值點,不滿足式(12)的點即為視差異常值點。

式中:Drl(x,y)是以左圖為參考圖得到的視差圖;Dlr(x,y)是以右圖為參考圖得到的視差圖。通常絕大多數(shù)異常點均為背景遮擋點,因此采用簡單的遮擋點視差填充方法[3]即可。

每個像素點對應(yīng)的視差值均為離散的整數(shù),將這些離散值直接用于三維重建會導(dǎo)致重建場景表面出現(xiàn)斷層,因此,必須對每個像素點聚合匹配代價函數(shù)進行平滑,以得到連續(xù)變化的視差值。

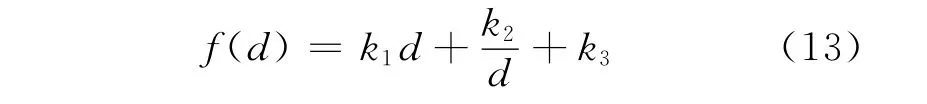

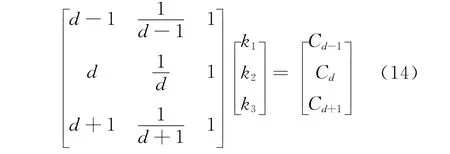

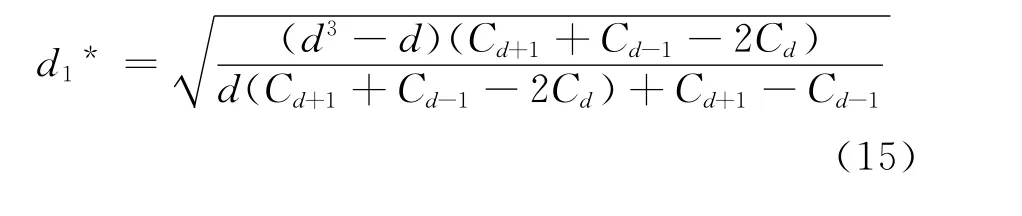

本文提出了一種新的平滑函數(shù),采用式(13)所示的雙曲線函數(shù)對視差值進行平滑。

k1,k2,k3∈R 且k1>0,k2>0

根據(jù)雙曲線函數(shù)的性質(zhì)可知:f(d)在d1*處取得極小值。由上式可解得:

3 實驗結(jié)果及分析

3.1 測試圖實驗結(jié)果

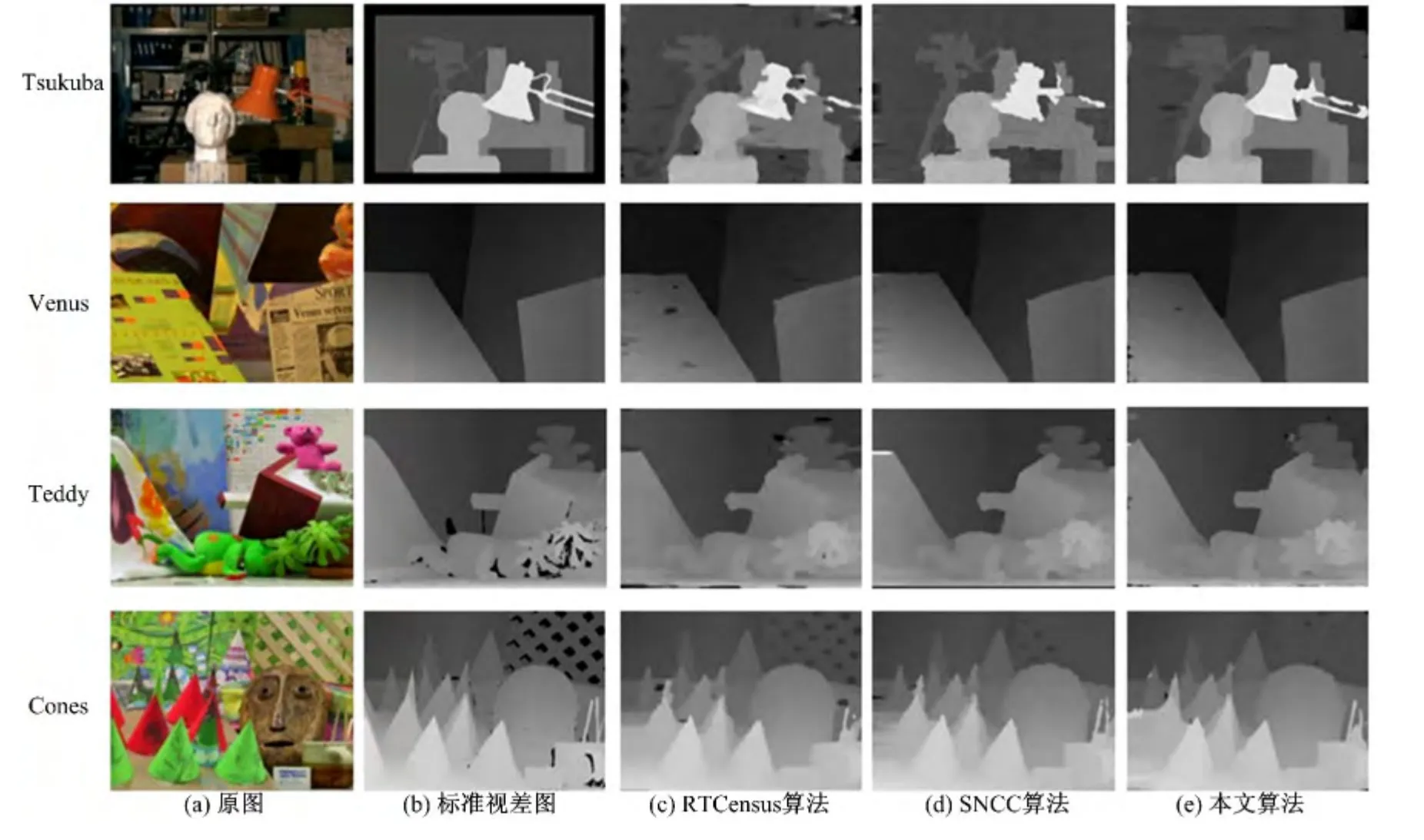

為了測試本文算法的匹配精度,選用Middlebury網(wǎng)站提供的測試圖進行測試。各參數(shù)設(shè) 置 分 別 為{λ,TD,TG,α,β}={0.4,25,50,35,25},利用不同算法獲得視差圖如圖1所示。

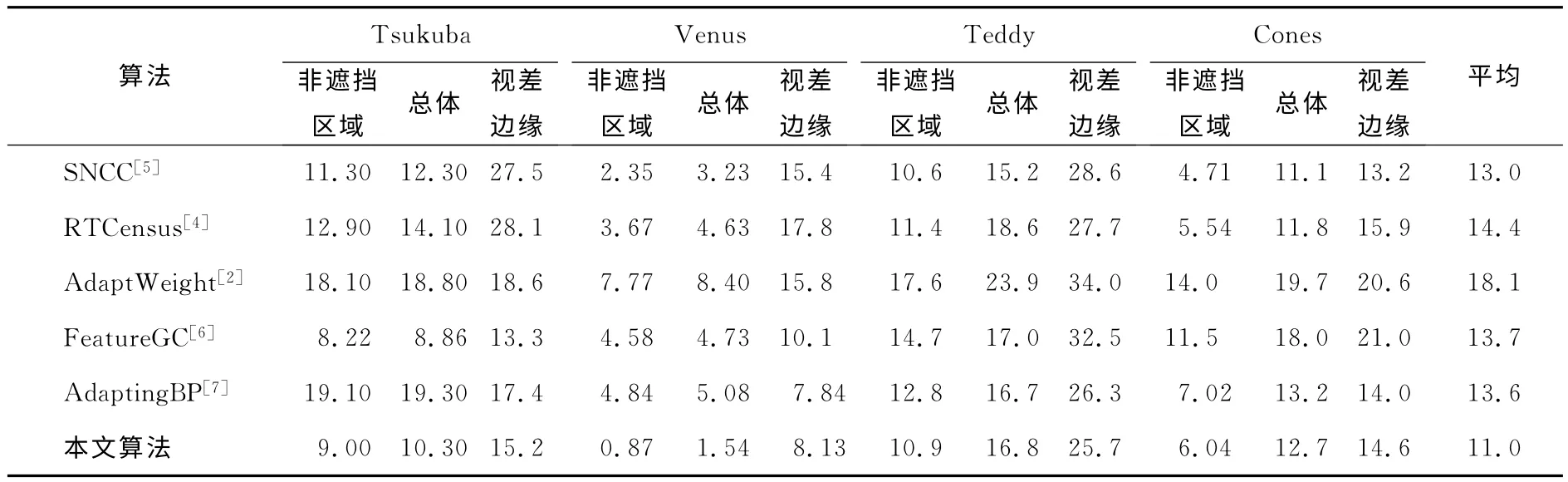

利用不同算法獲得視差圖的誤匹配率如表1所示。其中,SNCC、RTCensus、AdaptWeight代表傳統(tǒng)局部立體匹配算法,F(xiàn)eatureGC、AdaptingBP為全局立體匹配算法。誤差閾值取為0.5。

從圖1中可以看出,本文算法在低紋理區(qū)域能夠獲得更好的效果,如‘Venus’黑色板區(qū)域、‘Teddy’屋頂區(qū)域等;由于在視差精煉階段采用了視差平滑策略,由4張測試圖的視差圖均可看出,視差過渡平滑,有效減少了視差圖中“波紋”現(xiàn)象,整體視差圖的匹配效果較好。

從表1 中可以看出,SNCC 算法在圖‘Tsukuba’視差邊緣處(如燈的邊界和支架處)誤匹配率較高;雖然在圖‘Cones’非遮擋區(qū)域誤匹配率低于本文算法,但平均誤匹配率明顯高于本文算法。RTCensus算法雖然在圖‘Cones’非遮擋區(qū)域誤匹配率比本文算法略低,但在其視差邊緣處誤匹配率高于本文算法,RTCensus算法平均誤匹配率為14.4%。

從表1中可以看出,與采用固定窗口聚合匹配代價的AdaptWeight算法相比,本文算法采用的權(quán)重聚合匹配代價,在視差邊緣處及非遮擋區(qū)域的匹配性能均優(yōu)于傳統(tǒng)算法,平均誤匹配率最低。

圖1 視差圖效果比較Fig.1 Comparison of disparity maps results

表1 幾種算法的誤匹配率比較Table 1 Comparison of error rate of different algorithms %

相比較于計算復(fù)雜度較高的全局立體匹配算法,如:FeatureGC、AdaptingBP,本文算法也有較大的優(yōu)勢。兩種算法分別基于圖割理論和置信度傳播理論進行分割,采用平面擬合的方法進行視差精煉。FeatureGC算法對圖‘Tsukuba’前景與背景分割的效果好,匹配性能稍好于本文算法,但圖‘Cones’平均誤匹配率高達11.5%,本文算法只有6.04%。而AdaptingBP算法誤匹配率明顯過高;究其原因是由于分割與平面擬合的精度不夠,影響了整體視差精度。

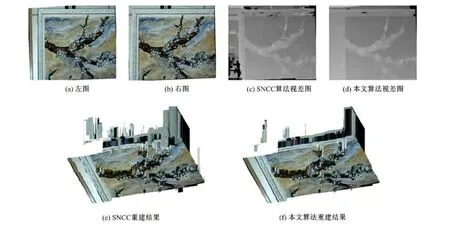

3.2 實際場景的立體匹配與三維重建

實際場景立體匹配效果如圖2所示。從圖2可以看出,本文算法在畫作邊框附近處誤匹配點明顯少于SNCC,在樹枝及花的位置處,本文算法的誤匹配點也少于SNCC 算法;從三維重建結(jié)果可以看出,利用SNCC 算法進行重建,畫作邊框有較多的突刺現(xiàn)象,在畫作樹枝及花的位置處突刺也比較多,而本文算法則較好地避免了這一現(xiàn)象,較為真實的重建了畫作的立體信息。

圖2 畫作的匹配與重建Fig.2 Stereo matching and reconstruction for picture

4 結(jié)束語

提出了一種基于雙權(quán)重聚合的立體匹配算法,利用雙邊濾波器的特性設(shè)置匹配代價聚合的權(quán)重獲得每一點的聚合匹配代價,并將匹配代價聚合過程分離開來,利用不同聚合權(quán)重進行匹配代價聚合。在視差精煉階段,采用雙曲線函數(shù)對聚合匹配代價平滑,得到稠密視差圖。通過對比一些優(yōu)秀的局部立體匹配算法和全局立體匹配算法,證明了本文算法優(yōu)越性。

[1]Sharstein D,Szeliski R.A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[J].International Journal on Computer Vision,2002,47(1-3):7-42.

[2]Yoon K J,Kweon S.Adaptive support-weight approach for correspondence search[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(4):650-656.

[3]Min D,Lu J,Do M.Joint histogram based cost aggregation for stereo matching[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(10):2539-2545.

[4]Humenberger M,Zinner C,Weber M,et al.A fast stereo matching algorithm suitable for embedded real-time systems[J].Computer Vision and Image Understanding,2010,114(11):1180-1202.

[5]Einecke N,Eggert J.A two-stage correlation method for stereoscopic depth estimation[C]∥International Conference on Digital Image Computing:Techniques and Applications,Sydney,New South Wales,2010:227-234.

[6]Saygili Gorkem,van der Maaten Laurens,Hendriks Emile A.Feature-based stereo matching using graph-cuts[C]∥Conference on Asian Society of Cardiovascular Imaging,Hong Kong,2011:14-15.

[7]Klaus A,Sormann M,Karner K.Segment-based stereo matching using belief propagation and a selfadapting dissimilarity measure[C]∥The 18th International Conference on Pattern Recognition,Hong Kong,2006:15-18.

[8]Cigla Cevahir,Alatan A Aydin.Information permeability for stereo matching[J].Signal Processing on Image Communication,2013,28(9):1072-1088.

[9]Mattoccia S,Tombari F,Di Stefano L.Fast fullsearch equivalent template matching by enhanced bounded correlation[J].IEEE Transactions on Image Processing,2008,17(4):528-538.

[10]Hosni A,Rhemann C,Bleyer M,et al.Fast costvolume filtering for visual correspondence and beyond[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(2):504-511.

[11]趙巖,劉靜,陳賀新,等.用于單視加深度視頻編碼的快速立體匹配算法[J].吉林大學(xué)學(xué)報:工學(xué)版,2012,42(4):1032-1036.Zhao Yan,Liu Jing,Chen He-xin,et al.Fast stereo matching algorithm used in stereo video coding based on video plus depth[J].Journal of Jilin University(Engineering and Technology Edition),2012,42(4):1032-1036.

[12]門朝光,邊繼龍,李香.基于限制搜索空間的快速立體匹配方法[J].吉林大學(xué)學(xué)報:工學(xué)版,2012,42(2):423-428.Men Chao-guang,Bian Ji-long,Li Xiang.Fast stereo matching algorithm based on limited search space[J].Journal of Jilin University(Engineering and Technology Edition),2012,42(2):423-428.