改進自適應(yīng)加權(quán)的局部立體匹配算法

劉 辰,姚劍敏,郭太良

(福州大學(xué) 平板顯示技術(shù)國家地方聯(lián)合工程實驗室,福建 福州 350002)

改進自適應(yīng)加權(quán)的局部立體匹配算法

劉 辰,姚劍敏,郭太良

(福州大學(xué) 平板顯示技術(shù)國家地方聯(lián)合工程實驗室,福建 福州 350002)

針對Yoon經(jīng)典自適應(yīng)加權(quán)法在深度不連續(xù)處誤匹配率較高、邊緣細節(jié)不突出以及匹配窗口大小憑經(jīng)驗設(shè)計不通用等缺陷,提出了一種改進自適應(yīng)加權(quán)的局部立體匹配算法。在經(jīng)典自適應(yīng)加權(quán)局部立體匹配算法的基礎(chǔ)上用高斯分布權(quán)值替換了幾何空間權(quán)值,增加了邊緣權(quán)值突出深度不連續(xù)處的邊緣細節(jié),采用贏家通吃原則(Winner Take All,WTA)獲取單像素點視差,在目標(biāo)視圖中逐點求取視差,最終獲得稠密視差圖。實驗結(jié)果表明,該算法相比于經(jīng)典自適應(yīng)加權(quán)法,在非遮擋區(qū)域錯誤匹配百分比上下降6%,在深度不連續(xù)處的誤匹配率降低了5%,邊緣細節(jié)毛刺明顯減少。

立體匹配;自適應(yīng)加權(quán)法;視差圖;高斯分布權(quán)值;邊緣權(quán)值

立體匹配技術(shù)實現(xiàn)了從二維圖像獲取三維深度信息的過程。立體匹配技術(shù)的基本原理是從多個視點觀察同一物體,以獲得不同視角下的圖像;通過算法處理計算出相應(yīng)的視差圖從而獲得該物體的三維深度信息。近幾年來立體匹配技術(shù)成為視覺領(lǐng)域的研究重點,在諸如繪制虛擬視點、重構(gòu)三維圖像、虛擬實現(xiàn)方面都有廣泛應(yīng)用。

在諸多的立體匹配方法中,基于區(qū)域的立體匹配算法是一種重要的方法,主要以匹配窗口內(nèi)視差相等為前提條件來計算匹配窗口內(nèi)左右圖像的相似性。但這樣存在一個明顯的問題,在深度不連續(xù)處由于視差跳變邊緣處相鄰視差明顯不同,很容易造成深度不連續(xù)處的誤匹配即前景膨脹。為滿足區(qū)域視差相等的條件:文獻[1-4]為圖像中的每一點尋找最適宜的匹配窗口,這種自適應(yīng)窗口方法在的適宜窗口計算上依賴初始視差的精確度,而且需要人為依靠經(jīng)驗估算參數(shù)并不能很好地適用于一般圖像情況;文獻[5-7]提出了多重窗的方法來解決深度不連續(xù)的問題,但該方法計算復(fù)雜度大,效率低下;文獻[8-11]提出了圖像分割的方法來確定匹配窗口,從而降低深度不連續(xù)處的誤匹配率,但是當(dāng)處理多紋理區(qū)域時該方法極為依賴精確的圖像分割算法;文獻[12]提出的自適應(yīng)加權(quán)立體匹配法是一種經(jīng)典的局部立體匹配方法。該方法是以匹配像素與待匹配像素的色度空間以及幾何空間的鄰近性引入權(quán)值計算,提高深度不連續(xù)區(qū)域以及低紋理區(qū)域匹配精度,但前景圖像的邊緣細節(jié)并沒有很突出,雖然不是很依賴窗口大小,但窗口大小往往憑經(jīng)驗值決定,在效率和通用性方面并沒有做得很好。

本文提出一種改進自適應(yīng)加權(quán)的局部立體匹配算法,該算法在自適應(yīng)加權(quán)代價函數(shù)的基礎(chǔ)上提出:1)用高斯分布權(quán)值替換其幾何空間表達式來精確確定窗口大小區(qū)域;2)增加邊緣權(quán)值突出圖像邊緣,減少深度不連續(xù)的誤匹配率,突出邊緣細節(jié)。

經(jīng)過實驗驗證,該改進算法能夠在原有效果上較好地突出邊緣細節(jié),得到稠密視差圖。

1 Yoon經(jīng)典自適應(yīng)加權(quán)立體匹配及其問題

1.1 Yoon經(jīng)典自適應(yīng)加權(quán)法步驟

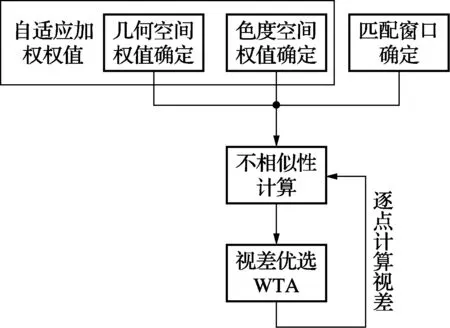

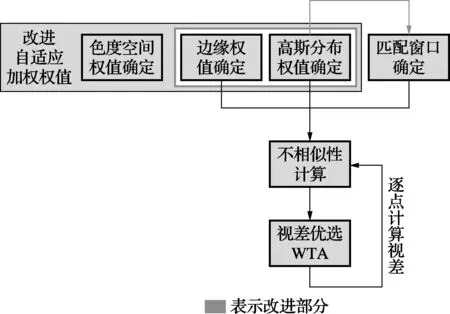

如圖1所示,Yoon經(jīng)典自適應(yīng)加權(quán)法主要包括自適應(yīng)加權(quán)權(quán)值計算、匹配窗口確定、不相似性計算以及視差優(yōu)選4個步驟。

圖1 Yoon經(jīng)典自適應(yīng)加權(quán)法流程圖

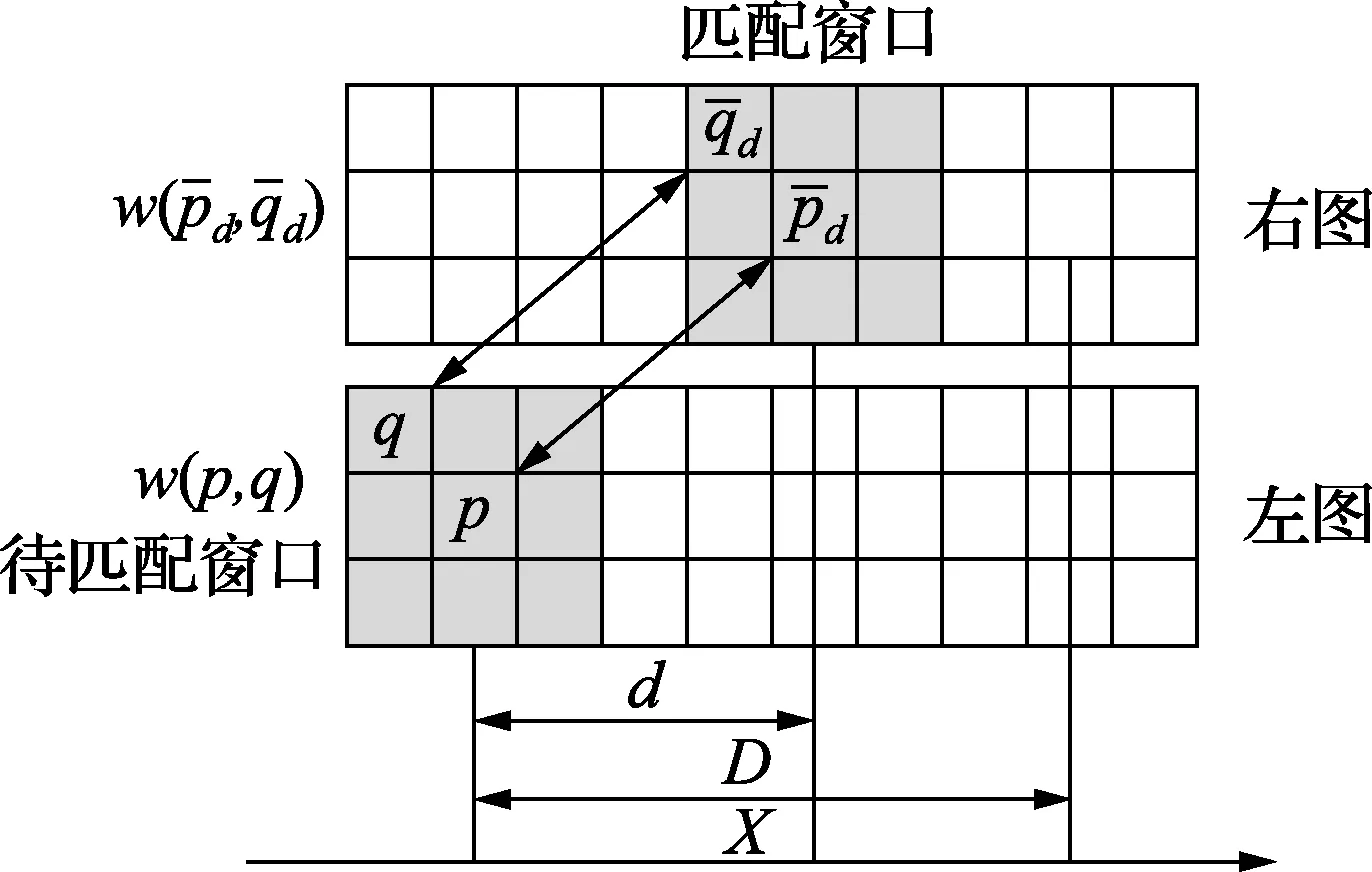

1)自適應(yīng)權(quán)值計算:自適應(yīng)權(quán)值計算由于需要避免其他深度區(qū)域的像素點對匹配窗口權(quán)值計算結(jié)果帶來的干擾,應(yīng)滿足匹配窗口中的匹配像素點與待匹配像素點同處于一個深度條件,其中匹配像素點表示匹配窗口中除待匹配像素外的所有像素點。如圖2所示,根據(jù)同一深度條件匹配窗口中匹配像素點q和待匹配點p的自適應(yīng)權(quán)值與匹配像素點q和待匹配像素點p處于同一深度的概率成正比。

圖2 Yoon經(jīng)典自適應(yīng)加權(quán)法示意圖

經(jīng)典自適應(yīng)加權(quán)法的自適應(yīng)權(quán)值w(p,q)可以表示為

w(p,q)=k·f(Δcpq,Δgpq)

(1)

式中:k為常數(shù);Δcpq表示顏色差異;Δgpq表示空間臨近性;Δcpq與Δgpq分別為獨立的事件,所以式(1)可以表示為

w(p,q)=k·f(Δcpq)·f(Δgpq)

(2)

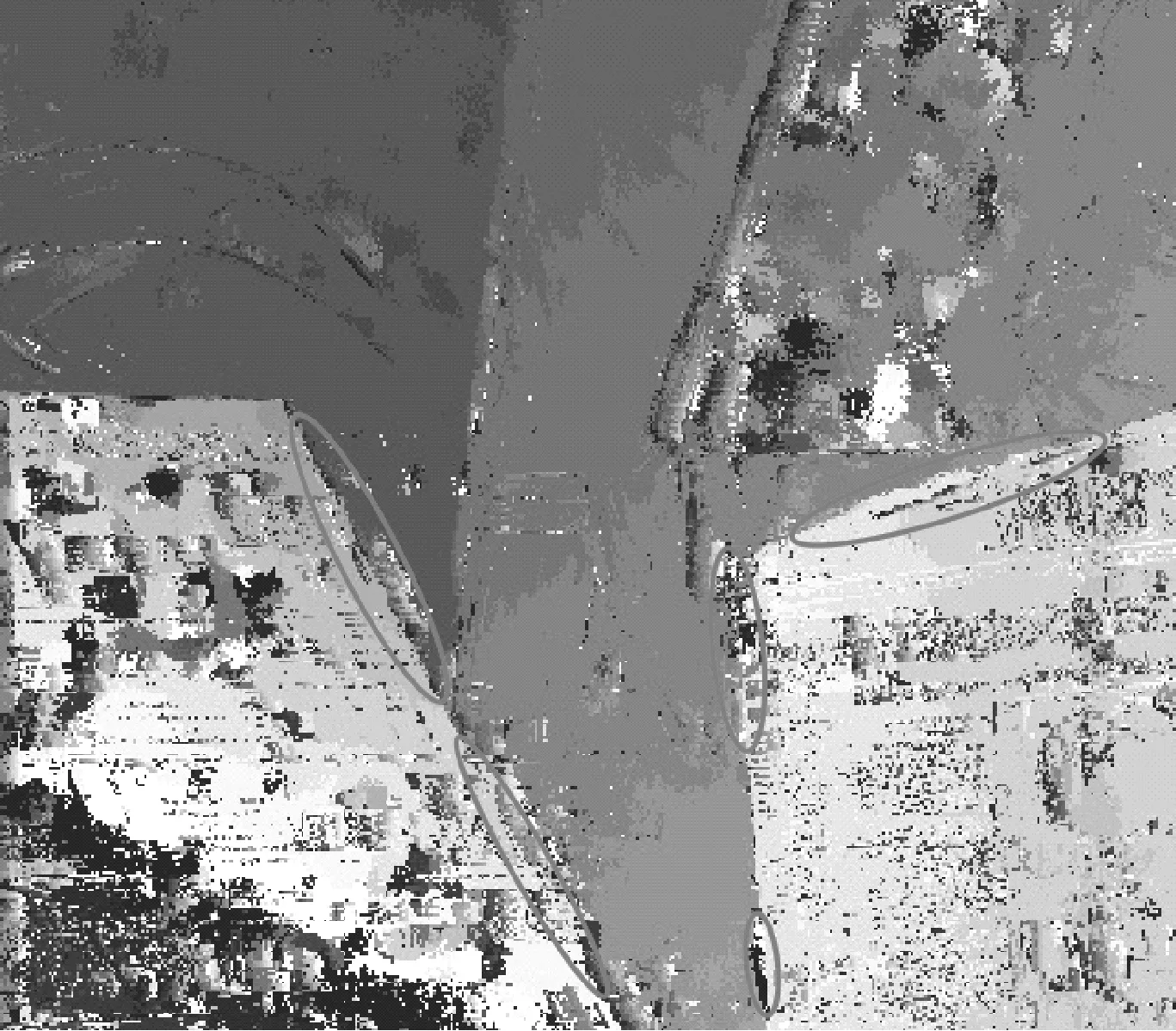

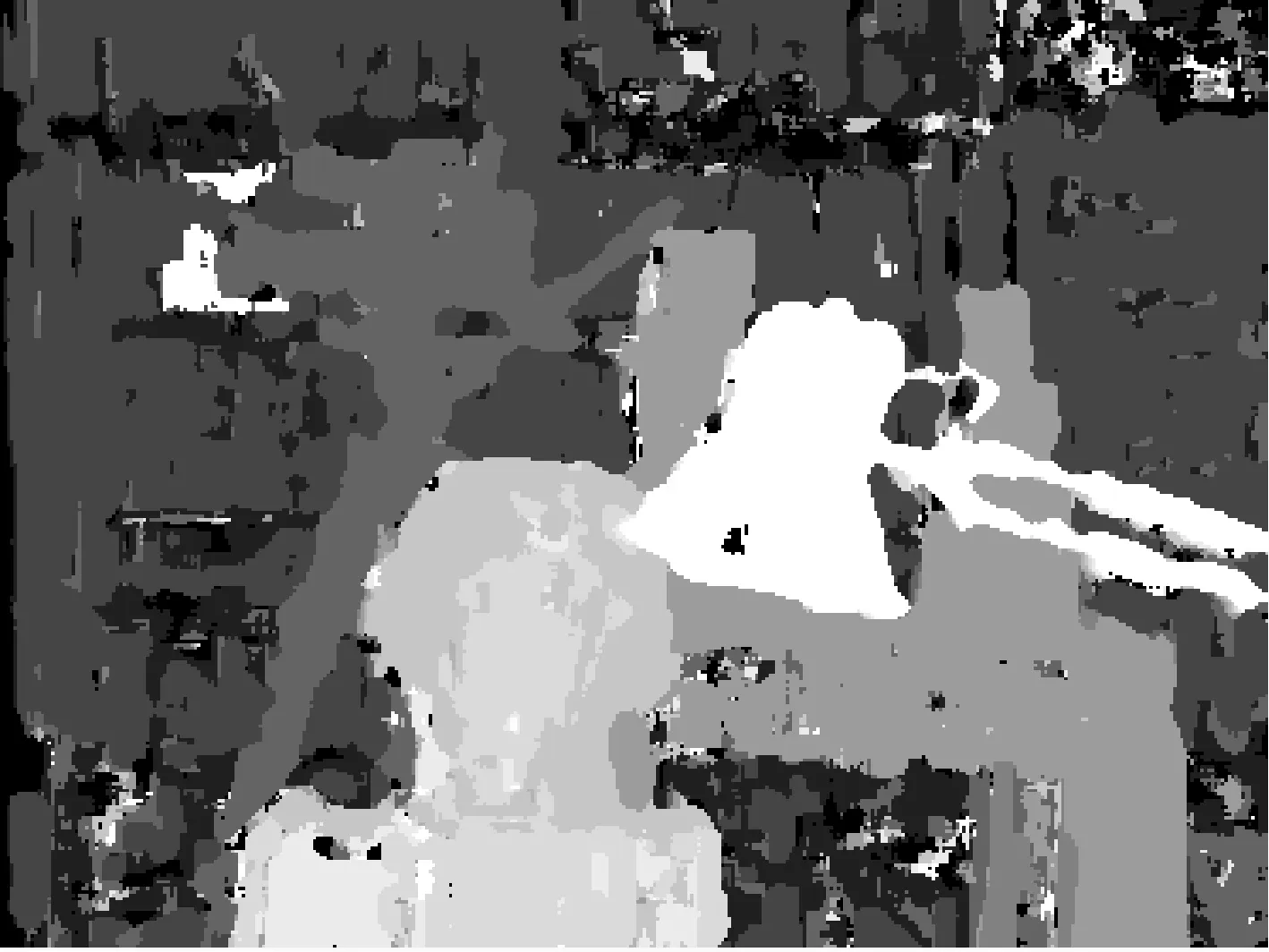

自適應(yīng)權(quán)值以色度空間權(quán)值f(Δcpq)和幾何空間權(quán)值f(Δgpq) 來描述同一深度條件,由于沒有突出邊緣細節(jié)的權(quán)值,邊緣處的像素點由于處于區(qū)域臨界位置,在幾何空間權(quán)值f(Δgpq)的作用下造成歸屬區(qū)域不明確的結(jié)果,形成邊緣毛刺現(xiàn)象,效果圖如圖3所示。

圖3 Yoon經(jīng)典自適應(yīng)加權(quán)方法邊緣毛刺現(xiàn)象

2)匹配窗口確定:匹配窗口大小是根據(jù)設(shè)計者對于目標(biāo)圖像大小、圖像紋理細節(jié)的經(jīng)驗給定的。這樣存在一個很大的缺陷:若匹配窗口過小,匹配窗口中的匹配像素信息不足以用于支持待匹配像素;若匹配窗口過大,匹配效率低下,增加了不必要的匹配時間。

(3)

式中:Ic表示像素點的色度值;c∈{r,g,b},表示c屬于RGB三基色取值范圍內(nèi);T表示截斷閾值。

(4)

4)視差優(yōu)選:根據(jù)WTA原則在最大視差D范圍內(nèi)即D個不相似性矢量值中選擇最小值,該不相似矢量最小值所對應(yīng)的匹配窗口即為待匹配窗口的最相似匹配窗口,取最相似匹配窗口所對應(yīng)的視差值為待匹配窗口中待匹配點的匹配視差。最后對所有目標(biāo)視圖中所有像素點逐一求取視差,獲得視差圖。

1.2 Yoon經(jīng)典自適應(yīng)加權(quán)法存在的問題

Yoon經(jīng)典自適應(yīng)加權(quán)法目前存在兩個明顯的問題:1)由于只考慮匹配窗口中的顏色與空間關(guān)系,沒有考慮前景圖像的具體信息(如圖像形狀、邊緣等),使得深度不連續(xù)處誤匹配率不夠低,邊緣細節(jié)十分粗糙,存在大量邊緣毛刺。2)匹配窗口大小僅憑經(jīng)驗造成窗口過小信息不足或窗口過大匹配時間過長不通用的問題。

2 改進自適應(yīng)加權(quán)立體匹配

2.1 改進自適應(yīng)加權(quán)算法思路

改進自適應(yīng)加權(quán)算法根據(jù)Yoon經(jīng)典自適應(yīng)加權(quán)法的缺陷對自適應(yīng)權(quán)值進行重新考慮。

1)提出用高斯分布權(quán)值替換Yoon的幾何空間權(quán)值,利用高斯分布權(quán)值中一定范圍外的點對中心點影響忽略不計的特性,確定匹配窗口大小,解決匹配窗口大小僅憑經(jīng)驗造成窗口過小信息不足或窗口過大匹配時間過長不通用的問題。

2)提出增加邊緣權(quán)值以加強圖像邊緣像素點的作用,確定像素區(qū)域歸屬,從而消除邊緣毛刺,解決圖像邊緣處于區(qū)域臨界位置,在幾何空間權(quán)值的作用下造成歸屬區(qū)域不明確形成邊緣毛刺問題。

如圖4所示,改進自適應(yīng)加權(quán)法流程圖包括:改進自適應(yīng)加權(quán)權(quán)值計算、匹配窗口確定、不相似性計算以及視差優(yōu)選。

圖4 改進自適應(yīng)加權(quán)法流程圖

2.2 改進自適應(yīng)加權(quán)權(quán)值組成

文獻[12]中,Yoon提出的自適應(yīng)加權(quán)法是根據(jù)格式塔視覺心理學(xué)[13]中的規(guī)律來獲取稠密視差圖。格式塔視覺心理學(xué)其中主要的兩大規(guī)律:接近律和相似律。接近律表示人對視覺物體的感知是根據(jù)物體各部分的臨近程度來判斷它們是否能夠組成一個整體。相似律表示人對視覺物體的感知傾向于將要素相似的部分結(jié)合在一起。色度空間權(quán)值、幾何空間權(quán)值分別是根據(jù)格式塔視覺心理學(xué)中的相似律、接近律分析得出表示像素不相似性。經(jīng)典自適應(yīng)加權(quán)法權(quán)值w(p,q)是由色度空間權(quán)值與幾何空間權(quán)值組成,權(quán)值可以表示為

w(p,q)=k·f(Δcpq)·f(Δgpq)

(5)

針對匹配窗口大小僅憑經(jīng)驗造成窗口過小信息不足或窗口過大匹配時間過長不通用的問題,將f(Δgpq)項替換成f(ΔGpq)高斯分布權(quán)值,利用高斯分布權(quán)值中一定范圍外的點對中心點影響忽略不計的特性,確定最適合匹配窗口大小。其中ΔGpq表示高斯分布權(quán)值中的空間臨近性。

針對圖像邊緣處于區(qū)域臨界位置,在幾何空間權(quán)值的作用下造成歸屬區(qū)域不明確,形成邊緣毛刺問題,增加邊緣權(quán)值f(Δepq)項以加強圖像邊緣像素點的作用,確定像素區(qū)域歸屬,從而消除邊緣毛刺,其中Δepq表示邊緣與非邊緣差異。

這樣改進的自適應(yīng)加權(quán)法權(quán)值可以表示為

w(p,q)=k·f(Δcpq)·f(ΔGpq)·f(Δepq)

(6)

2.2.1 色度空間權(quán)值

根據(jù)經(jīng)典自適應(yīng)加權(quán)法中的格式塔視覺心理學(xué)的相似律,兩個像素點之間的顏色差異是由CIELab色彩空間[14]來描述的。當(dāng)兩個像素點在CIELab色彩空間中的距離增加時,亮點之間的顏色差異也就相應(yīng)增加。基于CIELab色彩空間計算方法色度空間權(quán)值可以表示為

(7)

式中:cp、cq分別表示p、q點的CIELab色彩空間值;Δcpq表示為兩個像素點顏色之間的歐氏距離,其中

cp=[Lp,ap,bp]

(8)

cq=[Lq,aq,bq]

(9)

(10)

式中:Lp,ap,bp和Lq,aq,bq分別是像素點p,q在CIELab空間中的L分量、a分量和b分量,γc是一個常數(shù)通常取7。

2.2.2 邊緣權(quán)值

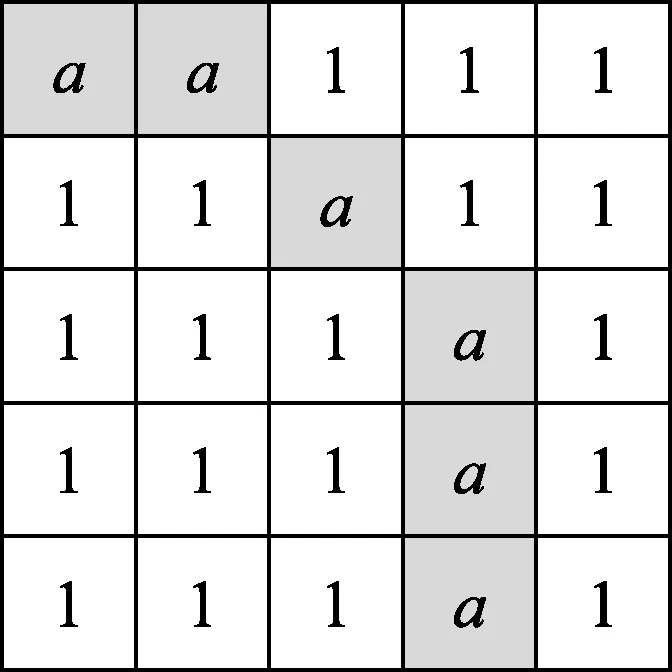

經(jīng)典自適應(yīng)加權(quán)法獲取的稠密視差圖雖然在深度不連續(xù)處能夠得到較為準(zhǔn)確的視差圖,但邊緣毛刺十分嚴重。造成此結(jié)果的主要原因是格式塔原則的接近性并且沒有考慮前景圖像的具體信息,由于空間臨近性的關(guān)系導(dǎo)致深度不連續(xù)的兩相鄰像素有了很大的相關(guān)性。改進方法對圖像進行邊緣檢測,突出邊緣細節(jié)。其中邊緣權(quán)值為改進算法新增權(quán)值項。根據(jù)上述要求,改進算法采用Canny邊緣檢測算法[15]先將圖像邊緣勾勒出來,并對邊緣區(qū)域賦值概率a,非邊緣區(qū)域賦值概率1即保持原本圖像狀態(tài)。如圖5所示。

圖5 邊緣權(quán)值求解示意圖

則邊緣權(quán)值可以表示為

(11)

2.2.3 高斯分布權(quán)值

根據(jù)經(jīng)典自適應(yīng)加權(quán)法中的描述,幾何空間權(quán)值滿足格式塔空間鄰近性原則,即兩像素點間的距離越大,其幾何空間權(quán)值越小。高斯分布很顯然滿足這個原則。高斯分布可以表示為N(μ,σ2),其中μ是高斯分布隨機變量均值,σ是高斯分布隨機變量的方差。取值距離μ越近概率越大,反之概率越小;根據(jù)算法需要我們將μ值取0,并已匹配窗口中心點p為高斯分布原點。高斯分布權(quán)值可以表示為

(12)

式中:x表示pq間的水平距離;y表示pq間的垂直距離。

2.3 匹配窗口確定

Yoon的經(jīng)典自適應(yīng)加權(quán)法,在匹配窗口確定步驟上僅憑圖像紋理、大小的經(jīng)驗,若給定匹配窗口過小,造成窗口內(nèi)信息不足,導(dǎo)致視差圖特別深度不連續(xù)區(qū)域誤匹配率高,匹配效果十分粗糙,如圖6所示;若給定匹配窗口過大,造成窗口內(nèi)信息過多,由于信息過多導(dǎo)致程序運行時間加長,匹配效率低下。所以合理的設(shè)計匹配窗口大小對于最終得到的結(jié)果來說至關(guān)重要。本文提出的改進算法根據(jù)上文中的高斯分布權(quán)值的描述,在計算離散近似值時,3σ范圍之內(nèi)的越接近中心點作用越大,距離3σ以外的像素都可以看作是不起作用的。這樣就可以很方便地確定匹配窗口的長寬為6σ+1,最佳窗口處理后的效果圖。

圖6 窗口過小視差圖

2.4 不相似性計算以及視差優(yōu)選

(13)

(14)

圖7 改進自適應(yīng)加權(quán)法示意圖

式中:Ic表示像素點的色度值;T表示截斷閾值,引入截斷閾值是因為圖像色度在色度不連續(xù)處的變化很大,像素色度不能簡單的用色度差異來表示。

根據(jù)式(14)在參考圖像中以水平方向性原則為準(zhǔn)取最大視差范圍內(nèi)的匹配窗口并分別計算其與目標(biāo)圖像中匹配窗口的不相似性,然后采用簡單的WTA原則選取最小值,得到單點視差

(15)

最后重復(fù)不相似性計算以及視差優(yōu)選步驟逐點求取視差值,最終得到視差圖。

3 試驗結(jié)果與分析

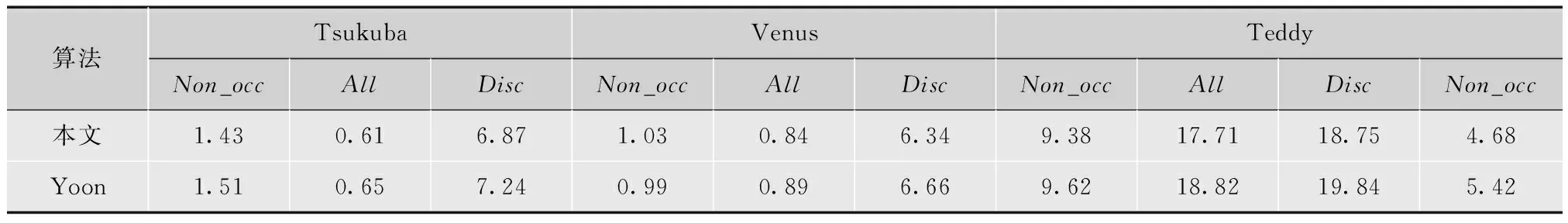

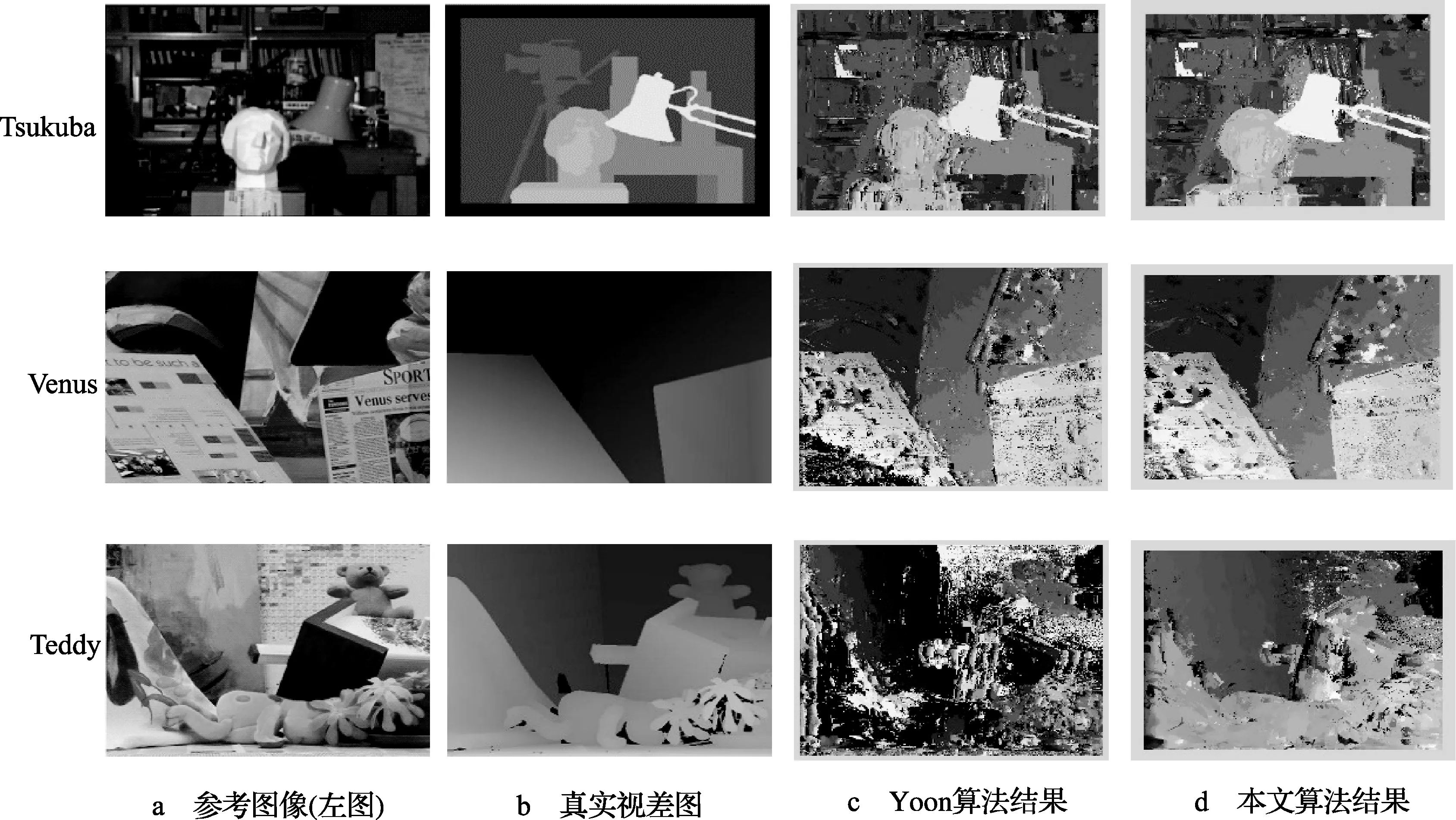

為了驗證本文算法的有效性,采用美國Middlebury大學(xué)數(shù)據(jù)庫(http://vision.middlebury.edu/stereo/)為實驗平臺,取其中Tsukuba,Venus,Teddy三幅標(biāo)準(zhǔn)圖像作為實驗圖像。實驗中窗口的尺寸Wsize大小為37,γc取值7,由于Wsize=6σ+1, 所以σ取值6,邊緣概率a取值0.5,最大視差范圍取值30。表1給出了本文算法與Yoon自適應(yīng)加權(quán)法性能指標(biāo)進行量化對比的結(jié)果。其中3個指標(biāo)分別為all(非遮擋區(qū)域錯誤匹配百分比)、untex(無紋理區(qū)域錯誤匹配百分比)、disc(視差不連續(xù)區(qū)域錯誤匹配百分比)。

本文方法將經(jīng)典自適應(yīng)加權(quán)法的空間權(quán)值替換為高斯分布權(quán)值,并增加邊緣權(quán)值突出邊緣細節(jié)。實驗結(jié)果參照對象為真實視差圖,以及Yoon的經(jīng)典自適應(yīng)加權(quán)法得出的3幅圖的結(jié)論。根據(jù)圖8以及表1對比結(jié)果圖明顯可得,經(jīng)過高斯分布權(quán)值的處理,實驗結(jié)果在受匹配窗口直接影響的非遮擋區(qū)域錯誤匹配百分比上比Yoon方法針對Tsukuba,Venus,Teddy三幅標(biāo)準(zhǔn)圖分別下降了6.15%,5.61%,5.89%整體約下降6%左右,替換高斯分布權(quán)值在圖像整體匹配上有明顯的改善效果。經(jīng)過添加邊緣權(quán)值,實驗結(jié)果在表示邊緣細節(jié)的視差不連續(xù)區(qū)域錯誤匹配百分比上比Yoon方法分別下降5.11%,4.80%,5.49%整體約下降5%左右。增加邊緣權(quán)值在突出邊緣細節(jié)降低深度不連續(xù)處誤匹配率上有明顯的效果。

表1 本文算法同Yoon算法的比較結(jié)果 %

圖8 試驗結(jié)果圖

4 結(jié)束語

本文提出了一種改進的自適應(yīng)加權(quán)方法,該方法Yoon方法在深度不連續(xù)處誤匹配率不低,邊緣細節(jié)不突出,匹配窗口大小只能依靠經(jīng)驗確定等缺陷對經(jīng)典自適應(yīng)加權(quán)法進行改進。首先,改進方法將經(jīng)典自適應(yīng)加權(quán)法中的幾何空間權(quán)值替換成高斯分布權(quán)值,由于高斯分布的性質(zhì)確定了空間距離權(quán)值與匹配窗口大小的關(guān)系,克服了憑經(jīng)驗確定窗口大小的缺陷,從實驗結(jié)果上看在受匹配窗口直接影響的非遮擋區(qū)域錯誤匹配百分比上比Yoon方法下降6%;本文在經(jīng)典自適應(yīng)加權(quán)法原有權(quán)值的基礎(chǔ)上添加了邊緣權(quán)值,突出了邊緣細節(jié),降低深度不連續(xù)處的誤匹配率,從實驗結(jié)果上看在表示邊緣細節(jié)的視差不連續(xù)區(qū)域錯誤匹配百分比上比Yoon方法降低5%。但是匹配速度相對于其他局部立體匹配方法較慢,可以在精確匹配的基礎(chǔ)上增加并行算法對程序進行處理提高獲取稠密視差圖的速度。

[1] KANADE T,OKUTOMI M. A stereo matching algorithm with an adaptive window:theory and experiment[J]. IEEE Trans. Pattern Analysis and Machine Intelligence, 1994,16(9):920-932.

[2]BOYKOV Y,VEKSLER O,ZABIH R. A variable window approach to early vision[J]. IEEE Trans. Pattern Analysis and Machine Intelligence, 1998,20(12):1283-1294.

[3]VEKSLER O. Stereo correspondence with compact windows via minimum ratio cycle[J]. IEEE Trans. Pattern Analysis and Machine Intelligence, 2002,24(12):1654-1660.

[4]VEKSLER O. Fast variable window for stereo correspondence using integral images[C]//Proc.IEEE Conf. Computer Vision and Pattern Recognition,2003.[S.l.]:IEEE Press,2003:556-561.

[5]FUSIELLO A, ROBERTO V,TRUCCO E. Efficient stereo with multiple windowing[C]//Proc.IEEE Conf. Computer Vision and Pattern Recognition,1997.[S.l.]:IEEE Press,1997:858-863.

[6]BOBICKA E, INTILLE S S. Large occlusion stereo[J]. Int’l J. Computer Vision,1999,33(1):181-200.

[7] KANGS B,SZELISKI R, JINXJANG C. Handling occlusions in dense multi-view stereo[C]//Proc.IEEE Conf. Computer Vision and Pattern Recognition,2001.[S.l.]:IEEE Press,2001:103-110.

[8] TAO H, SAWHNEY H S,KUMAR R. A global matching framework for stereo computation[C]//Proc.IEEE Conf. Computer Vision and Pattern Recognition,2001.[S.l.]:IEEE Press,2001:532-539.[9] WANG L, KANG S B, SHUM H Y. Cooperative segmentation and stereo using perspective space search[C]//Proc. Asian Conf. Computer Vision,2004.[S.l.]:IEEE Press,2004:366-371.

[10] 段軍,何明一,戴玉超.基于線段分割的圖割立體匹配[J].電視技術(shù),2012,36(11):15-18.

[11] 董欣,王國中,范濤,等.一種基于梯度增強的立體匹配算法[J].電視技術(shù),2014,38(3):1-3.

[12] YOON K J, KWEON I S. Locally adaptive support-weight approach for visual correspondence search[J]. IEEE Trans. Pattern Analysis and Machine Intelligence,2006,28(4):650-656.

[13] 鳳鳴.視覺傳達設(shè)計中的格式塔原理[J].池州學(xué)院學(xué)報,2010,8(4):111-114.

[14] 侯克杰.有源CIELAB顏色空間的建立與應(yīng)用[J].中國印刷與包裝研究,2010,4(2):15-21.

[15] 覃小峰,楊棕根,鄭湘群.Canny邊緣檢測算法在圖像處理上的應(yīng)用[J].商,2014,10(9):70-71.

劉 辰(1989— ),碩士生,主要研究方向為信息顯示系統(tǒng);

姚劍敏(1978— ),碩士生導(dǎo)師,主要研究方向為視頻圖像處理、模式識別;

郭太良(1963— ),博士生導(dǎo)師,主要研究方向為場致發(fā)射陰極材料及器件研究。

責(zé)任編輯:時 雯

Local Stereo Matching Algorithm Based on Improved Adaptive Support-weight

LIU Chen,YAO Jianmin,GUO Tailiang

(National&LocalUnitedEngineeringLaboratoryofFlatPanelDisplayTechnology,F(xiàn)uzhouUniversity,F(xiàn)uzhou350002,China)

With problems of Yoon’s classical local stereo matching algorithm, which are high error rate of disparity discontinuous region,unconspicuous detail of edge and matching windows designed by experience which is not universal, a local stereo matching algorithm based on improved adaptive support-weightis proposed. Referring to the classical local stereo matching algorithm based on adaptive support-weight, the improved algorithm uses the Gaussian distribution replace distance weight , edge weight is added to highlight edge detail of disparity discontinuous region, the winner-take-all rule is used to get disparity of single pixel, then getting the disparity of each pixel, finally a dense disparity map is obtained. Results of the experiment reveal that the algorithm’s error rate of Non-occluded region is about 6% lower than traditional adaptive matching algorithm and error rate of disparity discontinuous region is about 5% lower and the burrs on edge are less.

stereo matching;adaptive support-weight method; disparity map; Gaussian distribution;edge weight

【本文獻信息】劉辰,姚劍敏,郭太良.改進自適應(yīng)加權(quán)的局部立體匹配算法[J].電視技術(shù),2015,39(11).

國家“863”重大專項(2012AA03A301;2013AA030601);國家自然科學(xué)基金項目(61101169)

TP751

A

10.16280/j.videoe.2015.11.001

2014-08-18