基于加鎖機制的靜態手勢識別方法

王紅霞 王坤

摘要:基于RGBD(RGBDepth)的靜態手勢識別的速度高于其動態手勢識別,但是存在冗余手勢和重復手勢而導致識別準確性不高的問題。針對該問題,提出了一種基于加鎖機制的靜態手勢識別方法來識別運動中的手勢。首先,將通過Kinect設備獲取RGB數據流和Depth數據流融合成人體骨骼數據流;然后,在靜態手勢方法中引入加鎖機制,并與之前建立好的骨骼點特征模型手勢庫進行比對計算;最后,設計一款“程序員進階之路”益智類網頁游戲進行應用與實驗。實驗驗證在6種不同運動手勢情況下,該方法與純靜態手勢識別方法相比,平均識別準確率提高了14.4%;與動態手勢識別相比,識別速度提高了14%為更好地說明優勢,此處也改用相對值來說明,是否符合表達?請明確。英文也作了相應修改。。實驗結果表明,提出的基于加鎖機制的靜態手勢識別方法,既保留了靜態識別的速率,實現了實時識別;又能很好地剔除冗余手勢和重復手勢,提高了識別正確性。

關鍵詞:

RGBD;Kinect;骨骼數據;手勢識別;加鎖機制

中圖分類號: TP391.413; TP18 文獻標志碼:A

0引言

隨著深度攝像機技術的發展,實時同步獲取高質量的彩色圖(RGB圖)和深度圖(Depth圖)成為現實,所以基于RGBD(RGBDepth)數據的應用變得越來越流行。本文研究的基于RGBD融合的手勢識別方法是在Kinect的RGBD融合數據流的基礎上進行的。Kinect是微軟公司在2010年推出的一款應用于Xbox 360的周邊設備。由于Kinect價格低廉并且能有效、方便地獲取高分辨率的深度圖像,所以迅速應用在了手勢識別領域。瑞士Bern大學研究的Virtopsy課題,讓外科醫生使用Kinect并配合大尺寸監視器,無需接觸任何醫療設備就可以自動實現調整成像的角度和區域,用單手或雙手對3D血管圖像進行平移、放大、旋轉、鎖定等操作[1]。新加坡南洋理工大學的Ren等[2]提出基于一種新的手形匹配算法——指尖移動距離(FingerEarth Movers Distance, FEMD)實現對靜態手勢的識別并應用在數獨游戲中,通過玩家做出不同的手勢動作完成相應的數字填寫。文獻[3]通過Kinect設計出一種非接觸式播放器系統,將改進的連續自適應MeanShift(Continuously Adaptive MeanShift, CAMSHIFT)算法對手心部位進行穩定追蹤,使用隱馬爾可夫模型(Hidden Markov Model, HMM)算法對8種手勢命令進行識別,實現利用手勢軌跡對非接觸式播放器的控制[3]。文獻[4]利用Kinect的骨架跟蹤功能,使用最近鄰分類器和動態時間歸整(Dynamic Time Warping, DTW)算法,完成對波蘭手語的識別[4]。近幾年,國內也進行了大量的手勢識別方面的研究,如中國科學院智能信息處理重點實驗室利用Kinect通過對中國手語的3D運動軌跡校準并和單詞進行計算匹配,使聽障人士使用手語和計算機進行自然的互動[5-6];重慶郵電大學國家信息無障礙工程研發中心基于Kinect骨骼信息與四自由度機械臂結合,實現體感交互控制機械臂的轉動以及抓取物件[7];電子科技大學模式識別與機器智能實驗室基于Kinect研發的交互式投影顯示系統,通過多個手指觸點以及手勢來操控普通玻璃,進而控制計算機或各種設備,可用于智能家居、虛擬試衣間、互動櫥窗[8];Wang等[9]提出一種基于運動學信息和人體3D骨骼數據將運動視頻快速地分割為原子動作的時間分割方法;Chen等[10]通過利用表面普通信息分割物體和獲得平滑的深度圖特征來提高虛擬視角圖像的品質;鄭立國等[11]通過對Kinect獲取的3D點云數據進行初步處理和精細分類,實現多個人體檢測以及運動人體檢測。

國內外關于手勢識別的研究與應用都是基于兩大識別方法——靜態手勢識別方法和動態手勢識別方法展開的。本文通過對這兩種識別方法的對比分析,提出一種改進的手勢識別方法。該方法將加鎖機制引入到靜態手勢識別過程中,有效地改善了動態手勢識別方法中手勢識別實時性較差的問題,并且很好地剔除靜態手勢識別過程中的冗余手勢和重復手勢,提高識別正確率。

1問題描述

1.1傳統手勢識別方法的難點

依據輸入裝置分類,手勢識別技術可以分為兩大類:基于“接觸式”的交互設備與基于“視覺”的交互設備。“接觸式”交互設備常見的有觸控屏幕、數據傳感手套以及隨身加速器等設備。數據傳感手套需要大量的計算與標定,并且價格昂貴也穿戴不方便,比如手心容易出汗等,在人機交互的自然性上嚴重不足,所以沒有得到廣泛應用。基于視覺的交互設備能夠以非接觸的、自然的方式實現人機交互,普通計算機攝像頭就能作為輸入設備,但對外部環境的要求卻十分嚴格,強光或者弱光環境、復雜的識別背景,都會嚴重影響識別結果。在傳統的基于視覺的手勢識別系統中,手勢識別的難點主要體現在以下幾個方面。

1)目標分割。靜態手勢分割比較容易受到環境的影響,當光線太強或太弱、識別背景較復雜、手和其他身體部位重疊時,很難分割出完整的手部圖像。動態手勢在分割過程中,起點和終點的檢測也是一個難點,動態手勢由于在時間上是連續性的,不能準確地分割出動態手勢序列。

2)算法效率。由于人機交互系統對實時性要求比較高,而分割算法常常具有提取特征個數過多、過于復雜、訓練或識別時間太長的弊端,所以系統的實時性一般都不是很高,但是如果選擇較為簡單的分割算法、特征模型和分類器,識別率又不盡如人意。

3)手勢識別。由于手是一個沒有固定形態的物體,在自然人機交互中,手勢是比較隨意和舒適的,沒有僵硬的模型或狀態。人手揮動幅度的大小、移動速度的快慢都會導致即使是同一個人打同一個手勢也會有不一樣,運動軌跡的千差萬別和手形的多樣性也給手勢識別增加了難度。另外,如何剔除無效的手勢也是一個需要考慮的問題。

所以利用深度攝像頭能夠獲取Depth信息這一優點,來克服普通計算機攝像頭由于極端光環境、復雜的識別背景導致識別結果嚴重失真的局限,是很有意義的。

1.2基于RGBD的兩種手勢識別方法對比分析

1.1節分析了基于RGBD數據流的手勢識別方法可以有效地突破傳統手勢識別方法的局限,在基于RGBD數據流進行手勢識別的過程中,手勢識別方法主要分為靜態手勢和動態手勢兩類。靜態手勢識別針對含有手勢意義的某一幀圖像進行識別,主要包括人手的形態變化,例如張開或握拳,或者手指的示意,可以利用指尖識別來判斷手勢狀態,由于僅通過一幀圖像檢測,所以沒有時間序列上的變化,靜態手勢識別中常用模板匹配法、幾何特征分類法、支持向量機和人工神經網絡等方法。如果識別一段在時間序列上連續自然的動態手勢,則必須綜合考慮時間序列上的變化,并且要對時間進行分割,一般需要在時間和空間上指定相應的開始標識和結束標識。常用的動態手勢識別算法有隱馬爾可夫模型、動態時間規整和基于壓縮時間軸的方法。

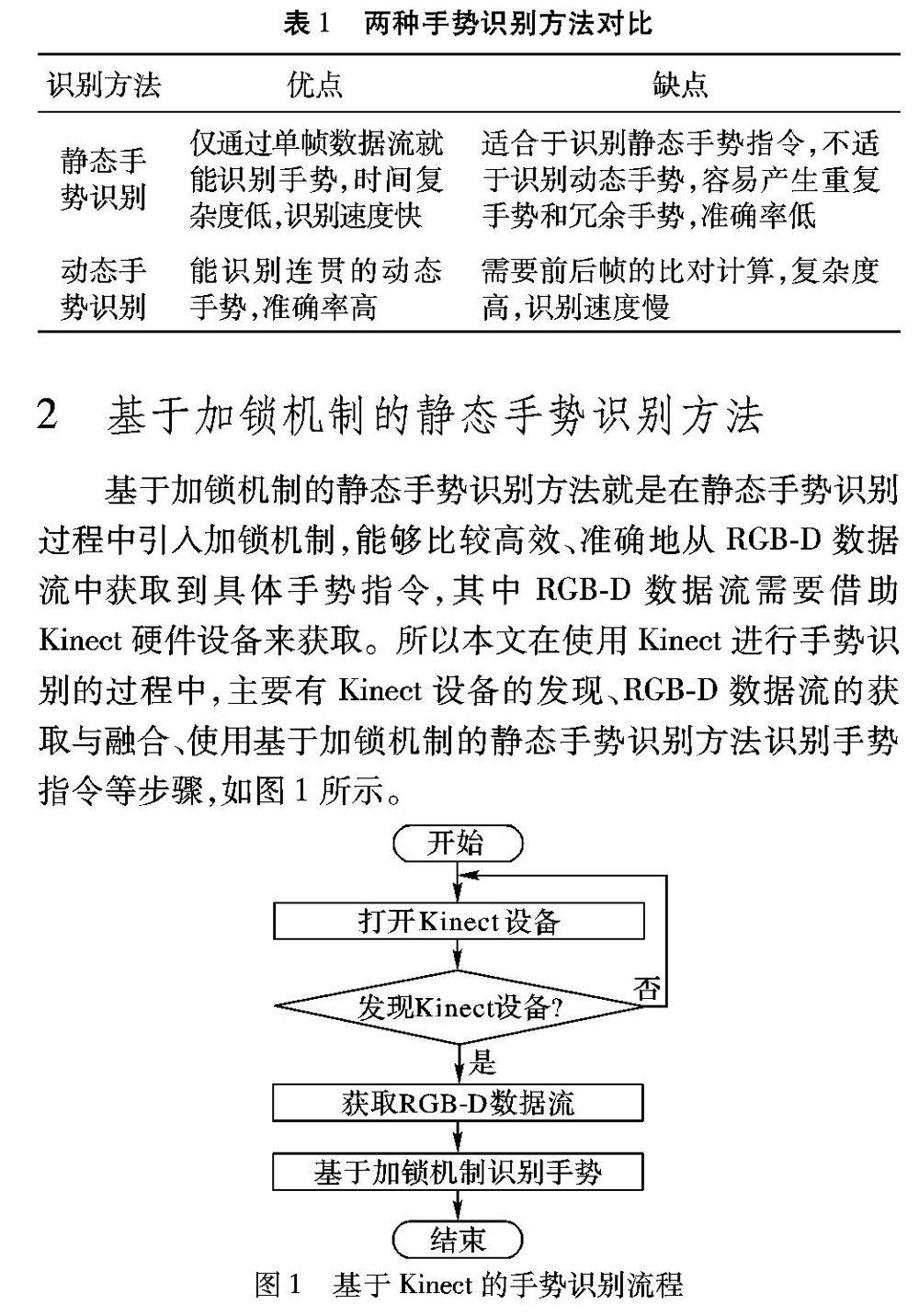

靜態手勢即指人靜止不動時的姿態,動態手勢為連續的動作序列,兩者的對比分析如表1所示。

2基于加鎖機制的靜態手勢識別方法

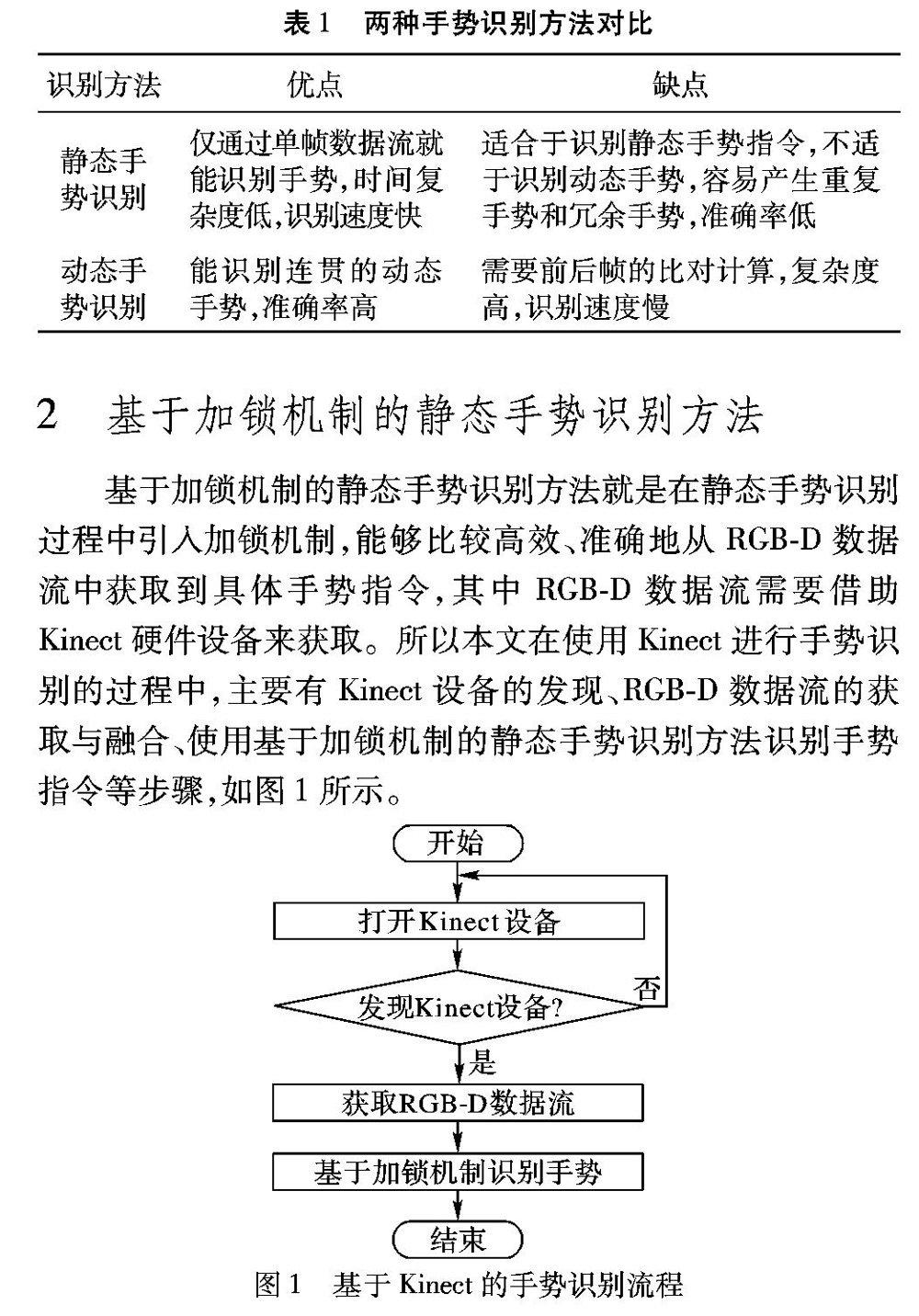

基于加鎖機制的靜態手勢識別方法就是在靜態手勢識別過程中引入加鎖機制,能夠比較高效、準確地從RGBD數據流中獲取到具體手勢指令,其中RGBD數據流需要借助Kinect硬件設備來獲取。所以本文在使用Kinect進行手勢識別的過程中,主要有Kinect設備的發現、RGBD數據流的獲取與融合、使用基于加鎖機制的靜態手勢識別方法識別手勢指令等步驟,如圖1所示。

2.1Kinect設備的發現

在基于Kinect設備進行手勢識別的過程中,最開始就需要用到KinectSensor對象,KinectSensor直接表示一個Kinect硬件設備。KinectSensor對象也就是需要獲取的各種數據流的封裝,包括RGB圖像數據流、Depth圖像數據流和Skeleton骨骼數據數據流。從KinectSensor對象獲取數據流最基本的方式是通過事件模型,監聽該對象的一系列事件。KinectSeneor對象有一個靜態的屬性集合,該集合有一個索引器和一個狀態值,狀態值總共有9此處為9種,但表2中卻為8種,是否正確?請作者核實。種返回值,分別代表著Kinect的不同狀態,如表2所示。集合中的索引器的作用就是用來獲取KinectSensor對象。

2.2RGBD數據流的獲取與融合

在Kinect的前方總共有3個鏡頭,分別是普通RGB彩色攝像頭、紅外線發射器和紅外線CMOS攝影機。其中RGB彩色攝影機主要用來采集彩色圖像,跟普通RGB攝像頭并沒有太多差別;CMOS攝影機和紅外線發射器一起構成的3D結構光深度感應器,其作用是采集深度數據,也就是場景中物體到攝像頭的距離。在使用Kinect設備進行手勢識別的過程中,與之相關的原始數據流有兩種,一種是RGB數據流,一種是Depth數據流,然后由這兩種數據流又可以融合成人體的骨骼數據流,在人體骨骼數據流的基礎上就能很方便地識別手勢。

在RGB數據流和Depth數據流進行融合的過程中需要用到隨機森林算法。隨機森林是一種基于統計的機器學習理論,使用隨機的方式建立一個決策樹森林。在得到隨機森林之后,每當輸入一個新的樣本到數據中后,首先讓森林中的每一棵決策樹分別進行判斷;然后看看這個樣本應該屬于對于分類算法而言的哪一分類;最后看哪一分類被選擇得最多,就預測這個樣本為哪一類,如圖2所示。

在Kinect平臺上使用的是由Shotton等[12]提出RGBD融合算法。該算法在實現過程中主要分為獲取樣本集、計算深度圖像特征值、根據特征值決定身體位置、確定骨架節點位置4個步驟。

1)獲取樣本集。

為了獲取足夠多的訓練樣本,Shotton等[12]用Kinect深度傳感器從各種不同的實際生活場景獲取了50多萬幀含有不同姿勢的深度圖像,然后用“最遠鄰居”聚類算法刪除相似重復樣本,得到一個最終包含10萬幀深度圖像的訓練樣本庫,這些樣本中任意兩個姿態的距離不小于5cm。

2)計算深度圖像的特征值。

Kinect使用式(1)來計算像素點x的特征值,以判斷該像素是否屬于身體的某一部位:

其中:dI(x)表示像素點x在深度圖I中的深度值;θ=(u,v)表示兩個偏移量u和v,為了使特征值具有深度不變性,偏移量需要除以一個歸一化因子dI(x)。

3)根據特征值確定身體位置。

決策森林是一個非常有效的多類分類器,它由T棵決策樹組成。從每幅合成圖中隨機選擇2000個能均勻覆蓋全身各部位的像素點構成樣本集,然后通過隨機決策森林算法進行訓練,隨機決策森林訓練完畢后,可以用來判斷某個像素點是否屬于身體的某一部位。在第T棵決策樹中,葉子節點表示像素x屬于身體部位標簽c的概率分布Pt(c|I,x)。最后通過式(2)將每棵樹的概率分布相加,就得到最終分類結果:

P(c|I,x)=1T∑Tt=1Pt(c|I,x)(2)

4)確定骨架節點位置。

隨機決策森林只能將深度圖像中的所有節點進行分類,還不能得到骨架節點的三維坐標信息。然后根據帶加權高斯核的均值漂移算法,就能得到最終的骨架節點的具體三維坐標信息。最終從單幅深度圖像中一共可以預測20個人體骨架節點的三維坐標位置。這20個骨架節點如圖3所示。

2.3骨骼點特征模型手勢庫

在進行手勢識別之前,本文先經過大量的訓練和測試,根據骨骼點之間的相對位置建立好了骨骼點特征模型手勢庫。在骨骼點特征模型手勢庫中,手臂部位的關節的不同相對位置可以對應不同的手勢指令,比如向左揮手和向右揮手,并且通過相應的閾值控制來提高手勢識別的魯棒性,不同手勢指令對應的骨骼點的相對位置圖4所示。

2.4加鎖機制控制原理

當獲取到骨骼數據流時,就能夠根據骨骼數據流中骨骼點之間的相對位置來與骨骼點特征模型手勢庫進行匹配來確定該時刻操作者的手勢含義。這種思路可以很好地解決動態手勢識別過程中實時性不高的問題,但是同時又會出現冗余手勢重復識別的問題。比如說當操作者向右揮手并一直停留在右邊時,根據剛才的設計思路,程序會多次響應向右的操作,但是很明顯操作者的意圖是只需要一次向右操作;本系統在具體的程序設計過程中通過操作系統中加鎖的機制來解決由于提高了手勢識別的實時性帶來的這一缺陷。具體做法就是在代碼中設置upActive、downActive、leftActive、rightActive、enterActive五把布爾型的全局變量鎖,能夠很有效地控制手勢操作的正常進行,即在一個指令還沒結束時,另一指令(包括與上次相同的指令)是不可能發生的,具體算法思路如算法1。

算法1加鎖模塊核心控制邏輯。

程序前

Input:skeletons。

Output:上、下、左、右、結束控制指令。

Skeleton=GetPrimarySkeleton(Skeleton[] skeletons)

if(rightHand.Position.Z primaryHand=rigthtHand; else primaryHand=leftHand; bool upActive=false; bool downActive=false;… private void ProcessSlideGesture(Joint shoulderCenter, Joint primaryHand) { double cross=primaryHand.X-shoulderCenter.X; double vertical=shoulderCenter.Y-primaryHand.Y; if (crossDistance>0.15) if(!upActive && !downActive && !leftActive && !rightActive) { rightActive=true; System.Windows.Forms.SendKeys.SendWait("{Right}"); } else rightActive=false; if (crossDistance<-0.15) if (!upActive && !downActive && !leftActive&&!rightActive) { leftActive=true; System.Windows.Forms.SendKeys.SendWait("{Left}"); } else leftActive=false;… } 程序后 2.5基于加鎖機制的靜態手勢識別方法流程 具體的手勢識別流程主要包括,獲取RGBD融合數據流、完整骨骼檢查、識別主控者骨骼、識別主控手、識別當前幀手勢指令、識別控制鎖是否激活、發送指令幾個步驟,具體流程如圖5所示。 通過前三個步驟,首先獲取到RGBD融合后的骨骼數據流,然后判斷數據流中是否有完整的骨骼數據流:若沒有,則重新獲取RGBD融合后的數據流;若有則首先通過Depth信息從數據流中識別出主控者的骨骼數據流,然后再判斷主控者的主控手。由于主控者在控制過程隨時都可能改變主控手,所以這一過程是必須的,而不能在初始時就假定哪只手為主控手。主控手確定后就能夠識別當前幀的手勢指令了,識別到手勢指令后,還需要判斷是控制鎖是否激活,若控制鎖被激活則表明上一手勢指令已結束,即能夠發出下一指令;若控制鎖沒有被激活則表明上一指令還在進行中,還沒有讓出控制鎖,不能發出當前指令操作。 3應用與實驗 通過對本文提出的基于加鎖機制的靜態手勢識別方法進行具體實現與應用,在實驗中設計并實現了一個具體的手勢識別系統,主體上分為手勢識別模塊和游戲模塊兩個部分。手勢識別模塊是對基于加鎖機制的靜態手勢識別方法的實現,用來識別用戶手勢,并發出相應操作指令。游戲模塊通過接收手勢識別模塊發出的指令進行游戲,起到在真實應用場景中測試手勢識別模塊的準確率和流暢性的作用。接下來將闡述游戲的功能、手勢識別對比實驗。 3.1游戲整體介紹 “程序員進階之路”是一款益智類網頁游戲,用來接收底層手勢識別模塊的指令并進行游戲,從而測試底層模塊在具體應用場景中的實用性。在游戲主界面中,主體顯示4×4的16個小方塊,每個小方塊上顯示有程序員的職位名稱,代表小方塊的分數值,如圖6所示,程序員的職位越高,方塊的分數值越大,并且不同的職位方塊使用深淺不同的顏色表示,操作者通過鍵盤上、下、左、右鍵來控制方塊的整體移動,通過鍵盤的enter鍵來控制游戲的重新開始,當兩個相同的等級值的方塊發生碰撞時表示程序員開始進階,將提升方塊的等級值為更高一等級。 手勢識別系統整體架構如圖7所示。游戲底層是手勢識別模塊,首先通過Kinect攝像機的RGB攝像頭和紅外傳感器獲取到彩色圖像數據流和深度信息數據流;然后由這兩種數據流融合成Skeleton骨骼數據流;接著通過對骨骼數據流的分析、預處理、顯示等步驟,并且使用基于加鎖機制的手勢識別方法達到手勢識別目的,在這個過程中需要與初始建立好的骨骼點特征模型手勢庫進行比對計算,得到手勢識別指令。

3.2手勢識別對比實驗

3.2.1手勢的定義

為了更好地測試基于靜態加鎖機制的手勢識別方法在實際應用中的識別效果,在實驗中,總共設計了6種手勢,分別是“左”“右”“上”“下”“確認”“取消”;同時這6種基本手勢也能很好地控制游戲的進行,每種手勢的具體參數與含義如表3所示。表中相對位置參數是指Hand關節與shoulder關節在空間三維坐標中的相對位置。具體地,“左”“右”手勢指X坐標抽上的相對位置,“上”“下”手勢指Y坐標軸上的相對位置,“確認”“取消”手勢指Z坐標軸上的相對位置;閾值的設置是為了提高算法識別的容錯性,具體參數是依據實驗參與者在實際游戲過程中的自然手勢的關節相對位置得到的。

3.2.2手勢的識別

手勢識別的流程主要分為骨骼點特征模型手勢庫的設計與建立、Kinect設備的發現及數據流的獲取與顯示、主控人與主控手的確定、手勢操作識別4個過程。其流程描述如下。

Input:Skeleton骨骼數據流。

Output:手勢識別指令。

1)骨骼特征模型手勢庫的設計與建立。

2)Kinect設備的發現打開與數據流的獲取顯示。

3)主控人與主控手的確定。

4)基于加鎖機制進行靜態手勢識別。

手勢識別模塊界面的設計與實現如下。

1)原始數據流的獲取。

從Kinect中獲取的初始深度數據流是原始的十六進制數據流,可以直接將其通過控制臺輸出,就能看到其具體表現形式。在十六進制數據流中,每一個深度圖像像素點都是一個三維坐標(x,y,z),表示其在三維空間中的位置。在獲取骨骼數據流時,從Kinect得到的是多個由20個三維坐標組成的數據,每一個三維坐標均表示一個骨骼點在三維空間中的位置,并且在骨骼點的數據結構中還有一個變量來表示骨骼點具體表示的是哪一個骨骼,具體的十六進制數據流如圖8所示。

2)實時骨架的繪制。

實時骨架的顯示流程首先是由骨骼數據獲取到骨骼點的三維坐標信息并將其轉化為界面中對應的二維坐標,然后根據骨骼點的二維坐標在圖形界面中將骨骼點用實心圓繪制出來,接著根據骨骼點對應的人體具體物理關節在圖形界面中連接實心圓用以表示骨架,并且若骨骼點不是實際獲取而是推測出來的,則用不用顏色表示用以區別,相應骨架用虛線連接。這樣當所有骨骼點和骨架繪制完畢后,一幅栩栩如生的實時人體骨架圖就會展現在主界面上,如圖9所示。

3.2.3識別準確率對比

分別使用靜態手勢識別方法實現的程序和基于加鎖機制的靜態手勢識別方法實現的程序,進行“程序員進階之路”游戲實驗,同一實驗人以自己最舒適的自然手勢進行游戲,并統計游戲過程中各種手勢出現的次數以及不同方法正確識別的手勢次數,由此計算出不同方法的識別準確率,具體如表4所示。

從表4中的數據可以看出,對于單個手勢的準確率和整體的準確率,本文提出的方法在手勢識別準確率上都較靜態手勢識別方法有所提高,這是由于靜態手勢識別方法沒有對關節移動過程中的時間序列進行分析,從而不能準確地判斷一個手勢開始時刻和結束時刻,導致識別準確率不高,而本文方法由于加鎖機制的引入,很好地避免了這一漏洞,使準確率得到了大幅的提升。

3.2.4識別速度對比

分別使用動態手勢識別方法實現的程序和基于加鎖機制的靜態手勢識別方法實現的程序,進行“程序員進階之路”游戲實驗,同一實驗人以自己最舒適的自然手勢進行游戲,規定游戲時間為2min,統計在這2min內程序識別的手勢次數,從而對比兩種方法的手勢識別速度。一次手勢識別的完整過程為實驗者從開始手勢動做到游戲界面執行完此手勢效果為止,并且實驗者在2min內連續發出手勢指令進行游戲,所以表中的識別速度是指兩種方法在此具體游戲環境中的識別速度,其中還包含有游戲界面的響應時間,具體數據如表5所示。

從實驗結果可以看出,在識別速度上,本文方法較動態手勢識別方法有所提高,平均每次識別所花的時間減少了1/4s0.25s,速度提高14%。這主要由于動態手勢識別方法在識別每一獨立手勢的時候都必須先分析手勢的時間序列,從而得到手勢的開始時刻和結束時刻,這一計算過程需要耗費一定的時間;而基于加鎖機制的靜態手勢識別方法由于加鎖機制的引入,不需要計算開始時刻和結束時刻,從而提高了識別速度。

4結語

本文提出的基于加鎖機制的靜態手勢識別方法有效地整合了靜態手勢識別和動態手勢識別的優勢。在方法中,首先獲取到RGBD融合后的骨骼數據流;然后通過Depth信息從數據流中識別出主控者的骨骼數據流;接著再判斷主控者的主控手,主控手確定后就能夠識別當前幀的手勢指令了。識別到手勢指令后,還需要判斷是控制鎖是否激活,若控制鎖被激活則表明上一手勢指令已結束,即能夠發出下一指令,若控制鎖沒有被激活則表明上一指令還在進行中,還沒有讓出控制鎖,不能發出當前指令操作。最后將提出的手勢識別方法具體應用到實際的手勢識別系統中,使用HTML5和JQuery技術設計了一款“程序員進階之路”益智類網頁游戲,并部署在GitHub的個人主頁上(網址:http://180.76.137.57:8080/aroad/index.html),在RGBD融合后的數據流上使用本文識別方法,來識別游戲者的手勢指令,可以很好地實現無需鼠標和鍵盤僅通過手勢就能實時準確地進行游戲的目的。

在實際系統中進行了兩個對比實驗:一個是比較本文方法與靜態手勢識別方法的識別準確率,由實驗數據可以看到,識別準確率提高了14.4%;另一個是比較本文方法與動態手勢識別方法的識別速度,實驗數據顯示每次手勢的平均本文方法識別速度提高了1/4s14%。實驗結果表明,本文提出的基于加鎖機制的靜態手勢識別方法,很好地解決了靜態手勢識別中存在的冗余手勢和重復手勢問題,提高了識別正確性;同時又保留了靜態識別的速率速度快的優勢,達到了實時識別的目的。

參考文獻:

[1]

CHOI W, PANTOFARU C, SAVARESE S. A general framework for tracking multiple people from a moving camera [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(7): 1577-1591.

[2]

REN Z, YUAN J, MENG J, et al. Robust hand gesture recognition based on fingerearth movers distance with a commodity depth camera [C]// MM11: Proceedings of the 19th ACM International Conference on Multimedia. New York: ACM, 2011: 1093-1096.

[3]

YANG C, JANG Y, BEHETC J. Gesture recognition using depthbased hand tracking for contactless controller application [C]// ICCE 2012: Proceedings of the 2012 IEEE International Conference on Consumer Electronics. Piscataway, NJ: IEEE, 2012: 297-298.

[4]

OSZUST M, WYSOCKI M. Polish sign language words recognition with Kinect [C]// HSI 2013: Proceedings of the 2013 6th International Conference on Human System Interactions. Washington, DC: IEEE Computer Society, 2013: 219-226.

[5]

CHAI X, LI G, LIN Y, et al. Sign language recognition and translation with Kinect [C]// FG 2013: Proceedings of the 10th IEEE International Conference on Automatic Face and Gesture Recognition. Washington, DC: IEEE Computer Society, 2013: 22-26.

[6]

CHAI X, LI G, CHEN X, et al. A tool to support communication between deaf and hearing persons with the Kinect [C]// ASSETS 2013: Proceedings of the 15th International ACM SIGACCESS Conference on Computers and Accessibility Proceedings. New York: ACM, 2013: 21-23.

[7]

林海波,梅為林,張毅,等.基于Kinect骨骼信息的機械臂體感交互系統的設計與實現[J].計算機應用與軟件,2013,30(2):157-160.(LIN H B, MEI W L, ZHANG Y, et al. Design and implementation of robot arm somatosensory interaction system based on Kinect skeletal information [J]. Computer Applications and Software, 2013, 30(2): 157-160.)

[8]

ZHAO Y, LIU Z, CHENG H. RGBdepth feature for 3D human activity recognition [J]. China Communication, 2013, 10(7): 93-103.

[9]

WANG Y, SHI Y. Human activities segmentation and location of key frames based on 3D skeleton [C]// CCC 2014: Proceedings of the 33rd Chinese Control Conference. Washington, DC: IEEE Computer Society, 2014: 4786-4790.

[10]

CHEN H, LIU T, GE M, et al. A depth optimization method for 2Dto3D conversion based on RGBD images [C]// IEEE ICNIDC 2014: Proceedings of the 2014 4th IEEE International Conference on Network Infrastructure and Digital Content. Piscataway, NJ: IEEE, 2014: 223-227.

[11]

鄭立國,劉楊,羅江林,等.基于RGBD數據的實時人體檢測算法[J].吉林大學學報(信息科學版),2015,33(2):214-218.(ZHENG L G, LIU Y, LUO J L, et al. Implementation of realtime human body detection based on RGBD data [J]. Journal of Jilin University (Information Science Edition), 2015, 33(2): 214-218.)

[12]

SHOTTON J, FITZGIBBON A, COOK M, et al. Realtime human pose recognition in parts from single depth images [C]// CVPR 2011: Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2011: 1297-1304.