基于Skip-gram模型的微博情感傾向性分析

李天彩 王 波 毛二松 席耀一

(解放軍信息工程大學 河南 鄭州 450002)

?

基于Skip-gram模型的微博情感傾向性分析

李天彩王波毛二松席耀一

(解放軍信息工程大學河南 鄭州 450002)

摘要為了更好地對微博進行表示,提高微博情感傾向性識別的準確度,提出一種基于Skip-gram模型的微博情感傾向性分析方法。首先,使用Skip-gram模型在中文數據上進行訓練得到詞向量;然后,利用詞向量在詞語表示上的優勢,以及一定程度上滿足加法組合運算的特性,通過向量相加獲得微博的向量表示以及正負情感向量;最后,通過計算微博向量和正負情感向量的相似度判斷微博的情感傾向。在NLP&CC2012數據上進行實驗,結果表明,該方法能夠有效識別微博的情感傾向,較傳統的JST(Joint Sentiment/Topic model)和ASUM(Aspect and Sentiment Unication Model)平均F1值分別提高了23%和26%。

關鍵詞微博情感分析Skip-gram模型詞向量微博向量

0引言

微博的情感傾向性分析是指對微博消息所表示的情感進行識別,判斷它的傾向性是正面還是負面。根據中國互聯網信息中心CNNIC(China Internet Network Information Center)2014年7月發布的全國互聯網發展統計報告[1]指出,我國網民規模達6.32億,其中微博用戶2.75億,占整體網民的43.6%。雖然較2013年的微博用戶的數量略有下降,但是微博的平臺效應更加明顯,內容更加豐富,網民參與微博上的討論,發表意見和看法的活動也越來越頻繁。因此,對微博中包含的情感進行分析,獲得網民對熱點事件的情感傾向對輿情監測、輔助決策等具有重要的意義。

目前,情感傾向性分析主要包括基于規則和基于統計兩類方法。基于規則的方法一般是通過情感詞典獲取詞的情感傾向性,然后通過句法規則對微博消息進行處理,最后通過加權計算獲得微博消息的情感傾向性。2012年,馮時等人[2]提出了一種基于句法依存分析技術的博客文本情感傾向性分析算法SOAD(Sentiment Orientation Analysis Based on Syntactic Dependency)。通過分析句法依存樹得到含有情感詞的依存關系對,然后依據設定的規則計算博客文本的情感傾向性。2013年,Guo等人[3]改進了依存句法分析技術,并將其用于微博的分析。該方法在句法樹中考慮了表情符號和標點符號的影響,通過句法樹中詞語到核心情感詞的距離來計算詞語的情感傾向。基于規則的方法需要對文本進行句法分析,但是微博消息一般比較簡短,存在著大量的集外詞,上下文存在交錯,往往不具有標準的句法結構,這使得基于規則的方法適用性受到了限制。

基于統計的方法分為有監督的方法和無監督的方法[4]。其中,有監督的方法一般是通過有標注的訓練數據提取特征并訓練分類器,再對測試數據進行情感分析。2010年,Barbosa等人[5]利用已進行情感分類的Twitter數據作為訓練數據,使用得到的特征信息對Twitter進行情感分類。2012年,謝麗星等人[6]使用了表情符號的規則方法、情感詞典的規則方法和基于SVM的層次結構的多策略方法對微博的情感分析進行了深入細致的研究,并指出與英文微博相比中文微博語義更加豐富,主題更加多樣。有監督的方法一般可以得到較高的準確度,但是其性能與訓練數據的質量和數量有很大的關系。由于很難獲得大規模高質量的人工標注數據,有監督方法的性能受到了限制;并且有監督的方法存在領域可移植性較差的不足,在一個領域數據上訓練得到的模型移植到新的領域時性能會明顯下降,需要在新的訓練數據上重新進行訓練。無監督的方法一般是通過對數據進行統計分析,通過概率模型計算微博中的情感分布,然后進行情感傾向性判斷。2009年,Lin等人[7]提出了一種基于LDA(Latent Dirichlet Allocation)模型改進的模型,稱為JST模型。JST模型在LDA模型的文檔和主題之間加入了情感層,使其成為一個4層的概率模型,在采樣過程中對每個詞采樣主題標簽和情感標簽,通過統計主題標簽和情感標簽的對應關系得到每個主題的情感分布。2011年,Jo等人[8]提出了ASUM模型。假設每個句子只有一個主題,在采樣過程中對每個句子采樣其主題標簽和情感標簽。2013年,Ding等人[9]提出了HDP-LDA(Hierarchical Dirichlet Process-Latent Dirichlet Allocation)模型。該模型利用了HDP模型可以自動確定主題個數的優勢,挖掘短語級別的情感傾向,但是該方法需要通過詞性標注識別短語對,短語識別的準確度會影響情感分析的結果,并且該模型中需要設定大量的參數,降低了其領域可移植性。基于主題模型的情感傾向性分析取得了較傳統方法更準確的結果,但是從大量的實驗和實踐中發現,LDA模型、PLSA(Probabilistic Latent Semantic Analysis)模型等主題模型并不適用于大規模數據的訓練和處理。該類模型中都需要假設數據服從指數分布,但是真實環境下的數據,尤其是互聯網上的數據,服從的是長尾分布[10]。該類模型過于偏重從高頻數據中歸納語義,忽視了對低頻數據的處理,所以并不適用于描述長尾數據。

為了發揮無監督方法可移植性好的優勢,同時結合微博數據量大,內容多樣的特點,本文提出了一種基于Skip-gram模型的微博情感傾向性分析方法。Skip-gram模型是Mikolov等人[11]提出的一種可以在大規模數據集上進行訓練的神經網絡語言模型。本文使用Skip-gram模型在中文數據集上進行訓練,得到詞向量后,將其用于微博的情感傾向性分析。實驗結果表明,本文提出的方法較傳統的無監督的方法性能得到了有效提高。

1詞向量

詞向量的基本思想是將每個詞映射成一個k維實數向量,一般取1000維以下。Mikolov等人[11]指出相比于傳統的語言模型,基于神經網絡語言模型[12]NNML(Neural Network Language Model)得到的詞向量對詞的表示更加準確。Mikolov等人[13]提出的Skip-gram模型是對現有模型的改進,它可以快速地完成對數十億詞的大規模數據的訓練,得到的詞向量在詞語表示上更加準確。Skip-gram模型可以通過Hierarchical Softmax[14]和Negative Sampling[13]兩種框架構造實現。本文使用的是基于Hierarchical Softmax構造的Skip-gram模型。

目前對詞向量的研究主要是針對詞聚類、同義詞判斷和詞性分析等任務,主要是利用詞向量對詞語進行表示,通過向量計算詞與詞之間的相似程度。本文使用Mikolov等人[11]提出的Skip-gram(http://code.google.com/p/word2vec)模型在中文數據上進行訓練,對得到的詞向量進行實驗發現,詞向量在中文詞語的表示上也表現出較好的性能。例如使用詞向量計算“北京”、“和諧”、“奸商”和“貪污”這4個詞語兩兩之間的相似度時,“北京”與“和諧”、“奸商”與“貪污”的相似度明顯高于其他組合。

根據Mikolov等人[13]的研究,使用Skip-gram模型訓練得到的詞向量除了用來計算詞與詞之間的相似度之外,一定程度上還滿足加法組合運算。Mikolov等人在文獻[11,13]中都舉了例子對這點進行說明:

vector(″Paris″)-vector(″France″)+vector(″Italy″)

≈vector(″Rome″)

(1)

vector(″King″)-vector(″Man″)+vector(″Woman″)

≈vector(″Queen″)

(2)

vector(″Russia″)+vector(″river″)≈vector(″Volga River″)

(3)

如式(1)、式(2)所示,“King”和“Man”的關系類似于“Queen”和“Woman”的關系,當使用“King”和“Woman”的詞向量減去“Man”的詞向量得到的結果非常接近于“Queen”的詞向量。“Paris”、“France”、“Italy”和“Rome”也滿足類似的關系。式(3)中“Russia”和“river”的詞向量的和與“Volga River”很相近,這說明對詞向量進行加法運算,得到的向量仍然是有意義的,而且其表示的語義與之前的詞都是相關的。在中文數據上進行測試,也存在類似的關系:

vector(″中國″)-vector(″北京″)+vector(″華盛頓″)

≈vector(″美國″)

(4)

vector(″中國″)+vector(″男籃″)≈vector(″姚明″)

(5)

2微博情感傾向性分析

使用Skip-gram模型訓練得到的詞向量不僅在詞語的表示上較傳統的方法更加準確,而且能通過加法組合運算挖掘詞與詞之間的語義關系。本文根據這些特點提出了一種新的微博情感傾向性分析方法。

在微博的情感分析中,由于微博長度較短,包含的詞語較少,使用向量空間模型進行表示時會出現嚴重的特征稀疏。而且在微博中常常會有網絡語言和流行新詞出現,基于知識庫的方法受到更新速度的限制,一般無法及時收錄這些詞語或是更新已有詞的新含義。因此本文方法中將微博表示成其包含詞的詞向量的集合,使用大量公開數據進行訓練得到詞向量用于挖掘詞語之間的語義關系。

wbm={v(w1),v(w2),v(w3),…,v(wNm)}

(6)

其中wbm表示序號為m的微博消息,v(wi)表示wbm中第i個詞的詞向量,Nm表示wbm中詞的個數。

Skip-gram模型訓練得到的詞向量一定程度上滿足加法組合運算,將多個詞的詞向量進行相加得到的新向量仍然表示與這些詞相關的語義。因此本文提出關于微博向量的假設如下:

假設一條微博消息所包含詞的詞向量進行相加得到的向量和仍然與這條微博的語義相關,并且可以反映其情感傾向。微博向量的計算式如下所示:

(7)

其中v(wbm)表示wbm中所有詞的詞向量相加并進行歸一化之后得到的向量,本文將其稱為微博向量。通過實驗證明,這樣的假設是符合真實情況的,例如式(8)、式(9)所示:

vector(″英雄″)+vector(″出″)+vector(″少年″)

≈vector(″英勇″)

(8)

vector(″中國″)+vector(″需要″)+vector(″這樣″)+

vector(″人才″)≈vector(″真才實學″)

(9)

這兩條微博都來自NLP&CC2012微博情感分析測試數據中“90后當教授”事件相關的微博中。從內容來看,兩句都反映的是正面的情感,計算向量和之后得到的向量也與反映正面情感的詞相近,這說明可以使用微博向量對微博消息進行表示。

本文還通過對情感詞典中的正負情感詞進行詞向量相加定義了正面情感向量和負面情感向量的計算式如下:

(10)

(11)

其中,S+表示正面情感,S-表示負面情感,v(POS)和v(NEG)分別表示正面和負面情感向量。當對一條微博消息進行情感傾向性分析時,通過式(12)的判別函數進行判斷。

(12)

(13)

(14)

其中,S0表示中性,sim(v(wbm),v(POS))表示微博向量與正面情感向量的余弦相似度,sim(v(wbm),v(NEG))表示微博向量與負面情感向量的余弦相似度,t是判斷微博情感傾向的閾值。當sim(v(wbm),v(POS))>t時,說明wbm的情感與正面情感更相近,判斷wbm屬于正面微博;當sim(v(wbm),v(NEG))>t時,說明wbm的情感與負面情感更相近,判斷wbm屬于負面微博;當微博與正負情感向量的相似度都較小時,說明微博的正負傾向性都不明顯,判斷wbm是中性微博。

當只需要進行正負情感傾向性判斷時,判別函數可以簡化如下:

(15)

3實驗與結果分析

3.1實驗數據

實驗的訓練數據來源于“搜狗實驗室”的“全網新聞數據”(http://www.sogou.com/labs/dl/ca.html),包含3.79億個詞。使用的情感詞典是通過合并HowNet情感詞典[15]、NTUSD詞典[16]、學生褒貶詞典[17]得到的。測試數據集來源于微博情感傾向性分析研究領域的通用數據NLP&&CC2012[18],包括20個話題,每個話題標注大約100條微博,共記2023條微博。其中包含正面情感傾向微博307條,負面情感傾向微博1406條,以及310條中立傾向的微博。由于現有研究很多都沒有考慮中立傾向的微博,為了便于對比,本文實驗只分析微博的正負面情感傾向性。

3.2評價方法

為了評價情感傾向性分析方法的性能,本文實驗選取與NLP&&CC2012相同的評價方法,即準確率P(Precision)、召回率R(Recall)以及F1值:

(16)

(17)

(18)

其中,S表示情感傾向,S={S+,S-},PS、RS和FS分別表示在對情感傾向為S的類別進行評價的準確率、召回率和F1值。整體的情感傾向性的性能可以通過F1S值加權求和得到,公式如下:

(19)

其中,Favg表示正負面微博F1值的加權平均值,NS表示情感傾向為S的微博消息的數量。

3.3實驗設置與結果分析

為了驗證該方法的有效性,本文選取文獻[7]提出的JST和文獻[8]提出的ASUM進行對比實驗,結果分別記為JST和ASUM;本文方法結果記為MBV(Micro-Blog Vector)。JST和ASUM按照文獻[9]中的方法設置最優參數;MBV中Skip-gram模型的參數按照文獻[11]中設置。設置以下2組實驗:

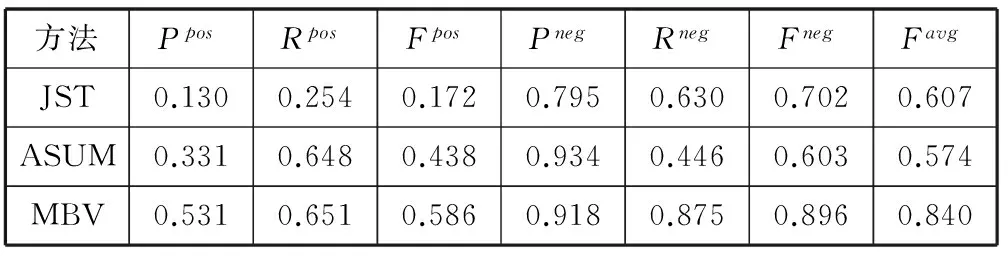

(1) 綜合性能對比實驗

分別利用上述3種方法進行實驗,評估其綜合性能。其中,對JST、ASUM和MBV的結果取10次求平均作為其最終結果。其中,Ppos表示正面微博的準確率,Rpos表示正面微博的召回率,Fpos表示正面微博的F1值,Pneg表示負面微博的準確率,Rneg表示負面微博的召回率,Fneg表示負面微博的F1值,Favg表示正負面微博F1值的加權平均值。綜合性能對比情況如表1所示。

表1 不同方法的綜合性能對比實驗

由表1可以看出,三種方法結果中MBV的Favg值為0.840,明顯高于JST的0.607和ASUM的0.574,而且MBV在正面微博和負面微博的情感傾向性分析中也都顯示了明顯的優勢。三種方法的Fpos都較低,這是因為實驗數據不平衡,負面傾向的微博有1406條,遠多于正面傾向的微博,將負面微博誤判為正面微博的數量更多,造成正面微博的準確率相對較低。除此之外,因為JST和ASUM都是基于主題模型的方法,當實驗數據中正負面情感的微博數量不平衡時,通過主題模型得到的主題中包含負面情感詞的概率較大,將微博判斷為負面的概率也隨之增大,這進一步導致JST和ASUM的Rpos較低。與此同時,這種情感判斷的傾向性會使得JST和ASUM的Pneg較高,但是Rneg較低,Fneg也相對較低。ASUM的Fpos高于JST,這是因為ASUM假設數據中正負面微博比例相當,導致相當一部分負面微博誤識別為正面微博,使得Rpos較高,從而導致Fpos偏高,但是ASUM的這種假設會導致Fneg相應偏小,整體性能低于JST。MBV中以詞語的詞向量表示為基礎,訓練過程中不需要對訓練數據中正負面內容的比例進行規定。除此之外,通過情感詞的詞向量計算情感向量作為對正負面情感的表示也可以避免情感詞典不平衡和不完整對情感分析的影響。總的來說,MBV使用微博向量對微博包含的語義信息進行表示。通過計算微博向量與正負面情感的語義相似度進行情感傾向性判斷,更符合對人類認知內容的過程,實驗結果也表明該方法明顯優于JST和ASUM。

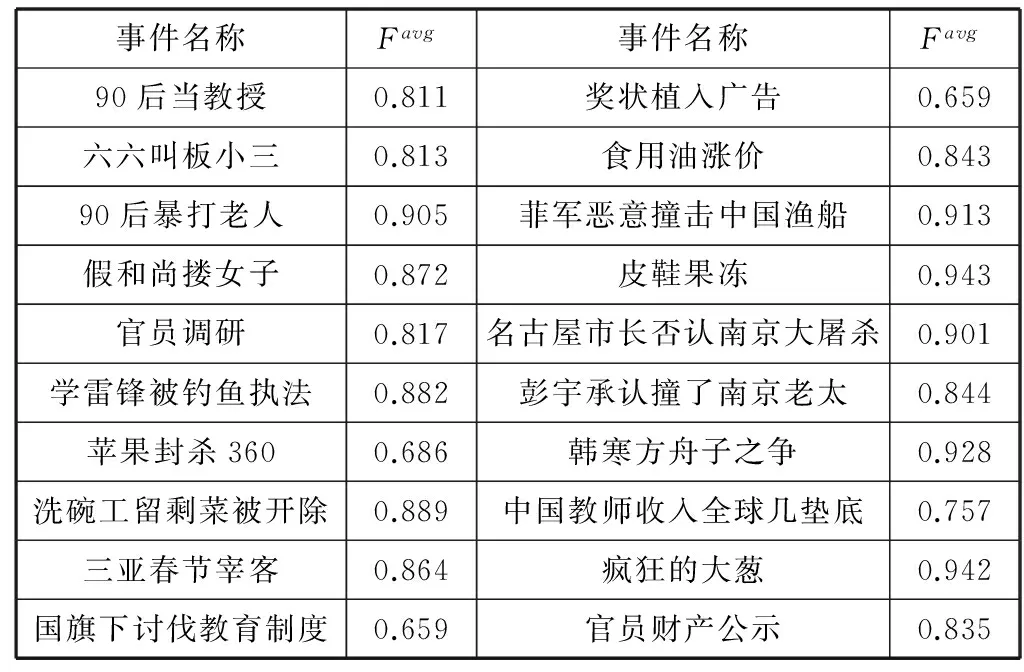

本文提出的方法是在大規模無標注的訓練數據上進行訓練,具有良好的領域可移植性。為了驗證本文提出的方法在單個微博事件的情感傾向性分析中的性能,本文對實驗中使用的20個事件的情感傾向性分析結果進行了單獨計算,得到的結果如表2所示。

表2 單個微博事件情感傾向性分析

從表2中可以看出,“皮鞋果凍”、“瘋狂的大蔥”、“名古屋市長否認南京大屠殺”等事件對應的Favg高于其他事件,這是因為與這些事件相關的微博中大部分都是表示譴責和批評,使用了較多具有強烈的負面情感傾向的詞,使微博向量明顯的傾向于負面情感向量。而在“蘋果封殺360”、“國旗下討伐教育制度”等事件中,有較多的微博包含了支持一方反對另一方的內容,如“他的勇氣實在令人佩服,這個社會就是黑暗的”等。由于本文的方法將微博內容看成詞袋,無法區分評論的對象,當包含多個對象多種情感時該方法的準確性降低。總體來說,本文提出的方法在大多數屬于不同領域的單個事件的情感傾向性分析中都取得了較好的結果,說明本文的方法具有良好的領域可移植性。

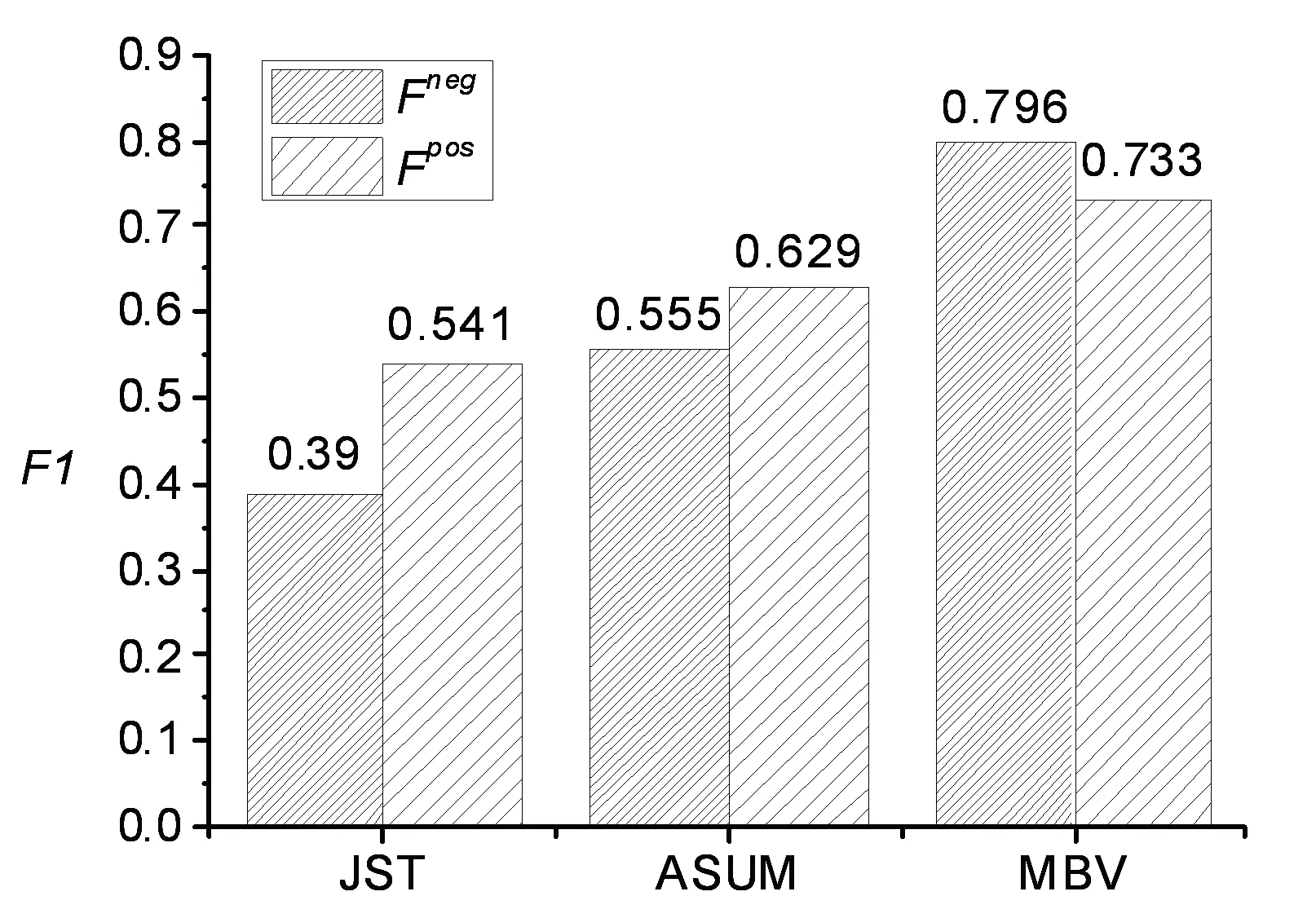

(2) 平衡數據上的對比實驗

實驗(1)中,由于實驗數據中正負情感傾向的微博數量差別較大,數據存在不平衡。為了增強實驗對比的可靠性,本文從實驗數據中分別選取正負面微博各307條構建了一份平衡數據用于進行對比實驗,結果如圖1所示。

圖1 平衡數據對比實驗結果

由圖1可以看到,在平衡數據上進行實驗,MBV的Fpos和Fneg均明顯高于JST和ASUM。三種方法的Fpos都高于實驗(1)的結果,這是因為負面微博被錯判為正面微博的數量減少,使Ppos得以提高,進而提高了Fpos。JST和ASUM的Fneg都低于實驗(1)中的結果,這符合之前的結果分析。除此之外,ASUM在平衡語料上的結果優于JST,這是因為平衡語料符合ASUM正負面微博比例相當的假設,ASUM表現更好。MBV對每條微博計算一個微博向量作為其表示,與正負面情感向量計算語義相似度進行情感傾向性判斷。不同微博計算微博向量表示和進行情感傾向性判斷的過程是相互獨立的,因此不會受到待測數據中正負面內容的比例不同的影響。綜合實驗(1)和實驗(2)的結果,本文的方法具有良好的領域可移植性,在非平衡數據還是平衡數據上,性能均優于傳統方法,這充分證明了本文方法的有效性和優越性。

4結語

本文利用Skip-gram模型在中文數據上進行訓練,利用詞向量在詞語表示上的優勢,以及在一定程度上滿足加法組合運算的特性,提出了一種使用微博向量對微博進行表示,并將其用于微博情感傾向性分析的方法。通過在非平衡數據和平衡數據上分別進行實驗,證明了本文提出的方法較傳統的JST模型和ASUM模型性能上有了很大的提高,并且具有良好的領域可移植性。本文的方法中是使用微博向量對一條微博進行表示,該方法同樣可以適用于其他句子級的情感傾向性分析任務中。除此之外,Skip-gram模型對詞語表示的準確度可以通過擴大訓練數據的規模和領域范圍進行提高,所以本文方法的性能還有進一步提高的空間。

本文的方法中還存在一些不足,主要包括以下兩個方面的問題:首先是沒有對微博中用詞不規范的情況進行處理,在微博中經常會出現錯別字、散光字、火星文等,如“老白姓”、“弓雖”等,當微博內容較短時會影響結果;其次是本文雖然取得了較好的結果,但是構造微博向量的方法較為簡單,沒有考慮詞語的前后順序及否定詞的影響。在下一步工作中,如何解決這兩個問題,將是研究的重要方向。

參考文獻

[1] 中國互聯網絡發展狀況統計報告(2014年7月)[R].北京:中國互聯網信息中心,2014.

[2] 馮時,付永陳,陽鋒,等.基于依存句法的博文情感傾向性分析研究[J].計算機研究與發展,2012,49(11):2395-2406.

[3] Fuliang Guo,Gang Zhou.Research on micro-blog sentiment orientation analysis based on improved dependency parsing[C]//Proceedings of the 2013 3rd International Conference on Consumer Electronics,Communications and Networks,Xianning,China,2013:546-550.

[4] Bing Liu,Lei Zhang.A survey of opinion mining and sentiment analysis[M].New York:Springer US,2012:415-463.

[5] Barbosa L,Junlan Feng.Robust sentiment detection on twitter from biased and noisy data[C]//Proceedings of the 23rd International Conference on Computational Linguistics,Uppsala,Sweden,2010:36-44.

[6] 謝麗星,周明,孫茂松.基于層次結構的多策略中文微博情感分析和特征抽取[J].中文信息學報,2012,26(1):73-83.

[7] Chenghua Lin,Yulan He.Joint sentiment topic model for sentiment analysis[C]//Proceedings of the 18th ACM Conference on Information and Knowledge Management Hong Kong,China,2009:375-384.

[8] Jo Yohan,Oh Alice.Aspect and Sentiment Unification Model for Online Review Analysis[C]//Proc. of the fourth ACM international conference on Web search and data mining,2011:815-824.

[9] Wanying Ding,Xiaoli Song,Lifan Guo.A novel hybrid HDP-LDA model for sentiment analysis[C]//Proceedings of the 2013 IEEE/WIC/ACM International Joint Conferences on Web Intelligence (WI) and Intelligent Agent Technology,Atlanta,USA,2013,1(1):329-336.

[10] Kevin P Murphy.Machine Learning-A Probabilistic Perspective[M].Cambridge,Massachusetts London,England: The MIT Press,2012:2-3.

[11] Mikolov T,Chen K,Corrado G,et al.Efficient estimation of word representations in vector space[C]//International Conference on Learning Representations,2013.

[12] Yoshua B,Rejean D,Pascal V,et al.A neural probabilistic language model[J].The Journal of Machine Learning Research,2003,3(6):1137-1155.

[13] Mikolov T,Sutskever I,Chen K,et al.Distributed Representations of Words and Phrases and their Compositionality[C]//Neural Information Procesing Systems Foundation,2013.

[14] Frederic M,Yoshua B.Hierarchical probabilistic neural network language model[C]//Proceedings of the international workshop on artificial intelligence and statistics,2005.

[15] 董振東,董強.HowNet情感詞典[EB/OL].[2013-07-28].http://www.keenage.com.

[16] Ku Lunwei,Lo Yongsheng,Chen Hsinhsi.Using Polarity Scores of Words for Sentence-level Opinion Extraction[C]//Proc.of NTCIR-6 workshop meeting,2007:316-322.

[17] 張偉,劉縉,郭先珍.學生褒貶義詞典[M].北京:中國大百科全書出版社,2004.

[18] 中國計算機學會.微博情感分析評測數據[EB/OL].[2012-09-12].http://tcci.ccf.org.cn/conference/2012/.

收稿日期:2014-12-13。李天彩,碩士生,主研領域:情感分析,會話抽取。王波,副教授。毛二松,碩士生。席耀一,博士生。

中圖分類號TP391.4

文獻標識碼A

DOI:10.3969/j.issn.1000-386x.2016.07.027

ANALYSING MICROBLOGGING SENTIMENT ORIENTATION BASED ON SKIP-GRAM MODEL

Li TiancaiWang BoMao ErsongXi Yaoyi

(ThePLAInformationEngineeringUniversity,Zhengzhou450002,Henan,China)

AbstractIn order to represent microblogs better and to improve the accuracy of microblogging sentiment orientation identification, we presented a Skip-gram model-based microblogging sentiment orientation analysis method. First, we used Skip-gram model in training on Chinese dataset to get word vector; then, we took use of the advantage of word vector on word representation and its feature of satisfying in certain extent the addition combinational operation to obtain the vector representation of microblogs and the positive and negative sentiment vectors by vectors addition; finally, we determined the microblogging sentiment orientation by computing the similarity between microblogging vectors and positive and negative sentiment vectors. Experiment was carried out on NLP&CC2012 data, the results showed that our method could effectively identify the sentiment orientation of microblogs, and improved the average F1-measure by 23% and 26% respectively compared with traditional JST and ASUM.

KeywordsMicrobloggingSentiment analysisSkip-gram modelWord vectorMicroblogging vector