雙目實時目標三維測量實現方法的研究

肖永強,王海暉,2*,劉奧麗,王子維,章劉斌

1.武漢工程大學計算機科學與工程學院,湖北 武漢 430205;2.智能機器人湖北省重點實驗室(武漢工程大學),湖北 武漢 430205

雙目實時目標三維測量實現方法的研究

肖永強1,王海暉1,2*,劉奧麗1,王子維1,章劉斌1

1.武漢工程大學計算機科學與工程學院,湖北 武漢 430205;

2.智能機器人湖北省重點實驗室(武漢工程大學),湖北 武漢 430205

為了解決目標匹配困難、匹配效率低等問題,提出了一種基于雙目立體視覺的實時目標特征匹配算法——絕對窗口誤差最小化(CAEW).首先,在研究攝像機基本原理后利用張氏標定法解決攝像機的標定,并對最終標定數據采用Bouguet算法進行雙目立體校正;然后,利用AdaBoost迭代算法訓練目標檢測器實現目標檢測.將CAEW算法與常用的尺度不變性的特征點檢測和匹配(SURF)的效果評估進行比較分析,結果顯示CAEW算法的效果評估能達到90%以上,這一指標有明顯提高,可以很好地滿足雙目實時目標匹配的需求.通過CAEW與SURF算法實驗對比,進一步說明了減少不必要的全局性圖像像素點處理可以提高匹配速度.

雙目立體視覺;特征點匹配;三維測距

1 引 言

雙目立體視覺的目標測距技術由于其在實施測量方法過程中具有效率高、精度合適、系統結構簡單、成本低等優點而被廣泛研究與應用.它是基于視差原理,利用成像設備從不同的位置獲取被測物體的兩幅圖像,通過各種匹配算法來確定兩幅圖像對應點間的位置偏差,進而求取物體三維幾何信息的方法.其中,匹配算法是實現雙目立體視覺測距技術的關鍵[1-3].此類算法大致可分為基于區域的立體匹配算法、基于特征的立體匹配算法和基于相位的立體匹配算法三大類.但這三類方法常常是因為計算量大、操作過于復雜等問題致使實時效果較差.事實上,只需要對目標小區域內操作來確定目標匹配點就可以計算目標三維信息進而達到較好的實時效果,因此,本文提出一種在視圖窗口內進行目標點匹配的方法,若誤差最小即可認為是一對強匹配點.

2 攝像機成像原理

2.1攝像機模型

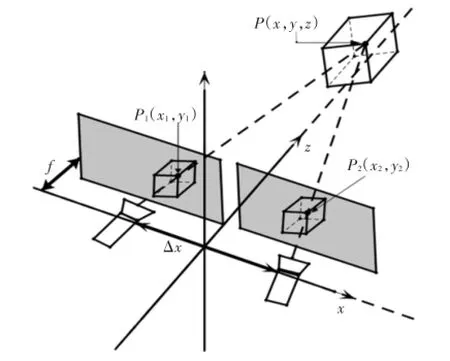

通常把由兩個光軸平行且內部參數一致的相機組成的雙目視覺模型稱之為標準雙目視覺模型[4],如圖1所示.

圖1 標準雙目立體視覺模型Fig.1 Model of standard binocular stereovision

圖1展示了空間實物點P(x,y,z)在兩個透視平面上的投影點為P1(x1,y1)和P2(x2,y2).由相似三角形得如下基本公式:

透視平面中的圖像平面坐標y1=y2=Y,由空間坐標與攝像頭成像原理得空間任意點P(x,y,z)坐標公式:

其中:d為兩攝像頭視差[5];f為焦距;z為空間距離;Δx是兩攝像頭的光心距.

標準雙目視覺模型中只要知道攝像機的內部參數及光心距,根據左右攝像機的視差就可以計算出空間任意點的坐標.

2.2圖像坐標系和世界坐標系與攝像機坐標系

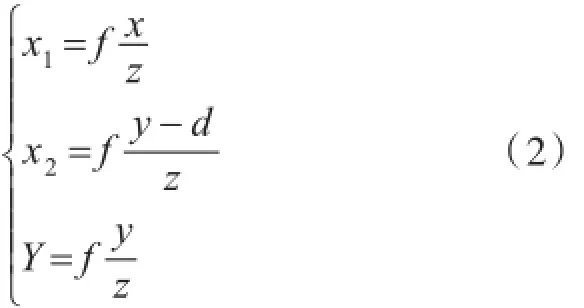

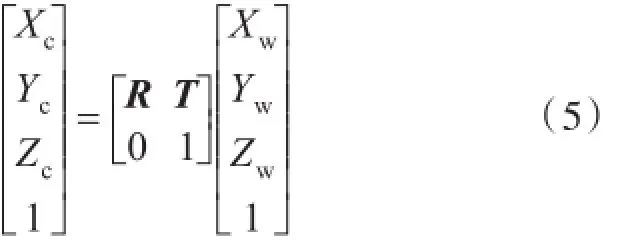

在二維平面圖像上定義直角坐標系uov,坐標(u,v)代表該圖像在數組中的行數與列數[6].坐標(u,v)是以像數為基本單位,這里需要再定義一個圖像坐標系xo′y,如圖2所示,o′是圖像坐標系的原點.

圖2 圖像坐標系Fig.2 Coordinate system of image

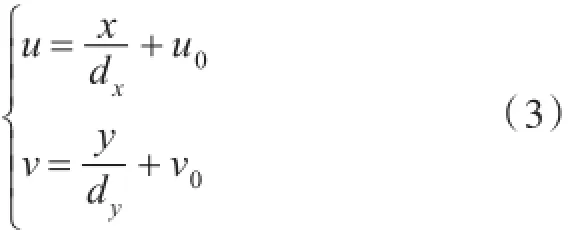

假設二維平面圖像坐標(u,v)的每一個像素在x和y方向的尺寸大小分別為dx和dy,則與圖像坐標建立的關系為:

用齊次坐標的矩陣方式表示式(3),以便后邊的推導.

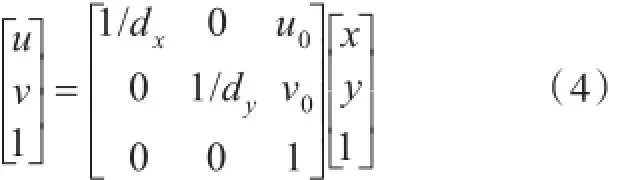

攝像機幾何成像原理圖如圖3所示,o是攝像機光心,oo′的距離是焦距f,Zc是光軸,與圖像平面垂直.點P(Xc,Yc,Zc)是攝像機坐標外一點,P′是P在圖像坐標上的投影.

圖3 攝像機幾何成像Fig.3 Geometric imaging of camera

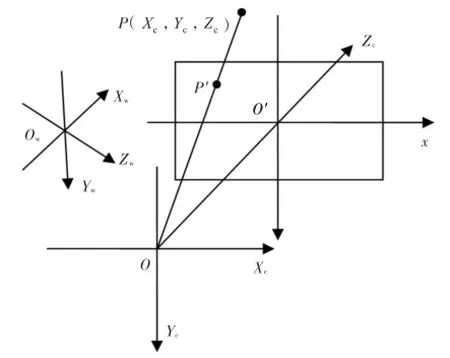

攝像機的擺放位置沒有固定,可以隨意扭曲.這里必須需要選取一個基準坐標系來描述攝像機的相對位置,進而可以描述環境中的任何物體的位置,該坐標系稱為世界坐標系.它由Xw,Yw,Zw軸組成.攝像機坐標系與世界坐標系之間的關系可以用旋轉矩陣R與平移向量T來描述[7].用攝像機齊次坐標(Xc,Yc,Zc)T與世界坐標的齊次坐標(Xc,Yc,Zc,1)T建立如下關系:

圖3中的P點通過圖像坐標時認為是針孔原理,所以在空間中的任何一點P與光心的連線在圖像坐標系xo′y平面上的交點即是空間點在圖像坐標上的投影點.圖像坐標系上的投影點稱為透視投影點.根據圖2和圖3幾何線性關系,存在如下比例式:

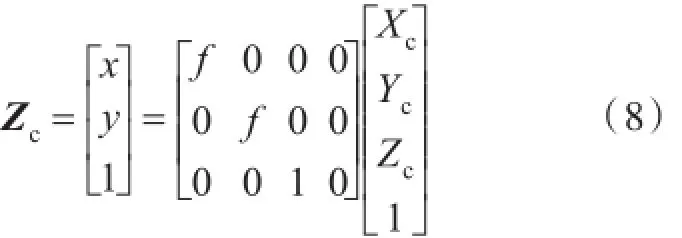

將式(6)和式(7)用齊次坐標與矩陣表示為:

將式(5)代入式(8)后再代入式(4)可以得到攝像機坐標(Xc,Yc,Zc)與二維平面圖像坐標(u,v)之間的對應關系:

3 攝像機標定

攝像機標定是為了獲取相機參數,保證攝像機參數的精度可以進一步提高三維測量[8].

3.1張氏標定法

張氏標定法是張正友經典的平面標定方法,該方法大體分為三個步驟.

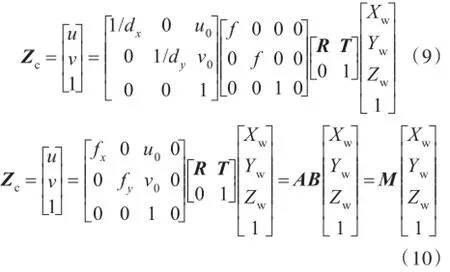

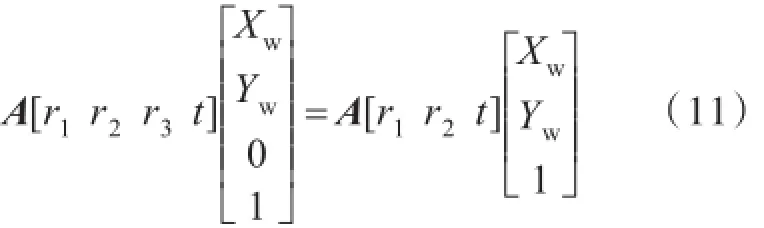

步驟一:求取攝像機單應性矩陣.公式(10)變形為:

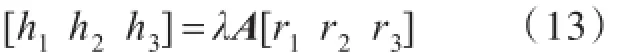

令 H=A[r1r2t],H=[h1h2h3]即為單應性矩陣.

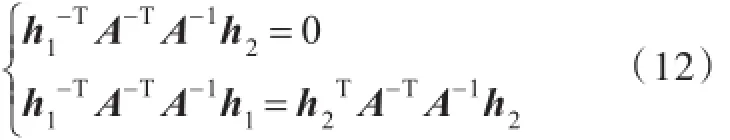

步驟二:求取攝像機內參數.求取方法是利用兩個約束條件,分別是r1r2=0和||r1=||r2=1.最終可以化解為單應性矩陣和內參數之間的關系:

顯然,當已知足夠多的單應性矩陣時,內參數矩陣A里的未知數就可以被求解.

步驟三:從上面求出來的單應性矩陣和內參數矩陣自然就可以求解出攝像機外參數:

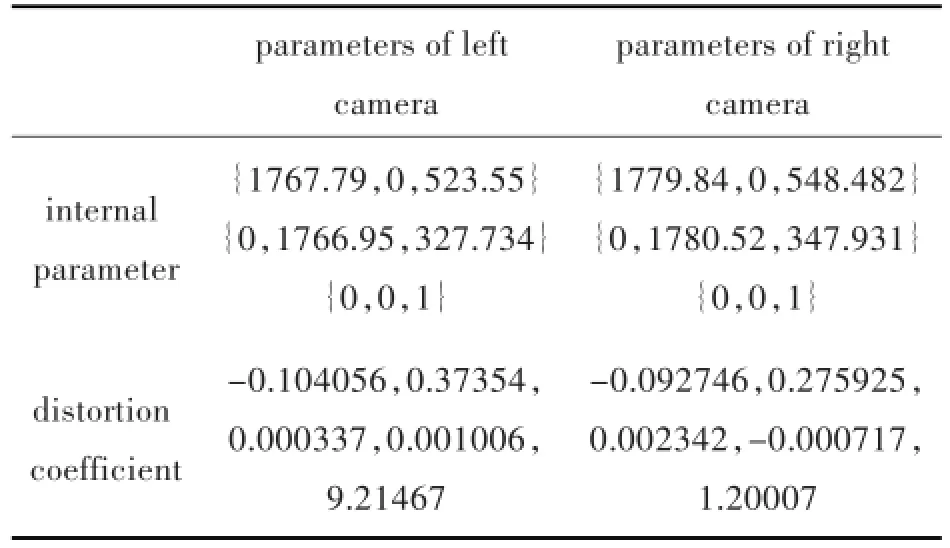

3.2攝像機標定實驗

本實驗環境是在WindowsXP操作系統下的visual studio 2010開發工具,所用攝像機規格是逐行掃描彩色CCD傳感器,分辨率為1 024×768,像素尺寸為4.65 μm×4.65 μm.標定板所使用其中的角點數是9×6,方格大小為30 mm×30 mm的棋盤格,如圖4所示.

圖4 棋盤格標定板Fig.4 Calibration board of Checkerboard

采集左、右攝像機標定板圖像9對,并分別對其執行單目標定,標定后得到攝像機參數,如表1所示.3.3立體校正

表1 左右攝像機參數Tab.1 Parameters of left and right cameras

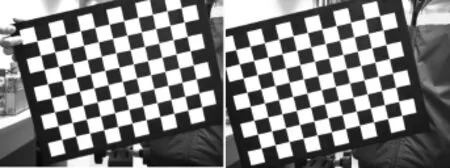

標準雙目視覺模型的左、右圖像按攝像機水平光軸嚴格對準.嚴格前向平行對準在實際情況下是不存在的,圖5為實際中未校正圖像,但是可以通過數學方法計算重投影圖像來達到理想視覺模型.于是采用Bouguet算法[9]對雙目視覺進行立體校正.

圖5 校正前的圖像Fig.5 Image before correction

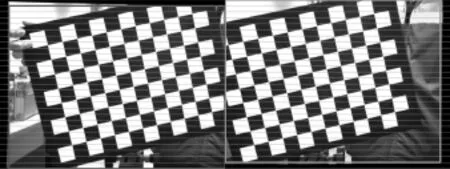

經過Bouguet算法立體校正后可以獲得重投影數據和重投影矩陣.利用重投影數據就可以重新對采集的圖像進行像數點重排列,從而達到前向平行對準,如圖6所示.在獲得重投影矩陣以及一對匹配點后即可計算三維坐標.

圖6 校正后的圖像Fig.6 Image after correction

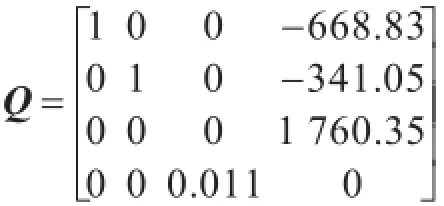

其中,(x,y)是左圖像上的某一點,d是視差.三維坐標是(X/w,Y/w,Z/w).立體校正之后得到的重投影矩陣Q數據:

4 目標檢測

采用一種Adaboost的迭代算法[10-11]來實現目標檢測.Adaboost算法是針對同一個訓練集訓練不同的分類器(弱分類器),然后把這些弱分類器集合起來,構成一個更強的最終分類器(強分類器).其算法本身是通過改變數據分布來實現的,它根據每次訓練集之中每個樣本的分類是否正確,以及上次的總體分類的準確率,來確定每個樣本的權值.將修改過權值的新數據集送給下層分類器進行訓練,最后將每次訓練得到的分類器融合起來,作為最后的決策分類器.使用Adaboost分類器可以排除一些不必要的訓練數據特征,并將特征點放在關鍵的訓練數據上面.Adaboost目標檢測效果好、速度快、魯棒性好,適合對實時性要求較高的場合應用.

4.1Adaboost算法流程

給定一個訓練數據集T={(x1,y1),(x2,y2)…(xN,yN)},其中實例x?χ,而實例空間x?Rn,yi屬于標記集合{-1,+1},Adaboost的目的就是從訓練數據中學習一系列弱分類器或基本分類器,然后將這些弱分類器組合成一個強分類器.

Adaboost的算法流程如下:

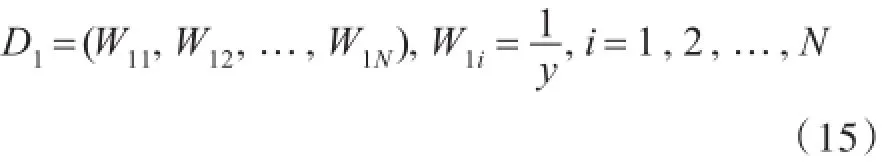

步驟一:首先,初始化訓練數據的權值分布.每一個訓練樣本最開始時都被賦予相同的權重為.

步驟二:進行多輪迭代,用m=1,2,…,m表示迭代的第多少輪.

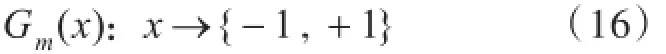

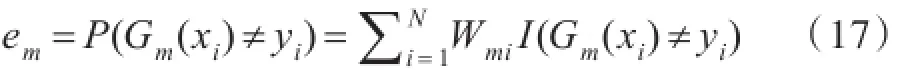

1)使用具有權值分布Dm的訓練數據集學習,得到基本分類器:

2)計算Gm(x)在訓練數據集上的分類誤差率

由式(16)~(17)可知,Gm(x)在訓練數據集上的誤差率em就是被Gm(x)誤分類樣本的權值之和.

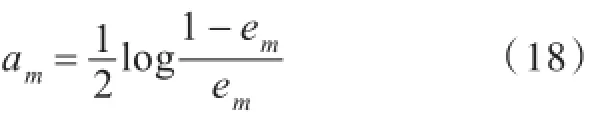

3)計算Gm(x)的系數,am表示Gm(x)在最終分類器中的重要程度(目的:得到基本分類器在最終分類器中所占的權重):

由式(18)可知,em<=時,am>=0,且 am隨著em的減小而增大,意味著分類誤差率越小的基本分類器在最終分類器中的作用越大.

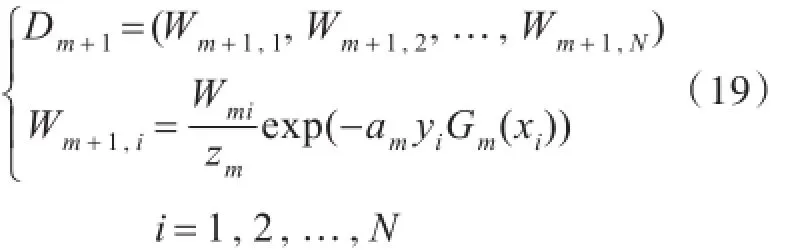

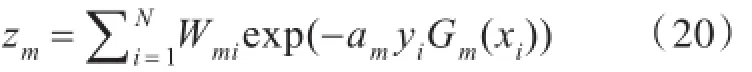

4)更新訓練數據集的權值分布(目的:得到樣本的新的權值分布),用于下一輪迭代:

使得被基本分類器Gm(x)誤分類樣本的權值增大,而被正確分類樣本的權值減小.通過這樣的方式,Adaboost方法能聚焦于那些較難分的樣本上.

其中,zm是規范化因子,使得Dm+1成為一個概率分布:

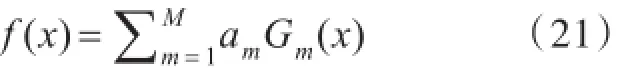

步驟三:組合各個弱分類器

從而得到最終分類器,如下:

4.2訓練行人檢測器

訓練檢測器分為3個步驟:a)樣本的創建;b)訓練分類器;c)利用訓練好的分類器進行目標檢測.

訓練樣本分為正例樣本和反例樣本,其中正例樣本是指待檢目標樣本(本實驗是行人),一個樣本可以包含多個待檢目標,所有的樣本圖片都被歸一化為同樣的尺寸大小(本實驗為18×44).將所有正樣本存放在一個文件里,文件的每一行包含樣本文件名、待檢目標個數、待檢目標位置以及樣本尺寸.

負樣本可以來自于任意的圖片,但這些圖片不能包含目標特征.負樣本由背景描述文件來描述.背景描述文件是一個文本文件,每一行包含了一個負樣本圖片的文件名(描述文件的相對路徑),該文件可通過手工創建.

訓練分類器得到的檢測器是一個xml文件,文件是區別于負樣本的特征集,該特征集由不同級別構成,級別越高表示檢測器越好.將訓練好的檢測器應用于真實的環境場景,可以進行實時目標檢測,檢測結果如圖7所示,使用一個方框來表示檢測出目標.

圖7 檢測器檢測目標Fig.7 Detected target by detector

5 目標三維測量系統實現

5.1CAEW算法原理

CAEW(Calculate the Absolute Error Window)算法是基于窗口小領域內的數據操作,該算法是在左右視圖重投影后為如何達到絕對強匹配點對而采取的一種策略.執行算法步驟分三步:確立目標點、計算匹配點誤差和選擇匹配點.

5.1.1確立目標點目標點的確立是指程序在執行時能夠自動選取目標上的某一點,而這一點正是要作為被匹配點.被匹配點的選取是否合適將很大程度影響到匹配點是否可靠.

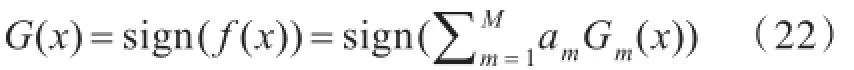

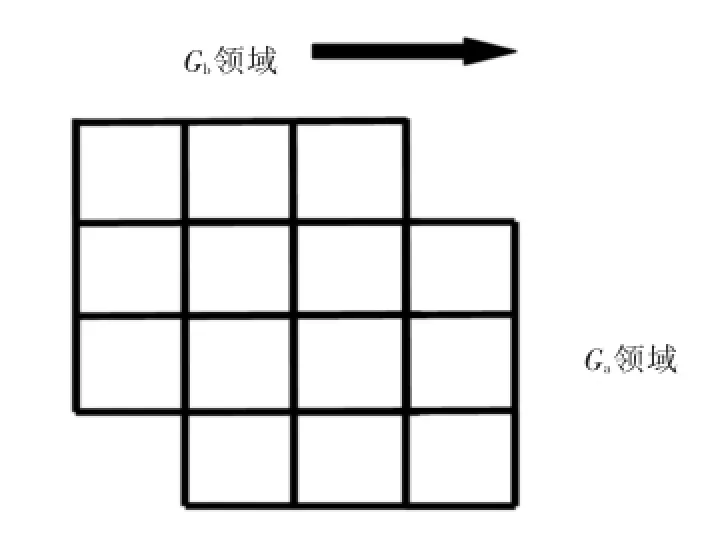

圖8顯示Ga、Gb兩個領域,Ga領域表示檢測器識別目標后的目標中點的3×3領域大小,Gb領域表示要對Ga領域內進行逐個值操作,每一次操作都如圖9所示而進行函數匹配,也就是在允許的最大視差范圍內計算匹配點對的誤差.最大視差可由用戶設定,它避免了圖像整行掃描操作,提高了匹配速度.

圖8 確定目標點Fig.8 Determined destination point

圖9 匹配原理Fig.9 Matching principle

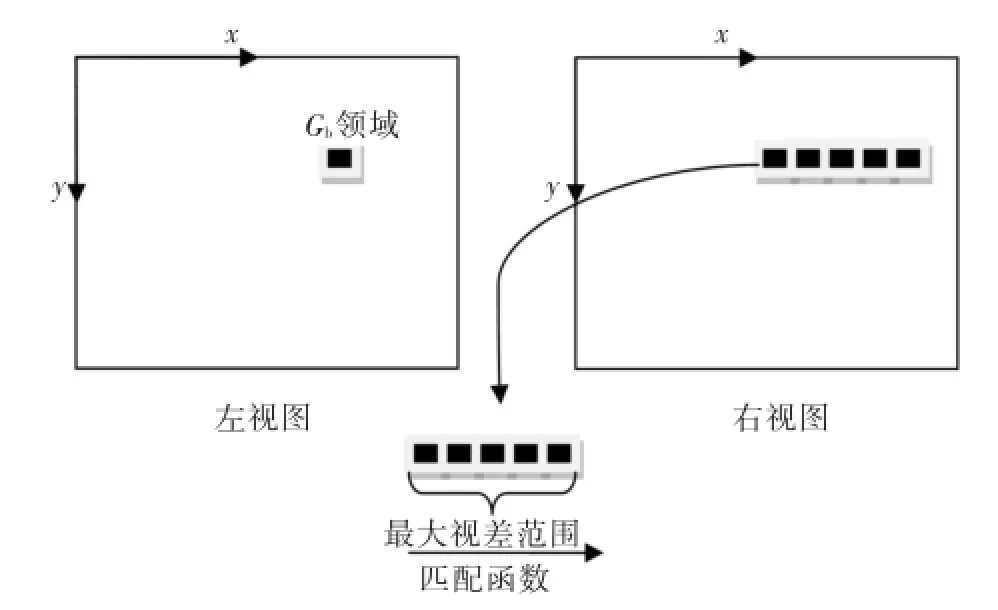

5.1.2計算匹配點誤差計算匹配點誤差前需要構建誤差函數,CAEW算法服從如下公式:

式(23)可化簡為

式(23)~(24)中,e′是誤差值,值越小表示左右視圖的Gb領域匹配效果越好;ρ是相關系數;e表示Gb領域內左右視圖對應點灰度值的誤差累加.

Ga領域內的每一個點都會有對應的一個最終誤差值,在進行計算匹配點誤差的同時也會記錄極小誤差值的目標點的位置,用于選擇匹配點.若為了能讓匹配點的誤差值最小化或能達到小于預期誤差值,可以進行對Ga領域擴展增大.但要注意控制好Ga領域大小,因為Ga領域越大,匹配速度越慢,而且過大的Ga領域會使匹配點偏離目標點.

5.1.3選擇匹配點先對Gb領域進行自適應中值濾波[12]操作,這樣做既可以降噪也可以減少圖像失真,之后就可以實施圖8的操作.當Ga領域都經過Gb領域方法的操作后可以得到最小的誤差匹配點,這一點即默認為強匹配點,用于三維測量.

5.2CAEW和SURF算法實驗

SURF(Speeded-Up Robust Feature)算法與SIFT(Scale-invariant feature transform)算法是兩個經典匹配算法,文獻[13]通過實驗對比了它們各自的優缺點,并確定了SURF算法更能滿足實時性要求.

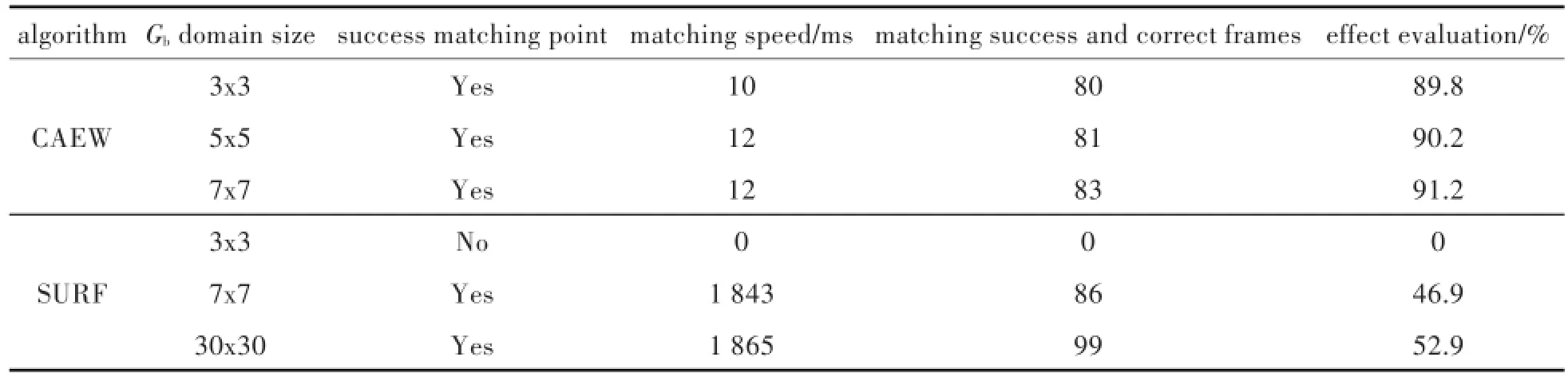

與攝像機標定同一實驗環境下采集場景視頻序列,然后分別用CAEW算法和SURF算法進行目標匹配與三維測量(如圖10所示),如此統計前后共100幀的實驗結果數據如表2所示.其中,效果評估由匹配速度和匹配成功且正確幀數決定,計算公式如下:

圖10 目標三維測量結果Fig.10 Three-dimensional measurement results of target

表2 CAEW算法與SURF算法實驗結果比較Tab.2 Comparison of experimental results between CAEW algorithm and SURF algorithm

在進行CAEW算法和SURF算法匹配前需要先經過圖像重投影及檢測器檢測目標,而重投影耗時約35 ms,檢測目標耗時約2 ms.實驗結果顯示:CAEW算法的速度遠快于SURF算法,而且Gb領域窗口較小時也可以找到匹配點,但在匹配正確率上差于SURF算法.

因為SURF算法是針對于圖像全局操作,而CAEW算法是圖像局部操作,這樣的區別使CAEW算法匹配速度更快,實驗數據結果上已經充分體現它的優勢.實驗說明了CAEW算法能夠應用于實時目標的三維測量當中,具有較強的擴展性與實用性.

5.3雙目實時測距系統

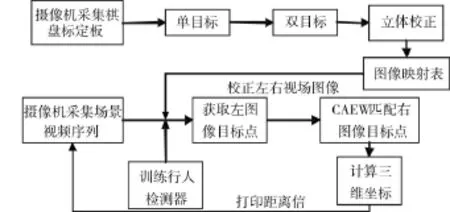

經過前面的討論與實驗,將設計出的具體實施方案如圖11所示.

1)獲取映射表與重投影矩陣

系統標定步驟:先進行單目標定得到攝像機內部參數,然后用得到的兩臺攝像機內部參數,再用攝像機內部參數進行雙目標定重投影標定棋盤得到映射表.

2)訓練行人檢測器

調用OpenCV函數訓練Haar特征,不斷訓練提高檢測器的檢測效果,采集場景視頻驗證之.

3)獲取CAEW特征匹配點

設定Gb領域窗口大小和最大可能視差值,用誤差公式計算得到強匹配點.

4)計算三維坐標

確定目標匹配點后利用投影矩陣計算其三維坐標,對比人為實測距離目標.調試程序改進.

圖11 實時雙目測距系統流程圖Fig.11 Flowchart of real-time binocular distance measurement system

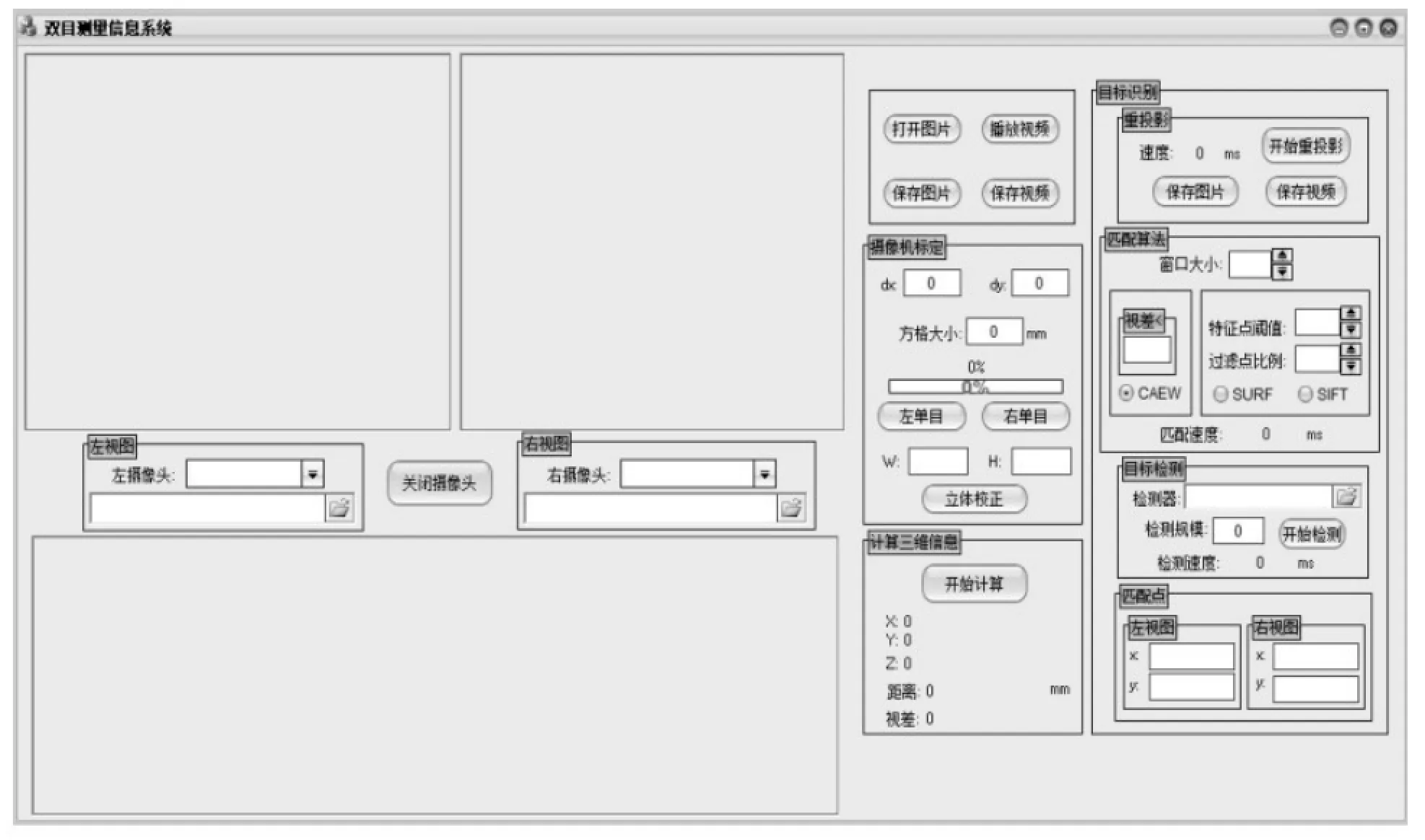

圖12 軟件界面Fig.12 Software interface

6 結語

以上針對雙目立體視覺的目標三維信息測量研究中經常要解決的目標匹配困難、匹配效率低的現狀,提出了一種新算法CAEW來解決上述問題.其中,對匹配點的選取是基于窗口領域內的信息誤差最小化,實驗結果說明了它能夠快速匹配目標點,對比SURF算法的全局圖像處理,CAEW算法的匹配速度有明顯優勢.從這一點說明,如果想要提高匹配速度,就需要盡量避免全局圖像的處理或減少不必要的圖像區域操作.

[1]李強,張鈸.一種基于圖像灰度的快速匹配算法[J].軟件學報,2006,17(2):216-222.

LI Q,ZHANG B.A fast matching algorithm based on image gray level[J].Journal of software,2006,17(2):216-222.

[2] 羅希平,田捷.自動指紋識別中的圖像增強和細節匹配算法[J].軟件學報,2002,13(5):946-956.

LUO X P,TIAN J.Image enhancement and minutia matching algorithms in automatic fingerprint identification system[J].Journal of software,2002,13(5):946-956.

[3] 王宏力,賈萬波.圖像匹配算法研究綜述[J].計算機技術與應用,2008(6):17-19.

WANG H L,JIA W B.Survey of Research on Image Matching Algorithm[J].Advances in computer technology and Applications,2008(6):418-423.

[4]張艷珍,歐宗瑛.一種新的攝像機線性標定方法[J].中國圖象圖形學報,2001,6(8):727-731.

ZHANG Y Z,OU Z Y.A new camera linear approach for camera calibration[J].Journal of image and graphics,2001,6(8):727-731.

[5] TAO J,HONG Z J,WEN M H,et al.Evaluating 3D position and velocity of subject in parabolic flight experiment by use of the binocular stereo vision measurement [J].Chinese optics letters,2010,8(6):601-605.

[6] 馬頌德,張正友.計算機理論與算法基礎[M].北京:科學出版社,1998.

[7] 劉金頌,原思聰,張慶陽.雙目立體視覺中的攝像機標定技術研究[J].計算機工程與應用,2008,44(6):237-239.

LIU J S,YUAN S C,ZHANG Q Y.Research on camera calibration in binocular stereo vision[J].Computer engineering&application,2008,44(6):237-239.

[8] 楊明,王海暉,陳君,等.雙目標定系統精度提高的方法[J].武漢工程大學學報,2012,34(1):69-73.

YANG M,WANG H H,CHEN J,et al.Method of accuracy improvement based on binocular calibration system [J].Journal of Wuhan institute of technology,2012,34 (1):69-73.

[9] 徐磊.攝像機標定算法研究[D].西安:西安電子科技大學,2011.

[10]朱誼強,張洪才,程詠梅,等.基于Adaboost算法的實時行人檢測系統[D].西安:西北工業大學,2006.

[11]劉洋,王海暉,向云露,等.基于改進的Adaboost算法和幀差法的車輛檢測方法[J].華中科技大學學報(自然科學版),2013,41(z1):379-382.

LIU Y,WANG H H,XIANG Y L,et al.Vehicle detection method based on improved adaboost algorithm and frame difference method[J].Journal of huazhong university of science and technology(Natural science edition),2013,41(z1):379-382.

[12]岡薩雷斯.數字圖像處理的MATLAB實現[M].北京:清華大學出版社,2013.

[13]高如新,王俊孟.基于雙目視覺的目標識別與定位[J].河南理工大學學報(自然科學版),2014,33(4):495-500.

GAO R X,WANG J M.Target recognition and localization based on binocular vision[J].Journal of Henan polytechnic university(natural science edition),2014,33(4):495-500.

本文編輯:陳小平

Realization Method of Three Dimensional Measurement of Real-Time Target of Binocular Stereo Vision

XIAO Yongqiang1,WANG Haihui1,2*,LIU Aoli1,WANG Ziwei1,ZHANG Liubin1

1.School of Computer Science&Technology,Wuhan Institute of Technology,Wuhan 430205,China;

2.Hubei Key Laboratory of Intelligent Robot(Wuhan Institute of Technology),Wuhan 430205,China

To improve efficiency of the target-matching,a matching algorithm based on real-time target characteristics of binocular stereo vision,namely absolute window error minimization(CAEW)was presented.Firstly,the camera calibration was realized by the Zhang's calibration method based on the basic principle of camera,and the final data of binocular stereo calibration was tested by Bouguet algorithm.Then,the target detector was trained by AdaBoost iterative algorithm for better target detection.The evaluated effects of CAEW algorithm was compared with that of the commonly Speeded-up Robust Feature(SURF)algorithm,and the results show that the evaluated effects of CAEW algorithm achieve more than 90%,which is significantly improved,and can meet the requirement of the application of binocular real-time target matching.By comparing with the experimental results of SURF and CAEW algorithm,it demonstrates that the reduction of unnecessary operation can improve the matching speed.

binocular stereo vision;feature point matching;3D distance measurement

王海暉,博士,教授.E-mail:wanghaihui69@sina.com

TP242.6

A

10.3969/j.issn.1674-2869.2016.04.014

1674-2869(2016)04-0386-08

2016-04-10

武漢工程大學大學生校長基金項目(2015047);湖北高校2015年省級大學生創新創業訓練計劃項目(201510490021)

肖永強,本科生.E-mail:1849122014@qq.com