情感語音的非線性動力學特征

姚 慧,孫 穎,張雪英

(太原理工大學信息工程學院,山西太原 030024)

情感語音的非線性動力學特征

姚 慧,孫 穎,張雪英

(太原理工大學信息工程學院,山西太原 030024)

基于語音發聲過程中的混沌特性,提出了非線性動力學模型與情感語音信號處理相結合的方法.提取了該模型下情感語音的非線性特征:最小延遲時間、關聯維數、Kolmogorov熵、最大Lyapunov指數和Hurst指數.設計情感語音識別對比實驗以驗證非線性特征性能.首先,選用德國柏林語音庫和自主錄制的TYUT2.0情感語音數據庫中的3種情感(高興、悲傷和憤怒)作為實驗數據來源;其次,分別提取非線性特征、韻律特征和梅爾頻率倒譜系數特征,采用支持向量機進行了情感識別.結果表明,非線性特征在柏林數據庫實驗中的識別率高于韻律特征識別率,但是略低于梅爾頻率倒譜系數特征識別率,驗證了非線性特征是一組區分情感的有效特征;在TYUT2.0數據庫中的識別率均高于韻律特征和梅爾頻率倒譜系數特征的識別率,在語料真實度和自然度更高的TYUT2.0數據庫中識別結果相對更高,魯棒性更好.

情感語音識別;混沌特性;非線性特征;動力學模型

情感語音識別是建立在對語音信號的產生機制進行深入研究和分析的基礎上,提取采集到的語音信號中表達情感的特征參數,并利用這些參數進行相應的建模和識別,從而確定語音情感狀態的技術[1].其中,情感特征提取是情感語音識別的關鍵問題之一.目前,提取的有效情感特征參數主要集中于聲學特征[1],這些特征大多是基于語音信號具有短時平穩特性進行線性處理得到的.而事實上,已有理論研究證明語音信號的產生是一個復雜的非線性過程[2].混沌理論是非線性動力學理論的一個分支,被廣泛應用到語音信號處理中[3-6].文獻[3-4]的作者多年致力于研究自然語音中的混沌特性并將其應用于檢測阿爾茨海默病,通過提取自然語音中的分形維數特征來檢測說話人是否發聲病變;文獻[5]將語音的混沌特性與其他常用特征進行多特征融合,從司機的應答語音中提取特征用來檢測司機是否疲勞駕駛.雖然學者對語音信號的混沌特性進行了多方面的研究,但是對情感語音方面的研究還不多見.

筆者針對語音發聲過程中表現出的混沌特性與情感關聯性加以研究,對情感語音信號進行分析處理,并提取基于語音混沌特性的5種非線性特征:最小延遲時間、關聯維數、Klmogorov熵、最大Lyapunov指數和Hurst指數.選用TYUT2.0數據庫和柏林語音庫兩類數據庫中的情感語句,通過對非線性特征、韻律特征和梅爾頻率倒譜系數(Mel-Frequency Cepstral Coefficients,MFCC)特征在情感語音識別實驗的結果對比,驗證了非線性特征是區分情感的有效特征.

1 混沌理論及非線性特征

相空間重構是TAKENS提出的一種非線性分析方法.TAKENS定理[7]指出:選取合適的延遲時間τ和嵌入維數m,就可以將一維時間序列從低維空間映射到高維空間,并且重構的高維空間和原始空間等價.根據上述定理,將情感語音信號與非線性動力學模型相結合的過程為:對一維情感語音信號[x(1),x(2),…,x(N)],選擇合適的最小延遲時間τ和嵌入維數m兩個參數,將其映射到高維空間進行重構,得到語音信號Xi=[x(i),x(i+1),…,x(i+(m-1)×τ)],i=1,2,…,M,其中M=N-(m-1)τ,為語音總相點個數,而實現將情感語音信號與非線性動力學模型相結合[8].在高維空間里分析語音信號,可以提取情感語音動力學模型的非線性特征參數,獲取代表情感差異度的非線性特征.筆者選取了5種非線性特征,分別介紹如下.

1.1最小延遲時間

已知語音信號[x(1),x(2),…,x(N)],利用互信息函數求解不同時間間隔時對應的語音信號x(i)與x(j)互信息量.當互信息量達到最小時,兩個變量之間的相關性最小,此時對應的時間間隔即為最小延遲時間τ.筆者選擇平均互信息法(Mutual Information,MI)[9]計算最小延遲時間τ:

其中,pi和pj分別表述序列幅值分別落在第i和第j段內的概率,pi,j表示間隔時間為τ的序列前后兩點幅值分別同時落在第i和第j段內的聯合概率.得到的互信息函數I(τ)曲線上第1個局部最小值所對應的時刻即為最小延遲時間,它量化了兩個離散變量之間的無序性.

1.2關聯維數

關聯維數是混沌動力學的一種非線性表征量,用來描述高維空間語音動力學模型系統自相似結構,對結構的復雜度可以給出定量的比較.系統結構越復雜,對應的關聯維數越大.筆者使用G-P算法計算關聯維數.G-P算法[10]是Grassberger和Procaccia提出的計算關聯維數的方法:

其中,D(m)為關聯維數;C(r,m)為關聯積分函數,定義為

C(r,m)表示m維重構空間中任意(Xi,Xj)之間的距離小于r的相點對占所有相點對之比.式(3)中m取最小嵌入維數后得到相對應的ln C(r,m)→ln r曲線,通過對該曲線局部直線擬合即可得到關聯維數.

1.3Kolmogorov熵

Kolmogorov熵(縮寫為K熵)是精確地描述時間序列分布概率混亂程度的物理量.Grassberger和Procaccia提出計算關聯維數方法的同時,論證了可以用K2熵逼近K熵的思想來求得K熵.K2熵與關聯積分函數C(r,m)存在的關系為

由式(4)計算得到的K2熵就是Kolmogorov熵.

1.4最大Lyapunov指數

Lyapunov指數反映了相空間中相鄰軌道的局部收斂或者發散的平均變化率.而最大Lyapunov指數(Largest Lyapunov Exponent,LLE)λ1表示軌道收斂或者發散的快慢程度.當λ1>0時,λ1值越大,表示軌道發散的速率也越大,且混沌程度也越大.筆者采用Wolf方法[11]求得最大Lyapunov指數.取相空間中初始點Xi,并尋找其最近鄰點Xi′,距離為L0.追蹤n時刻,后兩點之間的距離Li滿足設定值ε,則保留此點.開始下一時刻的追蹤.當追蹤疊加M次后,就能得到最大Lyapunov指數,即

該方法相較于其他算法,具有計算快、對嵌入維m、延遲時間τ和噪聲都有很好的魯棒性等特點.

1.5Hurst指數

Hurst指數(縮寫為H)衡量了時間序列的長期記憶性.H值的范圍為0~1.如果H>0.5,則表示時間序列具有長期自相關性,時間序列前后關聯性較大.筆者使用重標極差分析方法[12]計算H值.重標極差法分析是一種非參數統計方法,不受時間序列分布的影響.該方法是將一維情感語音信號[x(1),x(2),…,x(N)]分成M個長度相同的相鄰子序列u,計算每個子序列的累積離差zu與標準差Su.計算每個子序列的重標極差Ru/Su,其中Ru=max zu-min zu,得到Hurst指數.計算方法為

其中,b為常數.通過對式(6)兩邊取對數,求得H為Hurst指數.當語音信號的情感狀態不同時,H變化規律也不相同.提取情感語音的Hurst指數特征可以體現情感變化的前后關聯性高低.

2 情感語音數據庫

情感語音數據庫是進行情感語音分析和情感識別的前提條件,為情感識別提供訓練及測試語音數據.為了客觀全面地評價所研究的基于語音混沌特性的非線性特征的性能,同時考慮不同語種對于情感特征識別結果的影響,選用TYUT2.0語音數據庫和柏林語音庫作為實驗所用數據庫.

2.1TYUT2.0數據庫

TYUT2.0情感語音數據庫采用截取廣播劇的手段獲取語音,建立包括高興、驚奇、悲傷和憤怒4種情感類別的數據庫,包含語音678句,采樣率為16 k Hz.廣播劇來源于專業演員,有豐富的人物和素材,貼近生活,語言表達符合日常習慣且語音純凈度高.

2.2柏林語音庫

德國柏林語音庫(EMO-DB)[13]是由10位演員(5男5女)對7種情感(中性、生氣、害怕、高興、悲傷、厭惡、無聊)進行模擬得到的,包含800句語料,采樣率為16 k Hz.該數據庫的語料來源豐富、表述自然.語音錄制要求演員通過回憶自身經歷來完成情緒的表達,使得語音情感真實度高.

3 實 驗

為了驗證基于語音混沌特性的非線性特征的有效性,設計了一組實驗.選用TYUT2.0數據庫和柏林語音庫兩類數據庫中的情感語句,提取非線性特征、韻律特征和MFCC特征,并分別在單一的語音數據庫進行實驗.通過3組特征的識別結果對比,驗證非線性特征的有效性.

3.1情感語音數據庫處理

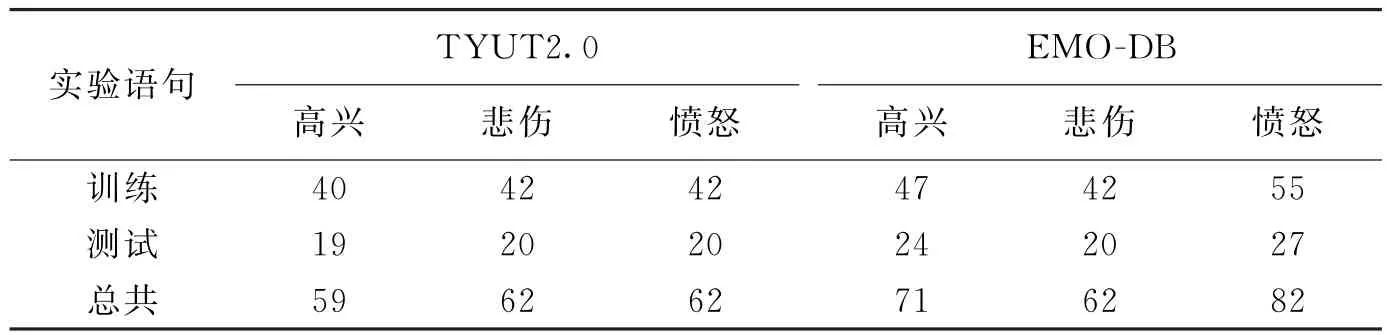

對情感語音識別跨數據庫的實驗,要求訓練和測試所包含的情緒類別一致.由于柏林語音庫中包含7種情感,而TYUT2.0數據庫中只有4種情感,因此,筆者只選用了高興、悲傷和憤怒情感語音作為實驗數據.此外,為了規避時長不同造成的影響,基于語音時長近似相同的原則,對上述兩類數據庫語句進一步地剔除.最后得到183句TYUT2.0語音數據庫語句和215句柏林語音庫語句,用于測試和訓練語句,如表1所示.

表1 情感語音實驗語句

3.2情感語音預處理

提取特征參數時,首先對語句進行預處理.預處理主要包括端點檢測、預加重和加窗分幀處理.端點檢測采用基于過零率和能量雙門限的方法,預加重系數?取0.97.加窗分幀處理時采用hamming窗并設置幀長N=256,幀移為128.

3.3特征提取

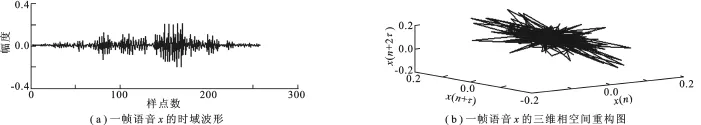

語音信號經過預處理之后,依次提取最小延遲時間、關聯維數、Kolmogorov熵、LLE和Hurst指數這5種非線性特征、韻律特征[1]和MFCC特征[1].提取非線性特征時,首先利用Taken’s的相空間重構法通過互信息法和鄰接誤差法分別得到每一幀語音信號的最小延遲時間τ和嵌入維數m兩個參數;然后在重構模型下依次提取5種非線性特征.圖1為一幀語音信號相空間重構結構圖.通過計算得到該幀語音信號的嵌入維數為3,最小時間延遲為4.從圖中可以看出,一維語音信號通過相空間重構后被映射到了三維空間,擴展成為三維結構.此外,筆者提取了語速、過零率、能量、基頻、共振峰這5種韻律特征和MFCC特征.

圖1 一幀語音相空間重構(τ=4,m=3)

3.4構造特征向量

特征向量構造主要有兩種形式:靜態全局統計特征和動態短時特征.由于動態短時特征對文本信息較為依賴[14],因此本實驗選取靜態全局統計特征用于實驗.識別網絡選用支持向量機(Support Vector Machine,SVM).構造特征向量時,首先提取上述特征及其相應的一階差分,然后對這些特征進行統計函數計算.統計函數包括:偏度(skewness)、峰度(kurtosis)、均值(mean)、方差(std)和中值(median).因此,非線性特征、韻律特征和MFCC特征各自構成的特征向量分別是50維、48維和60維.

4 實驗結果比較與分析

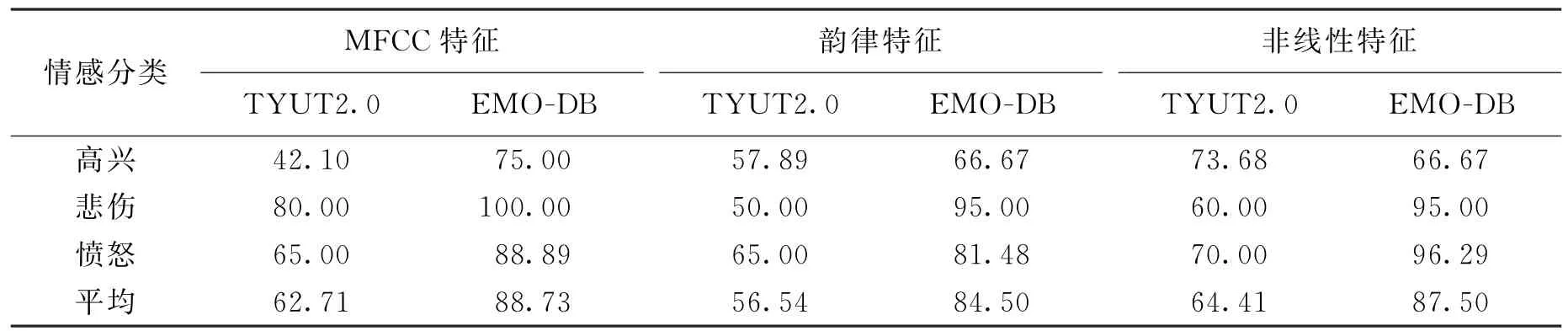

分別對TYUT2.0數據庫和柏林語音庫提取非線性特征、韻律特征和MFCC特征,使用支持向量機作為識別網絡.識別網絡支持向量機參數尋優采用十倍交叉驗證的方法.將測試樣本輸入訓練好的支持向量機得到識別結果.表2為3類特征的識別結果.

從表2可以得出:

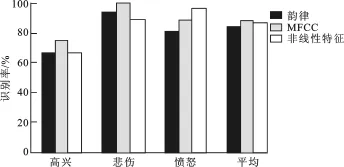

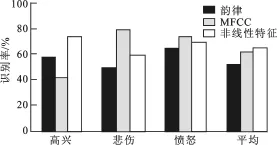

(1)針對柏林語音庫的情感語音識別,從整體的平均識別結果來看,非線性特征、韻律特征和MFCC特征在柏林語音庫中的平均識別率依次為87.5%、84.5%和88.73%.可以得出,非線性特征表現出的性能普遍優于韻律特征,平均識別率高出韻律特征3%.但是相較于MFCC特征,非線性特征識別結果略低,平均識別率比MFCC特征低0.8%.在“憤怒”情感識別中,非線性特征的識別結果反而高出MFCC.圖2更加直觀地描述了這3類特征在柏林數據庫中針對不同情感的識別結果.

表2 3類特征在單獨語音庫下的識別結果%

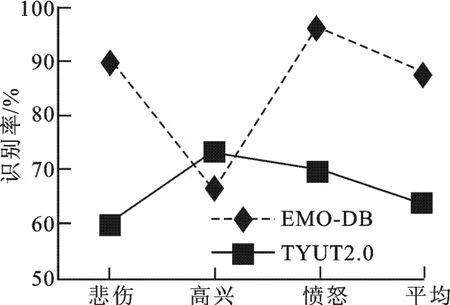

(2)針對TYUT2.0語音庫的情感語音識別,非線性特征表現出的優勢較為明顯.從平均識別結果來看,非線性特征的識別率均高出了韻律特征和MFCC的識別率.非線性特征的平均識別率為64.41%,分別高出MFCC特征的平均識別率1.7%和韻律特征的平均識別率8%,但是3類特征在TYUT2.0的識別率整體低于在柏林語音庫的識別率.這與數據庫建庫方式的不同有關系.柏林語音庫是基于表演錄制型語音庫,而TYUT2.0語音庫是以截取廣播劇的方式建立的,屬于摘引型數據庫.除此之外,柏林語音庫是定量人員的語音錄制,而TYUT2.0語音庫所截取的語音片段來自于不定量人員的表達.所以,TYUT2.0語音庫相比較而言情感真實度比表演型數據更高,表述方式更貼近現實生活中的語音.雖然兩類數據庫整體識別率有差距,但是3類特征在兩類數據庫上表現出的趨勢是大致相同的.圖3更加直觀地描述了3類特征在TYUT2.0數據庫中針對不同情感的識別結果.

圖2 3類特征在EMO-DB數據庫下識別結果比較

圖3 3類特征在TUYUT2.0數據庫下識別結果比較

圖4 非線性特征在兩類數據庫的結果對比

(3)圖4單獨描述了非線性特征在兩類數據庫下的實驗結果.在“高興”情感識別中,非線性特征在TYUT2.0數據庫中的識別結果高出柏林語音庫的識別結果.此外,在TYUT2.0數據庫中的3種情感識別的波動趨勢較柏林語音庫的趨勢更加平穩一些,說明非線性特征對實際語音的情感識別魯棒性較好.

綜上可得,非線性特征相較于韻律特征和MFCC特征具有一定的優勢,得到了較為理想的識別結果.因此,驗證了非線性特征是區分情感的有效特征.此外,非線性特征在TYUT2.0語音庫中表現出的優勢更明顯,說明該特征對情感語音識別具有更為實際的意義.

5 結束語

從語音發聲過程中的混沌特性出發,將非線性動力學模型與情感語音信號處理相結合,提出了該模型下的情感語音非線性特征.與常用的韻律特征和MFCC特征識別性能相比,非線性特征具有較好的識別率和可靠性.實驗結果說明,非線性特征更適合于語音真實度和自然度更好的應用環境.

[1]韓文靜,李海峰,阮華斌,等.語音情感識別研究進展綜述[J].軟件學報,2014,25(1):37-50.HAN Wenjing,LI Haifeng,RUAN Huabin,et al.Review on Speech Emotion Recognition[J].Journal of Software,2014,25(1):37-50.

[2]BANBROOK M,MCLAUGHLIN S,MANN I.Speech Characterization and Synthesis by Nonlinear Methods[J].IEEE Transactions on Speech and Audio Processing,1999,7(1):1-17.

[3]LóPEZ-DE-IPI?A K,SOLé-CASALS J,EGUIRAUN H,et al.Feature Selection for Spontaneous Speech Analysis to Aid in Alzheimer’s Disease Diagnosis:a Fractal Dimension Approach[J].Computer Speech and Language,2015,30 (1):43-60.

[4]LóPEZ-DE-IPI?A K,ALONSO-HERNáNDEZ J B,SOLé-CASALS J,et al.Feature Selection for Automatic Analysis of Emotional Response Based on Nonlinear Speech Modeling Suitable for Diagnosis of Alzheimer’s Disease[J]. Neurocomputing,2015,150:392-401.

[5]李響,譚南林.一種應用語音多特征檢測駕駛疲勞的方法[J].儀器儀表學報,2013,34(10):2231-2237. LI Xiang,TAN Nanlin.Method of Applying Speech Multi-features to Detect Driver Fatigue[J].Chinese Journal of Scientific Instrument,2013,34(10):2231-2237.

[6]GóMEZ-GARCíA J A,GODINO-LLORENTE J I,CASTELLANOS-DOMINGUEZ G.Non Uniform Embedding Based on Relevance Analysis with Reduced Computational Complexity:Application to the Detection of Pathologies from Biosignal Recording[J].Neurocomputing,2014,132:148-158.

[7]TAKENS F.Detecting Strange Attractors in Turbulence[M].Berlin:Springer,1981:366-381.

[8]HENRIQUEZ P,ALONSO J B,FERRER M A,et al.Application of Nonlinear Dynamics Characterization to Emotional Speech[C]//5th International Conference on Nonlinear Speech Processing.Heidelberg:Springer Verlag,2014: 126-135.

[9]KANTZ H,SCHREIBER T.Nonlinear Time Series Analysis[M].Cambridge:Cambridge University Press,2004: 30-150.

[10]趙貴兵,石炎福.從混沌時間序列同時計算關聯維和Kolmogorov熵[J].計算物理,1999,16(3):310-315. ZHAO Guibing,SHI Yanfu.Computing Fractal Dimension and the Kolmogorov Entropy from Chaotic Time Series[J]. Chinese Journal of Computational Physics,1999,16(3):310-315.

[11]WOLF A,SWIFT J B,SWINNEY H L,et al.Determining Lyapunov Exponents from a Time Series[J].Physica,1985,16D(3):285-317.

[12]HURST H E,BLACK R P,SIMAIKA Y M.Long-term Storage:an Experimental Study[J].Journal of the Royal Statistical Society,1965,129(4):591-593.

[13]BURKHARDT F,PAESCHKE A,ROLFES M,et al.A Database of German Emotional Speech[C]//9th European Conference on Speech Communications and Technology.Lisbon:ISCA,2005:1517-1520.

[14]趙力,黃程韋.實用語音情感識別中的若干關鍵技術[J].數據采集與處理,2014,29(2):157-170. ZHAO Li,HUANG Chengwei.Key Technologies in Practical Speech Emotion Recognition[J].Journal of Data Acquisition and Processing,2014,29(2):157-170.

(編輯:郭 華)

Research on nonlinear dynamics features of emotional speech

YAO Hui,SUN Ying,ZHANG Xueying

(College of Information Engineering,Taiyuan Univ.of Technology,Taiyuan 030024,China)

The application of nonlinear measures based on the chaotic characteristics of emotional speech is proposed.Nonlinear features such as minimum delay time,dimension correlation,Kolmogorov entropy,Lyapunov exponent and Hurst exponent are extracted from the emotional speech signal.The performance of nonlinear features is verified by the comparisons of recognition rates of different features(nonlinear characteristics,prosodic features and MFCC features).First,the Berlin emotional speech database and TYUT2.0 emotional speech database are chosen as the corpus independently,both covering three emotional classifications(anger,happiness and fear).The effectiveness of the nonlinear characteristics is tested on the Support Vector Machine Network.The result shows that the performance of nonlinear features outperforms that of prosodic features on the Berlin emotional speech database and that of prosodic features and MFCC on TYUT2.0 emotional speech database.In addition,nonlinear features have obvious advantage in detecting more natural emotional speech and better robustness.

emotional speech recognition;chaos theory;nonlinear features;dynamic model

TN912.34

A

1001-2400(2016)05-0167-06

10.3969/j.issn.1001-2400.2016.05.029

2015-06-15 網絡出版時間:2015-12-10

國家自然科學基金資助項目(61371193);山西省青年科技研究基金資助項目(2013021016-2);山西省回國留學人員科研資助項目(2013-034)

姚 慧(1991-),女,太原理工大學碩士研究生,E-mail:5366970@qq.com.

孫 穎(1981-),女,博士,E-mail:tyutsy@163.com.

網絡出版地址:http://www.cnki.net/kcms/detail/61.1076.TN.20151210.1529.058.html