基于Kinect的拆卸工具運(yùn)動(dòng)軌跡識(shí)別方法

張志佳,魏 信,周自強(qiáng),劉 政

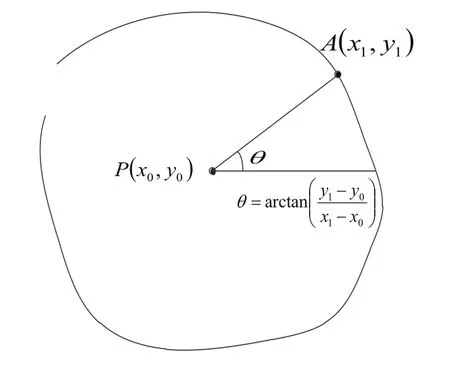

(1.沈陽工業(yè)大學(xué) 視覺檢測技術(shù)研究所,沈陽 110020;2.江蘇省機(jī)電產(chǎn)品循環(huán)利用技術(shù)重點(diǎn)建設(shè)實(shí)驗(yàn)室,常熟 215500;3.遼寧省廣播電視中心發(fā)射臺(tái),沈陽 110016)

基于Kinect的拆卸工具運(yùn)動(dòng)軌跡識(shí)別方法

張志佳1,2,魏 信1,2,周自強(qiáng)2,劉 政3

(1.沈陽工業(yè)大學(xué) 視覺檢測技術(shù)研究所,沈陽 110020;2.江蘇省機(jī)電產(chǎn)品循環(huán)利用技術(shù)重點(diǎn)建設(shè)實(shí)驗(yàn)室,常熟 215500;3.遼寧省廣播電視中心發(fā)射臺(tái),沈陽 110016)

為了獲取拆卸工具的運(yùn)動(dòng)軌跡,提出了基于Kinect的軌跡識(shí)別方法。首先采用Kinect傳感器獲取拆卸人員前臂及拆卸工具深度圖像,通過圖像細(xì)化獲得拆卸工具頂端位置并提取軌跡特征,進(jìn)而提出了一種基于歐式距離和隨機(jī)抽樣一致性的樣本軌跡預(yù)處理方法,然后利用隱馬爾科夫模型(HMM)訓(xùn)練軌跡樣本并實(shí)現(xiàn)軌跡的識(shí)別。實(shí)驗(yàn)結(jié)果表明,該方法能有效地識(shí)別拆卸工具運(yùn)動(dòng)軌跡,并且對(duì)樣本預(yù)處理后,能顯著提高識(shí)別率。

Kinect傳感器;深度圖像;圖像細(xì)化;歐式距離;隨機(jī)抽樣一致性;隱馬爾科夫

0 引言

在廢舊產(chǎn)品的自動(dòng)化拆卸中,如何獲取人工拆卸的相關(guān)信息并進(jìn)行學(xué)習(xí),能大幅度提高拆卸過程的自動(dòng)化程度。Kinect設(shè)備是微軟于2010年正式推出[1,5],可以獲取RGB和深度圖像數(shù)據(jù),同時(shí)進(jìn)行實(shí)時(shí)的全身骨骼跟蹤[2],并可以進(jìn)行人體動(dòng)作姿態(tài)識(shí)別[3,4]。目前大部分運(yùn)動(dòng)跟蹤設(shè)備需要穿戴,通過標(biāo)記來識(shí)別[6],微軟開發(fā)的Kinect不做任何標(biāo)定直接獲取人體姿態(tài)動(dòng)作,滿足了便捷性。

Kinect在人體手勢識(shí)別方面[7]已經(jīng)有了研究,但在利用拆卸工具的情況下,對(duì)拆卸工具的軌跡識(shí)別還未見有相關(guān)研究。基于以上背景,本文提出基于Kinect的拆卸工具運(yùn)動(dòng)軌跡識(shí)別方法。該方法通過Kinect提取手持拆卸工具的深度圖像,并進(jìn)行二值化、圖像細(xì)化[8]等處理,獲取拆卸工具頂端位置,提取拆卸工具軌跡,然后對(duì)提取的軌跡進(jìn)行量化編碼。構(gòu)建隱馬爾科夫(HMM)模型[9],將編碼值輸入到HMM模型中進(jìn)行訓(xùn)練,優(yōu)化選取模型參數(shù),實(shí)現(xiàn)拆卸工具軌跡識(shí)別。

1 Kinect與關(guān)節(jié)跟蹤

Kinect共有三個(gè)攝像頭(如圖1所示),中間的鏡頭是RGB彩色攝像頭,左右兩邊鏡頭分別是紅外線發(fā)射器和紅外線CMOS攝像機(jī)。Kinect在底部還配備了傳動(dòng)馬達(dá),在兩側(cè)內(nèi)置了陣列麥克風(fēng)系統(tǒng),用于語音識(shí)別。

圖1 Kinect傳感器

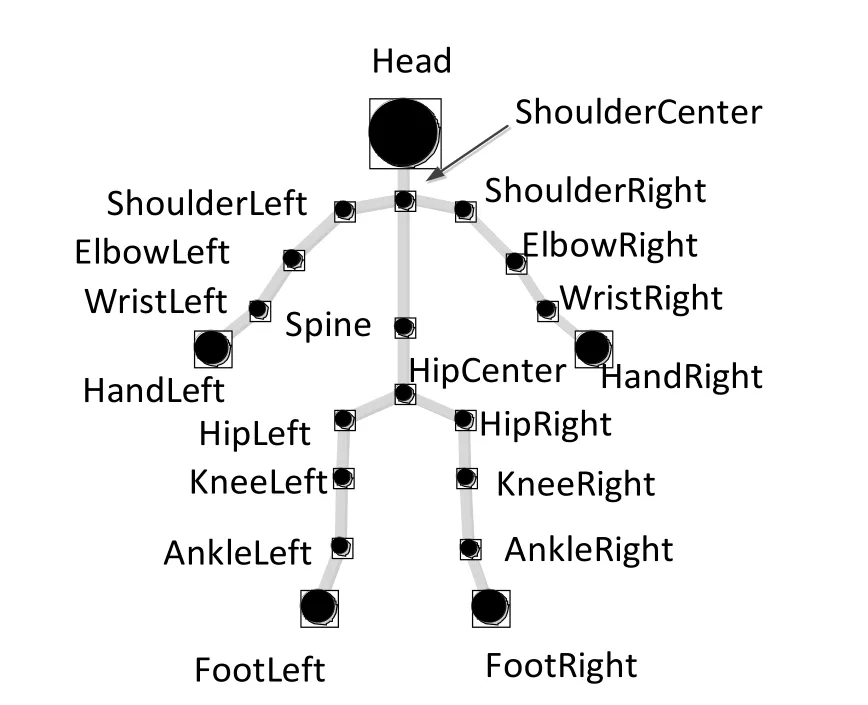

Kinect具有骨骼跟蹤技術(shù),它是通過處理深度數(shù)據(jù)來建立人體各個(gè)關(guān)節(jié)的坐標(biāo),骨骼追蹤能夠確定人體各個(gè)部分(如:手,頭部以及身體),還能確定他們相對(duì)于Kinect所在的空間位置。基于這一特性,在拆卸過程中,可以利用Kinect對(duì)人體骨骼進(jìn)行跟蹤。

圖2 20個(gè)人體關(guān)節(jié)點(diǎn)

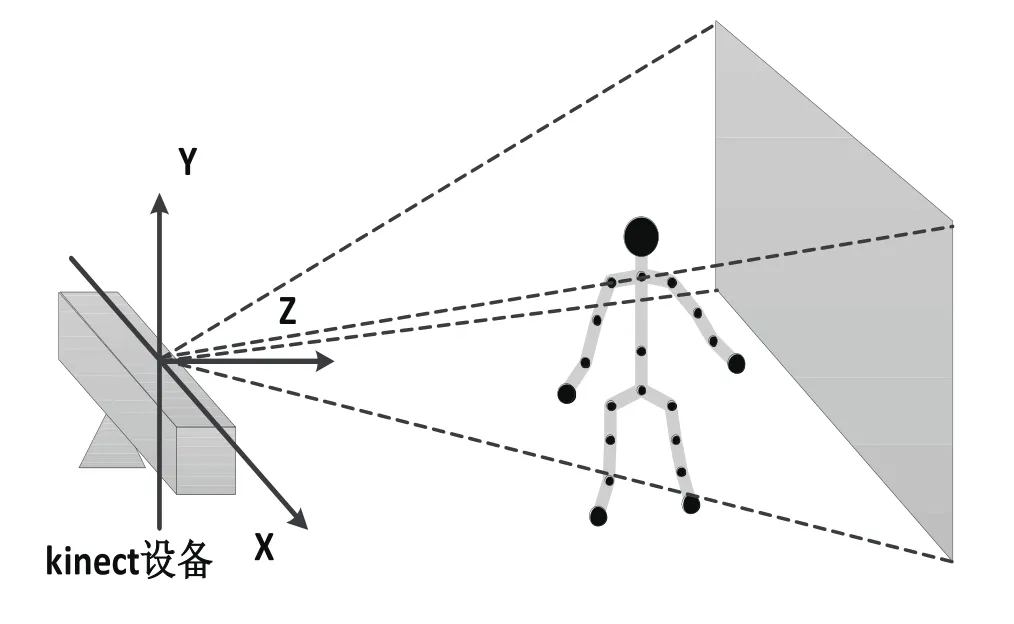

Kinect系統(tǒng)通過20個(gè)關(guān)節(jié)點(diǎn)來表示一個(gè)骨架,如圖2所示。當(dāng)人進(jìn)入如圖3所示的Kinect視野范圍內(nèi),Kinect會(huì)把人的20個(gè)骨骼關(guān)節(jié)點(diǎn)找到,且以坐標(biāo)形式表示出來。

圖3 Kinect場景內(nèi)的人體骨骼

2 軌跡提取及預(yù)處理

手持拆卸工具的軌跡提取主要包括以下主要步驟:提取右臂及拆卸工具的深度圖像,對(duì)深度圖像二值化;然后對(duì)二值化圖像進(jìn)行細(xì)化,獲取細(xì)化圖像頂端的位置;提取拆卸工具運(yùn)動(dòng)軌跡,將軌跡進(jìn)行量化編碼,以方便對(duì)軌跡進(jìn)行識(shí)別。

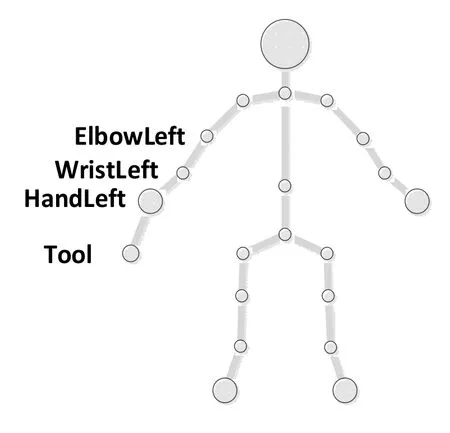

2.1 獲取工具的深度圖像

深度圖像包含與場景物體表面距離有關(guān)信息的一種圖像。與彩色圖像相比,深度圖像能反映物體表面的三維特征,且不受光照等外在因素的影響。利用Kinect獲得的深度圖像可以對(duì)人體主要部位進(jìn)行識(shí)別,本文主要研究手持拆卸工具軌跡,所以對(duì)手持拆卸工具進(jìn)行識(shí)別。加入工具的關(guān)節(jié)點(diǎn)作為第21個(gè)關(guān)節(jié)點(diǎn),如圖4所示。

圖4 21個(gè)人體關(guān)節(jié)點(diǎn)

由于是手持拆卸工具,為了獲取更多的圖像信息方便圖像處理,利用Kinect提取前臂及拆卸工具的整個(gè)深度圖像如圖5所示。

圖5 右前臂及拆卸工具

2.2 圖像細(xì)化

由于獲取的前臂及拆卸工具深度圖像特征不精細(xì),這給拆卸工具頂端坐標(biāo)獲取帶來很大難度,因此引入圖像分析方法,得到一個(gè)精細(xì)的骨架特征,這就是圖像細(xì)化[8]。

圖像細(xì)化是針對(duì)二值圖像的細(xì)化,對(duì)于640×480的二值圖像,1代表待細(xì)化的像素點(diǎn)區(qū)域,0代表背景。對(duì)邊界點(diǎn)P及其八鄰域點(diǎn)P0,P1,…,P6,P7,如圖6所示。

圖6 細(xì)化規(guī)則

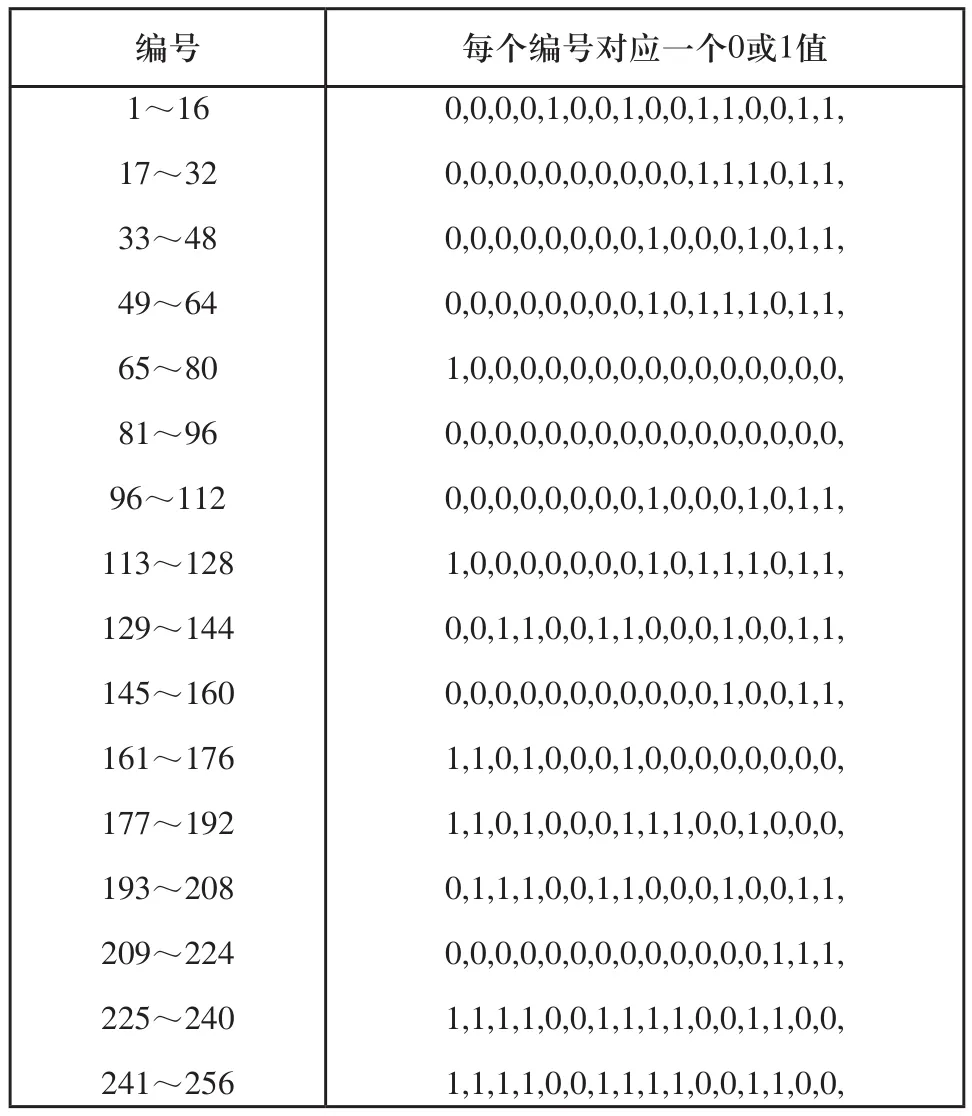

對(duì)于邊界點(diǎn)P,判斷P0到P7所對(duì)應(yīng)的像素值,計(jì)算八個(gè)鄰域點(diǎn)的權(quán)值S,對(duì)S值查表1的編號(hào),若編號(hào)對(duì)應(yīng)的值為1,則可以判斷P為可刪除點(diǎn)。

式中:Pk表示第k個(gè)鄰域點(diǎn)的像素值;k表示第幾個(gè)鄰域點(diǎn)。

通過上述方法對(duì)人體前臂及拆卸工具的二值圖像進(jìn)行細(xì)化,如圖7所示。

圖7 細(xì)化示意圖

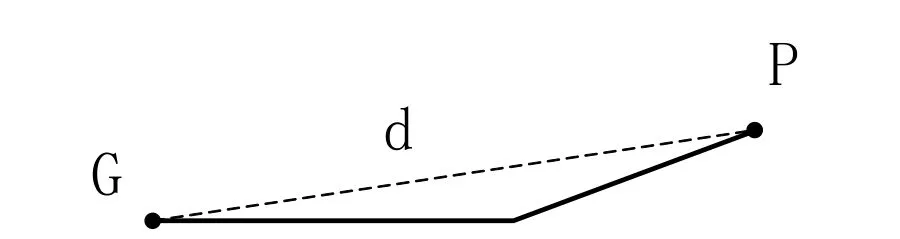

2.3 提取拆卸工具頂端三維坐標(biāo)

對(duì)于細(xì)化后的圖像,獲取曲線上點(diǎn)的坐標(biāo)。利用Kinect的關(guān)節(jié)跟蹤,可以提取出肘關(guān)節(jié)G點(diǎn)的坐標(biāo)為(x,y),計(jì)算G點(diǎn)與曲線上其他點(diǎn)的歐式距離d,則歐式距離d最大值所對(duì)應(yīng)的點(diǎn)P為拆卸工具頂點(diǎn),其坐標(biāo)為(x',y'),如圖8所示。

表1 索引表

圖8 尋找頂端示意圖

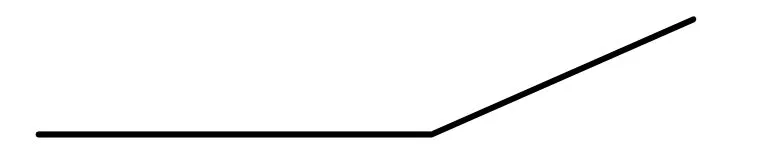

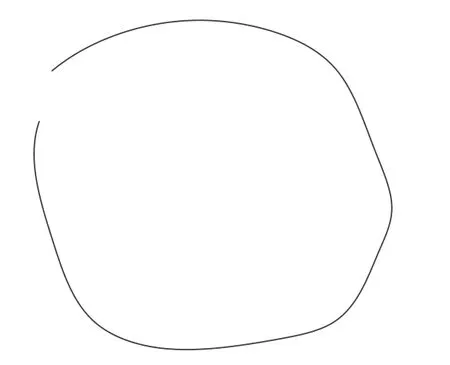

2.4 獲取拆卸工具軌跡

人拿拆卸工具進(jìn)行運(yùn)動(dòng)(以圓為例),在運(yùn)動(dòng)的整個(gè)過程中,利用Kinect提取一系列深度圖像,對(duì)每一幅深度圖像進(jìn)行2.2~2.3節(jié)的操作,獲得拆卸工具頂端的位置,提取軌跡特征,如圖9所示的是一個(gè)近似圓形的工具軌跡。

圖9 軌跡模型

2.5 軌跡預(yù)處理及量化編碼

1)對(duì)軌跡進(jìn)行預(yù)處理

樣本數(shù)據(jù)里存在干擾點(diǎn),所以提出利用歐式距離和隨機(jī)抽樣一致性對(duì)樣本進(jìn)行預(yù)處理。

對(duì)于獲取的軌跡特征點(diǎn)的數(shù)據(jù)集合Q,計(jì)算其重心點(diǎn)P(x0,y0)。

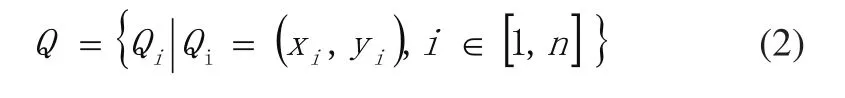

軌跡特征點(diǎn)集合可表示為:

式中:Qi表示(xi,yi)處的位置坐標(biāo);n表示特征點(diǎn)數(shù)目。

重心點(diǎn)坐標(biāo)可表示為:

式中:xi表示點(diǎn)的橫坐標(biāo);yi表示點(diǎn)的縱坐標(biāo)。

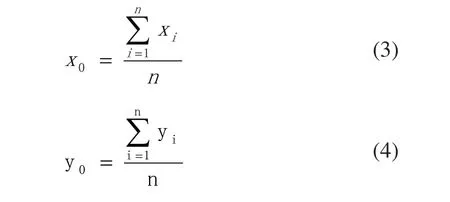

計(jì)算每個(gè)樣本里點(diǎn)到重心P(x0,y0)的歐式距離d,若則將d〉T所對(duì)應(yīng)的點(diǎn)剔除;若對(duì)式(1)樣本,利用隨機(jī)抽樣一致性算法擬合成一條直線L,提取集合Q中每一點(diǎn)到直線L的距離d',將d'〉T'所對(duì)應(yīng)的點(diǎn)剔除,圖10給出剔除干擾點(diǎn)示意圖。

圖10 干擾點(diǎn)剔除示意圖

如圖10所示,左圖A點(diǎn)離重心P(x0,y0)的歐式距離太大,作為剔除點(diǎn);右圖B點(diǎn)離擬合的直線的歐式距離太大,作為剔除點(diǎn)。

2)對(duì)軌跡進(jìn)行量化編碼

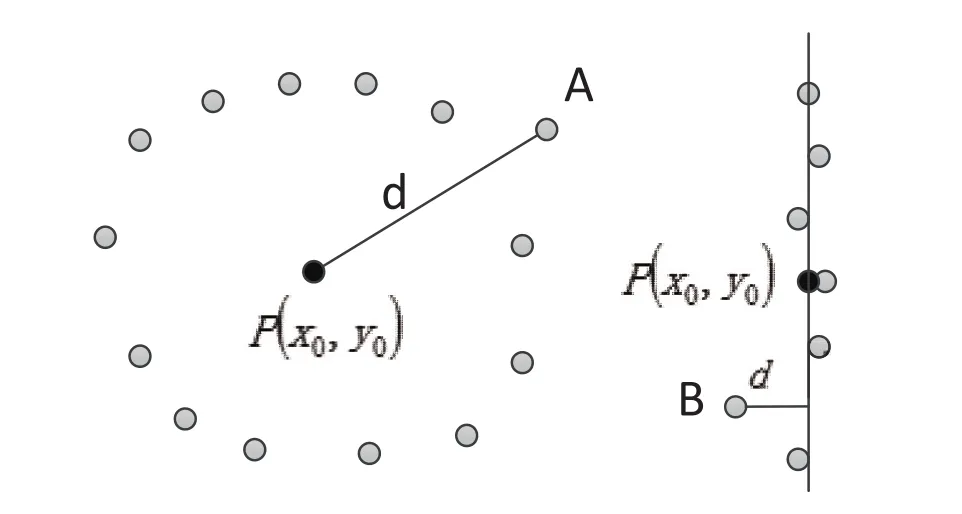

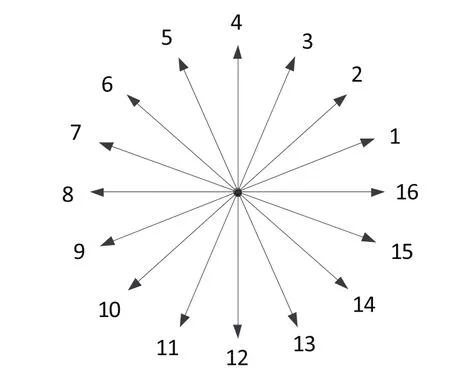

為了便于對(duì)軌跡進(jìn)行識(shí)別,需要對(duì)軌跡進(jìn)行量化編碼。對(duì)于提取的軌跡,將其深度值Z去掉,以便于量化編碼,圖11給出求取角度的方向矢量圖。

如圖11所示,P(x0,y0)是軌跡曲線的重心,對(duì)于軌跡曲線上任意點(diǎn)A(x1,y1),通過幾何關(guān)系,求出A點(diǎn)所在的角度值θ,其中:

圖11 方向矢量圖

從軌跡曲線上得到一系列角度值,采用16方向鏈碼進(jìn)行角度量化編碼,圖12給出里夾角量化編碼示意圖。

圖12 夾角量化編碼

如圖12所示,軌跡上每個(gè)點(diǎn)都對(duì)應(yīng)一個(gè)角度值,根據(jù)對(duì)應(yīng)關(guān)系將角度值轉(zhuǎn)化為1到16的碼值,通過碼值對(duì)軌跡進(jìn)行識(shí)別。

3 軌跡識(shí)別

3.1 HMM模型

隱馬爾科夫模型(Hidden Markov Model, HMM)[9,10]是用于描述隨機(jī)過程統(tǒng)計(jì)特性的概率模型[11],可以用來描述含有隱含未知參數(shù)的馬爾科夫過程。首先通過可觀察的參數(shù)中確定該過程的隱含參數(shù);然后利用這些參數(shù)進(jìn)行模式識(shí)別[12]等。

HMM用5個(gè)元素來描述,包括兩個(gè)狀態(tài)和三個(gè)狀態(tài)概率矩陣。

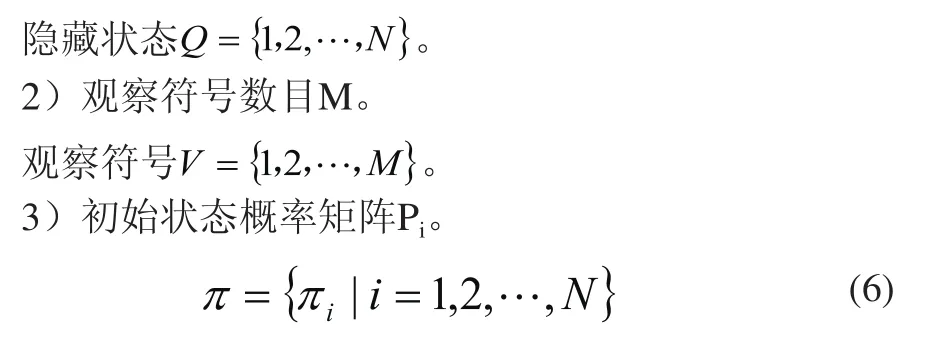

1)隱藏狀態(tài)數(shù)目N。

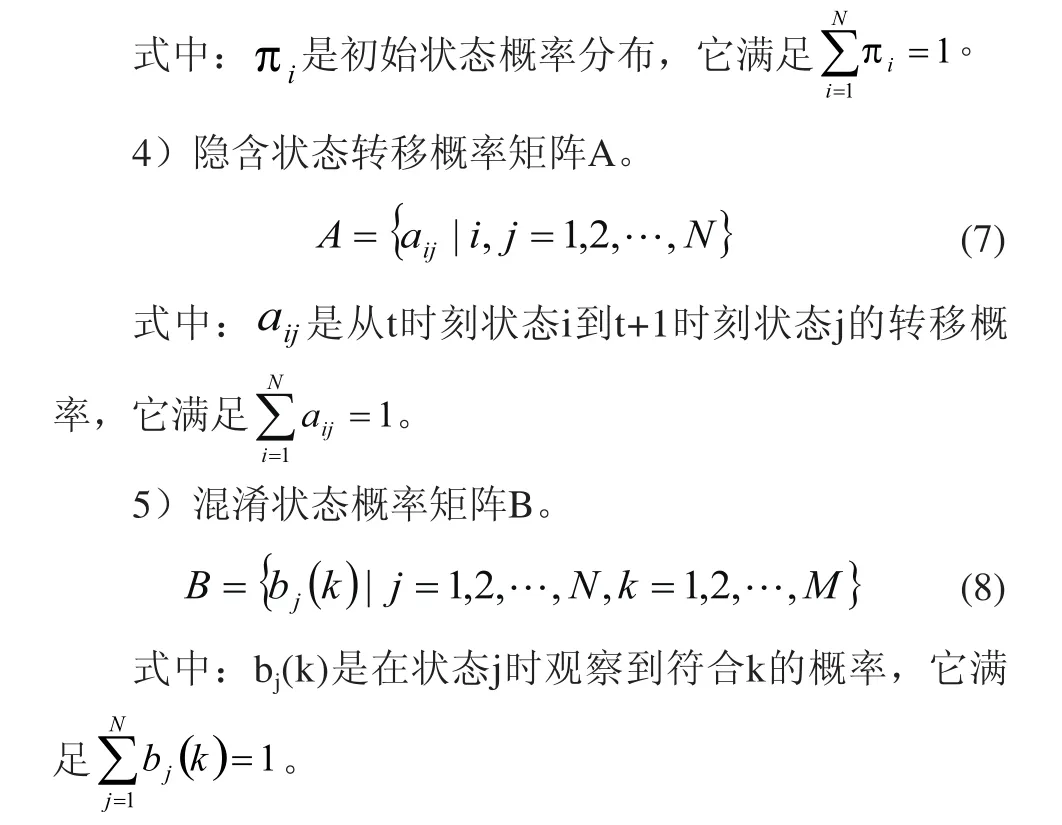

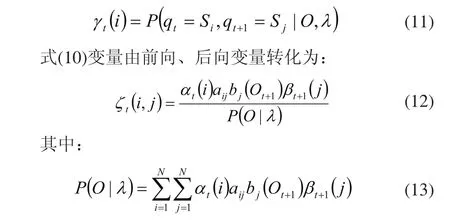

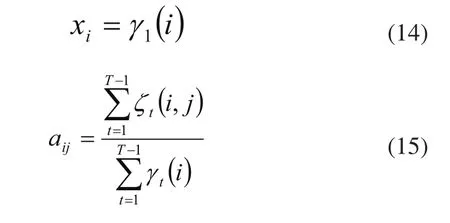

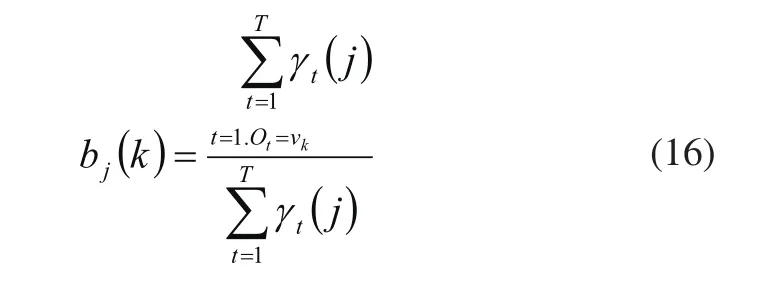

3.2 HMM參數(shù)估計(jì)

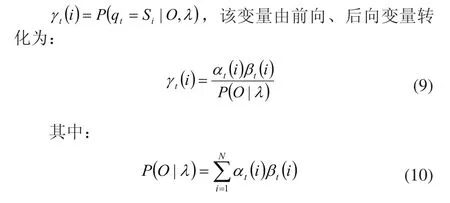

利用HMM對(duì)軌跡識(shí)別之前,需要對(duì)HMM參數(shù)進(jìn)行估計(jì)。前向-后向算法(Baum-Welch算法)可以解決隱馬爾科夫模型參數(shù)估計(jì)問題。

給定觀察序列O及隱馬爾科夫模型λ,定義t時(shí)刻位于隱藏狀態(tài)Si的概率變量為:

給定觀察序列O及隱馬爾科夫模型λ,定義t時(shí)刻位于隱藏狀態(tài)Si及t+1時(shí)刻位于隱藏狀態(tài)Sj的概率變量為:

對(duì)多組角度量化編碼,進(jìn)行迭代提取γ和ζ,用這兩個(gè)變量對(duì)HMM模型參數(shù)進(jìn)行重新估計(jì):

3.3 軌跡識(shí)別

4 實(shí)驗(yàn)

4.1 提取拆卸工具軌跡

本文以螺絲刀為研究對(duì)象進(jìn)行了拆卸工具的軌跡提取。利用Kinect獲取前臂及螺絲刀的深度圖,且提取出右肘所在的深度圖像坐標(biāo),圖13給出提取的前臂及螺絲刀深度圖,圖14給出了細(xì)化后的輪廓圖。

圖13 前臂及拆卸工具提取

圖14 前臂及拆卸工具圖像細(xì)化

如圖14所示,利用Kinect的骨骼跟蹤提取右肘圖像坐標(biāo),計(jì)算出離右肘最遠(yuǎn)的點(diǎn)作為螺絲刀頂端所在的圖像坐標(biāo)。最后通過Kinect SDK開發(fā)工具包將圖像坐標(biāo)轉(zhuǎn)換為三維點(diǎn)云坐標(biāo)。

拆卸工具運(yùn)動(dòng)時(shí)記錄下不同時(shí)刻其三維坐標(biāo)則提取出拆卸工具頂端的運(yùn)動(dòng)軌跡。

4.2 軌跡識(shí)別

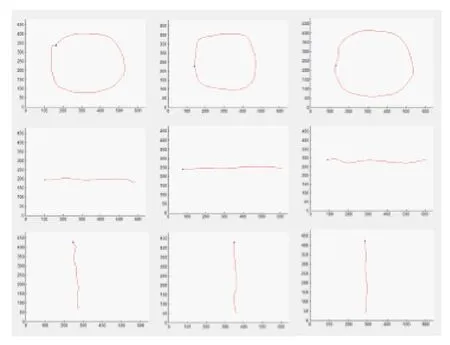

本文設(shè)計(jì)了三種軌跡類型來進(jìn)行識(shí)別,有圓形軌跡、垂直運(yùn)動(dòng)軌跡和水平運(yùn)動(dòng)軌跡,典型的軌跡樣本如圖15所示。本研究對(duì)預(yù)處理前后的樣本利用HMM算法對(duì)三種軌跡進(jìn)行識(shí)別實(shí)驗(yàn)。

圖15 三種軌跡圖

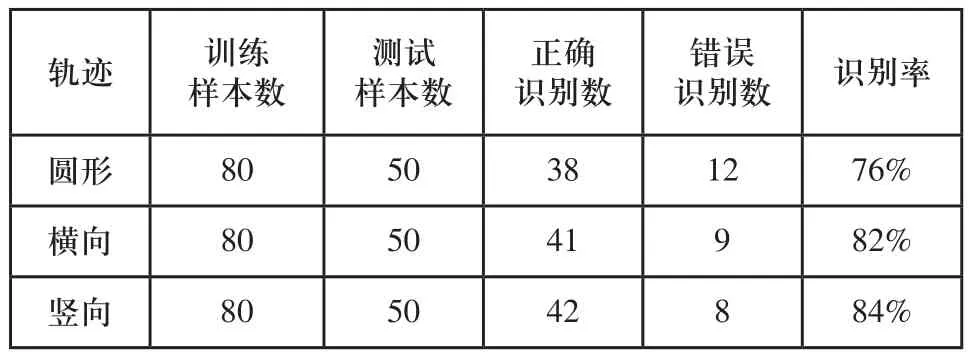

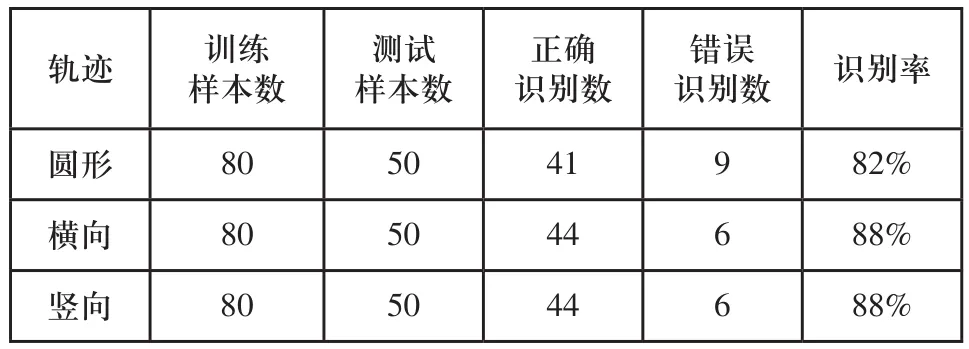

經(jīng)過實(shí)驗(yàn)與分析,各閾值參數(shù)確定為:T1=60,T2=300,T'=20。本研究對(duì)每種軌跡類型分別用80組樣本進(jìn)行訓(xùn)練。表2和表3分別為通過實(shí)驗(yàn)分析得到原HMM算法和對(duì)樣本預(yù)處理后的軌跡識(shí)別率。

通過實(shí)驗(yàn)分析可知:對(duì)樣本預(yù)處理后的識(shí)別率比沒有預(yù)處理的提高了6個(gè)百分點(diǎn),驗(yàn)證了本文對(duì)樣本預(yù)處理后用HMM算法能提高識(shí)別率。

表2 原HMM算法對(duì)三種軌跡的識(shí)別率

表3 樣本預(yù)處理后的識(shí)別率

5 結(jié)論

本文研究了利用Kinect獲取的深度圖像對(duì)人手拆卸工具進(jìn)行軌跡識(shí)別。從深度圖像出發(fā),結(jié)合圖像細(xì)化獲得拆卸工具頂端位置,提取軌跡特征,進(jìn)而提取一種基于歐式距離和隨機(jī)抽樣一致性的樣本軌跡預(yù)處理方法;然后利用隱馬爾科夫算法訓(xùn)練軌跡樣本并實(shí)現(xiàn)軌跡的識(shí)別。試驗(yàn)結(jié)果表明樣本預(yù)處理后的識(shí)別率比未作預(yù)處理的識(shí)別率有了明顯提高。

[1] Biswas K K ,Basu S K. Gesture recognition using Microsoft Kinect[A].5th Internation Conference on Automation,Robotics and Application[C].IEEE,2011:100-103.

[2] Shotton J, Sharp T, Kipman A, et al. Real-time human pose recognition in parts from single depth images[J].Communications of the ACM,2013,56(1):116-124.

[3] Le T L, Nguyen M Q,Nguyen T T M,Human posture recognition using human skeleton provided by Kinect[A]. International Conference on Computing, Management and Telecommunications[C].IEEE,2013:340-345.

[4] 田國會(huì),尹建芹,韓旭,等.一種基于關(guān)節(jié)點(diǎn)信息的人體行為識(shí)別新方法[J].機(jī)器人,2014,36(3):285-292.

[5] Microsoft Kinect Tear down(iFixit,4 November 2010).[EB/ OL].http://www.ifixit.com/Teardown/Microsoft_Kinect_ Teardown/4066/1.

[6] MEENAKSHI P.Hand gesture recognition based on shape parameters[A].Computing, Communication and Application(ICCCA), 2012 International Conference[C],2012.

[7] SILANON K, SUVONVORN N. Hand motion analysis for Thai alphabet recognition using HMM[J].International Journal of Information and Electronics Engineering,2011,1(1):65-71.

[8] Tian Jie Chen Xinjian,Zhang Yangyang et al. Recent progress on finger print identification technologies[J].Progress in Natural Science.2006,16(4):400-406.

[9] Marcinczuk M,Piasecki M. Study on named entity recognition for polish based on hidden Markov models[A].Proceedings of Text,Speech and Dialogue-13th International Conference(TSD 2010)[C],2010:142-149.

[10] 吳曉娟,張博洋,張楨,等.基于HMM動(dòng)態(tài)手勢軌跡識(shí)別的門限模型研究方法[J].模式識(shí)別與人工智能.2003,16(1):122-125.

[11] RABINER R,JUANG H.An introduction to HMMs[J].IEEE ASSP Magazine,1986,3:4-16.

[12] Wu Haitao,Pan Wei, Xiong Xingyu,et al.Human activity recognition based on the combined SVM & HMM[A].Proceedings of 2014 IEEE International Conference on Information and Automation[C].Hailar:IEEE,2014:219-224.

Recognition of removal tool trajectory based on kinect

ZHANG Zhi-jia1,2, WEI Xin1,2, ZHOU Zi-qiang2, LIU Zheng3

TP391.4

A

1009-0134(2016)12-0140-06

2016-11-24

江蘇省機(jī)電產(chǎn)品循環(huán)利用技術(shù)重點(diǎn)建設(shè)實(shí)驗(yàn)室基金(KF1508);國家自然科學(xué)基金(61540069)

張志佳(1974 -),男,副教授,博士,研究方向?yàn)闄C(jī)器視覺檢測技術(shù)、圖像處理與模式識(shí)別。

- 制造業(yè)自動(dòng)化的其它文章

- 二維碼標(biāo)簽打印及產(chǎn)品真?zhèn)巫R(shí)別系統(tǒng)設(shè)計(jì)

- E-車間通信系統(tǒng)的設(shè)計(jì)與實(shí)現(xiàn)

- 復(fù)雜機(jī)電產(chǎn)品剛?cè)峄旌涎b配仿真技術(shù)研究

- 基于Profinet的安全氣囊自動(dòng)裝配產(chǎn)線網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)與實(shí)現(xiàn)

- 基于Modbus的船舶配電監(jiān)控系統(tǒng)的設(shè)計(jì)

- 高速高精度太陽能硅片插片機(jī)的設(shè)計(jì)