基于二進制光流描述子的運動目標提議

李 洋 吳克偉 謝 昭 孫永宣

(合肥工業大學計算機與信息學院 安徽 合肥 230009)

基于二進制光流描述子的運動目標提議

李 洋 吳克偉 謝 昭 孫永宣

(合肥工業大學計算機與信息學院 安徽 合肥 230009)

針對視頻目標檢測提議框存在大量冗余的問題,提出二進制光流描述子,實現視頻連通目標的分離提議。通過分析目標局部運動一致性,設計二進制光流描述子,構建目標提議模型,然后利用線性支持向量機分類器求解運動目標提議參數。為充分利用二進制與或運算速度快的優勢,采用二進制近似表示運動目標提議參數,快速高效地完成目標提議任務。實驗針對Caltech行人數據庫,快速地生成了少量高質量的運動目標提議窗口。實驗結果優于現有目標提議方法。

目標提議 局部運動一致性 光流 二進制描述子

0 引 言

目標檢測是計算機視覺領域重要的研究任務之一,近年來這方面的研究取得了巨大成就,廣泛應用在工業、醫學、軍事、教育、商業、體育等領域中。但是,目前許多先進的檢測器,需要使用特定類別分類器評估每一個滑動窗口,而被評估的滑動窗口存在大量的冗余,導致檢測速度過慢[1-2]。為了加快目標檢測速度,通過目標性提議,剔除特定類別分類器需要評估的滑動窗口中的非目標性窗口,成為近年來研究的熱點[3-4]。

目標具有定義良好的封閉邊界而背景具有雜亂無章性,梯度幅值特征描述子可以表示目標的封閉邊界特性,用于區分目標與背景,剔除滑動窗口中的非目標性窗口[5]。圖像中目標像素點比背景像素點具有更強的視覺吸引力[6],圖像中目標像素點局部顏色統計特征可以描述目標局部顯著性,使用決策森林方法判別每一個像素點與周圍像素點的差異性,得到目標的輪廓區域[7]。超像素把目標分割成具有統一顏色和紋理的小區域,同一個超像素區域里的像素點屬于同一個目標[8],因此,一個目標雖然被劃分為幾個超像素區域,但是每一個區域并沒有跨越目標邊界,超像素的這一特性可以作為評估一個窗口是否包含目標的有效線索[9]。靜態背景視頻中運動目標具有運動顯著性,幀差法可以有效提取運動目標區域[10-11]。上述方法雖然都可以實現目標性提議任務,但是只考慮了目標與背景的差異性,沒有考慮目標局部運動一致性,應用于視頻前景檢測中,存在目標提議冗余,并且無法區分多個連通目標。

針對上述方法應用于動態背景視頻目標提議冗余和無法區分連通目標的問題,本文考慮到目標封閉邊界性在視頻中表現為目標區域運動一致性這一線索,使用光流描述子,描述目標局部運動一致性以及與背景區域的差異性,有效地區分目標與背景以及多個連通目標,生成高質量的目標性提議窗口,與現有目標提議方法相比,本文主要貢獻如下:

(1) 針對視頻中場景信息混雜的難題,利用前景目標的局部運動一致性,提出一種二進制光流描述子,實現運動目標性的客觀提議,有效區分多個連通目標。

(2) 采用線性支持向量機,實現特定類目標的二進制光流模板的近似求解。

(3) 在Caltech數據集中,驗證了本文方法對行人目標提議的查全率,優于目標提議的現有方法。

1 基于光流特征的目標提議

將客觀目標提議用于視頻運動目標識別,可以有效地加快視頻目標識別速度,但是現有方法是針對靜態圖片提議,應用于視頻提議存在大量冗余框,所以本文構建目標運動描述子,采用二進制光流描述子完成視頻運動目標提議任務。

1.1 光流幅值描述子與客觀目標性

目標具有定義良好的封閉邊界,在視頻圖像中,目標的封閉邊界特性表示為目標區域運動一致性。將不同尺度的視頻圖像目標窗口縮放到大小預先設定的分辨率,光流幅值特征是區別運動目標與背景的有效特征,因為光流幅值特征的變化體現了運動目標封閉邊界的微小變化,雖然目標的形狀、顏色、紋理、光照等特征不同,但是目標局部運動是一致的,局部運動量是相似的,與背景光流特征具有差異性[12]。

基于運動目標的局部光流幅值相似性,計算每種預設尺度的窗口縮放為預先設定的分辨率后的光流幅值,構成對應窗口的光流特征向量,采用式(1)計算每一個窗口的目標性得分:

sl=〈W,OFl〉

(1)

其中,sl表示濾波值,OFl表示窗口l的光流幅值特征向量,l=(i,x,y)表示窗口位置參數,i=(a,b)表示預設的目標提議窗口的長和寬,(x,y)表示窗口坐標,W為模型參數。

1.2 二進制近似求解目標性得分

與或運算比乘法運算具有更快地運算速度[13],為了充分利用二進制與或運算速度快的優勢,加快視頻目標提議的速度,本文將W與OFl轉化為二進制形式[5],通過與或運算求解〈W,OFl〉的近似值。

為了用與或運算近似求解〈W,OFl〉,本文將向量OFl中的值量化為0~255,得到二進制表示的光流特征向量OFBl。將每種預設尺度的窗口縮放為8×8,每個像素的光流幅值用1byte=8bit表示,那么每個窗口的特征向量正好用64byte存儲。將訓練數據集中標定的正例窗口作為正例樣本,隨機采取背景窗口構造負例樣本,使用線性支持向量機獲得模型最優解。

算法1 目標提議模板二值化近似求解算法

輸入:W,NW

初始化:ε=w

forj=1:Nw

αj=sign(ε)

βj=〈αj,ε〉/‖αj‖2

ε←ε-βjαj

Endfor

將用二進制向量基近似表示的W和二進制光流幅值特征向量OFBl代入式(1),得到式(1)的近似表示式(2):

(2)

通過與或運算快速計算式(2),得到每一個預設尺度i下的每一個窗口的目標性得分sl的近似值,采用極大值抑制,從每一個固定尺度和比率的窗口中選擇一些候選框,快速完成目標提議任務。

2 實 驗

本文實驗方法基于Caltech行人數據庫,該數據采用車載攝像頭拍攝,約10個小時左右,視頻的分辨率為640×480,30幀/秒,標注了約250 000幀,用矩形框標定每幀中的行人,另外還對矩形框之間的時間對應關系及其遮擋的情況進行標注。數據集包括set00-set10,其中set00-set05為訓練集,set06-set10為測試集。測試時,以DR#WIN和時效性作為對比方法評價標準,其中DR為檢測查全率,WIN為DR對應的目標提議窗口數量,目標被正確預測的標準為預測的窗口與Ground-Truth窗口面積重疊超過50%。為了保證公平對比,本文程序和對比方法的程序在同一臺PC上在單線程條件下運行,本文PC的配置為IntelCPUi3-4130。

為了獲取行人目標提議的窗口分辨率參數,分別對Caltech行人數據庫中行人高度分辨率,以及行人寬度與高度的比率進行了統計。在統計分析的基礎上,本文為目標提議窗口預設了10個不同的高度分辨率(26到160等比取10個值),為每種高度的預設窗口設置3個不同的縱橫比(寬/高)0.34、0.41、0.50,所以本文共計預設30種尺度的預設窗口,并隨后縮放為8×8提取二進制光流描述子。

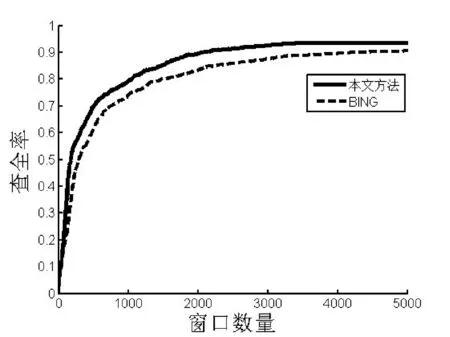

表1中給出了用于近似表示W的二進制向量基的數量Nw對查全率和平均一幀視頻提議時間的影響,時間單位為毫秒,用符號ms表示。Nw越大基元數量越多,則檢測速度越慢,綜合考慮目標提議的查全率與速度,由表1可以看出,Nw=2可以兼顧查全率與速度。圖1給出了本文方法與BING[5]方法在Caltech行人測試數據集上的DR#WIN曲線(Nw=2),曲線橫坐標表示目標提議窗口數量,縱坐標表示目標查全率。

表1 不同基元個數情況下的運動目標提議

圖1 本文方法與BING[5]方法的目標提議查全率

由于缺乏目標的先驗位置,傳統的目標檢測算法采用滑動窗口采樣,需要的采樣窗口數量約為106~107,造成目標檢測實時性效率低下。觀察圖1中曲線,對應每一個WIN,本文方法DR高于BING[5]方法DR,WIN約為3 600時,本文方法的DR已經達到最大值93.7%,而BING[5]方法在WIN約為5 000時DR才達到最大值90.2%。本文方法使用比BING[5]方法較少的窗口數量實現了比BING[5]方法高的召回率,說明在視頻圖像目標提議中,光流特征描述子能夠比BING[5]方法中的梯度幅值特征描述子更有效地描述目標,獲得更高質量的目標提議框。

本實驗對不同方法的檢測速度進行對比,由于兩種方法都使用了二進制與或運算,并且計算量相當,因此,實驗中兩種方法時間開銷非常接近,本文方法為39.1毫秒,BING[5]方法為36.4毫秒,在同一個數量級上,本文方法使用較少窗口數量實現了較大DR。綜上所述,本文時效性與BING[5]相同的情況下,使用更少的窗口數量實現了更高的查全率,即窗口數量比BING[5]減少了30%,DR值卻增加了3.5%。

與BING[5]方法相比,本文方法不僅使用更少的窗口數量實現了更高的查全率,而且還可以區分多個連通目標。如圖2(a)所示,輸入視頻幀最左邊的兩個行人連在一起,由于BING[5]方法基于外觀特征,將兩個連通的人視為一個目標,如圖2(c)最左邊白色框所示。而本文通過計算場景的光流能量圖2(b),使用目標局部運動一致性線索,由于兩個人的運動速度不同,所以有效地區分兩個連通的目標,如圖2(d)中最左邊兩個白色框。為避免標記過多窗口,圖中只標記與目標重疊率大于50%的目標提議窗口中重疊面積最大的窗口。

圖2 連通目標的運動目標提議

上述實驗結果表明,視頻目標檢測中目標局部運動一致性是非常有用的線索,使用二進制光流特征描述,能夠很好地表示目標局部運動量相似性,并通過二進制與或運算,高效地完成目標提議任務。

3 結 語

本文通過使用二進制光流幅值特征描述子,快速地完成了視頻目標提議任務,生成了少量高質量的目標性提議窗口。將這些窗口應用于特定類別的目標檢測器,可以有效地加快目標檢測速度。基于本文的目標提議窗口數量為103數量級,因此,下一步工作將探索是否可以利用時間和空間規律,確定獨立目標的新信息,完成準確高效的目標性估計,降低目標提議窗口的數量。

[1]RenX,RamananD.Histogramsofsparsecodesforobjectdetection[C]//Proc.ComputerVisionandPatternRecognition,Portland,OR,USA,2013:3246-3253.

[2]DayanandaKumarNC,SureshKV.HOG-PCAdescriptorwithopticalflowbasedhumandetectionandtracking[C]//Proc.InternationalConferenceonCommunicationsandSignalProcessing,Melmaruvathur,India,2014:900-904.

[3]HosangJ,BenensonR,DollárP,etal.Whatmakesforeffectivedetectionproposals?[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2015,38(4):814-830.

[4]GirshickR,DonahueJ,DarrellT,etal.Richfeaturehierarchiesforaccurateobjectdetectionandsemanticsegmentation[C]//Proc.ComputerVisionandPatternRecognition,Columbus,OH,USA,2014:580-587.

[5]ChengMM,ZhangZ,LinWY,etal.BING:Binarizednormedgradientsforobjectnessestimationat300fps[C]//Proc.ComputerVisionandPatternRecognition,Columbus,OH,USA,2014:3286-3293.

[6] 白雪飛,王文劍,梁吉業.基于區域顯著性的活動輪廓分割模型[J].計算機研究與發展,2015,49(12):2686-2695.

[7]DollárP,ZitnickCL.Fastedgedetectionusingstructuredforests[J].PatternAnalysis&MachineIntelligence,2015,8(37):1558-1570.

[8]RussellBC,FreemanWT,EfrosA,etal.Usingmultiplesegmentationstodiscoverobjectsandtheirextentinimagecollections[C]//Proc.ComputerVisionandPatternRecognition,Jeju,Korea,2006,2:1605-1614.

[9]AlexeB,DeselaersT,FerrariV.Measuringtheobjectnessofimagewindows[J].TransactionsonPatternAnalysisandMachineIntelligence,2012,34(11):2189-2202.

[10]ZhouF,KangSB,CohenMF.Time-mappingusingspace-timesaliency[C]//Proc.ConferenceonComputerVisionandPatternRecognition,Columbus,OH,USA,2014:3358-3365.

[11] 高美鳳,劉娣.分塊幀差和背景差相融合的運動目標檢測[J].計算機應用研究,2013,30(1):299-302.

[12]BarronJL,FleetDJ,BeaucheminSS.Performanceofopticalflowtechniques[J].Internationaljournalofcomputervision,1994,12(1):43-77.

[13]HareS,SaffariA,TorrPHS.Efficientonlinestructuredoutputlearningforkeypoint-basedobjecttracking[C]//Proc.ComputerVisionandPatternRecognition,Providence,RI,2012:1894-1901.

MOTION OBJECT PROPOSAL BASED ON BINARY OPTICAL FLOW DESCRIPTOR

Li Yang Wu Kewei Xie Zhao Sun Yongxuan

(SchoolofComputerandInformation,HefeiUniversityofTechnology,Hefei230009,Anhui,China)

In order to reduce the redundance of proposal windows in video object detection, a novel binary optical flow descriptor is proposed to achieve separate proposals for connected objects. By analysing the local motion coherence of objects, we design the binary optical flow descriptor, construct the object proposal model and then use linear SVM classifier to solve motion object proposal parameters. To make full use of the speed advantage of binary and/or calculation, the motion object proposal parameters are represented approximately in binary to complete object proposal tasks quickly and efficiently. The experiment on the Caltech Pedestrians dataset is carried out, and a small number of high-quality motion object proposal windows are generated quickly. Experimental results show that the proposed method is superior to current object proposal methods.

Object proposal Local motion coherence Optical flow Binary descriptor

2016-01-22。國家自然科學

61503111,61501467)。李洋,碩士生,主研領域:計算機視覺。吳克偉,講師。謝昭,副研究員。孫永宣,講師。

TP391.41

A

10.3969/j.issn.1000-386x.2017.03.023