卷積神經網絡算法的比較探究

蔣承知+于起+葉文強+甘凇元

摘 要 機器學習的興起使得計算機在處理龐大數據時多了一種強有力的手段,尤其計算機在識別大數據量圖像時與計算機視覺技術相結合,使得圖像識別等人工智能運用更加快速。深度學習發展和延伸了傳統機器學習,使得計算機能像人類大腦一樣用通過感受視取圖像特征。卷積神經網絡改善了傳統神經網絡的功能,通過權值共享技術減少網絡訓練參數的數量,采用下采樣技術避免了傳統神經網絡易于過擬合等缺點,因此卷積神經網絡在人臉識別,語音識別等領域有了廣泛的運用。隨著技術的發展,卷積神經網絡也衍生出了許多性能優良的網絡結構框架。本文主要探究R-CNN和Fast-R-CNN進行圖像識別上的性能分析。

【關鍵詞】深度學習 卷積神經網絡 權值共享 下采樣 R-CNN Fast-R-CNN

1 緒論

隨著電子信息技術的快速發展,芯片的設計與生產進入了納米時代,計算機的計算能力與計算速度得到了空前的提高,但是人們的需求是無限的,要求計算機能更加任性化的服務于我們的生活,這也就要求計算機本身能像人一樣識別與感知周圍的環境,并對復雜的環境做出正確的判斷。而圖片信息是我們周圍環境最直觀的,最容易獲取的信息,要求計算機能對為的環境做出識別與判斷也就要求計算機能夠智能的識別圖像信息。深度學習是機器學習中的一個新的研究領域。通過深度學習的方法構建深度網絡來抽取目標特征進而識別周圍的環境。卷積神經網絡對圖像的處理具有平移,旋轉,扭曲不變的優良特性。在處理圖像是更加快捷和便利。卷積神經網絡使得計算機在感知識別周圍環境的能力有了巨大的提升,使得計算機更加智能。卷積神經網絡擁有強大的特征提取能力,使得其在圖像分類識別,目標跟蹤等領域有著強大的運用。

1.1 國內外研究現狀

1986年,Rumelhart和Mc Celland提出BP算法。BP算法反向傳導神經網絡輸出誤差進行訓練神經網絡。通過BP算法,神經網絡能夠從大量訓練數據中的學習到相關統計信息,學習到的數據統計信息能夠反映關于輸入-輸出數據模型的函數映射關系。

自2006年以來,Geoffery Hinton教授提出深度信念網絡。從此深度學習在學術界持續升溫。深度學習不僅改變著傳統的機器學習方法,也影響著我們對人類感知的理解,迄今已在語音識別和圖像理解等應用領域引起了突破性的變革。各種相關的算法和模型都取得了重要的突破,使得深度學習在圖像分類,語音識別,自然語言處理等領域有廣泛的運用。

2013年百度成立百度深度學習研究院以來我國的人工智能領域取得了長足的進步。在人工智能專家吳恩達的帶領下,百度陸續推出一系列人工智能產品,無人駕駛技術,DuerOS語音交互計算平臺,人臉識別技術,美樂醫等優秀產品。此外Imagenet圖像識別大賽中也誕生了一系列經典的神經網絡結構,VGG,Fast-R-CNN,SPP-net等等,可以說人工智能技術在近幾年得到了空前的發展。

2 深度學習概述

深度學習是機器學習的一個新方向,通過學習樣本數據內在規律和深層特征深度,深度學習神經網絡能夠像人一樣有分析和學的能力,尤其在文字處理,圖像識別,語音等領域更加突出。能夠自主學習一些新的東西。目前深度學習使用的典型技術是通過特征表達和分類器來進行目標識別等任務的。并在語音識別、圖像處理、機器翻譯等領域取得很多成果。

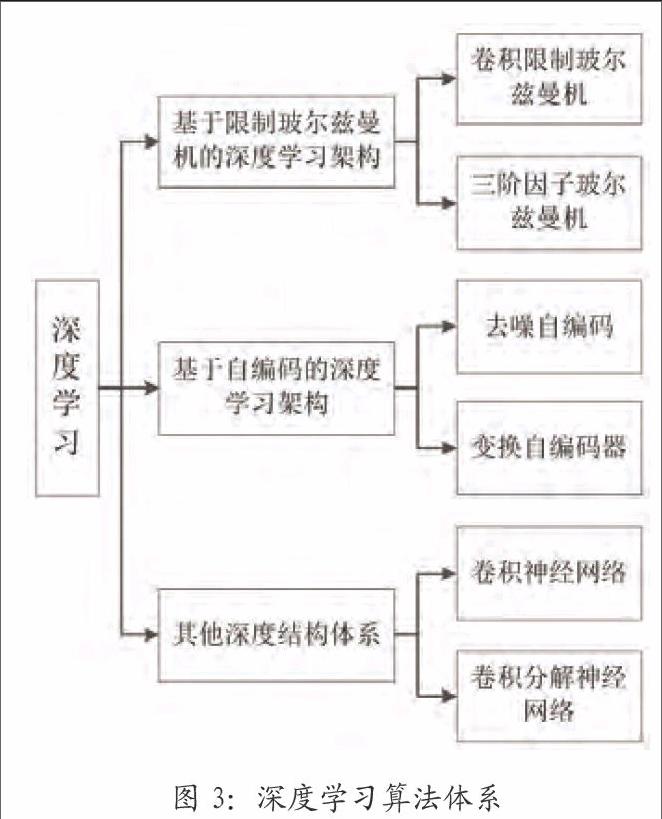

深度學習不同于以往的淺層學習,淺層學習模型值包含一個隱藏層,或者不存在隱藏層,深度學習則是由很多隱藏層組成的,上一層的輸出作為下一層的輸入,實驗對輸入信息進行分級表達。目前深度學習框架主要包含三種深度學習框架,如圖1、2、3所示。

3 卷積神經網絡

卷積神經網絡的結構層次比傳統的神經網絡復雜,卷積神經網絡包含大量的隱藏層,相鄰的卷積核或者下采樣核采用局部感受野全鏈接,神經元權值共享的規則,因此卷積神經網絡訓練參數的數量遠比傳統神經網絡少,卷積神經網絡在訓練和前向測試的復雜度大幅度降低,同時也減少了神經網絡訓練參數過擬合的幾率。卷積神經網絡主要有兩部分,分別是卷積核和下采樣核。卷積核主要對上一層的圖像進行卷積運算,提取圖像特征,下采樣核則是對上層的數據進行將為處理,減少神經網絡的復雜度。

卷積神經網絡中每一個神經元的輸入與前一層的局部感受野相連,提取局部感受野的特征,比如圖像的輪廓,顏色等特征,而這些特征不僅包括傳統人類能理解的特征,也包括神經網絡自身能夠識別的特征,卷積核全職共享,因此這些特征提取與圖像的位置無關。

圖4是經典的LeNet5卷積神經網絡架構,LeNet5架構中卷積核和下采樣核交替出現,下采樣核及時的將卷積核生成的特征向量進行降維,減少神經網絡的運算量。LeNet5算法在1962年幼Hubel等人提出,在識別手寫數字mnist中有極高的準確率。

4 R-CNN、Fast-R-CNN對比分析

卷積神經網絡在對圖像進行識別具有平移,旋轉,扭曲不變的優良特性,并且能夠實現高準確率識別圖像,但是在現實生活運用中往往需要神經網絡標記出目標的相對位置,這是傳統卷積神經網絡不具備的功能。因此在前人傳統卷積神經網路基礎上對卷積神經網絡進行改進,產生了具有對圖像中目標進行識別和定位的卷積神經網絡R-CNN,Fast-R-CNN等改良算法。

4.1 R-CNN

R-CNN為Region Convoluntional Neural Network的縮寫即對圖像進行局部區域的卷積處理,其核心思想主要是利用候選區圖像對物體探測中位置信息進行精確處理和利用監督式預訓練和區域特殊化的微調方法,代替了傳統的非監督式預訓練和監督式微調。

在CNN中,全連接層輸入是固定大小的,因此R-CNN用計算機視覺算法將每一張圖片分割成1000-2000張的候選區圖片后,要將這些候選區圖片進行變換,生成固定大小的候選圖片,在訓練提取特征時一般采用經過預訓練的模型參數進行finetuning,為了增加訓練樣本,模型在也將生成的候選框以及標定的標簽作為訓練樣本進行訓練。R-CNN采用SVMs分類器對特征向量進行分類,在訓練SVMs時將候選框經過卷積神經網絡提取的特征和SVM標定結果輸入到SVMs分類器訓練分類器模型。而在測試時將圖像全部候選框經過卷積神經網絡提取的特征輸入到SVMs分類器中,得到每一類的評分結果。但是R-CNN在處理一張圖片是要處理需要對一張圖片1000-2000個候選區圖像進行前向運算,保存所有后選取圖片的特征值,要求計算硬件有大量的存儲空間,同時處理每一張圖片的時間也會增加。由于訓練集龐大,本文采用hard negative mining method方法提高存儲的利用率。

R-CNN的體現出了極大的優勢,其中MAP也可以大幅度提高,但是正如本文上述,R-CNN計算的時間成本很大,達不到實時的計算效果,R-CNN在對候選區進行處理時會使得圖像失真,部分信息丟失。

4.2 Fast-R-CNN

Fast-R-CNN則是再次改進的一種基于卷積神經網絡目標跟蹤定位算法。相比于R-CNN,Fast-R-CNN從單輸入變為雙輸入,在全連接層后有了兩個輸出,引入了Rol層。

Fast-R-CNN在運行的時候同樣會生成大量的候選區,同時將原始的圖片用卷積神經網絡進行特征提取,將原始圖片提取的特征與生成的候選區坐標送入Rol層為每一個候選區生成一個固定大小的特征向量。最后將Rol生成的特征向量全連接層產生最終的LOSS。Fast-R-CNN中的LOSS采用多LOSS模式,SoftMax LOSS用于計算K+1分類的損失,K為第K個目標,1為背景;Regression LOSS計算候選區的四個角的坐標。

Fast-R-CNN在MAP上有了大幅度的提升,速度也得到了提升,但是在計算候選區是仍存在瓶頸,這也是限制Fast-R-CNN速度的因素。

5 實驗測試

對于本文提出的卷積神經網絡識別圖像定位圖像目標算法R-CNN,Fast-R-CNN,在本章給出實驗結果。實驗平臺為基于Linux系統的debian8下運行caffe進行訓練,采用顯卡K620進行實驗。

訓練模型初始化參數在是服從高斯隨機分布,R-CNN采用的網絡結構如圖7所示,Fast-R-CNN的網絡結構如圖8所示。

本次實現的訓練樣本為錄制實驗室視頻數據,將視頻數據轉換成幀圖片,對每張圖片數據進行裁剪,裁剪后圖像大小在256*256,共有500張,再將裁剪后的圖片進行旋轉,平移,扭曲,鏡像,加噪聲等處理,最后生成144萬張樣本圖片,其中136.8萬張圖片作為訓練樣本,7.2萬張作為測試樣本。

6 總結

在目標識別定位領域,卷積神經網絡具有強大的圖像處理能力,對圖像的識別定位具有很高度平移,旋轉,扭曲不變形的優良性能。卷積神經網絡架構R-CNN和Fast-R-CNN都有強大的圖像處理能力。Fast-R-CNN在識別準確率上比R-CNN高。R-CNN算法復雜,對一張圖片需要進行1000-2000次的卷積運算,特征重復提取。因此在訓練和前向測試時,R-CNN用的時間長,不能很好的適用于處理實時圖片數據,尤其視頻數據。R-CNN在對每個候選區進行特征提取之后需要將提取的特征向量存入內存,降低訓練測試時間的同時也需要耗費大量內存。因此從各方面分析可知,Fast-R-CNN性能優于R-CNN。

參考文獻

[1]謝寶劍.基于卷積神經網絡圖像分類方法研究[D].合肥工業大學,2015.

[2]鄭胤,陳權崎,章毓晉.深度學習及其在目標和行為識別中的新進展[J].中國圖象圖形學報,2014(02):175-184.

[3]陳先昌.基于卷積神經網絡的深度學習算法與運用研究[D].杭州:浙江工商大學,2006(04):603-617.

[4]李彥冬,郝宗波,雷航等.卷積神經網絡研究綜述[J].計算機應用,2016.

[5]Gibson.J J.The perception of the Visual World[J].Cambridge,England,1950.

[6]HORN B,SCHUNCK P.Determining optical flow[J].Artificial Intelligence, 1981,17:185-203.

[7]R.Girshick,J.Donahue,T. Darrell,and J.Malik,“Rich feature hierarchies for accurate object detection and semantic segmentation,”in CVPR,2014

[8]Ross Girshick,Wicrosoft Research. Fast R-CNN,.

[9]R.Girshick.Fast R-CNN. arXiv:1504.08083,2015.

作者單位

東北大學信息科學與工程學院 遼寧省沈陽市 110819