基于視覺詞袋模型的羊絨與羊毛快速鑒別方法

路 凱,鐘躍崎,2,朱俊平,柴新玉

(1. 東華大學 紡織學院,上海 201620;2. 東華大學 紡織面料技術教育部重點實驗室,上海 201620)

?

基于視覺詞袋模型的羊絨與羊毛快速鑒別方法

路 凱1,鐘躍崎1,2,朱俊平1,柴新玉1

(1. 東華大學 紡織學院,上海 201620;2. 東華大學 紡織面料技術教育部重點實驗室,上海 201620)

為快速準確地鑒別羊絨和羊毛,提出一種基于視覺詞袋模型的鑒別方法。該方法使用羊絨和羊毛的光學顯微鏡圖像作為實驗樣本,將纖維鑒別問題轉化為圖像的分類問題。首先對光學顯微鏡圖像進行預處理以增強特征,然后從纖維形態中提取局部特征并生成視覺單詞,再依據視覺單詞對纖維圖像進行分類,從而達到鑒別纖維的目的。使用了4 400幅纖維圖像作為數據集,從中選擇不同的羊絨和羊毛的混合比作為訓練集和測試集,得到的識別率最高為86%,最低為81.5%,鑒別1 000根纖維需要的時間小于100 s,訓練好的分類器可保存并用于后期的檢測工作。

羊絨;羊毛;視覺詞袋模型;圖像處理;快速鑒別

羊毛和羊絨的鑒別一直是紡織行業的難題,目前常用的鑒別方法有光學顯微鏡法[1]、掃描電鏡法[2]、近紅外光譜鑒別法[3]、DNA分析法[4]。在顯微鏡下觀察到的動物纖維表面形態差異可用于纖維鑒別[5],但通常只有經過專業訓練的專業人員才能比較準確地觀察到二者的差別。Tang等[4]提出一種DNA分析的方法,采用熒光定量聚合酶鏈式反應(PCR)引物與探針和羊絨羊毛的線粒體12S核糖體進行反應,通過建立對數曲線來計算羊絨羊毛的混合比例。該方法客觀有效,但檢測過程中需要比較精密的儀器,且只能由專業人員操作,成本相對昂貴。總而言之,上述幾種方法耗時長,成本高,而且往往需要專業人員操作,因此目前急需一種成本低、速度快、操作簡單、精確度較高、穩定可靠的檢測方法。近年來有一些基于圖像處理技術的羊絨與羊毛鑒別方法[6-7],通過測量纖維表面形態的一些特征測量如纖維直徑、鱗片高度、鱗片厚度等值來識別纖維,但這些特征的測量工作難度比較大,如鱗片的厚度在光學顯微鏡下很難檢測,并且近年來羊絨和羊毛纖維變異程度很大,例如羊毛羊絨的直徑等特征差異越來越小,僅僅依靠挑選幾個特征已經不能滿足實際工作中的鑒別需要。

視覺詞袋模型在圖像分類與目標檢測中具有良好的效果,本文將該模型引入到纖維鑒別領域,提取顯微鏡圖像中纖維的形態特征并依據這些特征對纖維進行分類。本文方法將纖維檢測技術與計算機視覺技術相結合,從大樣本中提取特征,從而達到客觀、快速地鑒別纖維的目的。

1 研究方法

本文方法的思路是通過羊絨羊毛纖維的圖像來提取特征,并以此鑒別2種纖維圖像,這就將纖維的鑒別問題轉化為纖維圖像的分類問題。人們對圖像分類和物體識別已經做了許多研究,在諸多方法中,視覺詞袋模型(Bag-of-Visual-Word,簡稱BoVW)是比較受關注的方法,該方法原理簡單,效果好。首先需要對獲取的顯微鏡圖像進行預處理,然后介紹如何使用BoVW模型來表示纖維的特征,接下來使用支持向量機(SVM)對纖維圖像進行鑒別分類,最后通過預測結果和真實值的比較來評價識別效果。

1.1 圖像預處理

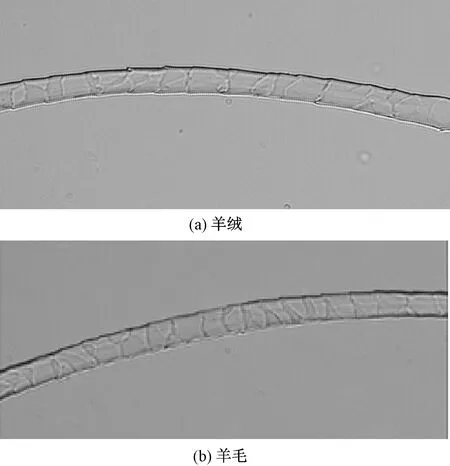

圖1(a)、(b)示出常見的羊絨和羊毛纖維的顯微鏡照片。由圖可看出,二者外觀形態比較接近,顯然直徑等單一特征已經不能作為識別依據。另外由圖1可看出,2種纖維表面的鱗片邊緣很不清晰,需要對圖像進行增強處理。在拍攝的圖像中不可避免地會出現一些氣泡和雜質,這些干擾信息要盡量去除,而且還要盡可能地保留纖維有效信息。接下來的預處理過程將會增強纖維圖像表面,并且可去除纖維背景。

圖1 原始羊絨和羊毛顯微鏡圖像(×500)Fig.1 Original microscope images of cashmere and wool(×500). (a) Cashmere; (b) Wool

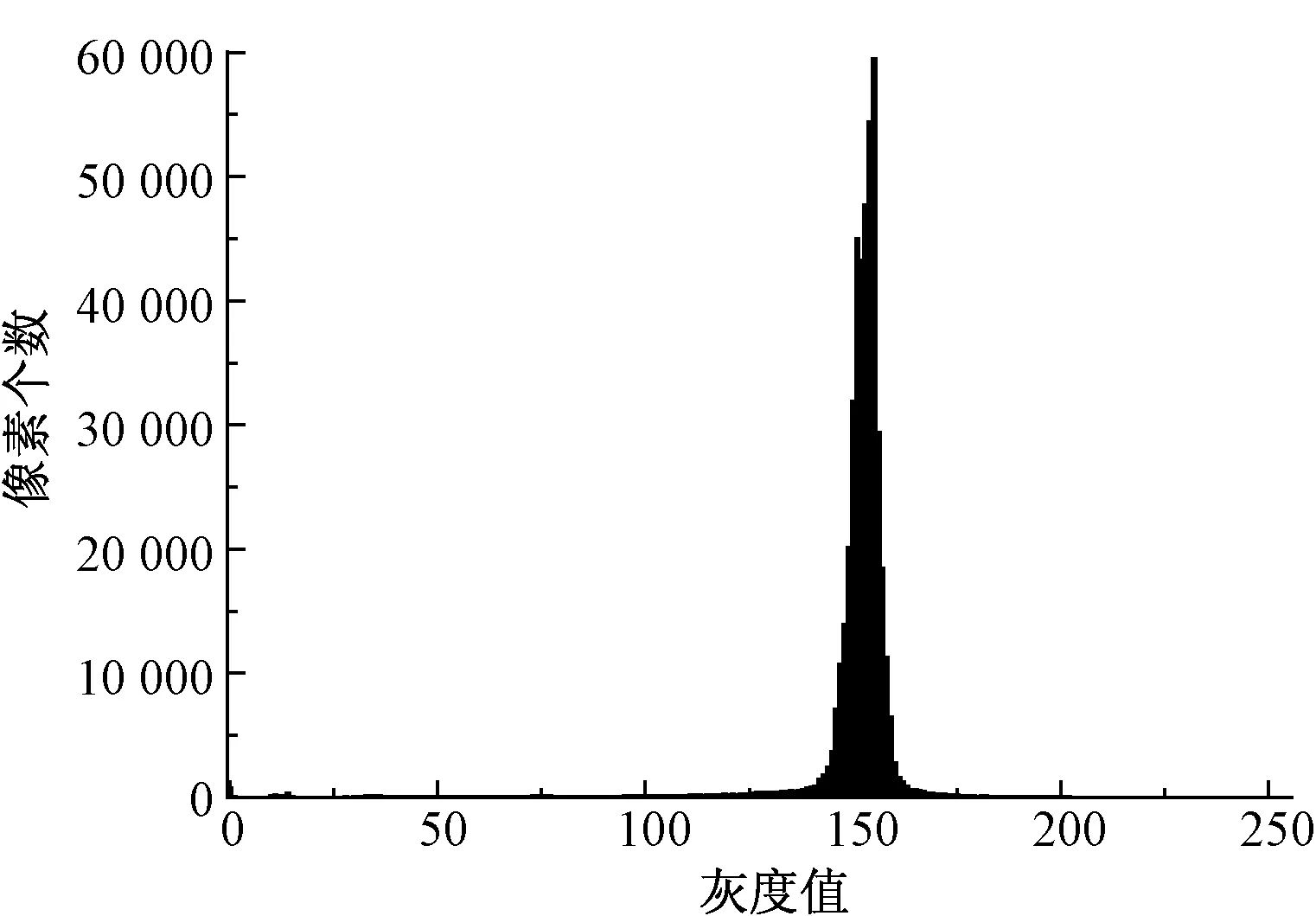

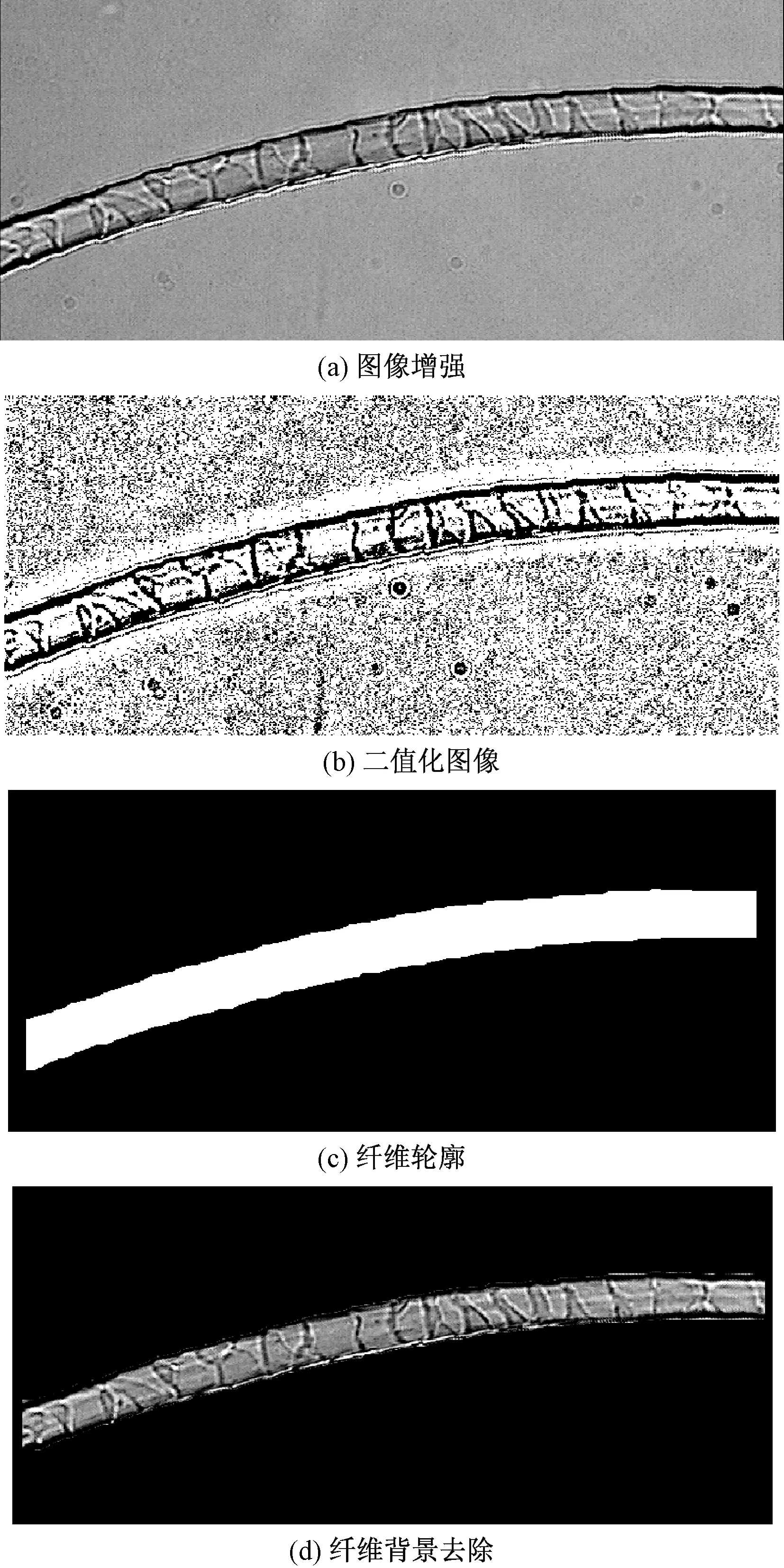

羊絨和羊毛纖維圖像的預處理過程相同,以圖1(b)中的羊毛纖維為例。首先將原始圖像轉換為灰度圖像,然后使用對比度拉伸、直方圖增強和濾波增強等3種方法對圖像進行增強處理。可發現,對比度拉伸算法效果更好,能使圖像中纖維表面的鱗片邊緣清晰度明顯增強。圖2示出圖1(b)轉化成灰度圖的直方圖,可看到圖像中像素的灰度值集中在很小的區域,在灰度值150附近的區域,通過對100根隨機挑選的纖維圖像統計發現,圖像95%以上的像素灰度值集中在[115,180]區間,將此區間的灰度值拉伸到[0,255]這個范圍,處理結果如圖3(a)所示。可看到圖像中纖維表面信息已經有了明顯增強。

圖2 羊毛纖維圖像灰度直方圖Fig.2 Gray histogram of wool image

接下來,使用自動局部閾值方法將纖維圖像二值化,如圖3(b)所示。可看到圖像中噪聲比較多,這里的目的是僅獲取纖維本身的圖像,需要去掉圖像中其他部分。使用圖像形態學操作,先通過“開”操作除掉圖中的孤立單像素小塊,然后計算圖中像素點連通區域的面積,將小于面積最大值一半的小塊去掉,再填充孔洞,并對所得圖像求反,最后去掉圖像邊界四周的幾行像素,得到的結果就是二值化的纖維輪廓,如圖3(c)所示;接下來將增強的圖像和輪廓二值圖進行形態學中的“與”操作,即圖3(a)與圖3(c)相與,得到去掉背景的纖維增強圖,如圖3(d)所示。

圖3 羊毛圖像預處理(×500)Fig.1 Image pre-processing of wool fibers(×500).(a) Image enhancement; (b) Binary image; (c) Binary contour; (d) Background removal

1.2 視覺詞袋模型

BoVW的主要思想是創建一個由視覺單詞組成的詞典,其中視覺單詞是對纖維圖像中檢測到的關鍵點的描述,也就是圖像中纖維表面的特征表示,然后統計纖維圖像中的視覺單詞在詞典中出現的頻率,并將其轉換為直方圖,用直方圖向量表示纖維的特征。BoVW方法包括以下幾個步驟:1)特征提取;2)生成視覺單詞;3)建立視覺詞典;4)生成直方圖;5)分類。下面對模型的主要步驟進行說明。

1.2.1 特征提取

圖像的特征提取就是通過獲取目標圖像中的必要信息,借助于這些信息可有效區分其他類別圖像。特征提取是圖像分類與識別的前提,尺度不變特征變換(SIFT)是著名的方法之一,其對尺度縮放、亮度、旋轉保持不變,對亮度、仿射變換、噪聲也有較強魯棒性。這里使用SIFT獲取的關鍵點用128維向量表示[8-9]。SIFT方法包括以下步驟:1)尺度空間關鍵點檢測;2)關鍵點定位;3)關鍵點的方向確定;4)關鍵點的描述。

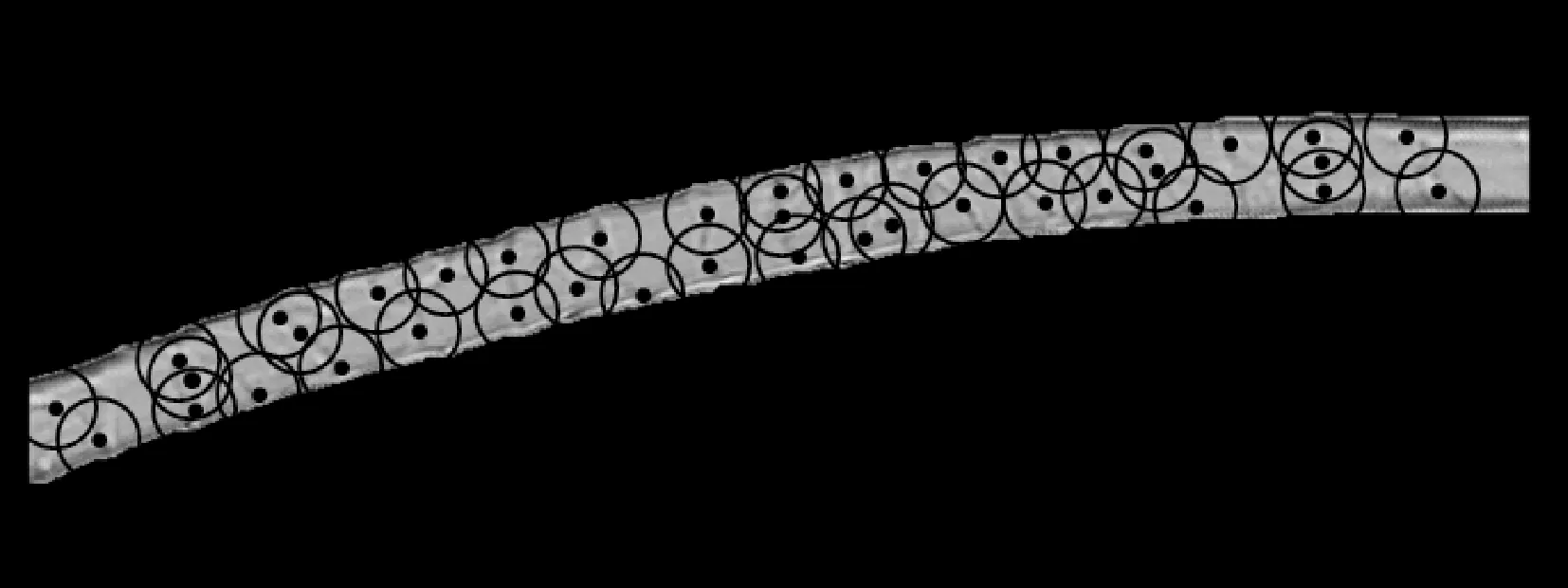

按照上面各個步驟可得到纖維圖像中的關鍵點,如圖4所示,關鍵點用圓圈中心表示。

圖4 纖維圖像的關鍵點檢測Fig.4 Keypoints detection

1.2.2 視覺單詞與詞典的生成

接下來需要將這些關鍵點轉換為視覺單詞。視覺詞袋模型中使用聚類算法對獲得的關鍵點進行聚類,得到的聚類中心稱為視覺單詞,其中K-means聚類是最常用的方法。K-means方法的主要思想是在集合X={x1,x2,…,xi,…,xn}中找到k個聚類中心{m1,m2,…,mj,…,mk},使得集合X中的點到其所屬聚類中心的歐式距離最小,公式為

(1)

式中Wn表示集合中的點xi到聚類中心mj的歐式距離,聚類中心就是前面所述的視覺單詞,對應于圖像中的特征。這里的視覺單詞就是纖維圖像表面圖案的各個特征,而一組圖像的視覺單詞的集合就是視覺詞典,表示為

V={w1,w2,…,wi,…,wM}

(2)

式中:V表示視覺詞典;wi為詞典中第i個視覺單詞;視覺單詞總數為M。將圖像中的視覺單詞在視覺詞典中出現的次數直方圖轉換為向量,并用其描述圖像,記為

BI=[t1,t2,…,ti,…,tM]

(3)

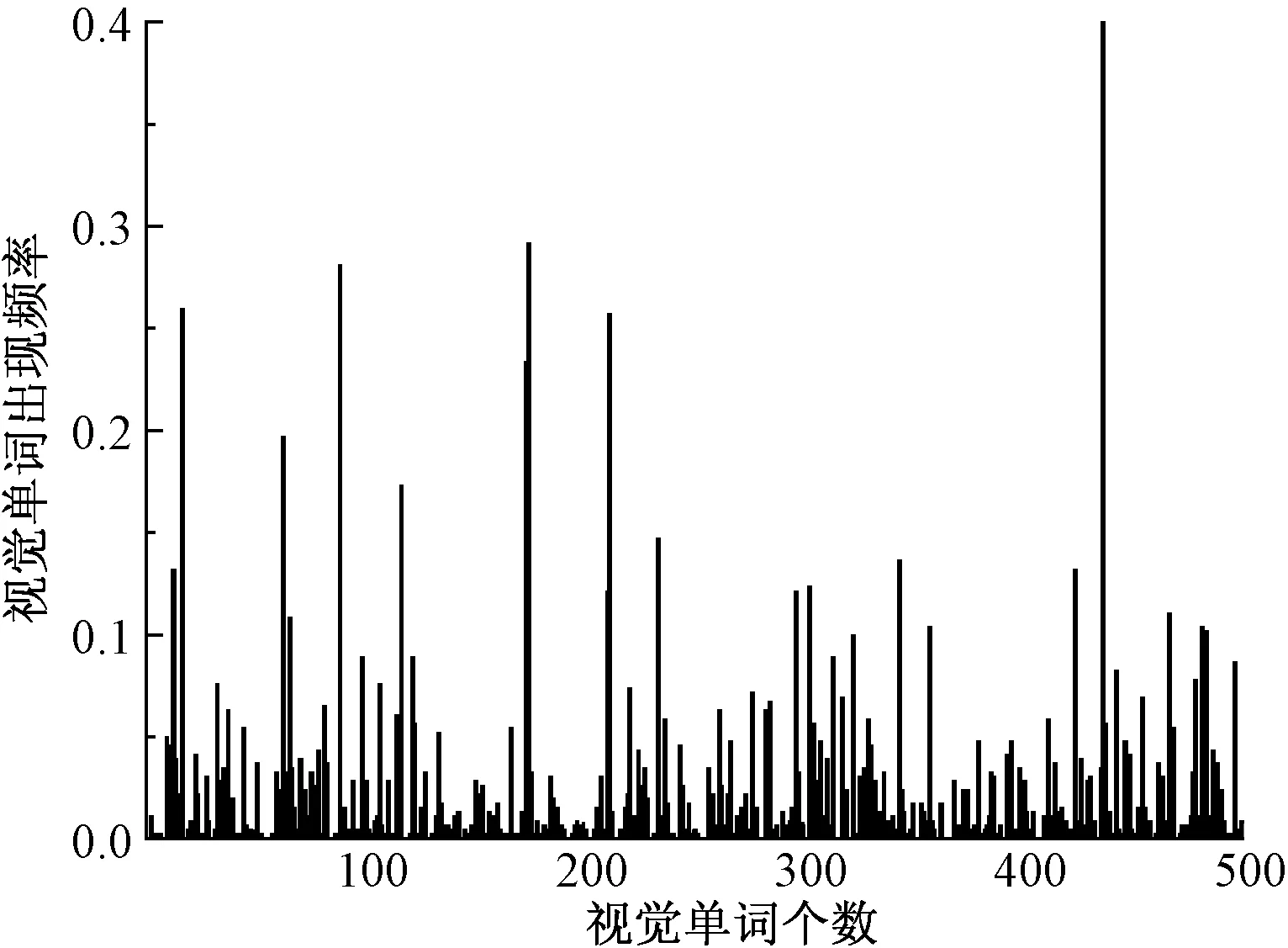

式中:BI表示數據集中第I個圖像的視覺單詞直方圖;ti表示視覺單詞wi在圖像中出現的次數。選取前500個視覺單詞作為描述圖像的特征,結果如圖5所示。

圖5 視覺單詞直方圖Fig.5 Visual word histogram

1.2.3 空間金字塔

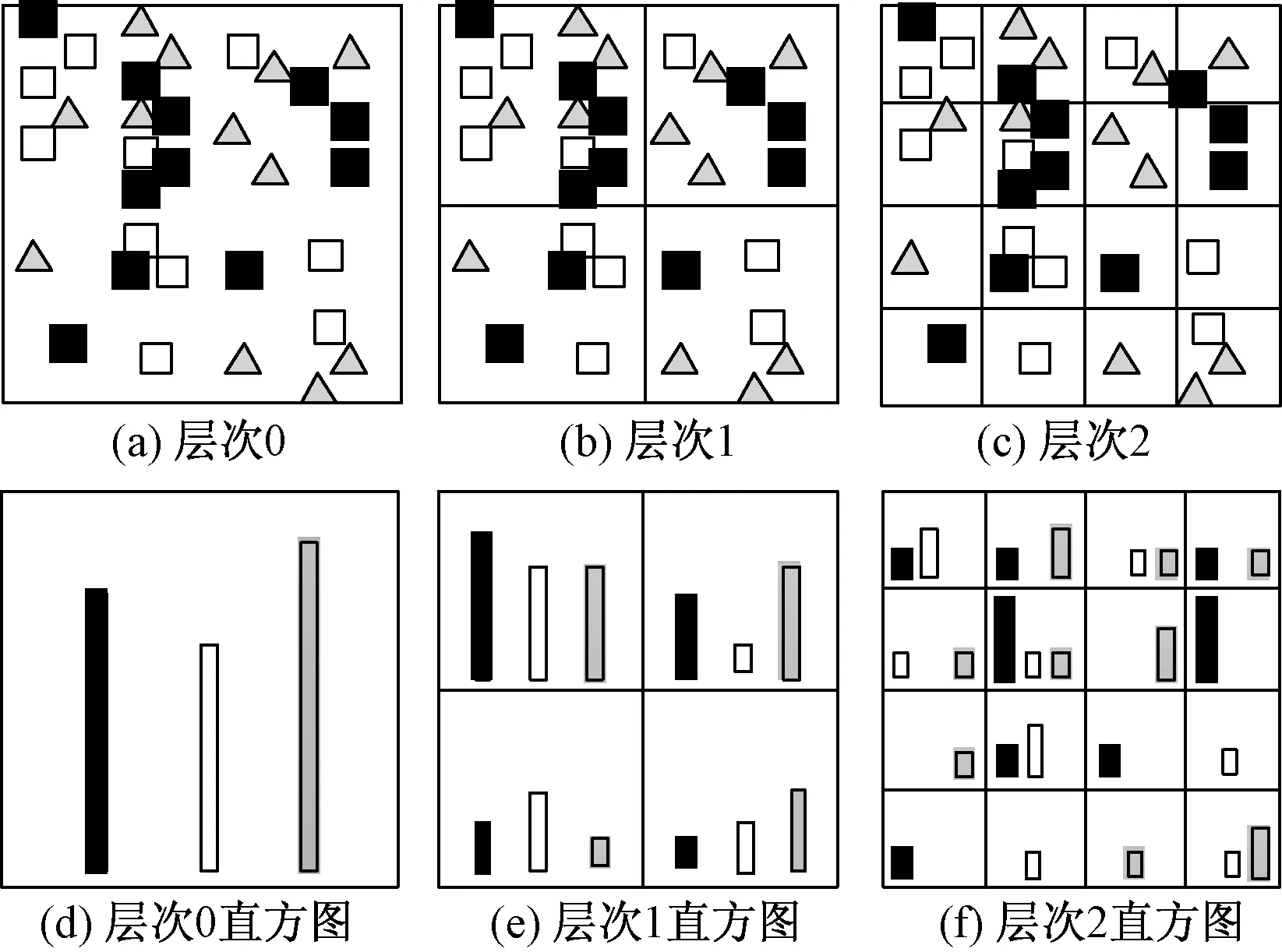

借助空間金字塔匹配方法,可使得BoVW模型在計算視覺單詞時獲得特征點相對的空間位置關系,這樣可更好地描述圖像特征。

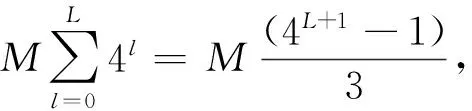

空間金字塔主要思想是在不同分辨率的層次上來計算圖像中的視覺單詞的匹配程度,將圖像分為多層(0,1,…,l,…,L),L為層數,0≤l≤L,第l層將圖像水平和垂直方向都分為2l個方格,則圖像l層共有22×l(4l)個方格[10]。統計每個方格中的視覺單詞直方圖,如圖6所示。

圖6 空間金字塔示意圖Fig.6 Schematic diagram of spatial pyramid.(a)Level 0;(b)Level 1;(c)Level 2; (d) Histogram of level 0;(e)Histogram of level 1;(f)Histogram of level 2

2 實驗過程

實驗樣品是鄂爾多斯羊絨集團提供的20批羊絨和24批羊毛纖維,每批次選擇100根纖維,使用蒸餾水清洗后晾干。取纖維放置于清潔的載玻片上,均勻涂抹甘油后加上蓋玻片,由測試中心工程師拍攝。拍攝儀器為北京合眾視野的CU系列纖維投影儀,纖維圖像由安裝在光學顯微鏡上的CCD攝像機獲取,放大倍數為500,每副圖像上有1根纖維。GB/T 16988—2013《特種動物纖維與綿羊毛混合物含量的測定》中規定,纖維總數不少于1 500根,這里選擇的纖維圖像總數為4 400張,其中包含2 000根羊絨圖像和2 400根羊毛圖像,實驗的數據集從樣本容量中選擇不少于1 500根作為數據集。按照前面提到的方法流程進行實驗。首先,原始纖維圖像要按照1.1的方法進行圖像預處理,將纖維圖像增強,并且去掉背景;然后使用文中介紹的BoVW模型生成視覺單詞和視覺詞典,接下來用基于視覺詞典的視覺單詞直方圖向量表示纖維圖像;最后使用SVM對纖維圖像進行分類。

2.1 評估指標

實驗中使用混淆矩陣來評估方法的有效性,總體識別率用準確率的平均值At表示,定義如下。

(4)

(5)

(6)

式中:Ac和Aw分別表示羊絨和羊毛的識別率;Rc和Rw分別表示正確識別羊絨和羊毛纖維的數量;Tc和Tw分別表示樣本中羊絨和羊毛纖維的數量。實驗記錄了訓練和測試所需的時間,采用計算機的處理器為Intel Xeon E5-2620,主頻為2.0 G,內存為8 G。

2.2 結果與討論

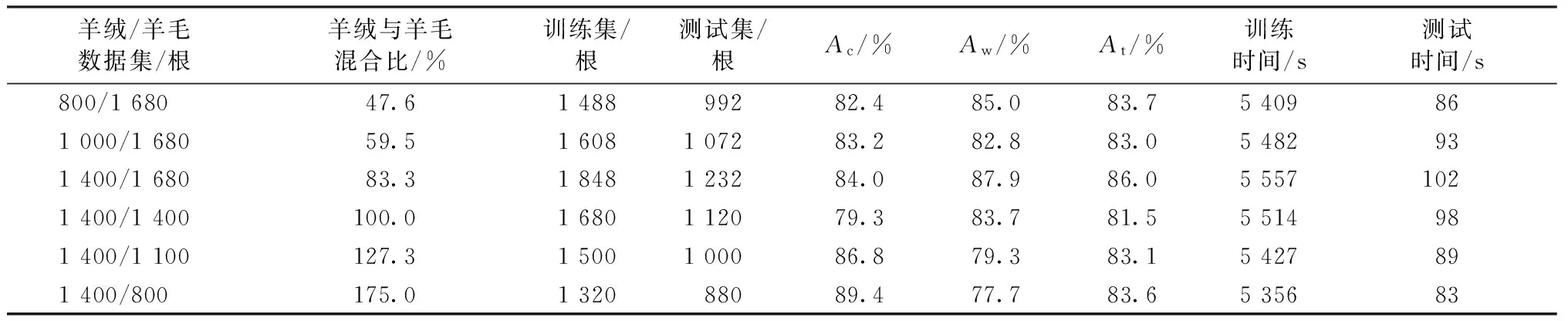

表1示出羊絨與羊毛鑒別結果。實驗中進行的是監督學習訓練,每次從數據集中隨機選擇不同數量和比例的纖維圖像作為訓練集和測試集,訓練集與測試集的比例為6∶4。表中第1列給出了每次選擇的數據集的纖維數量,第2列給出了羊絨和羊毛的混合比。第3~4列為訓練集和測試集的纖維數量,第5~7列分別為測試集中羊絨、羊毛以及平均識別率,第8~9列為訓練和測試所耗費的時間。從表1中實驗結果可看到,在不同的纖維混合比的數據集上,測試集平均識別率最高為86.0%,最低為81.5%,表1中第8列數據表明該方法訓練分類器的時間稍長,但實際應用中分類器是提前訓練好,可保存并多次使用,而鑒別樣本所需時間是表1中最后1列的測試時間,可得知本文方法鑒別1 000根纖維需要時間小于100 s。

表1 羊絨與羊毛鑒別結果Tab.1 Identification results and cashmere and wool

與其他鑒別方法相比,本文方法檢測速度快,適合用于初步鑒別,且樣本來源于光學顯微鏡圖像,成本比較低,易推廣到實踐中使用。

3 結 論

本文提出了一種基于視覺詞袋模型的羊絨羊毛鑒別方法,該方法使用羊絨羊毛纖維的光學顯微鏡圖像,借助于計算機視覺技術中的特征提取及特征描述方法,將纖維鑒別問題轉化為圖像分類問題。通過提取纖維圖像表面特征,并使用視覺單詞來表示纖維特征,然后使用SVM分類圖像,以此來鑒別羊絨羊毛纖維,最后通過實驗驗證該方法的效果。從實驗結果看出本文方法速度快,方便靈活,但識別率不算高,適合用于羊絨和羊毛的初步鑒別,接下來的工作應著眼于如何獲取纖維表面更多有效的特征,從而進一步提高識別準確度。

FZXB

[1] 盛冠忠, 李龍. 關于山羊絨鑒別有關問題的探討[J]. 毛紡科技, 2007(12): 52-55. SHENG Guanzhong, LI Long. Study on distinguishing problem of cashmere fiber[J]. Wool Textile Journal, 2007(12): 52-55.

[2] WORTMANN F J, PHAN K H, AUGUSTIN P. Quantitative fiber mixture analysis by scanning electron microscopy: part V: analyzing pure fiber samples and samples with small admixtures according to test method IWTO-58[J]. Textile Research Journal, 2003, 73(8): 727-732.

[3] ZOCCOLA M, LU N, MOSSOTTI R, et al. Identification of wool, cashmere, yak, and angora rabbit fibers and quantitative determination of wool and cashmere in blend: a near infrared spectroscopy study[J]. Fibers & Polymers, 2013, 14(8): 1283-1289.

[4] TANG M, ZHANG W, ZHOU H, et al. A real-time PCR method for quantifying mixed cashmere and wool based on hair mitochondrial DNA[J]. Textile Research Journal, 2014, 84(15): 1612-1621.

[5] WORTMANN F J, ARNS W. Quantitative fiber mixture analysis by scanning electron microscopy: part I: blends of mohair and cashmere with sheep′s wool[J]. Textile Research Journal, 1986, 56(7): 442-446.

[6] 季益萍, 楊云輝, 黃少君. 基于決策樹算法的羊絨羊毛鑒別[J]. 紡織學報, 2013, 34(6): 16-20. JI Yiping, YANG Yunhui, HUANG Shaojun. Identification of wool and cashmere based on decision tree algorithm[J]. Journal of Textile Research, 2013, 34(6): 16-20.

[7] 石先軍,胡新榮,蔡光明. 基于鱗片紋圖基因碼的羊絨理論識別精度及正誤判率[J]. 紡織學報,2014, 35(4): 5-10. SHI Xianjun, HU Xinrong, CAI Guangming, et al. Theoretical recognition accuracy and error rate for cashmere based on scale pattern gene code[J]. Journal of Textile Research, 2014, 35(4): 5-10.

[8] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2):91-110.

[9] 解文杰. 基于中層語義表示的圖像場景分類研究[D]. 北京:北京交通大學, 2011: 69-77. XIE Wenjie. Research on middle semantic representation based image scene classification[D]. Beijing: Beijing Jiaotong University, 2011: 69-77.

[10] 趙春暉, 王瑩, KANEKO M. 一種基于詞袋模型的圖像優化分類方法[J]. 電子與信息學報, 2012, 34(9): 2064-2070. ZHAO Chunhui, WANG Ying, KANEKO M. An optimized method for image classification based on bag of words model[J]. Journal of Electron & Information Technology, 2012, 34(9):2064-2070.

Rapid identification method of cashmere and wool based on bag-of-visual-word

LU Kai1,ZHONG Yueqi1,2,ZHU Junping1,CHAI Xinyu1

(1.CollegeofTextiles,DonghuaUniversity,Shanghai201620,China;2.KeyLaboratoryofTextileScience&Technology,MinistryofEducation,DonghuaUniversity,Shanghai201620,China)

In order to identify cashmere and wool rapidly and accurately, a method based on bag-of-visual-word was proposed. Optical microscope images of cashmere and wool were taken as experimental samples in this method. The problem of fiber identification was changed to the problem of image classification. Firstly, fiber images were pre-processed to enhance their characteristics. Then, local features were extracted from fiber morphology and these local features were converted to visual words. Fiber images can be classified using visual words mentioned above. The experimental dataset contains 4 400 fiber images. Different mixing ratio of cashmere and wool were selected as train set and test set from the dataset. In this experiment, the highest recognition ratio is 86%, and the lowest is 81.5%. The time required to identify 1 000 fibers is shorter than 100 s. The trained classifier can be saved and used for the late detection.

cashmere;wool;bag-of-visual-word;image processing; rapid identification

10.13475/j.fzxb.20160606906

2016-06-27

2016-11-24

國家自然科學基金資助項目(61572124);中央高校基本科研業務費專項資金資助項目(CUSF-DH-D-2016016);上海市自然科學基金資助項目(14ZR1401100)

路凱(1979—),男,講師,博士生。研究方向為纖維圖像鑒別、紡織圖像技術。鐘躍崎,通信作者,E-mail:zhyq@dhu.edu.cn。

TS 102.3

A