應用卷積網絡及深度學習理論的羊絨與羊毛鑒別

王 飛, 靳向煜,2(. 東華大學 紡織學院, 上海 20620; 2. 東華大學 紡織面料技術教育部重點實驗室, 上海 20620)

應用卷積網絡及深度學習理論的羊絨與羊毛鑒別

王 飛1, 靳向煜1,2

(1. 東華大學 紡織學院, 上海 201620; 2. 東華大學 紡織面料技術教育部重點實驗室, 上海 201620)

為解決羊絨與羊毛纖維圖像難以鑒別的問題,提出一種基于卷積網絡和深度學習理論的鑒別方法。使用sigmoid分類器將卷積深度網絡提取的纖維圖像特征進行粗分類,根據驗證集合驗證結果并記錄網絡的最優權重。根據整體的分類網絡所獲取的權值,對每張樣本圖片使用改進的局部增強整體的網絡模型提取局部特征,并對局部特征和整體特征進行融合,根據這些融合特征建立新的分類網絡。在此基礎上,使用鄂爾多斯標準羊絨與羊毛數據集對網絡進行50輪次的迭代訓練,得到的最優準確率達92.1%。實驗結果表明:采用深度卷積網絡表征纖維,并對羊絨羊與毛纖維圖像進行分類的方法,能夠有效解決羊絨、羊毛等類似纖維鑒別問題;若用于商業檢測,還需更多數據集的驗證。

羊絨; 羊毛; 圖像鑒別; 卷積網絡

由于羊絨和羊毛的物理表征極為接近,二者的鑒別一直是紡織領域的難題。目前業界常用的羊絨與羊毛鑒別方法有掃描電鏡法[1],近紅外光譜鑒別法[2],脫氧核糖核酸(DNA)分析法[3],電子顯微鏡纖維表征傳統計算機技術測量法[4-5]等。傳統的基于計算機圖像處理技術的羊絨與羊毛鑒別方法,通過計算機測量纖維表面形態一些特征的量化值對二者進行鑒別,如纖維直徑、鱗片高度、鱗片厚度等,但是,這些方法對數據的敏感程度高,并且特征的測量工作難度較大。在使用計算機采樣時容易造成數據丟失,同時在還原數值時通過計算會造成數據的污染,此外由于近年來羊絨和羊毛纖維變異程度很大,羊毛與羊絨的直徑、鱗片高度等特征差異越來越小,僅依靠人工篩選很難滿足實際應用中的需要。綜上所述,以上提及的幾種方法通常只有經過專業訓練的專業人員才能夠比較準確鑒別,同時準確率也不足以用于大批量的應用環境,因此,采用精密儀器以及傳統計算機圖像比對方式鑒別羊絨與羊毛具有耗時長、成本高、人工經驗依賴性強等不足。

近年來,以深度學習理論為代表的計算機視覺技術取得了突破性的發展,基于圖像特征的圖像分類與識別已取得了很大進展。本文借鑒Alex-Net[6]圖像分類網絡,提出一種利用部分特征增強整體特征的卷積網絡的羊絨與羊毛鑒別方法,該方法獲取纖維表面的整體特征,并利用調整參數的模型通過整體網絡特征選取局部特征,將整體與局部特征進行融合訓練獲取分類網絡,最后利用獲取到的網絡對這2種纖維進行分類與鑒別。

1 研究方法

采用的策略思路是利用羊絨與羊毛纖維的原始計算機圖像具有不同層次的特征,依據此特征值對2種纖維圖像進行分類,這就可把近似類別纖維鑒別問題轉化為圖像的分類問題并加以解決。人們對圖像分類以及物體識別已做出了突破性的進展,在諸多方法中,卷積網絡[7](convolutional neuron networks, CNNs)是一種對自然圖像分類極為有效的方法,該方法訓練時間稍長,但利用訓練好的網絡進行分類時間效率較高。具體方法為首先需要使用卷積網絡提取原始圖像特征,然后介紹網絡的構成,再利用所獲取的網絡,調整參數模型對分類網絡進行局部特征提取,最后通過混合使用局部特征和整體特征,進行特征增強,最后通過預測值和樣本真實標簽值的比較來評價識別效果。

1.1 圖像特征與卷積網絡

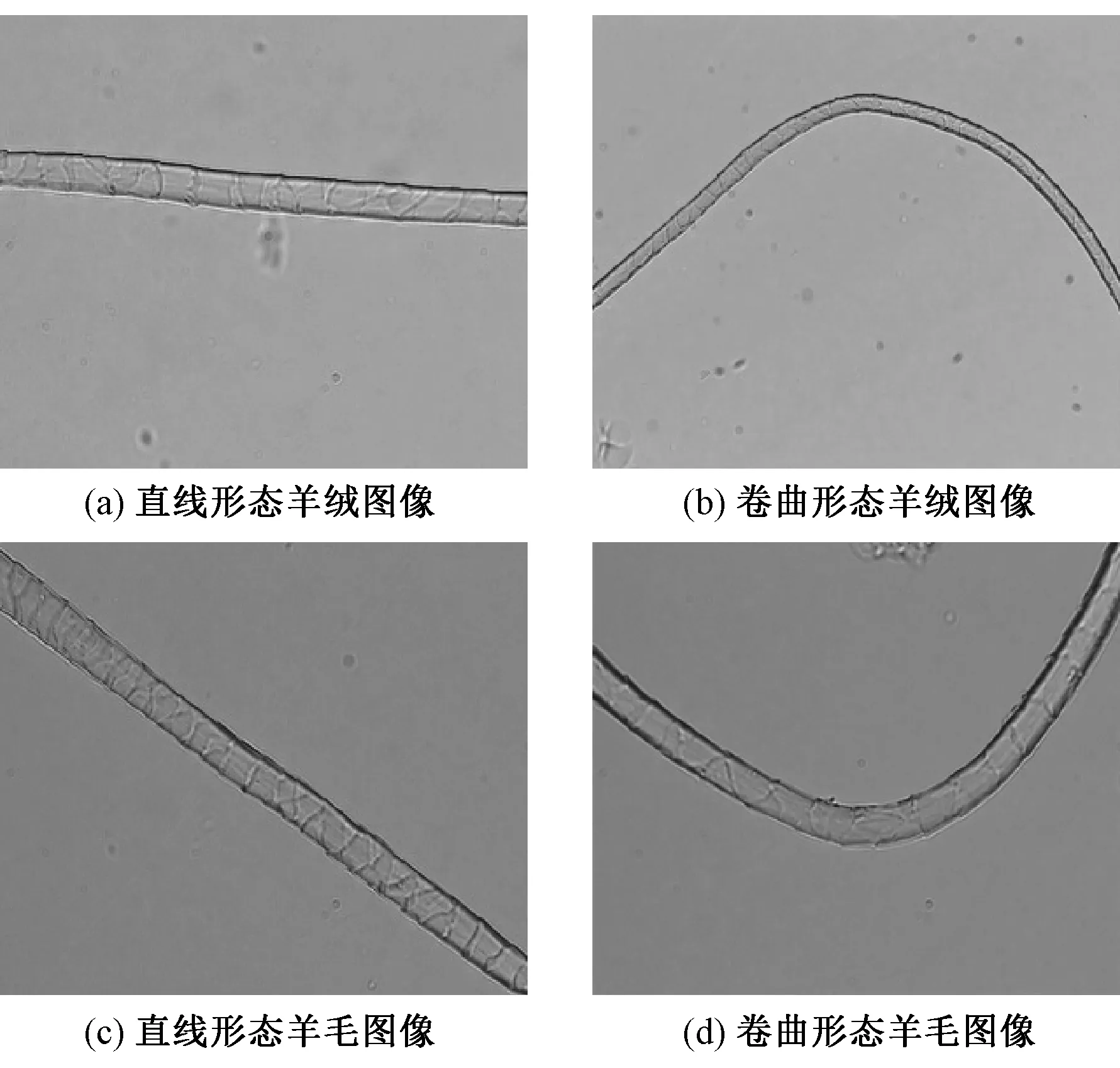

圖1示出常見的彎曲度差異較大的2種羊絨及羊毛纖維。2種纖維從二維圖像角度觀察,外觀形態比較接近,由于不同范圍內的直觀特征如直徑、鱗片厚度等人工選擇的一些特征很難作為量化區分的直接依據。同時,由于拍攝的環境并非嚴格無塵環境,所以樣本圖像存在若干肉眼可分辨的雜質,如果使用傳統的圖像比對方法,這些內容需要盡量剔除。同時由于樣本存在不規則的展開形態,并且傳統圖像灰度圖的處理方式不能有效利用圖像的顏色及光澤度信息,所以傳統的圖像比對方法不適用于纖維的細分類。

圖1 整根的羊絨和羊毛不同形態的顯微鏡圖像Fig.1 Object-level microscope images of cashmere and wool.(a) Straight cashmere; (b) Curl cashmere; (c) Straight wool; (d) Curl wool

由于卷積網絡采用模擬人類識別物體的分層方式,鑒于樣本的原始特征存在背景包含信息較少且不具有典型的邊緣、層次等內容,同時樣本圖片也是自然圖片,所以使用卷積網絡進行特征提取不需要對樣本圖片進行過多的人工干預。

卷積網絡是以像素圖像為基礎輸入單位的前饋型神經網絡。其理論主要由生物學中的感受野啟發得到。卷積網絡有局部連接、空間次采樣以及權值共享3個主要特性。它的出現大大降低了以往神經網絡的計算難度,同時也產生了在一定程度上的抗平移、抗變形以及抗扭曲的特性。由于以上幾點原因,卷積神經網絡用于圖像的處理尤為合適。

同時考慮到具體羊絨與羊毛分類的任務,每個輸入圖像由一組像素的3個通道灰度值所組成,輸出為2個類別的后驗概率分布。針對自然圖像的不同形態處理,卷積網絡具有平移、縮放、旋轉等不變性特點,所以使用卷積網絡處理不同形態的細分類羊絨、羊毛纖維圖像不需要進行過多的人工干預處理。

1.2 卷積網絡模型選取

卷積網絡從全連接網絡演化而來,受生物學中接受視覺信息的局部接收野啟發,采用算法對全連接網絡中的信息進行選擇傳遞,構成了卷積網絡。卷積網絡分類分為以下幾個步驟:卷積層的使用及特征的提取;下采樣層的選用;通過訓練樣本集進行訓練;使用訓練所得網絡對測試樣本集進行分類預測并記錄結果。

1.2.1卷積網絡輸入層及處理

鑒于計算量及硬件限制,在實驗中采用的樣本圖片集合被處理為300像素×300像素。根據鄂爾多斯羊絨鑒別工程師提供的先驗知識,樣本圖像的光澤也是鑒別羊絨與羊毛的關鍵要素,所以本文使用R、G、B 3個通道處理數據[8],而不是如傳統圖像比對采用灰度圖像。這樣,一個輸入計算單元的計算數據量為300像素×300像素×3通道數×1 Byte即270 kByte。解決這個問題的辦法是使用部分聯通特征的卷積網絡降低其計算量。由于自然圖像有其固有特性即圖像的一部分的統計特性與其他部分是基本一致的。

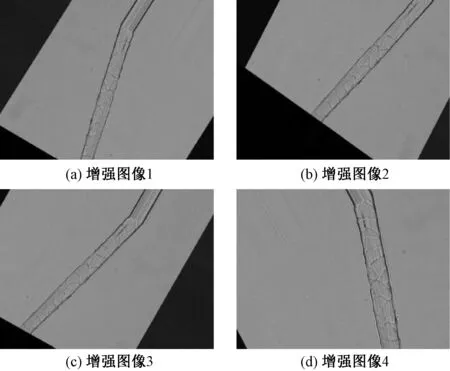

同時,實驗使用4 800張的訓練數據集合對于使用深度網絡進行二分類的比賽,kaggle[9]數據競賽平臺的貓狗大戰等圖像集合在數量級上仍有很大的差距,因此,對數據進行增強處理是防止由于網絡深度加深而導致的數據過擬合情況發生的關鍵環節。本文采用了4種方式進行了圖像的生成增強。分別是隨機平移、隨機角度旋轉、隨機縮放尺寸、隨機裁剪。

針對每個樣本均采用上述隨機變換的方式增強后生成20個樣本。如此,羊毛與羊絨的數據集合擴展到了80 000訓練樣本集合。可達到二分類的數量要求,從而防止數據過擬合情況的發生。經過生成增強方法處理的羊毛樣本樣例如圖2所示(本文僅選取了編號為1、2、3、4的圖像為例,羊絨的增強處理方法與此相同)。

圖2 單根羊毛纖維樣本生成增強處理樣例Fig.2 A single wool fiber sample instance after processing enhance-generating.(a) Enhanced image 1; (b) Enhanced image 2; (c) Enhanced image 3; (d) Enhanced image 4

在實驗訓練中,對每個樣本進行如圖2所示的增強處理能夠有效地降低樣本的過擬合。

在輸入處理中,圖像以二維矩陣通過R、G、B 3個通道被算法拉長成為1個列向量輸入到網絡中。雖然神經網絡中激活函數通常采用logistic激活函數,但針對所處理纖維樣本特征及計算量的考慮,所選用的是簡單非線性RELU激活函數。RELU激活函數的公式如下:

(1)

在使用的卷積網絡中每層使用了32到64不等數量的濾波矩陣,對同一副纖維圖像進行特征提取。這樣處理也能夠把不同的濾波矩陣所輸出的內容理解為樣本圖像經不同特征提取后所得特征的集合。過濾矩陣的運算結果也就是特征提取所得的矩陣為特征映射(feature map),所以可使用較為深層的網絡分層次提取纖維圖像的不同層次的特征,為網絡最后的分類節點提供數據基礎及支持。

1.2.2下采樣層的選用

在上述卷積層提取了圖像的特征之后,接下來所要進行的工作是使用這些特征值進行分類,但是,若利用所獲取的所有特征去訓練分類器,會出現計算維度過大的問題。

同時由于纖維樣本的紋理復雜度低顏色單調,由實驗得知,普通處理極容易出現提取特征的重疊;同時由于提高了特征映射的維度,訓練過程中的過擬合也是一個不可忽視的問題。本文在網絡中強化纖維圖片的紋理特征,添加所需的下采樣層避免上述問題的發生。

在下采樣層輸入的特征矩陣為W1×H1×D1,其中空間變換幅度為F以及下采樣步長S,通過下采樣過程產生一個W2×H2×D2的映射矩陣:

(2)

(3)

D2=D1

(4)

式中:W1、W2為圖像寬度;H1、H2為圖像高度;D1、D2為圖像的通道數。

由上述公式可得網絡下采樣可降低網絡前饋以及反向傳導的計算量,同時由于自然圖像的局部表征性質,并沒有降低圖像的特征表達能力。

在下采樣層常用的2種算法分別是最大值下采樣max-pooling和均值下采樣mean-pooling。其中max-pooling是取得下采樣過濾矩陣范圍內的最大特征值,常用于獲取紋理細節特征;而mean-pooling是以下采樣過濾矩陣范圍內的特征矩陣的均值為特征值組成新的特征矩陣,常用于獲取圖像的整體特征。

針對2種不同的過濾策略,本文通過實驗中進行了針對性策略選擇。在訓練過程中,第1輪粗分類中使用max-pooling層,意在于獲取纖維整體的紋理特征;而在第2輪局部特征提取中使用mean-pooling,從而獲取樣本纖維的局部的整體性特征。通過上述調整可在有限的數據集合中盡量挖掘所有數據的有效內容。

1.3 改進的網絡結構

利用Alex-Net方法,可在cifar圖像10分類樣本以及各類自然物品圖像分類競賽中取得良好的分類效果。針對羊絨與羊毛自然圖像紋理特征較明顯的特點,該網絡結構提取并表征其特征。

使用改進的Alex-Net,其主要思想是不同的過濾器可獲取不同層次的樣本特征。如:紋理、光澤、邊緣、形態等。同時,由于樣本數量有限,且樣本的主要特征區別在于紋理及邊緣以及光澤等內容,所以對Alex-Net進行了降低維度的使用。圖3示出經過改進的Cashmere and Wool-Net(CW-Net)結構。

圖3 改進的CW-Net結構Fig.3 Improved CW-Net structure

網絡中的特征矩陣均由基本像素點的灰度值構成,同時基于小樣本,簡單紋理等原因,本文只使用了3次卷積層提取特征。針對每個卷積層后都緊跟1個下采樣層對卷積提取的特征映射進行降維。下采樣層均為最大值下采樣即max-pooling,這樣做能夠針對圖像的紋理特點進行特征提取。圖3中最后2個全連接層是為2種纖維圖像分類計算而加入。同樣地,也在低維度對樣本集特征值進行計算。所以文中的全連接層使用的連接單元數修改為256。最后根據2種纖維的二分類需求,修改最后1個全連接層使用one-hot的1個運算位即可對二者進行區分標注,因此最后可使用sigmoid函數分類器對二者進行最終的分類鑒別,從而降低運算量。

其中使用的sigmoid函數為

f(x)=1/(1+e-x)

(5)

式中:x表示網絡中傳導的灰度計算值。

針對二分類問題,設P(y=1|x,θ)=f(x)則P(y=0|x,θ)=1-f(x)。由式(5)及以上可得:

P(y|x,θ)=f(x)y(1-f(x))1-y

(6)

式中:y=0表示計算結果為羊絨;y=1表示計算結果為羊毛。

1.4 局部特征增強選擇

在使用上述改進的CW-Net對樣本進行第1輪粗分類之后。受文獻[10-12]啟發,使用部分特征增強整體特征[13]的思路,利用第1輪粗分類的結果網絡,每個樣本選取放大局部特征向量對整體圖像進行增強。特征增強的步驟如下。

第1步:將原始樣本圖片768像素×576像素隨機劃分出20~200個300像素×300像素候選樣本。

第2步:使用CW-Net對隨機數量的候選纖維樣本區域進行分類,選取分類概率最高的圖像作為增強部分圖像。

第3步:保存卷積網絡提取部分增強圖像的特征,用于下一步分類器的訓練。

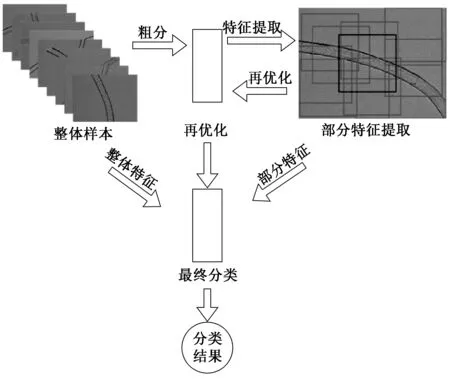

圖4示出纖維部分級特征選取過程。其中灰色方框為綁定窗口的候選區域,純黑色方框為選定區域。

圖4 纖維部分級特征選取過程Fig.4 Part-level feature selection procedure

1.5 網絡整體結構描述

通過上述網絡結構,應用部分增強整體的思路,本方法分為3個步驟:使用上述網絡結構第1輪粗分類并記錄權重;第2輪中對原始圖像樣本采用候選區域劃分部分法,在原始768像素×576像素大小的圖像上隨機劃分20~200個300像素×300像素的候選區域,對其使用第1輪分類的結果對這 20個區域進行預測,得分最高的圖像劃分為對應類別;最后,對于選出的樣本中的候選區域加入整體樣本中再進行第3輪訓練。其中稍有調整的是第2輪的訓練中修改所有的下采樣子層的max-pooling調整為mean-pooling,即采用均值下采樣,這里意圖為獲取局部樣本的整體特征。最后利用第3輪調優的網絡進行分類預測。圖5示出整體算法的結構描述。

圖5 使用局部增強整體策略的整體網絡算法結構Fig.5 Whole structure of part-level enhance object-level strategy

根據人類視覺細胞的分層增強性,通過3個輪次調優,同時使用圖5中方法進行部分特征對整體網絡進行訓練增強,則可獲取優于單獨使用整體特征或者單獨使用部分特征進行訓練結果的鑒別網絡權重值。

2 實驗與結果分析

實驗樣本集合是鄂爾多斯羊絨集團測試中心工程師拍攝的20批羊絨和24批羊毛纖維,其中樣本來自羊鄂爾多斯土種羊及澳洲雜交羊。樣本經洗去雜質并干燥處理后進行拍攝,圖像拍攝儀器是北京合眾視野公司生產的CU系列纖維攝像機,該攝像機最高能夠得到光學放大500倍的顯微鏡圖像,獲取每張樣本原始圖像大小為768像素×576像素。根據國家推薦標準GB/T 16988—2013《特種動物纖維與綿羊毛混合物含量的測定》中規定,分類樣本纖維須大于等于1 500根,并且機器學習網絡深度越深,所需要的樣本數越多,因此,本文選用的纖維圖像總數為4 800張,其中包含2 400根羊絨圖像和2 400根羊毛圖像,每輪次實驗的數據集從樣本容量中隨機選擇各2 000張作為訓練集樣本,同時選取余下的400張圖像作為驗證集樣本。每張樣本圖片均被處理成.jpg格式,實驗進行50輪次的訓練,并每次使用訓練樣本所獲取的網絡對驗證集進行分類判斷,選取其中分類結果最優的網絡參數。實驗按照前文提到的方法和策略流程進行。首先,原始纖維圖像要按照CW-Net進行圖像特征提取,獲取第1輪纖維整體粗分類的網絡;然后利用第1輪獲取的網絡模型更換max-pooling層為min-pooling層對每張樣本進行分部特征提取;最后使用第2步的分部特征對第1步獲取的整體特征進行增強后對驗證樣本進行分類鑒別。

2.1 評估指標

因實驗中實際上屬于二分類問題,可通過計算準確率(AC)來衡量鑒別的有效程度。同時,也可分析訓練的損失值(LS)評估該模型最后是否收斂于最小值,從而以此評估分類識別的效果。

其中準確率定義如下:

(7)

式中:TP表示樣本的真實類別為正,最后預測得到的結果也為正;FP表示樣本的真實類別為負,最后預測得到的結果卻為正;FN表示樣本的真實類別為正,最后預測得到的結果卻為負;TN表示樣本的真實類別為負,最后預測得到的結果也為負。在文中計算的目標是二分類,設羊絨為正值,羊毛為負值,則TP為統計羊絨經過CW-Net計算結果為羊絨的數量;FP為統計羊毛被鑒別為羊絨的數量;FN為統計羊絨被鑒別為羊毛的數量;TN表示羊毛被鑒別為羊毛的數量。準確率就是正確分類的羊絨及羊毛的數量與所有樣本數量的比值。

另外一個本文主要采用的統計指標損失函數LS,該函數根據分類評分和訓練集圖像數據實際分類的一致性,衡量某個具體參數集的質量好壞。在此選擇對數損失函數,對數損失函數LS的計算公式如下:

(8)

其中:N為樣本數;M為類別數,在此類別數為2;yi,j表示當第i個樣本為j類時為1,否則為0;pi,j表示第i個樣本被預測為j類的概率;其中y和p均為N×M的one-hot值矩陣。

綜上所述,本文方法中主要采用準確率AC為主要指標對網絡鑒別效果進行判別。同時考慮到函數的收斂性,也選取損失函數LS作為參考評價指標。其原因是損失值經過不斷梯度計算迭代而變小時,所得的網絡收斂到局部極值,效果最好。

2.2 結果分析

實驗中進行的是監督學習訓練,每輪次從數據集中隨機選擇不同數量和比例的纖維圖像作為訓練集和測試集,效果最佳的訓練集與測試集的比例為5∶1。訓練和測試均為50輪次,選取其中效果最優的網絡進行預測。

表1示出分別使用標準的Alex-Net、object-level CW-Net、part-level CW-Net以及增強整體MixCW-Net 4種分類方法的準確率和loss值。其中Alex-Net是Alex Krizhevsky的網絡結構;object-level是使用CW-Net網絡以及僅使用纖維整體樣本進行訓練的方法;part-level CW-Net是使用CW-Net網絡以及1.4小節策略僅選取樣本局部進行訓練的方法;CW-Net是使用局部特征增強整體特征進行訓練的方法。

表1 不同結構網絡的分類效果Tab.1 Classification results of different structure networks

從表1可看出,在處理樣本有限且表面紋理細節簡單,同時背景等無意義內容較多的圖像時,使用3輪次局部增強整體的CW-Net能夠比使用Alex-Net獲取更好的效果。同時,若使用了更深層次的vgg16等網絡則得到的LS值是0,發生了網絡彌散,所以針對樣本調整網絡為更低維度。同時,適當降低網絡的深度以應對樣本圖像的數量不足問題。

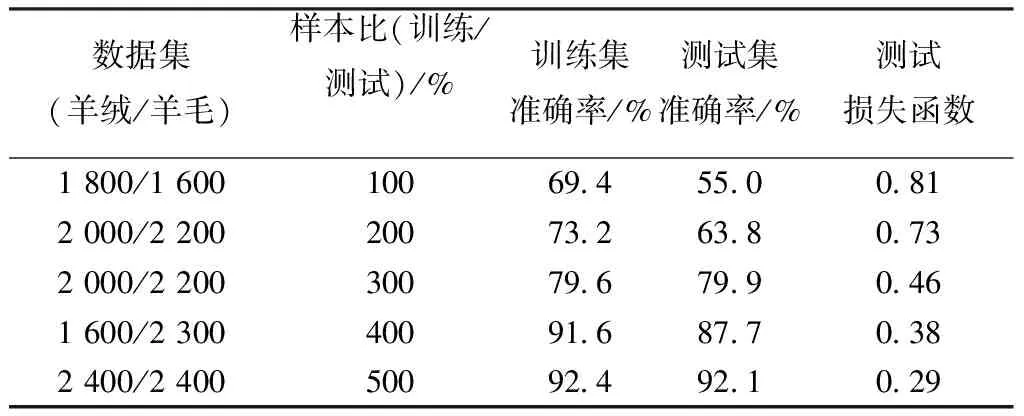

表2示出不同混合樣本比例的分類效果。第1列給出了每次選擇的數據集的纖維數量,數量單位為纖維的根數,第2列給出了訓練和預測的樣本混合比與比例。第3、4列給出了訓練集和測試集的準確率。最后一列是訓練的損失值。

表2 不同混合樣本比例的分類效果Tab.2 Classification results of different mix ratio

從表2可看到,當使用訓練測試集合比為5∶1時得到最優分類準確率。使用50輪次隨機挑選的不同批次的數據集,在該混合比下測試集中準確率最高為92.1%,最低為79.5%,同時對比其他混合比例,發現該比例損失值由8.0降低到0.29。

綜上所述,考慮到樣本數量有限,樣本總量為5 000張,去除樣本圖像帶有明顯雜質及灰塵陰影的無效圖像,實驗只選取了4 800張作為樣本。CW-Net針對圖像內容簡單,圖像無效內容居多,圖案及顏色并不豐富的羊絨及羊毛纖維圖像進行了低維度及深度降低的調整。在通過設計的3輪次模型的部分增強整體的實驗中,得到的最佳測試樣本分類準確率達到了92.1%。

與傳統計算機圖像處理識別方法相比較,該方法在訓練階段速度在可接受范圍內,且獲得最優網絡值后檢測速度更快。針對與傳統圖像關鍵點比對算法樣本少、應用范圍窄的問題,網絡學習應用范圍更廣,更適合用于大批量羊絨與羊毛的鑒別。同時考慮到羊的雜交及變異,羊絨與羊毛也產生的不可預測的變化,該方法獲得的分類效果較好。該方法使用的圖像樣本獲取方便、廉價、方法應用性價比高,更容易推廣應用。

3 結 論

本文提出了一種使用卷積網絡模型的羊絨與羊毛識別方法,該方法使用羊絨與羊毛的光學顯微鏡圖像,借助計算機卷積網絡技術中的特征提取及特征描述方法,將纖維鑒別問題轉化為圖像分類問題。通過改進采用低維度的CW-Net提取纖維圖像表面特征,在使用部位特征增強整體纖維特征的同時,采用sigmoid分類器分類圖像,鑒別羊絨與羊毛。實驗結果表明,該方法的鑒別效果較傳統計算機方法適用范圍更廣,鑒別速度更快,識別率更高,比較適合用于2種相似纖維的鑒別,但商業應用尚需進一步研究。下一階段的工作是獲取更多更高質量的纖維樣本圖像,同時適當調整網絡結構模型,優化算法,同時也可適當增加網絡深度,從而進一步提高識別準確率和鑒別的精度。

FZXB

[1] 盛冠忠,李龍. 關于山羊絨鑒別有關問題的探討[J]. 毛紡科技, 2007(12): 52-55.

SHENG Guanzhong, LI Long. Study on distinguishing problem of cashmere fiber[J]. Wool Textile Journal, 2007(12): 52-55.

[2] ZOCCOLA M, LU N, MOSSOTTI R, et al. Identification of wool, cashmere, yak, and angora rabbit fibers and;quantitative determination of wool and cashmere in blend: a near;infrared spectroscopy study[J]. Fibers & Polymers, 2013, 14(8):1283-1289.

[3] TANG Minfeng, ZHANG Weiping, ZHOU Hui,et al. A real-time PCR method for quantifying mixed cashmere and wool based on hair mitochondrial DNA[J]. Textile Research Journal, DOI: 10.1177/0040517513494252.

[4] 石先軍, 胡新榮, 蔡光明,等. 基于鱗片紋圖基因碼的羊絨理論識別精度及正誤判率[J]. 紡織學報, 2014, 35(4):5-10.

SHI Xianjun, HU Xinrong, CAI Guangming, et al. Theoretical recognition accuracy and error rate for cashmere based on scale pattern gene code[J]. Journal of Textile Research, 2014,35(4): 5-10.

[5] 季益萍,楊云輝,黃少君. 基于決策樹算法的羊絨羊毛鑒別[J]. 紡織學報, 2013, 34(6): 16-20.

JI Yiping, YANG YunHui, HUANG Shaojun. Identification of wool and cashmere based on decision tree algorithm[J]. Journal of Textile Research, 2013, 34(6): 16-20.

[6] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Image net classification with deep convolutional neural networks[J]. Advances in Neural Information Processing System, 2012, DOI: 10.1145/3065386.

[7] CHAKRADHAR S, SANKARADAS M, JAKKULA V, et al. A dynamically configurable coprocessor for convolutional neural networks[J]. Acm Sigarch Computer Architecture News, 2010,38(3):247-257.

[8] SUN B, ABDULLAH M I, YAN F, et al. An RGB multi-channel representation for images on quantum computers[J]. Journal of Advanced Computational Intelligence & Intelligent Informatics, 2013, 17(3):404-417.

[9] Distinguish images of dogs from cats. Dogs vs. cats redux: kernels edition [db/ol]. (2016-12-22)[2017-07-25].https://www.kaggle.com/c/dogs-vs-cats-redux-kernels-edition.

[10] GE Zhongyuan, ALEX Bewley, CHRISTOPHER Mccool, et al. Fine-grained classification via mixture of deep convolutional neural networks[J]. Computer Science, 2015, 9241(3):1-7.

[11] REN Shaoqing, HE Kaiming, ROSS Girshick, et al. Towards real-time lbject detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6):1137-1149.

[12] ZHANG Ning. Part-Based R-CNNs for fine-grained category detection[C]//DONAHUE Jeff, GIRSHICK Ross. 13th European Conference on Computer Vision 2014. Swizerland: Springer International Publishing, LNCS, 2014: 834-849.

[13] XIAO Tianjun. The application of two-level attention models in deep convolutional neural network for fine-grained image classification[C]//XU Yichong, YANG Kuiyuan. 2015 IEEE Conference on Computer Vision and Patten Recognition(CVPR). USA: IEEE Xplore, 2015: 842-9850.

Identificationofcashmereandwoolbasedonconvolutionalneuronnetworksanddeeplearningtheory

WANG Fei1, JIN Xiangyu1,2

(1.CollegeofTextiles,DonghuaUniversity,Shanghai201620,China; 2.KeyLaboratoryofTextileScience&Technology,MinistryofEducation,DonghuaUniversity,Shanghai201620,China)

In order to solve the problem of the difficulty in identification of cashmere and wool fiber images, a novel identification method based on convolutional neuron network (CNN) and the deep learning theory was proposed. A sigmoid classier was used to carry out coarse classification on fiber image features extracted by the CNN. The results were verified according to the validation datasets, and the optimal weights of the network was recorded. Part-level features of each sample image are extracted by an improved part-level augment object-level network based on previously obtained parameters. In addition, the part-level and object-level features were fused, and a new network model was established based on the fused features. On this basis, Ordos′s standard cashmere and wool dataset was used to train the network for 50 times, and the best accuracy is 92.1%. The experiment results demonstrate that the method for classifying cashmere and wool images, based on the CNN features, can be applied to cashmere and wool or discriminate similar fibers identification successfully. However, a large number of sample sets and validations are required for commerical use.

cashmere; wool; image identification; convolutional neuron networks

10.13475/j.fzxb.20161202907

TS 131

A

2016-12-20

2017-08-29

王飛(1982—),男,博士生。主要研究方向為機器視覺及深度學習算法在紡織品鑒別的應用。靳向煜,通信作者, E-mail:jinxy@dhu.edu.cn。