基于深度學習的遙感影像基礎設施目標檢測研究

王 港,陳金勇,高 峰,吳金亮

(1.中國電子科技集團公司航天信息應用技術重點實驗室,河北 石家莊 050081;2.中國電子科技集團公司第五十四研究所,河北 石家莊 050081)

0 引言

遙感是人類在模擬人的視覺系統基礎上發展起來的一種高科技觀測技術,通過檢測和度量地物目標電磁轄射量所得到的客觀記錄,把人眼看得到的和看不到的景物都轉化為人眼所能看到的圖像,重現地物目標電磁轄射特性的空間分布狀況。遙感圖像已被廣泛應用于環境檢測、資源探測、生態研究、測繪制圖和軍事指揮等眾多領域[1]。遙感圖像目標檢測作為遙感圖像處理的一個重要部分,具有覆蓋范圍廣、作用距離遠、執行效率高等優點,在軍事和民用領域都有重要的意義和價值。

高分系列衛星是我國自行研制并發射的系列衛星。其中,“高分一號”衛星于2013年4月發射成功,其主要參數為2 m全色/8 m多光譜分辨率相機和16 m多光譜分辨率寬覆蓋相機,幅寬分別為60 km和800 km。“高分一號”衛星擁有8 m分辨率多光譜相機,一般的基礎設施大小在100 m以上,故“高分一號”遙感影像適合作為基礎設施目標檢測的影響材料[2]。

深度學習是近年來在大數據環境下興起的一門機器學習技術,其實質是通過構建具有多層結構的機器學習模型和海量的訓練數據來學習數據中的復雜特征,用于之后的分析、預測等應用[3]。由于其具備海量數據的學習能力和高度的特征抽象能力,在諸多圖像應用領域都取得了革命性的成功。

自2014年開始,基于深度學習(主要是卷積神經網絡(CNN)[4])的目標識別在自然圖像應用中也取得了巨大突破。例如,以R-CNN(Region with CNN features)方法為代表的結合通用候選區域算法和CNN分類的目標識別框架(R-CNN[5]、SPP-NET(Spatial Pyramid Pooling Net)[6]、Fast R-CNN(Fast Region with CNN features)方法[7]、Faster R-CNN(Faster Region with CNN features)方法[8])。其候選區域采用Selective Search[9]、EdgeBox[10]或BING特征[11]等通用目標候選方法,而這些通用區域候選算法本質上還是遍歷滑窗的方法。后期的算法包括Fast R-CNN和Faster R-CNN等都采用回歸學習方法對目標的準確位置進行了修正,甚至有YOLO(You Only Look Once)方法[12]、SSD(Single Shot Multibox Detector)方法對于“大范圍、小目標”的遙感識別效果并不理想。2015年,微軟研究院何凱明提出了深度卷積網絡的改進——深度殘差網絡,在圖像分類和檢測方面取得了進一步的提高。此后,殘差網絡結構慢慢成為各種卷積網絡模型的參照結構,為各類圖像處理任務提供了優化。

上述深度學習算法模型,都是在ImageNet挑戰賽[13]上獲得過最高名次的算法。ImageNet挑戰賽極大地促進了計算機視覺領域目標檢測識別領域的發展。但是ImageNet所包含的自然圖像和衛星遙感影像,存在著一些關鍵性區別:① 遙感影像中目標相對影像較小,而且其存在很多的旋轉、仿射等現象[14];② 輸入圖像巨大,往往有數百萬像素甚至數億像素[15];③ 十分缺乏相關的訓練學習數據,尤其在深度學習的算法中,高質量、高數量的訓練樣本對算法效果起到至關重要的作用;④ 欺騙性,遙感影像由于其拍攝高度原因,獲得的信息可能是不真實的。故將深度學習的算法模型借鑒到遙感影像處理領域,還需要做更多的工作。

針對遙感影像目標檢測的具體情況,本文設計了基于殘差神經網絡模型的“高分一號”遙感影像基礎設施目標檢測算法[16]。為解決訓練樣本少、目標小、圖像大的問題,通過“高分一號”遙感影像和谷歌地圖建立了圖像目標樣本庫;為解決輸入圖像巨大難以處理的問題,對檢測輸入的遙感影像進行分塊處理,使得每一塊都可以直接進行基于殘差神經網絡模型的高分辨率遙感影像目標檢測,同時針對重復區域建議的問題,進行了RPN優化,方便了并行化處理。實驗結果表明,本文算法很好地解決了深度學習模型應用于遙感影像的諸多問題,其檢測的準確率、效率、實用性和魯棒性都有提高。

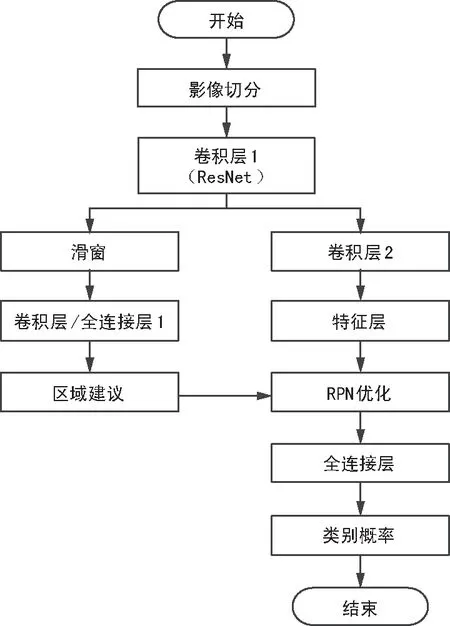

1 算法流程

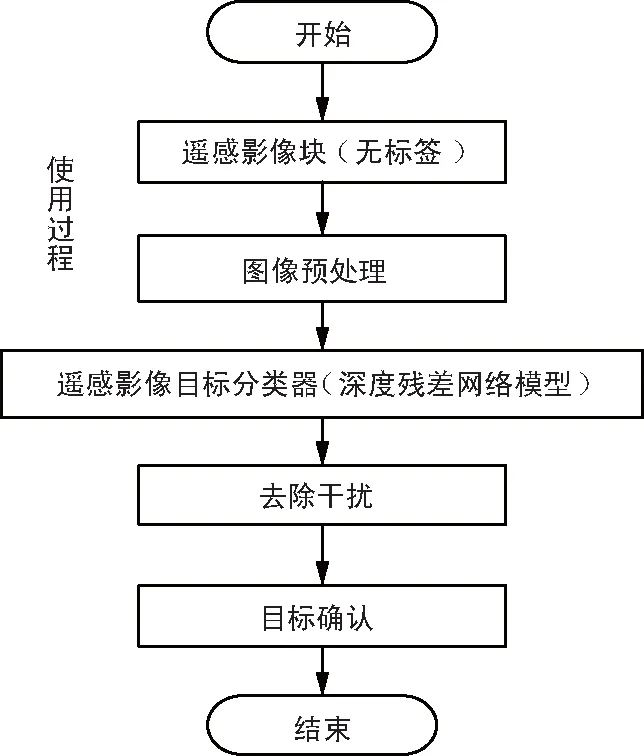

總體算法流程如圖1所示。設計思路主要為目標定位和目標識別協同工作,從而達到目標檢測的目的。在對寬幅遙感影像進行切分后,運用深度卷積神經網絡進行特征提取,提取的通用特征既可以用于目標定位,也可以用于目標識別。在目標定位給出目標具體位置后進行識別,既保證了識別的準確性,也提高了識別的針對性和魯棒性。

圖1 算法流程

2 網絡結構設計

2.1 殘差網絡

深度卷積神經網絡在圖像目標檢測中表現出了較為良好的性能,但是在現有基礎下,想要進一步訓練更深層次的神經網絡是非常困難的,而檢測復雜結構目標又迫切需要深層次的網絡結構來抽象特征。故提出了一種減輕網絡訓練負擔的殘差學習框架,這種網絡比以前使用過的網絡本質上層次更深。明確地將這層作為輸入層相關的學習殘差函數,而不是學習未知的函數。同時,全面實驗數據證明殘差網絡更容易優化,并且可以從深度增加中大大提高精度。在一般圖像的處理上,在ImageNet數據集用152層比VGG網絡深8倍的深度來評估殘差網絡,但它仍具有較低的復雜度。在ImageNet測試集中,這些殘差網絡整體達到了3.57%的誤差。該結果在2015年大規模視覺識別挑戰賽分類任務中贏得了第一。從而證明,深度殘差網絡對于圖像目標檢測識別方面是具有優勢的,達到了現階段的最好效果。故將其引入到遙感影像目標檢測中來,以期達到更加出色的目標檢測效果。

將H(x)假設為由幾個堆疊層匹配的(不一定是整個網)基礎映射,用x表示這些第一層的輸入。假設多元非線性層能逼近復雜的函數,也就相當于假設它們可以逼近殘差函數,例如H(x)(假設輸入和輸出在同一規模)。因此可以非常明確地讓這些層近似于殘差函數,而并非期待堆疊層近似于H(x)。所以原函數變成了:F(x)+x。盡管2種形式都能逼近期望函數,但F(x)更容易逼近[17]。

本文對每一個堆疊層都采用殘差學習,構建模塊定義為:

H(x)=F(x,{Wi})+x,

(1)

式中,x和H(x)是考慮到的層的輸入和輸出向量;函數F(x,{Wi})代表學習的殘差函數;F+x的操作是由快捷連接和增加的元素智能進行的。

式(1)中介紹的快捷連接,沒有額外的參數和復雜的計算。這在實踐中缺乏魯棒性,它在對比平原和殘差網絡方面也同樣重要。有著相同數量的參數、深度、寬度和計算成本時,可以對平原和殘差網絡進行簡單的對比。

在式(1)中,x和F的大小必須相同。如果不同(例如改變輸入和輸出渠道)可以通過快捷連接線性投影Ws來匹配維度,

H(x)=F(x,{Wi})+Wsx,

(2)

也可以在式(1)中使用一個正方形矩陣Ws。只有在匹配維度時,才使用Ws。

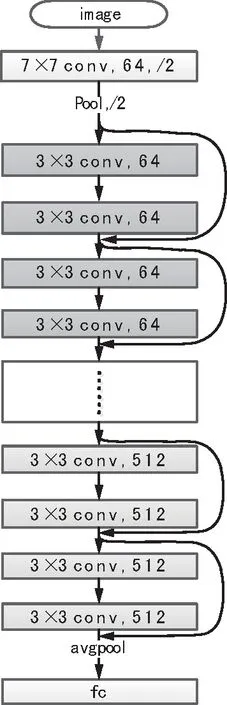

2.2 網絡結構設計

在設計應用于遙感影像目標檢測的殘差網絡時,借鑒于VGG網理論[18]。卷積層主要有3×3的過濾器并遵循2個簡單的設計規則:① 對于相同的輸出特征映射大小,圖層有相同數量的濾波器;② 如果特征映射的大小被減半,過濾器的數量增加一倍,以保持每層的時間復雜度。通過有一個跨度為2的卷積層,直接進行下采樣[18]。網絡以一個全局平均池層和全連接層結尾,其中加權層的總數是34。模型比VGG網有著更少的過濾器和更低的復雜度。34層基線有3.6億個觸發器(乘加),這只有VGG19的18%(19.6億觸發器)。網絡結構示意圖如圖2所示。

圖2 深度殘差網絡結構示意

基于以前的平原網絡(無殘差),設計出這樣一個結構。讓一個更深度模型的訓練誤差,不大于與其相應的更淺的模型訓練誤差,從而精準度下降問題得到解決。求解器在通過多個非線性層近似于身份映射方面有困難。隨著殘差學習重構,如果身份映射是最佳的方法,那么求解器可以簡單地驅動多個非線性層的權重趨向于零,以便逼近身份映射。這樣,函數逼近的模型也就是學習的模型就建立起來了[19]。

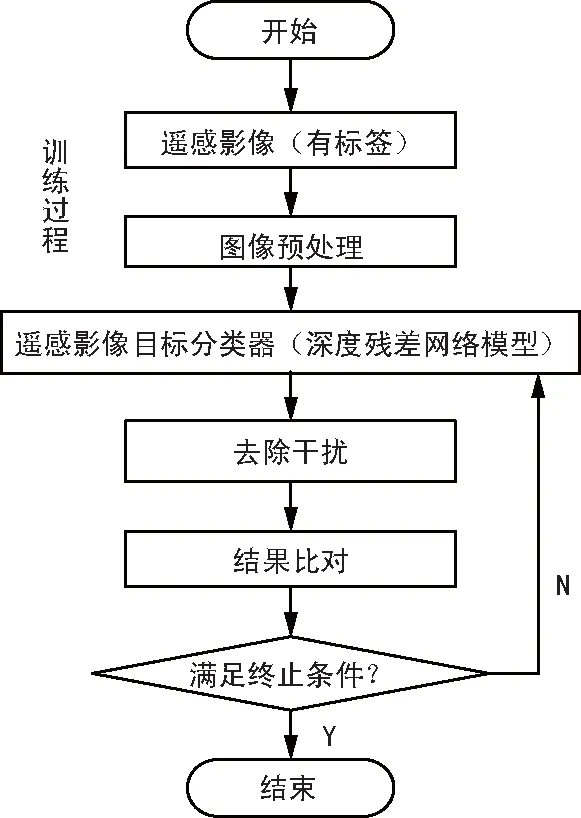

3 網絡訓練

在建立的初始深度殘差網絡中,各個參數是初始參數,沒有準確地模擬相應的復雜函數,故需要通過采集到的有標簽的遙感影像目標樣本來訓練,使網絡學習得到特征抽象描述的能力。首先將采集到的樣本數據進行歸一化和標準化處理,得到可以直接輸入的標準樣本集;其次將樣本輸入到網絡中,經過層層計算,正向傳播到最后,得到分類結果;最后結果與標簽進行比照,得到誤差,進行反向傳播,利用隨機梯度下降法(SGD)調整網絡各層的參數。針對每一個樣本進行訓練,多次迭代,當損失函數或者樣本準確率變化不大時,停止迭代。此時的網絡作為接下來遙感影像目標檢測的網絡模型。深度殘差網絡的訓練流程圖如圖3所示。

圖3 深度殘差網絡的訓練流程

4 基于深度殘差網絡的目標檢測

在獲得訓練好的深度殘差網絡上,進行目標未知的遙感影像的目標檢測。首先將采集到的樣本數據進行歸一化和標準化處理,得到可以直接輸入的標準樣本集;其次將樣本輸入到訓練好的網絡中,通過殘差卷積計算和全連接分類計算,得到分類結果。基于深度殘差網絡的目標檢測流程圖如圖4所示。

圖4 基于深度殘差網絡的目標檢測流程

5 訓練樣本庫的建立

深度學習的所有算法都建立在大量數據的基礎上,算法都是在大量有效數據上進行特征和規律學習。遙感影像數量很多,但是包含有特定類別、且分辨率一致的影像數據并不夠多。本文建立了高分辨率遙感影像的基礎設施典型目標樣本庫,通過這個樣本庫進行典型目標的學習和檢測。

搜集的典型目標包括:機場、操場。搜集包含目標的樣本,主要按照由大到小的范圍進行搜集,比如機場樣本,即按照“國家—基地—機場”的思路進行搜集。

搜集的高分辨率遙感影像數據主要來自于“高分一號”遙感衛星和Google Earth,其中采用“高分一號”遙感衛星中全色2 m和多光譜8 m作為樣本庫選取素材,采用Google Earth中L15層作為樣本庫選取素材。Google Earth圖像的引入,目的在于提高網絡模型的魯棒性,以及一定程度緩解過擬合問題。

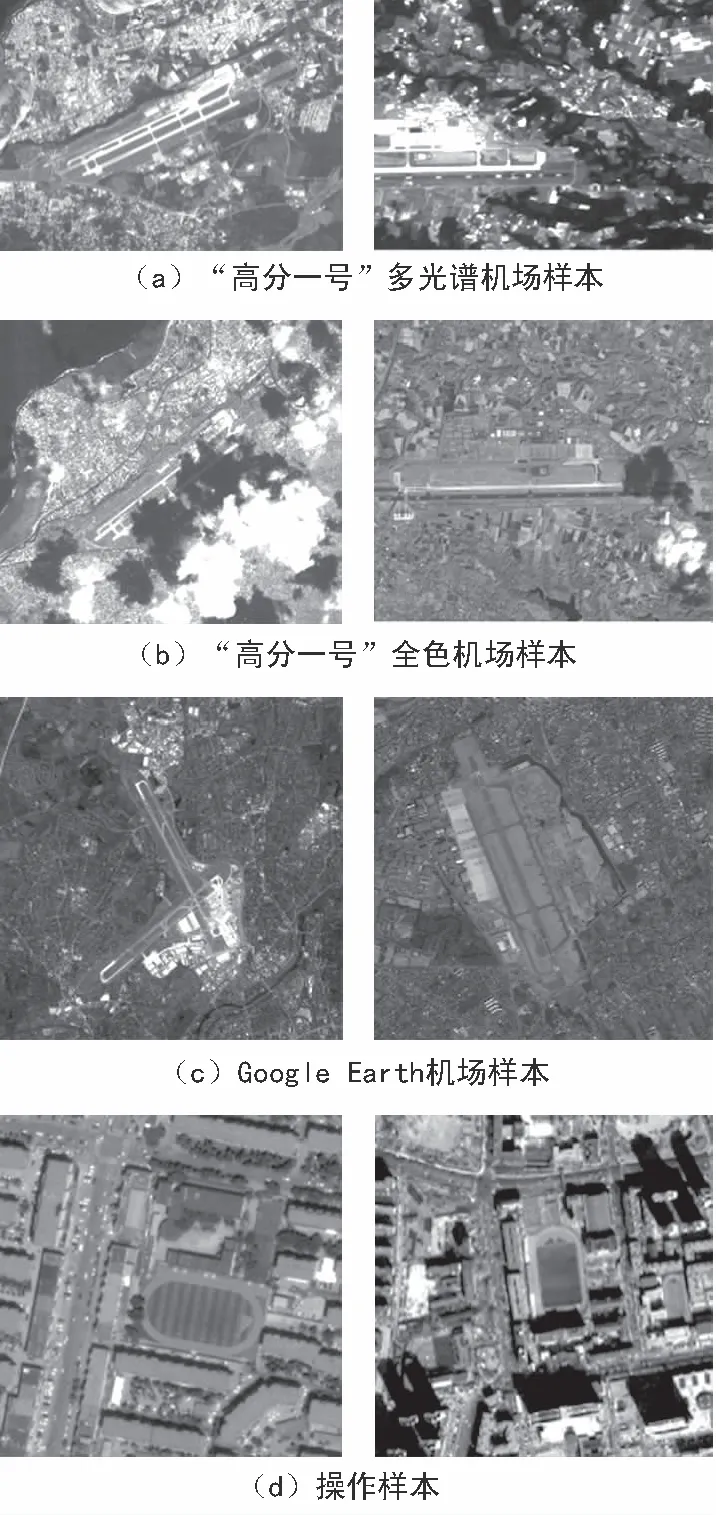

搜集到的粗樣本數據再進行細加工。殘差網絡訓練的樣本數據一般要求在1 000×1 000像素左右,故制作細樣本時,也將樣本大小選定在1 000×1 000左右。每一幅細樣本中包含1~3個目標。典型樣本實例如圖5所示。

圖5 樣本示例

圖5(a)為“高分一號”多光譜機場樣本示例,圖5(b)為“高分一號”全色機場樣本示例,圖5(c)為Google Earth機場樣本示例,圖5(d)左邊為Google Earth操場樣本示例,右邊為“高分一號”全色操場樣本示例。

6 實驗結果分析

6.1 實驗數據集

利用從“高分一號”和Google Earth上獲取的光學遙感圖像進行實驗,包括機場、操場。其中機場樣本500幅,操場樣本300幅。隨機從帶有標簽的數據集中選出機場樣本300幅,操場樣本200幅,作為訓練樣本;其余作為測試樣本,訓練樣本與測試樣本不重復。

6.2 實驗環境配置

本算法在Matlab 2014b上進行編寫,采用Caffe深度學習開源庫作為模型構建基礎[20]。計算機為聯想Think Station P100,至強E2630 v3(雙路),顯卡為英偉達Quadro M6000 24G。本算法訓練和測試均是在GPU加速下完成。

由于輸入的檢測影像大小不一,本文在輸入的第一步對其進行了尺度歸一化,以1 000×1 000作為標準輸入大小;對卷積特征圖進行滑窗處理時,以10像素作為滑窗步幅;訓練時學習率為0.001,學習動量為0.9,權重衰退率為0.000 5,迭代次數為3 000。

6.3 實驗分析

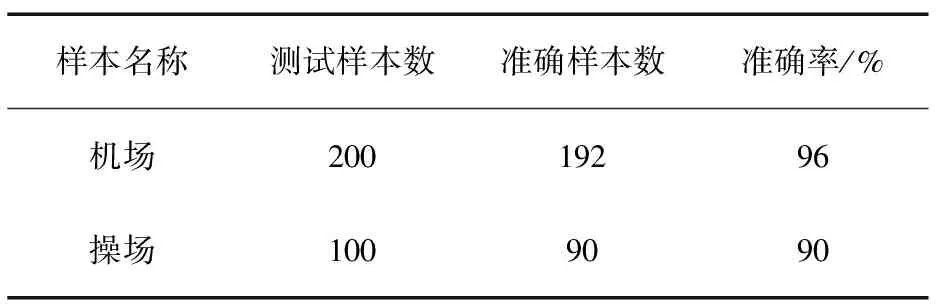

本文采用了機場和操場這2種典型目標作為測試對象,其中重點分析機場的檢測情況,并對分塊后的遙感影像進行了準確率測試。分塊后平均檢測時間為0.2 s。具體如表1所示。

表1 分塊遙感影像目標檢測統計數據

樣本名稱測試樣本數準確樣本數準確率/%機場20019296操場1009090

傳統算法遙感影像目標檢測的準確率一般在80%左右。由表1可知,本文方法對于高分辨率遙感影像目標檢測準確率更高。

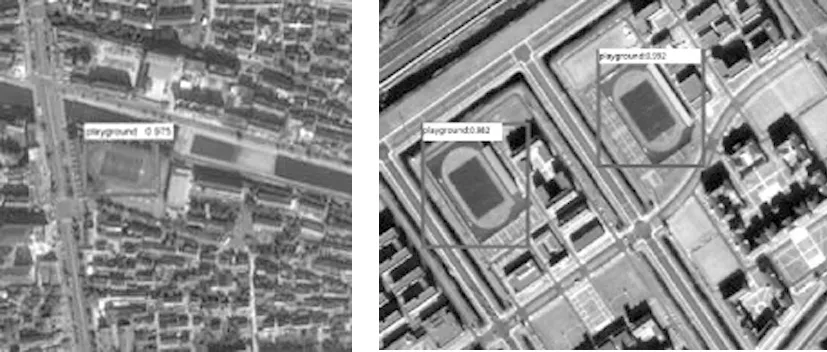

機場檢測的結果示例如圖6所示,操場檢測的結果示例如圖7所示。可以看出,本文方法對典型目標的檢測效果十分良好,其復雜的環境背景并沒有對結果造成影響。

圖6 機場檢測結果示例

圖7 操場檢測結果示例

6.4 算法魯棒性驗證

一般情況下,算法在無干擾或者去除干擾的情況下,表現良好,但是實際應用中,會出現很多由于天氣、相機載荷和拍攝角度等原因造成的影像成像模糊、有遮擋和光照異常等情況[21]。本文將這些情況考慮進去,從而驗證所設計算法的魯棒性和穩定性。

“高分一號”衛星拍攝的影像如圖8所示,分別出現了光照異常、云層遮擋和模糊情況。

圖8 有干擾遙感影像示例

應用本文算法對其進行目標檢測測試,得到結果如圖9所示。從檢測結果可以看出,本文算法在有干擾情況下的表現良好,具有很好的魯棒性。

圖9 有干擾影像檢測結果示例

7 結束語

本文提出了一種基于深度學習模型(深度殘差模型ResNet34)的高分辨率遙感影像基礎設施目標檢測方法。針對高分辨率遙感影像內容豐富、尺度大等問題,將計算機視覺領域目標檢測效果最好的模型通過寬幅遙感影像分塊、RPN優化等多處改進應用于遙感影像處理領域,并在單幅高分辨率遙感影像目標檢測方面取得了很好的效果。

在整個實驗中,介紹了從樣本制作、模型結構、環境配置以及訓練參數等多方面的“高分一號”遙感圖像處理的工程化應用實施細節,同時驗證了本文算法對存在有云、模糊等干擾的遙感影像具有魯棒性,為接下來繼續開展國產高分遙感影像處理打下了良好基礎。實驗表明,在“高分一號”遙感影像典型基礎設施目標檢測中,本文方法具有很好的效果,克服了目標復雜的環境背景。

[1] 王鑫.基于選擇性視覺注意機制的遙感圖像機場檢測[D].上海:復旦大學,2012.

[2] 陳金鳳,程乾.高分1號融合光譜特征提取杭州灣河口沿岸濕地典型植被信息方法研究[J].杭州師范大學學報(自然科學版),2015,14(1):39-43.

[3] 牛新,竇勇,張鵬,等.基于深度學習的光學遙感機場與飛行器目標識別技術[J].大數據,2016,5(1):54-67.

[4] LECUN Y,BOSER B,DENKER J S,et al.Backpropagation Applied to Handwritten Zip Code Recognition[J].Neural Computation,2008,1(4):541-551.

[5] GIRSHICK R,DONAHUE J,DARRELL T,et al.Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2014:580-587.

[6] HE K,ZHANG X,REN S,et al.Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2015,37(9):1904-1916.

[7] GIRSHICK R.Fast R-CNN[C]∥IEEE International Conference on Computer Vision,IEEE,2015:1440-1448.

[8] REN S,HE K,GIRSHICK R,et al.Faster R-CNN:Towards Real-time Object Detection with Region Proposal Networks[C]∥Neural Information Processing Systems,2015:1-3.

[9] UIJLINGS J R R,SANDE K E A V D,GEVERS T,et al.Selective Search for Object Recognition[J].International Journal of Computer Vision,2013,104(2):154-171.

[10] ZITNICK C L,DOLLR P.Edge Boxes:Locating Object Proposals from Edges[M].Proceedings of the European Conference on Computer Vision,2014:391-405.

[11] CHENG M M,ZHANG Z,LIN W Y,et al.BING:Binarized Normed Gradients for Objectness Estimation at 300 fps[C]∥IEEE International Conference on Computer Vision.IEEE,2014:3286-3293.

[12] REDMON J,DIVVALA S,GIRSHICK R,et al.You Only Look Once:Unified,Real-Time Object Detection[C]∥IEEE International Conference on Computer Vision,IEEE,2016:779-788.

[13] DENG J,DONG W,SOCHER R,et al.ImageNet:A Large-scale Hierarchical Image Database[C]∥IEEE International Conference on Computer Vision and Pattern Recognition,IEEE,2009:248-255.

[14] 田子恒.基于遙感圖像的橋梁目標檢測方法研究[D].長春:東北大學,2012.

[15] 王岳環,宋云峰,陳君靈.高分辨率遙感圖像中油庫的檢測識別[J].華中科技大學學報(自然科學版),2011,39(2):110-112.

[16] 帥通,師本慧,張霞,等.高分遙感艦船目標SIFT特征的提取與匹配[J].無線電工程,2015,45(11):48-51.

[17] HE K,ZHANG X,REN S,et al.Identity Mappings in Deep Residual Networks[C]∥Proceedings of the European Conference on Computer Vision,2016:630-645.

[18] DUMOULIN V,VISIN F.AGuide to Convolution Arithmetic for Deep Learning[J].arXiv:1603.07285[cs.CV],2016.

[19] SPRINGENBERG J T,DOSOVITSKIY A,BROX T,et al.Striving for Simplicity:The All Convolutional Net[C]∥International Conference on Learning Representations,2015.

[20] JIA Y,SHELHAMER E,DONAHUE J,et al.Caffe:Convolutional Architecturefor Fast Feature Embedding[J].arXiv:1408.5093[cs.CV],2014.

[21] 季艷,魯克文,張英慧.海量遙感數據分布式集群化存儲技術研究[J].計算機科學與探索,2017(9):1398-1404.