基于兩階段分類與自適應特征變換的人臉表情識別

周濤,孫亞新

(嘉興學院,嘉興 314001)

0 引言

人臉表情識別是對人臉的表情信息進行特征提取和分析,進而使機器理解人類情感的人工智能技術。在機器人、人機交互、遠程教育、游戲娛樂等領域都有非常廣泛的應用。目前已經有大量的研究者針對人臉表情識別展開研究。

何俊提出了一個新的多角度人臉表情識別方法,該方法首先提取回歸模型的增量修正特征,然后用主成分分析法進行特征選擇,最后采用判別共享高斯過程隱變量模型識別多角度人臉表情[1]。黃壽喜采用改進的深度信念網絡作為提取人臉表情特征的檢測器,堆疊自編碼器作為識別表情的分類器,實現在人臉表情識別研究中深度信念網絡與堆疊自編碼器的結合[2]。齊梅提出了一種韋伯梯度編碼特征描述的人臉表情識別算法[3]。盧官明提出一種基于協作表示的分類算法,并應用于人臉表情識別[4]。羅源將訓練樣本切割出眼眉、臉頰和嘴三部分,對分割的各部分利用K-SVD算法得到塊字典向量,再用層次分析法的權重賦值方法求塊字典向量的權重值,構成各類子字典[5]。周宇旋針對完全局部二值模式存在直方圖維數過高和特征冗余,會導致識別速度降低和識別率低的問題,提出基于有判別力的完全局部二值模式的人臉表情識別算法[6]。

從上述文獻的描述可以看到,這些文獻主要從特征提取[2,3,6]和分類器[1,4,5]上展開研究。這些方法在分類上均采用單個分類器完成任務。但是本文注意到在人臉數據中,不同人、不同角度、不同光照往往比不同表情對人臉的影響更大,導致導致不同表情的數據可能比同一表情的數據更相似。然而人類在這種情況下,卻能比較容易的發現不同表情的人臉之間的差異。究其原因可能是人類在識別不同的人臉表情時,會自動尋找合適的特征和分類方法將其區分開來。

為了模擬上述人類識別人臉表情的過程,本文提出一種基于兩階段分類與自適應特征變換的人臉表情識別方法。第1階段,在維數約簡結果上,分別使用KNN和SVM對測試樣本分類。這里KNN和SVM分別表示兩個不同的人采取同一特征識別人臉表情。如果該特征適合用來識別該表情,顯然兩者結果應該一致。如果該特征不適合用來識別該表情,則兩個人可能會持不同的意見。此時應該尋找另外一種特征來識別該表情,所以接下來采取新的階段再次識別該表情。

第2階段,首先使用一種自適應特征變換,將維數約簡結果變換到新的特征空間,然后使用稀疏表示分類進行分類。其中,對于自適應特征變換,本文發現文獻[7]給出的基于引力感知模型的自適應特征變換能夠很好的完成任務。另外,本文使用稀疏表示分類的原因稀疏表示分類的原理與KNN和SVM差異較大。

1 基于兩階段分類與自適應特征變換的集成分類器(TSAFTC)

TSAFTC的主要過程是對分類難度較大的測試樣本,將特征映射到新的空間,使用新的分類器進一步識別。其原理是模擬人類在識別目標時會自動選擇合適的特征和分類方法。本節先給出TSAFTC的框架,然后給出自適應特征變換(Adaptive Feature Transform,AFT),最后給出TSAFTC算法。

1.1 T SAFTC的框架

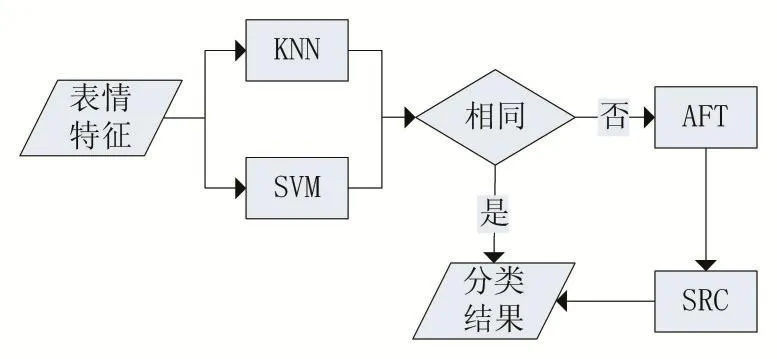

圖1給出了TSAFTC的流程圖。從圖1可以看到給定一個測試樣本的表情特征。第1階段,使用KNN和SVM分別進行識別,并判斷分類結果是否相同,如果相同則輸出分類結果,否則進入第2階段。第2階段,首先使用AFT將特征變換到新的特征空間,然后使用SRC進行分類,得到最終分類結果。

圖1 TSAFTC流程圖

1.2 自適應特征變換(AFT)

本文采用文獻[7]研究得到的自適應特征變換方法。給定 n個訓練樣本其中 p是數據的維度,n是數據的個數,對于訓練樣本xi自適應特征變換定義如下:

1.3 T SAFTC算法

根據前面兩小節的描述,TSAFTC算法可以總結如下:

算法1 TSAFTC

輸入:訓練樣本集X=[x1,x2,…,xn]∈Rp×n和其類別標簽L=[l1,l2,…,ln],測試樣本x

輸出:測試樣本的類別c

1:對x分別使用KNN和SVM得到分類結果c1和c2。

2:如果c1和c2結果相同,則分類結果c=c1。否側,進入第3步。

3:使用式(1)得到訓練樣本的自適應特征變換結果Y=[y1,y2,…,yn]∈Rn×n,使用式(9)得到測試樣本的自適應特征變換結果y∈Rn×1。

4:根據Y,L,y使用SRC得到分類結果c

2 基于TSAFTC的人臉表情識別方法

為了實現人臉表情識別,還需要特征提取和維數約簡。流程圖如圖2所示。接下來簡要介紹本文采用的特征提取和維數約簡方法。

圖2 基于TSAFTC的人臉表情識別方法流程圖

其中梯度方向直方圖(Histogram of Oriented Gradients,HOG)用于提取特征。首先將人臉圖像歸一化為128×128大小。然后使用兩種不同的參數提取HOG特征,其中方向組數為16。第1種參數設置如下:人臉圖像劃分成8×8不重疊的塊,這樣總共有256塊。第2種參數設置如下:人臉劃分成16×16不重疊的塊,這樣總共有64塊。

文獻[8]給出的增強的相關反饋(Enhanced Rele?vance Feedback,ERF)方法用于維數約簡。

3 實驗結果

3.1 實驗數據集

兩個基準數據庫用于實驗。第1個數據庫是日本女性人臉表情數據庫(Japanese female facial expression,JAFFE)。該數據庫總共包含213張256×256大小的灰度圖。由10位日本女性,每種表情提供2到4張圖片組成。

第2個數據庫是擴展 Cohn–Kanade(Extended Cohn–Kanade,CK+)數據庫。該數據庫包含123個對象的327個標注了人臉表情的圖像序列,其中表情標簽有高興、悲傷、憤怒、害怕、厭惡、藐視、驚奇等。本文選擇序列中的最后3張圖片用于實驗。

3.2 對比算法和實驗策略

TSAFTC是一種分類器,所以本文將與其他的分類器比較,包括SVM,KNN,SRC三種方法。其中SVM使用多項式核,KNN中的鄰域參數k由在訓練數據中的交叉算法確定。

采用人獨立的實驗策略,即每次采用一個人的數據作為測試數據,其他人的數據作為訓練數據。所有人的數據均作為一次測試數據,所有實驗結果的平均作為最終的實驗結果。

3.3 人臉表情識別結果

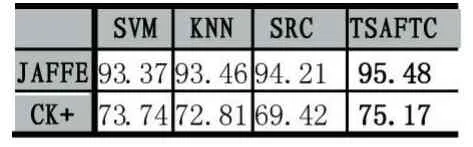

表1 兩數據庫上使用不同分類器的人臉表情識別結果

表1給出了不同分類器在兩個數據庫上的人臉表情識別結果。從表1可以看到TSAFTC在兩個數據庫上均能取得最好的效果。在CK+數據上,TSAFTC比SVM,KNN,SRC分別高 2.11%,2.02%,1.27%。在JAFFE數據庫上比 SVM,KNN,SRC分別高 1.43%,2.36%,5.75%。這些實驗結果證明了本文算法在人臉表情識別上的有效性。

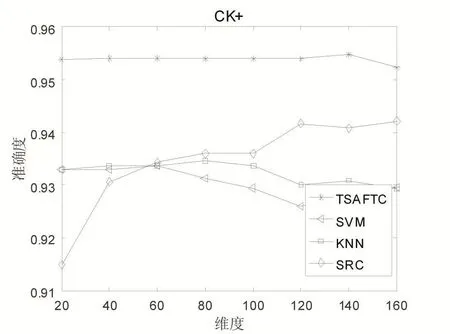

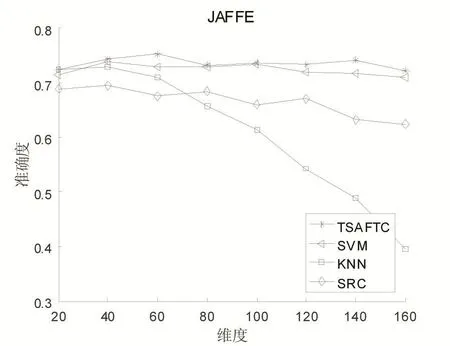

因為各個分類器的輸入數據需要先使用維數約簡算法降維,所以在圖3和圖4中還給出了維數約簡結果取不同維度的實驗結果,其中維度分別取20,40,60,80,100,120,140,160。從圖3和4可以看到,在取不同維度時,TSAFTC算法相對其他算法能夠得到更穩定的實驗結果。特別是TSAFTC在降低的維度時就能達較好的實驗結果。這樣有兩個好處:首先,維數約簡結果的維度,目前來說,并沒有一個很好的選擇方法,如果分類器在不同維度時的結果更穩定,則更有利于維數約簡結果維度的選擇。其次,在更低維度上就能達到更好的效果,有利于提高后續步驟的執行速度。

4 結語

本文提出一種基于兩階段分類與自適應特征變換的人臉表情識別方法。該方法能夠模擬人類以下的目標識別過程:當一種特征或者識別方法不能夠很好地識別物體時,會自動的切換至另外一種特征或者方法來識別該目標。通過在JAFFE和CK+上的人獨立的表情識別實驗可以看到,本文算法能夠取得更好的實驗結果。

圖3 ERF取不同維度時在CK+數據庫上的分類結果

圖4 ERF取不同維度時在JAFFE數據庫上的分類結果

本文算法使用兩個不同的分類器對測試樣本進行識別,然后根據識別結果,判斷該樣本使用該特征和方法是否能夠比較容易的識別該表情。雖然在一定程度上能夠發現該特征和方法是否有利于該表情,但是依舊會出現較多的、兩者識別結果一致時,識別結果卻不對的情況。所以在將來研究一種更合理的方法,來發現采用的特征和方法是否有利于識別該表情。

參考文獻:

[1]何俊,何忠文,蔡建峰,房靈芝.一種新的多角度人臉表情識別方法.計算機應用研究.2018(35):1-8

[2]黃壽喜,邱衛根.基于改進的深度信念網絡的人臉表情識別.計算機工程與設計,2017(6):1580-1584

[3]齊梅,李艷秋.WGC特征描述的人臉表情識別.電子測量與儀器學報,2017(4):566-572

[4]盧官明,石婉婉,李霞,張正言,閆靜杰.基于協作表示的人臉表情識別.南京郵電大學學報(自然科學版),2017(2):51-56

[5]羅源,張靈,陳云華,朱思豪,田小路.基于層次結構化字典學習的人臉表情識別,2017(11):3514-3517

[6]周宇旋,吳秦,梁久禎,王念兵,李文靜.判別性完全局部二值模式人臉表情識別.計算機工程與應用,2017(4):163-169

[7]Ya-xin Sun,Gu-ihua Wen.Cognitive Gravitation Model-Based Relative Transformation for Classification.Soft computing,2017,21(18):5425-5441.

[8]Ya-xin Sun,Gui-huaWen.Cognitive Facial Expression Recognition with Constrained Dimensionality Reduction.Neuro computing,2017,239:397-408.