基于低分辨率彩色指導圖像的深度圖像超分辨率重建

武玉龍,趙 洋,曹明偉,劉曉平

?

基于低分辨率彩色指導圖像的深度圖像超分辨率重建

武玉龍,趙 洋,曹明偉,劉曉平

(合肥工業大學計算機與信息學院,安徽 合肥 230009)

傳統的以彩色圖像為指導的深度圖像超分辨率(SR)重建方法,參考圖像必須為高分辨率彩色圖像,彩色圖像的分辨率決定了深度圖像的放大上限。同時,實際應用中可能只存在低分辨率彩色圖像,此時上述方法也不再適用。為此,探討使用任意分辨率彩色圖像為指導的深度圖像SR重建方法。首先,使用大量不同類別的圖像SR算法對輸入彩色圖像進行上采樣,得到高分辨率彩色圖像并以此作為指導圖像,然后采用基于二階總廣義變分方法,將由低分辨率彩色圖像重建得到的圖像作為正則約束項,添加圖像邊緣信息,構建目標函數,將深度圖像SR重建問題轉化為最優化問題,再通過原-對偶方法求解,最終得到高分辨率深度圖像。探討了之前被相關方法所忽略的情形,該方法可以適用于任意分辨率的彩色指導圖像。并且通過相關實驗發現了令人驚異的現象,即通過使用低分辨率彩色圖像放大后作為指導,可以得到與使用高分辨率彩色指導圖像相近甚至更好的結果,對相關問題的研究和應用具有一定參考意義。

超分辨率重建;深度圖像;二階總廣義變分;ToF相機

場景中各點相對于相機的距離可以用深度圖像表示,獲取準確、高分辨率的深度圖像是計算機視覺領域的一個挑戰性工作。快速、準確地獲取真實場景的稠密深度信息,在如三維重建、目標識別、機器人導航、自動輔助駕駛、醫療等諸多領域[1-3]有著廣泛應用。

傳統的深度圖像獲取方法主要包括兩類:①立體匹配方法[4-5],通過找出兩幅或多幅圖像之間成像點的對應關系,計算視差圖,從而估計深度信息。這類算法容易受到遮擋以及無紋理區域的影響,因此,難以產生廣泛的實際應用。②通過硬件設備直接獲取。如激光測距掃描儀[6]和飛行時間相機[7]。前者通過逐點掃描獲取場景深度,同一時間只能測量一個點的深度,其只能應用于靜態場景,同時也決定了其較大的時間代價;后者運用高速快門(大約幾毫秒),通過主動給場景發送光脈沖,檢測反射信號的時間延遲來確定場景深度,這種測量方法與場景紋理無關,與環境光條件也無關,即使近距離的場景,依然可以得到稠密的深度圖像。但由于芯片大小的限制,其只能獲取低分辨率的場景深度,如Canesta EP DevKit僅僅可以得到分辨率為64×64的深度圖像,難以滿足實際應用的需求。

為提高深度圖像的分辨率,許多學者開展了關于深度圖像超分辨率(super-resolution,SR)重建的研究。目前,深度圖像SR重建主要有兩種方法:①利用序列深度圖像的SR算法。SCHUON等[8]引入雙邊全變差正則約束項對多幅深度圖像SR重建,采用極大似然估計理論構建目標函數進行深度圖像的SR重建。RAJAGOPALAN等[9]將馬爾科夫隨機場引入到深度圖像SR重建問題中。這類方法需要多幀深度圖像之間的亞像素位移信息,很難保證實時性,而且ToF相機采集深度的隨機誤差會對多幀圖像之間的運動估計和匹配產生較大影響。②結合同場景高分辨率彩色圖像的SR重建算法。這類算法假定同場景的彩色圖像和深度圖像之間存在一致的不連續性,以高分辨率的彩色圖像為指導,對低分辨率深度圖像重建。YANG等[10]利用雙邊濾波函數指導深度圖像的SR重建。DIEBEL和THRUN[11]運用馬爾科夫隨機場建立彩色圖像和深度圖像之間的聯系,將深度圖像SR重建問題轉化為能量最優化問題。LU等[12]改進了馬爾科夫隨機場。文獻[13-14]采用聯合雙邊上采樣(joint bilateral upsampling)和引導圖像濾波函數指導深度圖像SR重建。文獻[15]對聯合雙邊濾波進行改進并提出了自適應雙邊濾波器。文獻[16]利用二階總廣義變分模型,將高分辨率彩色信息融入到二階正則項中進行深度圖像的SR重建。以同場景的高分辨率彩色圖像為指導,對深度圖像SR重建,可以取得較好效果。但是,此方法的前提條件是存在同場景的高分辨率彩色圖像,且重建后的深度圖像的分辨率上限受彩色圖像分辨率所限制,無法生成任意的更高分辨率的深度圖像;同時,實際應用中可能存在彩色參考圖像分辨率過低的情形,此時上述方法也不再適用。

目前的基于彩色指導圖像的方法僅關注于高分辨率,對任意分辨率的指導圖像,特別是低分辨率指導圖像的情形,缺乏相關的討論與研究。因而,本文探討了基于低分辨率彩色指導圖像的深度圖像SR重建方法。本文以低分辨率彩色圖像為輸入,采用不同的SR重建算法對彩色圖像進行放大,得到高分辨率彩色指導圖像,然后以此指導深度圖像的SR重建。本文的意義在于:①輸入指導圖像可以為任意分辨率彩色圖像,擴大了算法的應用范圍;②本文通過實驗發現,通過放大低分辨率指導圖像這一超采樣過程,重建的指導圖像的噪聲等不自然效應也相應得到抑制,進而使用相應放大后圖像作為指導得到的結果可達到甚至超過直接使用高分辨率彩色指導圖像獲得的結果。這一結論是違反了普遍的直觀感覺的,對相關研究和應用具有一定的參考價值。

1 本文框架

以同場景高分辨率彩色圖像為指導的深度圖像SR重建算法框架如圖1所示,其輸入為低分辨率深度圖像和高分辨率彩色圖像,通過發掘彩色圖像和深度圖像之間的內在聯系,結合重構約束來制定優化策略,最終將圖像的SR重建問題轉化為最優求解問題。

如圖2所示,不同于傳統框架,本文以低分辨率彩色圖像和低分辨率深度圖像為輸入,首先對彩色圖像SR重建,得到高分辨率的彩色圖像作為參考圖像,然后利用上述算法框架,采用二階總廣義變分模型,把得到的參考圖像作為初始高分辨率深度圖像的正則約束項,并添加圖像邊緣信息,構建目標函數,將SR重建問題轉化為最優求解問題,最終得到高分辨率深度圖像。

1.1 彩色圖像超分辨率重建

本文的輸入為任意分辨率的彩色圖像,為了獲得高分辨率的彩色指導圖像,需對輸入彩色圖像SR重建。圖像SR是指通過單幀或多幀低分辨率圖像恢復對應高分辨率圖像的過程,其中單幀圖像SR也常被稱為圖像放大、上采樣、上尺度。目前的SR重建方法可分為基于插值、基于重建和基于學習3類。

基于插值的方法是最為基礎的一類算法[17],然而插值往往會引起邊緣鋸齒、振鈴、模糊等不自然效應。為了降低插值帶來的不自然效應,許多插值方法聚焦于利用邊緣先驗知識、改進插值網格、強化邊緣[18]等。

基于重建的方法是另一類經典的SR算法,其基本約束在于放大得到的重建圖像再次降采樣后,需和輸入的低分辨率圖像相一致。同時,通過引入額外的模型或約束,可以進一步改善重建圖像的質量,如基于梯度的約束[19]、基于紋理的約束[20]和基于迭代反卷積模型的方法等。由于重建方法的基本相似約束是定義在低分辨率級別,在放大因子較大時,該類方法性能會較大程度的衰退。

近些年,基于學習的方法逐漸成為SR的熱門研究方向。該類方法由FREEMAN和PASZTOR[21]提出,通過參照使用額外的高分辨率樣例,學習如何從低分辨率恢復高分辨率圖像。常見的基于學習的SR模型包括:基于領域嵌入(neighbor embedding)的流形方法[22-23]、基于稀疏表達(sparse representation)的方法[24-25]、基于局部自樣例(local self-exemplar)的方法[26]、基于錨鄰居回歸(anchor neighborhood regression,ANR)的方法[27-29]、基于局部編碼的方法[30]和基于隨機森林(radom forest)的方法[31]。特別是最近兩年,基于深度卷積神經網絡(convolutional neural network, CNN)的方法在圖像SR問題上取得了非常好的效果,如DONG等[32]提出的基于CNN的三層SR網絡(SR-CNN),KIM等[33]提出的更窄更深的SR卷積網絡(very deep SR,VDSR),ZHAO等[34]提出的漸進上采樣網絡(gradual upsampling network,GUN)及LEDIG等[35]采用的基于對抗網絡(Adversarial Network)的方法等。

1.2 以高分辨率彩色圖像為指導的深度圖像SR重建

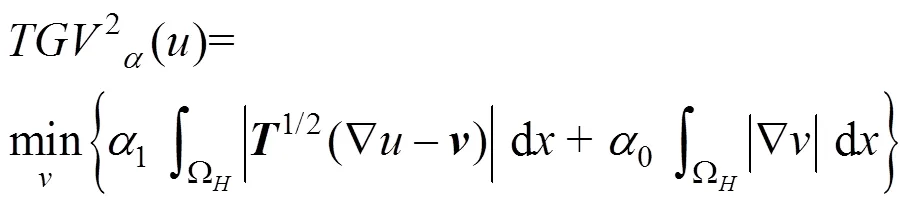

本文首先對任意分辨率的彩色圖像SR重建,然后由得到的高分辨率彩色圖像為指導,對深度圖像SR重建,后者主要基于文獻[16],其在彩色圖像邊緣對應于深度圖像邊緣的前提假設下,引入帶有各向異性擴散張量的二階總廣義變分模型,避免了一范式正則項會使重建后圖像存在分塊效應的問題,在SR重建效果和計算效率上都取得較大提升。

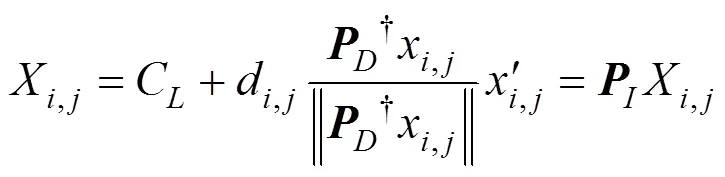

由于深度圖像和彩色圖像來自不同的相機,首先要對相機標定,獲取相機的內部參數和外部參數,這樣就可以定義彩色相機所在的坐標系為世界坐標系Ω,將深度圖像映射到彩色圖像所在世界坐標系中。這種映射關系為

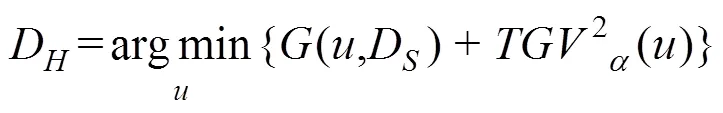

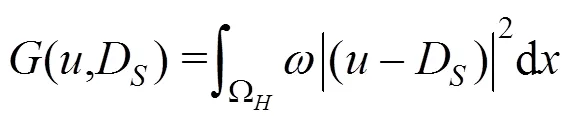

通過上述映射,得到一張基于深度測量的稀疏深度圖像D,引入二階總廣義變分模型,將D作為初始值,以高分辨率彩色圖像作為正則化約束項,構建目標函數,從而將圖像SR重建問題轉化為目標函數最優化求解問題。這里的目標函數定義為

最后,利用原-對偶能量最小化方法(primal- dual energy minimization scheme),設定閾值和迭代次數,迭代計算,直到滿足小于閾值或達到最大迭代次數,完成計算,得到最終重建的高分辨率深度圖像。

2 實驗結果及分析

為了驗證本文方法的有效性,采用了Middlebury數據集[36]和FERSTL等[16]提供的真實場景數據集ToFMark分別進行測試。本文的實驗環境為:處理器Intel(R) Core(TM) i7-2600,主頻3.40 GHz,內存8 G。為了便于定量分析實驗結果,本文以平均絕對誤差(mean absolute error,MAE)為評價標準,MAE的計算如下

2.1 Middlebury數據集

由于Middlebury數據集只提供了高分辨率的彩色圖像和高分辨率的深度圖像,為了模擬實驗中輸入為低分辨率彩色圖像和低分辨率深度圖像,首先分別以因子為1/4和1/16的Bicubic降采樣方法,對高分辨率彩色圖像降采樣,1/4降采樣后的彩色圖像分辨率為344×272,1/16降采樣后的彩色圖像分辨率為86×68。然后分別以因子為1/2和1/4的Bicubic降采樣方法,對高分辨率深度圖像降采樣,1/2降采樣后的深度圖像分辨率為688×544,1/4降采樣后的深度圖像分辨率為344×272,同時為了模擬深度圖像真實獲取過程,對降采樣后的深度圖像添加高斯噪聲[16]。

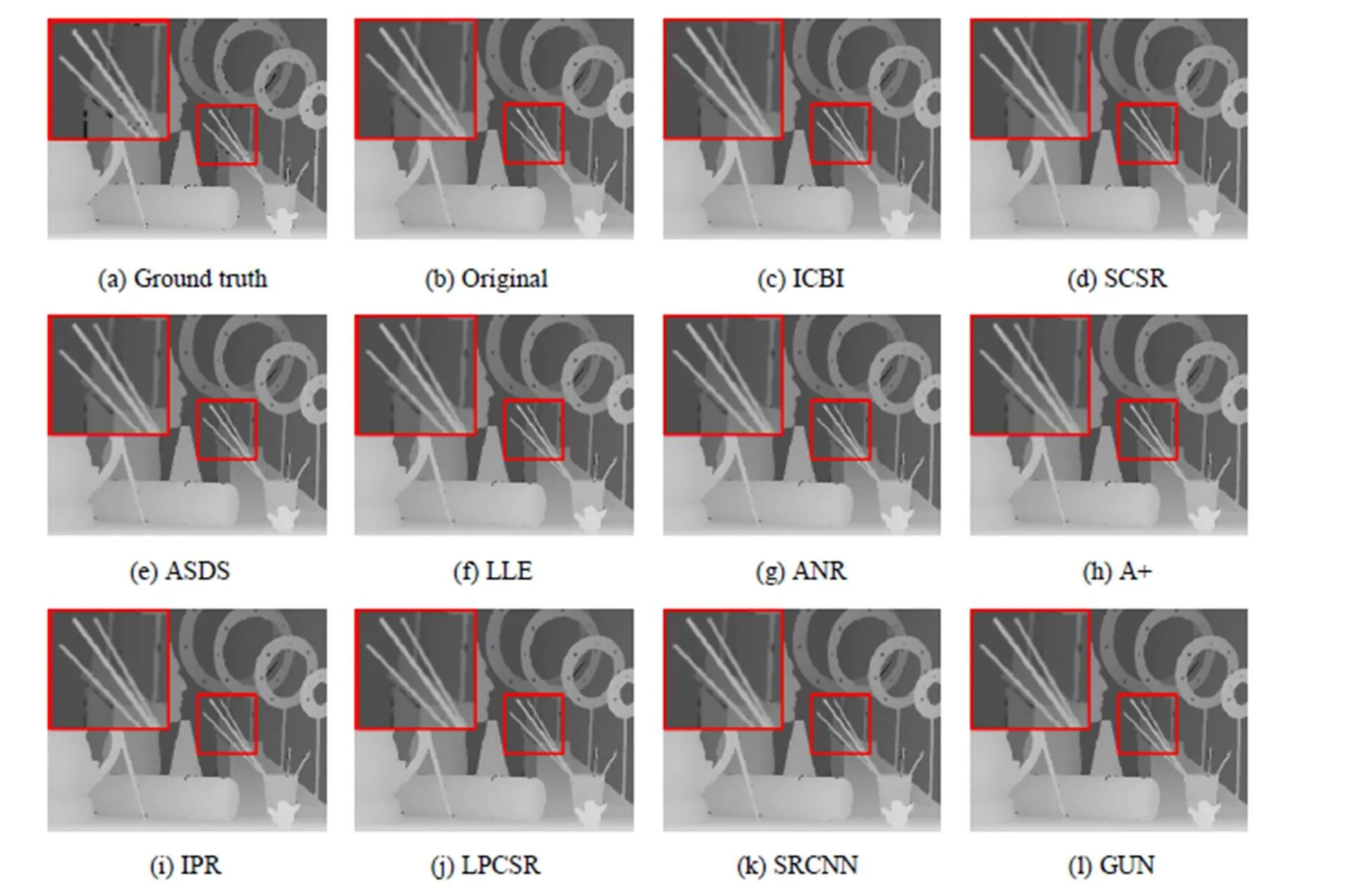

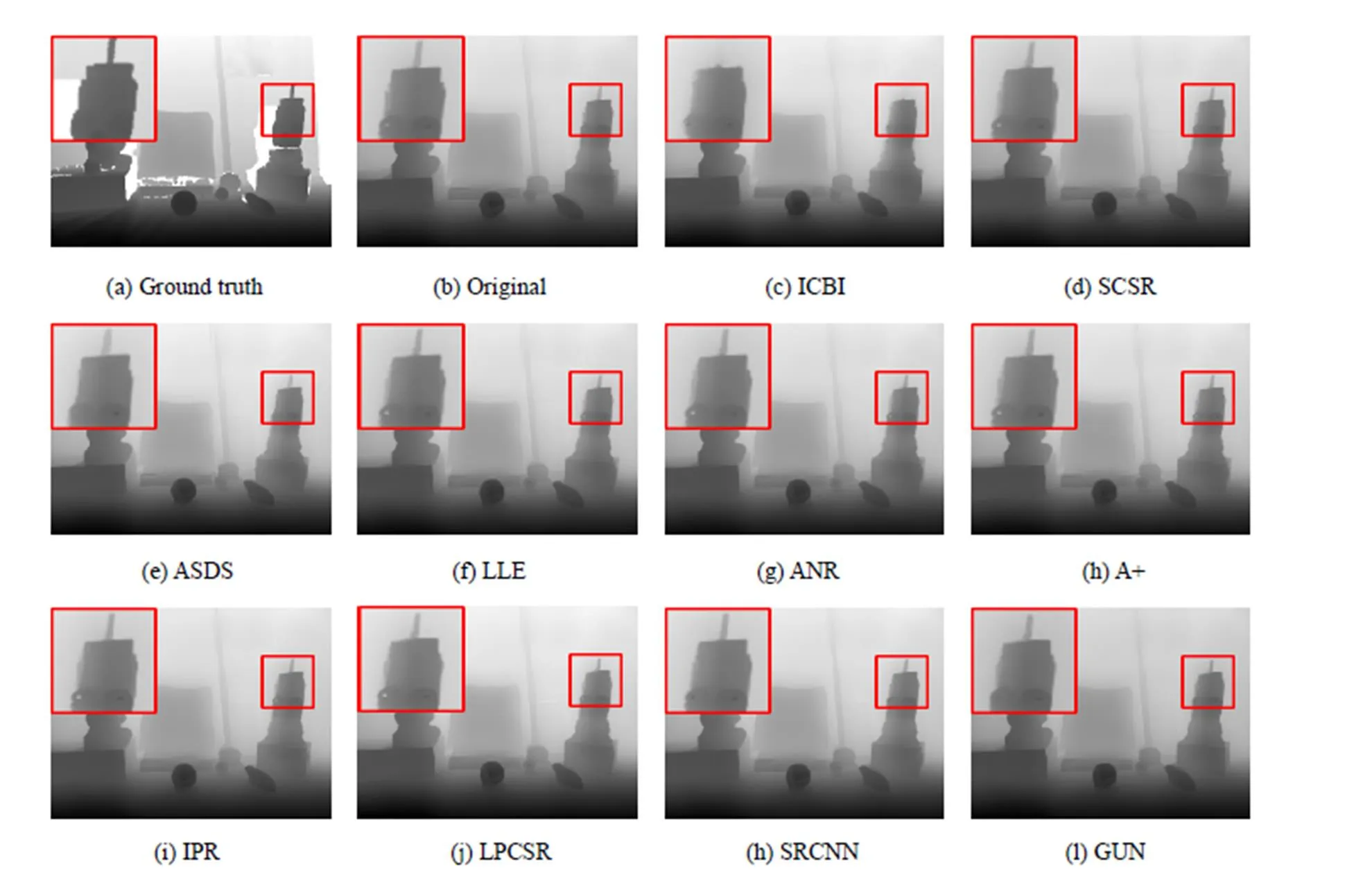

為了對比實驗結果,本文使用了多種圖像SR算法進行低分辨率指導圖像的重建試驗,包括:基于插值的方法ICBC[18],基于字典學習的方法ScSR[24]、ASDS[25]、LLE[22]、ANR[27]、A+[28]、IPR[29]、LPCSR[30],以及基于深度學習的方法SRCNN[32]、GUN[34]。圖3展示了測試圖像Art的實驗結果,其中Ground truth為原始高分辨率深度圖像,Original為以原始高分辨率彩色圖像為指導深度圖像的重建結果,其他圖像分別為先對低分辨率彩色圖像SR重建,然后以重建后的圖像為指導深度圖像的重建結果。圖3中截取了部分畫筆圖像進行放大,對比發現以重建后的彩色圖像為指導重建得到的深度圖像質量與以原始高分辨率彩色圖像為指導重建得到的深度圖像質量非常接近,這說明盡管使用低分辨率圖像作為指導,也可以有效地指導深度圖像的SR重建。

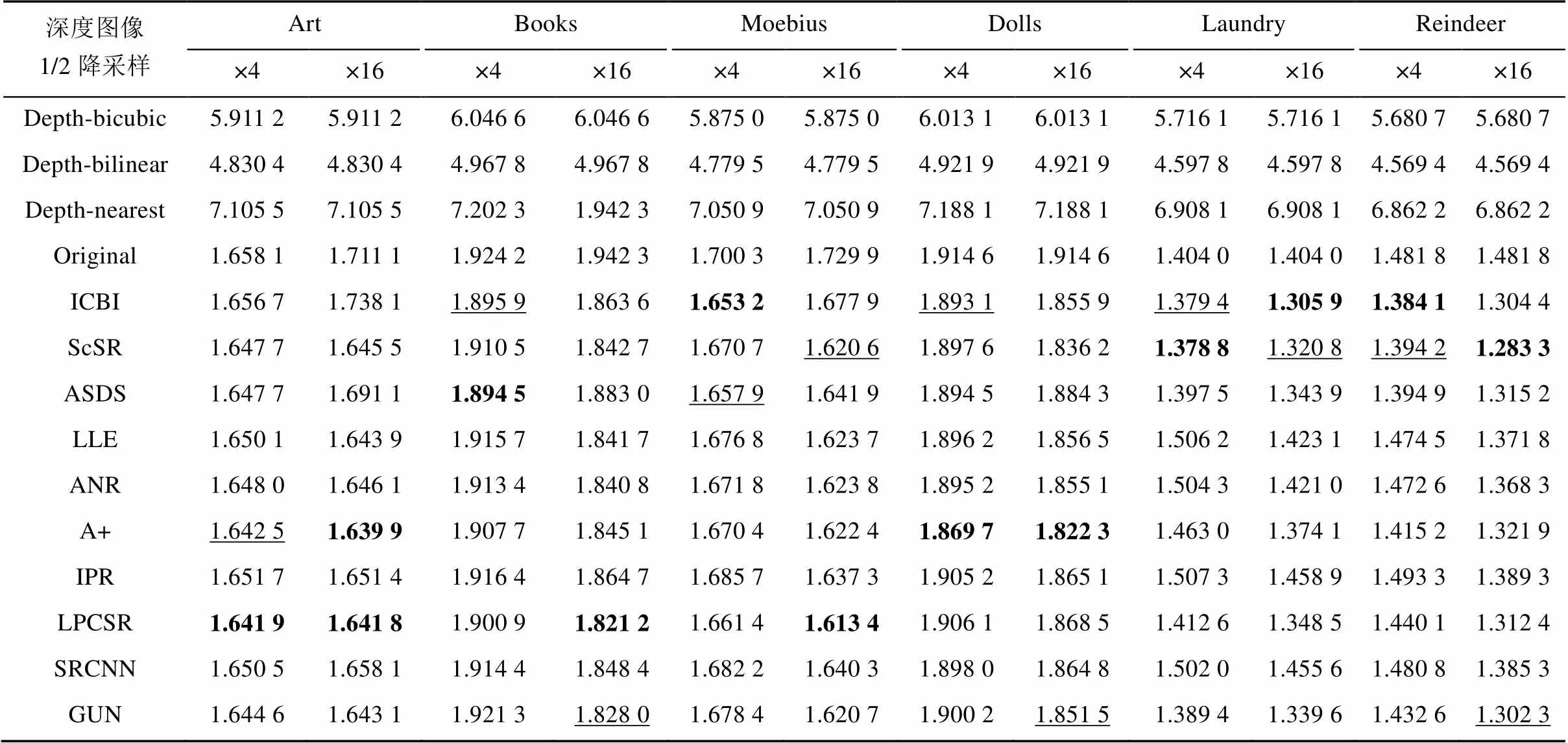

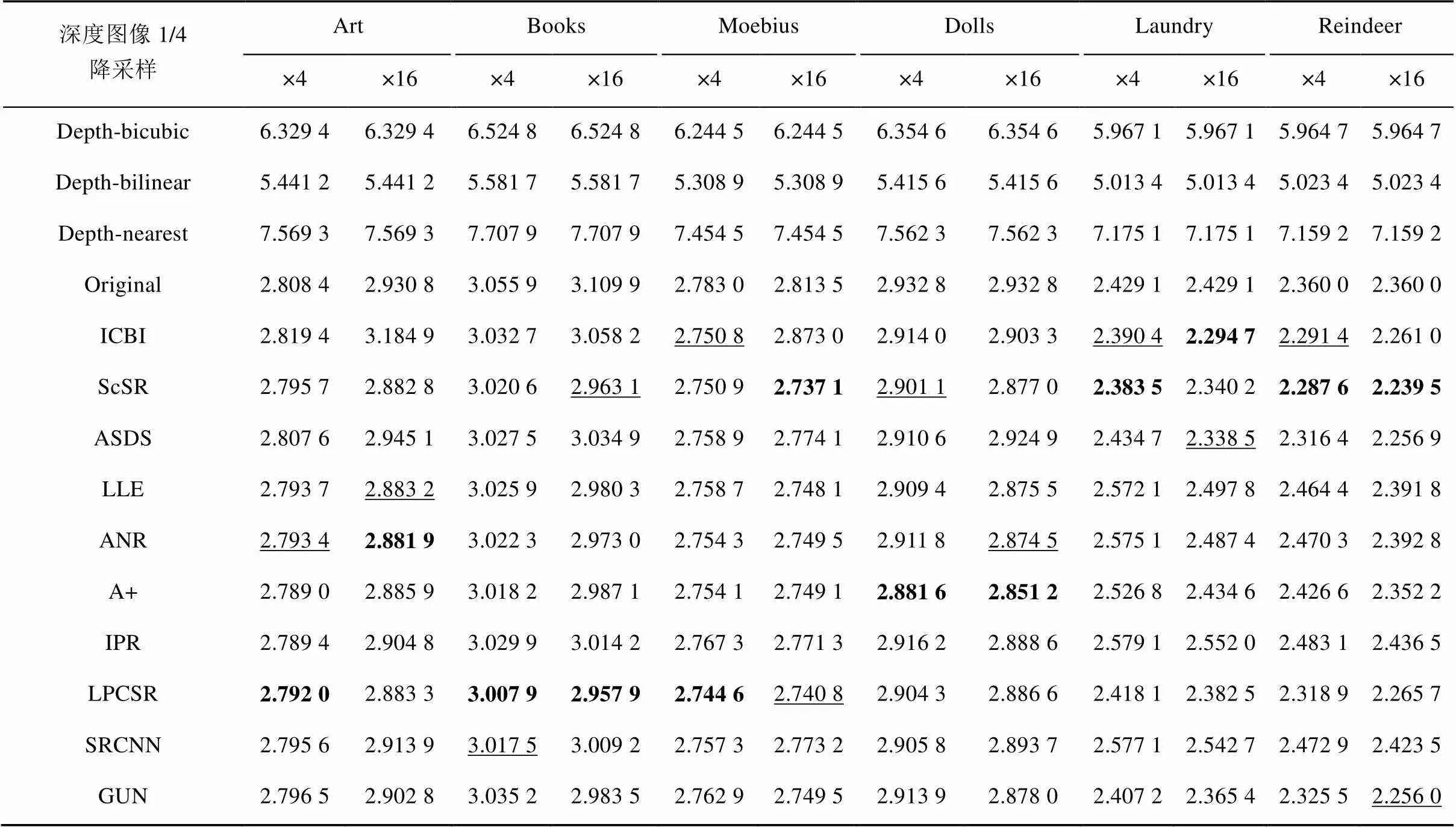

為了定量比較,表1、2分別給出了不同算法在不同圖片Art、Books、Moebius、Dolls、Laundry、Reindeer上對1/2/、1/4降采樣得到的低分辨率深度圖像重建的MAE結果。其中×4、×16分別指對低分辨率彩色圖像4倍、16倍SR重建。表中前3行列出了采用不同插值方法由低分辨率深度圖像重建的結果,Original為使用高分辨率指導圖像獲得的結果,后面為采用不同SR重建方法獲得的彩色圖像指導的重建結果。實驗結果表明,從客觀指標上看,低分辨率指導圖像獲得的結果接近甚至好于高分辨率指導圖像獲得的結果,整體上看,針對Art、Books、Moebius圖片,LPCSR方法要優于其他方法;針對Dolls、Laundry、Reindeer,ScSR方法更為優秀,這說明基于字典學習的方法可以取得最佳效果。同時也發現了兩個有趣的現象。

圖3 不同算法在圖片Art上的SR重建結果比較

表1 不同算法對Middlebury數據集1/2降采樣得到的低分辨率深度圖像重建的MAE

(注:標注加粗的為本組最佳者;標注下劃線的為本組次佳者)

表2 不同算法對Middlebury數據集1/4降采樣得到的低分辨率深度圖像重建的MAE

(注:標注加粗的為本組最佳者;標注下劃線的為本組次佳者)

(1) 以各個方法重建后的彩色圖像為指導獲得的結果,整體上優于以原始彩色圖像為指導的結果,這一結論與普遍的直觀感覺恰恰相反。對于這一現象的成因,可分析為在基于彩色圖像邊緣對應于深度圖像邊緣的前提假設下,采用各向異性擴散張量,將圖像看做熱量場,每個像素看做熱流,根據當前像素和周圍像素的關系,來確定是否要向周圍擴散,在當前像素和周圍像素差別較大時,認定鄰域像素很可能是個邊界,那么當前像素就不向這個方向擴散,這個邊界就得到保留。通過在TGV模型中添加各向異性擴散張量,保留圖像邊緣信息,增強邊緣對比度。這樣在以彩色圖像為指導的深度圖像SR重建過程中只考慮物體的邊緣結構,而不考慮具體的紋理細節,所以低分辨率圖像放大帶來的紋理損失并不會過多的影響深度圖像重建,反之,這一過程中對圖像邊緣的隨機增強效果反而對圖像的重建質量帶來少許提升;其次,實驗圖像中存在噪聲和紋理細節的干擾,不論基于字典學習還是基于深度學習的方法,在低分辨率圖像方法這一類似超采樣的過程中,能夠較好地抑制噪聲等高頻分量。因而使用SR重建后的彩色圖像為指導得到的深度圖像結果反而略優。

(2) 在以各個方法重建后的彩色圖像為指導獲得的結果比較中,最好結果均非由基于深度學習的方法獲得,這與理論上基于深度學習的方法更為優秀相悖,這說明雖然基于深度學習的重建方法相較于其他方法可以帶來更好的紋理細節,卻并非能夠實現最好的邊緣增強效果。

2.2 ToFMark數據集

ToFMark數據集中低分辨率深度圖像由PMD Nano ToF相機采集獲得,分辨率為120×160,高分辨率彩色圖像由CMOS相機獲得,分辨率為810×610。為了模擬低分辨率彩色輸入圖像,本文分別以因子為1/4和1/16的Bicubic降采樣方法,對高分辨率彩色圖像降采樣,1/4降采樣后的低分辨率彩色圖像分辨率為203×153,1/16降采樣后的低分辨率彩色圖像分辨率為51×39。

圖4中Ground truth為原始高分辨率深度圖,Original為采用原始高分辨率彩色圖像為指導重建出的深度圖像,其他圖像分別為先對低分辨率彩色圖像SR重建,然后以重建后的圖像為指導深度圖像的重建結果。圖中截取了玩偶的頭部進行了放大,從視覺效果上看,以原始高分辨率彩色圖像為指導重建出的深度圖像質量最佳;以基于深度學習和基于字典學習重建的彩色圖像為指導得到的深度圖像質量次之;基于插值的方法效果最差,可以看到玩偶的頂部較為模糊。但整體上看,基于以重建后的彩色圖像為指導重建得到的深度圖像質量與以原始高分辨彩色圖像為指導重建得到的深度圖像質量相差不大。

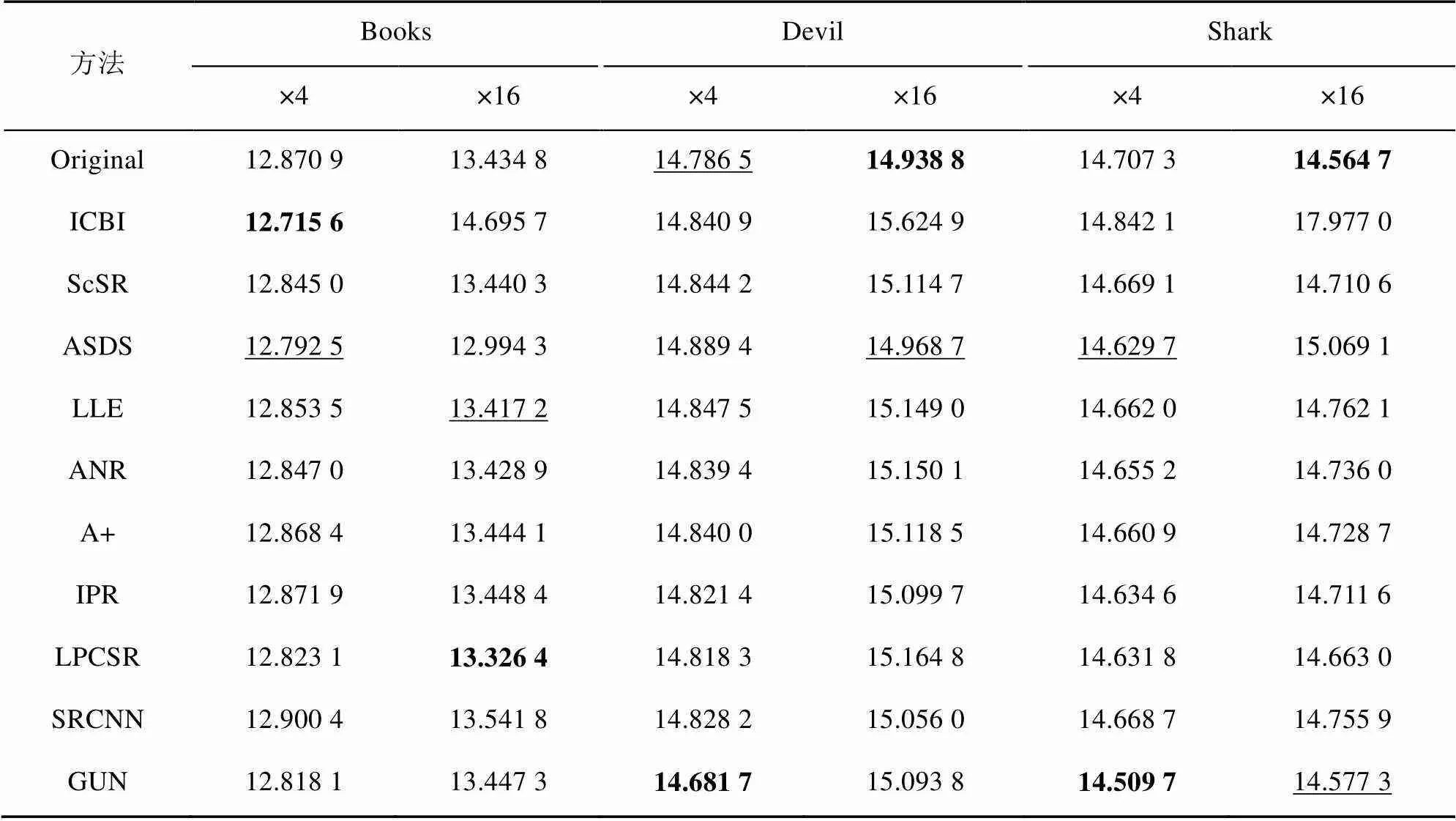

表3分別為不同方法深度圖像重建的MAE結果比較。整體來看,使用低分辨率指導圖像可以獲得接近于以原始高分辨率彩色圖像為指導所得到的結果。而在不同的彩色圖像SR算法中,以GUN和ASDS方法重建的指導圖像的效果略好于其他方法。

圖4 不同算法在圖片Devil上的SR重建結果比較

表3 不同算法對ToF數據集低分辨率深度圖像重建的MAE

(注:標注加粗的為本組最佳者;標注下劃線的為本組次佳者)

3 結束語

傳統的以彩色圖像為指導的深度圖像SR重建方法,輸入指導圖像必須為高分辨率彩色圖像。為了擴展其應用范圍,本文探討了一種以任意分辨率彩色圖像為指導的深度圖像SR重建方法。本文首先采用圖像SR重建算法對輸入彩色圖像上采樣,得到高分辨率彩色圖像并以此作為參考圖像,采用基于二階總廣義變分的方法,將低分辨率彩色圖像重建得到的圖像作為正則約束項,添加圖像邊緣信息,構建目標函數,將深度圖像SR重建問題轉化為最優求解問題,最終得到高分辨率深度圖像。實驗結果表明,以重建的彩色圖像為指導方法得到的深度圖像質量可以達到甚至超過以原始高分辨率彩色圖像為指導方法得到的深度圖像,這就避免了對輸入彩色圖像的高分辨率要求,擴展了算法的應用范圍。同時,本方法突破了輸入彩色圖像分辨率的限制,可以輸出合理范圍內的任意分辨率的高質量深度圖像。后續工作將在大量的深度圖像SR重建方法上應用本文所提出的低分辨率指導的框架,以進一步驗證本文所觀測的結論。

[1] NGUYEN C V, IZADI S, LOVELL D. Modeling Kinect sensor noise for improved 3D reconstruction and tracking [C]//International Conference on 3d Imaging. New York: IEEE Press, 2012: 524-530.

[2] ONG A P R, BUGTAI N T, ALDABA L M M, et al. Application of KinectTMand wireless technology for patient data recording and viewing system in the course of surgery [C]//Biomedical Engineerings Recent Progress in Biomaterials, Drugs Development & Medical Devices: First International Symposium of Biomedical Engineering. New York: AIP Publishing LLC, 2017: 465-471.

[3] FANKHAUSER P, BLOESCH M, RODRIGUEZ D, et al. Kinect v2 for mobile robot navigation: evaluation and modeling [C]//International Conference on Advanced Robotics. New York: IEEE Press, 2015: 388-394.

[4] NAVARRO J, BUADES A. Robust and dense depth estimation for light field images [J]. IEEE Transactions on Image Processing, 2017, (99): 1.

[5] WANG F, JIA K, FENG J. The real-time depth map obtainment based on stereo matching [C]//The Euro-China Conference on Intelligent Data Analysis and Applications. Berlin: Springer International Publishing, 2016: 138-144.

[6] DOMAE Y. 3-D sensing technology for industrial robots [J]. Mitsubishi Electric Advance, 2013, 141: 15-17.

[7] KOLB A, BARTH E, KOCH R, et al. Time-of-flight sensors in computer graphics [J]. Computer Graphics Forum, 2009(10): 776-778.

[8] SCHUON S, THEOBALT C, DAVIS J, et al. LidarBoost: depth superresolution for ToF 3D shape scanning [C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2009: 343-350.

[9] RAJAGOPALAN A N, BHAVSAR A, WALLHOFF F, et al. Resolution enhancement of PMD range maps [C]//Dagm Symposium on Pattern Recognition. Berlin: Springer International Publishing, 2008: 304-313.

[10] YANG Q, YANG R, DAVIS J, et al. Spatial-depth super resolution for range images [C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2007: 1-8.

[11] DIEBEL J, THRUN S. An application of Markov random fields to range sensing [C]//Advances in Neural Information Processing Systems. Cambridge: MIT Press, 2005: 291-298.

[12] LU J, MIN D, PAHWA R S, et al. A revisit to MRF-based depth map super-resolution and enhancement [C]//IEEE International Conference on Acoustics, Speech and Signal Processing. New York: IEEE Press, 2011: 985-988.

[13] ALVES A. Joint bilateral upsampling [J]. ACM Transactions on Graphics, 2013, 26(3): 96.

[14] CHO J H, IKEHATA S, YOO H, et al. Depth map up-sampling using cost-volume filtering [C]//IEEE IVMSP Workshop. New York: IEEE Press, 2013: 1-4.

[15] KIM J, JEON G, JEONG J. Joint-adaptive bilateral depth map upsampling [J]. Signal Processing Image Communication, 2014, 29(4): 506-513.

[16] FERSTL D, Reinbacher C, Ranftl R, et al. Image guided depth upsampling using anisotropic total generalized variation [C]//IEEE International Conference on Computer Vision. New York: IEEE Press, 2013: 993-1000.

[17] LEHMANN T M, G?NNER C, SPITZER K. Survey: interpolation methods in medical image processing [J]. IEEE Transactions on Medical Imaging, 1999, 18(11): 1049.

[18] GIACHETTI A, ASUNI N. Real-time artifact-free image upscaling [J]. IEEE Transactions on Image Processing, 2011: 20(10): 2760-2768.

[19] SUN J, SUN J, XU Z, et al. Image super-resolution using gradient profile prior [C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2008: 1-8.

[20] ZHAO Y, WANG R, WANG W, et al. High resolution local structure-constrained image upsampling [J]. IEEE Transactions on Image Processing, 2015, 24(11): 4394-4407.

[21] FREEMAN W T, PASZTOR E C. Learning low-level vision [J]. International Journal of Computer Vision, 2000, 40(1): 25-47.

[22] CHANG H, YEUNG D Y, XIONG Y. Super-resolution through neighbor embedding [C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2004: 275-282.

[23] ZHAO Y, WANG R, WANG W, et al. Multilevel modified finite radon transform network for image Upsampling [J]. IEEE Transactions on Circuits & Systems for Video Technology, 2016, 26(12): 2189-2199.

[24] YANG J, WRIGHT J, HUANG T S, et al. Image super-resolution via sparse representation [J]. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873.

[25] DONG W, ZHANG L, SHI G, et al. Image deblurring and super-resolution by adaptive sparse domain selection and adaptive regularization [J]. IEEE Transactions on Image Processing, 2011, 20(7): 1838-1857.

[26] GLASNER D, BAGON S, IRANI M. Super-resolution from a single image [C]//IEEE Conference on International Computer Vision. New York: IEEE Press, 2009: 349-356.

[27] TIMOFTE R, DE V, GOOL L V. Anchored neighborhood regression for fast example-based super-resolution [C]//IEEE International Conference on Computer Vision. New York: IEEE Press, 2013: 1920-1927.

[28] TIMOFTE R, SMET V D, GOOL L V. A+: adjusted anchored neighborhood regression for fast super-resolution [C]//Asian Conference on Computer Vision. Berlin: Springer International Publishing, 2014: 111-126.

[29] ZHAO Y, WANG R G, JIA W, et al. Iterative projection reconstruction for fast and efficient image upsampling [J]. Neurocomputing, 2016, 226(C): 200-211.

[30] ZHAO Y, WANG R, JIA W, et al. Local patch classification based framework for single image super-resolution [C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 1-11.

[31] SCHULTER S, LEISTNER C, BISCHOF H. Fast and accurate image upscaling with super-resolution forests [C]//Computer Vision and Pattern Recognition. New York: IEEE Press, 2015:3791-3799.

[32] DONG C, LOY C C, HE K, et al. Image super-resolution using deep convolutional networks [J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014, 38(2): 295-307.

[33] KIM J, LEE J K, LEE K M. Accurate image super-resolution using very deep convolutional networks [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2015: 1646-1654.

[34] ZHAO Y, WANG R, DONG W, et al. GUN: Gradual upsampling network for single image super-resolution [C]// IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 1-11.

[35] LEDIG C, THEIS L, HUSZAR F, et al. Photo-realistic single image super-resolution using a generative adversarial network [C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2016: 1-19.

[36] HIRSCHMULLER H, SCHARSTEIN D. Evaluation of cost functions for stereo matching [C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2007: 1-8.

Low-Resolution RGB Image Guided Depth Image Super-Resolution

WU Yulong, ZHAO Yang, CAO Mingwei, LIU Xiaoping

(School of Computer and Information, Hefei University of Technology, Hefei Anhui 230009, China)

In traditional methods of RGB image guided depth image super-resolution, the reference images are required to be high-resolution intensity images and its resolution determines the upper limit of the depth image upsampling. Moreover, in some situations only low-resolution RGB images are available, thus the traditional methods are unpractical. In this paper an arbitrary resolution RGB image guided depth image super-resolution is proposed. First, we use different image super-resolution algorithm for the input RGB image upsampling, so that a high-resolution reference RGB image can be obtained. Then we increase the resolution of the input depth image by using the second-order total generalized variation based method and adding edge cues from the reference image obtained in above step. Then the final energy objective function is defined and depth image super-resolution can be transformed into optimization problem, which can be solved by primal-dual energy minimization scheme. Finally the high-resolution depth image is generated. This paper explores the cases previously ignored by the relevant method and the proposed method can be applied to arbitrary resolution RGB images. Through the relevant experiments, we found an amazing phenomenon that, by using low-resolution color image up-sampling as a guide, we can get similar to or even better results compared with using high-resolution intensity guided image. This conclusion has some reference significance for the research and application of related issues.

super-resolution reconstruction; depth image; second order total generalized variation; ToF camera

TP 751

10.11996/JG.j.2095-302X.2018020235

A

2095-302X(2018)02-0235-09

2017-06-20;

2017-08-13

國家自然科學基金面上項目(61370167);國家自然科學基金青年科學基金項目(61602146);安徽省自然科學基金項目(JZ2015AKZR0664)

武玉龍(1991–),男,山東東營人,碩士研究生。主要研究方向為三維重建。E-mail:1317255537@qq.com

劉曉平(1964–),男,山東濟南人,博士,教授,博士生導師。主要研究方向為計算機輔助設計、計算機圖形學。E-mail:liu@hfut.edu.cn