基于ELM-AE的遷移學習算法?

鄧萬宇 屈玉濤 張 倩

(西安郵電大學計算機學院 西安 710061)

1 引言

互聯網和社交網絡的快速發展,帶來了數據(例如,Web數據)的爆發式增長[11]。數據種類的增多導致實際應用中經常需要處理來自于不同領域的數據。由于數據特征之間的差異較大,導致很難訓練出一種公共分類器去分類不同類別的數據,在這種情況下就需要使用遷移學習。遷移學習[15]的主要目的是訓練一種健壯的公共分類器,可以很好地對來自于不同領域的數據進行分類。遷移學習廣泛應用在自然語言處理[16~18],計算機視覺[18~20],統計和機器學習[18~20]中。傳統的遷移學習有很多都是基于主成分分析法(PCA)[6,9~10]來實現的。PCA[5,12]是在盡量不改變數據特征的情況下來降低數據的維度,它是考察多個變量間相關性的一種多元統計方法,研究如何通過少數幾個主成分來揭示多個變量間的內部結構,即從原始變量中導出少數幾個主成分,使它們盡可能多地保留原始變量的信息,且彼此間互不相關。PCA所要做的就是設法將原來眾多具有一定相關性的變量,重新組合為一組新的相互無關的綜合變量來代替原變量。然而PCA具有它的局限性:1)它要求數據必須是線性的。2)它分解出的特征必須是正交的。這導致在實際應用中很多數據都無法應用PCA來進行處理。

本文使用一種新的特征提取方法,即極限學習機自編碼(ELM-AE)。基于ELM-AE來完成遷移學習,它可以解決PCA應用中的局限性,并在遷移學習上獲得更高的分類準確率。

遷移學習的最基本的實現方法是將原始數據映射到一個新的空間中,在這個空間中,源域和目標域的特征之間的差異被最小化。基于PCA的遷移學習算法已經被廣泛的研究[6,9~10],通過 PCA 可以找到一個公共的特征子空間。在文獻[8]中Blitzer等提出了一種方法,通過不同領域之間的特征關系去學習一個新的特征空間。在Chang[15]表示源域數據可以通過目標域數據線性變換而得到。在 Gong等[7]提出了一個 geodesic flow kernel(GFK),它主要統計源數據和目標數據在幾何和統計上特征的改變。Fernando等[3]提出了一種基于PCA的遷移學習算法,他們應用PCA分別得到源域數據和目標域數據的特征空間,然后將源域數據特征映射到目標域數據的特征空間中或者將目標域數據的特征映射到源域數據的特征空間中。

2 ELM-AE

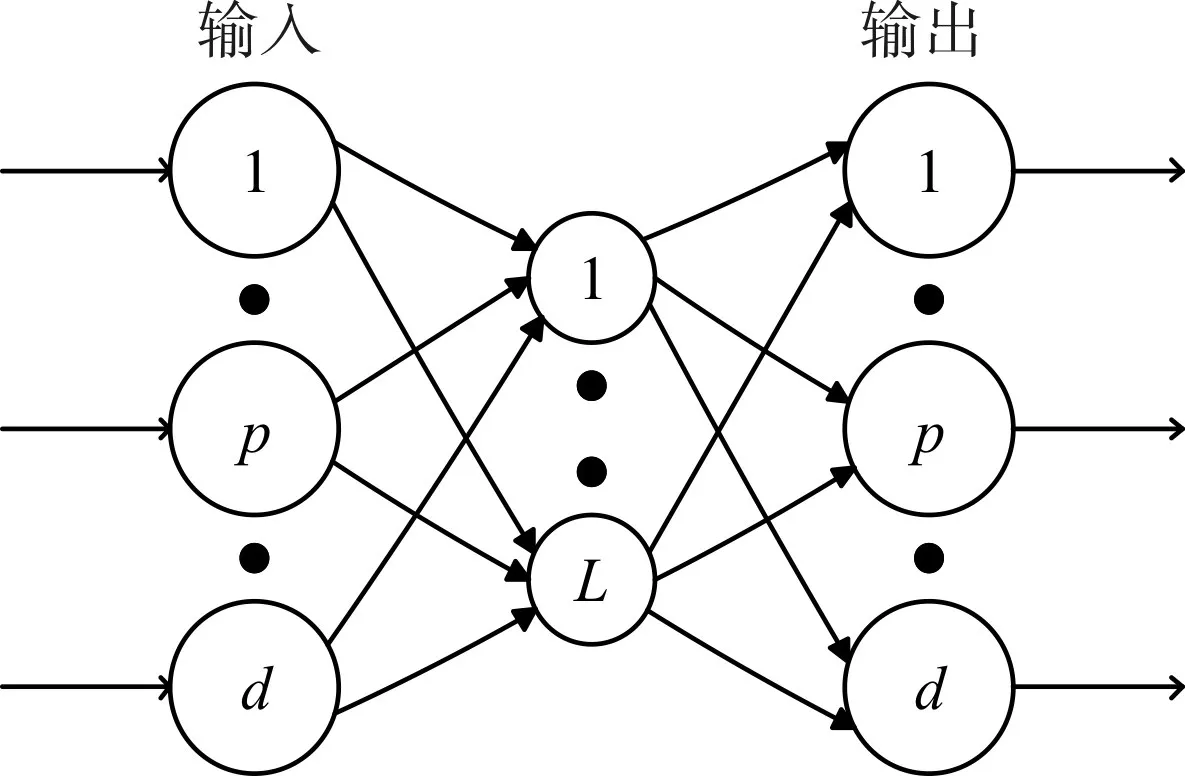

極速學習機自編碼器(ELM-AE)是一種基于極速神經網絡(ELM)的自編碼器,具有ELM的計算速度快,效率高等優點。和傳統的ELM[14]神經網絡類似,ELM-AE的網絡結構包含三層:輸入層,隱含層和輸出層。唯一不同之處在于ELM-AE的目標輸出和它的輸入是相等的,其網絡結構如圖1所示。

圖1 ELM-AE網絡結構

在圖1中,L代表的是隱含節點數,d代表的是輸入層和輸出層的節點數,也就是數據的維度,x代表的是ELM-AE的輸入和輸出。根據d和L之間的關系,ELM-AE可以被分為三種不同的類型。

壓縮型:代表數據從高維空間映射到低維空間中。

稀疏型:代表數據從低維空間映射到高維空間中。

等維型:代表數據映射前后的維度是相等的。

根據ELM的理論[4,14],隱含層的參數可以隨機地生成。通常可以選擇正交的隱含層參數來提高ELM-AE的泛化性能。隱含層的參數可以通過Johnson-Lindenstrauss lemma[13]來計算得到:

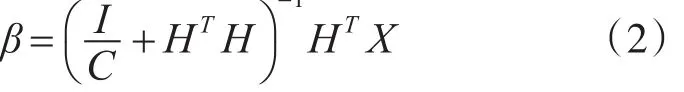

在式(1)中 a=是隨機正交的權重,b=[b1,…,bL]是隨機正交的偏差。對于壓縮型和稀疏型的ELM-AE,計算ELM-AE的輸出權值β可以通過式(2):

-1

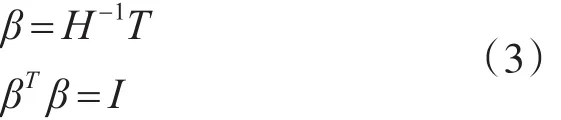

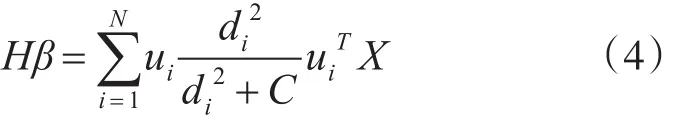

其中,H=[h1,…,hN]是ELM-AE的隱含層輸出,C是ELM的輸入參數,I是標準單位矩陣,X=[x1,…,xN]是ELM-AE的輸入和輸出。對于等維型ELM-AE,計算它的輸出權值 β可以通過式(3):

式(2)的奇異值分解(SVD)可以表示為

其中u是HHT的特征向量,d是H的奇異值,H是輸入X在隱含層空間上的映射,所以ELM-AE的輸出權值β通過奇異值可以對輸入數據進行特征表達,通過β可以將輸入數據映射到對應的特征子空間中。

3 基于ELM-AE的子空間對齊

在實際應用中,數據通常來源于不同領域,例如圖片和文本混合的數據,如果使用圖片的數據來訓練一個分類器,并用它來分類文本的數據,通常不會獲得好的分類效果。遷移學習可以很好地解決此類問題。

ELM-AE的輸出權β可以通過奇異值來對輸入數據進行特征表達,因此通過ELM-AE可以得到源域數據和目標域數據各自的特征子空間,分別記為WS和WT(WS,WT∈RD×L)。D表示的是數據的維度,L表示的是ELM-AE的隱含層節點數。由于源域數據和目標域數據分布不同,映射出的特征子空間也各不相同。通過子空間對齊將源域和目標域的特征子空間映射到一個公共的特征空間中,在該公共特征空間中,源域數據和目標域數據之間的特征差異被最小化。這樣通過公共特征子空間上的數據來訓練的分類器可以很好地分類來自不同域的數據。

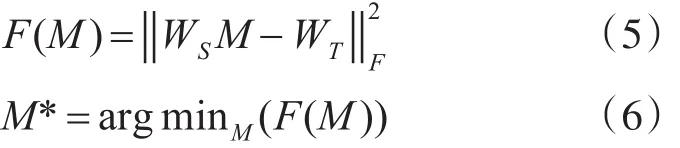

假設源域數據為 xS,目標域數據為 xT,xS,xT∈R1×D,則源域和目標域的特征子空間 X?S和X?T可以被分別表示為 ySWS和 yTWT。為了將源域特征子空間 X?S和目標域特征子空間 X?T映射到一個公共特征子空間中,在此需要學習一個轉換矩陣M ,通過M 使WS和WT對齊。根據文獻[3],M可以通過最小化Bregman矩陣求解:

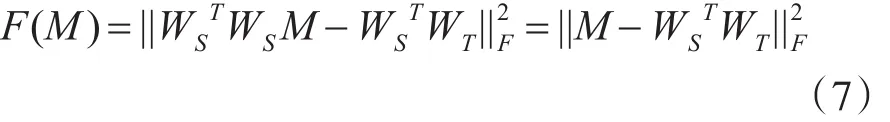

其中是Frobenius范數。由于Frobenius范數的正交不變性,式(5)可以寫成

由式(7)可以求得最優的轉化矩陣M :

通過轉化矩陣M,可以得到子空間對齊后的新的映射空間:

W?a就是目標域特征子空間對齊源域特征子空間后的公共特征空間。

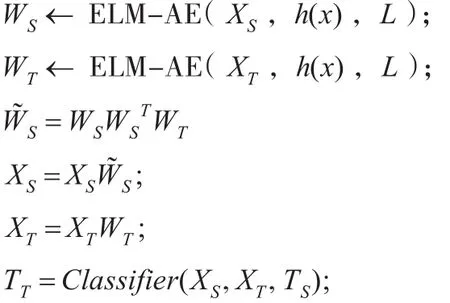

4 算法實現

基于ELM-AE的子空間對齊算法的實現主要分兩個環節:子空間生成;子空間對齊。其主現現步驟為:首先初始化ELM-AE,計算輸入數據的輸出權值,生成對應的特征子空間。其次,利用生成的特征子空間求解出轉化矩陣M。最后利用轉化矩陣將各自的特征空間進行對齊。基于ELM-AE的子空間對齊算法流程見算法1。

算法1:基于ELM-AE的子空間對齊算法

輸入:源域數據XS,目標域數據XT,源域數據標簽TS,目標域數據標簽TT,隱含層節點數 L,激活函數 h(x)。

輸出:預測的目標域標簽 TT

5 實驗驗證

本次實驗選取 Office[1]和 Caltech256[2]數據集來進行算法的驗證。Office數據集上包含webcam圖片(W),DSLR圖片(D)和 Amazon圖片(A)。Caltech256中的圖片被標記為C。數據集共包含4個不同領域的數據。A,W,D和C可以組成12組遷移學習問題。遷移學習可以被標記為S→T,S代表源數據域,T代表目標數據域。

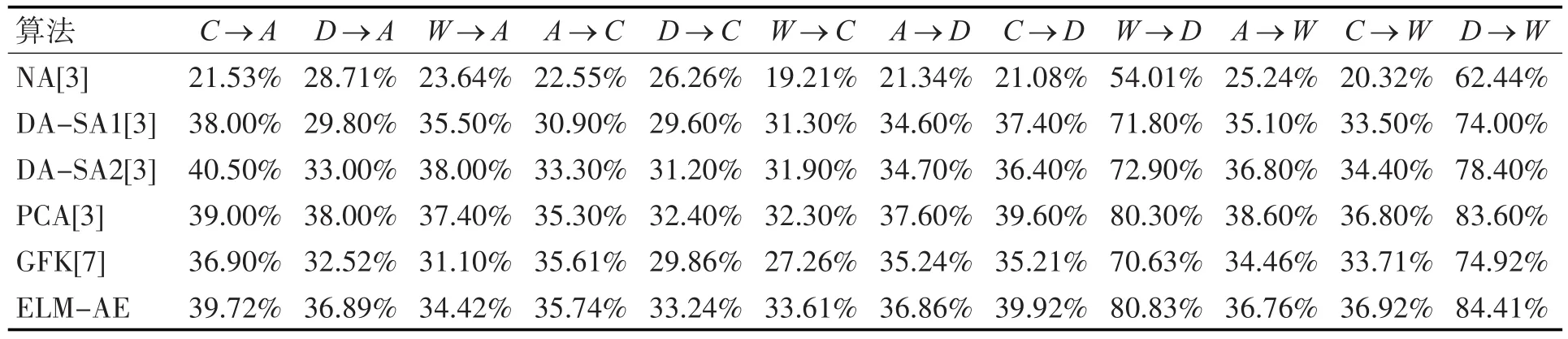

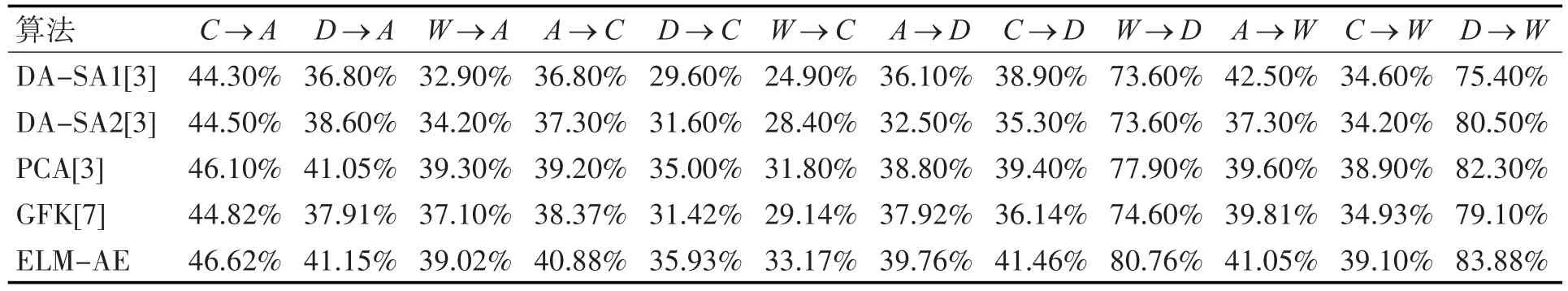

本實驗將基于ELM-AE的遷移學習算法與其他幾種常見的遷移學習算法進行了比較,每組遷移學習分別使用KNN和SVM作為最終分類器,實驗結果如表1所示。

表1 (Part I).KNN分類器的分類準確率(Office dataset+Caltech256)

表2 (Part I).SVM分類器的分類準確率(Office dataset+Caltech256)

6 實驗結果分析

在上述實驗結果中,表1和表2均被分為兩個部分。NA表示的是在該組遷移學習中不涉及特征映射。GFK[7]主要統計源數據和目標數據在幾何和統計上特征的改變。PCA[3]表示應用PCA分別得到源域數據和目標域數據的特征空間,然后將源域數據特征映射到目標域數據的特征空間中或者將目標域數據的特征映射到源域數據的特征空間中。DA-SA1[3]表示源數據通過PCA來求得源數據的目標子空間WS。DA-SA2[3]表示目標域數據利用PCA得到目標域子空間WT。表1使用KNN作為最終分類器,在表1的12組遷移學習中,有8組在準確率方面提升明顯。表2使用了SVM作為最終分類器,表2中的遷移學習中有11組遷移學習獲得了更高的分類準確率。實驗結果表明不論最終分類器是選擇KNN還是SVM,基于ELM-AE的遷移學習算法都可以獲得更高的分類準確率,這證明了基于ELM-AE的遷移學習算法擁有更好的應用性。

7 結語

基于ELM-AE的遷移學習算法相比傳統的遷移學習算法擁有著更好的效率。由于ELM-AE和ELM一樣在計算過程中不需要迭代,因此計算速度快。相比于PCA,ELM-AE可以很好地處理那些非線性的數據問題。隨著數據種類的增多,基于ELM-AE的遷移學習算法在未來會獲得更加廣泛的應用。

[1]Saenko K,Kulis B,Fritz M,et al.Adapting Visual Category Models to New Domains[J].ECCV,Heraklion,Greece,September 2010:213-226.

[2]Gopalan R,Ruonan L,Chellappa R.Domain adaptation for object recognition:An unsupervised approach[J].2011,24(4):999-1006.

[3]Fernando B,Habrard A,Sebban M,et al.Unsupervised Visual Domain Adaptation Using Subspace Alignment[C]//IEEE International Conference on Computer Vision.IEEE,2014:2960-2967.

[4]Kasun L L C,Zhou H,Huang G B,et al.Representational Learning with ELMs for Big Data[J].Intelligent Systems IEEE,2013,28(6):31-34.

[5]Jolliffe I T.Principal Component Analysis[J].Journal of Marketing Research,2002.

[6]Chen B,Lam W,Tsang I,et al.Extracting discriminative concepts for domain adaptation in text mining[C]//ACM SIGKDD International Conference on Knowledge Discovery and Data Mining,Paris,France,June 28-July.DBLP,2009:179-188.

[7]Gong B,Shi Y,Sha F,et al.Geodesic flow kernel for unsupervised domain adaptation[C]//IEEE Conference on Computer Vision and Pattern Recognition.IEEE Computer Society,2012:2066-2073.

[8]Blitzer J,Mcdonald R,Pereira F.Domain adaptation with structural correspondence learning[J].Emnlp,2006:120-128.

[9]Pan S J,Kwok J T,Yang Q.Transfer learning via dimensionality reduction[C]//AAAI Conference on Artificial Intelligence,AAAI 2008,Chicago,Illinois,Usa,July.DBLP,2008:677-682.

[10]Pan S J,Tsang I W,Kwok J T,et al.Domain adaptation via transfer component analysis[J].IEEE Transactions on Neural Networks,2011,22(2):199.

[11]Torralba A,Efros A A.Unbiased look at dataset bias[C]//Computer Vision and Pattern Recognition.IEEE,2011:1521-1528.

[12]Zwald L,Blanchard G.On the Convergence of Eigenspaces in Kernel Principal Component Analysis[C]//2005:1649-1656.

[13]Johnson W B,Lindenstrauss J.Extensions of Lipschitz maps into a Hilbert space[J].1984,26(189):189-206.

[14]Huang G B,Chen L,Siew C K.Universal approximation using incremental constructive feedforward networks with random hidden nodes[J].IEEE Trans Neural Netw,2006,17(4):879-892.

[15]Jhuo I H,Liu D,Lee D T,et al.Robust visual domain adaptation with low-rank reconstruction[C]//Computer Vision and Pattern Recognition.IEEE,2012:2168-2175.

[16]Iii H D.Frustratingly Easy Domain Adaptation[J].ACL,2009.

[17]Leggetter C J,Woodland P C.Maximum likelihood linear regression for speaker adaptation of continuous density hidden Markov models[J].Computer Speech&Language,1995,9(2):171-185.

[18]Huang J,Smola A J,Gretton A,et al.Correcting sample selection bias by unlabeled data[C]//International Conference on Neural Information Processing Systems.MIT Press,2006:601-608..

[19]Ben-David S,Blitzer J,Crammer K,et al.Analysis of representations for domain adaptation[C]//International Conference on Neural Information Processing Systems.MIT Press,2006:137-144.

[20]Pan S J,Yang Q.A Survey on Transfer Learning[J].IEEE Transactions on Knowledge&Data Engineering,2010,22(10):1345-1359.