基于IPCNN的紅外與可見(jiàn)光圖像融合算法

江澤濤,吳 輝,周嘵玲,黃 錦

(1.桂林電子科技大學(xué) 廣西高校圖像圖形智能處理重點(diǎn)實(shí)驗(yàn)室,廣西 桂林 541004;2.桂林電子科技大學(xué) 廣西可信軟件重點(diǎn)實(shí)驗(yàn)室,廣西 桂林 541004)

0 引 言

紅外圖像記錄了目標(biāo)物體的溫度信息,對(duì)低照度下或者偽裝的目標(biāo)有較強(qiáng)的識(shí)別能力。可見(jiàn)光圖像受光照的影響程度較大,可以提供目標(biāo)所需要的背景信息。紅外與可見(jiàn)光圖像融合有利于觀察者對(duì)該場(chǎng)景進(jìn)行更加準(zhǔn)確、全面的描述[1,2]。

非降采樣輪廓波變換(nonsubsampled contourlet transform,NSCT)能夠多尺度、多方向的表示圖像,并且具備平移不變性,可以產(chǎn)生較好的融合效果[3,4]。但圖像的多尺度分解方法普遍存在計(jì)算復(fù)雜度高,實(shí)時(shí)性差等問(wèn)題。壓縮感知(compressive sensing,CS)理論的提出有效地彌補(bǔ)了這一不足。文獻(xiàn)[5-7]將CS應(yīng)用于圖像融合中,討論了不同采樣率對(duì)融合圖像的影響,取得了較好的融合結(jié)果。文獻(xiàn)[8]將CS與NSCT相結(jié)合,在保證融合質(zhì)量的同時(shí)提高了算法運(yùn)行效率。脈沖耦合神經(jīng)網(wǎng)絡(luò)(pulse coupled neural network,PCNN)從被提出到現(xiàn)在,一直受到人們的重點(diǎn)關(guān)注。文獻(xiàn)[9]對(duì)PCNN進(jìn)行改進(jìn),解決了PCNN中參數(shù)設(shè)置復(fù)雜、迭代次數(shù)無(wú)法固定等問(wèn)題。文獻(xiàn)[10]則提出了一種多通道PCNN模型。文獻(xiàn)[1]、文獻(xiàn)[11]結(jié)合使用了NSCT和PCNN,將圖像的邊緣信息作為PCNN的外部輸入,充分保留了圖像的細(xì)節(jié)信息,取得了較為理想的融合結(jié)果。

結(jié)合CS與PCNN的優(yōu)勢(shì),本文提出了一種基于改進(jìn)脈沖耦合神經(jīng)網(wǎng)絡(luò)(improved pulse coupled neural network,IPCNN)的圖像融合算法。對(duì)NSCT低頻子帶,進(jìn)一步采用靜態(tài)小波變換(static wavelet transform,SWT)對(duì)其進(jìn)行分解,采用CS理論對(duì)SWT分解后的高頻子帶進(jìn)行融合,提高了算法效率。對(duì)NSCT高頻子帶采用絕對(duì)值取大與IPCNN相結(jié)合的融合方法,并將鏈接突觸計(jì)算神經(jīng)網(wǎng)絡(luò)(linking synaptic computation network,LSCN)引入其融合過(guò)程中,使圖像的細(xì)節(jié)信息更加豐富。LSCN和IPCNN算法保留了圖像的全局特征以及每個(gè)像素點(diǎn)的特性,能夠突出表現(xiàn)圖像邊緣,使融合結(jié)果視覺(jué)觀感更佳。

1 壓縮感知理論

1.1 壓縮感知原理

CS理論主要包含稀疏表示、測(cè)量采樣以及信號(hào)重構(gòu)3部分,其詳細(xì)介紹如下:

(1)稀疏表示:假設(shè)x為離散信號(hào),其長(zhǎng)度為N,則x在某一N×N正交基或稀疏字典Ψ下的稀疏表示為

x=Ψθ

(1)

其中,θ為x在基Ψ上的稀疏系數(shù),且θ中非零元素的個(gè)數(shù)遠(yuǎn)小于N。

(2)采樣測(cè)量:對(duì)稀疏化信號(hào)以遠(yuǎn)小于奈奎斯特采樣定理要求的采樣率進(jìn)行采樣,得到觀測(cè)信號(hào)y,y∈RM,即

y=Φx=ΦΨθ=Aθ

(2)

其中,Φ是對(duì)信號(hào)x的測(cè)量矩陣,A=ΦΨ,Φ∈RM×N,A∈RM×N。

(3)信號(hào)重構(gòu):當(dāng)測(cè)量矩陣Φ滿足k限定等距性,則可以利用觀測(cè)值y恢復(fù)出信號(hào)x,即

(3)

通過(guò)求解上述凸優(yōu)化問(wèn)題,可得信號(hào)x的最稀疏解

(4)

1.2 分塊壓縮感知

為了解決CS在圖像重建中存在的存儲(chǔ)量大、耗時(shí)等問(wèn)題,對(duì)圖像進(jìn)行分塊壓縮感知(block compressive sensing,BCS)。其原理是把源圖像分割成B×B大小的子塊,將每個(gè)子塊排列成列向量后壓縮投影到各自的觀測(cè)矩陣上,得到每個(gè)子塊的觀測(cè)值,最后對(duì)所得到的觀測(cè)值φBi進(jìn)行優(yōu)化求解[12]。觀測(cè)矩陣φ為對(duì)角矩陣,即

(5)

2 LSCN與PCNN理論

在圖像融合中,適當(dāng)引入圖像增強(qiáng)算法可以提高融合圖像的視覺(jué)觀感,使最終的融合圖像具備較好的邊緣信息和對(duì)比度。文獻(xiàn)[13]針對(duì)傳統(tǒng)增強(qiáng)算法的不足,提出了一種LSCN模型,能夠較好的濾除圖像噪聲并增強(qiáng)邊緣細(xì)節(jié)信息,提高融合圖像的可見(jiàn)性及對(duì)比度。

2.1 脈沖耦合神經(jīng)網(wǎng)絡(luò)

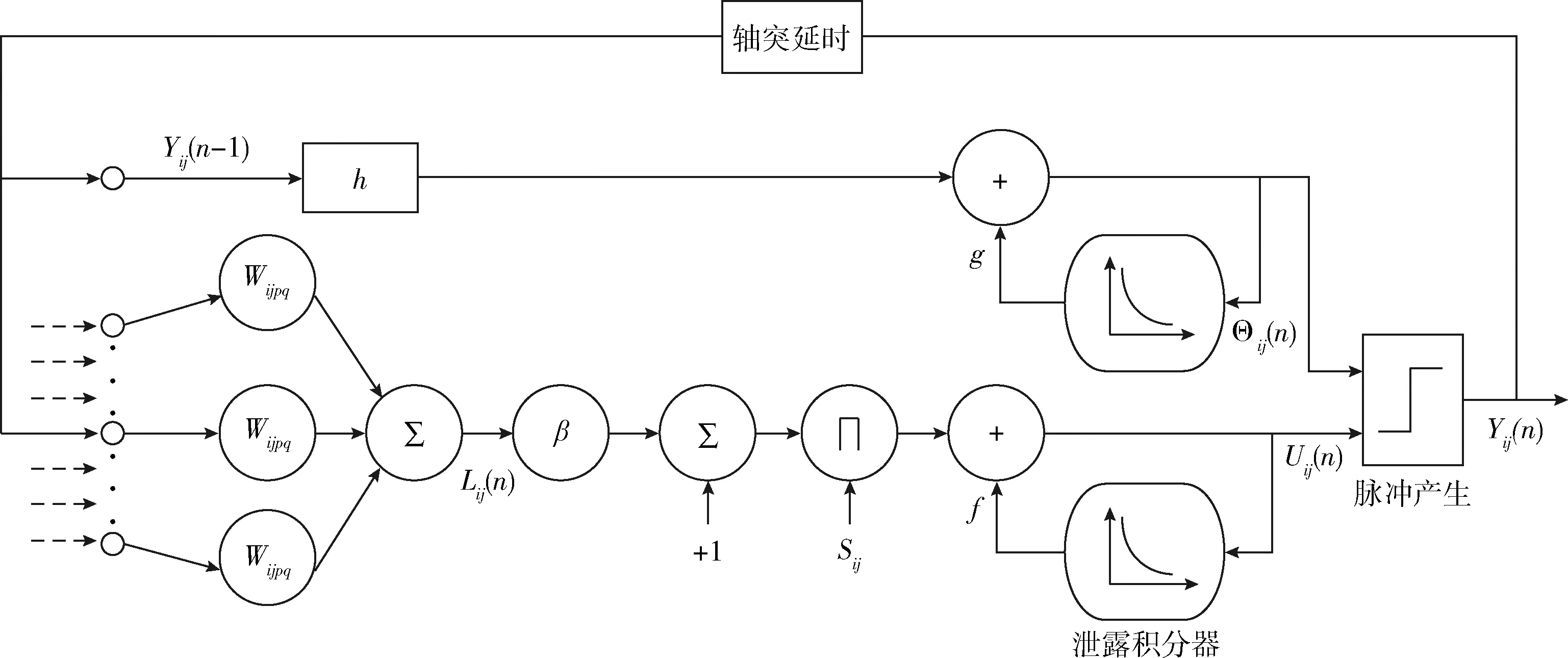

單個(gè)PCNN[14,15]神經(jīng)元由輸入、鏈接調(diào)制、脈沖產(chǎn)生3部分構(gòu)成。PCNN的輸入部分包含反饋輸入以及鏈接輸入,其中反饋輸入是主要輸入信號(hào),用于刺激PCNN神經(jīng)網(wǎng)絡(luò)開(kāi)始運(yùn)作,鏈接輸入部分作為輔助信號(hào),將其與反饋輸入信號(hào)相調(diào)制,調(diào)制結(jié)果輸出到脈沖產(chǎn)生域。若調(diào)制結(jié)果大于閾值,則神經(jīng)元產(chǎn)生點(diǎn)火并發(fā)射脈沖。如此經(jīng)過(guò)多次迭代以后,將神經(jīng)元總的點(diǎn)火次數(shù)構(gòu)成點(diǎn)火映射圖作為PCNN的輸出。

2.2 鏈接突觸計(jì)算神經(jīng)網(wǎng)絡(luò)

LSCN模型在PCNN的基礎(chǔ)上做了兩點(diǎn)改進(jìn),包括將膜電位表達(dá)為漏電積分器以及對(duì)反饋輸入進(jìn)行簡(jiǎn)化。其數(shù)學(xué)表達(dá)式如下

(6)

其中,L是鏈接輸入,U表示神經(jīng)元內(nèi)部調(diào)制結(jié)果,Θ和Y分別代表閾值和神經(jīng)元的輸出,l為鏈接常量,Wijpq是鏈接輸入權(quán)值,f和g均表示衰減常量,S、β、h依次為外部刺激輸入、鏈接強(qiáng)度及放大系數(shù)。相關(guān)LSCN增強(qiáng)模型的理論內(nèi)容可以參考文獻(xiàn)[13]。單個(gè)LSCN神經(jīng)元結(jié)構(gòu)如圖1所示。

圖1 LSCN神經(jīng)元結(jié)構(gòu)模型

3 本文融合算法

3.1 融合規(guī)則步驟

本文融合算法過(guò)程圖如圖2所示,算法步驟如下:

步驟1 采用NSCT對(duì)源圖像進(jìn)行分解,得到低頻子帶LJ(x,y)與高頻子帶Hj,r(x,y),其中J為分解層數(shù),j、r代表分解尺度和方向數(shù)。

步驟2 對(duì)NSCT低頻子帶進(jìn)行SWT分解,分別采用局部能量與絕對(duì)值取大相結(jié)合和CS理論對(duì)小波低頻、高頻子帶進(jìn)行融合,再進(jìn)行小波逆變換得到NSCT重構(gòu)的低頻子帶系數(shù)。

步驟3 判斷待融合圖像的清晰度,根據(jù)判決準(zhǔn)則選取

LSCN的增強(qiáng)層數(shù)。

步驟4 分別采用絕對(duì)值取大與IPCNN模型對(duì)NSCT高頻子帶的最高層與其余各層子帶進(jìn)行融合。

步驟5 對(duì)融合得到的低、高頻子帶進(jìn)行NSCT逆變換,得到融合圖像。

3.2 低頻融合規(guī)則

根據(jù)不同多尺度分析方法的互補(bǔ)特性[16,17],采用SWT對(duì)NSCT分解得到的低頻系數(shù)進(jìn)行融合。圖像的低頻部分包含了圖像中大部分能量信息,本文采用局部區(qū)域能量與絕對(duì)值取大相結(jié)合的融合方式對(duì)SWT低頻子帶進(jìn)行融合,融合準(zhǔn)則如式(7)所示

圖2 本文融合算法過(guò)程

(7)

式中:EN為局部區(qū)域能量,其定義為

(8)

對(duì)于SWT分解得到的高頻子帶系數(shù),采用CS理論進(jìn)行融合,提高了算法效率,具體步驟如下:

(2)設(shè)計(jì)測(cè)量矩陣Φ,對(duì)輸入的高頻子帶系數(shù)進(jìn)行測(cè)量

(9)

標(biāo)準(zhǔn)差反映了圖像的對(duì)比度信息,其公式為

(10)

圖像清晰度公式為

(11)

加權(quán)系數(shù)ω參考文獻(xiàn)[11]中的S函數(shù)得到,即

(12)

其中

(13)

f為S函數(shù)的收縮因子,并且f大于等于1,本文取f=5;

3.3 高頻融合規(guī)則

圖像的細(xì)節(jié)成分大多保存在高頻子帶中。本文采用分層融合的策略對(duì)高頻部分進(jìn)行融合,并在融合過(guò)程中引入LSCN模型對(duì)高頻系數(shù)進(jìn)行增強(qiáng)。由于LSCN模型有時(shí)存在微弱的振鈴效應(yīng),且直接使用LSCN對(duì)高頻系數(shù)增強(qiáng)會(huì)過(guò)分突出融合圖像的邊緣,因此本文通過(guò)計(jì)算待融合圖像的清晰度來(lái)判斷LSCN增強(qiáng)的高頻層數(shù)。融合準(zhǔn)則如下:

根據(jù)式(11)計(jì)算圖像清晰度并將其與閾值λ比較,根據(jù)比較結(jié)果決定高頻系數(shù)增強(qiáng)的層數(shù),即

(14)

其中,J為分解層數(shù),兩幅圖像整體的清晰度用S表示,取α1=α2=0.5,λ=27。

對(duì)最高層高頻子帶n采用絕對(duì)值取大的方法進(jìn)行融合,以提高融合圖像總體的對(duì)比度和亮度,即

(15)

為了增強(qiáng)圖像的視覺(jué)觀感,對(duì)除最高層高頻子帶n以外的其余子帶,采用IPCNN模型進(jìn)行融合,通過(guò)比較IPCNN神經(jīng)元的點(diǎn)火幅度之和來(lái)確定融合系數(shù),即

(16)

其中,Mij(n)為IPCNN輸出的脈沖點(diǎn)火幅度總和,j=1,2,…,n-1,ε為自定義閾值,本文取ε=0.002。

本文采用一種軟限幅的Sigmoid函數(shù)作為IPCNN神經(jīng)元的輸出,與傳統(tǒng)PCNN模型相比,能夠更好體現(xiàn)神經(jīng)元點(diǎn)火時(shí)脈沖幅度的不同。Sigmoid函數(shù)為

(17)

本文選用改進(jìn)的拉普拉斯能量和(sum of modified Laplacian,SML)與局部空間頻率分別作為IPCNN的外部輸入和鏈接系數(shù),以更好地保留圖像的邊緣信息。SML定義如下

SMLj,r(i,j)=|2Ij,r(i,j)-Ij,r(i-h,j)-Ij,r(i+h,j)|+

|2Ij,r(i,j)-Ij,r(i,j-h)-Ij,r(i,j+h)|+

|1.4Ij,r(i,j)-0.7Ij,r(i-h,j-h)-0.7Ij,r(i+h,j+h)|+

|1.4Ij,r(i,j)-0.7Ij,r(i+h,j-h)-0.7Ij,r(i-h,j+h)|

(18)

空間頻率為

(19)

其中,RF、CF、MDF和SDF分別表示行頻率、列頻率、主對(duì)角頻率和副對(duì)角頻率,其公式如下

RF=[I(i,j)-I(i,j-1)]2

CF=[I(i,j)-I(i-1,j)]2

MDF=[I(i,j)-I(i-1,j-1)]2

SDF=[I(i,j)-C(i-1,j+1)]2

(20)

4 融合實(shí)驗(yàn)與效果分析

4.1 實(shí)驗(yàn)設(shè)置

選取幾組待融合圖像進(jìn)行算法驗(yàn)證,并將本文算法的融合結(jié)果與其它方法進(jìn)行比較。本文中所選圖像均為灰度圖。NSCT采用′maxflat′濾波器和′dmaxflat7′濾波器,方向級(jí)數(shù)為[1,2,2]。IPCNN的迭代次數(shù)為10次,遠(yuǎn)小于文獻(xiàn)[14]中設(shè)置的200次。實(shí)驗(yàn)采用的CS分塊大小均為8×8,局部窗口大小為3×3。

4.2 UNcamp圖像集實(shí)驗(yàn)

圖3為UNcamp圖像集與不同算法的融合結(jié)果。其中圖3(a)為紅外圖像,圖中行人目標(biāo)清晰可見(jiàn),但缺乏行人所在的場(chǎng)景信息。圖3(b)為可見(jiàn)光圖像,它包含了目標(biāo)需要的場(chǎng)景內(nèi)容,如樹木、房屋、圍欄等。圖3(c)~圖3(f)分別為文獻(xiàn)[7]、文獻(xiàn)[8]、文獻(xiàn)[14]和本文方法的融合圖像。從視覺(jué)角度看,以上方法均成功融合了源圖像的有效信息。但經(jīng)過(guò)仔細(xì)觀察,圖3(c)對(duì)比度較低,亮度相對(duì)不高,圖3(d)中行人目標(biāo)偏暗,目標(biāo)相對(duì)不夠突出,圖3(e)背景較為模糊,邊緣不夠?qū)R,視覺(jué)觀感欠佳。本文融合圖像邊緣突出,對(duì)比度和亮度較好,目標(biāo)突出,并且能夠清晰看到遠(yuǎn)處路邊生長(zhǎng)的草塊,相對(duì)于其它3種方法有較為明顯的優(yōu)勢(shì)。

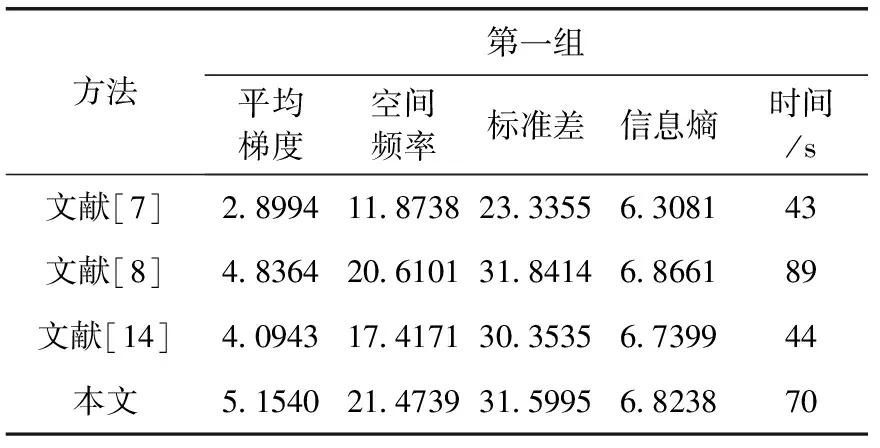

圖3 UNcamp圖像集與不同算法融合結(jié)果

平均梯度反映了圖像是否清晰,空間頻率可以統(tǒng)計(jì)圖像相鄰像素間的差異,信息熵則表示了圖像中信息量的大小[18-20]。本文采用以上指標(biāo)以及標(biāo)準(zhǔn)差作為圖像質(zhì)量的客觀評(píng)價(jià)指標(biāo)。UNcamp圖像集的客觀評(píng)價(jià)結(jié)果見(jiàn)表1,表1可以看出本文融合圖像的平均梯度、空間頻率與其它方法相比有較大提升,圖像的標(biāo)準(zhǔn)差、信息熵相對(duì)較高。本文算法采用的融合策略相對(duì)復(fù)雜,并且在融合過(guò)程中進(jìn)一步采用SWT和LSCN模型,因此算法的融合速度相對(duì)一般。

表1 UNcamp圖像集實(shí)驗(yàn)結(jié)果對(duì)比

4.3 其它測(cè)試集實(shí)驗(yàn)

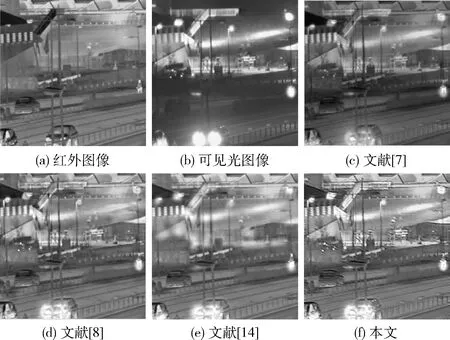

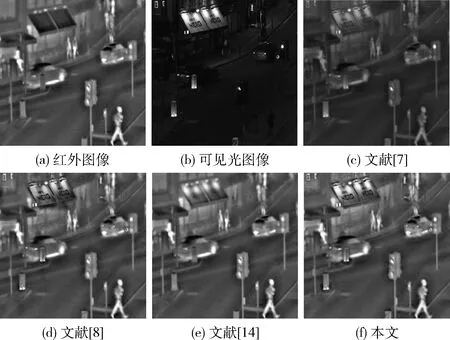

圖4、圖5為另外兩組圖像集的融合結(jié)果。從主觀評(píng)價(jià)來(lái)看,圖(c)仍有亮度偏低、對(duì)比度不高的情況,總體效果一般。圖(d)總體效果較好,但部分區(qū)域存在背景缺失的現(xiàn)象。例如,圖4中的遠(yuǎn)處燈光較暗,圖5中的廣告牌處有部分陰影產(chǎn)生。圖(e)表現(xiàn)不佳,背景信息丟失嚴(yán)重,視覺(jué)觀感較差。在這兩組實(shí)驗(yàn)中,圖(f)融合效果最好,整體看起來(lái)亮度適中,目標(biāo)較為清晰,背景信息豐富,滿足人眼的視覺(jué)舒適度。

圖4 第一組圖像與不同算法融合結(jié)果

圖5 第二組圖像與不同算法融合結(jié)果

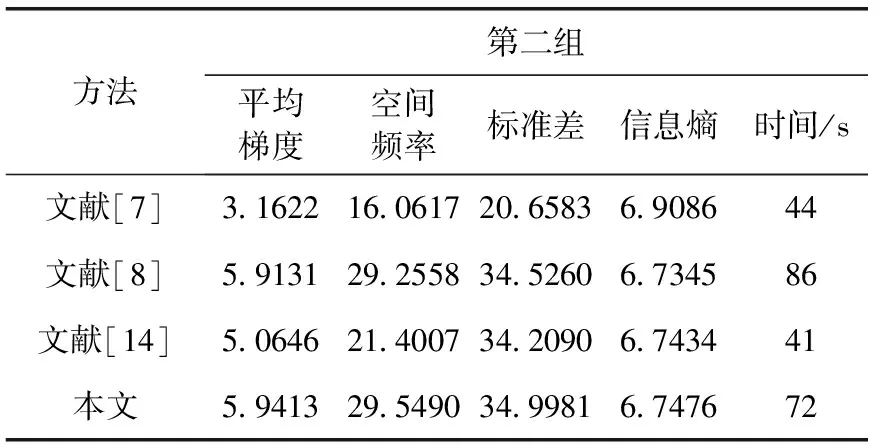

表2、表3分別為第一組、第二組融合實(shí)驗(yàn)的客觀評(píng)價(jià)結(jié)果。從表2中可以看到,本文算法的各項(xiàng)指標(biāo)均優(yōu)于其它算法。本文算法的總體表現(xiàn)在表3中依舊最佳,各個(gè)指標(biāo)相對(duì)比其它算法也都有所提升,但圖像的信息熵要遜色于文獻(xiàn)[7]。總體來(lái)說(shuō),本文算法在主觀評(píng)價(jià)與客觀評(píng)價(jià)兩個(gè)方面表現(xiàn)均優(yōu)于其它3種算法。

表2 第一組圖像融合結(jié)果評(píng)價(jià)

表3 第二組圖像融合結(jié)果評(píng)價(jià)

5 結(jié)束語(yǔ)

針對(duì)傳統(tǒng)紅外與可見(jiàn)光圖像融合算法存在的不足,提出了一種基于IPCNN的圖像融合算法。對(duì)NSCT低頻子帶進(jìn)一步進(jìn)行SWT分解,對(duì)SWT分解后的低頻部分,使用局部能量與絕對(duì)值取大相結(jié)合的融合方法。采用CS理論對(duì)SWT分解后的高頻部分進(jìn)行融合,可以減少融合過(guò)程中的計(jì)算量。針對(duì)NSCT分解得到的高頻子帶采用分層融合的策略,分別采用絕對(duì)值取大和IPCNN模型對(duì)高頻子帶的最高層和其余各層進(jìn)行融合。本文在高頻融合過(guò)程中還引入了一種LSCN模型,能夠進(jìn)一步增強(qiáng)圖像的細(xì)節(jié)信息。實(shí)驗(yàn)結(jié)果表明本文算法的各項(xiàng)評(píng)價(jià)指標(biāo)均優(yōu)于其它算法,視覺(jué)觀感較好,是一種切實(shí)可行的融合方法。