基于SSD_MobileNet模型的ROS平臺(tái)目標(biāo)檢測(cè)①

童 星, 張 激

(中國(guó)電子科技集團(tuán)公司第32研究所, 上海 201808)

目標(biāo)檢測(cè)作為計(jì)算機(jī)視覺的重要研究方向, 被廣泛應(yīng)用于無人駕駛、智能攝像頭、人臉識(shí)別等新興科研領(lǐng)域. 它是以圖像分類技術(shù)為基礎(chǔ), 對(duì)圖像中目標(biāo)對(duì)象進(jìn)行識(shí)別分類, 并且在目標(biāo)對(duì)象周圍繪制適當(dāng)大小的邊界框?qū)ζ溥M(jìn)行定位實(shí)現(xiàn)的[1]. 從2012年深度學(xué)習(xí)算法AlexNet獲得ILSVRC (ImageNet Large Scale Visual Recognition Challenge) 圖像分類比賽的冠軍后,深度學(xué)習(xí)算法在圖像處理和目標(biāo)檢測(cè)技術(shù)應(yīng)用中不斷取得重大突破, 其中卷積神經(jīng)網(wǎng)絡(luò)(Convolution Neural Network, CNN)和候選區(qū)域(Region Proposal)算法起到了關(guān)鍵性作用. 目前很多成熟的目標(biāo)檢測(cè)深度學(xué)習(xí)算法在檢測(cè)精度和速度上有著非常不錯(cuò)的表現(xiàn), 以SSD[2](Single Shot MultiBox Detector)算法為例, 使用VOC2007數(shù)據(jù)集在NVIDIA Titan X上測(cè)試, mAP(mean Average Precision)可以達(dá)到74.3%, 速度達(dá)到每秒59幀.

在機(jī)器人技術(shù)領(lǐng)域中, 目標(biāo)檢測(cè)同樣具有重要作用. 它是機(jī)器人完成諸多智能行為的必要前提, 例如機(jī)械手臂的智能抓取和無人車的智能避障. 而ROS(Robot Operating System)作為目前最受歡迎的機(jī)器人應(yīng)用開發(fā)平臺(tái)之一, 實(shí)現(xiàn)快速準(zhǔn)確的目標(biāo)檢測(cè)功能具有十分重要的實(shí)際意義. ROS應(yīng)用開發(fā)平臺(tái)提供了消息傳遞、分布式計(jì)算、代碼重用等優(yōu)勢(shì)功能, 具有跨平臺(tái)、模塊化、集成度高和社區(qū)活躍等特點(diǎn)[3]. 目前ROS平臺(tái)自帶一些實(shí)現(xiàn)目標(biāo)檢測(cè)功能的數(shù)據(jù)包, 主要是基于傳統(tǒng)的局部圖像特征描述方法實(shí)現(xiàn)的. 這些傳統(tǒng)方法與深度學(xué)習(xí)算法相比, 目標(biāo)檢測(cè)的魯棒性和泛化能力上存在明顯的差距.

本文將首先介紹ROS平臺(tái)實(shí)現(xiàn)目標(biāo)檢測(cè)功能的原理, 并選取典型的目標(biāo)檢測(cè)數(shù)據(jù)包, 實(shí)現(xiàn)完整的目標(biāo)檢測(cè)過程, 分析實(shí)驗(yàn)結(jié)果; 然后通過制作用于目標(biāo)檢測(cè)的圖像數(shù)據(jù)集, 結(jié)合 SSD_MobileNet預(yù)訓(xùn)練模型, 在NVIDIA JETSON TX2開發(fā)板上訓(xùn)練定制的目標(biāo)檢測(cè)模型, 并將訓(xùn)練好的模型集成到ROS平臺(tái), 實(shí)現(xiàn)目標(biāo)檢測(cè)功能, 并與ROS平臺(tái)自帶數(shù)據(jù)包實(shí)現(xiàn)的目標(biāo)檢測(cè)效果進(jìn)行對(duì)比, 得出結(jié)論.

1 ROS平臺(tái)目標(biāo)檢測(cè)功能

傳統(tǒng)的ROS平臺(tái)目標(biāo)檢測(cè)功能主要是基于局部圖像特征描述方法實(shí)現(xiàn)的. ROS平臺(tái)通過攝像頭等設(shè)備獲取包含目標(biāo)物體的圖像場(chǎng)景, 運(yùn)用局部圖像特征描述方法提取目標(biāo)對(duì)象的特征, 并根據(jù)提取的特征去目標(biāo)場(chǎng)景中檢測(cè)和識(shí)別目標(biāo)對(duì)象. 本章節(jié)首先介紹局部圖像特征描述的實(shí)現(xiàn)原理, 然后以find_object_2d數(shù)據(jù)包為例介紹ROS平臺(tái)目標(biāo)檢測(cè)功能的實(shí)現(xiàn)過程, 并分析實(shí)驗(yàn)結(jié)果.

1.1 局部圖像特征描述

局部圖像特征描述主要功能是尋找圖像中的對(duì)應(yīng)點(diǎn)以及完成物體特征描述, 目前在三維場(chǎng)景構(gòu)造、物體識(shí)別、圖像拼接和配準(zhǔn)等領(lǐng)域應(yīng)用廣泛[4]. 局部圖像特征描述的核心有兩點(diǎn): 不變性和可區(qū)分性, 不變性是指對(duì)圖像變化情況下的處理能力, 而可區(qū)分性指的是對(duì)圖像中不同對(duì)象特征的區(qū)別能力[5]. 好的局部圖像特征描述算法應(yīng)同時(shí)具備好的不變性和可區(qū)分性, 代表性的算法有SIFT (Scale Invariant Feature Transform)、SURF (Speeded Up Robust Features)等. 由于圖像位置變化多樣性、光線變化多樣性、視角多樣性等因素,使得通過傳統(tǒng)的局部圖像特征描述方法提取魯棒的物體特征十分困難. 同時(shí)局部圖像特征描述方法提取局部紋理特征時(shí)丟失的全局信息, 也讓目標(biāo)檢測(cè)的泛化能力十分有限.

1.2 find_object_2d目標(biāo)檢測(cè)數(shù)據(jù)包

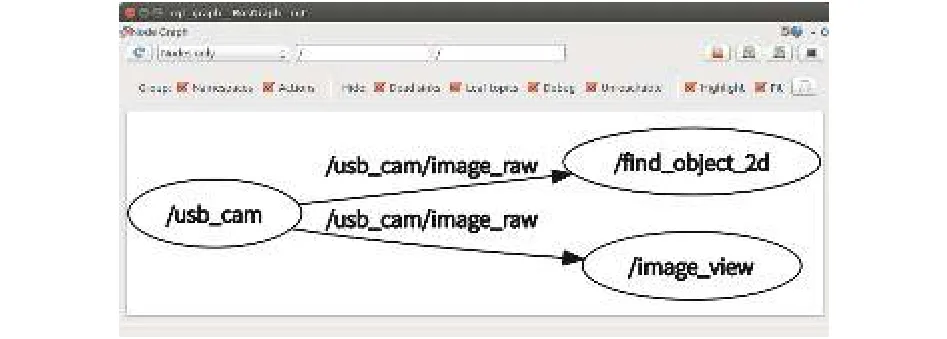

find_object_2d是ROS平臺(tái)中實(shí)現(xiàn)目標(biāo)檢測(cè)功能的典型數(shù)據(jù)包, 它具有簡(jiǎn)單的Qt圖形界面, 通過調(diào)用OpenCV庫(kù)的SURF、SIFT等局部圖像特征描述子實(shí)現(xiàn)目標(biāo)檢測(cè)功能[6]. find_object_2d包目標(biāo)檢測(cè)功能的實(shí)現(xiàn)過程如圖1所示. 首先啟動(dòng)find_object_2d包的目標(biāo)檢測(cè)節(jié)點(diǎn), 節(jié)點(diǎn)會(huì)訂閱由攝像頭等圖像獲取設(shè)備發(fā)布的圖像會(huì)話, 獲得圖像場(chǎng)景信息, 并打開Find-Object窗口. 在該窗口中可以直接提取圖像場(chǎng)景中目標(biāo)對(duì)象的特征, 然后在目標(biāo)檢測(cè)階段, find_object_2d包根據(jù)提取的對(duì)象特征在圖像場(chǎng)景中檢測(cè)目標(biāo)對(duì)象, 并在檢測(cè)到目標(biāo)對(duì)象之后, 在圖像場(chǎng)景中用適當(dāng)大小的邊界框標(biāo)識(shí)出檢測(cè)到的目標(biāo)對(duì)象. find_object_2d包實(shí)現(xiàn)目標(biāo)檢測(cè)的框架如圖2所示. 調(diào)用USB攝像頭驅(qū)動(dòng)啟動(dòng)節(jié)點(diǎn)/usb_cam, 發(fā)布的/usb_cam/image_raw會(huì)話由/find_object_2d節(jié)點(diǎn)訂閱, 進(jìn)而實(shí)現(xiàn)目標(biāo)檢測(cè)功能.

圖1 find_object_2d包目標(biāo)檢測(cè)功能的實(shí)現(xiàn)過程

1.3 實(shí)驗(yàn)結(jié)果分析

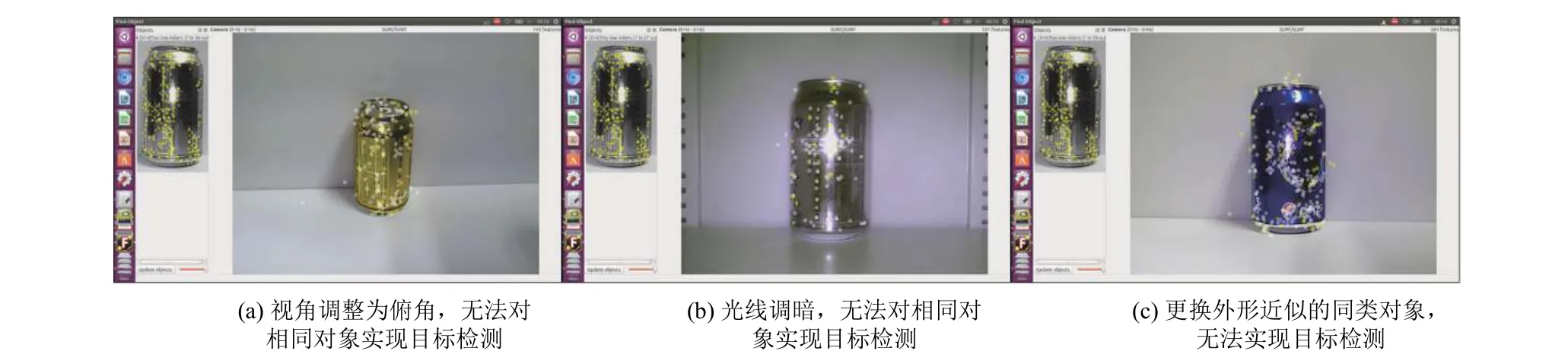

以find_object_2d包為代表的實(shí)現(xiàn)ROS平臺(tái)目標(biāo)檢測(cè)功能, 在目標(biāo)對(duì)象特征提取過程中不需要大量的圖像數(shù)據(jù)集即可完成特征提取, 但是在目標(biāo)對(duì)象檢測(cè)過程中, 對(duì)于目標(biāo)物體因視角、光照強(qiáng)度等因素照成的圖像變化影響魯棒性差. 同時(shí)由于單張圖像提取局部特征的限制, 對(duì)于外形近似的同類別對(duì)象也無法檢測(cè)和識(shí)別, 實(shí)驗(yàn)效果如圖3所示.

圖2 find_object_2d包實(shí)現(xiàn)目標(biāo)檢測(cè)的框架

2 深度學(xué)習(xí)算法實(shí)現(xiàn)ROS平臺(tái)目標(biāo)檢測(cè)

深度學(xué)習(xí)算法應(yīng)用于目標(biāo)檢測(cè)技術(shù)盡管時(shí)間不長(zhǎng),但是效果顯著, 并且不斷取得進(jìn)步與突破. 從使用卷積神經(jīng)網(wǎng)絡(luò)處理多尺度滑窗的OverFeat算法[7], 到以RCNN[8-11]算法 (包括 R-CNN, SPP-NET, Fast R-CNN,F(xiàn)aster R-CNN等)為代表的結(jié)合卷積神經(jīng)網(wǎng)絡(luò)分類和候選區(qū)域的目標(biāo)檢測(cè)算法, 再到以YOLO[12](You Only Look Once)和SSD為代表的將目標(biāo)檢測(cè)轉(zhuǎn)化為回歸問題的算法, 深度學(xué)習(xí)已經(jīng)成為目標(biāo)檢測(cè)的核心, 推動(dòng)著目標(biāo)檢測(cè)技術(shù)的快速發(fā)展. 本次實(shí)驗(yàn)選擇基于SSD框架結(jié)合MobileNet網(wǎng)絡(luò)結(jié)構(gòu)的目標(biāo)檢測(cè)模型,本章將首先介紹SSD模型的基本結(jié)構(gòu)和實(shí)現(xiàn)目標(biāo)檢測(cè)的原理, 再分析結(jié)合MobileNet網(wǎng)絡(luò)作為特征提取模塊的優(yōu)勢(shì), 最后介紹完整的模型訓(xùn)練以及集成到ROS平臺(tái)的過程.

2.1 SSD_MobileNet模型

目前基于候選區(qū)域的深度學(xué)習(xí)目標(biāo)檢測(cè)算法效果令人滿意, 以Faster R-CNN算法為例, 在VOC2007測(cè)試集測(cè)試mAP達(dá)到73.2%, 但是測(cè)試速度僅為每秒5幀[11]. 這是因?yàn)轭A(yù)先獲取候選區(qū)域, 然后對(duì)每個(gè)區(qū)域進(jìn)行分類處理計(jì)算量非常巨大, 無法達(dá)到實(shí)時(shí)的目標(biāo)檢測(cè)效果. 于是便孕育了一類使用回歸思想的目標(biāo)檢測(cè)算法, 既給定輸入圖像, 直接在圖像的多個(gè)位置上回歸出這個(gè)位置的目標(biāo)邊框以及目標(biāo)類別. YOLO算法是將目標(biāo)檢測(cè)任務(wù)轉(zhuǎn)換成回歸問題的代表性算法[12],它將圖像分割為若干網(wǎng)格, 每個(gè)網(wǎng)格輸出若干包圍盒,包含目標(biāo)置信度的值, 同時(shí)每個(gè)網(wǎng)格預(yù)測(cè)各自的類別信息, 測(cè)試時(shí)通過每個(gè)網(wǎng)格的類別概率和包圍盒的置信度即可實(shí)現(xiàn)目標(biāo)檢測(cè). 但是YOLO對(duì)于目標(biāo)對(duì)象的尺度比較敏感, 對(duì)尺度變化較大的物體泛化能力較差,即位置預(yù)測(cè)不夠精確. 同時(shí)因?yàn)槊總€(gè)網(wǎng)格只檢測(cè)一個(gè)目標(biāo)對(duì)象, 所以容易造成誤檢. 針對(duì)以上問題, SSD目標(biāo)檢測(cè)方法提供了很好的解決方案, 它結(jié)合YOLO的回歸思想和Faster R-CNN算法中的anchor機(jī)制, 在保證了實(shí)時(shí)性前提下提高了目標(biāo)檢測(cè)的精度.

圖3 實(shí)驗(yàn)結(jié)果展示

SSD模型是由Wei Liu、Dragomir Anguelov等人[2]提出的使用單個(gè)深層神經(jīng)網(wǎng)絡(luò)檢測(cè)圖像中對(duì)象的方法.SSD模型的結(jié)構(gòu)如圖4所示: 前五層為VGG-16網(wǎng)絡(luò)的卷積層, 第六和第七層全連接層轉(zhuǎn)化為兩個(gè)卷積層,后面再添加三個(gè)卷積層和一個(gè)平均池化層. 基礎(chǔ)網(wǎng)絡(luò)結(jié)構(gòu)為VGG-16卷積神經(jīng)網(wǎng)絡(luò)的主體, 并連接多層卷積層和池化層作為額外特征提取層. SSD同樣采用回歸方法獲取目標(biāo)對(duì)象位置和類別, 不同的是SSD使用的是目標(biāo)對(duì)象位置周圍的特征而非全圖的特征.SSD各卷積層將特征圖分割為若干相同大小的網(wǎng)格,稱為feature map cell, 對(duì)每個(gè)網(wǎng)格設(shè)定一系列固定大小的包圍盒, 稱為default boxes. 然后分別預(yù)測(cè)default boxes的偏移以及類別得分, 最終通過非極大值抑制方法得到檢測(cè)結(jié)果. default boxes的作用類似于Faster R-CNN的anchor機(jī)制, 不同的是default boxes作用于不同層次的多個(gè)特征圖上, 這樣可以利用多層的特征以最佳尺度匹配目標(biāo)對(duì)象的實(shí)際區(qū)域(groudtruth).

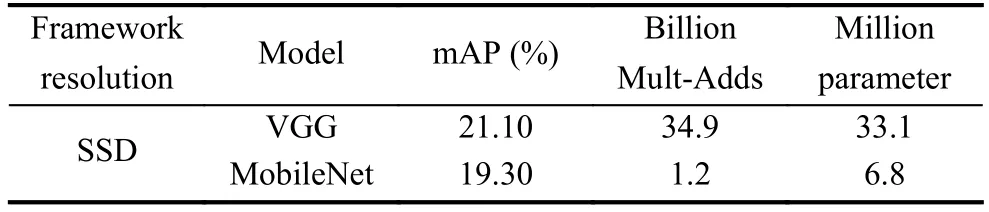

SSD_MobileNet模型是使用MobileNet網(wǎng)絡(luò)代替VGG網(wǎng)絡(luò)作為基礎(chǔ)網(wǎng)絡(luò)結(jié)構(gòu). MobileNet是Andrew G.Howard等人提出的適用于嵌入式視覺應(yīng)用的高效模型. MobileNet的主要特點(diǎn)是用深度級(jí)可分離卷積替代傳統(tǒng)網(wǎng)絡(luò)結(jié)構(gòu)的標(biāo)準(zhǔn)卷積來解決卷積網(wǎng)絡(luò)的計(jì)算效率低和參數(shù)量巨大的問題. Andrew G. Howard等人在實(shí)驗(yàn)中對(duì)比了基于SSD框架下, VGG模型和MobileNet模型使用COCO數(shù)據(jù)集訓(xùn)練及測(cè)試的結(jié)果[13], 如表1所示. 可見SSD框架結(jié)合MobileNet網(wǎng)絡(luò)結(jié)構(gòu)實(shí)現(xiàn)目標(biāo)檢測(cè)盡管檢測(cè)準(zhǔn)確率略有下降, 但計(jì)算量和參數(shù)量大幅減少. 對(duì)于機(jī)器人等嵌入式平臺(tái)應(yīng)用來說, 硬件資源有限, 使用MobileNet這樣的輕量級(jí)、低延遲的網(wǎng)絡(luò)模型能夠有效地提高目標(biāo)檢測(cè)的實(shí)時(shí)性.

圖4 SSD模型的結(jié)構(gòu)圖

表1 SSD-VGG和SSD-MobileNet測(cè)試結(jié)果對(duì)比

2.2 模型的訓(xùn)練與集成

Google推出的TensorFlow[14]是目前最受歡迎的深度學(xué)習(xí)框架之一, 而開放的Object Detection API是基于TensorFlow構(gòu)造的開源代碼示例庫(kù), 通過Object Detection API能夠?qū)σ恍┐笮颓页墒斓哪繕?biāo)檢測(cè)模型進(jìn)行高效的重復(fù)利用, 結(jié)合特定的圖像數(shù)據(jù)集即可訓(xùn)練具有定制功能的目標(biāo)檢測(cè)模型. 本次實(shí)驗(yàn)將通過Object Detection API, 基于 Google 預(yù)訓(xùn)練 SSD_MobileNet模型, 結(jié)合自己搜集制作的圖像數(shù)據(jù)集, 訓(xùn)練定制的目標(biāo)檢測(cè)模型, 并集成到ROS平臺(tái), 實(shí)現(xiàn)目標(biāo)檢測(cè)功能.

2.2.1 數(shù)據(jù)集制作

模型訓(xùn)練需要的圖像數(shù)據(jù)集必須為TFRecord檔案格式. 首先搜集包含目標(biāo)對(duì)象的圖片, 實(shí)驗(yàn)為了與ROS平臺(tái)find_object_2d包實(shí)現(xiàn)目標(biāo)檢測(cè)實(shí)驗(yàn)進(jìn)行對(duì)照, 選擇的目標(biāo)對(duì)象類別為易拉罐, 以及與易拉罐相近的杯子和瓶子, 每類圖片各20張, 共計(jì)60張圖片. 再使用圖片標(biāo)記軟件對(duì)原始圖片進(jìn)行目標(biāo)對(duì)象位置標(biāo)記,并轉(zhuǎn)化為標(biāo)準(zhǔn)的VOC目標(biāo)檢測(cè)數(shù)據(jù)集格式: 包含Annotations、ImageSets、JPEGImages三個(gè)文件, 其中Annotations文件存放了每張圖片的標(biāo)注信息,為.xml格式; ImageSets文件記錄了分別用于訓(xùn)練、驗(yàn)證和測(cè)試的樣本名稱, 為.txt格式; 而 JPEGImages則存放了所有圖片, 為.jpg格式. 最后調(diào)用 Object Detection API 庫(kù)中的數(shù)據(jù)格式轉(zhuǎn)化程序 create_pascal_tf_record.py,將數(shù)據(jù)集轉(zhuǎn)化為TFRecord 格式.

2.2.2 模型訓(xùn)練

實(shí)驗(yàn)中預(yù)訓(xùn)練模型版本選擇的是ssd_mobilenet_v1_coco_2017_11_17. 下載模型, 編寫模型訓(xùn)練配置文件, 結(jié)合制作的圖像數(shù)據(jù)集, 在NVIDIA JETSON TX2嵌入式開發(fā)板上訓(xùn)練定制的模型. 實(shí)驗(yàn)中設(shè)置初始學(xué)習(xí)率為0.004, 衰減速度和系數(shù)分別為800 720和0.95.訓(xùn)練步數(shù)設(shè)定為95 000步, 使用TensorFlow自帶的可視化工具TensorBoard可查看模型訓(xùn)練情況, 如圖5所示, 隨著訓(xùn)練步數(shù)的增加模型的損失率逐漸減小, 并最終接近1.0. 訓(xùn)練結(jié)束之后, 調(diào)用Object Detection API庫(kù)中的export_inference_graph.py腳本將包含模型結(jié)構(gòu)和參數(shù)的臨時(shí)文件轉(zhuǎn)化為可獨(dú)立運(yùn)行的PB模型文件.

2.2.3 模型集成

ROS平臺(tái)通過定義節(jié)點(diǎn)來表示應(yīng)用程序, 不同節(jié)點(diǎn)之間通過預(yù)先定義的會(huì)話、服務(wù)或行為來實(shí)現(xiàn)彼此的通信[15]. 實(shí)現(xiàn)目標(biāo)檢測(cè)模型的ROS平臺(tái)集成, 需建立如圖6所示的目標(biāo)檢測(cè)節(jié)點(diǎn)以及網(wǎng)絡(luò)連接方式. 首先創(chuàng)建detect_ros目標(biāo)檢測(cè)節(jié)點(diǎn), 該節(jié)點(diǎn)中包含訓(xùn)練好的目標(biāo)檢測(cè)模型文件、目標(biāo)對(duì)象的標(biāo)簽文件以及TensorFlow的Object Detection API庫(kù). 節(jié)點(diǎn)實(shí)時(shí)地訂閱由USB攝像頭驅(qū)動(dòng)發(fā)布的包含圖像場(chǎng)景信息的會(huì)話, 以獲得原始圖像信息, 之后通過調(diào)用OpenCV庫(kù)的cv_bridge模塊將圖像信息轉(zhuǎn)化OpenCV數(shù)據(jù)格式, 再使用目標(biāo)檢測(cè)模型對(duì)OpenCV格式的圖像數(shù)據(jù)進(jìn)行進(jìn)行推理, 最后將推理的結(jié)果實(shí)時(shí)地發(fā)布會(huì)話, 訂閱該會(huì)話即可查看目標(biāo)檢測(cè)結(jié)果.

圖5 損失值隨模型訓(xùn)練步數(shù)的變化

圖6 目標(biāo)檢測(cè)節(jié)點(diǎn)以及網(wǎng)絡(luò)連接方式

3 實(shí)驗(yàn)結(jié)果對(duì)比與分析

連接外接USB攝像頭, 運(yùn)行目標(biāo)檢測(cè)節(jié)點(diǎn), 使用集成到ROS平臺(tái)的SSD_MobileNet目標(biāo)檢測(cè)模型可以識(shí)別出目標(biāo)對(duì)象的類別, 并通過適當(dāng)大小的包圍盒標(biāo)注目標(biāo)對(duì)象實(shí)現(xiàn)定位, 如圖7所示: 以81%的概率推測(cè)目標(biāo)對(duì)象類別為can (易拉罐), 并且以適當(dāng)大小的包圍盒圈住目標(biāo)對(duì)象實(shí)現(xiàn)定位. 以該目標(biāo)檢測(cè)結(jié)果為標(biāo)準(zhǔn), 設(shè)置相關(guān)對(duì)照實(shí)驗(yàn)如圖8所示, 實(shí)驗(yàn)證明SSD_MobileNet模型對(duì)于不同視角、不同光線強(qiáng)度場(chǎng)景下, 都有著非常好的目標(biāo)檢測(cè)魯棒性, 同時(shí)對(duì)于同類別對(duì)象檢測(cè)具有一定的泛化能力. 并且可通過訓(xùn)練數(shù)據(jù)集標(biāo)簽類別的豐富, 使得目標(biāo)檢測(cè)算法在單個(gè)場(chǎng)景圖像中實(shí)現(xiàn)多個(gè)不同類別目標(biāo)對(duì)象的檢測(cè)和識(shí)別. 實(shí)驗(yàn)中訓(xùn)練數(shù)據(jù)集中包含can、cup、bottle三種不同但外形近似的類別, 可以檢測(cè)出三種類別的對(duì)象.

圖7 目標(biāo)檢測(cè)結(jié)果展示

通過對(duì)以上實(shí)驗(yàn)結(jié)果進(jìn)行分析, 以及與find_object_2d包實(shí)現(xiàn)的目標(biāo)檢測(cè)結(jié)果進(jìn)行對(duì)比, 可以發(fā)現(xiàn)深度學(xué)習(xí)算法, 對(duì)于層次信息豐富的圖像數(shù)據(jù), 具有更好的特征提取和特征表達(dá)能力. 使得基于深度學(xué)習(xí)的目標(biāo)檢測(cè)算法能夠不受視角變化、光線強(qiáng)弱等因素的影響,獲得魯棒性強(qiáng)的目標(biāo)檢測(cè)效果. 同時(shí)伴隨著訓(xùn)練數(shù)據(jù)集的豐富, 深度學(xué)習(xí)目標(biāo)檢測(cè)算法對(duì)于同類別的目標(biāo)對(duì)象檢測(cè)以及單個(gè)場(chǎng)景多類別目標(biāo)對(duì)象檢測(cè)都有良好的表現(xiàn).

圖8 對(duì)照實(shí)驗(yàn)結(jié)果展示

4 結(jié)論

本文首先介紹了ROS平臺(tái)目標(biāo)檢測(cè)功能的實(shí)現(xiàn)原理, 并以find_object_2d數(shù)據(jù)包為例演示了目標(biāo)檢測(cè)過程, 通過分析實(shí)驗(yàn)結(jié)果發(fā)現(xiàn)傳統(tǒng)的目標(biāo)檢測(cè)方法魯棒性和泛化能力差. 然后介紹了目前流行的深度學(xué)習(xí)目標(biāo)檢測(cè)算法SSD的結(jié)構(gòu)及其實(shí)現(xiàn)機(jī)制, 并分析了SSD框架結(jié)合MobileNet網(wǎng)絡(luò)結(jié)構(gòu)的實(shí)時(shí)性優(yōu)勢(shì), 最后基于Google的SSD_MobileNet預(yù)訓(xùn)練模型, 結(jié)合制作的圖像數(shù)據(jù)集, 重新訓(xùn)練定制的目標(biāo)檢測(cè)模型, 并集成到ROS平臺(tái)實(shí)現(xiàn)目標(biāo)檢測(cè)功能. 通過實(shí)驗(yàn)結(jié)果對(duì)比,證明了深度學(xué)習(xí)目標(biāo)檢測(cè)算法對(duì)圖像特征提取和表達(dá)具有更好的表現(xiàn), 目標(biāo)檢測(cè)的魯棒性和泛化能力更強(qiáng).