基于改進卷積神經網絡的單幅圖像物體重建方法

張玉麒 陳 加 葉立志 田 元 夏 丹 陳亞松

(華中師范大學教育信息技術學院 湖北 武漢 430079)

0 引 言

從二維圖像中獲得三維信息并恢復三維模型是計算機視覺研究的主要方向之一。基于圖像的三維重建在諸如商品展示、文物三維修復、智慧城市建設、醫療器官重建等領域也具有重要的應用價值[1-5]。基于圖像的三維重建問題按照重建圖像的數量可以分為基于多幅圖像的三維重建方法[6-9]和基于單幅圖像的重建方法,按照重建的內容可以分為對物體的重建和對場景的重建[10]。本文主要針對基于單幅圖像的物體重建方法展開研究。

傳統方法按照重建方法的不同可以分為基于模型的重建方法和基于幾何外形恢復的重建方法。基于模型重建的方法通過匹配輸入圖像和模型,找到模型的最佳參數來進行重建。基于CAD模型的方法[11-12],能夠大致地展現物體的近似外形,在找到一組對應點后,可以很好地確定相應實例的視點,但是其獲得的模型和實際的模型仍然有很大偏差。形變模型(Morphable model)常用來重建人臉部分[13-14],其主要為一些可以變形的線性組合模型,通常由一些三維掃描的設備獲取。Cashman等[15]找到了降低三維數據獲取門檻的方式,通過三維模型和輔助的二維信息學習到相應的形變模型來重建物體。Vicente等[16]先在圖像數據集中匹配一張和輸入圖像相同類型相似視角的圖像,結合了可視外殼的方法,但是其無法應用于真實拍攝的圖像。Kar等[17]在Vicente等的工作基礎上,通過物體的二維注釋來學習相應的形變模型,不但可以重建真實拍攝的圖像,在重建效果上也有了一定的提升。基于模型的方法因為存在設計好的模型,對固定類別的物體能夠取得相對較好的重建效果,但是無法具有較好的泛化性。基于幾何外形恢復的方法主要包括從陰影中恢復外形(Shape from shading)[18-19]和從紋理中恢復外形(Shape from texture)[20-21],基于幾何外形恢復的方法能重建較多種類的物體,但其往往對灰度和光照等要求較高,對真實場景的物體圖片的重建效果欠佳。

近年來,隨著深度學習技術的不斷發展,出現了基于深度學習的物體重建方法。Choy等[22]提出了一套端到端的基于體素的重建網絡結構(3D recurrent reconstruction neural network,3D-R2N2),與傳統方法通過匹配一個最近似的模型并不斷優化其參數得到最佳模型不同,3D-R2N2利用大量的訓練去學習二維圖像和三維模型之間的映射,其無需對圖像加入分類標簽。在以IoU(Intersection-over-Union)值作為評價指標的對比實驗中,3D-R2N2的重建效果優于效果最好的傳統方法。但其在重建精度上仍無法達到可以使用的程度,且部分重建細節如桌腿等會存在缺失的問題,相較于二維領域也存在著計算量大、訓練時間長的缺點。此外也出現了基于深度學習的點云重建方法[23-25]和網格重建方法[26-28],與傳統方法相比也取得了較好的重建效果。

本文采用與3D-R2N2相似的網絡結構來做基于體素的單幅圖像物體重建,并針對相應模塊作出改進。

本文方法具有如下特點:

(1) 針對Encoder模塊進行了改進。本文的Encoder模塊使用改進的inception-resnet網絡結構,并使用全局平均池化來代替全連接層,與3D-R2N2的重建結果相比能夠得到更高的IoU值,重建精度更高。

(2) 針對單幅圖像信息量少的問題,采用多種網絡結構提取多特征并依次輸入3D-LSTM模塊中,從而增強單幅圖像的重建效果。

(3) 與3D-R2N2相比,本文提出的方法具有更低的計算開銷。

1 3D-R2N2網絡模型

3D-R2N2網絡采用監督學習的方式,僅在邊界框信息(Bounding boxes)的輔助下,就可以端到端地從單幅或者多幅圖像中重建出圖像中物體的三維模型。其網絡結構由三部分組成:卷積神經網絡構成的編碼器(Encoder)、三維卷積長短期記憶網絡(3D convolutional LSTM)和解碼器(Decoder)。

1.1 Encoder模塊

Encoder模塊將輸入的圖像轉化為較低緯度的特征向量。其網絡結構包含了12個卷積層,1個全連接層和5條殘余連接(Residual connection)。其中殘余連接是在每兩個卷積層間添加,為了匹配卷積操作后的通道數,殘余連接使用1×1卷積。Encoder模塊最終輸出一個維度為1 024的特征向量。

1.2 3D convolutional LSTM模塊

3D convolutional LSTM模塊通過Encoder模塊得到的特征向量去更新其中記憶單元的信息。該模塊由n×n×n個3D-LSTM單元組成,其中n為3D-LSTM網格的空間分辨率。3D-LSTM單元在空間上分布在3D網格結構中,每個單元負責重建特定部分的最終輸出,其都對應最終重建輸出矩陣的一個元素(i,j,k),單元中還伴隨著一個獨立的隱藏狀態ht。

1.3 Decoder模塊

Decoder模塊接收3D-LSTM傳來的隱藏狀態ht,并將它們轉化為體素塊存在與否的概率,最終通過得到每個體素塊概率的值為0或者1來確認是否重建該體素塊。與Encoder模塊相同,Decoder模塊也由卷積神經網絡和相應的殘余連接組成,但這里使用了3×3×3的卷積核進行三維卷積,同時在Decoder模塊會進行三維上池化(3D unpooling)來對三維信息進行處理。

2 改進神經網絡的單幅圖像物體重建方法

2.1 對Encoder模塊的優化

盡管3D-R2N2的Encoder模塊使用了帶有殘余連接的卷積網絡,但仍存在著特征提取效果差導致的重建精度問題。GooleNet[29]首次提出的Inception模塊可以一次性使用多個不同尺寸的卷積核,能夠讓網絡自己選擇需要的特征,如選擇大尺寸的卷積核可以抓取到像素與周邊像素之間的關系。同時,Inception模塊增大了網絡寬度,能夠對有噪聲的圖片提取到更多的深度特征,讓含噪聲的圖片具有更好的泛化能力。受到Szegedy等[30]提出的方法的啟發,本文在保存殘余連接的同時加入了Inception模塊,既能夠利用Resnet中的殘余連接解決梯度消失的問題,又能夠利用Inception模塊提取更深更細節的圖像特征。本文設計了兩種改進的Inception-resnet模塊,其中Inception-resnet-A結構如圖1所示。

圖1 Inception-resnet-A的結構

Inception-resnet-A模塊包括3個卷積分支,在第一個卷積分支中將3×3卷積替換為1×3和3×1兩種大小的卷積核,這種非對稱卷積核能夠替代3×3卷積核的同時節省計算量,并提取到更多圖像的局部特征。放在3×3卷積核前的1×1卷積用于控制輸入特征的通道數。第三個卷積分支使用池化來增加整體的非線性特征。同時模塊仍保留著殘余連接,整體模塊使用較小的卷積核,但能夠較好地提取局部特征。

Inception-resnet-B模塊采用了更大的卷積核尺寸,5×1和1×5兩個卷積核由5×5的卷積核拆分得到,中間分支僅采用了1×1特征用來對不同通道的特征進行統一。該結構能夠更好地抓取像素與像素之間的關系。其結構如圖2所示。

圖2 Inception-resnet-B的結構

(1)

改進后的Encoder模塊的網絡結構如圖3所示。與3D-R2N2相比,網絡在層數上沒有增加,網絡的前四層沒有變化,仍使用帶有殘余連接的卷積神經網絡。但是從第五層開始使用了改進的Inception-resnet模塊替換了單純帶有殘余連接的卷積網絡,每個Inception的分支后連接有1×1的線性卷積核,其主要用來統一跳躍連接后的通道維度。輸入的圖片經過Inception-resnet模塊后,再經過全局平均池化的處理,最終輸出一個維度為1 024的特征向量。

圖3 改進的Encoder模塊網絡結構

2.2 多特征重建網絡

使用不同的Encoder網絡結構會得到不同的重建結果,原因在于不同的網絡結構的特征提取能力不同,某一種網絡結構在特定的特征上表現出較好的能力,但可能在其他特征上表現較差。單幅圖像本身就包含較少的信息,如果只使用一種網絡結構用作特征提取,則會限制重建的性能。

本文在Encoder模塊中使用多種網絡結構進行特征提取,采用的網絡結構有AlexNet[31]、ResNet[32]、DenseNet[33]以及本文中改進的Inception-resnet,幾種網絡結構均為現有方法中具有開創性且效果較好的網絡結構。在本文提出的多特征重建網絡框架中,四種網絡結構對同一張圖像提取到四種不同的特征,所提取的四種特征分別依次輸入3D-LSTM中并進行整合,從而達到模擬多幅圖像的重建的過程,進而增強單幅圖像的重建效果。多特征重建網絡的整體結構如圖4所示。

圖4 多特征重建網絡結構框架

3 實驗與結果分析

本文使用Theano框架來實現相應的網絡模型。實驗在配置有 Intel Xeon E3 1230 V5 CPU(3.40 Ghz),Nvidia GeForce 1080 Ti GPU(11 GB)的硬件平臺上進行。

3.1 實驗數據集與評價標準

本文采用ShapeNet數據集[34]作為網絡訓練和測試所使用的數據集。該數據集包括了13個種類共43 783個CAD模型,本文采用數據集中的37 192個CAD模型作為訓練集,6 591個剩余的CAD模型作為測試集。

本文采用IoU值,也即網絡輸出結果與對應真實模型的交疊率作為評價三維重建精度的評判標準。

3.2 網絡模型及訓練

網絡輸入的圖像大小為127×127,輸出體素大小為32×32×32,在網絡模型中使用了Adam算法[35]來優化梯度下降過程,加速網絡的訓練速度,其中的超參數β1值為0.9,β2值為0.999,權重衰減值為5×10-6。LeakyReLU中斜率設置為0.1,初始的學習率設置為了10-5。為了實現實驗的公平對照,本文網絡的初始超參數值采用了和3D-R2N2一樣的設置。多特征重建網絡的四種網絡結構均采用與3D-R2N2相同的12層。

3.3 ShapeNet數據集實驗結果分析

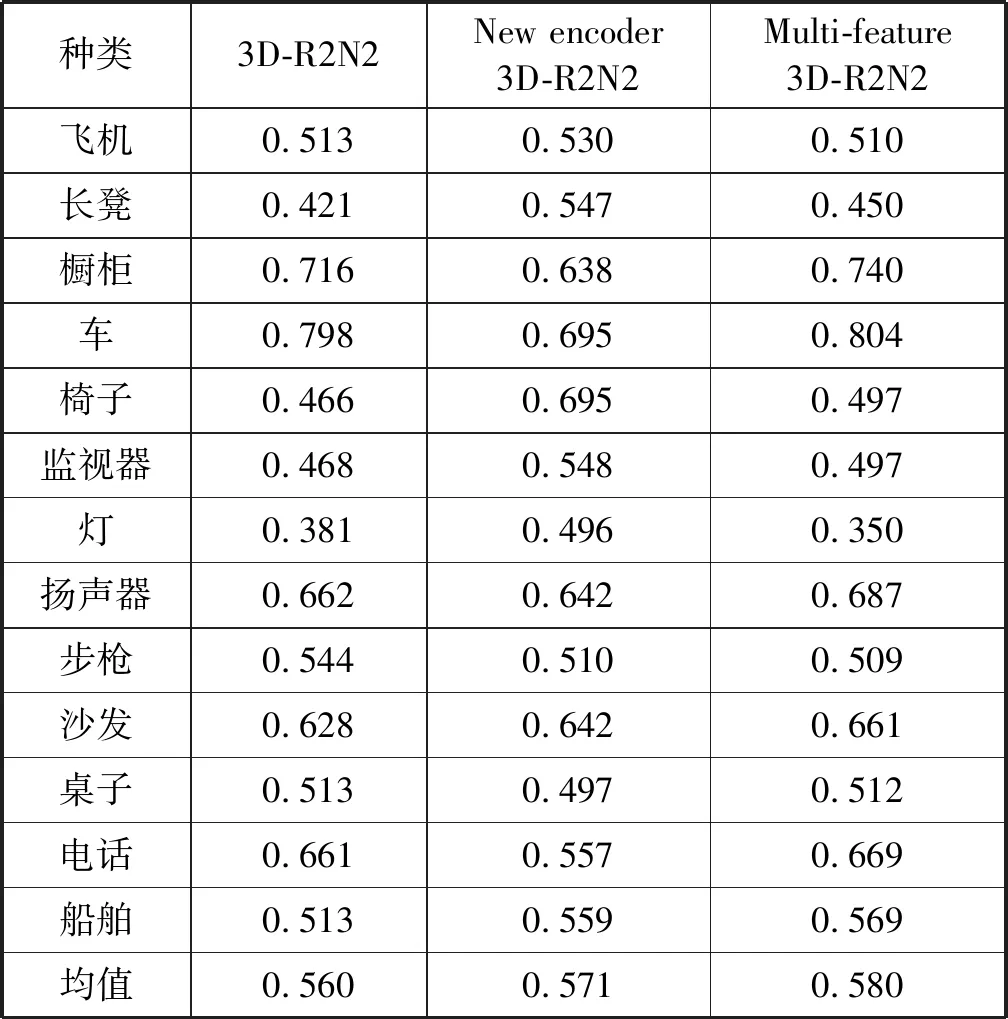

本文針對ShapeNet數據集中13個種類的物體分別進行了實驗,并且針對Encoder模塊的改動以及多特征重建網絡分別做了單一的對照實驗,僅使用改進后的Inception-resnet模塊的網絡稱為New encoder 3D-R2N2,使用多種網絡結構作為Encoder的多特征網絡結構稱為Multi-feature 3D-R2N2。表1顯示New encoder 3D-R2N2在13個主要類別中有7類的重建效果優于3D-R2N2,Multi-feature 3D-R2N2在13個主要類別中有10類優于3D-R2N2,且兩者整體平均重建表現均優于3D-R2N2,該結果證明了本文方法的有效性。實驗分析可知,引入改進后的Inception-resnet結構的Encoder模塊能夠更好地提取圖像的細部特征及深度特征,在面對燈、電話等重建細節較多的物體時有相對較大的效果提升。但在面對諸如桌子、櫥柜等結構相對簡單的物體,其表現反而不如3D-R2N2,這也印證了本文提到的使用不同的網絡結構提取特征,會對不同的特征產生不同的表現。而使用了多種網絡結構來提取多特征的多特征重建網絡,對重建效果的提升則是全面的,僅在飛機、燈和步槍三類上IoU值與3D-R2N2近乎持平,其余10類均優于3D-R2N2。本文將多特征重建網絡的重建模型與3D-R2N2進行了對比,其重建模型對比如圖5所示。通過模型對比可以看出,本文的重建結果擁有更多細節,重建效果更好。

表1 不同重建方法的IoU值對比

種類3D-R2N2New encoder 3D-R2N2Multi-feature 3D-R2N2飛機0.5130.5300.510長凳0.4210.5470.450櫥柜0.7160.6380.740車0.7980.6950.804椅子0.4660.6950.497監視器0.4680.5480.497燈0.3810.4960.350揚聲器0.6620.6420.687步槍0.5440.5100.509沙發0.6280.6420.661桌子0.5130.4970.512電話0.6610.5570.669船舶0.5130.5590.569均值0.5600.5710.580

圖5 多特征重建網絡與3D-R2N2的重建效果對比

3.4 改進的Encoder模塊對計算開銷的提升

為了驗證改進Inception-resnet后的Encoder模塊對計算開銷的提升,本文仍使用ShapeNet數據集對模型的訓練時間及訓練模型的參數數量進行對比,其結果如表2所示。

表2 不同重建方法訓練時間及參數數量比較

其中,由于全局平均池化取代了全連接層大量的參數,使得參數數量減掉了60%,同時參數的減少也加快了訓練的時長,Inception-resnet模塊中加入的非對稱卷積核也能省去該模塊近1/3的訓練時間,最終改進的網絡結構在訓練時間上也有了較大的改善。實驗結果也證明了本文所提方法對計算開銷的提升。

4 結 語

本文采用類似于3D-R2N2的網絡結構,通過使用改進的Encoder模塊及結合多特征的重建網絡結構,進一步提高了特征的表達能力和網絡的優化能力。通過實驗對重建的輸出模型的IoU值計算,得到的結果證明了本文方法在重建精度上和計算開銷上的提升。下一步的工作是添加一些人為設計的結構信息和幾何信息作為網絡的輔助信息,從而提高該類物體的重建精度。