基于時序空間關系模型的交通標志識別

翟孝威 宋云志

摘? 要: 道路交通標志識別是汽車無人駕駛技術的重要組成部分。通過調整卷積層和池化層數據輸入方式,改進具有融合特征的多尺度卷積神經網絡,提高識別準確率。依據視頻圖像的空間連續關系構建時序空間關系模型(Temporal-Spatial Model, TSM),結合多尺度卷積神經網絡減少識別數據量,提高處理的效率,實現視頻圖像交通標志的高效率和高準確率識別。實驗結果表明,所提出的算法識別率保持90.36%,在原始圖像上運行平均幀率為32fps,有效地改進了基于單幀的交通標志圖像識別效率低的問題。

關鍵詞: 交通標志識別; 汽車無人駕駛; 多尺度卷積神經網絡; 時序空間關系模型

中圖分類號:TP391? ? ? ? ? 文獻標志碼:A? ? 文章編號:1006-8228(2019)06-63-04

Abstract: Traffic sign recognition is an important part of driverless car technology. In this paper, by adjusting the data input methods of convolutional layer and pooling layer, the multi-scale convolutional neural network with fusion features is improved to make better recognition accuracy, and the Temporal-Spatial model is constructed according to the spatial relationship of video images. Combining with multi-scale convolutional neural network to reduce the amount of identification data, improve the efficiency of processing, the model achieves the recognition of traffic sign with high efficiency and high accuracy. The experimental results show that the proposed algorithm's recognition rate is 96.81%, and the average frame rate is 32fps on the original image, which effectively improves the low-efficiency of single-frame traffic sign recognition.

Key words: traffic sign recognition; driverless car technology; the multi-scale convolutional neural network; Temporal-Spatial model

0 引言

道路交通標志牌是應用圖像符號和文字符號顯示當前道路信息的交通安全設施,嚴格按照國家相關法律標準設計。交通標志背景和圖形文字的顏色反差較大為識別帶來便利,但由于受到多種因素的影響,如標志牌顏色變淺、光照太強或不足、損壞形變、車輛抖動和視角的變化等因素,都會對交通標志的識別帶來困難,因此,我們的目標就是設計一個穩健和高效的交通標志識別算法。

文獻[1-2]總結和分析了目前交通標志識別技術發展概況。近幾年道路交通標志的識別技術發展迅速,主要分為兩大類:基于圖像處理與機器學習相結合的方法[3]以及深度學習方法[4-5]。Claw Bahlmann[6]提出一種基于顏色、形狀和運動信息的交通標志檢測、追蹤和識別系統框架。首先,使用AdaBoost訓練算法獲得一組Haar小波特征,然后,使用貝葉斯生成模型分類。該系統具有接近實時檢測和較高準確分類的性能,但基于Haar小波特征檢測算法易受光照影響。文獻[7]通過基于顏色的分割生成感興趣區域,再使用特定幾何形狀匹配該區域,最后采用基于假設生成和驗證的三維重建驗證交通標志區域,該方法對遮擋和變形效果較好,但無法保證檢測的準確性和時效性。

近幾年深度學習技術在圖像識別方面取得快速發展,甚至優于人類的表現。Yok-Yen Nguwi和Abbas Z. Kouzani[8]提出一種基于神經網絡的交通標志自動識別系統。該系統分為交通標志的檢測和識別兩個模塊。檢測階段將圖像轉換到HIS顏色空間,根據顏色特征和幾何形狀特征分割圖像,再使用MLP神經網絡過濾分割圖像得到較為精確的感興趣區域。識別模塊使用的一對一架構分別訓練每一類別的交通標志,該識別結構擴展性強,識別率較高。文獻[5]在交通標志識別階段,訓練多任務卷積神經網絡進行特征提取和分類,網絡識別準確率高,但實時性較差。

與傳統卷積神經網絡[9]識別方式不同,本文充分利用已識別交通標志圖像,構建已識別目標集(Already Recognized Objects Set ,AROS),提出一種基于TSM模型的交通標志識別算法。算法包括三部分。①基于統計學原理的圖像映射壓縮算法用于提取待識別區域,提高檢測速度。②基于時空關系模型的交通標志識別算法用于提高識別速度,解決識別序列圖像問題上單幀耗時長的問題。③改進多尺度卷積神經網絡,使分類更加精準。

1 交通標志識別流程框架

本文通過圖像映射壓縮算法得到二值壓縮圖像,并利用幾何形態學方法快速提取待識別區域,提取13200樣本數據的卷積特征,訓練SoftMax分類器。并依據分類器識別結果構建已識別目標集,將多尺度卷積神經網絡模型和基于時序關系構建的TSM模型有效結合,完成交通標志識別工作。處理流程如圖1所示。

2 交通標志檢測

交通標志牌底色多以紅、藍和綠色用于警告、指示和指路信息。顏色和形狀是交通標志最顯著的特征,我們使用這兩種特征區分背景、快速定位交通標志,得到待識別交通標志區域。

2.1 圖像映射壓縮算法

為了減少計算時間、提高檢測交通標志的效率,首先將圖像中滿足閾值范圍的像素點重繪在對應二值圖像中,使用基于統計學原理的圖像映射壓縮算法將二值圖像按比例壓縮,減少目標篩選階段數據量。算法流程如下:

⑴ 將原始RGB圖像轉化為同尺寸的HSV圖像。

⑵ 遍歷圖像所有像素點。將H、S、V三分量滿足顏色閾值范圍的像素點在二值圖像B中設置為255,反之置為0。

⑶ 映射壓縮。如下圖所示,將二值圖像B劃分為M×N個子塊,每個子塊大小為m×m。設輸出二值圖像為S,其尺寸為M×N,將圖像B中每一個子塊映射壓縮成S中對應的一個像素點。

圖像映射壓縮過程如圖2所示,統計二值圖像B中每個子塊白色像素點占子塊總像素點的比率。當比率大于閾值時在輸出圖像對應像素點置為255,反之置0。

分割并壓縮圖像之后得到包含目標候選區域的壓縮二值圖像。如圖3所示,左側為原始圖像(768×320),右側上方和下方分別是根據紅色和藍色分割后的映射壓縮二值圖像(96×40)。

2.2 交通標志候選區域提取

通常交通標志區域具有特定的幾何形態,因此可以依據幾何形態特征去噪。將圖像中區域尺寸過小或者過大、形狀異常的區域過濾。按照公式⑴提取目標區域。

其中Si表示第i個連通區域的最小外接矩形的面積,Ri為該外接矩形的長寬比率。Smin和Smax為圖像中交通標志最小外接矩形的面積最小值和最大值,Rmin和Rmax為交通標志最小外接矩形的長寬比率的最小值和最大值。當這兩個變量同時滿足條件時,即為提取的交通標志候選區域,否則過濾掉。

3 基于時序空間關系模型的交通標志識別

通過統計交通標志視頻序列圖像,可以發現相鄰幀中的交通標志具有位置、形態與尺寸變化較小,相似度高,關聯性強[10]的特點。基于單幀的目標識別,可以保持每幀中目標區域高識別率,但如果連續識別序列圖像中的目標,識別效率較低。本文將時空關系模型和分類網絡有效結合,在保持高識別率前提下,減少識別時間。

3.1 模型描述

模型要依據視頻圖像時序空間變化的連續性和關聯性特點,比較相鄰幀中待識別區域的信息,優化識別方法。基于相鄰幀交通標志時序空間變化原理,構建TSM識別模型。依據F0…Fn-1幀中交通標志的識別結果,構建AROS,包括交通標志類型、位置、是否被處理的標記信息、已識別次數,以及近幾幀該目標未出現的次數等參數。

TSM識別模型按照圖4結構設計,目標識別可以使用TSM預測或分類器預測。分析模型的結構可知,AROS的創建以及更新是構建該模型的關鍵。當第Fn幀中的目標滿足下列關系,將當前幀中的目標加入AROS中:

⑴ AROS為空時。

⑵ AROS非空。讀取第Fn幀中第i個目標的信息和AROS中第j個目標信息按照公式⑵匹配操作。參數滿足di,j<10,同時目標長寬比率范圍在0.8-1.2時,可以判斷為同一類型的目標,并用當前目標信息更新AROS。

基于單幀識別的卷積分類網絡,依次識別相似連續幀中目標,耗時較長。上述構建的基于時序空間關系的識別模型,能夠在保持高識別率的基礎上,有效加快序列幀相似目標的識別速率。

3.2 改進的多尺度卷積神經網絡

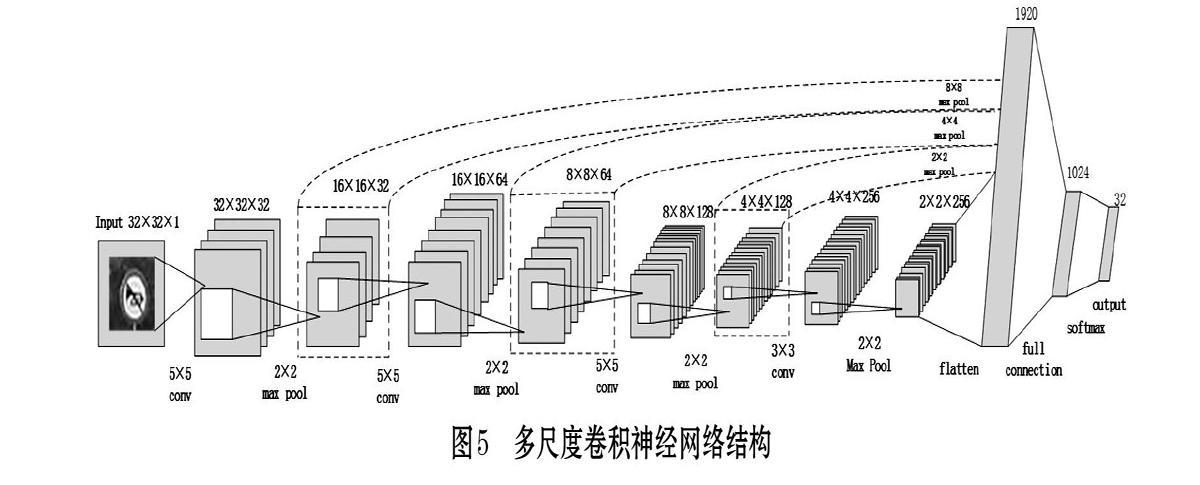

模型的識別準確率歸根結底依賴于神經網絡分類器,因此采用一個高精度的分類器尤為重要。“分類器學習到更多的卷積特征,那么它的分類精度就越高”,受Yann LeCun[11]文獻啟發,網絡結構采用多尺度卷積神經網絡,每個卷積層不僅傳遞給下一層,而且傳遞給分支層,經過相應比例的下采樣后都可以作為輸入直接傳給分類器。這樣的網絡結構設計,使得分類器充分學習每層網絡的特征圖像,提高目標分類識別效果。

本文構建的卷積神經網絡采用四層卷積層和池化層用于特征提取,一層全連接層用于分類。與傳統的神經網絡不同,多尺度卷積神經網絡可以同時保留L1和L2卷積層提取的局部特征和L3、L4層的高級特征,能夠兼顧學習到樣本特征的全局性和局部性。多尺度卷積神經網絡結構如圖5所示。

隨著訓練過程的進行,模型復雜度增加,會出現過擬合現象,本文采用Dropout、L2正則化、Early stopping三種方式解決過擬合。將Dropout作用在全部網絡層,以一定概率將選中的神經元舍棄,使其不起作用。L2正則化在損失函數上加上一個正則化項,起到對模型向量 “懲罰”的作用,避免單純最小二乘問題的過擬合問題。Early stopping在每一個迭代結束時,計算驗證集的準確率,當準確率隨著訓練不再提高時,就停止訓練,防止過擬合,提高訓練速度和調參效率。

3.3 模型應用

將本文的模型應用在視頻圖像中,運行大量視頻,統計結果。圖6(a)為使用卷積神經網絡識別連續幀圖像選取9幀作為樣例,識別率較高,耗時長;圖6(b)是使用TSM模型識別該連續幀圖像,在該序列圖像中,識別率不變,時間明顯縮短。

(a) 卷積神經網絡識別序列圖像

(b) TSM識別序列圖像

從序列圖像的識別結果來看,基于單幀識別的卷積神經網絡識別率高,但TSM識別算法結合多幀信息,不僅識別率高,還加快識別速度。

4 實驗結果與分析

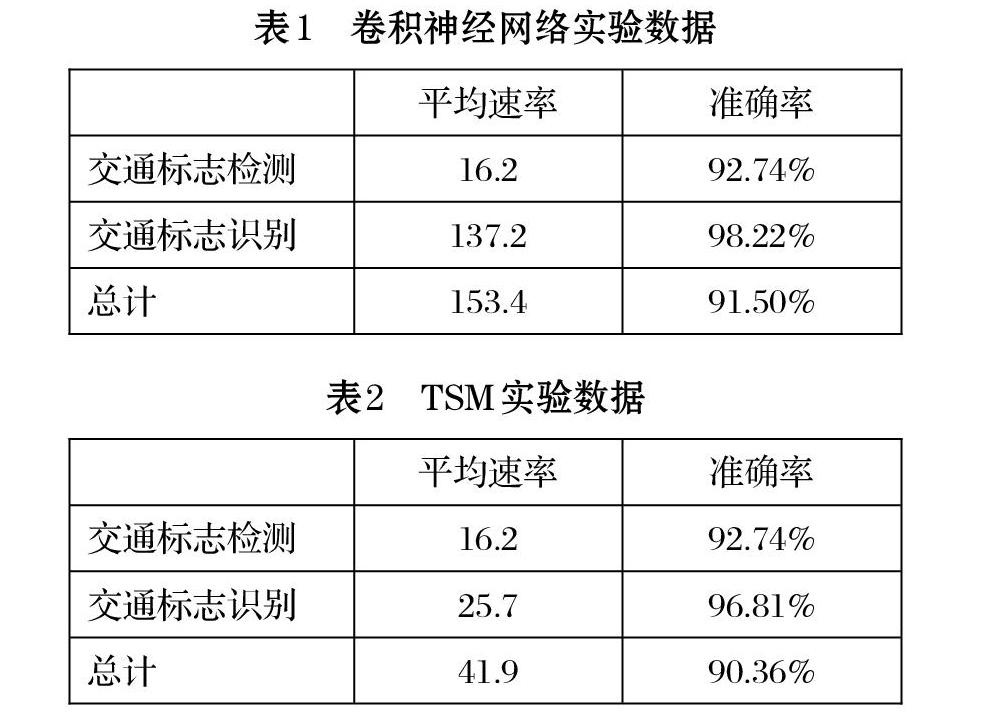

為驗證本文識別算法的準確率和效率,采用行車記錄儀錄制的青島市多條城市道路、多種天氣情況和多個時間段的的視頻文件作為測試數據,視頻幀率29fps,分辨率1920×1080。測試環Intel@Xeon(R) CPU E5-2683 v3 @2.00GHz×28。使用卷積神經網絡和TSM識別算法分別測試同一視頻文件,結果數據如表1、表2所示。

通過對比表1和表2的數據可以得出結論,使用本文提出的TSM識別算法,識別率降低約2%,識別速率可以提高近400%。本文算法在保證高識別率的前提下,有效解決序列圖像基于單幀識別效率低的問題。

5 結束語

本文根據交通標志在序列圖像中的時序空間關系,提出了基于TSM的交通標志識別算法,該算法通過將TSM模型和改進的多尺度卷積神經網絡有效結合,解決了單幀圖像識別效率低的問題,保證高識別率的基礎上,大大提高了序列圖像交通標志識別速率。下一步工作,繼續完善檢測算法,以及優化識別階段的網絡模型,實現更快速的圖像識別。

參考文獻(References):

[1] 劉佳敏,何寧,杜金航.智能輔助駕駛系統中的禁令交通標志識別方法研究[D].西南交通大學,2013.

[2] 溫斯傲,李志民,郝博聞.交通標志檢測研究綜述[J].智能計算機與應用,2016.6(3): 58-61

[3] 姚漢利,趙金金,鮑文霞.基于特征融合和字典學習的交通標志識別[J].計算機技術與發展,2018.28(1):51-55

[4] S. Jung U L, J. Jung and D. H. Shim. Real-time TrafficSign Recognition system with deep convolutional neural network[C].2016 13th International Conference on Ubiquitous Robots and Ambient Intelligence (URAI), Xi'an,2016:31-34

[5] H. Luo Y Y, B. Tong, F. Wu and B. Fan. Traffic SignRecognition Using a Multi-Task Convolutional Neural Network[J].International IEEE Conference on Intelligent Transportation Systems,2018.19:1100-1111

[6] Bahlmann C, Zhu Y, Ramesh V, et al. A system for trafficsign detection, tracking, and recognition using color, shape, and motion information[J].2005 IEEE Intelligent Vehicles Symposium Proceedings,2005:255-260

[7] Soheilian B, Paparoditis N, Vallet B. Detection and 3Dreconstruction of traffic signs from multiple view color images[J].Isprs Journal of Photogrammetry and Remote Sensing,2013.77:1-20

[8] Nguwi Y Y, Kouzani A Z. Automatic road sign recognitionusing neural networks[J]. 2006 Ieee International Joint Conference on Neural Network Proceedings,2006.1-10.

[9] Lecun Y, Bengio Y. Convolutional networks for images,?speech, and time series[M].1998.

[10] 王元奎,秦勃,李偉.基于時空關系模型的城市道路車輛實時檢測[J].計算機系統應用,2017.10:207-212

[11] Sermanet P, Lecun Y. Traffic Sign Recognition withMulti-Scale Convolutional Networks[J].2011 International Joint Conference on Neural Networks (Ijcnn),2011:2809-2813