基于深度卷積長短時神經網絡的視頻幀預測

張德正 翁理國 夏旻 曹輝

摘 要:針對視頻幀預測中難以準確預測空間結構信息細節的問題,通過對卷積長短時記憶(LSTM)神經網絡的改進,提出了一種深度卷積長短時神經網絡的方法。首先,將輸入序列圖像輸入到兩個不同通道的深度卷積LSTM網絡組成的編碼網絡中,由編碼網絡學習輸入序列圖像的位置信息變化特征和空間結構信息變化特征;然后,將學習到的變化特征輸入到與編碼網絡通道數對應的解碼網絡中,由解碼網絡輸出預測的下一張圖;最后,將這張圖輸入回解碼網絡中,預測接下來的一張圖,循環預先設定的次后輸出全部的預測圖。與卷積LSTM神經網絡相比,在Moving-MNIST數據集上的實驗中,相同訓練步數下所提方法不僅保留了位置信息預測準確的特點,而且空間結構信息細節表征能力更強。同時,將卷積門控循環單元(GRU)神經網絡的卷積層加深后,該方法在空間結構信息細節表征上也取得了提升,檢驗了該方法思想的通用性。

關鍵詞:視頻幀預測;卷積神經網絡;長短時記憶神經網絡;編碼預測;卷積門控循環單元

中圖分類號: TP183? 文獻標志碼: A

文獻標志碼:A

Abstract: Concerning the difficulty in accurately predicting the spatial structure information details in video frame prediction, a method of deep convolutional Long Short Term Memory (LSTM) neural network was proposed by the improvement of the convolutional LSTM neural network. Firstly, the input sequence images were input into the coding network composed of two deep convolutional LSTM of different channels, and the position information change features and the spatial structure information change features of the input sequence images were learned by the coding network. Then, the learned change features were input into the decoding network corresponding to the coding network channel, and the next predicted picture was output by the decoding network. Finally, the picture was input back to the decoding network, and the next picture was predicted, and all the predicted pictures were output after the pre-set loop times. In the experiments on Moving-MNIST dataset, compared with the convolutional LSTM neural network, the proposed method preserved the accuracy of position information prediction, and had stronger spatial structure information detail representation ability with the same training steps. With the convolutional layer of the convolutional Gated Recurrent Unit (GRU) deepened, the method improved the details of the spatial structure information, verifying the versatility of the idea of the proposed method.

Key words: video frame prediction; Convolutional Neural Network (CNN); Long and Short-Term Memory (LSTM) neural network; encoding prediction; convolutional Gated Recurrent Unit (GRU)

0 引言

在近些年深度學習快速發展的背景下,多種以前難以很好解決的計算機視覺問題有了解決方案。視頻幀預測作為計算機視覺的難點問題,長期以來得不到很好的解決,也難以引起人們的重視,但是隨著無人駕駛技術的爆發式發展,對其的需求越來越迫切。原因是:研究人員看重視頻幀預測在無人駕駛過程中預測路面行人和車輛移動軌跡的能力。傳統的方法停留在車載雷達實時檢測車輛前方是否有障礙物,但不能預測t時刻后將與另一個移動物體路徑交匯發生碰撞,也就無法作出需要提前減速或者加速的判斷。這一能力對于危險情況有提前預防的作用,能夠顯著增強無人駕駛的安全性能。此外,視頻幀預測在夏季短時強降水的預測任務中也可以應用。通過前一段時間雷達回波圖預測下一段時間雷達回波圖的可能情況,從而判斷接下來那些地方可能有強降水發生。視頻幀預測也為夏季多發的臺風軌跡預測提供了一種方法。由于我國沿海大部分是季風氣候,所以夏季東南沿海地區經常受到臺風的侵擾,良好地預測臺風軌跡,對防災減災有重要意義。

目前,已經被很好解決的識別、分類和目標檢測等問題的數據集都是靜態的圖片,即便是同一類別的兩張圖也不存在時空序列相關性。而視頻幀預測問題的前后兩幀甚至是間隔數幀依舊存在著很強的時空序列相關性。對于這類時空序列問題,近年來火熱的基于卷積神經網絡(Convolutional Neural Network, CNN)的AlexNet[1]、VGG(Visual Geometry Group)[2]、GoogLeNet[3]等算法都無法解決。主要原因是以上三種算法代表的卷積神經網絡的優點是對結構表征能力很強,缺點是局限于靜態圖,無法建模動態圖的時空序列問題。如何建模時空序列問題,是一個比較基礎也比較重要的任務。起初研究人員注意力主要集中在人類動作預測方向,使用的方法大多基于統計學習和傳統的機器學習。Ryoo[4]把動作預測問題概率化,使用時空特征積分直方圖來建模特征分布與時間的變化關系。Zhu等[5]應用條件隨機場提出了感知語法事件解析、推斷事件目標和預測可信動作的算法。Vondrick等[6]利用一種深度回歸網絡的方法來學習視頻表征,結合動作識別模型,能夠很好地根據靜態圖像來推測未來動作。除此之外,研究人員還進行了物體軌跡預測方向的研究。Kooij等[7]基于貝葉斯算法提出了動態貝葉斯網絡,應用于行人路徑預測。Walker等[8]的光流預測模型對靜態圖中的所有像素點進行光流標記,可以預測每一個像素的運動。Mottaghi等[9]使用兩個CNN和一個循環神經網絡(Recurrent Neural Network, RNN)來建模物體移動動態,其結果表明可以從單個圖像中預測出物體的長期運動作為外力的反映。以上的運動預測模型多是從建模移動物體的運動軌跡出發,能較好地預測物體的瞬時運動軌跡,但具有兩個缺點:一是不能預測多幀后物體準確位置;二是不能表征多幀后物體的結構信息。

針對這兩個難解決的問題,本文在卷積長短時神經網絡(Long and Short-Term Memory neural network, LSTM) [10]基礎上提出了深度卷積長短時神經網絡模型,基于Moving-MNIST數據集的實驗表明,在多幀后的物體位置預測和物體結構信息保留兩方面取得了更優的效果。

1 卷積LSTM

1.1 循環神經網絡

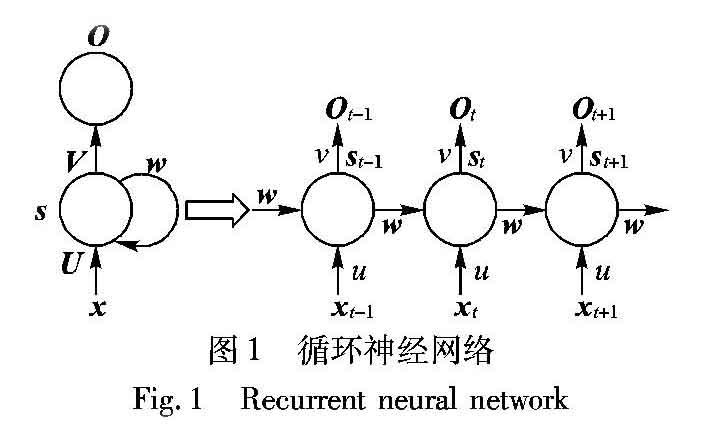

循環神經網絡[11]的提出主要是為了解決自然語言處理領域的詞語長期依賴問題。該問題將一條語句甚至是段落轉化成詞向量,而語句中不同位置上的詞語存在高度相關性,體現在詞向量上就是不同元素間存在相關性,這就是序列問題。循環神經網絡結構如圖1所示。在左邊部分中,x是神經網絡的輸入;U是輸入層到隱藏層之間的權重矩陣;w是記憶單元到隱藏層之間的權重矩陣;V是隱藏層到輸出層之間的權重矩陣;s是隱藏層的輸出,同時也是要保存到記憶單元中,并與下一時刻的x一起作為輸入;O是神經網絡的輸出。圖的右邊是展開結構。循環神經網絡接受多個獨立的輸入,并且最終輸出多個結果。將循環神經網絡的結構與一般的全連接神經網絡比較,會發現循環神經網絡只是多了一個記憶單元s,而這個記憶單元就是循環神經網絡的關鍵所在。t時刻的神經元接受t時刻的輸入xt,并且在給出輸出之前參考上一時刻的記憶單元st-1,同樣的t時刻的神經元也會留下該時刻的記憶單元st,用于下一個時刻的輸出參考。實際的效果就是將不同時刻狀態聯系到一起,建模了時間的相關性。

在后來的神經網絡發展中,為了解決一些實際的問題,例如:文本情感分析[12]、語音識別等[13],研究人員提出了基于原始循環神經網絡的變體,例如為了解決多輸入單分類的問題提出多輸入單輸出的循環神經網絡。原始的循環神經網絡還要求輸入與輸出長度對應,但在機器翻譯中源語言與目標語言的句子往往并沒有相同的長度,這時可采用輸入與輸出不等長(N vs M) 模型,這種結構又稱為“編碼解碼”(Encoder-Decoder) 模型,也稱序列到序列(Seq2Seq)模型[14],是從自編碼器發展而來的。在諸多變種中,長短時神經網絡(LSTM)模型由于能更好地處理長期依賴和訓練時的梯度爆炸問題[15],所以經常被使用。

1.2 卷積LSTM

卷積LSTM的提出是為了解決臨近降水預測問題,該問題的數據是雷達回波序列圖,有很強的時空相關特性。Shi等[16]在結合了LSTM的序列處理能力和CNN的空間特征表達能力后,提出了能夠解決時空序列預測問題的卷積LSTM模型。與各種循環神經網絡不同的是:通過對輸入序列圖像使用卷積操作獲取圖像特征,在循環神經網絡應用于翻譯等任務時獲取的都是一維的詞向量輸入;而這里獲取的是二維的圖像輸入,也可以根據任務不同輸入三通道的彩色圖像,這時就變成了三維輸入。在視頻幀預測任務中,將單通道的64×64的數字序列圖像作為輸入。如圖2所示,卷積LSTM模型與LSTM模型具有同樣的三個門控制單元和一個隱藏層,分別是:輸入門it、遺忘門ft、輸出門ot和隱藏層ht。最大的不同是在當前時刻的輸入與隱層結合后進行了單層卷積計算,這個不同點是提取空間結構信息的關鍵。

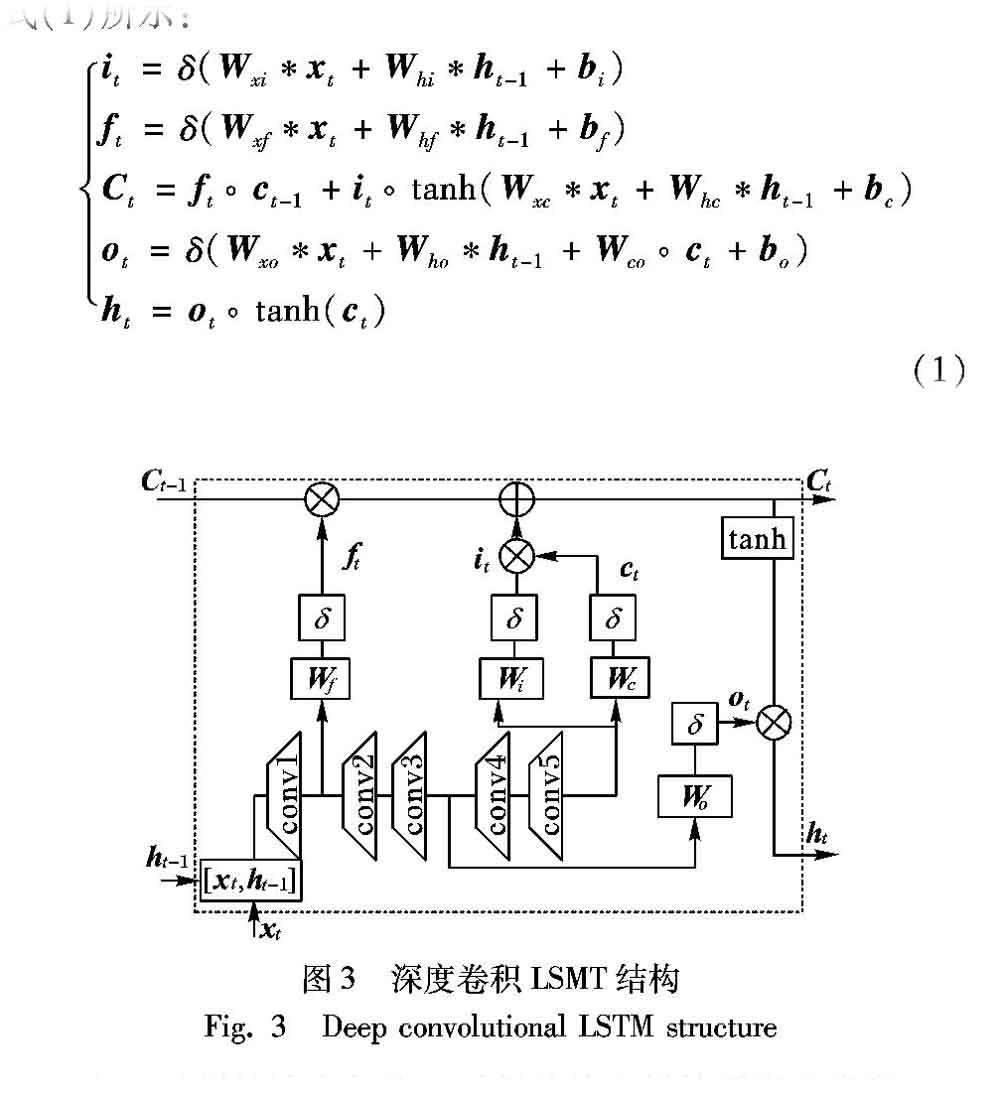

2 深度卷積LSTM

在深層卷積可以提取更抽象特征的思想啟發下,本文提出了深度卷積LSTM模型,卷積層的具體分布上不是簡單地加深而是參考了GoogLeNet中讓網絡變寬的方法[17-18],目的是解決普通卷積LSTM在預測多幀時結構信息模糊的問題。具體操作是將輸入與隱層結合后的單層卷積加深,并且將不同層的卷積結果傳遞給不同的門控單元,卷積層之間用relu函數激活,結構如圖3所示。

4 仿真實驗及分析

4.1 對比實驗

為了進一步對深度卷積LSTM模型有直觀了解,在Moving-MNIST數據集上比較改進的深度卷積LSTM網絡與普通卷積LSTM網絡。在測試了添加不同卷積層后,得到如下結論:

1)深度卷積LSTM在處理時空相關方面優于卷積LSTM。

2)深度卷積LSTM對圖片結構信息表征能力更強,細節信息可以傳遞到更深層預測。

對比用的兩個網絡都借用tensorflow框架,使用python語言編寫,運行在單塊NVIDIA TITAN X顯卡上。具體操作:將前10幀圖像作為輸入,通過使用反向傳播和最小化均方差損失來訓練模型,學習率設置為10E-3。首先,使用普通卷積LSMT算法在訓練后預測數字9和8的運動情況,結果如圖8(a)所示:第一行是輸入的前10幀圖像,第二行是真實的后10幀圖像,第三行是預測出的后10幀圖像;再與原算法對比使用改進的深度卷積LSTM網絡預測構造比較復雜的9和8兩個數字的運動圖,結果如圖8(b)所示:第一行是輸入的前10幀圖像,第二行是真實的后10幀圖像,第三行是預測出的后10幀圖像。

通過觀察預測的結果圖8可以發現,單層卷積LSTM網絡在預測時的表現很差,只有前邊兩幀圖像還能分辨出是數字9和8,到最后一幀圖片結構信息完全丟失只剩模糊的像素點;反觀深度卷積LSMT網絡的預測結果,前邊的七幀都能較好地保持圖像的結構信息,能分辨出是數字9和8,最后一幀的結構信息也很模糊但還是有一些輪廓信息。也可以發現,雖然原算法預測出的圖像結構信息較差,但在位置信息預測上比較準確,這個優點在改進的深度卷積LSTM上依然得到了保留,對于位置的預測還是一樣地準確。

4.2 算法通用性實驗

進一步討論加深卷積層的算法思想是否可以拓展到其他相關的序列預測算法上,實現性能的提升。為此,選擇同樣是由循環神經網絡演變來的卷積門控循環單元(Gated Recurrent Unit, GRU)算法進行驗證。GRU是新一代的循環神經網絡,結構上去掉了細胞狀態,使用隱藏狀態來進行信息的傳遞,整體和LSTM非常相似。改進思路與深度卷積LSTM一樣,將卷積GRU的一層卷積加深為五層,卷積層之間用如圖10所示的relu激活函數,有三點好處:1)防止梯度爆炸。2)計算速度快,只需要判斷是否大于0。3)收斂速度大于sigmoid和tanh。

4.3 任務通用性實驗

為了測試算法在不同類型圖像上的表現,選取了阿里巴巴天池大數據比賽上的部分珠三角地區降水雷達回波數據集。結合深度卷積LSMT網絡的要求,對數據集中的61張降水回波圖按順序間隔兩張挑出一張,做出了輸入10張、輸出10張的序列圖。經過訓練后測試結果如圖13所示。從預測結果圖13來看,深度卷積LSMT對深黑色的降水區域預測更準確,重合更大,尤其從前邊的三張預測圖對比看出:原來的卷積LSMT網絡預測圖的左下角黑色降水區域偏差較大。原因還是因為卷積LSMT的單層卷積在訓練時對圖像的深層特征學習不夠,相反深度卷積LSMT的五層卷積更能挖掘到圖像變化的深層特征。

同樣地在測試集上對比深度卷積LSMT網絡和卷積LSMT網絡的結構相似度。深度卷積LSTM網絡在100個序列的測試集上取得了0.68的平均結構相似度,卷積LSMT網絡的結構相似度為0.62,結構相似度提升了約9.7%。對比兩個數據集結果發現,不論是否改進,算法整體的結構相似度都比Moving-MNIST數據集表現好;區別在于雷達回波數據集中的圖像中雨云的結構不是固定的,而Moving-MNIST數據集中的移動數字結構是固定的,所以固定的結構預測難度更大。此外,在Moving-MNIST數據集上深度卷積LSMT網絡在結構相似度上提升了14.58%,而雷達回波圖上才提升了9.7%。這和雨云的運動高度相關,數字圖僅僅是有方向性的運動,而雨云不僅運動還可能降水消失,具有突變性,所以提升難度更大。綜合表現來看,深度卷積LSMT對圖像的空間結構信息預測更準確,但在圖片信息出現突變的情況中提升效果會下降。

5 結語

通過對卷積LSTM網絡的加深和不同卷積層與不同門控單元的結合,深度卷積LSTM模型成功增強了模型在時空序列預測問題中的空間結構信息表征能力,在圖像細節的表達能力上明顯優于原模型;在位置預測上,依然繼承了卷積LSTM算法的精準度;并且加深的算法思想在同樣可以作序列預測的卷積GRU模型上驗證了,加深卷積層來提升空間結構信息表征能力的想法是有效的、可行的。但是從序列預測的結果圖來看,經過深度卷積加深的網絡依然很難將清晰的結構信息保留到7幀之后。分析原因,首先最小化均方差作為損失函數,會使得在反向傳播后修正像素點值時過分追求均值最小,將誤差均值化從而導致了模糊;其次,序列預測的過程中是利用前一張的預測結果預測下一張,誤差會累計。這兩方面還有很大的優化空間,未來將作進一步的研究。

參考文獻 (References)

[1] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks [C]// Proceedings of the 25th International Conference on Neural Information Processing Systems. North Miami Beach, FL: Curran Associates Inc., 2012: 1097-1105.

[2] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [EB/OL]. [2018-10-15]. https://arxiv.org/pdf/1409.1556.pdf.

[3] SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015: 1-9.

[4] RYOO M S. Human activity prediction: early recognition of ongoing activities from streaming videos [C]// Proceedings of the 2011 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2011: 1036-1043.

[5] ZHU S, JIA Y, PEI M. Parsing video events with goal inference and intent prediction [C]// Proceedings of the 2011 International Conference on Computer Vision. Piscataway, NJ: IEEE, 2011: 487-494.

[6] VONDRICK C, PIRSIAVASH H, TORRALBA A. Anticipating visual representations from unlabeled video [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 98-106.

[7] KOOIJ J F P, SCHNEIDER N, FLOHR F,et al. Context-based pedestrian path prediction [C]// Proceedings of the 2014 European Conference on Computer Vision, LNCS 8694. Berlin: Springer, 2014: 618-633.

[8] WALKER J, GUPTA A, HEBERT M. Dense optical flow prediction from a static image [C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 2443-2451.

[9] MOTTAGHI R, RASTEGARI M, GUPTA A, et al. “What happens if…” learning to predict the effect of forces in images [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9908. Berlin: Springer, 2016: 269-285.

[10] HOCHREITER S, SCHMIDHUBER J. Long short-term memory [J]. Neural Computation, 1997, 9(8): 1735-1780.

[11] ELMAN J L. Distributed representations, simple recurrent net-works, and grammatical structure [J]. Machine Learning, 1991, 7(2/3): 195-225.

[12] 李洋,董紅斌.基于CNN和BiLSTM網絡特征融合的文本情感分析[J].計算機應用,2018,38(11):3075-3080.(LI Y, DONG H B. Text sentiment analysis based on feature fusion of convolution neural network and bidirectional long short-term memory network [J]. Journal of Computer Applications, 2018, 38(11): 3075-3080.)

[13] 姚煜,RYAD C.基于雙向長短時記憶聯結時序分類和加權有限狀態轉換器的端到端中文語音識別系統[J].計算機應用,2018,38(9):2495-2499.(YAO W, RYAD C. End-to-end Chinese speech recognition system based on bidirectional long-term memory-timed timing classification and weighted finite state converter [J]. Journal of Computer Applications, 2018, 38(9): 2495-2499.)

[14] SUTSKEVER I, VINYALS O, LE Q V. Sequence to sequence learning with neural networks [C]// Proceedings of the 2014 Neural Information Processing Systems Conference. Cambridge, MA: MIT Press, 2014: 3104-3112.

[15] BENGIO Y, SIMARD P, FRASCONI P. Learning long-term dependencies with gradient descent is difficult [J]. IEEE Transactions on Neural Networks, 1994, 5(2): 157-166.

[16] SHI X J, CHEN Z R, WANG H, et al. Convolutional LSTM network: a machine learning approach for precipitation nowcasting [C]// Proceedings of the 28th International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2015: 802-810.

[17] MOLLAHOSSEINI A, CHAN D, MAHOOR M H. Going deeper in facial expression recognition using deep neural networks [C]// Proceedings of the 2016 IEEE Winter Conference on Applications of Computer Vision. Piscataway, NJ: IEEE, 2016: 1-10.

[18] IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift [C]// Proceedings of the 32nd International Conference on International Conference on Machine Learning. Cambridge, MA: MIT Press, 2015: 448-486.

[19] LESHNO M, LIN V Y, PINKUS A, et al. Original contribution: multilayer feedforward networks with a nonpolynomial activation function can approximate any function [J]. Neural Networks, 1991, 6(6): 861-867.