基于卷積神經網絡的室內場景三維重建技術研究

姚曉峰 武利秀 章 偉 王 松

(無錫太湖學院江蘇省物聯網應用技術重點建設實驗室 江蘇 無錫 214000)

0 引 言

傳統的三維重建方法大部分是借助現有的計算機輔助設計軟件(CAD,Maya等),通過專業三維制圖工程師使用大量的時間和手工方法對真實世界的場景進行三維幾何重建。該方法建造的場景具有較好的交互性,但模型真實感不太強,而且大多數輔助設計軟件具有很高的學習成本,工作量大,要想完成一個建模工作需要大量的人機交互工作,使得工作效率極大降低。這對于一些不需要高精度建模的使用者望而卻步。為此,如何尋找更快速的三維建模手段成為研究人員的新的研究方向。一種新的角度就是從圖像出發,通過對圖像信息的分析與處理,提取三維信息,用來實現三維場景的重建技術。為此,本文提出了一種采用RGBD圖像進行三維場景重建的方法。用戶首先通過Kinect攝像機獲取到一張室內場景的RGBD圖像,然后利用圖像分割技術將圖像分割成單一的場景元素塊。由于遮擋等問題使得分割結果有可能達不到滿意的效果,用戶可以手動對分割圖像進行相應的調整。分割之后,用每個元素塊的深度圖去和三維模型庫中的室內元素模型進行匹配,從而使其還原到三維場景中。針對大型的場景圖像,每個單張的圖像只需要覆蓋一部分的場景,從而用戶可以通過一組圖像重建整個場景。

本文創新點如下:

1) 通過三維模型渲染的方法獲取部分數據以擴展訓練數據集,并結合部分真實數據集,得到充足的訓練數據以用于模型匹配的三維重建方法的模型訓練上。

2) 通過改進現有的卷積神經網絡模型,將圖像分類的思想引入本文問題上,把室內場景元素的三維重建問題轉化成一個分類問題去解決。

1 相關工作

理想情況下的三維場景建模方式是基于單圖像的建模方法,采用立體視覺的方式對三維場景進行重建[1-2]的研究較多。該方法需要拍攝多幅同一物體的圖像作為參考,或者從不同視點對物體進行數據采集,并從中提取相關特征以用來達到物體三維重建的目的。單幅圖像的明暗[3]、焦距[4]、紋理[5]等線索是基于單幅圖像三維場景建模技術的十分重要的特征來源。但是,這些線索通常對圖像質量要求很高,使得在不同光照條件和物體遮擋下的效果變得很差,極大地限制了基于單幅圖像進行三維場景建模的發展,使得這項技術只能在某些特定的場合下完成三維場景重建問題。這就促使科研人員找到其他途徑去解決該問題。引入人機交互方法應用于三維場景重建問題[6-7],恰當的人機交互使得三維重建技術的相關難題得到有效的解決。文獻[8]提出了數據驅動的三維建模方法,通過圖像處理、三維檢索等技術把已有的或者自己創作的三維模型結合起來,可以迅速地實現他們的設計創意。針對三維場景的建模問題,文獻[9]把上述數據驅動的三維重建方法通過進一步的組裝,并對之進行建模,極大地推進了三維場景建模問題的進展,使得三維場景建模變得更加方便。這種方法把三維場景模型庫中的模型作為單個部件,通過部件之間的有機聯系組裝起來,從而得到新的三維場景模型。文獻[10]提出一種基于圖像的三維建模方法,通過對單張圖像的分析,匹配到三維物體模型庫中的模型,然后進行旋轉平移等變換,用來作為三維建模的組件。這類方法對三維模型庫要進行大量的手工預處理工作。基于草圖的三維模型的幾何重建是另一種三維場景建模方法。文獻[11-12]提出了一種基于草圖的模型檢索方法,通過輸入草圖,在三維模型庫中匹配與之對應的三維模型的技術。文獻[13]在此基礎上提出了一種基于草圖的三維建模方法。隨著觸屏技術的發展,這項技術有了更加廣闊的前景。通過觸屏的概念,能夠動態的指引用戶迅速完成三維建模任務。文獻[14]把三維建模技術轉換成搭積木工作,在系統后臺準備大規模的三維模型組件,讓用戶手動的組裝創意,并和用戶手繪的元素進行有機的結合,讓三維建模技術變得有趣起來。文獻[15]提出部件組裝的三維重建方法,利用這些殘缺的點云信息和三維檢索技術所得到的高質量的三維模型進行有機結合,對殘缺部分進行修復和拼接從而達到三維重建的目的。通過修復三維掃描儀獲取殘缺的場景點云模型以達到三維場景重建的目的是該方法的核心。文獻[16]提出了一種基于深度相機的三維場景重建方法。文獻[17]提出了一種交互式語義建模的方法,通過提取場景的深度信息進行分析與處理,從而達到三維場景重建的目的。文獻[18]也針對這類方法進行了研究。這類方法主要是通過掃描真實場景獲取RGBD信息,然后利用這些信息和三維模型數據庫之間的聯系,通過語義信息解決三維場景重建問題。研究人員對三維場景的點云信息進行分割,獲取單個物體的三維模型,從而恢復到原來的三維場景中去,完成三維場景的建模工作。這類方法雖然能夠取得很好的效果,并且有很高的效率,但是場景的點云信息的獲取成為了制約技術發展的絆腳石,也許在不久的將來,手持的深度相機的發展能夠彌補這個問題,但現階段這類方法還不能很好的推廣。

2 基于卷積神經網絡的模型匹配方法

在對RGB圖片進行語義分割的基礎上,本文提出一種基于卷積神經網絡的模型匹配方法,在三維模型庫中匹配到和已知圖像塊最類似的三維模型,然后把它放到適當的位置,就可以重建三維場景。模型訓練集是圖像分割后的圖像塊,標簽是它們對應的精確分類,例如椅子包含各種不同靠背、支撐形式以及形狀的椅子。卷積神經網絡對圖像分類問題中具有很好的精確度。

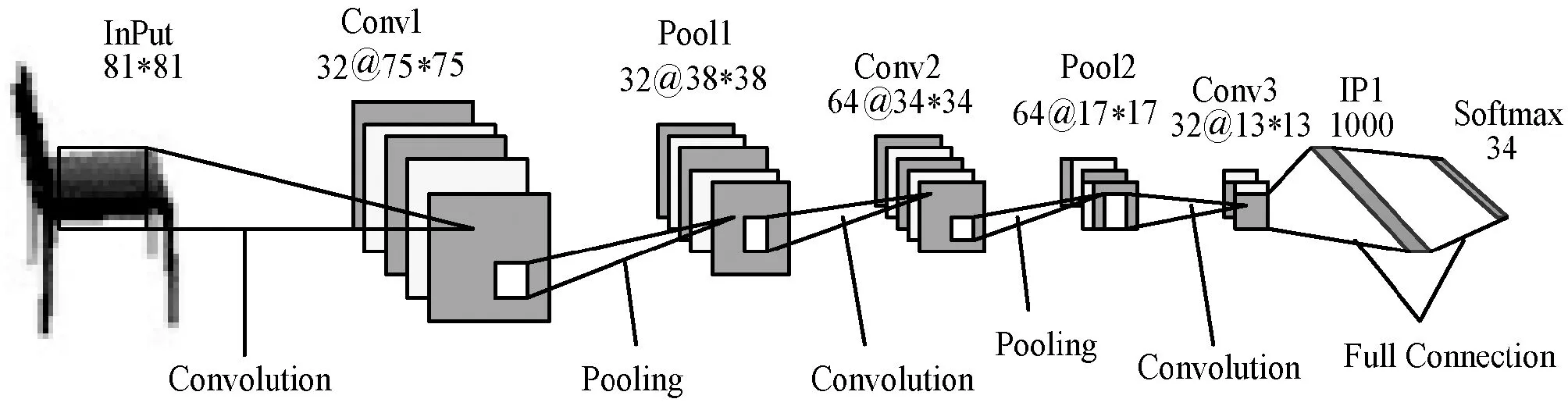

由于不同的場景元素所包含的精分類的類別并不相同,針對每個元素主體設計不同的網絡結構來達到分類匹配目的。此處不同元素的網絡結構大體類似,故本節以椅子作為主要描述對象。我們獲取到34個不同的椅子三維模型,即總共有34個椅子的精分類類別。

如圖1所示,本網絡結構有三層卷積層以及兩層下采樣層組成。網絡結構中每層卷積層后都添加激活函數,這里選擇RELU函數,其公式為:

f(x)=max(0,x)

(1)

圖1 卷積神經網絡結構圖

使用RELU激活函數有三點好處:一是RELU函數在網絡訓練階段計算量小,效率高;二是sigmoid激活函數容易出現梯度消失現象,RELU則可以避免這種狀況;三是RELU會使得部分神經元輸出為0,減少了參數之間的相互依存關系,對防止過擬合有一定作用。

3 實 驗

3.1 實驗數據

本文模型的輸入數據是語義分割后得到的場景元素圖像塊的深度圖,輸出是該圖像塊所屬的精分類類別。為了得到該分類模型的訓練數據,首先通過一些免費設計素材網站下載并整理室內場景三維模型,并搜索與之對應的真實RGB圖像,通過三維投影的方法,手動渲染了帶類標的深度圖像。然后通過對NYU室內場景圖片數據集的語義分割,手動標注了部分真實場景中的數據,混合形成本實驗的訓練數據集,用來訓練網絡模型。如圖2所示,NYU室內場景數據集由微軟的Kinect相機拍攝的各種室內場景的視頻序列組成。

圖2 NYU數據集樣本

3.2 評價標準

本文所提出的基于模型匹配的三維重建技術其實就是把重建方法轉化成一個分類問題。所以,分類問題的評價指標便是本實驗的評價標準,即模型匹配的準確率。

3.3 參數分析

通過對比現階段流行的深度學習框架,選擇了高效靈活的Caffe框架作為實驗環境。實驗環境配置如下:core i7處理器、NIVIDIA GTX980 GPU、16 GB內存、Caffe、Python。

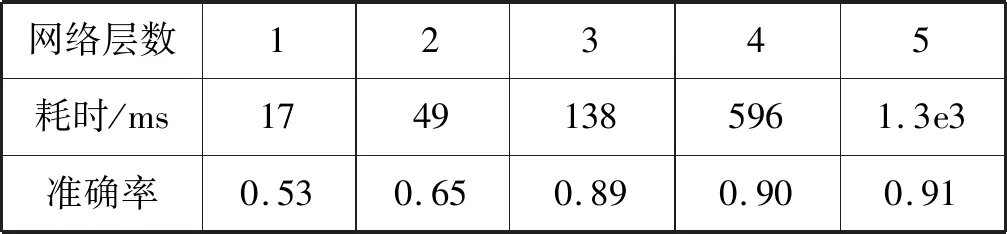

在進行網絡層數的選擇時,主要考慮耗時和準確率的問題,由于深層的深度神經網絡無論是在訓練階段還是測試階段,網絡層數多而導致的計算過程中大量的矩陣運算會增加耗時,所以盡可能在保證準確率的情況下選擇淺層卷積神經網絡是十分重要的。為此,本文設計一組關于卷積神經網絡層數對匹配效果影響的實驗,分別是1~5層卷積層的神經網絡結構搭配對應的采樣層來進行試驗。實驗效果如表1所示。

表1 不同層數網絡結構定量分析

表1中的耗時指標為單張圖像塊進行一次模型匹配所耗時長。可以看出,當網絡深度逐漸增大時,進行模型匹配的準確率有一定的增加,但深層的神經網絡又增加了測試時長,使得該算法在實際應用中沒有很好的使用價值。且在3層卷積結構,即整體網絡層數為7層時,準確率和耗時都在合理范圍內,而繼續增加網絡深度,對準確率的提升并不明顯,反而會增加耗時。故在后續實驗中,將選取3層卷積層,2層下采樣層作為最終網絡結構,即前文所提出的卷積神經網絡模型。

3.4 實驗結果

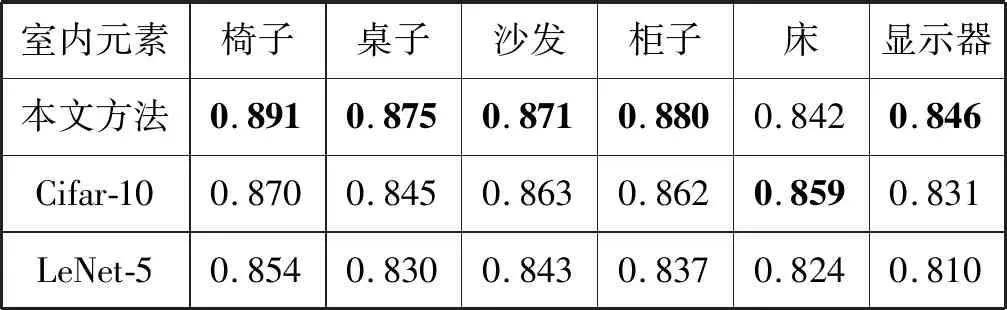

在實際室內場景中地板、天花板、墻和背景不需要參與三維模型匹配。椅子、桌子、沙發、柜子、床和顯示器這六種室內場景元素是有很多精分類的對象,故本實驗以這六種元素作為討論對象。為了對比本文所提出的方法和一些傳統的圖像分類模型的效果,本文使用Cifar-10和LeNet-5網絡結構做出相關對比實驗,結果如表2所示。

表2 不同結構精度對比

通過三維匹配得到模型,從而將匹配得到的室內場景元素三維模型和深度圖構建的殘缺點云模型相結合,得到一個大致的室內場景三維重建模型。

3.5 實驗分析

由表2可知,本文提出的基于匹配的三維場景重建技術能達到比較好的效果。該算法重建的室內場景三維模型基本能夠還原真實場景的場景畫面。但是有些區分度不高的元素,例如顯示器和床等,大部分顯示器都具有雷同的外觀,尤其是在對其進行圖像分析過程中所產生的誤差,使得其最終的模型匹配準確率整體偏低。

實驗選取的Cifar-10網絡結構和LeNet-5網絡結構,都是傳統的圖像分類方法上效果比較好的模型,針對這些模型進行改進,使它們適應本文問題的應用場景,訓練模型所得結果對本文模型的驗證有著很大的參考價值。在大部分場景元素的匹配中,本文算法都能夠取得相對較高的水平。通過實驗驗證了本文所提的基于卷積神經網絡的三維場景建模方法是一個高效可行的解決方案。

4 結 語

本文提出并實現了一種基于卷積神經網絡的三維場景重建方法。在對2D圖像進行語義分割的基礎上,提取分割后的室內場景元素圖像塊,訓練了一個基于卷積神經網絡的三維模型匹配模型,然后將匹配得到的三維模型結合深度圖構造的殘缺三維模型,進一步進行組合,從而完成室內場景的三維重建工作。并通過實驗驗證了該方法的可行性和優異性。隨著深度學習等技術的發展,一些新的基于深度學習的圖像分類算法將會使圖像分類技術得到很大的發展。這是本文三維模型匹配算法的核心,在這方面進行進一步研究可以提高三維模型匹配算法的準確率,使得整個三維場景重建的效果變得更好。