一種面向生文本的事件同指消解神經(jīng)網(wǎng)絡(luò)方法

方 杰,李培峰,朱巧明

(蘇州大學(xué) 計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院,江蘇 蘇州 215006)

0 引言

事件是語義表示的基本單位,描述了在真實(shí)世界中發(fā)生的事情。同指事件指向了真實(shí)世界中的同一個(gè)事件,是同一個(gè)事件在文檔中的不同表現(xiàn)形式。事件同指消解(event coreferecne resolution)用于識(shí)別同指事件實(shí)例,并將它們聚合形成一個(gè)事件鏈。例1和例2是兩個(gè)同指事件實(shí)例。例1中的觸發(fā)詞“l(fā)anded”,和例2中的觸發(fā)詞“l(fā)and”,都指向現(xiàn)實(shí)生活中的一個(gè)移動(dòng)(movement)類型的事件,它們被聚合到同一個(gè)事件同指鏈中。事件同指消解在話題探測(cè)[1]、信息抽取[2]和問答[3]等領(lǐng)域均有重要作用。

例1ACubanpatrolboatwithfourheavilyarmedmenlandedonAmericanshores.

例2ThesebozosletfourarmedCubanslandonourshores.

相比成熟的實(shí)體同指消解,事件同指消解更為復(fù)雜。由于事件實(shí)例的表示形式非常靈活[4],因而事件同指消解具有挑戰(zhàn)性。根據(jù)事件實(shí)例是否在同一個(gè)文檔中,可把事件同指消解劃分為兩大任務(wù),即文檔內(nèi)事件同指消解以及跨文檔事件同指消解。本文主要研究文檔內(nèi)事件同指消解。

目前,事件同指消解存在兩個(gè)主要問題。第一是面向未標(biāo)注生文本的事件同指消解方法很少。事件同指消解任務(wù)[5]嚴(yán)重依賴于事件抽取[6]。事件抽取用于發(fā)現(xiàn)文檔中特定類型的事件并對(duì)事件進(jìn)行分類。目前,大部分事件同指消解的研究都建立在事件已知(事件類型已經(jīng)標(biāo)記)的基礎(chǔ)之上,提出的方法需要利用大量標(biāo)注信息(如事件類型、子類型、時(shí)態(tài)、極性等),這使得這些事件同指消解方法難以真正應(yīng)用到現(xiàn)實(shí)任務(wù)中。

再就是早期的研究通常使用基于概率圖模型[7]或淺層神經(jīng)網(wǎng)絡(luò)模型[8]進(jìn)行事件的建模,無法高質(zhì)量獲取事件間復(fù)雜的語義信息。在一篇文檔中,同指事件實(shí)例在語義結(jié)構(gòu)上有著復(fù)雜、多變的表達(dá)方式,這導(dǎo)致了手工特征以及淺層特征在同指事件消解中的效果不明顯。此外,大部分研究僅僅使用單詞之間的短距離,這在事件相似度計(jì)算中會(huì)丟失全局特征,容易得出片面的結(jié)果。

為了解決上述問題,本文提出了一個(gè)面向未標(biāo)注生文本的事件同指消解模型,包括事件抽取、事件真實(shí)性識(shí)別和事件同指消解三部分。相比傳統(tǒng)事件已知的事件同指消解方法,本文使用模型發(fā)現(xiàn)文檔中事件,并進(jìn)行事件同指消解,只需輸入未標(biāo)注的生文本信息即可得到同指的結(jié)果。

本文提出的面向生文本的事件同指消解模型首先通過長短期記憶網(wǎng)絡(luò)(Long Short-Term Memory,LSTM)和卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)模型抽取事件并識(shí)別事件的真實(shí)性。在此基礎(chǔ)上,提出了一種基于注意力池化[9]和門控卷積[10]的事件同指消解模型,能很好地自動(dòng)抽取事件對(duì)特征。在KBP 2015和KBP 2016兩個(gè)數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果顯示,本文的模型均獲得了不錯(cuò)的效果。本文的貢獻(xiàn)有如下幾個(gè)方面:

(1) 在事件同指消解中加入事件真實(shí)性信息,真實(shí)性信息對(duì)于判斷事件是否同指具有重要作用;

(2) 把卷積池化用于特征的壓縮,使得事件在相似度計(jì)算的過程中可捕獲事件全局特征;

(3) 把門控卷積用于特征編碼,將特征映射到高維空間中,便于提取復(fù)雜語義特征。

1 相關(guān)工作

事件同指消解最早由Bagga[11]等提出,他們?cè)谛?shù)據(jù)集上做了初步的研究。在事件同指消解的語料庫方面,有ACE、ECB、KBP等語料庫。ACE語料庫中含有599篇文檔,包含了8種事件類型以及33種事件子類型。ACE語料庫中標(biāo)注了文檔內(nèi)的同指信息,以及事件的論元、時(shí)態(tài)、極性等語言學(xué)特征。ECB語料庫[12]是一個(gè)兼具文檔內(nèi)和跨文檔事件同指消解語料庫,包含502篇文檔及43種話題。ECB語料庫根據(jù)事件的地點(diǎn)、動(dòng)作、時(shí)間以及參與者是否一致來判斷事件之間是否同指。TAC-KBP會(huì)議中的事件抽取以及文檔內(nèi)事件同指消解評(píng)測(cè)任務(wù)提供了KBP語料庫[13]。KBP 2015語料庫中含有360篇文檔,其中包括8種事件類型和38種事件子類型。KBP 2016語料庫的測(cè)試集中刪除了部分容易識(shí)別為同指事件的事件子類型,保留了18種事件子類型。和ACE語料庫相比,KBP語料庫中沒有實(shí)體、論元等標(biāo)注信息,因而在KBP語料庫中進(jìn)行事件同指消解更加困難。

由于事件抽取任務(wù)較為困難,早期的事件同指消解通常基于已知事件并充分利用事件的標(biāo)注屬性(例如,事件類型、事件論元、極性和時(shí)態(tài)等)。Chen[14]等提出了一種基于4種事件屬性的事件對(duì)分類器,將事件的4種基本屬性(時(shí)態(tài)、極性等)作為同指消解的特征。Liu[15]等使用了大量的標(biāo)注信息,例如,論元中心詞、實(shí)體等特征,并加入了觸發(fā)詞前后單詞的語義信息、事件之間的距離等手工特征,最后使用SVM進(jìn)行事件同指消解。由于事件對(duì)分類模型沒有考慮到全局事件的同指消解,事件對(duì)分類結(jié)果轉(zhuǎn)化成事件簇的形式時(shí)會(huì)產(chǎn)生沖突。Ng[16]等提出了圖模型聚類的方法,構(gòu)建以事件為節(jié)點(diǎn)的無向圖,并將事件同指置信度高于閾值的兩個(gè)事件相互連接,形成事件簇。相比傳統(tǒng)機(jī)器學(xué)習(xí)方法使用大量的手工特征和外部信息,Krause[8]等僅使用了少量的標(biāo)注特征,基于CNN對(duì)句子和觸發(fā)詞上下文進(jìn)行建模,并通過比較特征之間的余弦距離判斷事件是否同指。

以往使用基于概率圖的模型或淺層的神經(jīng)網(wǎng)絡(luò)模型,大部分都是基于事件已知的事件同指消解,因而無法進(jìn)行比較。而基于事件未知的事件同指消解由于不能使用標(biāo)注信息,任務(wù)難度更大,因而在這方面的研究相對(duì)較少。Peng[17]等設(shè)計(jì)了一個(gè)事件抽取和事件同指消解的管道模型,使用多種向量化方法(如布朗聚類、詞向量、依存句法分析等)將事件表示成結(jié)構(gòu)化的事件向量,最后通過比較事件向量之間的相似度來判斷事件是否同指。由于管道模型會(huì)導(dǎo)致事件抽取的錯(cuò)誤在事件同指消解上累積,Lu[18]等使用了基于馬爾科夫邏輯網(wǎng)絡(luò)的聯(lián)合學(xué)習(xí)的事件同指消解模型,可在進(jìn)行事件同指消解時(shí)糾正事件抽取的錯(cuò)誤。由于都是基于簡單的淺層網(wǎng)絡(luò),或使用規(guī)則的方法進(jìn)行事件同指消解,因此在事件同指上的效果不佳。本文使用了門控卷積及注意力池化機(jī)制對(duì)事件進(jìn)行建模。門控卷積的遺忘門機(jī)制優(yōu)化了信息流動(dòng)的路徑,并帶入了時(shí)序特征。而注意力池化對(duì)特征加權(quán),能夠篩選出重要特征,大大提升了事件同指消解的性能。

2 面向生文本的事件同指消解模型

本文面向生文本的事件同指消解框架主要由事件抽取、真實(shí)性識(shí)別、事件同指消解三個(gè)部分構(gòu)成,如圖1所示。事件抽取部分使用多種神經(jīng)網(wǎng)絡(luò)模型(例如,BiLSTM(Bidirectional Long Short Term Memory)、CNN、BERT[19])建立語言模型,抽取句子的語言特征,并加入候選觸發(fā)詞及其前后的單詞作為輔助特征,用于判斷該候選觸發(fā)詞是否屬于定義的事件,并預(yù)測(cè)其事件類型。

圖1 面向生文本的事件同指消解框架

真實(shí)性識(shí)別用于判斷事件的真實(shí)性。事件的真實(shí)性有三種: 真實(shí)發(fā)生的事件,泛指類事件以及其他事件。其中,其他事件是指不能確定發(fā)生的事件。如以下例子所示。

例3Thetroopsareattackingthecity.

例4Weaponsalestoterroristsareaproblem.

例5Heplanstomeetwithlawmakersfrombothparties.

在真實(shí)事件中(例3),句子中的觸發(fā)詞通常會(huì)帶有進(jìn)行時(shí)或過去時(shí)(如例3中的are attacking)來表達(dá)一個(gè)真實(shí)發(fā)生的事件。而在泛指類事件(例4)中,通常沒有特別復(fù)雜的時(shí)態(tài),描述普遍存在的通用事件。而在其他事件(例5)中,會(huì)見(meet)事件僅僅是一個(gè)計(jì)劃,無法判斷其是否發(fā)生。這類事件通常會(huì)在前面有一些假設(shè),如“計(jì)劃”(plan)等。

事件真實(shí)性特征對(duì)于事件同指消解有著重要的作用,因?yàn)檎鎸?shí)性不同的事件將不可能是同指事件。事件的真實(shí)性與觸發(fā)詞的上下文有密切的關(guān)聯(lián)。因此,本文以事件的上下文為特征,并使用BiLSTM以及CNN模型對(duì)上下文建模,預(yù)測(cè)事件的真實(shí)性。

由于兩個(gè)同指事件具有較高的關(guān)聯(lián)度和相似性,本文使用事件對(duì)關(guān)聯(lián)度模型來判斷事件對(duì)是否同指。本文首先使用卷積神經(jīng)網(wǎng)絡(luò)對(duì)事件句進(jìn)行建模;然后,將事件特征相互融合,再加入事件類型、事件真實(shí)性等特征進(jìn)一步優(yōu)化模型;最后,將事件對(duì)同指結(jié)果轉(zhuǎn)化為事件鏈的形式。

2.1 事件抽取與真實(shí)性識(shí)別

事件抽取和真實(shí)性識(shí)別任務(wù)有很高的相似性,因此本文使用了多任務(wù)學(xué)習(xí)的架構(gòu)來抽取事件和識(shí)別其真實(shí)性。

事件抽取采用了多種神經(jīng)網(wǎng)絡(luò)模型,即BERT,BiLSTM,CNN,以及BiLSTM+CNN,來抽取事件特征,如圖2所示。

圖2 基于BiLSTM和CNN的事件抽取模型

下面以BiLSTM+CNN為例來說明其結(jié)構(gòu)。首先,從訓(xùn)練集中搜集觸發(fā)詞,并整合成觸發(fā)詞表,作為本文的候選觸發(fā)詞。本文使用候選觸發(fā)詞表探測(cè)文檔中的每個(gè)句子是否含有表中的單詞,并抽取候選觸發(fā)詞以及候選觸發(fā)詞所在句子中的前一個(gè)單詞和后一個(gè)單詞作為本文的觸發(fā)詞特征(Tri)。其次,將事件句特征和事件句候選觸發(fā)詞及其前后單詞特征輸入到該模型中。對(duì)于含有候選觸發(fā)詞的句子,本文先使用Transformer結(jié)構(gòu)的BERT預(yù)訓(xùn)練模型,提取句子中的語言學(xué)特征,BERT使用了大量的文檔進(jìn)行訓(xùn)練,并且Transformer中含有的大量參數(shù)用于提取豐富的語言學(xué)特征,進(jìn)而得到更好的語言學(xué)表示,接著我們使用BiLSTM以及CNN等參數(shù)量較少的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)一步提取基于事件任務(wù)的特征。由于KBP語料庫數(shù)據(jù)量較小,使用參數(shù)少的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)可以防止過擬合。最終得到句子級(jí)的特征向量SV(Sentence Vector)。CNN可對(duì)句子相鄰的單詞進(jìn)行采樣。由于相鄰單詞有較強(qiáng)的關(guān)聯(lián)度,因此可以抽取到句子間的語義特征。但由于CNN抽取的特征是一種詞袋特征,沒有引入單詞之間的順序信息,因此加入BiLSTM進(jìn)一步增強(qiáng)模型的性能。雙向的LSTM可以從前后兩個(gè)方向獲取句子的語義特征,由此可以得到更好地描繪事件句的信息。最后,將特征向量SV和候選觸發(fā)詞及前后單詞的特征向量Tri拼接,得到最終的向量EV,并將EV輸入到全連接分類器中得到分類結(jié)果。由于本文是多任務(wù)學(xué)習(xí)模型,因此事件抽取模型和真實(shí)性識(shí)別模型的網(wǎng)絡(luò)層相互共享,僅在最后一層由于分類任務(wù)的不同而使用了不同的全連接層。模型將同時(shí)輸出兩種分類任務(wù)的結(jié)果。集成學(xué)習(xí)(ensemble)由于結(jié)合多個(gè)單模型,往往能獲得比單模型更好的泛化能力。和Lu[18]在實(shí)驗(yàn)中使用了集成的分類器一樣,本文使用了BiLSTM、CNN、BiLSTM+CNN三種不同架構(gòu)的單模型進(jìn)行事件類型分類,再采用投票法的集成方式選取三種模型中一致性最高的結(jié)果作為最終結(jié)果。不同架構(gòu)的結(jié)果具有高差異性,這可使模型在集成的過程中得到更好的性能。

2.2 事件同指消解

事件同指消解模型AGCNN采用事件對(duì)的模型,如圖3所示。把兩個(gè)事件E1和E2輸入到AGCNN中,輸出結(jié)果就是這兩個(gè)事件E1和E2是否同指。AGCNN主要通過抽取事件之間的相互信息來判斷事件是否同指,內(nèi)部包括編碼層、融合層和分類層三個(gè)部分。

圖3 事件同指模型AGCNN結(jié)構(gòu)圖

編碼層使用了一維卷積對(duì)事件進(jìn)行編碼,卷積結(jié)構(gòu)可以通過卷積核的滑動(dòng)獲取句子前后的語義特征。相比RNN模型,一維卷積具有可以減少過擬合的發(fā)生,因而有更好的準(zhǔn)確度。

融合層將兩個(gè)事件E1和E2進(jìn)行融合和拼接,通過比較事件特征之間的差異性來判斷事件是否同指。在融合過程中,本文使用注意力池化方法壓縮事件E1的特征,再把該特征和事件E2的每個(gè)特征進(jìn)行融合,這使得事件E2的每個(gè)特征都和事件E1的全局特征進(jìn)行比較,防止了比較過程中的片面性。

分類層首先使用了一層全連接網(wǎng)絡(luò)抽取特征并判斷事件對(duì)是否同指。最后,將事件對(duì)結(jié)果轉(zhuǎn)化成事件鏈的形式。

2.2.1 輸入層

AGCNN輸入的是兩個(gè)事件E1和E2的事件句特征、觸發(fā)詞對(duì)特征(Trigger Pair)以及事件對(duì)特征(Event Pair)。

事件句特征e1和e2是兩個(gè)事件E1和E2對(duì)應(yīng)的兩個(gè)句子,是事件同指消解的主要特征。本文使用BERT技術(shù)抽取句子特征,并得到句子向量S1和S2。

觸發(fā)詞對(duì)特征是事件的核心特征。因而,本文單獨(dú)對(duì)兩個(gè)事件的觸發(fā)詞進(jìn)行比較。AGCNN中的觸發(fā)詞對(duì)特征由圖1的模型預(yù)測(cè)得來。本文使用Word2Vec將觸發(fā)詞對(duì)轉(zhuǎn)化成觸發(fā)詞向量t1和t2,將兩個(gè)觸發(fā)詞相減得到觸發(fā)詞比較向量TV(Trigger Vector),通過觸發(fā)詞詞向量之間作相減的運(yùn)算可以得到觸發(fā)詞之間的相似程度,這也是判斷事件同指的重要特征。

事件對(duì)特征來源于事件類型和真實(shí)性,是事件抽取和真實(shí)性識(shí)別的輸出結(jié)果。事件對(duì)特征同樣是事件是否同指的重要判斷依據(jù)。如果事件的類型和真實(shí)性不一致,那么事件將不可能同指。本文比較兩個(gè)事件的類型和真實(shí)性是否一致,得到事件對(duì)特征PV(Pair Vector),該特征是一種二元特征,在事件類型和真實(shí)性均一致的情況下取1,否則取0。

2.2.2 編碼層

事件句主要使用了一維卷積進(jìn)行編碼。如式(1)、式(2)所示,分別將事件句S1和S2經(jīng)過一維卷積后得到C1和C2。由于相鄰單詞之間具有較強(qiáng)的關(guān)聯(lián)性,所以可使用卷積核左右滑動(dòng)獲取事件間的相關(guān)信息,從而抽取到一個(gè)事件的語義特征。在事件句中,觸發(fā)詞周圍通常會(huì)含有與事件信息相關(guān)的單詞,如事件參與者、地點(diǎn)、時(shí)間等,因而使用卷積在觸發(fā)詞周圍滑動(dòng)可以得到與事件高度相關(guān)的語義特征。此外,多種卷積核可以在不同維度提取事件的特征,相當(dāng)于從多個(gè)角度提取事件的特征,使得事件的深層特征得以被挖掘,如式(1)、式(2)所示。

2.2.3 融合層

融合層主要包括事件間的特征融合,以及事件特征和事件對(duì)特征融合。通常在一個(gè)事件中含有大量的噪聲信息,因此本文加入了注意力機(jī)制,對(duì)句子中的每個(gè)單詞都賦予權(quán)值。對(duì)事件同指消解相關(guān)度不大的單詞將會(huì)得到較小的權(quán)值,從而減少了噪聲信息對(duì)模型的影響。在事件句特征的融合中,注意力池化可看作一個(gè)加性注意力機(jī)制,本文使用注意力池化方法壓縮事件E1的特征C1,得到壓縮特征向量XV,如式(3)、式(4)所示。注意力池化可看作一個(gè)加性注意力機(jī)制。其中,W是事件特征C1的注意力權(quán)值,它在初始時(shí)會(huì)被賦予一個(gè)隨機(jī)的值,隨后在反向傳播的過程中不斷調(diào)整。lC1是C1的長度,AttenC是加上權(quán)值后的事件句特征,AttenCj是事件句卷積編碼特征中第j個(gè)向量。

注意力池化可以動(dòng)態(tài)地對(duì)事件句中的特征加權(quán),再進(jìn)行求和。相比平均池化,注意力的加權(quán)機(jī)制相當(dāng)于對(duì)特征作了一次過濾處理,重要的特征將會(huì)被放大。而最大池化只選擇數(shù)值最高的特征,這將使大量的特征丟失。

為了使事件E1的特征與E2的特征融合,本文需要使兩個(gè)特征向量的維度保持一致。因此本文將事件E1的特征C1復(fù)制K次,其中K為事件句C2的長度,并將這些特征合并,得到特征向量RV(Repeat Vector),如式(5)所示。

RV與事件E2的特征C2的最后一維合并(特征向量的維度可以表示為(batch_size,sen_length,feature_dim),最后一維即特征維,合并特征維將使特征維度翻倍,并得到更好的特征表示),得到事件句融合特征EV。

使用注意力池化壓縮事件E1的特征并與事件E2融合的做法使得事件E2中的每個(gè)特征單位都可和事件E1的全局特征作比較,減少了片面性。在實(shí)驗(yàn)中本文嘗試了將C1與C2都進(jìn)行特征壓縮,但這使特征數(shù)量銳減,致使模型性能下降。此外本文也嘗試將C2特征壓縮并與C1融合,添加到模型中,但也沒有獲得性能上的提升。原因可能是和事件句C2相比,C1通常在文檔較前的位置,這使得C1句子中較少出現(xiàn)代詞,語義更加清晰,C1的全局特征會(huì)更有意義。同時(shí),將C2壓縮并與C1融合添加到模型中的做法也導(dǎo)致了模型參數(shù)成倍增加,容易造成模型的過擬合。

然后本文將事件句融合特征EV輸入到一層門控卷積中,得到最終的事件句融合特征向量ECV,如式(6)所示。門控機(jī)制相當(dāng)于LSTM中的門機(jī)制,解決了卷積在處理文本時(shí)無法獲取單詞的順序信息的問題。在事件中,論元位置不同,所表達(dá)的語義也會(huì)不同,這依然是判別是否為同指事件的關(guān)鍵。同時(shí),門控卷積可以將特征映射到高維空間中,從而提取非線性的特征。

最后,本文綜合了事件句的文本特征、觸發(fā)詞的特征以及真實(shí)性特征,這可以使模型從多種角度衡量事件是否同指。如圖2所示,將事件句融合特征ECV,觸發(fā)詞比較特征TV和事件對(duì)特征PV拼接,得到最終的特征向量FV,如式(7)所示。

2.2.4 分類層

分類器主要由一層全連接層構(gòu)成。將FV輸入到全連接層中,最終得出事件對(duì)是否同指,如式(8)所示,其中Wout是分類層參數(shù),bout是偏置項(xiàng)。

由于事件同指中正負(fù)樣本數(shù)據(jù)非常不平衡,本文使用focal loss作為損失函數(shù),如式(9)所示。為了防止過擬合,本文使用了dropout和batchnorm技術(shù)。

最后,將以上事件對(duì)同指消解結(jié)果采用無向圖連接方法,將判為同指的事件對(duì)相互連接,轉(zhuǎn)化成事件鏈的形式。

3 實(shí)驗(yàn)

本文使用了KBP 2015以及KBP 2016的英文語料庫,用于驗(yàn)證本文提出的事件同指消解模型AGCNN的有效性。KBP 2015含有8種事件類型和38種事件子類型。KBP 2016則刪除了大量容易識(shí)別為同指事件的事件類型,含有8種事件類型和18種事件子類型。由于含有候選觸發(fā)詞的句子可能并不是事件句,因此本文在實(shí)驗(yàn)中添加了一項(xiàng)NoneType類,即不是事件的句子。所以本文在KBP 2015和KBP 2016中分別有39和19種類型。和ACE 語料庫不同的是,KBP語料庫中一句話中通常含有若干個(gè)事件類型,而ACE語料庫中一句話一般只包含一個(gè)事件。以下是KBP 2016中的例子。

例6IfChenremittedallthemoneyhisfamilyheldoverseasbacktoTaiwan,hewouldhaveagoodchanceofbeingreleased.

例7"IhadremittedallUS$18.43millionback.Ifthejudgestillwon’treleaseme,ishecheattingme?"theformerpresidentasked.

例6中含有兩個(gè)事件,分別為以“remitted”為觸發(fā)詞的Transfer-Money的事件和以“released”為觸發(fā)詞的Justice-Arrest的事件。同樣地,例7中也含有兩個(gè)事件,分別為以“remitted”為觸發(fā)詞的Transfer-Money的事件和以“release”為觸發(fā)詞的Justice-Arrest的事件,且例6中的兩個(gè)事件與例7 中的兩個(gè)事件都分別描述了同一個(gè)事件,因此,這兩對(duì)事件互相同指。

3.1 實(shí)驗(yàn)設(shè)置

本文在實(shí)驗(yàn)中以9:1的比例選取訓(xùn)練集和開發(fā)集,測(cè)試集采用了KBP的官方測(cè)試集。實(shí)驗(yàn)中句子向量的維度為300維,卷積核大小為3,Dropout值為0.2,訓(xùn)練輪數(shù)為50輪,實(shí)驗(yàn)中選取開發(fā)集中最好的一輪用于測(cè)試集。

實(shí)驗(yàn)中,事件同指消解和真實(shí)性識(shí)別使用了BERT預(yù)訓(xùn)練模型,并在BiLSTM、CNN、BiLSTM+CNN結(jié)合的集成模型進(jìn)行微調(diào),預(yù)測(cè)出事件類型和事件的真實(shí)性,并輸入到事件同指消解模型AGCNN(單模型)中,輸出事件同指的結(jié)果。在評(píng)測(cè)中,本文使用了召回率、準(zhǔn)確率、F1值來評(píng)測(cè)事件抽取和真實(shí)性識(shí)別的性能,使用MUC,B3[20],CEAFe[21]和BLANC[22]評(píng)測(cè)事件同指消解的性能。其中,MUC是基于事件鏈的指標(biāo),B3是基于事件的指標(biāo),它彌補(bǔ)了MUC忽略非同指事件評(píng)測(cè)的不足。CEAFe加入了實(shí)體用于評(píng)測(cè)事件同指消解的性能,BLANC評(píng)測(cè)了非同指事件和同指事件之間的平均性能。4種指標(biāo)的綜合評(píng)測(cè)全面地反映模型在事件同指消解中的性能。

3.2 實(shí)驗(yàn)結(jié)果

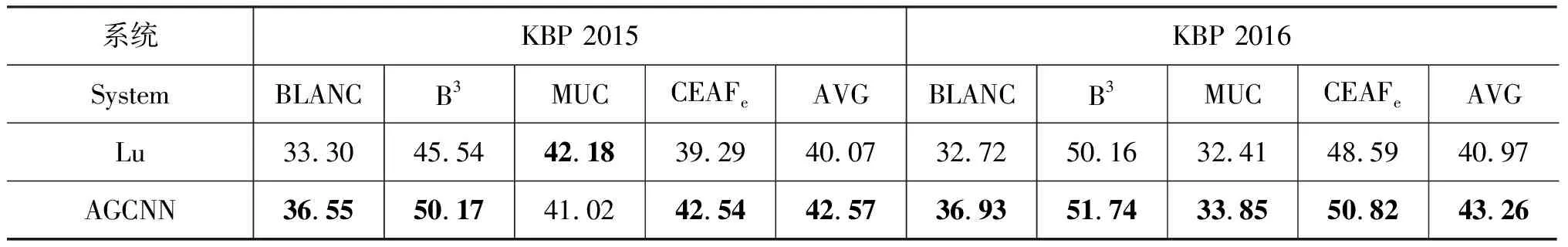

為了驗(yàn)證本文面向生文本的事件同指系統(tǒng)的性能,本文選取了目前性能最好的面向生文本的事件同指消解系統(tǒng)Lu[18]作為基準(zhǔn)系統(tǒng)。另外,由于神經(jīng)網(wǎng)絡(luò)方法Krause[8]使用了大量的標(biāo)注事件特征,所以無法和本文方法進(jìn)行比較。事件抽取、事件真實(shí)性識(shí)別和事件同指消解的結(jié)果如表1~表3所示。其中,表1和表2中LC為圖1所示的模型,ENS_NN是集成模型。

表1 事件抽取實(shí)驗(yàn)結(jié)果

表2 真實(shí)性識(shí)別實(shí)驗(yàn)結(jié)果

表3 事件同指消解實(shí)驗(yàn)結(jié)果

在事件抽取方面,ENS_NN和Lu性能相當(dāng),F(xiàn)1值在KBP 2015和KBP 2016中分別提升了1.2%和0.22%。相比KBP 2015的事件抽取性能,KBP 2016的性能相對(duì)較低,這是因?yàn)镵BP 2016的訓(xùn)練集和測(cè)試集的差距相比KBP 2015更大。Lu在實(shí)驗(yàn)中使用了WordNet等外部信息作為擴(kuò)充,減少了性能的下降,而本文將BERT在大規(guī)模語料中得到的參數(shù)遷移至本文的任務(wù)中,同樣提升了性能。表1和表2也顯示了集成模型ENS_NN和LC相比在事件抽取和真實(shí)性識(shí)別性能上有提升。

本文研究的側(cè)重點(diǎn)是事件同指消解。表3的結(jié)果表明本文提出的AGCNN在KBP 2015和KBP 2016上的平均F1值和Lu相比分別有2.5%和2.29%的提升,這驗(yàn)證了本文模型AGCNN的有效性。Lu需要為CRF分類器提取大量的手工文本淺層特征,并使用了一套復(fù)雜的規(guī)則系統(tǒng)用于事件同指消解。而本文提出的AGCNN只需要簡單的文本信息,特征都從文本信息中自動(dòng)學(xué)習(xí)得來。

AGCNN在兩個(gè)語料庫上的平均性能均優(yōu)于Lu。但是,在MUC上的提升較小。這是因?yàn)镸UC只統(tǒng)計(jì)了事件鏈中同指鏈的數(shù)量,而對(duì)非同指鏈(孤鏈)的處理欠佳。因此,綜合使用B3、CEAFe和BLANC更能反映模型在事件同指消解方面的性能。同時(shí)實(shí)驗(yàn)結(jié)果也表明模型在KBP 2016中的MUC性能與Lu的差距大幅縮小,這是由于KBP 2016中刪除了大量容易區(qū)分為同指的事件類型,刪除事件類型也進(jìn)一步造成了非同指事件數(shù)量的增加。綜上所述,AGCNN在事件消解上的性能總體優(yōu)于Lu的模型。

3.3 實(shí)驗(yàn)分析

AGCNN性能提升的原因主要源于以下三個(gè)方面: (1)真實(shí)性特征的加入;(2)注意力池化的使用;(3)門控卷積的加入。表4分別顯示了加入真實(shí)性特征、注意力池化、門控卷積后各項(xiàng)指標(biāo)在F1值上的提升。

表4 與除去真實(shí)性特征(Realis)、注意力池化(Atten)、門控卷積(Gated)的方法比較

AGCNN去除真實(shí)性特征后,表4顯示平均F1值在兩個(gè)語料庫上分別降低了3.91%和2.52%。本文的真實(shí)性識(shí)別模型的準(zhǔn)確率雖然不高,但同指消解系統(tǒng)所用的特征只需判斷事件之間真實(shí)性特征是否一致,利用真實(shí)性識(shí)別模型結(jié)果的事件對(duì)真實(shí)性一致特征在KBP 2015和KBP 2016中的準(zhǔn)確率達(dá)到72.6%和68.9%,能有效提升事件同指消解的性能。

表4表明了注意力池化的重要性。AGCNN去除注意力池化后,F(xiàn)1值分別降低了1.44%和1.72%。本文的注意力池化相當(dāng)于對(duì)特征的加權(quán)平均。相比平均池化、特征池化,注意力池化使得特征處理更加平滑,能夠針對(duì)性地選出重要的信息。

表4也表明了門控卷積的有效,F(xiàn)1值分別提升了0.45%,1.15%。這說明門控的卷積神經(jīng)網(wǎng)絡(luò)可以提取更多復(fù)雜的高維語義特征。門控卷積能在特征學(xué)習(xí)和提取特征時(shí)自適應(yīng)地建立上下文和局部語義之間的聯(lián)系,而普通卷積只能感知局部語義。相比RNN結(jié)構(gòu),門控卷積計(jì)算量更小。

4 結(jié)論

本文提出了一種面向生文本的事件同指消解模型AGCNN,該模型中真實(shí)性特征、注意力池化和門控卷積的使用都大大提升了性能。實(shí)驗(yàn)結(jié)果顯示,本文的模型AGCNN在KBP 2015和KBP 2016語料庫中擊敗了目前最優(yōu)系統(tǒng)。未來的工作是將本文的工作延伸至跨文檔事件同指消解和多語言事件同指消解領(lǐng)域。