一種基于近鄰樣本評估的動態選擇性集成預測算法

曲文龍 李一漪 陳笑屹 曲嘉一

摘要:針對現有的動態選擇策略局限于尋找待測樣本的局部相似樣本,未充分考慮樣本特征之間的重要性程度,從而對預測精度造成影響的問題,該文提出一種基于近鄰樣本評估的動態選擇性集成預測算法。算法基于誤差擾動度量出特征的重要性權值,并在此基礎上進行樣本近鄰的相似性度量。根據不同的待測樣本特點自動適應近鄰數目,找到最佳近鄰。通過最佳近鄰對具有不同預測精度的學習器的性能評估,擇優篩選出精度較高的學習器進行選擇性集成預測。實驗結果表明,相比原有集成學習算法和普通選擇性集成算法,該算法預測精度得到進一步提升,表現出良好的預測效果和較強的預測性能。

關鍵詞:動態選擇性集成;回歸預測;近鄰樣本;相似度量

中圖分類號:TP181

DOI:10.16152/j.cnki.xdxbzr.2020-05-014

A dynamic selective ensemble prediction algorithm basedon evaluation of neighborhood sample

QU Wenlong1,LI Yiyi1,CHEN Xiaoyi1,QU Jiayi2

(1.School of Information Engineering, Hebei GEO University, Shijiazhuang 050031, China;

2.School of Science, Hebei University of Science and Technology, Shijiazhuang 050018, China)

Abstract: Aiming at the problem that the existing dynamic selection strategy is limited to finding locally similar samples of the test sample and does not fully consider the importance of the sample features, thus affecting the prediction accuracy,? a dynamic selective ensemble prediction algorithm based on evaluation of neighborhood sample is proposed. Based on the importance weight of the feature measured by the error perturbation, the similarity of neighborhood sample is measured. According to the characteristics of different samples to be measured, the number of nearest neighbor is automatically adapted to find the best nearest neighbor. By evaluating the performance of learners with different prediction accuracy, the learner subset with high accuracy is selected for selective ensemble prediction. The experimental results show that, compared with the original ensemble learning algorithm and the common selective ensemble algorithm, the prediction accuracy of this algorithm is further improved, showing that it has good effect of prediction and strong performance.

Key words: dynamic selective ensemble; regression prediction; nearest neighbor sample; similarity measure

回歸預測是根據自變量和因變量之間的相關關系進行建模預測的方法。集成學習是由Hansen和Salamon提出的一種將互為差異性的基模型使用某種策略組成起來,整合為一個更強大模型的方法[1]。其目的是訓練出一個穩定且可靠的強學習器,以獲得比單一學習器更好的泛化性能。目前,集成學習在許多領域都有了廣泛應用,在數據預測方面也有所涉及[2-3]。然而在集成的過程中,容易引入一些預測精度低,性能不佳的基模型而影響最終模型的泛化能力,還會大大增加所需的存儲空間。

2002年,南京大學周志華等人首次提出了選擇性集成(selective ensemble),它基于一定的評估標準將作用不大的基學習器拋棄,只保留部分表現較好的作為最終集合器來構建集成模型。通過實驗驗證和理論分析,選擇性集成的預測效果明顯優于傳統集成方法[4]。2011年,張春霞等人從不同的評價準則角度詳細綜述了選擇性集成算法,總結了對于分類和回歸的相應研究[5]。早期的選擇性集成通常使用靜態選擇策略,對所有待測樣本均同等對待,導致篩選出的學習器不一定為最優集合。

針對上述問題,相關學者開始了對動態選擇策略的研究[6]。動態選擇策略考慮到每個樣本存在的差異性,根據樣本的不同特點,動態挑選最適合待測樣本的基學習器進行預測,其優勢在于利用更加靈活的方式減少學習器之間的冗余[7-8]。它的主要策略有KNORA(K-nearest-oracles),DCES(dynamic classifier ensemble selection)等[9],并已應用在很多方面,例如人工排水區域預測[10]、客戶流失預測[11]等。Oliveira等人以邊緣平衡作為切入點改進了KNORA,提出了KNORA-B和KNORA-BI技術用于提高分類器的性能[12]。Luca Didaci等人利用合適的距離度量來定義鄰域,并通過鄰域大小的自適應來估計局部分類器的精度進行動態集成[13]。為了減弱噪聲對學習器動態選擇的影響,Cruz Rafael提出一種增強的FIRE-DES++方法[14]。目前關于動態選擇策略的研究主要集中在尋找待測樣本的局部相似樣本,通常采用歐氏距離作為近鄰相似度的定義,而未充分考慮樣本特征的重要性。鑒于此,本文引入特征重要度進行近鄰樣本的相似性度量,根據最佳近鄰對各學習器的預測性能評估進行選擇性集成。

綜上所述,本文提出一種基于近鄰樣本評估的動態選擇性集成預測算法DSERP-KNN(dynamic selective ensemble regression prediction approach based on K-nearest neighbors),該算法首先基于誤差擾動的方式度量出特征權值,并將其作為權重引入到樣本近鄰的相似性度量中;然后根據每個待測樣本的特點自適應近鄰數目,尋找其最佳近鄰樣本并評估各學習器的預測性能。最后在所有基學習器中擇優挑選出精度較高的學習器,進行選擇性集成預測。相比于原有集成學習算法和普通選擇性集成算法,該算法考慮了樣本的特征重要度,有效提高了預測精度,加強了預測性能。

1 相關理論

1.1 集成學習

集成學習是一種通過結合多個較弱學習器來構建一個強學習器的方法,主要分為Boosting,Bagging以及Stacking[15]。其中,由Brieman提出的隨機森林(random forest,RF)是Bagging的代表算法,適用于解決回歸和分類問題[16]。它是由多棵沒有剪枝的決策樹組成,對于每棵樹均利用自助法重采樣技術,有放回地從原始數據中抽取樣本組成訓練集,建立決策樹,并最終全部集成來構建出一個“森林”。它的隨機性體現在采樣和特征選擇均隨機,因此,可以降低模型過擬合的風險[17]。

盡管不易產生過擬合問題,但由于有放回地采樣,使得約1/3的樣本在抽取過程中始終未被取到,而剩下的樣本中有些會被多次抽取,因此,參與每棵決策樹的訓練集只包含原始數據的2/3。這些未被抽取到的樣本稱為袋外數據(out of bag data,OOB),它是產生泛化誤差的主要原因[18-19]。

隨機森林算法的優勢體現在它將多個弱學習器進行全集成,使得總體性能得到最大發揮,且樹與樹之間相互獨立,所以易于并行化的方法來加快訓練速度。當處于異常值較多的情況下隨機森林算法依然能夠保持較高的精度。然而,隨機森林中含有決策樹的棵樹、樹的深度以及節點分裂時的特征個數等大量超參數,它們會對算法性能產生較大影響,因此,關于超參數的取值是它的研究難點。

1.2 選擇性集成

原有集成學習是將創建的所有弱學習器融合得到一個強學習器的過程。盡管它避免了早期機器學習單一的問題,但是在學習過程中會大大增加計算復雜度,并且無法差別對待不同的學習器。為了改善這一問題,選擇性集成在前者基礎上增加了學習器的篩選階段,通過對影響模型整體預測效果的學習器進行剪枝,只集成最具代表性的部分學習器,來提高模型性能。由于學習器個數的減少,不僅可以提高模型預測效果,整體預測速度也優于全部集成。

對于現有的選擇性集成算法,它們的區別主要在于評測方法的不同。評測方法是一種選擇策略,選擇性集成是基于某種選擇策略來完成篩選過程。這些方法可以分為以下4類:基于聚類的方法、基于排序的方法、基于優化的方法以及基于選擇的方法[5]。其中,基于選擇的方法又分為靜態選擇和動態選擇,靜態選擇法的主要思想為對待任意一個待測樣本均根據已篩選好的學習器集合來進行預測。動態選擇法是本文的研究重點,它是根據不同待測樣本的特點,從已有基學習器中動態挑選學習器進行預測,每個待測樣本對應的學習器集合一般是不同的[20]。選擇性集成預測算法的具體過程在算法1中給出。

算法1 選擇性集成預測算法

輸入: 訓練集Xtrain,測試集Xtest,基學習器個數T,評測方法M

輸出: 篩選出的學習器集合Tt

Step 1 初始化T=Φ

Step 2 for t=1 to T do

Step 2.1 采用抽樣方法從訓練集Xtrain中抽取樣本數據得到新的訓練集X′train

Step 2.2 訓練X′train得到基學習器,并將其加入到基學習器集合T中得到T={T1,T2,…,Tt}

Step 3 end for

Step 4 在測試集Xtest上對每個基學習器進行預測誤差測試,得到Err′

Step 5 根據得到的Err′利用評測方法M評價基學習器集合T中的每個子集,篩選出符合條件的學習器集合Tt

Step 6 采用結合策略集成學習器集合Tt,構建選擇性集成預測模型

2 基于近鄰的動態選擇性集成算法DSERP-KNN

本文利用選擇性集成具有更好的泛化能力和更低的預測開銷等優勢,提出一種基于近鄰的動態選擇性集成預測算法DSERP-KNN。該算法在傳統動態選擇策略的基礎上,考慮了樣本特征的重要性對預測結果的影響,引入特征重要度作為近鄰的相似性度量,以此找到待測樣本的最佳近鄰。通過近鄰樣本對不同學習器的性能評估進行選擇性集成,可以有效提高預測精度。

2.1 基于誤差擾動的特征權值度量

特征權值度量是指樣本特征之間的權值重要性度量,它是樣本中所有特征重要程度的體現。依據自助法重采樣會產生1/3始終未被抽取到的樣本數據的特點,通過計算這些數據的誤差可以得到相應特征的重要性權值度量,即加入輕微干擾后的精度與加入干擾前精度的平均減少量[21]。基于誤差擾動的特征權值度量算法的基本原理為若給某個特征引入噪聲干擾后導致誤差大幅增加,則說明該特征對于預測結果影響較大,重要程度較高,因此需保留。反之誤差若無明顯變化則說明該特征重要程度較低可考慮剔除。因此,算法首先要使用自助法重采樣抽取到樣本集,然后標記始終未抽取到的樣本并計算誤差,之后加入噪聲干擾并再次計算誤差,最后利用兩次的誤差結果計算出特征的權值度量。基于誤差擾動的特征權值度量算法的詳細過程見算法2。

算法2 基于誤差擾動的特征權值度量算法

輸入: 自助重采樣到的樣本s=1,2,…,S(S為樣本個數)

輸出: 特征Xi的權值度量

Step 1 選擇樣本數據s=1,2,…,S作為樣本集S

Step 2 在樣本集S上創建決策樹Ts,并將始終未被取到的數據標記為Ls

Step 3 對于每顆決策樹Ts,選擇相應Ls計算誤差,記作Err1

Step 4 隨機對Ls數據中的所有樣本的特征Xi,i=1,2,…,N(N為未被抽取到的數據總個數)加入噪聲擾動,再次計算誤差,記作Err2

Step 5 計算特征Xi的權值度量,

=1T∑(Err2-Err1)。(1)

2.2 樣本近鄰相似度量

2.2.1 主成分分析 主成分分析(principal component analysis,PCA)是一種以較少的特征為代表對樣本進行描述來降低維度的方法[22]。它的原理是將一個高維向量Xm×n通過一個特殊矩陣投影到低維空間中,最大限度地保留原始高維向量所包含的信息。它的主要方法為通過對協方差特征分解來提取主成分。

PCA的具體計算步驟分為4步[23]。首先,求出樣本均值,

=∑ni=1in。(2)

然后,計算Xm×n的協方差矩陣Q,

Q=∑mi=1(xi-m)(xi-m)T。? (3)

接著,計算協方差矩陣Q的特征值λ和特征向量μ,并將特征值從小到大進行排序,

λ=(λ1,λ2,…,λn),λ1≥λ2≥…≥λn,(4)

μ=(μ1,μ2,…,μn)。(5)

最后,計算特征向量在每一維上的投影矩陣αik,該投影矩陣則為該樣本空間的主成分。

αik=μkT(xi-m)。(6)

2.2.2 特征重要度加權相似度量 K近鄰算法(K-nearest neighbor,KNN)是一種經典的懶惰型學習,它省略了訓練過程,因此具有精度高,對異常值不敏感等優勢,目前在分類、回歸等問題中有較為成熟的應用[24]。其算法原理為基于某種相似性度量找出訓練集中與給定待測樣本最接近的k個近鄰樣本,并根據近鄰的信息做出預測[25]。當KNN算法用于回歸預測時,它將k個近鄰樣本的預測結果的平均值作為最終結果。

特征空間中樣本點之間的距離反映了其相似程度,而不同的相似度量方式會確定不同的近鄰點,從而影響預測準確性。相似性度量可以通過樣本間距離計算來實現,常用的距離度量方式有歐氏距離、馬氏距離等。然而這些傳統的距離度量往往存在對樣本的不同特征之間的差別等同對待的問題,并且傳統的空間變換方法如PCA、線性判別分析(LDA)也會忽視貢獻率小但含有樣本差異的重要信息的特征,從而產生不合理的相似性度量。為了篩選出對預測幫助最大的學習器集合,需要首先對樣本間的相似性做出合理度量,尋找到一個合適的近鄰,最終根據最佳近鄰選擇優秀的基學習器進行預測。本文以經典歐氏距離為基礎,依據特征重要度計算特征對預測的貢獻程度的權值,并賦予權重w,構建新的樣本近鄰相似度量函數,使其體現出相關特征的重要性。

n維空間中,樣本點a(xa1,xa2,…,xan)與點b(xb1,xb2,…,xbn)間的歐氏距離公式如式(7)所示,

dab=

(xa1-xb1)2+(xa2-xb2)2+…+(xan-xbn)2=

∑nk=1(xak-xbk)2。(7)

將式(1)中的特征權值作為權重w引入式(7)中,根據特征重要性對k個近鄰的貢獻進行加權,定義基于特征重要度加權的近鄰相似度量d′ab,

d′ab=

w1(xa1-xb1)2+w2(xa2-xb2)2+…+wn(xan-xbn)2=

∑nk=1wk(xak-xbk)2。(8)

其中,wk為權重,滿足

∑nk=1wk=1。(9)

2.3 基于樣本近鄰預測精度評估的動態選擇性集成預測

選擇性集成較普通集成相比,具有預測精度高、算法性能強等優勢,因此,為了從已生成的學習器集合中選擇出最適合待測樣本的子集,設計一種基于近鄰的動態選擇性集成算法進行預測。該算法基于之前定義好的近鄰相似性度量,運用k的自適應得到待測樣本的最佳近鄰,并以此評估具有預測精度差異的各學習器性能,擇優篩選出精度較高的學習器。通過近鄰樣本選中的學習器進行選擇性集成預測,可以有效克服全集成產生的計算量過大的問題,并能針對待測樣本的差異性動態選擇其適合的基學習器,既可以提高預測精度,又可以滿足預測性能的要求。

該算法的主要思想是利用樣本近鄰預測精度評估選擇基學習器。首先,使用訓練集Xtrain生成一定數量的CART樹作為基學習器集合,之后依據引入特征權值后定義的樣本近鄰相似度量,對每個待測樣本分別在k值的不同選取下尋找它的近鄰樣本,并對每個近鄰樣本均測試出所有CART樹的預測誤差集合;然后,對樹的預測精度設定一個容忍度閾值θ,剔除預測誤差小于θ的子CART樹,篩選余下的預測性能較好的子CART樹集合作為待測樣本的CART樹子集,并將選中的閾值范圍內的CART樹子集做并集,再使用學習法結合策略集成選出的子CART樹進行選擇性集成,并計算MSE;最后,比較k取不同值的預測精度評估情況,選擇MSE最小的k值作為最佳近鄰,并利用此近鄰對應的集合學習器對待測樣本進行預測,得到最終結果。基于樣本近鄰預測精度評估的動態選擇性集成預測算法詳細過程見算法3。

算法3 基于樣本近鄰預測精度評估的動態選擇性集成預測算法

輸入:訓練集Xtrain,待測樣本集Xpred,基學習器集合T={T1,T2,…,Tt},近鄰K,容忍度閾值θ∈[0,1],基于特征重要度加權的樣本近鄰相似性度量d′ab

輸出:最佳近鄰k,待測樣本的預測值集合Φ={yi}Xtesti=1

Step 1 利用訓練集Xtrain生成基學習器集合T

Step 2 初始化近鄰K

Step 3 k=K

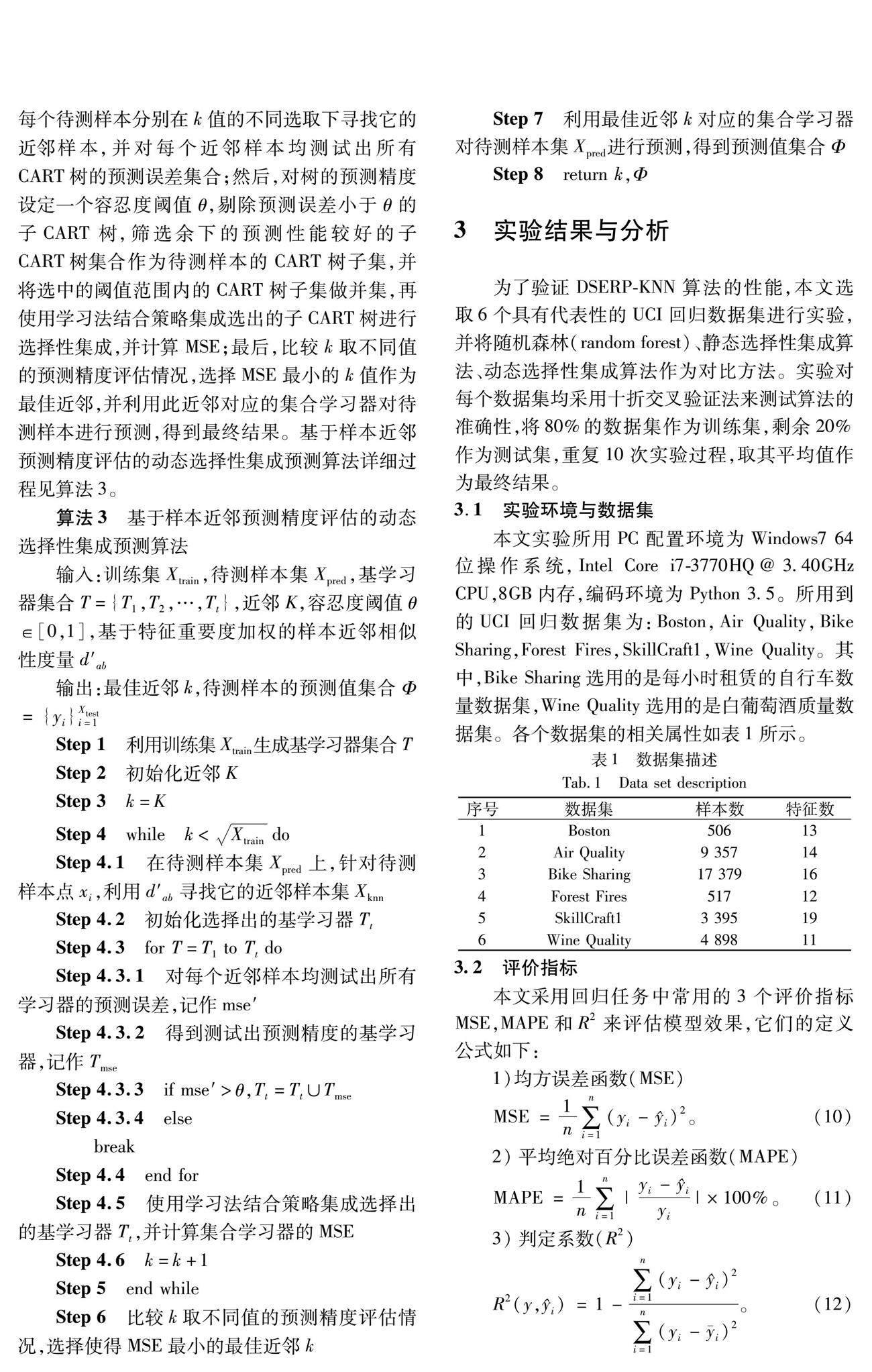

Step 4 while k Step 4.1 在待測樣本集Xpred上,針對待測樣本點xi,利用d′ab尋找它的近鄰樣本集Xknn Step 4.2 初始化選擇出的基學習器Tt Step 4.3 for T=T1 to Tt do Step 4.3.1 對每個近鄰樣本均測試出所有學習器的預測誤差,記作mse′ Step 4.3.2 得到測試出預測精度的基學習器,記作Tmse Step 4.3.3 if mse′>θ,Tt=Tt∪Tmse Step 4.3.4 else break Step 4.4 end for Step 4.5 使用學習法結合策略集成選擇出的基學習器Tt,并計算集合學習器的MSE Step 4.6 k=k+1 Step 5 end while Step 6 比較k取不同值的預測精度評估情況,選擇使得MSE最小的最佳近鄰k Step 7 利用最佳近鄰k對應的集合學習器對待測樣本集Xpred進行預測,得到預測值集合Φ Step 8 return k,Φ 3 實驗結果與分析 為了驗證DSERP-KNN算法的性能,本文選取6個具有代表性的UCI回歸數據集進行實驗,并將隨機森林(random forest)、靜態選擇性集成算法、動態選擇性集成算法作為對比方法。實驗對每個數據集均采用十折交叉驗證法來測試算法的準確性,將80%的數據集作為訓練集,剩余20%作為測試集,重復10次實驗過程,取其平均值作為最終結果。 3.1 實驗環境與數據集 本文實驗所用PC配置環境為Windows7 64位操作系統,Intel Core i7-3770HQ@3.40GHz CPU,8GB內存,編碼環境為Python 3.5。所用到的UCI回歸數據集為:Boston,Air Quality,Bike Sharing,Forest Fires,SkillCraft1,Wine Quality。其中,Bike Sharing選用的是每小時租賃的自行車數量數據集,Wine Quality選用的是白葡萄酒質量數據集。各個數據集的相關屬性如表1所示。 3.2 評價指標 本文采用回歸任務中常用的3個評價指標MSE,MAPE和R2來評估模型效果,它們的定義公式如下: 1)均方誤差函數(MSE) MSE=1n∑ni=1(yi-i)2。(10) 2)平均絕對百分比誤差函數(MAPE) MAPE=1n∑ni=1|yi-iyi|×100%。(11) 3)判定系數(R2) R2(y,i)=1-∑ni=1(yi-i)2∑ni=1(yi-i)2。(12) 其中:n表示樣本個數;yi為真實值;yi為預測值;i表示真實值的均值。MSE和MAPE的值越小表明真實值與預測值的誤差越小,模型預測越準確,R2的正常取值范圍為[0,1],越趨于1,表明模型的擬合效果越好。 3.3 不同算法對預測精度的影響 通過與其他3個方法的預測精度對比分析實驗,評價本文提出的DSERP-KNN算法。表2為DSERP-KNN算法與其他方法分別在6個數據集上R2值的對比結果,表3和表4為相應的MSE和MAPE值的對比結果。 實驗中首先針對不同數據集樣本特點訓練生成T個基學習器,然后按照DSERP-KNN算法流程依次尋找到每個待測樣本的前k個近鄰樣本,并在每個近鄰樣本上均測試各學習器的MSE值,選擇在容忍度閾值范圍內的學習器子集進行待測樣本的選擇性集成預測。為了進一步驗證DSERP-KNN算法的有效性,將隨機森林算法、靜態選擇法以及動態選擇法作為對比算法進行實驗分析。 從表2中可以明顯地看出,隨機森林算法在各數據集上的表現較差,而選擇后的集成學習效果均要優于全集成學習。靜態選擇性集成在各數據集上的精度都要低于動態選擇性集成,DSERP-KNN算法在各數據集上的結果均優于全集成學習算法和普通選擇性集成算法,R2值均有所提高。其中,在Wine Quality數據集上的提升效果最佳,約為5.0%。 此外,根據表3和表4的實驗結果表明,隨機森林算法在各數據集上的表現基本處于較低水平,而DSERP-KNN算法的MSE和MAPE值最低,具有良好的預測效果。其中,Bike Sharing數據集與其余數據集MSE值相差較大是因為每個數據集之間的方差大小存在較大差異性,因此,導致MSE的值也相差較大。通過表2、表3和表4分析可知,引入樣本近鄰相似度量后的動態選擇性集成算法能夠有效提高預測精度。 3.4 不同近鄰數目k對預測精度的影響 由于本文所提出的DSERP-KNN算法性能與k值的選擇密切相關,k值的變化會影響算法的預測效果。因此,本文詳細分析了在不同數據集上不同近鄰數目k對預測精度的影響,如圖1所示。 根據樣本數量及特征的不同,近鄰的范圍為1~40。通過具體分析可知,圖1(a),1(c),1(e)中近鄰k對MSE的影響波動總體較小,在達到MSE最小值之前曲線呈穩步下降趨勢,說明此時較少的近鄰樣本無法滿足預測的需要。隨著k取值的增大,DSERP-KNN算法精度迅速提高,分別在k=6,k=18以及k=11時,MSE達到最低值,此時預測效果最佳。當算法找到最佳近鄰后MSE值持續上升,說明近鄰樣本數目達到一定的值之后,再加入的近鄰會對算法預測性能造成干擾。因此,對于Boston,Bike Sharing和SkillCraft1數據集,k=6,k=18和k=11分別為它們的最佳近鄰。圖1(b),1(d),1(f)中,近鄰k對MSE的影響波動總體較大,在達到MSE最小值之前,曲線基本處于波動式下降趨勢,然后分別在k=13,k=7和k=7時MSE降到最低。之后圖1(b)基本呈現平穩上升,僅在k=23以后有一個短暫的波動。然而圖1(d)和1(f)的MSE值均出現較大波動,這可能是因為隨著近鄰數目的上升引入了一些無關近鄰,從而影響到了算法的預測效果。因此,對于Air Quality,Forest Fires和Wine Quality數據集,它們的最佳近鄰分別為k=13, k=7以及k=7。圖1中的實驗結果在一定程度上說明了針對不同特點的數據集,合適的近鄰數目k是通過自適應來選擇的。 3.5 不同近鄰相似度量對預測精度的影響 為了驗證本文算法中的相似度量方法的有效性,即基于特征重要度加權的相似度量(記作w-similarity measure),將歐氏距離度量(euclidean distance)、PCA度量作為對比方法,在各數據集上進行預測精度實驗分析。為了更加直觀地看出模型效果,采用R2作為評價指標,結果如圖2所示。 由圖2可以看到,歐式距離的表現有所欠缺,基本處于較低水平,在SkillCraft1數據集和Wine Quality數據集上尤為明顯。PCA度量對精度的影響要略優于歐式距離度量,說明維度的縮減可以降低數據復雜度,但也可能會損失掉有用信息。基于特征重要度加權的相似度量在6個數據集上的R2值均有小幅度提升,其中,Air Quality數據集的提升效果最為明顯。這說明了該相似度量方法具有更好的針對性,能充分考慮樣本特征的重要性程度,驗證了本文所采用的相似度量方式是有效的。 綜合以上3個實驗可以看出,本文提出的DSERP-KNN算法在回歸評價指標中均為最好,且達到了針對不同待測樣本,根據其近鄰樣本對各學習器的預測精度評估來動態篩選學習器的目的。同時還驗證了k的自適應性以及基于特征重要度加權的樣本近鄰相似度量方式的有效性,體現出算法具有較高的精度和較好的性能。 4 結 語 為了改善動態選擇策略中未充分考慮樣本特征的重要性,從而影響預測結果準確性的問題,提出了一種基于近鄰的動態選擇性集成預測算法。該算法基于特征重要度加權的樣本近鄰相似性度量,尋找待測樣本的最佳近鄰樣本,并根據樣本近鄰對學習器的預測精度評估篩選基學習器,進行選擇性集成預測。通過6個UCI數據集上的實驗結果表明,該算法相較于原有集成學習和常規選擇性集成,具有更好的預測效果和預測性能,這也為今后選擇策略的研究提供了一種新的思路。 另外,研究過程中也發現,盡管算法提高了預測精度,但是運行效率不夠理想,因此,下一階段的研究目標是進一步優化基學習器的選擇策略。 參考文獻: [1] HANSEN L K, SALAMON P. Neural network ensembles[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 12(10):993-1001. [2] WANG T J, ZHANG Z W, JING X Y, et al. Multiple kernel ensemble learning for software defect prediction[J]. Automated Software Engineering, 2016, 23(4):569-590. [3] CHEN P, HU S S, ZHANG J, et al. A sequence-based dynamic ensemble learning system for protein ligand-binding site prediction[J].Transactions on Computational Biology and Bioinformatics, 2016, 13(5):901-912. [4] ZHOU Z H, WU J X, TANG W. Ensembling neural networks: Many could be better than all [J].Artificial Intelligence, 2002, 137(1):239-263. [5] 張春霞, 張講社. 選擇性集成學習算法綜述 [J].計算機學報, 2011, 34(8):1399-1410. ZHANG C X,ZHANG J S. A survey of selective ensemble learning algorithms[J].Chinese Journal of Computers, 2011, 34(8):1399-1410. [6] ABRAHMS B, WELCH H, BRODIE S, et al. Dynamic ensemble models to predict distributions and anthropogenic risk exposure for highly mobile species[J]. Diversity and Distributions, 2019, 25(8):1182-1193. [7]MARKATOPOULOU F, TSOUMAKAS G, VLAHAVAS I.Dynamic ensemble pruning based on multi-label classification[J].Neurocomputing, 2015, 150:501-512. [8] MENG J, ZHANG J, LUAN Y S, et al. Parallel gene selection and dynamic ensemble pruning based on affinity propagation[J].Computers in Biology and Medicine, 2017, 87(8):8-21. [9] 李瑞. 基于聚類的動態集成選擇算法[J].計算機應用與軟件, 2014, 31(8):317-323. LI R. Dynamic ensemble selection algorithm based on clustering[J].Computer Applications and Software, 2014, 31(8):317-323. [10]XIAO J, XIAO Y, HUANG A Q, et al. Feature-selection-based dynamic transfer ensemble model for customer churn prediction[J]. Knowledge and? Information Systems, 2015, 43(1):29-51. [11]MLLER A B,BEUCHER A, IVERSEN B V, et al. Predicting artificially drained areas by means of a selective model ensemble[J]. Geoderma, 2018, 320:30-42. [12]OLIVERA D V R, CAVALCANTI G D C, PORPIONO T N,et al. K-nearest oracles borderline dynamic classifier ensemble selection[C]∥2018 International Joint Conference on Neural Networks(IJCNN).Rio de Janeiro:IEEE,2018:1-8. [13]DIDACI L, GIACINTO G.Dynamic classifier selection by adaptive k-nearest-neighbourhood rule[J].Multiple Classifier Systems, 2004:174-183. [14]CRUZ R M O, OLIVEIRA D V R, CAVALCANTI G D C, et al. FIRE-DES++:Enhanced online pruning of base classifiers for dynamic ensemble selection[J].Pattern Recognition, 2019, 85:149-160. [15]徐繼偉, 楊云. 集成學習方法:研究綜述[J].云南大學學報(自然科學版), 2018, 40(6):1082-1092. XU J W, YANG Y. A survey of ensemble learning approaches[J].Journal of Yunnan University(Natural Science Edition), 2018, 40(6):1082-1092. [16]BREIMAN L.Random forests[J].Machine Learning, 2001, 45(1):5-32. [17]WANG H Z, YANG F, LUO Z Y. An experimental study of the intrinsic stability of random forest variable importance measures[J].BMC Bioinformatics, 2016, 17(1):1-18. [18]ZHANG T L, XIA D H, TANG H S, et al. Classification of steel samples by laser-induced breakdown spectroscopy and random forest[J].Chemometrics and Intelligent Laboratory Systems, 2016, 157:196-201. [19]SHENG L W, ZHANG T L, NIU G H, et al. Classification of iron ores by laser-induced breakdown spectroscopy (LIBS) combined with random forest (RF)[J].Journal of Analytical Atomic Spectrometry,2015, 30(2):453-458. [20]LIN C, CHEN W Q, QIU C, et al. LibD3C: Ensemble classifiers with a clustering and dynamic selection strategy[J].Neurocomputing, 2014,123:424-435. [21]VERIKAS A, GELZINIS A, BACAUSKIENE M. Mining data with random forests: A survey and results of new tests[J].Pattern Recognition, 2011, 44(2):330-349. [22]ZHANG Q, PENG C, LU Y M, et al. Airborne electromagnetic data levelling using principal component analysis based on flight line difference[J].Journal of Applied Geophysics, 2018, 151:290-297. [23]李遠博, 曹菡. 基于PCA降維的協同過濾推薦算法[J].計算機技術與發展, 2016, 26(2):26-30. LI Y B, CAO H. Collaborative filtering recommendation algorithm based on PCA dimension reduction[J].Computer Technolocy and Development, 2016, 26(2):26-30. [24]劉鵬, 杜佳芝, 呂偉剛, 等. 面向不平衡數據集的一種改進的k-近鄰分類器[J].東北大學學報(自然科學版), 2019, 40(7):932-936. LIU P, DU J Z, LYU W G, et al. A modified KNN classifier for unbalanced dataset[J].Journal of Northeastern University(Natural Science Edition), 2019, 40(7):932-936. [25]LI C G, QIU Z Y, LIU C T. An Improved Weighted K-Nearest Neighbor Algorithm for Indoor Positioning[J].Wireless Personal Communications, 2017, 96(2):2239-2251. (編 輯 李 靜)