基于卷積神經網絡和膠囊神經網絡的宮頸病變圖像分類方法研究

宋丹 張育釗

摘? ?要:為了更好地治療宮頸癌,準確確定患者的宮頸類型是至關重要的。因此,用于檢測和劃分宮頸類型的自動化方法在該領域中具有重要的醫學應用。雖然深度卷積神經網絡和傳統的機器學習方法在宮頸病變圖像分類方面已經取得了良好的效果,但它們無法充分利用圖像和圖像標簽的某些關鍵特征之間的長期依賴關系。為了解決這個問題,文章引入了膠囊網絡(CapsNet),將CNN和CapsNet結合起來,以提出CNN-CapsNet框架,該框架可以加深對圖像內容的理解,學習圖像的結構化特征,并開展醫學圖像分析中大數據的端到端訓練。特別是,文章應用遷移學習方法將在ImageNet數據集上預先訓練的權重參數傳輸到CNN部分,并采用自定義損失函數,以便網絡能夠更快地訓練和收斂,并具有更準確的權重參數。實驗結果表明,與ResNet和InceptionV3等其他CNN模型相比,文章提出的網絡模型在宮頸病變圖像分類方面更加準確、有效。

關鍵詞:宮頸癌;卷積神經網絡;膠囊神經網絡;遷移學習

研究表明,宮頸病變圖像的分類預測對于宮頸癌癥診斷具有重要的意義,準確預測宮頸病變類型可以輔助醫生判斷患者的病情,制定更有針對性的治療方案,從而有助于提高癌癥患者的治療質量[1-2]。現有的宮頸病變圖像分類預測方法大多局限于使用卷積神經網絡,尚無使用膠囊神經網絡的細胞分類預測研究。因此,本研究提出了一個基于膠囊神經網絡的方法CNN-CapsNet,對宮頸病變圖像進行分類預測。首先,對人工神經網絡、卷積神經網絡和膠囊神經網絡等神經網絡模型進行介紹;其次,對CNN-CapsNet算法進行詳細的說明和闡述;再次,評估了CNN-CapsNet算法在宮頸病變圖像分類預測中的性能;最后,通過與其他預測方法進行比較,對實驗結果進行分析。

1? ? 膠囊神經網絡

膠囊神經網絡是由國外學者于2017年在神經信息處理系統大會(Conference and Workshop on Neural Information Processing Systems,NIPS)上提出的,其核心思想是使用膠囊來代替卷積神經網絡中的神經元,使網絡可以保留對象之間詳細的姿態信息和空間層級關系。膠囊神經網絡彌補了卷積神經網絡的缺陷。例如,在有相對位置的情況下,一旦卷積核檢測到了類似于眼睛、鼻子、嘴巴這種特征,卷積神經網絡將圖像分類到人臉這一類。同時,一張非人臉圖像雖然包含了眼睛、鼻子、嘴巴,但卷積神經網絡也將它歸于人臉。

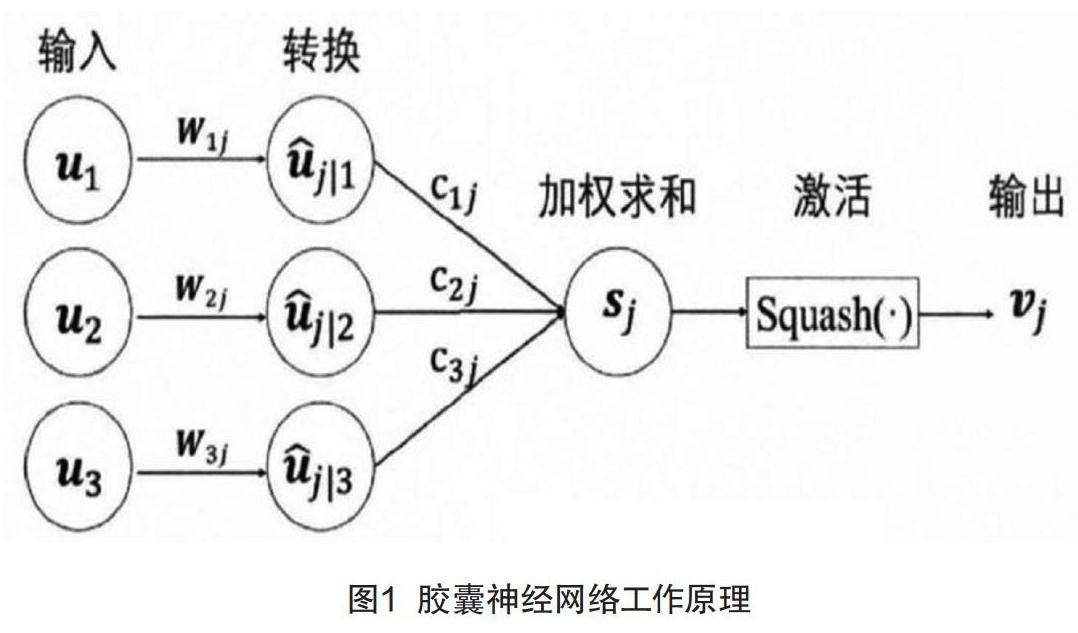

膠囊神經網絡的工作原理如圖1所示,都需要經過加權求和與非線性激活步驟,但是相比于神經元,膠囊需要一個額外的轉換步驟,目的是在網絡中考慮對象間的空間和層級關系。

2? ? 膠囊神經網絡結構

一個簡單的CapsNet網絡只用到了一層膠囊,但是也很好地展現了CapsNet的工作原理,如圖2所示。

(1)Capsule神經網絡算法:動態路由算法。

(2)Capsule特性:一個向量神經元可包含任意個值,每個值代表了當前需要識別的物體的一個特征。(加權求和結果為標量)這個向量不僅可表示物體的特征,還可以表示物體的相對位置關系等。

(3)分類原理:用向量模的大小衡量某個實體出現的概率,模值越大,概率越大。

(4)分類依據:Digit Caps中一共3個向量,每個向量中元素的個數為16。對這3個向量求模,求得模值最大的那個向量代表的就是圖片概率最大的分類。

網絡的輸入為宮頸病變圖像數據,該數據來自于福建省婦幼保健醫院,作為訓練數據對網絡進行訓練。宮頸病變圖像數據共分為3個類型,包括CIN1,CIN2和CIN3,圖像的尺寸為256×256像素。CNN-CapsNet方法的網絡結構為一個4層的結構,包括了2個卷積層和2個膠囊層,相比于原始膠囊神經網絡,具有更深的網絡結構,因此可以提取出更高層的宮頸病變圖像語義信息,有助于圖像的分類預測。除此之外,網絡中還具有一個重構部分,為一個3層全連接層結構,由膠囊層的膠囊值為輸入,實現對輸入圖像的重構,以增加網絡的魯棒性。

3? ? 實驗結果與分析

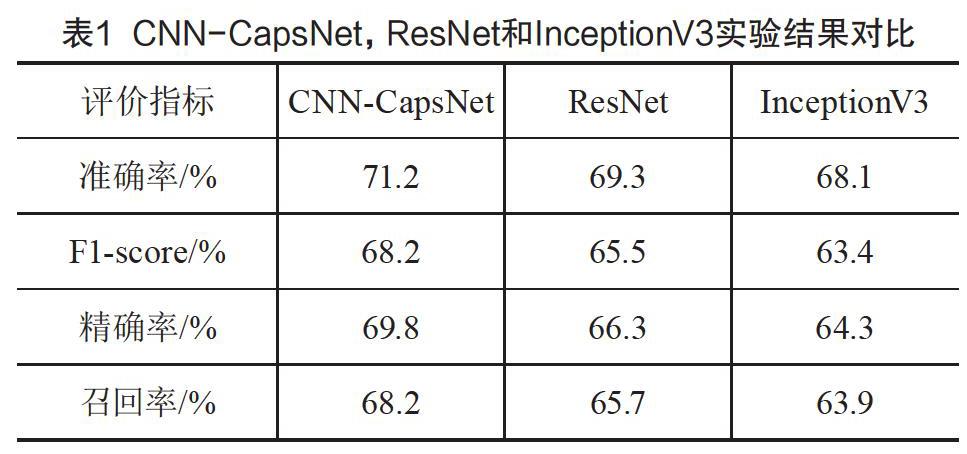

本實驗是基于深度學習框架Keras,在NVIDIA RTX2070下進行的,在圖形處理器(Graphics Processing Unit,GPU)下進行訓練,實驗效率相對于中央處理器(Central Processing Unit,CPU)要高很多,經過多次實驗調整訓練參數,CNN-CapsNet,ResNet[3]和InceptionV3[4-5]實驗結果對比如表1所示。

最后利用CNN-CapsNet訓練階段學習到的模型搭建一個簡易的宮頸病變圖像分類系統,該系統使用python編程語言和keras + flask框架,對上傳的宮頸病變圖像進行預測。將預測的過程作為一個Web服務,實現在網頁上上傳一張宮頸病變的圖像,然后返回預測結果,給出分類級別供醫生參考,輔助醫生診斷,考慮到陰道鏡醫生在長期閱讀陰道鏡圖像時容易疲憊,從而導致不必要的漏判、誤判,而系統在這方面具備優勢。系統操作界面如圖3所示。

4? ? 結語

通過對膠囊神經網絡的網絡結構及其參數進行調整與優化,提出了一個基于膠囊神經網絡的宮頸病變圖像分類預測方法CNN-CapsNet,用于宮頸病變圖像的分類任務。為了評估該方法在宮頸病變圖像中的性能,使用宮頸病變圖像數據集,對CNN-CapsNet方與ResNet和InceptionV3等其他CNN模型進行比較,發現CNN-CapsNet均取得了最佳的預測性能,此外,搭建簡易的宮頸病變圖像分類系統,展示了其在細宮頸病變圖像預測中的有效性與實用性。

[參考文獻]

[1]VACCARELLA S,LORTET T J,PLUMMER M,et al.Worldwide trends in cervical cancer incidence: impact of screening against changes in disease risk factors[J].European Journal of Cancer,2013(15):3262-3273.

[2]CHEN W,ZHENG R,BAADE P,et al.Cancer statistics in China, 2015[J].CA-A Cancer Journal for Clinicians,2016(2):115-132.

[3]KAIMING H,XIANGYU Z,SHAOQING R,et al.Deep residual learning for image recognition[C].Las Vegas:2016 IEEE Conference on Computer Vision and Pattern Recognition,2015.

[4]SZEGEDY C,VANHOUCKE V,IOFFE S,et al.Rethinking the inception architecture for computer vision[J].CoRR,2015(2):1512.

[5]SABOUR S,FROSST N,HINTON G E.Dynamic rounting between capsules[J].Advances in Neural Information Processing Systems,2017(10):3856-3866.

Research on image classification of cervical lesions based on

convolution neural network and capsule neural network

Song Dan1, 2, Zhang Yuzhao1, 2*

(1.College of Technology, Huaqiao University, Quanzhou 362021, China;

2.Fujian University Engineering Research Center of Industrial Intelligent Technology and System, Quanzhou 362021, China)

Abstract:In order to better treat cervical cancer, it is very important to accurately determine the cervical type of patients. Therefore, the automatic methods for detecting and classifying cervical types have important medical applications in this field. Although deep convolution neural network (CNN) and traditional machine learning methods have achieved good results in cervical lesions image classification, they can not make full use of the long-term dependence between some key features of image and image tag. To solve this problem, the CapsNet is introduced. Specifically, this paper combines CNN and CapsNet to propose the CNN-CapsNet framework, which can deepen the understanding of image content, learn the structural features of images, and carry out end-to-end training of big data in medical image analysis. In particular, this paper uses the migration learning method to transfer the weight parameters trained in advance on the Imagenet dataset to CNN, and use the custom loss function, so that our network can train and converge faster and have more accurate weight parameters. The experimental results show that compared with other CNN models such as ResNet and inception V3, our network model is more accurate and effective in cervical lesions image classification.

Key words:cervical cancer; convolution neural network; capsule neural network; migration learning