一種結合深度特征的人體運動序列追蹤模型

蔣宇 袁健

摘 要:目前主流的判別式目標跟蹤模型大多使用灰度、顏色等手工特征,在目標快速移動或受到視頻序列背景等因素干擾情況下,目標跟蹤器可能在跟蹤目標時學習到錯誤特征而導致跟蹤失敗。因此,提出一種結合深度特征的相關濾波跟蹤算法。首先將待跟蹤目標圖像輸入至卷積神經網絡中,提取出較高層的卷積特征,然后將提取的卷積特征輸入相關濾波器中得到響應,最后根據響應峰值得到追蹤結果。以VOT2016中包含人體運動的視頻序列為實驗數據集,并分別與CN、SAMF及KPDCF模型進行對比。實驗結果表明,結合深度特征的相關濾波算法具有較好的追蹤性能,在不大幅降低追蹤速度的情況下,提升了追蹤精度和穩定性。

關鍵詞:手工特征;相關濾波器;深度特征;目標追蹤;卷積神經網絡;人體運動序列

DOI: 10. 11907/rjdk.191379

開放科學(資源服務)標識碼(OSID):

中圖分類號:TP303

文獻標識碼:A

文章編號:1672-7800(2020)001-0089-06

0 引言

在人體運動序列中,需要追蹤的目標通常有著較大形變,且視頻序列背景可能有較多變化,所以在單目標跟蹤過程中需要選取出比較有區分度,且有著較低計算量的特征,才能更好地滿足單目標追蹤的實時性與高精度要求。如今,由于單目標跟蹤對實時性的要求越來越高,因此相關濾波算法在該領域十分流行,但是濾波跟蹤是基于先驗訓練模板的,一旦出現追蹤目標本身形變較大,或因運動過快而發生變形的情況,相關濾波算法產生的訓練模板很可能在后續的幀序列中匹配不一致,從而導致追蹤目標丟失或追蹤錯誤的情況。隨著機器學習技術的迅速發展,深度卷積神經網絡在視覺追蹤領域的應用也越來越廣。一般而言,構建的卷積神經網絡層數越多,提取的高層特征將包含更多語義信息以及定位目標的結構化信息,卷積神經網絡的應用效果也會越顯著。例如2014年提出的G oogLeNet與2015年提出的ResNet,這些深層次網絡采用大量圖片數據集進行訓練,被成功應用于圖像處理各相關領域。但是卷積神經網絡需要進行大量計算,直接使用卷積神經網絡進行分類追蹤,難以實現目標實時追蹤。因此,本文結合卷積神經網絡的抽象特征與相關濾波跟蹤算法,提出一種基于深度卷積特征的相關濾波跟蹤模型。實驗結果表明,該模型應用于人體運動序列追蹤速度較快,且有著較高精度。

目標追蹤是計算機圖像處理領域一個非常重要的研究方向,有著十分廣泛的應用場景。早期研究基本上都在歐美等發達國家,比如早在1980年代,Horn等[1]提出將光流法用于對計算機視頻中目標的追蹤與識別。光流計算實際上是一種通過檢測圖像像素點強度隨時間的變化情況,進而推斷出物體移動速度及方向的方法,如2001年Sidenbladh[2]通過光流信息表征運動特征,G onzalez[3]使用KLT特征,Btadski&Davisa1[4]采用運動梯度信息對運動特征進行表述。但這些基于光流法的研究缺陷在于當個體被遮擋時,提取運動信息會變得極其困難且誤差較大,追蹤精度也很低。因此,傳統光流計算在目標運動邊界被遮擋、背景干擾強的情況下,遠遠達不到對于目標追蹤精度和速度的要求。之后,出現了粒子濾波算法[5]與一些基于卡爾曼濾波[6]及其相關改進方法。隨著計算機技術的飛速發展,針對目標追蹤的研究逐漸演變為一個計算機視覺的目標識別檢測問題。2010年,Bolme等[7]第一次將相關濾波應用于目標追蹤領域,并構建了一個自適應的相關濾波器,稱為MOSSE濾波器。MOSSE濾波器對視頻第一幀中的追蹤目標建模,然后對視頻序列的每一幀,利用提取到的目標特征檢測幀圖像,以最小輸出平方誤差作為新的目標位置,并且不斷調整建模目標。MOSSE濾波器可通過快速傅立葉變換使大量計算轉換到頻域,從而加快追蹤速度;Henriques等[8]隨后提出一種基于核函數映射的相關濾波器,該濾波器將待追蹤目標的外觀通過核函數映射至特征空間,然后通過最小二乘作分類,從而提升了追蹤精度。但是該核相關濾波器只提取了目標灰度特征,也存在著追蹤丟失的可能性。

隨著人工智能技術的不斷發展,卷積神經網絡開始被應用于圖像處理領域,并在計算機視覺方面取得了很好的效果,在目標追蹤領域更是有著突破性進展。如Wang等[9]首次將卷積神經網絡運用于目標追蹤領域,利用預訓練的神經網絡挖掘目標深度特征,然后通過在追蹤時不斷調整神經網絡實現對目標的追蹤。神經網絡解決了追蹤時訓練樣本規模較小的問題,但在追蹤速度上低于基于相關濾波器的追蹤算法。然而,將神經網絡應用于目標追蹤領域,并在追蹤時不斷調整網絡的思想為后續深度學習在目標追蹤方面的應用打下了基礎。

2015年左右,深度學習在目標追蹤領域得到了大量應用。如Nam等[10]提出一種多域網絡,該模型基于預訓練的卷積神經網絡(CNN),使用大量視頻預先跟蹤CNN,并跟蹤視頻實況獲得通用目標表示。神經網絡由共享層與域特定層的多個分支組成,其中域對應于各個訓練序列,并且每個分支負責二進制分類以識別每個域中的目標。然后,迭代地針對每個域訓練網絡,以獲得共享層中的通用目標表示。當在新序列中跟蹤目標時,將預訓練CNN中的共享層與新的二進制分類層(在線更新)組合構建新網絡;M artin等[11-12]提出將SRDCF用于目標追蹤領域,使用循環矩陣解決了計算損失函數時的邊界效應問題,通過引入懲罰因子提高追蹤精度,但速度相比傳統相關濾波模型大幅降低,之后又提出一種改進的D-SRDCF模型,通過結合手工特征與CN特征,進一步提高了精度,但是速度又進一步降低。這些研究大都將目光聚焦在經過大數據集預訓練后的卷積神經網絡,但神經網絡存在計算耗時較長的問題,因而目標追蹤速度無法得到保證。

國內也在很早前就開始了目標跟蹤相關領域研究,早在1986年,我國就有部分學者對計算機視覺追蹤技術進行研究,并取得了一定成果,如徐博文等[13]提出的結合關鍵點跟蹤的尺度自適應相關濾波模型,候建華等[14]提出的基于在線學習判別性外觀模型的多目標跟蹤模型等。

綜上所述,基于相關濾波的目標追蹤通常在實時性方面表現出明顯的優越性,而基于深度學習的模型通常在準確性方面有著較好表現。本文根據目標追蹤領域發展趨勢,結合相關濾波算法與深度學習理論,基于預訓練卷積神經網絡提出一種結合深度特征的相關濾波追蹤算法模型,并將其應用于人體運動序列追蹤中。

1 相關濾波目標跟蹤模型

相關性是指兩個信號之間的關系,有互相關與自相關兩種,相關濾波便是建立在此基礎之上。對于給定的兩個離散信號Sigl和Sig2,其相關性可以描述為式(1)。

其中的*表示信號的共軛,其中m和n表示位移變量。相關性即相似程度,如果信號之間的相似程度高,則其相關性也高。所以在基于相關濾波的目標追蹤中,主要是提取追蹤目標在候選區域的特征,并將其與計算生成的濾波器作相關操作,得到相關濾波響應峰圖(空域置信圖)。響應峰圖中峰值坐標就是追蹤目標在圖像中的位置坐標,下面將詳細推導該過程。令一個數字圖像f和一個濾波器h進行相關操作后,得到輸出g,如式(2)所示。

g=f〇h

(2)

式(2)表明,得到的濾波響應值受到h(濾波器模板)的影響,因此目標追蹤問題就變為尋找濾波器模板的問題。式(2)中的〇表示卷積操作,卷積操作計算量較大,因此相關濾波跟蹤算法中通常將卷積操作通過快速傅立葉變換轉換到頻域中進行,從而減少計算量,提高追蹤效率。若將快速傅立葉變換表示為F,則式(2)可以表示為式(3)。

F(g)=F(f〇h)=F(h)。F(h)*(3)

G =F。H*

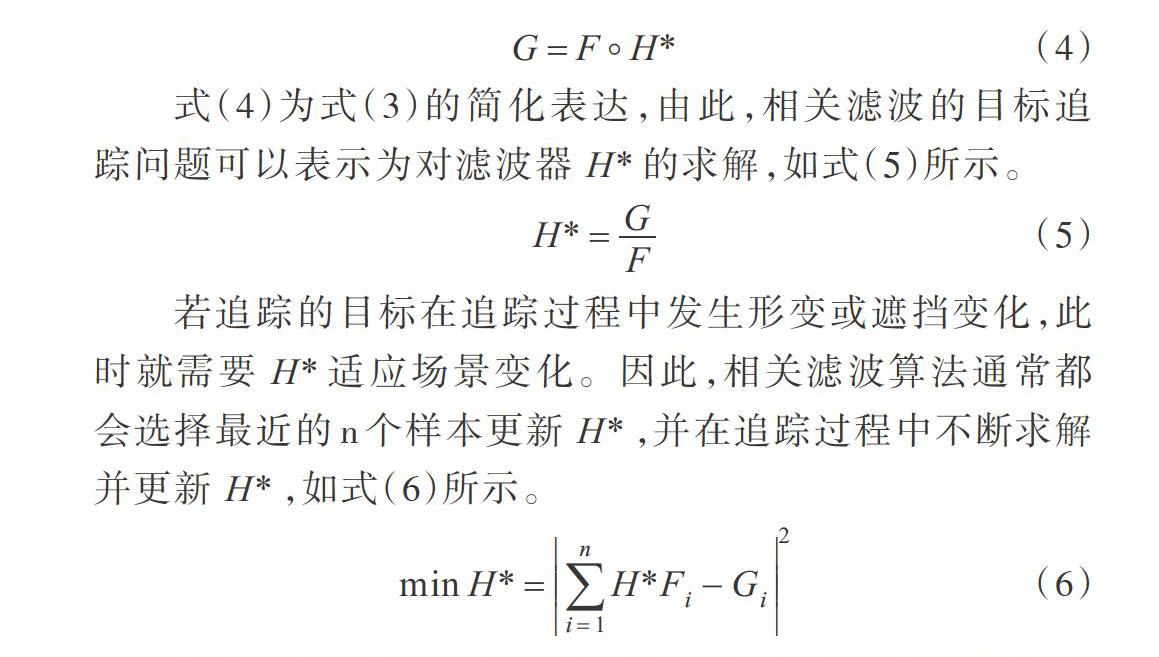

(4) 式(4)為式(3)的簡化表達,由此,相關濾波的目標追琮問題可以表示為對濾波器H*的求解,如式(5)所示。

H*=G/F/

(5) 若追蹤的目標在追蹤過程中發生形變或遮擋變化,此時就需要H*適應場景變化。因此,相關濾波算法通常都會選擇最近的n個樣本更新H*,并在追蹤過程中不斷求解并更新H*,如式(6)所示。

其中i表示第i個輸入樣例。將濾波器H*與追蹤目標特征集合進行相關計算,可以得到濾波響應峰圖,取峰圖中的峰值作為追蹤目標位置。因此,追蹤目標特征提取是相關濾波算法中很重要的組成部分,特征提取質量將直接關系到追蹤效果。相關濾波追蹤模型如圖1所示。

2 結合深度特征的相關濾波目標跟蹤算法

2.1 預訓練卷積神經網絡

目前有一些開源的已經過預訓練的圖像分類網絡,本部分算法模型將基于這些預訓練網絡提取深度特征,并將從這些網絡中提取的深度特征應用于相關濾波器,用于對目標進行追蹤。VGG[15]卷積神經網絡(簡稱為VCGNet)是Visual Geometry Group實驗室基于大規模分類數據庫Ima-geNet[16]訓練出來的卷積神經網絡模型。ImageNet是一個圖片數據庫,所有圖片已通過人工手動標注好類別,共有22 000個類別,是目前世界上最大的圖像識別數據庫。經過該數據庫訓練出的VGGNet網絡模型對除此之外的其它數據集具有很強的泛化能力。另外,VGCNet網絡模型還具有較強的遷移能力。

VCCNet模型結構十分簡潔,在目標追蹤領域大部分采用16或19層網絡結構(分別稱為VGC16和VCG19)。本文選擇19層網絡結構作為實驗的卷積神經網絡,包括16個卷積層與3個全連接層。前幾層采用3x3結構的卷積核作卷積操作,每個卷積層后面均有一個激活層。后幾層為池化層,池化層的卷積核為2x2。網絡最后有3個全連接層和一個soft- max層。

2.2 深度特征結合相關濾波器

上文討論了使用相關濾波解決目標追蹤問題,并將目標追蹤問題轉換成求解濾波器H*的問題。然而,在實際計算中,計算機都是針對圖像中每個像素點進行操作的,所以式(6)可以具體表示為式(7)。

其中u、v是單個像素元素對應矩陣H中的下標。要想使差平方和最小,此時只需對每個元素求得的偏導值為0即可,如式(8)所示。

在視頻序列開始時,通過手工對視頻第一幀中已標注好的目標位置進行特征提取,計算初始化相關濾波器模板。在具體實現時,對視頻序列的第一幀圖像進行隨機放射變換,產生n個訓練樣本,將樣本進行高斯函數輸出得到響應峰圖,響應峰圖中的峰值則是追蹤目標的中心位置,便可求得該相關濾波器模板。為了提高該相關濾波器的魯棒性,使其能夠應對復雜場景,如光照急劇變化或相似背景干擾等,對相關濾波器模板采用如下更新機制,如式(11)-(13)所示。

其中的Ai、Bi是由當前視頻幀計算得出的,而Ai-1、Bi-1,是由上一視頻幀計算得出的,η表示該相關濾波模板學習率。因此,之前視頻幀與當前視頻幀都會對濾波器模板訓練產生影響,但是當前幀的影響更大。

相關濾波算法將用于本章提出的模型在線學習部分中,下面說明如何使用濾波器進行追蹤。基本思路為:由初始給定的追蹤目標外觀,學習生成一個判別相關濾波器(簡稱DCF),在追蹤目標的待檢測圖片中,DCF會對其中的追蹤目標輸出相關響應峰值,由此實現對追蹤目標在待檢測圖片中的定位。相關濾波運算可以在頻域通過快速傅立葉變換實現,因此相關濾波有著較高的實時性。

首先,在視頻序列的初始幀中指定追蹤目標位置信息,然后根據指定的追蹤目標圖像提取追蹤目標特征集合,訓練得出DCF,在視頻序列的后續每幀圖像中,從前一幀由相關濾波輸出的追蹤目標位置中提取追蹤目標圖像特征,實現相關濾波的更新。以第t幀為例:①此時已知t-l幀時追蹤目標的位置信息D,在第t幀中提取出位置D的圖像;②對得到的圖像進行特征提取,作相關濾波運算,得到相關濾波響應峰圖(空域置信圖);③響應峰圖中的峰值位置即是第t幀中追蹤目標的位置;④將得到的第t幀追蹤目標位置作為第t幀的輸出,再依據位置信息更新相關濾波器。

下面構建基于深度特征的相關濾波實時追蹤模型(Deep Feature DCF,以下簡稱DFDCF)。模型主要流程如下:

首先,確定序列首幀中手工標注好的追蹤目標區域,將該區域圖像輸入VCG19網絡(已預訓練好的卷積神經網絡)中,提取出卷積層中第16層特征,根據式(10)計算出相應濾波模板;然后,對序列中的每一幀后續圖像,采用式(11)提出的更新規則更新濾波模板,由上一視頻幀的輸出結果(第一幀輸出結果即為手工標注結果)確定當前幀的位置提取信息,將當前幀提取的圖像再次輸入至VCG19網絡中。由于高層卷積特征有著追蹤目標的語義信息,所以選取( conv16)卷積層特征作為當前特征,與新濾波模板作用得出濾波響應;最終,將響應峰值作為當前追蹤結果。模型流程如圖2所示。

3 實驗與分析

3.1 數據集與實驗環境

VOT( Visual Object Tracking)[17]是一個針對單目標跟蹤的測試數據集,從2013年發展至今,已成為單目標跟蹤領域主流的3大平臺之一。作為一個測試數據集,VOT有著十分豐富的測試數據,本文只選取其中的人體運動視頻序列作為實驗數據,包括singerl、singer2、godfather等共24個視頻序列。

本實驗中利用已訓練好的VCC19提取目標區域特征,具體采用19層網絡中的第16層卷積特征,其中式(12)與式(13)中的學習率η值為0.02。從追蹤的實驗數據集VOT2017中篩選出人體運動序列數據集,其中的初始幀目標位置已知。

3.2 評估指標

為了驗證本文跟蹤算法的性能,結合VOT以及傳統追蹤指標,使用如下評價指標作為本文算法模型評價指標:

(1)每秒傳輸幀數(Frames Per Second,FPS)。定義為跟蹤視頻總耗時T與視頻總幀數F的商值,如式(14)所示。

FPS=T/F

(14)

(2)精確度(Accuracy)[18]。用來評價追蹤算法追蹤目標的準確度,數值越大,準確度越高。其借用了IoU( Inter-section-over-Union,交并比)定義,某人體運動序列第t幀的準確率定義如式(15)所示。

3.3 結果對比分析

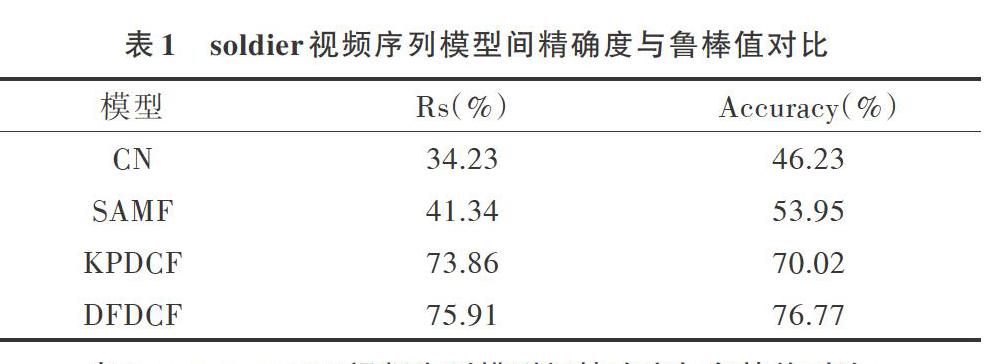

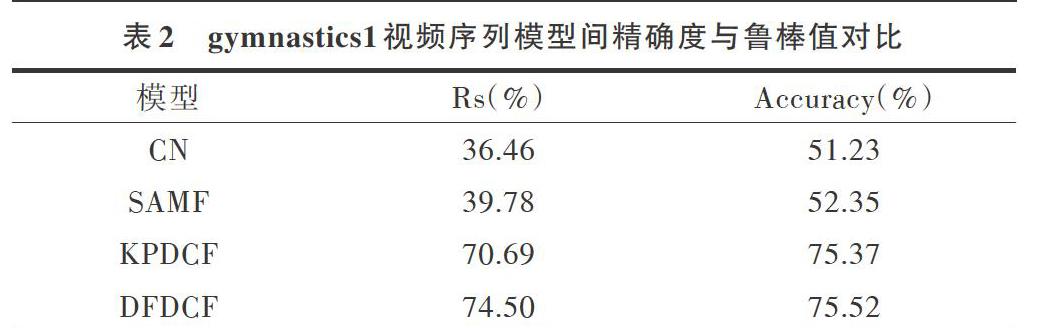

本文實驗采用文獻[13]中提出的結合關鍵點的跟蹤算法(簡稱KPDCF)、CN[19]、SAMF[20]進行實驗結果對比。實驗圖集如圖3所示。

由圖3可以看出,不同算法模型在視頻序列每一幀的追蹤結果都不相同,但是VOT數據集中標注的真實目標位置只有一個,因此不同算法的準確率也不同。當然,不同模型的跟蹤速度也不同,圖4展示了KPDCF、CN、SAMF與本文提出模型在速度上的對比實驗結果。

由圖4可以看出,最為簡單的CN模型跟蹤速度最快,達到了90fps多,但這是在犧牲追蹤精度的情況下達到的,本文提出的DFDCF模型跟蹤速度排名第二。KPDCF由于考慮了多尺度自適應問題,提高了算法的時間復雜度,因此速度較慢,而SAMF模型在跟蹤速度方面表現最差。

圖5展示了在singerl視頻序列下4個模型的精確度與魯棒值對比,在singerl視頻序列中,光線變化較為強烈,背景干擾性強。可以看到,在20次實驗中,本文提出的DFD-CF不論是平均準確度還是平均Rs值,在4個算法中都是最高的,雖然與KPDCF的性能差距不大,但在以上的FPS結果對比中,DFDCF相比KPDCF領先了約20fps。CN模型雖然在FPS對比中大幅領先,但其追蹤精度和魯棒值都遠達不到要求。事實上,在針對其它人體運動視頻序列的實驗結果中,DFDCF的平均精度與魯棒值都有著較好表現,具體數據如表1一表3所示。

4 結語

本文研究了人體運動序列的目標追蹤問題,首先介紹了傳統基于相關濾波的目標追蹤算法,指出其手工特征選擇部分在追蹤目標形變較大或受到外界環境因素干擾情況下,可能導致追蹤目標失敗,然后提出一種結合深度特征的相關濾波追蹤模型,使用預訓練的卷積神經網絡獲取目標特征,并將得到的深度卷積特征用作相關濾波器的特征提取部分,相關濾波器則作為運動序列的在線目標追蹤部分。實驗結果表明,本文提出的基于深度特征的相關濾波追蹤模型在人體運動序列追蹤領域有著良好性能,在與其它模型對比時,在每秒傳輸幀數、準確率和魯棒值方面都表現較好。然而,現有目標追蹤算法在追蹤速度與追蹤準確率方面很難做到兩者兼顧,后續研究將聚焦如何在不大幅降低追蹤準確率的情況下,進一步提高追蹤速度。

參考文獻

[1]HORN B K P, SCHUNCK B G. Determining optical flow[J]. ArtificialIntelligence, 1981 , 17( 1-3) : 185-204.

[2]BOBICK A F, DAVIS J W. The recognition of human movement usingtemporal templates [J]. Pattern Analysis & Machine IntelligenceIEEE Transactions on , 2001 .23( 3) : 257-267.

[3]COMANICIU D. RAMESH V, MEER P. Kernel-based object track-ing [J]. Pattern Analysis & Machine Intelligence, 2003, 25 (5) :564-575.

[4] ZHAO T, NEVATIA R. Tracking multiple humans in crowded envi-ronment [ C ]. Proceedings of the 2004 IEEE Computer Society Confer-ence on Computer Vision and Pattern Recognition, 2004.