面向遷移學(xué)習(xí)的意圖識(shí)別研究進(jìn)展*

趙鵬飛,李艷玲,林 民

內(nèi)蒙古師范大學(xué) 計(jì)算機(jī)科學(xué)技術(shù)學(xué)院,呼和浩特 010022

1 引言

對(duì)話系統(tǒng)主要由語(yǔ)音識(shí)別(automatic speech recog-nition,ASR)、口語(yǔ)理解(spoken language understanding,SLU)、對(duì)話管理(dialog management,DM)、對(duì)話生成(dialogue generation,DG)以及語(yǔ)音合成(text to speech,TTS)五部分組成[1]。口語(yǔ)理解在整個(gè)對(duì)話過程中尤為關(guān)鍵[1],主要由領(lǐng)域意圖識(shí)別(domain intent detection,DID)、意圖識(shí)別(intent detection,ID)和語(yǔ)義槽填充(slot filling,SF)三部分組成。領(lǐng)域意圖識(shí)別主要分析用戶意圖所屬領(lǐng)域,比如音樂、電影和電視節(jié)目等,而意圖識(shí)別主要分析理解輸入語(yǔ)句中用戶話語(yǔ)行為,如查詢音樂或預(yù)訂電影票等,通過對(duì)領(lǐng)域意圖識(shí)別的分析,并進(jìn)行更加細(xì)化的意圖識(shí)別和語(yǔ)義槽填充任務(wù),共同完成理解用戶輸入句子的任務(wù)[2]。

面向特定領(lǐng)域的任務(wù)型對(duì)話系統(tǒng)中,主要解決特定領(lǐng)域任務(wù),其輸入文本具有主題明確、意圖鮮明等特點(diǎn),比如查詢天氣、預(yù)訂酒店等對(duì)話系統(tǒng)。任務(wù)型對(duì)話系統(tǒng)中,意圖識(shí)別的準(zhǔn)確性將直接影響口語(yǔ)理解質(zhì)量以及對(duì)話系統(tǒng)性能[3],且因其可以為限定領(lǐng)域的對(duì)話系統(tǒng)擴(kuò)展領(lǐng)域而處于非常重要的地位。目前,研究人員利用深度神經(jīng)網(wǎng)絡(luò)算法對(duì)分類模型的研究取得了豐碩的成果。Zhang等人[4]提出一種基于雙向門控循環(huán)單元和條件隨機(jī)場(chǎng)的意圖識(shí)別模型,該方法利用聯(lián)合模型解決意圖識(shí)別和語(yǔ)義槽填充任務(wù),實(shí)驗(yàn)結(jié)果表明,聯(lián)合模型優(yōu)于獨(dú)立模型,為探究聯(lián)合模型解決問題提供了新的方向。深度學(xué)習(xí)利用大量標(biāo)注數(shù)據(jù)訓(xùn)練模型,通常隨著數(shù)據(jù)量的增加模型的性能以及準(zhǔn)確性都會(huì)逐步提升。然而,諸如預(yù)訂火車票、預(yù)訂賓館等限定領(lǐng)域訓(xùn)練語(yǔ)料相對(duì)較少,醫(yī)學(xué)領(lǐng)域、生物領(lǐng)域數(shù)據(jù)更是匱乏。如何利用現(xiàn)有領(lǐng)域的數(shù)據(jù)和模型,構(gòu)建具有少量標(biāo)注數(shù)據(jù)的新領(lǐng)域?qū)υ捪到y(tǒng)是當(dāng)前研究的重點(diǎn)。目前,遷移學(xué)習(xí)能夠利用相似任務(wù)領(lǐng)域的已有大量標(biāo)注數(shù)據(jù)進(jìn)行模型的預(yù)訓(xùn)練,通過對(duì)模型架構(gòu)與參數(shù)的調(diào)整,使其應(yīng)用到少量標(biāo)注數(shù)據(jù)領(lǐng)域中,并取得良好的效果。遷移學(xué)習(xí)在只含有少量標(biāo)注數(shù)據(jù)任務(wù)中表現(xiàn)出色,受到越來(lái)越多研究人員的關(guān)注,將其應(yīng)用于意圖識(shí)別問題中是未來(lái)研究的熱點(diǎn)問題。

本文首先對(duì)意圖識(shí)別問題進(jìn)行了概述,闡明意圖識(shí)別問題的發(fā)展及其本質(zhì),并著重介紹了意圖識(shí)別問題的方法以及未來(lái)發(fā)展所存在的問題和解決思路;其次對(duì)目前解決意圖識(shí)別所面臨問題的遷移學(xué)習(xí)進(jìn)行介紹,簡(jiǎn)單概述了其背景及應(yīng)用,并著重介紹了遷移學(xué)習(xí)的主要技術(shù)和當(dāng)前其面臨的問題和難點(diǎn);最后對(duì)深度學(xué)習(xí)模型和遷移學(xué)習(xí)模型的評(píng)價(jià)標(biāo)準(zhǔn)進(jìn)行簡(jiǎn)單概括,并對(duì)意圖識(shí)別在遷移學(xué)習(xí)上的研究進(jìn)行展望。

2 意圖識(shí)別介紹

2.1 意圖識(shí)別的形成與發(fā)展

意圖識(shí)別是隨著人機(jī)對(duì)話系統(tǒng)的發(fā)展逐漸形成的。2012年,蘋果公司首先發(fā)布一款名為Siri的私人手機(jī)助理,其支持自然語(yǔ)音輸入,可以幫助用戶撥打電話、讀取短信、查詢天氣以及制定日程安排等。Siri的誕生為人機(jī)口語(yǔ)對(duì)話系統(tǒng)的應(yīng)用前景指明了方向。2014 年3 月Google 推出了一款應(yīng)用Google Now,2014年4月Microsoft推出了Cortana,這兩款語(yǔ)音助手與Siri有相似之處,區(qū)別主要在于它們可以為用戶提供更加全面的實(shí)時(shí)信息搜索和個(gè)性化的服務(wù)。可以這樣說(shuō),未來(lái)幾十年是人機(jī)對(duì)話系統(tǒng)發(fā)展的巔峰時(shí)代。當(dāng)前人機(jī)對(duì)話系統(tǒng)分為兩類:開放領(lǐng)域的對(duì)話系統(tǒng)和任務(wù)驅(qū)動(dòng)的對(duì)話系統(tǒng)。開放領(lǐng)域的對(duì)話系統(tǒng)不限制用戶的對(duì)話主題,目的是將聊天進(jìn)行下去。任務(wù)驅(qū)動(dòng)的對(duì)話系統(tǒng)在于通過對(duì)話解決某個(gè)特定任務(wù)領(lǐng)域的問題。而在這兩類對(duì)話系統(tǒng)中,意圖識(shí)別是其關(guān)鍵所在,其準(zhǔn)確性將直接影響口語(yǔ)理解質(zhì)量以及對(duì)話系統(tǒng)性能。

隨著深度學(xué)習(xí)技術(shù)的逐漸成熟,不僅促進(jìn)了意圖識(shí)別的發(fā)展,同時(shí)也取得了一些豐碩的成果。Liu等人[5]提出一種基于注意力機(jī)制的循環(huán)神經(jīng)網(wǎng)絡(luò)用于解決意圖識(shí)別,上述模型在ATIS 數(shù)據(jù)集上表現(xiàn)良好。Yao等人[6]提出一種基于圖卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行文本分類,通過對(duì)詞共現(xiàn)和文檔詞關(guān)系建立一個(gè)語(yǔ)料文本圖,利用語(yǔ)料文本訓(xùn)練圖神經(jīng)網(wǎng)絡(luò)模型,該模型在多個(gè)分類任務(wù)的Benchmark 數(shù)據(jù)集上取得了良好的效果,圖神經(jīng)網(wǎng)絡(luò)為解決意圖識(shí)別任務(wù)提供了一個(gè)新的研究方向。Google公司[7]提出一種基于Trans-former的編碼器表示模型,通過預(yù)訓(xùn)練對(duì)文本數(shù)據(jù)進(jìn)行特征提取,利用遷移學(xué)習(xí)的思想將預(yù)訓(xùn)練模型進(jìn)行微調(diào)并將其應(yīng)用到目標(biāo)任務(wù)中,實(shí)驗(yàn)結(jié)果表明,該方法在意圖識(shí)別、情感分類、文本分類任務(wù)中取得了良好的性能。由此可以看到深度學(xué)習(xí)技術(shù)的發(fā)展推動(dòng)了意圖識(shí)別任務(wù)的發(fā)展,使得意圖識(shí)別的準(zhǔn)確性得到了大幅的提高。

2.2 意圖識(shí)別的本質(zhì)

口語(yǔ)理解是人機(jī)對(duì)話系統(tǒng)的重要部分,主要由領(lǐng)域意圖識(shí)別(DID)、意圖識(shí)別(ID)和語(yǔ)義槽填充(SF)三部分組成。其中,領(lǐng)域意圖識(shí)別主要分析用戶意圖所屬領(lǐng)域,比如音樂、電影和電視節(jié)目等,其本質(zhì)屬于分類問題;意圖識(shí)別主要分析理解輸入語(yǔ)句中用戶話語(yǔ)行為,如查詢音樂或預(yù)訂電影票等,其本質(zhì)屬于分類問題;語(yǔ)義槽填充解決特定領(lǐng)域關(guān)鍵詞以及屬性的標(biāo)注問題,其本質(zhì)屬于序列標(biāo)注問題;口語(yǔ)理解主要是在領(lǐng)域意圖識(shí)別分析的基礎(chǔ)上,再進(jìn)行更加細(xì)化的意圖識(shí)別和語(yǔ)義槽填充任務(wù),利用領(lǐng)域意圖識(shí)別、意圖識(shí)別和語(yǔ)義槽填充共同完成理解用戶輸入句子的任務(wù)[2]。

2.3 意圖識(shí)別的相關(guān)領(lǐng)域研究

隨著卷積神經(jīng)網(wǎng)絡(luò)(convolution neural networks,CNN)和循環(huán)神經(jīng)網(wǎng)絡(luò)(recurrent neural networks,RNN)在各個(gè)領(lǐng)域的應(yīng)用,口語(yǔ)理解的性能也取得極大提升。目前口語(yǔ)理解任務(wù)的最好性能基本由CNN和RNN及其變種所壟斷。神經(jīng)網(wǎng)絡(luò)在解決意圖識(shí)別任務(wù)時(shí),免去了機(jī)器學(xué)習(xí)人工提取特征的繁瑣步驟,通過神經(jīng)網(wǎng)絡(luò)框架自動(dòng)獲取文本特征信息,在解決語(yǔ)義信息缺失問題中,取得了良好的效果。Kim等人[8]利用語(yǔ)義詞匯(如WordNet[9])信息豐富的詞向量,提高對(duì)意圖文本語(yǔ)義信息的獲取能力,進(jìn)而提升意圖識(shí)別的準(zhǔn)確率。Devlin 等人[7]提出一種BERT(bidi-rectional encoder representation from transformers,BERT)語(yǔ)言模型,該模型進(jìn)一步增加詞向量的泛化能力,充分描述詞級(jí)、句級(jí)關(guān)系特征,利用雙向Trans-formers 編碼實(shí)現(xiàn)上下文相關(guān),并通過遮蔽語(yǔ)言模型(masked language model,MLM)和下一句預(yù)測(cè)(next sentence prediction,NSP)兩種方法捕捉詞級(jí)和句級(jí)的特征表示,使得詞向量包含更加深層次特征信息,從而提升意圖識(shí)別準(zhǔn)確性。目前,深度學(xué)習(xí)技術(shù)在意圖識(shí)別任務(wù)上已經(jīng)取得了良好的效果。

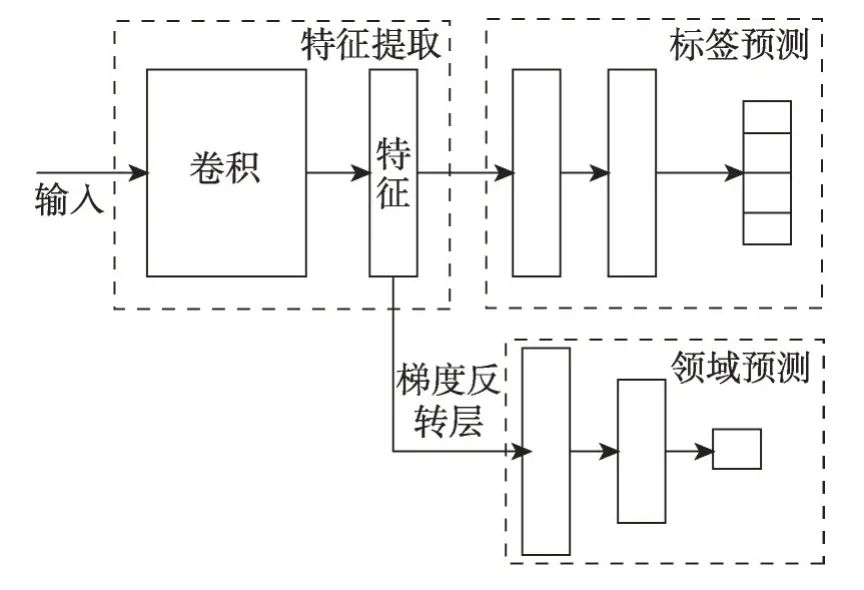

2.3.1 意圖識(shí)別

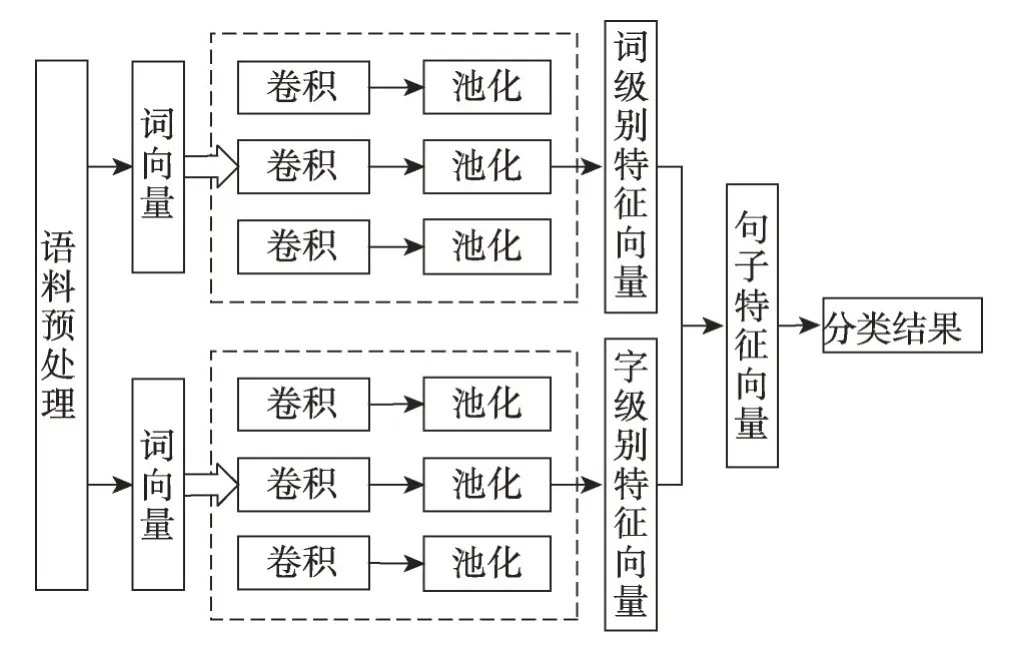

意圖識(shí)別主要指單意圖識(shí)別。意圖識(shí)別過程中,用戶的輸入文本信息只存在一種意圖種類。例如用戶輸入“預(yù)訂北京到上海的火車票”,其意圖類別為“預(yù)訂火車票”。侯麗仙等人[10]針對(duì)意圖識(shí)別問題以及語(yǔ)義槽填充任務(wù),提出一種增加門控機(jī)制、注意力機(jī)制以及條件隨機(jī)場(chǎng)約束條件的雙向長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)的方法,該方法在航空信息領(lǐng)域數(shù)據(jù)集上的意圖識(shí)別準(zhǔn)確率為93.20%,可見將意圖識(shí)別和語(yǔ)義槽填充任務(wù)聯(lián)合識(shí)別的方法能在一定程度上提升意圖識(shí)別的準(zhǔn)確率。楊志明等人[11]針對(duì)用戶輸入句子長(zhǎng)度短、單一卷積神經(jīng)網(wǎng)絡(luò)不能充分學(xué)習(xí)到句子的特征信息和語(yǔ)義信息等問題,提出一種雙通道卷積神經(jīng)網(wǎng)絡(luò)算法。兩個(gè)通道分別傳入字級(jí)別詞向量和詞級(jí)別詞向量,利用字級(jí)別詞向量輔助詞級(jí)別詞向量捕捉更深層次的語(yǔ)義信息。模型結(jié)構(gòu)如圖1所示,該算法通過對(duì)句子進(jìn)行字級(jí)以及詞級(jí)編碼獲得句子的分布式表示并結(jié)合預(yù)訓(xùn)練詞向量得到模型的輸入。

假設(shè)句子的長(zhǎng)度為n,詞向量的維度為k,Xi代表句子中的第i個(gè)詞。卷積層中,采用不同尺寸卷積核提取深層次語(yǔ)義信息,句子n進(jìn)行卷積計(jì)算后,獲得n-k+1個(gè)輸出并通過多次操作生成特征圖。

Y=Yk1,Yk2,…,Yk,n-k+1

利用池化操作,實(shí)現(xiàn)最具代表性特征的捕捉以及數(shù)據(jù)的降維,避免過擬合。該模型利用最大池化(max-pooling)對(duì)每個(gè)通道進(jìn)行池化操作。在合并層,將兩個(gè)通道獲取的特征進(jìn)行組合,并將其輸入給softmax 函數(shù),其輸出結(jié)果為意圖的預(yù)測(cè)值,如式(1)所示:

Fig.1 Structure diagram of dual-channel convolutional neural network圖1 雙通道卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)圖

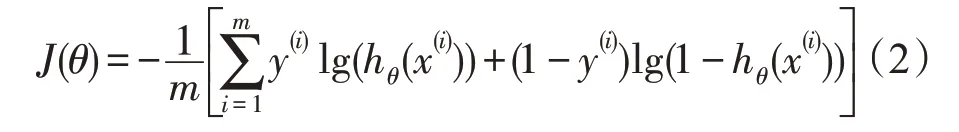

其中,hθ(x(i))代表第i個(gè)樣本的預(yù)測(cè)結(jié)果。模型整體使用多值交叉熵代價(jià)函數(shù)用于衡量模型損失,損失函數(shù)如式(2)所示:

2.3.2 多意圖識(shí)別

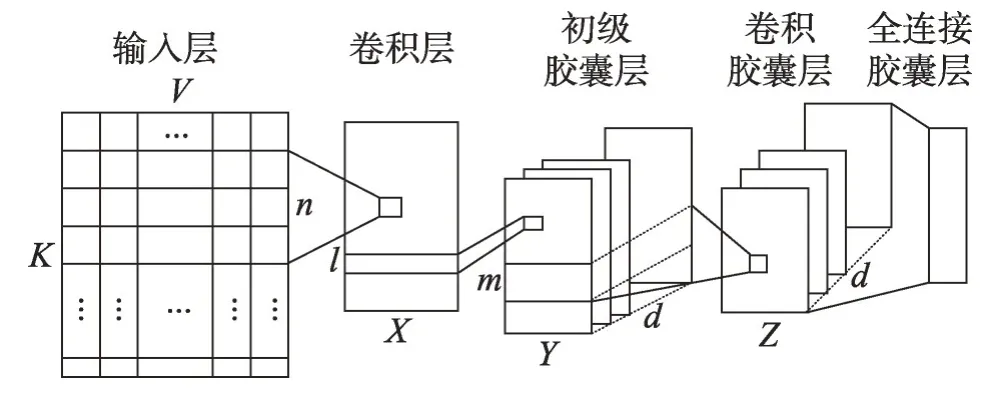

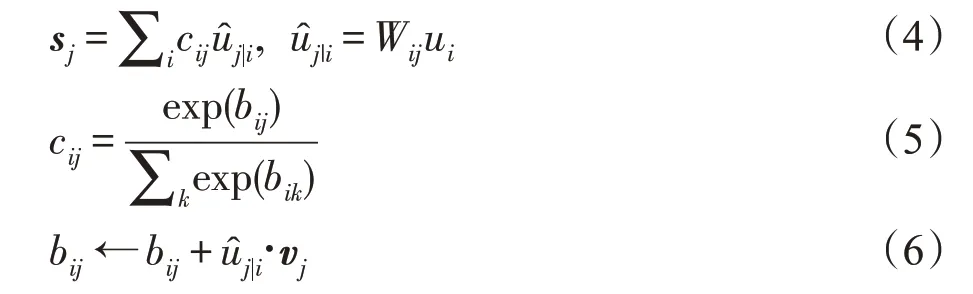

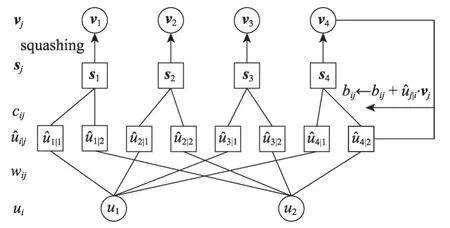

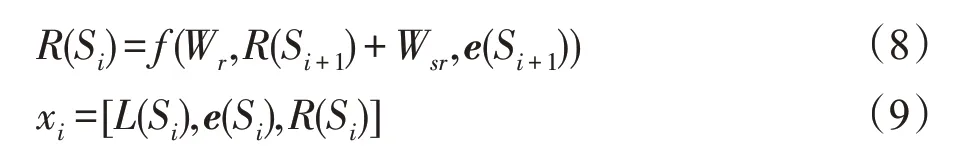

多意圖識(shí)別是指用戶的輸入文本信息中不僅包括一種意圖類別,有可能包括多種意圖種類。例如用戶輸入“預(yù)訂北京到上海的火車票并查詢上海的天氣狀況”,其意圖類別為“預(yù)訂火車票、查詢天氣”。楊志明等人[12]針對(duì)多輪對(duì)話中可能存在的多意圖識(shí)別問題,提出一種深度學(xué)習(xí)算法以解決多意圖問題,通過自然語(yǔ)言處理對(duì)用戶輸入進(jìn)行處理,并提取關(guān)鍵詞,利用深度學(xué)習(xí)提取上下文語(yǔ)境和語(yǔ)義信息用來(lái)識(shí)別用戶意圖,該方法在二分類以及多分類的意圖識(shí)別準(zhǔn)確率分別為94.81%和93.49%。楊春妮等人[13]針對(duì)短文本特征提取困難的問題以及可能存在的多意圖問題,提出一種結(jié)合句法分析和詞頻逆文檔頻率的卷積神經(jīng)網(wǎng)絡(luò),通過句法分析和詞頻逆文檔頻率確定文本是否包含多意圖以及意圖個(gè)數(shù),其次利用卷積神經(jīng)網(wǎng)絡(luò)對(duì)短文本進(jìn)行特征提取并進(jìn)行意圖識(shí)別,該方法在多意圖識(shí)別中的準(zhǔn)確率具有一定的提升。利用卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行自然語(yǔ)言處理通常會(huì)采用最大池化選取特征[14],導(dǎo)致句子的某些關(guān)鍵特征和位置信息丟失。針對(duì)這一問題,Hinton 等人[14]提出一種基于CNN 的膠囊網(wǎng)絡(luò),膠囊網(wǎng)絡(luò)是一組包含多個(gè)關(guān)鍵特征信息的神經(jīng)元,包含位置信息、方向信息等。Zhao 等人[15]將其應(yīng)用于文本分類,利用動(dòng)態(tài)路由算法提升模型的性能,實(shí)驗(yàn)驗(yàn)證了其有效性,且準(zhǔn)確率、F1值均優(yōu)于CNN。劉嬌等人[16]針對(duì)用戶輸入文本可能存在多意圖問題以及用戶輸入的短文本信息特征提取困難問題,提出一種基于膠囊網(wǎng)絡(luò)的多意圖分類模型,該模型在中英文數(shù)據(jù)集上的F1值為94.7%,較傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)有一定的提升。該膠囊網(wǎng)絡(luò)包括卷積層、初級(jí)膠囊層、卷積膠囊層和全連接膠囊層,膠囊網(wǎng)絡(luò)結(jié)構(gòu)如圖2所示。

Fig.2 Structure diagram of capsule neural network圖2 膠囊網(wǎng)絡(luò)結(jié)構(gòu)圖

假定輸入文本S∈RK×V。卷積層中,利用卷積核對(duì)輸入文本進(jìn)行卷積操作。為了獲取文本的多種語(yǔ)義信息,重復(fù)X次卷積操作后獲得特征圖X,維度為。在初級(jí)膠囊層中,為了獲取包含多重信息的特征表示,聚合特征圖X中的多個(gè)特征信息,采用d個(gè)卷積核且重復(fù)卷積Y次,獲得膠囊單元,每個(gè)膠囊中包含多種信息,維度為。卷積膠囊層中,采用d個(gè)卷積核w∈對(duì)每個(gè)膠囊進(jìn)行卷積操作,重復(fù)Z次操作獲得卷積膠囊,得到L-n-m+2 個(gè)d維膠囊。利用卷積膠囊對(duì)膠囊單元進(jìn)行全連接,膠囊向量的模長(zhǎng)代表其意圖概率。

在初級(jí)膠囊層和卷積膠囊層中利用動(dòng)態(tài)路由算法獲得最優(yōu)輸出膠囊向量,將低層膠囊通過權(quán)重分配到相應(yīng)的高層膠囊,利用高層膠囊模長(zhǎng)的概率對(duì)意圖進(jìn)行識(shí)別。為了輸出膠囊向量模長(zhǎng)的計(jì)算并完成激活,使用squashing 非線性函數(shù)確保向量的模長(zhǎng)概率保持在0-1之間,非線性激活函數(shù)如式(3)所示。

其中,vj是膠囊j的輸出向量,即卷積膠囊的輸出向量,sj是上層膠囊輸出到當(dāng)前膠囊j的向量加權(quán)和,即卷積膠囊的輸入向量加權(quán)和。式(3)包括兩部分,前一部分是輸入向量sj的縮放,第二部分是輸入向量sj的單位向量。膠囊的輸入向量計(jì)算分為兩階段,即線性組合和動(dòng)態(tài)路由。線性組合指利用上一層膠囊單元與對(duì)應(yīng)權(quán)重相乘獲得預(yù)測(cè)向量,動(dòng)態(tài)路由指通過耦合系數(shù)使預(yù)測(cè)向量獲得最優(yōu)的膠囊輸入向量。輸入向量如式(4)所示:

Fig.3 Structure diagram of capsule conversion圖3 膠囊間轉(zhuǎn)換結(jié)構(gòu)圖

表1[16]為膠囊網(wǎng)絡(luò)模型與其他模型在同一數(shù)據(jù)集下準(zhǔn)確率比較,普通膠囊網(wǎng)絡(luò)相較于傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)在準(zhǔn)確率方面都有較大的提升,F(xiàn)1值提升了30.4 個(gè)百分點(diǎn),召回率提升了39.1 個(gè)百分點(diǎn),而增加卷積膠囊層的膠囊網(wǎng)絡(luò)較普通膠囊網(wǎng)絡(luò)也有一定提升,其中F1值提升了9.2個(gè)百分點(diǎn),召回率提升了8.1個(gè)百分點(diǎn),可以看出,普通膠囊網(wǎng)絡(luò)能夠很好地體現(xiàn)其模型優(yōu)勢(shì),在文本信息的特征提取中起到了非常重要的作用,而增加卷積膠囊層的膠囊網(wǎng)絡(luò)能夠獲取到文本信息的深層語(yǔ)義信息并利用動(dòng)態(tài)路由提升模型的性能。在未來(lái)利用深度遷移學(xué)習(xí)解決訓(xùn)練數(shù)據(jù)稀缺的新領(lǐng)域意圖識(shí)別的研究中,可以在一定程度上利用膠囊網(wǎng)絡(luò)代替卷積神經(jīng)網(wǎng)絡(luò)解決文本信息獲取特征的功能。

Table 1 Model accuracy under the same data set表1 同一數(shù)據(jù)集下模型準(zhǔn)確率 %

2.3.3 相關(guān)領(lǐng)域模型

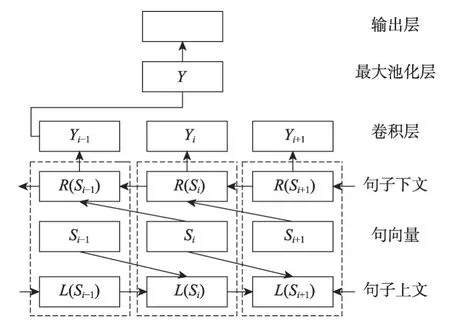

RNN 通常用于處理序列文本,其變體門控循環(huán)單元(gated recurrent unit,GRU)和長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(long-short term memory,LSTM)廣泛應(yīng)用于自然語(yǔ)言處理中,在意圖識(shí)別中也取得了良好的效果。李云紅等人[17]針對(duì)循環(huán)神經(jīng)網(wǎng)絡(luò)出現(xiàn)梯度爆炸或梯度消失問題以及長(zhǎng)文本序列因遠(yuǎn)距離依賴導(dǎo)致無(wú)法學(xué)習(xí)到上下文語(yǔ)序特征的問題,提出一種基于雙向門控循環(huán)單元和卷積神經(jīng)網(wǎng)絡(luò)(bidirectional gated recur-rent unit and convolutional neural network,BGRU-CNN)的混合模型。針對(duì)長(zhǎng)文本的語(yǔ)序語(yǔ)義信息的特征獲取,其算法采用了PV-DM(distributed memory model of paragraph vectors)神經(jīng)網(wǎng)絡(luò)模型進(jìn)行句向量訓(xùn)練。BGRU-CNN混合模型結(jié)構(gòu)如圖4所示。

Fig.4 Convolutional neural network with bidirectional gated recurrent unit圖4 雙向門控循環(huán)單元的卷積神經(jīng)網(wǎng)絡(luò)

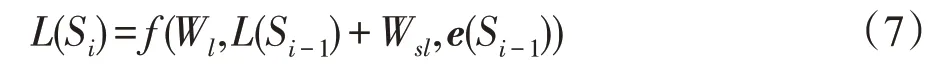

圖4 中,虛線框內(nèi)表示一個(gè)循環(huán)單元,用于獲取第i個(gè)句子Si的上文信息L(Si)和下文信息R(Si),如式(7)、式(8)所示,將上文信息、下文信息以及句向量拼接成文本特征向量,從循環(huán)層輸出進(jìn)入卷積層。如式(9)所示:

其中,W為權(quán)重參數(shù),Si-1為第i-1 個(gè)句子,e(Si-1)、e(Si+1)為句子Si-1和Si+1的句向量,L(Si)和L(Si-1)為句子Si和句子Si-1的上文信息,R(Si)和R(Si+1)為句子Si和句子Si+1的下文信息。

卷積層的作用是進(jìn)行特征提取,將卷積層的輸入進(jìn)行加權(quán)求和并通過偏置項(xiàng)獲得全部的特征表示。通過不同尺寸卷積核提取深層特征,并進(jìn)行多次卷積操作構(gòu)建特征圖,使用最大池化操作確定文本的最佳特征并將其輸入到softmax 函數(shù),根據(jù)其輸出進(jìn)行類別預(yù)測(cè)。該文本分類模型在SogouC和THUnews 數(shù)據(jù)集的文本分類準(zhǔn)確率分別達(dá)到了89.87%和84.65%,驗(yàn)證了該模型的可靠性并為意圖識(shí)別任務(wù)提供了方法。

2.4 深度學(xué)習(xí)在解決意圖識(shí)別中存在的問題

目前,口語(yǔ)理解中的意圖識(shí)別多數(shù)針對(duì)單一領(lǐng)域進(jìn)行研究,比如旅游交通領(lǐng)域等,意圖識(shí)別準(zhǔn)確率在深度神經(jīng)網(wǎng)絡(luò)的發(fā)展過程中也得到了巨大的提升。實(shí)際上,開發(fā)多個(gè)限定領(lǐng)域的對(duì)話系統(tǒng)需求在不斷增加,而需要開發(fā)的新領(lǐng)域短時(shí)間無(wú)法獲得大量數(shù)據(jù)。眾所周知,深度學(xué)習(xí)模型的訓(xùn)練存在兩個(gè)前提:(1)所需訓(xùn)練樣本數(shù)量足夠大;(2)訓(xùn)練數(shù)據(jù)和測(cè)試數(shù)據(jù)需保持在相同分布的特征空間[18]。而在預(yù)訂火車票、飛機(jī)票等領(lǐng)域樣本數(shù)據(jù)相對(duì)較少,而且無(wú)法滿足訓(xùn)練數(shù)據(jù)和測(cè)試數(shù)據(jù)保持在相同分布的條件,深度學(xué)習(xí)模型也無(wú)法由較少的訓(xùn)練樣本完成對(duì)模型性能的提升。如何利用現(xiàn)有標(biāo)注數(shù)據(jù)以及網(wǎng)絡(luò)模型,構(gòu)建一套只有少量標(biāo)注數(shù)據(jù)的新領(lǐng)域的對(duì)話系統(tǒng)成為當(dāng)前研究的重要方向。近年來(lái),人們對(duì)遷移學(xué)習(xí)的研究越來(lái)越多,其在解決數(shù)據(jù)稀缺領(lǐng)域中表現(xiàn)出了良好的效果,利用遷移學(xué)習(xí)解決類似預(yù)訂火車票、飛機(jī)票等數(shù)據(jù)稀缺領(lǐng)域的意圖識(shí)別是未來(lái)研究的重點(diǎn)。

3 遷移學(xué)習(xí)

3.1 遷移學(xué)習(xí)背景及應(yīng)用

隨著數(shù)據(jù)時(shí)代的到來(lái),機(jī)器學(xué)習(xí)和深度學(xué)習(xí)迎來(lái)了更加廣闊的發(fā)展,其已經(jīng)應(yīng)用在許多實(shí)際工作和學(xué)習(xí)中。眾所周知,機(jī)器學(xué)習(xí)和深度學(xué)習(xí)能夠利用訓(xùn)練數(shù)據(jù)提取其深層次信息特征,通過對(duì)信息的特征學(xué)習(xí),能夠預(yù)測(cè)信息的未來(lái)發(fā)展方向和趨勢(shì)。而傳統(tǒng)的機(jī)器學(xué)習(xí)和深度學(xué)習(xí)具有很重要的前提條件,即訓(xùn)練數(shù)據(jù)和測(cè)試數(shù)據(jù)要具有相同的數(shù)據(jù)分布,而在實(shí)際情況中,獲取具有相同數(shù)據(jù)分布是非常困難且耗費(fèi)財(cái)力的[19]。雖然半監(jiān)督學(xué)習(xí)能夠利用少量的標(biāo)記數(shù)據(jù)和未標(biāo)記數(shù)據(jù)訓(xùn)練模型,然而訓(xùn)練的模型往往性能較低。遷移學(xué)習(xí)是解決上述問題的一個(gè)有效途徑,其能夠?qū)⒃从驍?shù)據(jù)的知識(shí)和信息最大化地遷移到目標(biāo)域中,解決目標(biāo)域數(shù)據(jù)稀缺的問題,訓(xùn)練出用于解決目標(biāo)域問題的模型[20]。如何構(gòu)造用于解決實(shí)際問題的遷移學(xué)習(xí)模型是當(dāng)前研究的熱點(diǎn)問題。

近年來(lái),遷移學(xué)習(xí)得到了廣泛的關(guān)注,利用遷移學(xué)習(xí)解決問題的研究也越來(lái)越多。Cao 等人[21]利用條件對(duì)抗的自訓(xùn)練遷移學(xué)習(xí)方法,通過bert模型在源域數(shù)據(jù)集上進(jìn)行模型的微調(diào)并利用置信度過濾,在目標(biāo)域中生成偽標(biāo)簽數(shù)據(jù)進(jìn)行自我訓(xùn)練,通過該方法能夠減少領(lǐng)域間分布差異,且在多個(gè)數(shù)據(jù)集上表現(xiàn)出良好的性能。Li 等人[22]利用模型遷移的方法將普通話訓(xùn)練的神經(jīng)網(wǎng)絡(luò)遷移到廣東話的模型訓(xùn)練中,模型在廣東話識(shí)別的結(jié)果中,取得了有效的結(jié)果。Tarcar 等人[23]利用自然語(yǔ)言處理中的命名實(shí)體識(shí)別任務(wù)模型及方法,利用遷移學(xué)習(xí)將其應(yīng)用于用戶病例的非結(jié)構(gòu)化信息的提取。這也是跨學(xué)科融合的一個(gè)重要方向。Sarma 等人[24]利用遷移學(xué)習(xí)調(diào)整網(wǎng)絡(luò)權(quán)重以適應(yīng)目標(biāo)域任務(wù),該方法在分類問題中表現(xiàn)出了良好的效果。Baalouch 等人[25]針對(duì)物理學(xué)中模擬數(shù)據(jù)和真實(shí)數(shù)據(jù)間存在的差異可能導(dǎo)致傳統(tǒng)機(jī)器學(xué)習(xí)出現(xiàn)差錯(cuò)的問題,利用遷移學(xué)習(xí)從公共高等物理學(xué)數(shù)據(jù)訓(xùn)練域?qū)股窠?jīng)網(wǎng)絡(luò),實(shí)現(xiàn)了模擬數(shù)據(jù)到真實(shí)數(shù)據(jù)的遷移,并在高能物理學(xué)數(shù)據(jù)集上取得了良好性能。可以看到,遷移學(xué)習(xí)的應(yīng)用前景十分廣泛,既包括了文本分類、圖像分類、情感分析和閱讀理解等傳統(tǒng)領(lǐng)域,也包括了醫(yī)學(xué)、物理等實(shí)際領(lǐng)域。這也是人們對(duì)于遷移學(xué)習(xí)研究所重視的原因。

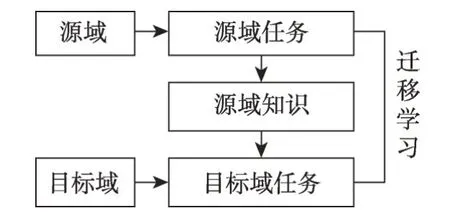

3.2 遷移學(xué)習(xí)的定義及主要技術(shù)

假定源域(含大量標(biāo)注樣本)為DS,目標(biāo)域(少量或完全無(wú)標(biāo)注樣本)為DT,選取來(lái)自源域樣本xS,xS∈DS且服從p分布,來(lái)自目標(biāo)域樣本xT,xT∈DT且服從q分布,源域樣本遠(yuǎn)大于目標(biāo)域樣本,利用源域樣本和目標(biāo)域樣本學(xué)習(xí)映射函數(shù),使源域和目標(biāo)域樣本映射到相同的分布空間,減少源域和目標(biāo)域間的差異性,使源域樣本學(xué)習(xí)的知識(shí)能夠應(yīng)用于目標(biāo)域,解決目標(biāo)域任務(wù),實(shí)際模型構(gòu)建中,將足夠多的源域知識(shí)遷移到目標(biāo)域是遷移學(xué)習(xí)研究重點(diǎn)[26]。遷移學(xué)習(xí)過程如圖5所示。

Fig.5 Transfer learning process圖5 遷移學(xué)習(xí)過程

目前深度學(xué)習(xí)和遷移學(xué)習(xí)的聯(lián)合方法在圖像領(lǐng)域中得到很好的應(yīng)用,例如圖像和視頻轉(zhuǎn)換[27],這種聯(lián)合方法在自然語(yǔ)言處理中的應(yīng)用也越來(lái)越廣泛。基于深度學(xué)習(xí)的遷移學(xué)習(xí)方法通常涉及單詞特征級(jí)遷移和模型結(jié)構(gòu)級(jí)遷移[28]。單詞特征級(jí)遷移利用源域預(yù)訓(xùn)練詞向量表示或利用輔助任務(wù)訓(xùn)練目標(biāo)域的特征表示,將預(yù)訓(xùn)練特征表示作為目標(biāo)域模型的輸入。模型結(jié)構(gòu)級(jí)遷移利用源域?qū)ι窠?jīng)網(wǎng)絡(luò)進(jìn)行預(yù)訓(xùn)練,將神經(jīng)網(wǎng)絡(luò)的部分網(wǎng)絡(luò)層或參數(shù)遷移至目標(biāo)域中訓(xùn)練,并通過目標(biāo)域數(shù)據(jù)對(duì)神經(jīng)網(wǎng)絡(luò)進(jìn)行微調(diào)實(shí)現(xiàn)目標(biāo)域網(wǎng)絡(luò)性能的提升。根據(jù)遷移學(xué)習(xí)的主要技術(shù)方法,深度遷移學(xué)習(xí)可以分為基于實(shí)例的遷移學(xué)習(xí)、基于網(wǎng)絡(luò)的遷移學(xué)習(xí)和基于對(duì)抗的遷移學(xué)習(xí)。

3.2.1 基于實(shí)例的遷移學(xué)習(xí)

實(shí)例是指源域或目標(biāo)域樣本中的樣本數(shù)據(jù)。基于實(shí)例的遷移學(xué)習(xí)是利用源域中樣本實(shí)例的空間分布,根據(jù)源域和目標(biāo)域樣本分布差異,配以適當(dāng)權(quán)重以符合目標(biāo)域分布,將此部分實(shí)例作為目標(biāo)域的補(bǔ)充,實(shí)現(xiàn)知識(shí)的遷移。Chowdhury等人[29]利用源域中的實(shí)例增強(qiáng)學(xué)習(xí)模型,通過學(xué)習(xí)源域和目標(biāo)域數(shù)據(jù)集的實(shí)例表示,并加入軟注意力機(jī)制的長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)和局部敏感哈希值對(duì)相關(guān)實(shí)例進(jìn)行檢索,將其擴(kuò)展到目標(biāo)域訓(xùn)練集中,實(shí)驗(yàn)在BBC 新聞分類結(jié)果上優(yōu)于長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)。Wang等人[30]提出一種基于實(shí)例的遷移學(xué)習(xí)方法,通過對(duì)源域數(shù)據(jù)進(jìn)行模型預(yù)訓(xùn)練并利用該模型對(duì)目標(biāo)域樣本進(jìn)行預(yù)估,根據(jù)其影響刪除目標(biāo)域樣本中造成模型性能降低的部分樣本實(shí)例,利用優(yōu)化的目標(biāo)域樣本訓(xùn)練并微調(diào)該模型并最終對(duì)目標(biāo)域進(jìn)行預(yù)測(cè)。實(shí)驗(yàn)結(jié)果表明該方法對(duì)圖像分類的模型質(zhì)量有一定的提升。

Zhuang 等人[31]針對(duì)情感分類訓(xùn)練數(shù)據(jù)稀缺問題,提出一種基于膠囊網(wǎng)絡(luò)的遷移學(xué)習(xí)方法,該方法將文檔級(jí)情感分類數(shù)據(jù)遷移到方面級(jí)情感分類中,一定程度上解決了方面級(jí)情感分類訓(xùn)練數(shù)據(jù)稀缺的問題,實(shí)驗(yàn)在semeval數(shù)據(jù)集上驗(yàn)證了基于膠囊網(wǎng)絡(luò)的遷移學(xué)習(xí)在情感分類任務(wù)中的有效性。Jiang等人[32]針對(duì)實(shí)例空間和標(biāo)簽空間中數(shù)據(jù)集之間的分布差異和固有信息,提出一種基于分布適應(yīng)的多標(biāo)簽度量遷移學(xué)習(xí)方法,其通過學(xué)習(xí)和微調(diào)訓(xùn)練實(shí)例的權(quán)重,將最大平均差異方法擴(kuò)展至分類任務(wù)中,從而彌補(bǔ)了實(shí)例空間和標(biāo)簽空間中訓(xùn)練域和測(cè)試域之間的分布差異,該方法對(duì)五個(gè)分類任務(wù)均有一定提升。

另外,將源域?qū)嵗湍繕?biāo)域?qū)嵗成涞较嗤臉颖究臻g,該樣本空間的樣本分布相似于源域樣本分布和目標(biāo)域樣本分布,實(shí)現(xiàn)源域和目標(biāo)域的融合,該方法是實(shí)例遷移學(xué)習(xí)的一種。如何利用源域和目標(biāo)域構(gòu)成新的樣本空間,成為新的研究方向。現(xiàn)有遷移學(xué)習(xí)方法通常利用源域和目標(biāo)域之間差異度量限定邊界以解決遷移問題[33]。吳彥文等人[34]針對(duì)推薦方法中目標(biāo)評(píng)分?jǐn)?shù)據(jù)稀疏的問題,提出一種領(lǐng)域自適應(yīng)的推薦方法,該方法利用GFK(geodesic flow kernal)解決源域和目標(biāo)域數(shù)據(jù)類別一致性的問題,其次通過特征映射將源域和目標(biāo)域數(shù)據(jù)映射到同一樣本空間,并通過PCA(principal component analysis)和測(cè)地線流式核方法完成對(duì)源域和目標(biāo)域的領(lǐng)域適應(yīng),之后進(jìn)行遷移學(xué)習(xí)完成模型的構(gòu)建,該方法在推薦系統(tǒng)數(shù)據(jù)集上表現(xiàn)良好。Long等人[35]基于分布的希爾伯特空間嵌入理論,提出了一種直接比較跨域的聯(lián)合分布差異,該差異可以將聯(lián)合分布嵌入到再生內(nèi)核希爾伯特空間中來(lái)直接比較跨域聯(lián)合分布差異,從而消除了對(duì)邊界條件分解的適應(yīng),不再需要對(duì)邊界條件進(jìn)行判定,該方法在一定程度上解決了源域和目標(biāo)域之間的差異性。賈云龍等人[36]針對(duì)微博用戶意圖數(shù)據(jù)較少的問題,提出一種基于注意力機(jī)制的雙向長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)的遷移學(xué)習(xí)方法,該方法利用遷移學(xué)習(xí)將相似領(lǐng)域數(shù)據(jù)集與微博用戶消費(fèi)意圖數(shù)據(jù)集結(jié)合共同構(gòu)成訓(xùn)練數(shù)據(jù)集,通過長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)和TF-IDF(term frequency-inverse document frequency,TF-IDF)識(shí)別用戶的隱性消費(fèi)意圖和顯性消費(fèi)意圖。實(shí)驗(yàn)結(jié)果表明,通過遷移學(xué)習(xí)所融合的數(shù)據(jù)集能夠提升模型的性能。

3.2.2 基于網(wǎng)絡(luò)的遷移學(xué)習(xí)

基于網(wǎng)絡(luò)的遷移學(xué)習(xí)是指利用源域樣本預(yù)訓(xùn)練部分網(wǎng)絡(luò),包括其結(jié)構(gòu)和參數(shù),將部分網(wǎng)絡(luò)遷移到目標(biāo)域中并作為神經(jīng)網(wǎng)絡(luò)的一部分。Mou 等[37]通過對(duì)源域預(yù)訓(xùn)練,并將其訓(xùn)練所得到的網(wǎng)絡(luò)與參數(shù)遷移至目標(biāo)域的輸入層、隱藏層以及輸出層且對(duì)該模型的輸入層和隱藏層進(jìn)行一定程度的微調(diào),實(shí)驗(yàn)結(jié)果表明,該模型能夠提升目標(biāo)域中的意圖識(shí)別性能。安明慧等人[38]針對(duì)問答型情感分類語(yǔ)料數(shù)據(jù)稀缺的問題,提出一種借助非問答型情感分類進(jìn)行模型的預(yù)訓(xùn)練并通過聯(lián)合學(xué)習(xí)優(yōu)化問答型情感分類損失以及非問答型情感分類損失,實(shí)現(xiàn)非問答型到問答型的知識(shí)遷移,實(shí)驗(yàn)結(jié)果表明,該方法提升了問答型情感分類任務(wù)的性能。

王立偉等人[39]針對(duì)高光譜圖像分類訓(xùn)練數(shù)據(jù)不足的問題以及數(shù)據(jù)樣本空間特征利用不充分的問題,提出一種基于深層殘差網(wǎng)絡(luò)的遷移學(xué)習(xí)方法。由于深層殘差網(wǎng)絡(luò)在普通圖像分類中已經(jīng)取得了很大的成功,因此該方法使用深層殘差網(wǎng)絡(luò)對(duì)高光譜圖像進(jìn)行深層特征的提取,以挖掘數(shù)據(jù)樣本的深層特征信息。其次使用遷移學(xué)習(xí)策略解決高光譜圖像分類數(shù)據(jù)不足所引起的過擬合現(xiàn)象,利用相關(guān)數(shù)據(jù)集對(duì)模型網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù)進(jìn)行訓(xùn)練,并針對(duì)高光譜圖像數(shù)據(jù)進(jìn)行模型結(jié)構(gòu)及參數(shù)的微調(diào)以適應(yīng)高光譜圖像分類。實(shí)驗(yàn)結(jié)果表明使用深層殘差網(wǎng)絡(luò)對(duì)數(shù)據(jù)進(jìn)行特征提取,分類效果提升0.82個(gè)百分點(diǎn),同時(shí)遷移不同的網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù)對(duì)分類具有很大的影響,實(shí)驗(yàn)中遷移最好的網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù)較不適用遷移學(xué)習(xí)性能提升了5.74 個(gè)百分點(diǎn),驗(yàn)證了基于深層殘差網(wǎng)絡(luò)的遷移學(xué)習(xí)方法的可行性。文獻(xiàn)[40-41]表明訓(xùn)練數(shù)據(jù)的缺失是影響意圖識(shí)別性能的關(guān)鍵,其中還可能涉及到意圖類別的不平衡性、獨(dú)立性以及類別的重疊性。Xiao 等人[42]針對(duì)類別不平衡和類別數(shù)量少的問題,提出了一種基于欠采樣技術(shù)[43]的遷移學(xué)習(xí),其利用源域數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,并在目標(biāo)域數(shù)據(jù)對(duì)模型進(jìn)行微調(diào),并根據(jù)目標(biāo)域數(shù)據(jù)對(duì)模型性能的影響對(duì)目標(biāo)域樣本進(jìn)行欠采樣,該模型在文本分類和情感分析數(shù)據(jù)集上有一定的提升。模型結(jié)構(gòu)如圖6所示。

Fig.6 Structure diagram of undersampling technology for transfer learning圖6 遷移學(xué)習(xí)的欠采樣技術(shù)結(jié)構(gòu)圖

圖6 中,第一部分對(duì)源域樣本進(jìn)行模型的預(yù)訓(xùn)練,第二部分利用目標(biāo)域子集對(duì)預(yù)訓(xùn)練模型進(jìn)行訓(xùn)練并微調(diào)其結(jié)構(gòu)與參數(shù),第三部分利用目標(biāo)域訓(xùn)練模型在其正樣本中進(jìn)行分類訓(xùn)練,標(biāo)簽為負(fù)的樣本進(jìn)行欠采樣,第四部分利用目標(biāo)域訓(xùn)練模型訓(xùn)練獲得的負(fù)標(biāo)簽樣本和負(fù)樣本共同訓(xùn)練源域模型,并對(duì)模型結(jié)構(gòu)與參數(shù)進(jìn)行微調(diào),第五部分利用第二部分模型對(duì)測(cè)試集進(jìn)行訓(xùn)練并利用其負(fù)標(biāo)簽樣本數(shù)據(jù)進(jìn)行分類預(yù)測(cè)。

利用源域預(yù)訓(xùn)練模型,通過目標(biāo)域?qū)︻A(yù)訓(xùn)練模型的參數(shù)和結(jié)構(gòu)進(jìn)行微調(diào)以適應(yīng)目標(biāo)域任務(wù),通過對(duì)網(wǎng)絡(luò)參數(shù)和結(jié)構(gòu)的微調(diào)實(shí)現(xiàn)源域到目標(biāo)域的知識(shí)遷移,微調(diào)也是遷移學(xué)習(xí)的一種研究方向。在步驟4中,選擇遷移輸入層和卷積層,以便充分利用模型在源域中學(xué)習(xí)到的特征表示[44],通過微調(diào)全連接層和輸出層使模型更適應(yīng)目標(biāo)任務(wù)。

邱寧佳等人[45]針對(duì)目標(biāo)域數(shù)據(jù)量少的問題,提出一種基于模型遷移的卷積神經(jīng)網(wǎng)絡(luò)算法。在實(shí)驗(yàn)中,利用PCA和自編碼機(jī)模型(autoencoder,AE)對(duì)源域和目標(biāo)域進(jìn)行數(shù)據(jù)特征的降維,利用源域和目標(biāo)域降維后的特征訓(xùn)練自編碼機(jī)損失函數(shù)以獲得目標(biāo)域的低維度特征表達(dá),通過目標(biāo)域低維度特征表達(dá)微調(diào)預(yù)訓(xùn)練模型,實(shí)現(xiàn)基于網(wǎng)絡(luò)的模型遷移。該模型在情感分類、文本分類及垃圾評(píng)論分類中取得了一定的提升。

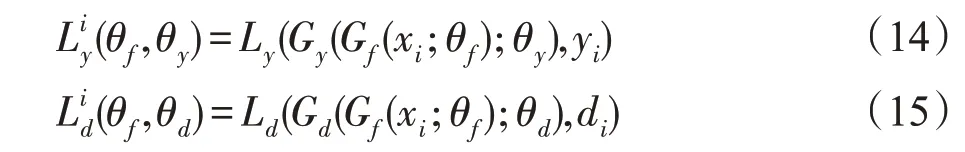

3.2.3 基于對(duì)抗的遷移學(xué)習(xí)

基于對(duì)抗的遷移學(xué)習(xí)指利用對(duì)抗神經(jīng)網(wǎng)絡(luò)尋找源域和目標(biāo)域的可遷移特征表示,通過對(duì)源域和目標(biāo)域的特征表示訓(xùn)練模型,使得該模型無(wú)法區(qū)分特征來(lái)自于源域或目標(biāo)域,實(shí)現(xiàn)源域知識(shí)到目標(biāo)域的遷移。對(duì)抗神經(jīng)網(wǎng)絡(luò)最早源于生成對(duì)抗網(wǎng)絡(luò)(gener-ative adversarial networks,GAN),主要應(yīng)用于圖像任務(wù)中[46]。Long 等人[47]提出一種隨機(jī)多線性域適應(yīng)對(duì)抗網(wǎng)絡(luò)(domain adaptation with randomized multilinear adversarial networks),其通過多重特征層以及多線性對(duì)抗分類層實(shí)現(xiàn)深度學(xué)習(xí)與對(duì)抗神經(jīng)網(wǎng)絡(luò)的結(jié)合,實(shí)現(xiàn)跨領(lǐng)域任務(wù)的遷移。Tzeng等人[48-49]針對(duì)目標(biāo)域訓(xùn)練數(shù)據(jù)稀疏的問題,提出一種基于卷積神經(jīng)網(wǎng)絡(luò)的遷移學(xué)習(xí),該方法利用域混淆損失評(píng)估域不變特征的有效性,通過對(duì)未標(biāo)注和稀疏標(biāo)注數(shù)據(jù)的域不變特征進(jìn)行優(yōu)化,實(shí)現(xiàn)源域和目標(biāo)域分布距離的最小化,從而實(shí)現(xiàn)源域到目標(biāo)域的遷移。Luo等人[50]針對(duì)源域和目標(biāo)域特征提取問題,提出一種基于度量學(xué)習(xí)的遷移學(xué)習(xí)方法,該方法利用度量學(xué)習(xí)實(shí)現(xiàn)領(lǐng)域間深層特征的提取并利用域?qū)箵p失實(shí)現(xiàn)跨領(lǐng)域的遷移。目前,域?qū)股窠?jīng)網(wǎng)絡(luò)(domain-adversarial neural networks,DANN)[51-52]在跨領(lǐng)域識(shí)別任務(wù)中受到了廣泛的關(guān)注,利用域不變特征使模型分不清數(shù)據(jù)來(lái)自于源域還是目標(biāo)域,從而實(shí)現(xiàn)源域到目標(biāo)域的遷移學(xué)習(xí)。域不變特征指利用源域和目標(biāo)域?qū)W習(xí)到一個(gè)公共的特征表示空間,在這個(gè)特征表示空間中,源域所學(xué)到的模型能夠用在目標(biāo)域中,領(lǐng)域間適應(yīng)問題可轉(zhuǎn)換為尋求此特征表示空間的問題。Ganin等人[52]基于域?qū)股窠?jīng)網(wǎng)絡(luò),模型通過對(duì)源域和目標(biāo)域的訓(xùn)練實(shí)現(xiàn)遷移,從而解決少樣本數(shù)據(jù)任務(wù)的預(yù)測(cè)。該模型利用來(lái)自源域樣本S以及目標(biāo)域樣本T建立目標(biāo)分類器η:X→Y的低目標(biāo)風(fēng)險(xiǎn)。如式(10)所示:

其中,不包含關(guān)于DT的標(biāo)簽信息,X為輸入空間,Y是標(biāo)簽集合。目前,大多數(shù)方法都將源誤差和目標(biāo)誤差的總和與源域分布和目標(biāo)域分布間的距離相結(jié)合解決域適應(yīng)問題,當(dāng)源域分布和目標(biāo)域分布相似時(shí),源域風(fēng)險(xiǎn)是目標(biāo)域風(fēng)險(xiǎn)的指標(biāo)。該域?qū)股窠?jīng)網(wǎng)絡(luò)主要基于兩個(gè)定理[52]:

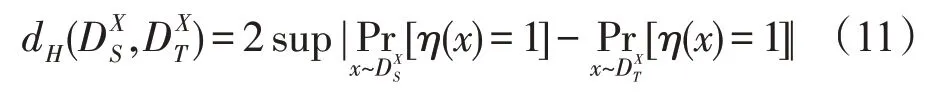

定理1給定兩個(gè)領(lǐng)域在X上的分布,且存在一個(gè)假設(shè)類H,在上有類H的散度,如式(11):

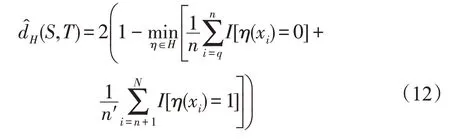

類H散度取決于區(qū)分樣本的能力,對(duì)于對(duì)稱類H,通過樣本S和T計(jì)算經(jīng)驗(yàn)散度,如式(12):

其中,I(a)為指標(biāo)函數(shù),a=0 為源樣本且樣本數(shù)為n,a=1 為目標(biāo)樣本且樣本數(shù)為n′。構(gòu)建新數(shù)據(jù)集U,文獻(xiàn)表明,H散度由其經(jīng)驗(yàn)估計(jì)散度加一個(gè)恒定項(xiàng)。該項(xiàng)取決于類H的維度和樣本S、T的大小。由此得到定理2。

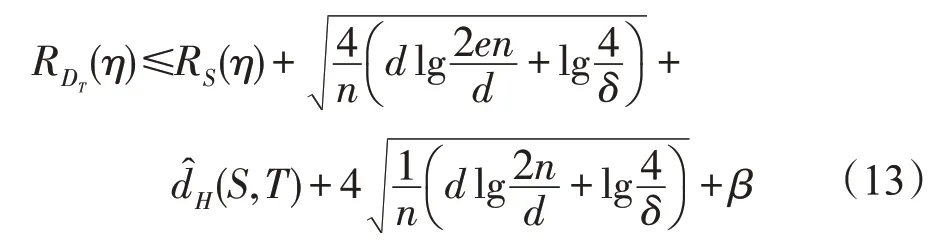

定理2H為VC維d的假設(shè)類。在每一個(gè)特征函數(shù)η?H下,對(duì)于選擇的樣本S、T存在概率1-δ,如式(13)所示:

控制H散度的策略是找到一個(gè)實(shí)例的表示形式,使得其在源域和目標(biāo)域都難以區(qū)分。根據(jù)定理1和定理2 的思想,構(gòu)建領(lǐng)域?qū)股窠?jīng)網(wǎng)絡(luò)(DANN)。DANN 包括特征提取器、標(biāo)簽預(yù)測(cè)器和領(lǐng)域預(yù)測(cè)器三部分,框架結(jié)構(gòu)圖如圖7所示。

Fig.7 Domain-adversarial neural network圖7 領(lǐng)域?qū)股窠?jīng)網(wǎng)絡(luò)

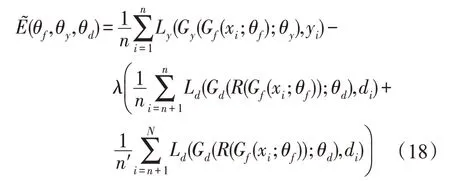

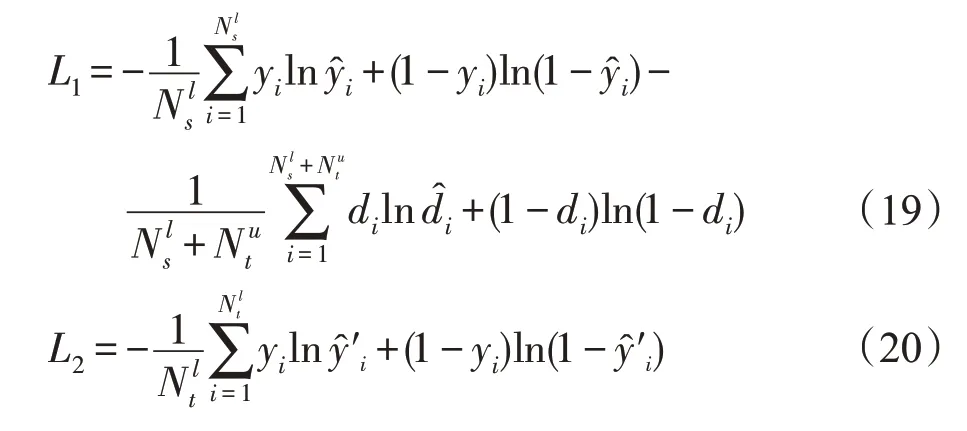

圖7 中,特征提取器為Gf(·;θf(wàn)),標(biāo)簽預(yù)測(cè)器為Gy(·;θy),領(lǐng)域預(yù)測(cè)器為Gd(·;θd),θ為參數(shù)。根據(jù)定理2,領(lǐng)域預(yù)測(cè)Gd生成的假設(shè)類Hd應(yīng)包括標(biāo)簽預(yù)測(cè)器生成的假設(shè)類Hy,即Hy?Hd。標(biāo)簽預(yù)測(cè)器損失函數(shù)和領(lǐng)域預(yù)測(cè)損失函數(shù)如式(14)、式(15)所示:

通過發(fā)現(xiàn)鞍點(diǎn)訓(xùn)練損失函數(shù)并進(jìn)行優(yōu)化以及在梯度更新中加入梯度反轉(zhuǎn)層實(shí)現(xiàn)域特征。根據(jù)域不變特征,模型將使得領(lǐng)域間互不可分,因此在梯度更新中減去領(lǐng)域預(yù)測(cè)梯度,從而避免在梯度下降中,最大程度地減少域分類損失。因此模型在特征提取器和領(lǐng)域預(yù)測(cè)器之間加入梯度反轉(zhuǎn)層來(lái)實(shí)現(xiàn)傳統(tǒng)梯度下降[53]。梯度反轉(zhuǎn)層在正向傳播時(shí),只做普通轉(zhuǎn)換,如式(16),而在反向傳播中,梯度反轉(zhuǎn)層從下一級(jí)獲取梯度并改變其符號(hào),如式(17)。

這里I是一個(gè)單位矩陣。通過梯度優(yōu)化后最終的損失函數(shù)如式(18)所示:

林悅等人[54]針對(duì)情感分析任務(wù)數(shù)據(jù)量少的情況,提出一種基于膠囊網(wǎng)絡(luò)的跨領(lǐng)域研究方法,該模型分為兩個(gè)階段進(jìn)行訓(xùn)練。第一階段,利用膠囊網(wǎng)絡(luò)進(jìn)行源域和目標(biāo)域的特征提取,采取源域和目標(biāo)域的域?qū)褂?xùn)練方法,并在域?qū)褂?xùn)練中加入梯度反轉(zhuǎn)層實(shí)現(xiàn)前向傳播和反向傳播的過程,最終得到第一階段分類損失函數(shù),如式(19)。第二階段,利用目標(biāo)域的標(biāo)記信息來(lái)改善模型的適應(yīng)能力,通過對(duì)目標(biāo)域的訓(xùn)練,學(xué)習(xí)目標(biāo)域獨(dú)有的特征表示,第二階段損失函數(shù)如式(20)所示。通過對(duì)兩個(gè)階段損失函數(shù)的融合與交互,最終提升整個(gè)分類器對(duì)目標(biāo)域的分類效果,即完成從源域到目標(biāo)域的遷移。

3.3 遷移學(xué)習(xí)存在的問題及解決思路

目前,遷移學(xué)習(xí)在意圖識(shí)別、情感分類和文本分類等傳統(tǒng)領(lǐng)域中得到廣泛的應(yīng)用。當(dāng)前遷移學(xué)習(xí)研究的主要問題如下:

(1)何時(shí)遷移。何時(shí)遷移是指在什么情況下可以進(jìn)行遷移學(xué)習(xí)完成所研究的任務(wù)。遷移學(xué)習(xí)的前提是源域和目標(biāo)域的樣本分布相似但不同,另外源域和目標(biāo)域選擇來(lái)自相似任務(wù),例如源域?yàn)楣宦肪€數(shù)據(jù)、旅游景點(diǎn)、醫(yī)院和餐館,目標(biāo)域?yàn)橛嗆嚻薄⒂嗁e館。源域和目標(biāo)域數(shù)據(jù)均來(lái)自文本信息且在文本信息中特征提取過程相似。主要的解決思路是通過PCA、樣本空間映射、深度學(xué)習(xí)和領(lǐng)域自適應(yīng)對(duì)源域和目標(biāo)域特征分布和損失函數(shù)進(jìn)行優(yōu)化,利用聯(lián)合優(yōu)化實(shí)現(xiàn)源域和目標(biāo)域樣本分布一致,從而實(shí)現(xiàn)遷移學(xué)習(xí)的目的。

(2)遷移什么。遷移什么是指對(duì)哪部分知識(shí)的遷移問題。主要解決思路是針對(duì)源域和目標(biāo)域的數(shù)據(jù)規(guī)模和數(shù)據(jù)分布,從而選擇適合的遷移學(xué)習(xí)方法,比如在源域數(shù)據(jù)規(guī)模足夠大的前提下,可以利用基于實(shí)例的遷移學(xué)習(xí)方法,通過遷移數(shù)據(jù)實(shí)例,達(dá)到遷移學(xué)習(xí)的目的。當(dāng)源域和目標(biāo)域數(shù)據(jù)分布足夠相似時(shí),可以對(duì)源域和目標(biāo)域的特征表示進(jìn)行遷移。

(3)如何遷移。如何遷移是指如何利用算法模型實(shí)現(xiàn)源域到目標(biāo)域的遷移。主要解決思路是利用遷移學(xué)習(xí)的主要技術(shù)。其中,基于實(shí)例的遷移學(xué)習(xí)主要針對(duì)源域數(shù)據(jù)的遷移,利用源域中部分實(shí)例加以權(quán)重使得部分實(shí)例與目標(biāo)域分布相似,從而增加目標(biāo)域樣本數(shù)據(jù)以提升神經(jīng)網(wǎng)絡(luò)模型性能。基于網(wǎng)絡(luò)的遷移學(xué)習(xí)主要針對(duì)模型結(jié)構(gòu)與參數(shù)的遷移,利用源域預(yù)訓(xùn)練模型,通過目標(biāo)域?qū)Y(jié)構(gòu)與參數(shù)進(jìn)行微調(diào)以適應(yīng)目標(biāo)域,實(shí)現(xiàn)遷移。基于對(duì)抗的遷移學(xué)習(xí)主要針對(duì)源域和目標(biāo)域的特征表示進(jìn)行遷移,從源域和目標(biāo)域中學(xué)習(xí)到特征表示,使得對(duì)抗網(wǎng)絡(luò)區(qū)分特征表示來(lái)自于源域或目標(biāo)域,如果對(duì)抗網(wǎng)絡(luò)區(qū)分不出源域或目標(biāo)域的內(nèi)容,可以認(rèn)為該特征表示融合了源域和目標(biāo)域的特征,從而實(shí)現(xiàn)遷移過程。

3.4 意圖識(shí)別遷移學(xué)習(xí)存在的問題及研究方向

當(dāng)前,由于實(shí)際應(yīng)用領(lǐng)域的對(duì)話系統(tǒng)需求增加,而需要開發(fā)的新領(lǐng)域短時(shí)間內(nèi)無(wú)法獲得大量的標(biāo)記數(shù)據(jù),同時(shí)數(shù)據(jù)的獲取需要耗費(fèi)大量的人力財(cái)力,因此在數(shù)據(jù)資源稀缺的情況下,構(gòu)建其對(duì)話系統(tǒng)模型成為了一項(xiàng)挑戰(zhàn)。如何利用現(xiàn)有標(biāo)注數(shù)據(jù)、模型結(jié)構(gòu)搭建一個(gè)只含有少量標(biāo)注數(shù)據(jù)的新領(lǐng)域?qū)υ捪到y(tǒng)成為目前研究的熱點(diǎn)問題。針對(duì)目前新領(lǐng)域意圖識(shí)別訓(xùn)練數(shù)據(jù)稀缺的情況,主要解決思路主要圍繞以下幾個(gè)方向進(jìn)行研究:

(1)通過對(duì)新領(lǐng)域數(shù)據(jù)的研究,尋找擁有大量標(biāo)注數(shù)據(jù)的相似領(lǐng)域且該領(lǐng)域利用深度學(xué)習(xí)已獲得不錯(cuò)的意圖識(shí)別模型,將其作為源域并通過對(duì)源域的實(shí)例、網(wǎng)絡(luò)或特征進(jìn)行遷移,以達(dá)到適應(yīng)目標(biāo)域?qū)W習(xí)的目的。

(2)深度學(xué)習(xí)在解決分類任務(wù)中獲得了很好的性能,而且對(duì)意圖識(shí)別也有很好的效果,遷移學(xué)習(xí)在少量標(biāo)注數(shù)據(jù)的領(lǐng)域研究也取得了不錯(cuò)的效果,結(jié)合深度學(xué)習(xí)模型和遷移學(xué)習(xí)方法進(jìn)行意圖識(shí)別研究,解決少量標(biāo)注數(shù)據(jù)的領(lǐng)域?qū)υ捪到y(tǒng)是未來(lái)研究的一個(gè)焦點(diǎn)。

(3)領(lǐng)域?qū)股窠?jīng)網(wǎng)絡(luò)在圖像跨領(lǐng)域任務(wù)中展現(xiàn)出了優(yōu)越的性能,且有研究人員將其應(yīng)用到自然語(yǔ)言處理中,結(jié)合域?qū)股窠?jīng)網(wǎng)絡(luò)和深度學(xué)習(xí),將源域的特征和知識(shí)遷移到目標(biāo)域中,實(shí)現(xiàn)少量訓(xùn)練數(shù)據(jù)領(lǐng)域的意圖識(shí)別模型的構(gòu)建。

4 評(píng)價(jià)指標(biāo)

4.1 意圖識(shí)別評(píng)價(jià)指標(biāo)

意圖識(shí)別本質(zhì)屬于分類問題。在模型評(píng)價(jià)中,通常使用分類器模型評(píng)價(jià)標(biāo)準(zhǔn),即準(zhǔn)確率、精確率、召回率和F1值。TP表示類A樣本正確分類到類A中;TN表示非類A樣本正確分類到除類A的其他類中;FP表示非類A樣本分到類A中;FN表示類A樣本分到除類A以外的其他類中。評(píng)價(jià)指標(biāo)計(jì)算公式如下所示:

(1)準(zhǔn)確率

(2)精確率

(3)召回率

(4)F1值

4.2 模型評(píng)價(jià)指標(biāo)

為了驗(yàn)證和分析所提模型和算法的性能,通常在實(shí)驗(yàn)中會(huì)將實(shí)驗(yàn)?zāi)P团c傳統(tǒng)深度神經(jīng)網(wǎng)絡(luò)模型和遷移學(xué)習(xí)基礎(chǔ)模型進(jìn)行對(duì)比。在同一數(shù)據(jù)集下,比較神經(jīng)網(wǎng)絡(luò)模型、遷移學(xué)習(xí)模型以及實(shí)驗(yàn)?zāi)P偷臏?zhǔn)確率、F1值。

5 結(jié)束語(yǔ)

遷移學(xué)習(xí)是近年來(lái)機(jī)器學(xué)習(xí)和深度學(xué)習(xí)領(lǐng)域中產(chǎn)生的新的研究方向,這一研究方向與傳統(tǒng)深度學(xué)習(xí)的不同在于遷移學(xué)習(xí)能夠利用少量標(biāo)注數(shù)據(jù)訓(xùn)練出準(zhǔn)確率較高的模型。當(dāng)前,利用遷移學(xué)習(xí)解決意圖識(shí)別問題的研究相對(duì)較少,這一研究方向具有可期的研究前景且蘊(yùn)含著巨大的潛在效益。

遷移學(xué)習(xí)的過程主要分為兩方面:源域數(shù)據(jù)的選擇和遷移學(xué)習(xí)主要技術(shù)的研究。其中源域的選擇須與所研究問題的目標(biāo)域的數(shù)據(jù)分布相似且領(lǐng)域相關(guān)。通過對(duì)前人的遷移學(xué)習(xí)方法進(jìn)行總結(jié),遷移學(xué)習(xí)的主要技術(shù)分為基于實(shí)例、網(wǎng)絡(luò)和對(duì)抗的遷移學(xué)習(xí)方法。完成對(duì)源域數(shù)據(jù)的選擇并利用合適的遷移學(xué)習(xí)方法能夠在一定程度上解決訓(xùn)練數(shù)據(jù)稀缺領(lǐng)域的研究。本文主要概述了意圖識(shí)別的由來(lái)及發(fā)展,并對(duì)目前所存在的意圖識(shí)別問題研究進(jìn)行介紹。在這之后,對(duì)遷移學(xué)習(xí)的應(yīng)用動(dòng)機(jī)、主要技術(shù)、應(yīng)用場(chǎng)景和存在的問題進(jìn)行介紹,并對(duì)問題的解決思路進(jìn)行說(shuō)明。

當(dāng)前,人們對(duì)遷移學(xué)習(xí)已經(jīng)進(jìn)行了一定的研究,但還處于探索階段,許多理論仍不完善,尤其將其應(yīng)用到意圖識(shí)別的研究更是少之又少。在未來(lái),利用現(xiàn)有標(biāo)注數(shù)據(jù)、模型結(jié)構(gòu)結(jié)合遷移學(xué)習(xí)搭建一個(gè)只含有少量標(biāo)注數(shù)據(jù)的新領(lǐng)域?qū)υ捪到y(tǒng)成為目前研究的熱點(diǎn)問題。