基于強化學習的城市交通路徑規劃

劉思嘉,童向榮

(煙臺大學計算機與控制工程學院,山東煙臺 264005)

0 引言

路徑規劃問題是人工智能領域熱點問題,該問題涉及許多領域,包括:移動機器人導航、飛行器航跡規劃、游戲自動導航以及車輛交通導航等。如今,城市交通路徑規劃在提升交通系統運行效率方面正發揮著越來越重要的作用。結合城市交通特點,可以總結出城市交通路徑規劃問題的規范化定義:將指定某一車輛作為智能體,目的是讓智能體從規定范圍內的狀態找到一條從起始狀態到目標狀態的一條無障礙路徑。其中如何提高路徑規劃算法的效率成為亟待解決的問題,路徑規劃算法使用高效的規劃算法來為智能體車輛選擇合理的導航路徑,從而減少車輛在城市道路上運行的時間,提升城市道路的運行通暢度。

目前,路徑規劃問題已經得到許多學者的關注,有一些成功的研究成果,具體可以分為全局規劃和局部規劃。全局規劃的算法包括A*算法[1]以及它的各種改進版本等,這些算法已經在離線靜態環境中表現出優異的效果。對于動態環境,Yu 等[2]提出了一種在動態圖中識別K-最短路徑的分布式算法(KShortest Path in Dynamic Graph,KSP-DG),能夠在動態道路網環境找到多條最短路徑。但是這些算法過于依賴環境數據,需要在大量數據支持下才能完成路徑規劃,而且在未知環境下的效果較差,無法應用在環境變化的情況下。局部規劃包括神經網絡法[3]、遺傳算法[4]以及強化學習算法等。其中強化學習算法由于無需環境的先驗知識,已經得到了廣泛的應用。

通過將強化學習算法應用到路徑規劃算法中,能夠有效幫助車輛的行駛路徑規劃,同時對道路未來通行狀態的變化加以考慮,從而能夠進一步提高選路算法的合理性,對于緩解城市交通擁堵有著重要的現實意義。因此提出了一種在道路交通網環境下基于強化學習的車輛路徑規劃算法,采用將基于模型的算法和模型無關的算法相結合的Dyna 框架[5]可以提高規劃的速度,同時較為經典的Sarsa 算法[5]作為選路策略可以提高算法的安全性。

與現有其他算法相比,基于強化學習的路徑規劃算法有如下特點:1)大部分的路徑規劃環境是未知的,需要算法建立到模型上再進行路徑搜索,而模型無關算法可以在未知環境工作,算法具有自適應能力;2)一些路徑規劃算法能夠找到最優路線,但是可能會經過較多的時間,這可能造成資源浪費,強化學習算法能夠找到一條相對較快且較優的路線,同時提高路徑規劃的安全性;3)強化學習是一個不斷嘗試的過程,通過不斷與環境交互來找到最優策略,這樣產生的策略對于智能車來說一定是可以完成的,不會因為路徑太復雜導致無法執行。仿真實驗表明:相對于經典的路徑規劃算法,基于強化學習的路徑規劃算法能夠真實地模擬智能車輛的實際行駛狀態,有效減少環境中車輛行駛時間開銷,提高城市交通運行效率。

1 相關工作

在解決路徑規劃問題的強化學習算法中,Q 學習(QLearning)算法[6]是較為常用的一種算法。喬俊飛等[7]把BP神經網絡引入Q-學習算法中應用在移動機器人中,能夠實現對未知環境的路徑規劃。Wang等[8]將Q-learning算法與Sarsa算法結合,提出了一種反向的Q-學習算法。Gosavi[9]提出了一種基于Q 學習和神經網絡規劃器的路徑規劃方法,實驗證明了該方法在全局信息已知環境中的有效性。Sarsa 算法[5]是在Q-學習算法的基礎上提出的一種模型無關的強化學習方法,基于Sarsa 的路徑規劃算法也得到了一定的研究。王軍紅等[11]提出了一種基于信用分配的Sarsa算法,引入信用分配的概念分配強化信號并修改動作選擇策略,實驗表明該算法可以解決動態環境下的路徑規劃問題。Sarsa 算法與其他方法結合也取得了一定的研究成果,例如k均值聚類算法(kmeans clustering algorithm,k-means)[12]、圖搜索算法[13]及神經網絡算法[14]等。這些文獻中的算法能夠完成路徑規劃的基本要求,但是收斂速度較慢,需要耗費大量的時間。

在1991 年,強化學習的先驅Sutton 等[5]提出了Dyna 框架,這個框架通過加入與模擬環境交互得到的經驗,能夠有效提升算法的收斂速度。Dyna 框架通常與Q-學習算法結合使用。朱美強[15]通過將流形學習中拉普拉斯特征映射方法與Dyna-Q 算法結合起來用于解決路徑規劃的問題,實驗證明取得較好的結果。史豪斌等[16]提出一種基于Dyna-Q 的旋翼無人機視覺伺服智能控制方法調節伺服增益以提高其自適應性。但是,Q-學習算法存在一個問題是過于追求獎勵最大化導致智能體在有障礙的地圖中陷入危險次數過多。

2 理論基礎

算法理論涉及經典的馬爾可夫決策過程(Markov Decision Process,MDP),由四元組來描述,其中:

S代表著狀態集合,指的是城市中的位置;

A代表智能體能夠采取的動作集合,智能體汽車在柵格內可執行4個動作,分別為上、下、左、右;

P代表著狀態轉移概率矩陣,表示智能體汽車選擇上下左右的概率;

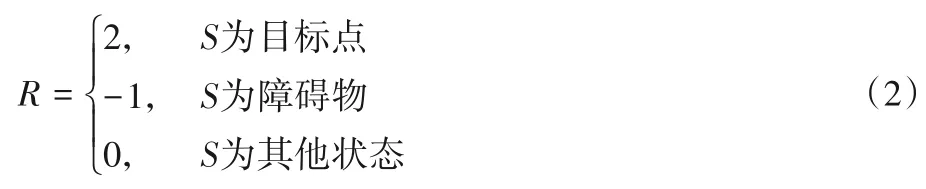

R代表著獎勵函數,智能體在模擬地圖中移動時,未碰撞障礙物時獎勵值為0,碰撞到障礙物時獎勵值為-1,移動到目標點時獎勵值為2。

馬爾可夫決策過程為強化學習問題提供了基本的理論框架,現存環境中幾乎所有的強化學習問題都可以使用MDP 去建模。

2.1 模型無關的強化學習算法

Sarsa 算法是一種使用時序差分求解強化學習控制問題的方法,與Q-學習算法相同,它采用Q-表的方式儲存動作值函數,決策部分采用貪婪策略(epsilon-greedy)選擇動作。Sarsa 算法屬于在線學習算法,它會先執行動作再更新,其基本更新規則如式(1)所示:

其中:S為當前狀態,A為當前狀態選擇的動作,S′為下一個狀態,A′為下一個狀態選擇的動作,R為獎勵值,γ為折扣因子,α為學習因子,Q為q值的集合。在仿真實驗中,學習率α=0.01,折扣因子γ=0.9。

從更新函數可以看出,相較于Q-學習算法,Sarsa 算法是一種更為保守的算法,它更在乎每一步的決策,它對錯誤和陷阱更加敏感。在城市交通路徑規劃中,智能車對碰撞更加敏感,那么系統需要一個更加安全的算法來指導智能車的移動。Sarsa 算法是一個兼顧安全與速度的無模型強化學習算法,它更加符合城市交通環境,所以選擇使用Sarsa算法作為基礎算法指導智能體的路徑規劃。

2.2 基于Dyna框架的強化學習算法

在模型無關的強化學習算法中,智能體能使用從環境中產生的經驗中直接學習到策略;而在基于模型的強化學習中,智能體使用模擬產生的模擬經驗規劃出新的策略;在Dyna框架中,智能體利用與環境交互產生的直接經驗來學習一個模型,同時利用模型生成模擬經驗,使用真實經驗和模擬經驗同時作用于智能體,幫助智能體去學習和規劃出合適的策略。

Dyna框架如圖1所示。

圖1 Dyna框架Fig.1 Dyna framework

從圖1 可以看出,Dyna 框架表示一個規劃的過程。在智能體每次尋找路徑過程中,Dyna 框架都會通過獲得的模擬經驗和完善模型來指導智能體的選擇,這樣可以使智能體在運行過程中不斷地思考,更快地選擇最優路徑。相比其他算法,收斂速度有一定的優勢。在城市交通路徑規劃中,將車輛作為智能體,車輛能夠移動的位置作為狀態空間,車輛選擇的每個動作作為動作空間。在車輛選擇到達目標位置的路徑的過程中,車輛首先在狀態空間中根據獎勵函數的值選擇下一個狀態,同時在系統中構建關于環境的地圖。車輛繼續與真實環境交互獲得直接經驗,車輛也與構建的模型交互獲得模擬經驗幫助智能車提前規劃路徑。在兩者共同作用下,車輛能夠避免選擇較差的路徑,提升車輛路徑規劃的速度。

3 基于Dyna框架的Sarsa算法

Dyna 學習框架下可以與多種強化學習算法相結合。結合方式為使用基礎算法與未知環境進行交互獲取真實樣本,再使用Dyna 框架對交互中建立的地圖模型進行多次規劃獲取虛擬樣本,最終使用真實樣本與虛擬樣本共同指導智能體的路徑規劃過程。基礎算法選擇的是Sarsa 算法。首先Sarsa算法是一種在線學習的算法,它會在狀態轉換的過程中學習,并且整個學習和行動過程只使用一個策略,同時使用兩次?-貪婪的方式選擇出Q(S,A)和Q(S′,A′)。相對于其他算法,Sarsa 算法更加謹慎,與Dyna 學習框架的規劃過程相結合,既保證了算法的安全性,又能提升算法的運行速度。

Dyna-Sa(Dyna-Sarsa)在城市交通環境的流程如圖2所示。

圖2 Dyna-Sa框架流程Fig.2 Flowchart of Dyna-Sa framework

3.1 Dyna-Sa算法

將Sarsa 算法與Dyna 框架結合,目的是將Dyna-Sa 算法應用到城市路徑規劃,具體如下:

研究的問題是單智能體路徑規劃,智能體為控制的車輛。在實現路徑規劃的過程中,智能體需要按照一些特定的規則尋找路徑,這些特定的規則就是算法,Dyna-Sa 算法作為新規則應用到城市路徑規劃問題中。在城市路徑規劃中,隨著車輛的運行,其所處的環境也在不斷變化,這對于路徑規劃是很大挑戰。Dyna 框架可以很好地解決這個問題,智能體既從模型中獲得模擬經驗,也從直接交互的環境中獲得經驗,兩種經驗能夠為智能體選路提供指導,智能體可以快速找到一條安全的路徑。

下面給出Dyna-Sa算法步驟:

1)初始化嘗試要理解得到的模型Model(s,a);

2)對于每一輪迭代,先根據當前狀態和Q(S,A)用?-貪婪的方式得到新狀態S′和獎勵R;

3)然后用Sarsa更新價值函數Q(S,A);

4)用R,S′更新模型Model(s,a)(與真實環境交互完畢后,進行n次模擬);

5)每次模擬都隨機選擇一個之前出現過的狀態S,并在此基礎上隨機選擇一個動作A;

6)基于模型Model(S,A)得到S′和R;

7)再使用Sarsa更新價值函數:

Q(S,A)=Q(S,A) +α(R+γQ(S′,A′) -Q(S,A))

Dyna-Sa算法基本流程中,外部循環過程直接利用數據經驗去構建環境模型,從而更新值函數,內部循環過程使用構建模型去生成新的模擬經驗,用來更新值函數,對較于簡單的規劃過程或者強化學習算法,Dyna-Sa算法呈現出更高的效率。

Dyna-Sa 是保證安全性的一種算法。它的安全性取決于基礎算法和框架的配合。基礎算法Sarsa 使用了廣義策略迭代的思想,會使用下一步的狀態S′和根據狀態給出的動作A′的Q值來對目標值進行估計。這就會對目標值的選擇更加敏感,對于獎勵值低的狀態,智能體就會選擇遠離。同時使用Dyna 框架進行不斷地模擬運行,在運行過程中能夠記錄下有風險的行為,智能體能夠避免這些路徑而選擇安全性更高的路徑。

在速度方面,Dyna-Sa 使用了Dyna 框架,直接對環境進行建模,算法同時獲得模擬經驗和直接交互的經驗,等同于智能體在未知環境中使用較少的時間嘗試了更多的路徑。相對于其他算法,能夠幫助更快的智能體選擇最優路徑,最終有效提高了整個算法的收斂速度。

3.2 算法分析

目前,Dyna-Q 算法已經成功應用到一些模擬環境中,這些場景與城市交通環境有一些差異。首先討論Sarsa 算法和Q-學習算法的不同點,以及選擇Sarsa 算法應用到Dyna 框架中的原因。

這兩種算法的差異主要體現在更新函數的不同,Sarsa 使用的是利用下次狀態所采取的動作對應的Q值來更新Q值,Q-學習使用下次狀態的最大Q值來更新。通過分析這兩種更新方式,可以得到兩種算法的特性:Sarsa 算法會探索更多的可能性,而Q-學習算法則會更傾向于選擇最大可能性的選擇。在學習效果方面,Q-學習算法具備學習到全局最優的能力,Sarsa 則相對差一些。收斂速度方面,Sarsa 與Q-學習算法有相似的效果。

城市道路復雜,車流量較大,當從車輛出發點到目標點進行路徑規劃時,需要考慮很多因素。其中一個重要因素是避開車輛擁堵路段,那么對于城市交通環境下的路徑規劃,最短的路徑并不一定是最優的路徑。Sarsa 算法和Q-學習算法都能在訓練中選擇遠離擁堵路段的路徑。同時需要考慮在車輛運行過程中,在規劃路線中發生擁堵的情況。Sarsa 算法能夠探索更多可能性,在規劃路線路況發生變化時,能夠做出較快改變,選擇其他暢通路線。

強化學習算法需要在與環境的交互中通過學習策略來獲得最大化回報或實現特定目標,與其他路徑規劃應用場景不同,城市交通路徑規劃的成本較高,在智能體汽車訓練過程中,難免與障礙物發生碰撞。需要選擇較為安全的路徑規劃算法。Sarsa 算法會選擇更加保守的策略,在更新Q值的時候已經為未來規劃好了動作,能夠有效避免碰撞。在算法與框架結合過程中,存在算法不收斂和計算時間過長的情況。對于算法不收斂的情況,需要考慮到基礎算法自身特點,與Q-學習算法相比,Sarsa 算法對低獎勵值的狀態更加敏感,在選擇下一步動作時會規避風險,這是一個較為安全的行動策略,但在障礙物較為密集的情況下,智能體較低概率通過獎勵值低的狀態,導致在局部區域產生死循環,Dyna-Sa 算法無法收斂。通過調整系統參數來避免該情況,提高系統貪婪值使得智能體探索更多未知狀態,降低盲目選擇高獎勵的概率,最終減少算法不收斂的情況。具體參數選擇在仿真實驗部分詳細說明。

計算時間過長原因是規劃次數選擇不當。增加規劃次數有利于增加虛擬經驗,更好地幫助智能體選擇路徑。但過多規劃會占用大量系統內存,路徑規劃目的是更快地選擇一條安全的路徑到達目標狀態。規劃次數過多影響系統整體運行速度,這與期望目標產生沖突。在經過多次仿真實驗后得出:當規劃次數為30 時,算法表現較優。在仿真實驗中,由于建立的地圖模型規模較小,所以規劃次數選擇較少的數值。隨著模型復雜化,規劃次數應當相應增加。

3.3 算法復雜度分析

強化學習算法復雜度與狀態空間大小n和智能體訓練次數m相關,在Dyna 框架模擬運行的次數可以認為在每次訓練次數中,所以Dyna-Sa算法的時間復雜度為O(m(n-1))。

4 仿真實驗

實驗部分是將提出的算法和城市交通路徑規劃問題結合起來進行仿真實驗,通過與其他幾種經典的強化學習路徑規劃算法的實驗結果進行對比,來驗證該算法的性能。首先做出如下假設:不考慮智能車與障礙物邊界碰撞問題以及交通信號燈等外在因素,僅將道路邊界與擁堵車流作為障礙物。在本章中使用兩個實驗來證明提出算法的有效性。

4.1 仿真環境

本文代碼的運行基于Intel Core i7-7700HQ CPU@2.80 GHz 的處理器、NVIDIA GeForce GTX1060 的顯卡以及8 GB 內存的硬件環境,使用Windows 10 操作系統搭建軟件環境,實驗平臺是PyCharm,編程語言是Python。

本實驗驗證算法的地圖由柵格法建立。需要選擇合適的柵格尺寸,為保證規劃精度,同時確保智能體汽車的安全,將柵格尺寸設定為恰好與模擬智能車的外輪廓邊長相同。地圖中的障礙物固定生成,智能體汽車在柵格內可執行4 個動作,分別為上、下、左、右。

4.2 不同規劃步數收斂速度對比

首先使用柵格建立一個的無障礙地圖,智能體從初始狀態到達目標狀態。引入Dyna 框架的目的是將基于模型的強化學習和模型無關的強化學習結合起來。通過實驗做出規劃步數分別為0、5、50的步數變化曲線,如圖3。其中圖3中的N表示規劃步數,橫軸表示智能體的迭代次數,縱軸表示每次迭代智能體從初始狀態到目標狀態所需步數。

圖3 不同規劃步數收斂速度對比Fig.3 Convergence speed comparison of different planning steps

從實驗結果可以看出:隨著迭代次數的增加,圓形表示的規劃步數為50 的情況收斂速度最快,矩形代表的規劃步數為5 的情況次之,星形表示的無規劃的情況最慢。最終可以得出結論:智能體使用模型產生的模擬經驗越多,狀態值函數的更新次數越多,那么它的步數收斂的速度越快。

4.3 模擬地圖下的仿真

本章使用柵格構建一個模擬地圖,地圖尺寸為6×6,如圖4~5 所示。其中左上角五角星表示智能車初始狀態,右下角圓形表示目標狀態,地圖中間黑色矩形表示障礙物,白色區域為可移動區域。任務是找到一條路徑將智能車從初始狀態移動到目標狀態。

圖4 無障礙地圖模型Fig.4 Map model without obstacle

圖5 有障礙地圖模型Fig.5 Map model with obstacles

4.4 仿真參數選擇

使用Q-學習算法、Sarsa 算法和Dyna-Q 算法作為對比實驗,與新算法進行比較。所有實驗的相關參數如下:算法最大嘗試回合設置為100,學習率α,折扣因子γ,貪婪值。其中的學習率、折扣因子和貪婪值需要通過運行實驗調整參數獲得,實驗如下。

首先調整的是強化學習算法的學習率。學習率可以理解為算法的學習效率。當學習率較大時,算法的學習速度快,但是容易導致易損失值爆炸;當學習率較小時,算法的學習速度慢,同時會出現過擬合問題,算法的收斂速度變慢。由于仿真環境較為簡單,所以不需要設置動態變化的學習率便可使算法實現最優效果。通過實驗可以得到:當學習率小于0.01時,算法收斂速度過慢,影響算法性能;當學習率大于0.01時,梯度可能會在最小值附近來回震蕩,甚至導致無法收斂;當學習率等于0.01 時,收斂速度最優,同時無其他副作用。算法的學習率設置為0.01。

然后調整折扣因子尋找最優性能。折扣率能夠避免產生狀態的無限循環,當折扣率較小時,智能體更加在意短期回報;當折扣率較大時,長期回報變得更重要。通過實驗得出當折扣因子為0.9 時能夠確保收斂的速度較快,同時不會導致不收斂的方差,更加適合仿真實驗地圖環境。

由于使用Sarsa算法作為基礎算法,其采樣的策略和指導的策略都是采用的貪婪策略,這就涉及貪婪值的選取問題。為此,最優貪婪值需要設計實驗來獲取,保證算法性能,其他參數在貪婪值變化的過程中保持不變。在實驗過程中,貪婪度在(0,1)區間取值,一些經典文獻將貪婪值劃分成3 個區間,分別是(0,0.1]、(0.1,0.2]、(0.2,1)。將3 種不同貪婪度的Dyna-Sa 算法應用到有障礙地圖中,進行100 次迭代訓練,同時使用收斂速度和碰撞次數作為評價標準。最終可以得到如表1的結果。

從表1 中可以看出貪婪度處于(0.1,0.2]區間時,算法能夠表現出最優性能。在貪婪度處于(0,0.1]區間時,算法會選擇獎勵值最大的狀態,所以收斂速度較慢,同時碰撞次數較多,安全性較差。貪婪度處于(0.2,1)區間時,算法表現過于保守,智能體會在某個安全區域內停滯,導致算法無法收斂,同時碰撞次數較多。

最終將學習率設置為0.01,折扣因子設置為0.9,貪婪度值在仿真實驗的有障礙地圖設置為0.2,在無障礙地圖中設置為0.1。

獎勵R的設置如式(2)所示:

表1 不同貪婪度下的算法性能Tab.1 Algorithm performance under different greedinesses

仿真地圖環境較簡單,獎勵R的取值對實驗結果影響有限,所以選擇簡單的值便可實現算法功能。智能體在模擬地圖中移動時,未碰撞障礙物時獎勵值為0,碰撞到障礙物時獎勵值為-1,移動到目標點時獎勵值為2。

4.5 仿真實驗結果及分析

按照前面的參數設置,將4 種算法分別引入地圖中進行實驗。每個算法進行100 次迭代訓練,其中使用Dyna 框架的規劃次數為30,就是將智能體與模擬環境進行30次交互來獲得虛擬經驗。每個算法實驗重復10 次,然后取平均值作為實驗輸出數據。算法性能的評價標準為算法平均運行時間、平均碰撞障礙物次數、達到收斂所需回合和達到收斂所需時間。

無障礙地圖和有障礙地圖實驗結果如表2~3所示。從表2~3中的數據可以看出,使用Dyna框架的算法的各項數據都要優于未使用框架的算法,這就體現了規劃的高效性。在無障礙地圖的實驗中,Dyna-Q算法和Dyna-Sa算法性能相似。在有障礙地圖的實驗中,平均碰撞數、達到收斂回合和達到收斂時間方面,Dyna-Sa算法均要優于Dyna-Q算法,但在平均運行總時間方面,Dyna-Sa表現稍差。原因是Dyna-Sa算法是一種風險敏感算法,在學習初期,Dyna-Sa算法因躲避障礙物而放棄較近路徑,保證安全性,但會導致時間浪費,Sarsa算法同理。在多次學習后,Dyna-Sa算法得到的經驗會指導智能體選擇最優路徑,所需時間會逐漸縮短。綜合表中數據可以得出:Dyna-Sa算法從總體看較優于其他三種算法,在保證安全性的同時,能夠在較短時間內找到一條較優路徑,滿足城市交通路徑規劃這種特殊環境的要求。

表2 無障礙地圖實驗結果Tab.2 Experimental results on map without obstacle

表3 有障礙地圖實驗結果Tab.3 Experimental results on map with obstacles

圖6 和圖7 分別表示無障礙物和有障礙物環境下算法收斂情況,橫軸表示迭代次數,縱軸表示算法每次迭代結束時經過的步數。

圖6 無障礙物環境下算法收斂情況Fig.6 Convergence of algorithm in obstacle-free environment

圖7 有障礙物環境下算法收斂情況Fig.7 Convergence of algorithm in environment with obstacles

為了更好地展示算法性能,方便讀者閱讀,將整個迭代過程進行分割。在無障礙環境中,圖6(a)部分表示前25回合算法收斂情況,可以得出:所有算法在17 回合后都已經收斂;Dyna-Sa 算法和Dyna-Q 算法收斂速度相似,遠優于不使用Dyna 框架的算法。圖6(b)部分表示26 回合到100 回合的算法收斂情況,可以得出:所有算法都收斂,沒有異常情況出現。圖7(a)、(b)、(c)分別表示前30 回合、31~70 回合、71~100 回合有障礙環境算法收斂情況,所有算法都呈現同一趨勢:首先步數較少,然后突然升高,最終趨于平穩。原因是在有障礙物的環境中,智能體首先嘗試碰撞障礙物獲取環境狀態,步數較少,然后在躲避障礙物的過程,產生大量的步數,最終產生一條通往目標狀態的完整路徑,達到收斂狀態。Sarsa 算法在整個過程無法收斂;Q-Learning 算法在37回合后能夠達到收斂;Dyna-Q 算法和Dyna-Sa 算法分別在24 回合和18 回合達到收斂。Dyna-Sa 是一種風險敏感算法,所以迭代產生平均步數較多。

5 結語

針對城市交通路徑規劃問題,新算法Dyna-Sa 主要是以Dyna 為框架,使用Sarsa 的更新函數和決策方式,將模型無關和基于模型的算法結合的Dyna 框架向無模型的強化學習算法引入模型,使用學習到的經驗來訓練模型,同時利用模型來產生模擬的經驗,最后與從環境中直接學習的經驗兩者共同作用于值函數的更新。本文分析了城市交通路徑規劃的特殊性,比較了Sarsa 算法和經典強化學習算法Q-學習的特點,選擇了更為保守并且適合的Sarsa算法與Dyna框架結合。

仿真實驗表明智能體規劃次數越多,學習到的模擬經驗就越多,算法的收斂速度越快。第二個實驗將提出的算法與其他3種算法在仿真地圖上對比,結果顯示Dyna-Sa算法能夠有效避免障礙物,提高了路徑規劃的安全性,同時能夠保證快速找到一條符合要求的路徑,更加適合應用在城市交通環境中。

未來工作主要是研究算法在動態交通環境中表現,以及在獎勵值的設置中增加變量函數來提升算法整體的收斂速度,同時提高車輛路徑規劃過程中的安全性。