基于改進后的SegNet高分影像建筑物提取

沈晶靈 楊曉竹

摘 要:針對傳統監督分類對高空間分辨率遙感影像中建筑物信息提取精度較低的問題,改進SegNet模型,利用U-Net模型中的跳層連接結構補充SegNet模型中解碼器層的目標細節,加入空洞空間金字塔池化模塊增強網絡對多尺度目標的捕捉能力。利用改進后的SegNet、全卷積神經網絡、支持向量機和最大似然法,對遙感影像中建筑物的提取結果進行對比分析。以法國國家信息與自動化研究所航空圖像標記數據集為數據源,對分類結果進行定性和定量分析。在有限的迭代次數和實驗區域內,改進后的SegNet的Kappa系數在80%以上,總體精度超過90%,在邊緣細節的分類效果更精細,改進后的SegNet對遙感圖像中建筑物的提取效果更好、精度更高,具有可行性和有效性。

關鍵詞:SegNet;高分影像;建筑物提取;ASPP模塊

中圖分類號:P237 文獻標識碼:A 文章編號:1003-5168(2021)25-0006-05

High-Scoring Image Building Extraction Based on the Improved SegNet

SHEN Jingling YANG Xiaozhu

(College of Surveying and Mapping and Geographic Science, Liaoning University of Engineering and Technology,

Fuxin Liaoning 123000)

Abstract: In view of the low accuracy of building information extraction in high spatial resolution remote sensing images by traditional supervision classification, this paper improves the SegNet model, used the jumper connection structure in the U-Net model to supplement the target details of the decoder layer in the SegNet model, and adds ASPP module to enhance the network's ability to capture multi-scale targets.The results of the extraction of buildings in remote sensing imagery are compared using the improved SegNet, Full Convolutional Neural Networks, Support Vector Machine, and Maximum Likelihood Classification.Using the INRIA aerial image marker data set as the data source, through qualitative and quantitative analysis of the classification results, the improved SegNet Kappa coefficient is more than 80% in the limited iteration and experimental area, the overall accuracy is more than 90%, and its classification effect in the edge details is more fine.It is shown that the improved SegNet is more effective, more accurate and feasible for the extraction of buildings in remote sensing images.

Keywords: SegNet;high-scoring imagery;building extraction;ASPP module

高分辨率遙感圖像的特征識別和檢測是當前科學領域的研究熱點[1],其提取的信息內容豐富,包括地物信息與紋理信息[2]。近年來,大量學者對高分辨率遙感影像中的地物信息提取等問題進行了研究,并提出了K均值[3]、迭代自組織的數據分析法(Iterative Self-Organizing Data Analysis Method,ISODATA)[4]、面向對象的分類方法[5]、最大似然法[6]、最小距離法[7]以及支持向量機[8-9]等方法。然而,在空間分辨率較高的遙感圖像中,由于這些方法依賴于光譜特征,導致提取精度較低。隨著分辨率的提高,圖像中的噪聲信息越來越突出。異物同譜和同物異譜等現象給影像質量帶來的問題日益突出,給在高分辨率遙感圖像中進行目標精確提取造成了很大影響[2]。

隨著計算機硬件性能不斷提高,由KRIZHEVSKY A等[10]提出的AlexNet網絡,使得卷積神經網絡在2012年再次受到廣泛關注。AlexNet使用了一種基于LeNet[11]的更深層次的網絡結構,使用卷積層來表現圖像特征。LONG等[12]研究的全卷積神經網絡(Fully Convolutional Network,FCN)模型,使卷積神經網絡進入語義分割領域并得到廣泛應用與發展。FCN的突出特點在于接受任意大小的輸入,且有效地前向傳播產生相應的輸出。

寧宵等[13]提出利用U-Net模型,RONNEBERGER O等[14]提出利用SegNet模型和改進后的SegNet模型對遙感影像進行建筑物提取,對數據集進行模型訓練,然后進行遙感影像的預測,達到了建筑物提取的目的,最后通過提取結果進行對比分析。基于目前遙感影像豐富的地類信息和復雜的建筑物結構的問題,U-Net模型和SegNet模型在遙感影像的建筑物、道路以及水體等重要地物的提取方面取得了良好效果。

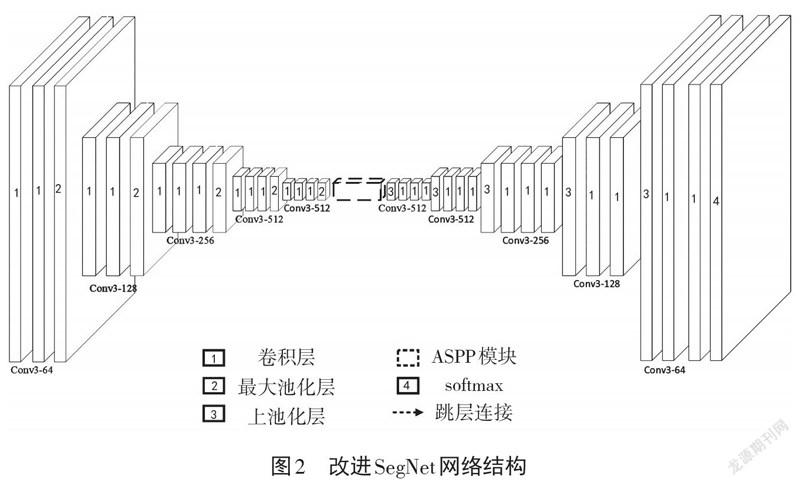

在此基礎上,對傳統的SegNet模型進行改進。結合U-Net模型優點,使用其中的跳層連接結構補充SegNet模型的解碼器層的目標細節,并在其中加入改進的ASPP模塊,加強捕捉多尺度目標的能力,得到改進后的SegNet模型。通過改進后的SegNet模型對高分辨率遙感影像中的目標建筑物進行精確提取,并與MLC、SVM和FCN算法進行比較。結構表明該算法提取的分類精度更高,邊緣細節更好,效果更佳。

1 研究方法

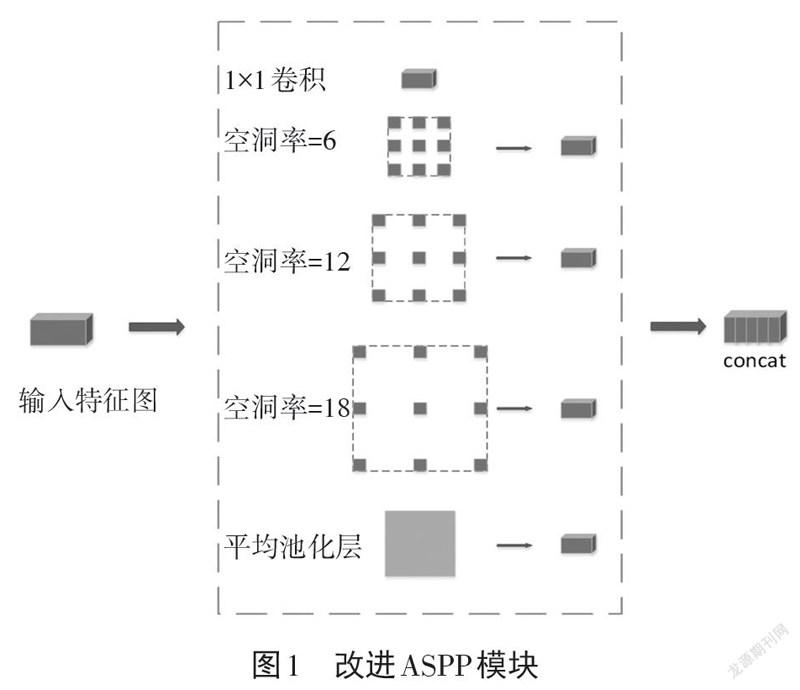

空洞空間金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)由CHEN L C等[15]在DeepLab v2網絡中提出,并在DeepLab v3中改進。圖1為DeepLab v3中的改進ASPP模塊。改進ASPP模塊中包含空洞卷積的空洞率分別為6、12、18,以及一個1×1卷積和一個全局平均池化層,且在每一個空洞卷積和全局平均池化層后添加一個1×1卷積,使得各自輸出的特征圖維度相同。不同大小的空洞卷積能夠捕捉多種尺寸的目標,增強網絡對不同尺寸建筑物的分割能力。DeepLab v2中,ASPP模塊采用4種不同空洞率的空洞卷積。但是,當空洞卷積的空洞率接近輸入特征圖尺寸時,空洞卷積只有中間部分的權重對特征圖有效。DeepLab v3在ASPP中加入了一個全局平均池化層為1×1的卷積核。1×1卷積用于捕捉更細小的目標,而全局平均池化能夠整合整個特征圖的信息,有效解決了上述問題。最后,將空洞率為6、12、18的空洞卷積、1×1卷積和全局平均池化層得到的特征圖進行concat操作。為了使其與輸入相當,使用1×1卷積調整輸出特征圖的維度。

SegNet在卷積層部分全部采用尺寸為3×3的卷積核,導致SegNet對不同尺度對象的捕捉能力存在欠缺。使用SegNet網絡進行建筑物和非建筑物二分類,實現遙感影像建筑物提取。它的上池化操作使其在小尺寸建筑物上提取效果較好,但在大尺寸建筑物上則提取結果不連續。同時,由于SegNet的解碼器沒有引入編碼器階段的特征圖,導致丟失一定的細節。為了增強網絡對多尺度目標的捕捉能力,在SegNet中加入改進的ASPP模塊,同時通過加入U-Net中的跳層連接結構來補充解碼器層的目標細節。

針對SegNet對不尺度目標信息捕捉能力有限,對大尺寸建筑物提取不連續的問題,提出改進SegNet網絡結構,改進后的SegNet網絡結構如圖2所示。其中,Conv3-64是利用大小為3×3的卷積核,設置卷積層深度為64,整體網絡結構采用對稱形式的編碼器-解碼器結構。編碼器層與VGG16的卷積層部分完全相同。13個層主要是卷積層、最大池化層和ReLU激活函數。5個最大池化層分為5組,每組的卷積層深度分別為64、128、256、512、512,均采用大小為3×3的卷積核。解碼器與編碼器相對稱,同樣分為5組,卷積層的深度和卷積核的尺寸也相同。不同的是,解碼器將最大池化層對應替換為上池化層,以將特征圖恢復至輸入大小。在編碼器與解碼器層中間則是改進的ASPP模塊,用多個空洞率的空洞卷積增強網絡對多尺度目標的捕捉能力。改進SegNet在使用上池化來恢復特征圖大小的同時,引入U-Net中提出的跳層連接結構。該結構能夠將編碼器得到的特征圖采用concat操作與解碼器對應位置的特征圖結合,恢復在編碼器階段進行最大池化操作時丟失的信息。最后,通過softmax分類器[16]計算每個像素屬于每一個類別的概率,從而判斷該像素的所屬類別。

2 試驗與討論

2.1 數據介紹與組織

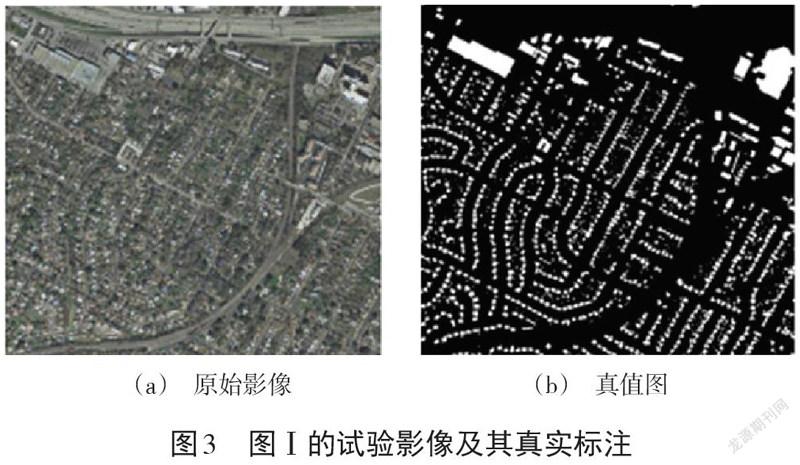

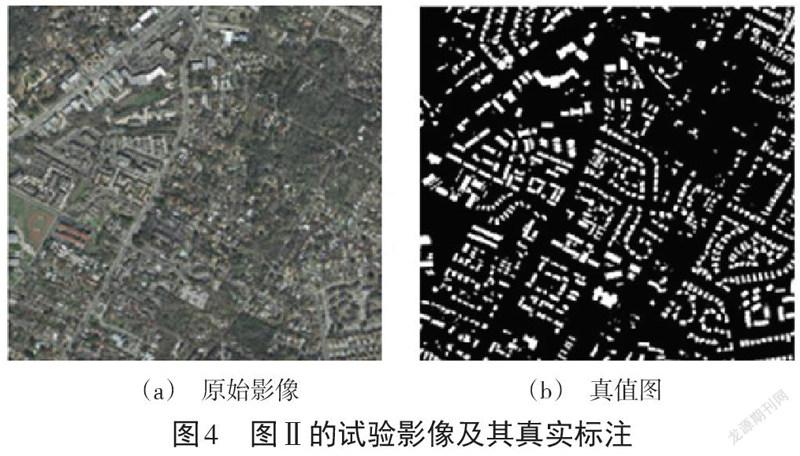

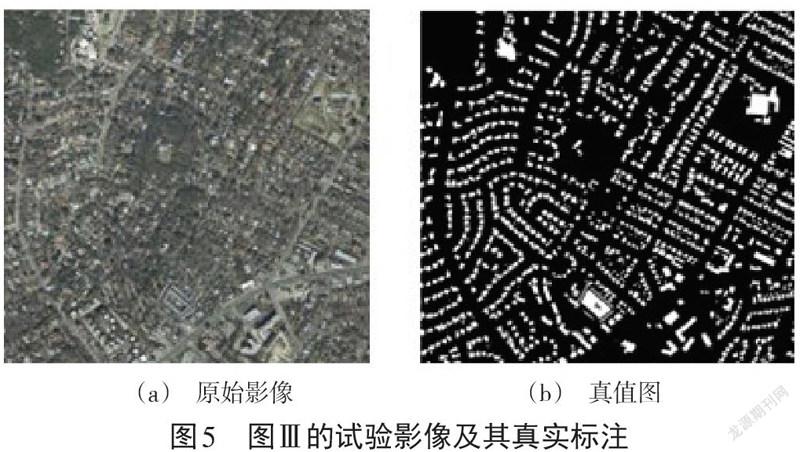

本次試驗選取了法國國家信息與自動化研究所的數據集(INRIA Aerial Image Labeling Dataset,IAILD)。該數據集所采用的遙感影像為美國、澳大利亞兩處的居民地,并標注出建筑物與非建筑物,航空正射校正影像的空間分辨率是0.3 m,覆蓋范圍從人口密集地區(如舊金山的金融區)延伸到高山城鎮地區(如奧地利蒂羅爾州的列昂斯),總面積為810 km2。同時法國國家信息與自動化研究所的數據集航空影像標注數據集也解決了遙感中的一個核心問題,即航空影像的自動像素化標注。本文選取3幅影像Ⅰ、Ⅱ、Ⅲ作為試驗的測試數據,其原始影像和對應的真值圖分別如圖3、圖4和圖5所示。

2.2 試驗環境與參數設置

本文試驗環境為Window 7操作系統,基于Keras訓練網絡。硬件方面CPU為Intel(R) Core i7 4790,GPU為Nvidia GTX1060 6G,選取MLC、SVM、FCN作為對比算法。訓練參數方面,均采用Adadelta[17]作為優化器,epoch設置為100,batch size設置為3。

2.3 試驗結果與分析

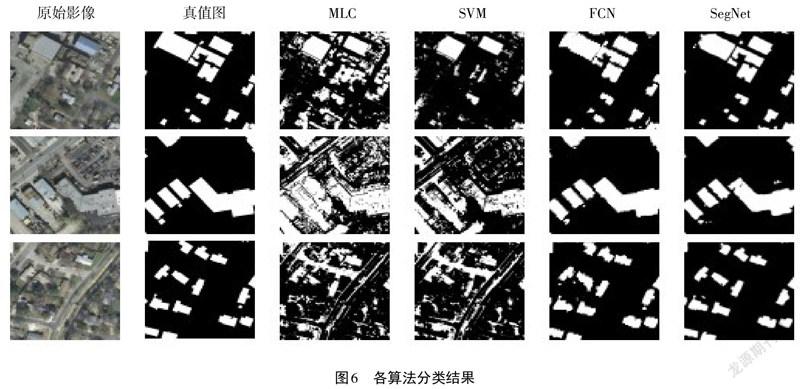

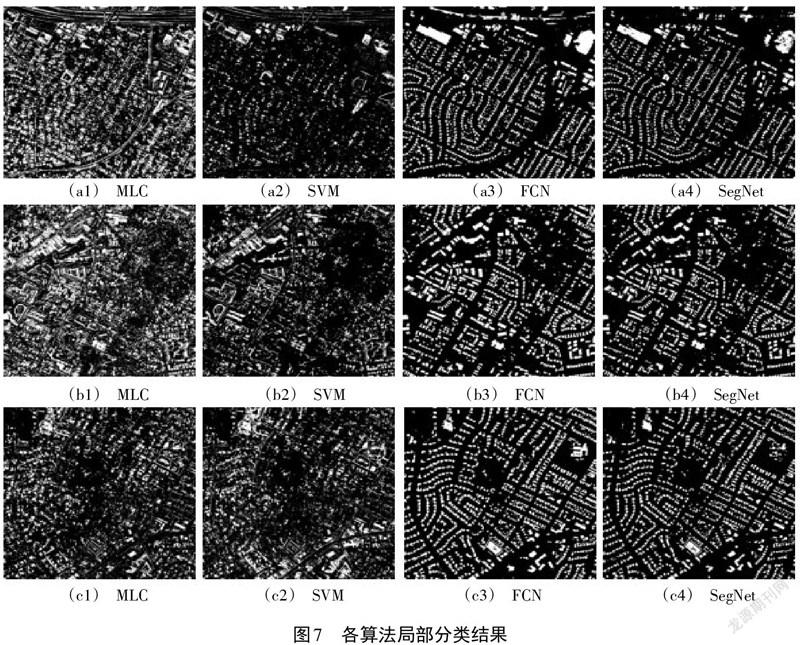

圖6為MLC、SVM、FCN和改進后的SegNet在a、b、c三幅影像的分類結果。由圖6可以看出:MLC和SVM對高空間分辨率遙感影像中建筑物的提取效果不理想,且噪聲多,在非建筑物的人造設施上出現了較為嚴重的錯分現象;作為深度學習算法的FCN和改進后的SegNet的分類效果要明顯好于MLC和SVM,二者對非建筑物的人造設施錯分現象大大減少,整體分類效果較好;改進后的SegNet與FCN相比,其在邊緣細節的分類效果上更優,對建筑物的邊緣把控得更好(見圖7),FCN則在大型建筑物的連續性上更有優勢。

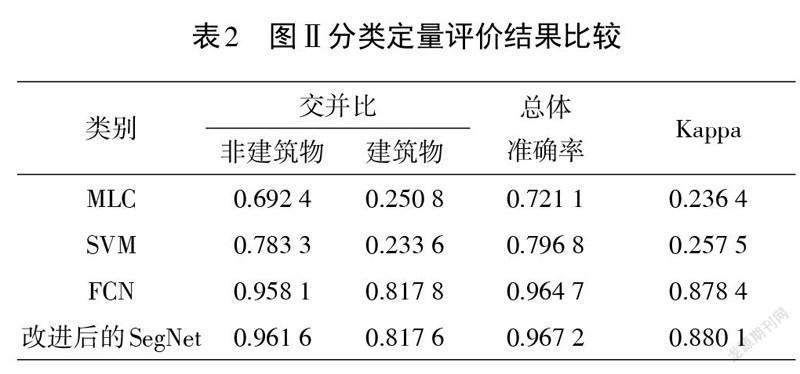

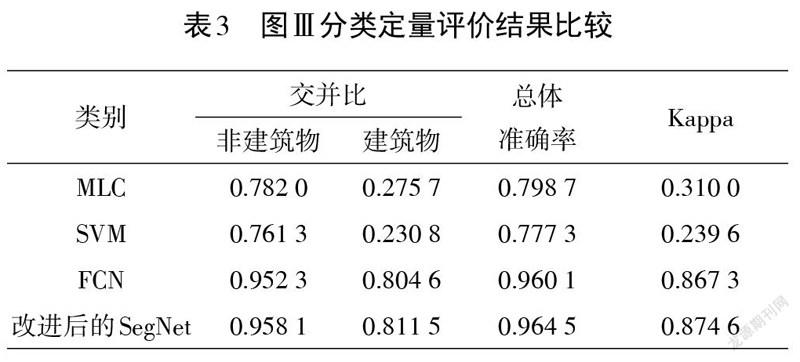

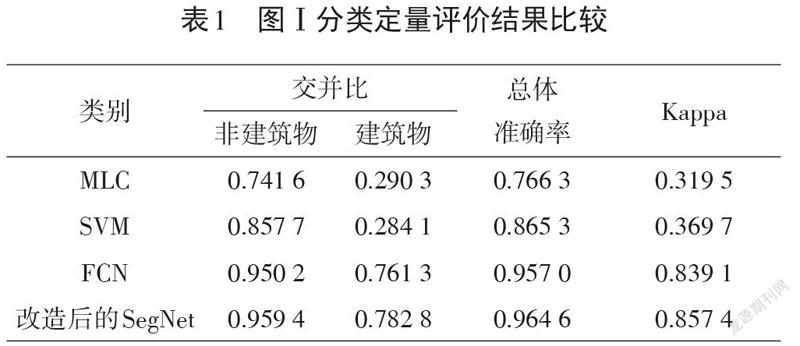

采用交并比(Intersection over Union,IoU)、Kappa和總體準確率(Overall Accuracy,OA)對分類結果進行定量評價。

交并比IoU的計算公式為:

IoU=TP/TP+FP+FN? ? ? ? ? ? ? ? ? ? (1)

式中:[TP]代表正確的分類;[FP]代表錯誤分類;[FN]代表泄漏分類。表1、表2以及表3分別表示各個算法在3張影像上的分類準確率。

由表1可以看到,在每個評估指標中,改進后的SegNet算法測試結果明顯高于其他3種分類算法。在表1中,FCN比MLC、SVM的Kappa系數和總體準確率分別提高51.96%、46.94%和19.07%、9.17%,本文算法比FCN算法的Kappa系數和總體準確率分別提高了1.83%和0.76%;在表2中,FCN比MLC、SVM的Kappa系數和總體準確率分別提高了64.20%、62.09%和24.36%、16.79%,本文算法比FCN算法的Kappa系數和總體準確率分別提高了0.17%和0.25%;在表3中,FCN比MLC、SVM的Kappa系數和總體準確率分別提高了55.73%、62.775%和16.14%、18.28%,本文算法比FCN算法的Kappa系數和總體準確率分別提高了0.73%和0.44%。

3 結論

①以IAILD作為試驗數據,使用改進后的SegNet圖像語義分割算法對遙感影像中的目標建筑物進行精確提取。將其與FCN、SVM和MLC這3種方法進行對比分析,得出以下結論:SVM和MLC兩種分類算法在高分辨率遙感影像中提取出的不同類別建筑物之間分界線不明顯,邊緣模糊,分類精度較低;從試驗結果可知,這兩種分類算法的Kappa系數和總體準確率均較低,不適合高空間分辨率遙感影像對建筑物的精確提取。

②在利用改進后的SegNet和FCN兩種分類算法對高空間分辨率遙感影像進行建筑物分類提取的結果中,兩者的Kappa系數均在80%以上,總體準確率均超過90%,但相比之下改進后的SegNet算法所獲得的結果在邊緣細節的分類效果上更優,對建筑物的邊緣把控得更好。

綜上所述,通過對以上4種分類算法所得到的結果進行定性和定量分析,在有限的迭代次數及試驗區域內,改進后的SegNet對目標建筑物的提取效果更好、精度更高,具有一定的可行性和真實有效性。盡管SegNet算法現處于起步階段,但可以預見,未來幾年,在該算法的基礎上將會出現更加優秀、更加靈活的深度學習算法與更加符合科技發展的新的研究路線。

參考文獻:

[1]趙英時.遙感應用分析原理與方法[M].北京:科學出版社,2003:165-168.

[2]元晨.高空間分辨率遙感影像分類研究[D].西安:長安大學,2016:16-21.

[3]王慧賢,靳惠佳,王嬌龍,等.k均值聚類引導的遙感影像多尺度分割優化方法[J].測繪學報,2015(5):526-532.

[4]沈照慶,舒寧,龔衍,等.基于改進模糊ISODATA算法的遙感影像非監督聚類研究[J].遙感信息,2008(5):28-32.

[5]LOBO A,CHIC O,CASTERAD A.Classification of mediterranean crops with multisensor data:per-pixel versus per-object statistics and image segmentation[J].International Journal of Remote Sensing,1996(12):2385-2400.

[6]駱劍承,王欽敏,馬江洪,等.遙感圖像最大似然分類方法的EM改進算法[J].測繪學報,2002(3):234-239.

[7]朱建華,劉政凱,俞能海.一種多光譜遙感圖象的自適應最小距離分類方法[J].中國圖像圖形學報,2000(1):24-27.

[8]張錦水,何春陽,潘耀忠,等.基于SVM的多源信息復合的高空間分辨率遙感數據分類研究[J].遙感學報,2006(1):49-57.

[9]FOODY G M,MATHUR A.A relative evaluation of multiclass image classification by support vector machines[J].IEEE Transactions on Geoscience and Remote Sensing,2004(6):1335-1343.

[10]KRIZHEVSKY A,SUTSKEVER I,HINTON G E.ImageNet classification with deep convolutional neural networks[J].Communications of the ACM,2017(6):84-90.

[11]LECUN Y,BOTTOU L.Gradient-based learning applied to document recognition[J].Proceedings of the IEEE,1998(11):2278-2324.

[12]LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015(4):640-651.

[13]寧霄,趙鵬.基于U-Net卷積神經網絡的年輪圖像分割算法[J].生態學雜志,2019(5):1580-1588.

[14]RONNEBERGER O,FISCHER P,BROX T. U-Net:convolutional networks for biomedical image segmentation[M].New York:Springer Cham,2015:109-112.

[15]CHEN L C,PAPANDREOU G,KOKKINOS I,et al.DeepLab:semantic image segmentation with deep convolutional nets,atrous convolution,and fully connected CRFs[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2018(4):834-848.

[16]蔣怡,黃平,董秀春,等.基于Softmax分類器的小春作物種植空間信息提取[J].西南農業學報,2019(8):1880-1885.

[17]MATTHEW D Z.ADADELTA:an adaptive learning rate method[J/OL].Computer Science,2012[2021-07-10].https://www.oalib.com/paper/4035734#.YYzJEflT8YE.

3985501908239