基于改進的神經網絡算法在裝配過程中的應用

陸坤龍 王 一

(華北理工大學電氣工程學院,河北 唐山063200)

在裝配過程中,產品工件笨重且組裝環節繁多,加上測量定位方面的精度問題,導致機器人裝配效率和精度低下。[1-2]。應運而生的是多視覺信息融合技術應用在了機器人自動裝配流程中解決機器人裝配過程中的問題。利用多個視覺傳感器對工件進行不同方位的定位,進而引導機器人執行相關動作,在這個過程中涉及到把各個傳感器的有用信息融合到統一坐標系下的問題[3-5]。目前,一些改進的新算法實質上是主要通過各種不同的方法共同作用來實現相互加強的目的。例如,模糊神經網絡方法不僅增強了神經網絡的算法魯棒性,還填補了模糊邏輯自適應能力的缺點[6]。雖然現在可以集成許多不同類型的傳感器來進行信息綜合,彌補單個傳感器信息不足的問題,但是,融合過程卻浪費了很多系統資源。文獻[7]提出了一種改進的D-S 參數理論算法,該方法比原算法多了一個距離因子,這增強了傳感器采集數據時的穩定性。文獻[8]提出了基于任務的神經網絡多傳感器數據融合的新方法,該方法在全面比較和分析了遙控機器人執行不同任務過程中的效果后,進而優化了神經網絡算法。結合本文研究內容特點,針對設計的視覺輔助系統采用改進型自適應BP 神經網絡算法對多個視覺傳感器采集到的視覺信息進行融合,從而為機器人提供視覺信息。

1 視覺輔助結構設計

本文主要對柔性裝配系統的視覺感知部分進行了設計。視覺感知系統主要有十字結構、光視覺傳感器和雙目視覺傳感器。雙目視覺傳感器作為待裝配物的遠視場測量裝置,得到待裝配物的遠位姿信息后,引導執行機構到達合適的裝配位置,之后啟動十字結構光傳感器對待裝配物進行二次位姿測量,其測量的結果與雙目視覺傳感器測量的位姿結果相融合,得出待裝配物的精確位姿信息,進而二次引導機器人進行準確的裝配動作。

2 視覺信息融合算法

2.1 自適應BP 神經網絡信息融合算法

本文提出的自適應改進BP 神經網絡信息融合算法不僅考慮到了原始BP 神經網絡的學習性能的高低,還優化了原始算法的復雜程度以及應用性能等問題。針對傳統自適應算法的不足之處,本文的改進型BP 神經網絡新方法采用了差異化的學習率,不僅能夠動態地調整著不同節點之間的連接權重數值,還能使得收斂誤差函數所需的時間減少。在改進的BP 神經網絡中,閾值是隨著權值變化的,并且將變化的閾值引入到權值的矩陣中進行再計算,形成一個反饋閉環。自適應BP 神經網絡算法實現過程如下:

第一步,算法初始化。

在軟件里面確定好三層的神經網絡后,再開始選擇合適的參數預設值。要進行設定的參數有:學習速率,誤差精度,權重矩陣。設定好后對這些參數進行訓練學習。

第二步,正向傳播誤差的求取。

首先把準備訓練的樣本進行分組,然后按照分組順序對樣本進行訓練,并記下訓練出的正向傳播誤差。

第五步,使用新權重進行正向傳播訓練,并更新網絡誤差。

第六步,BP 網絡迭代學習完成后,記錄最終值。

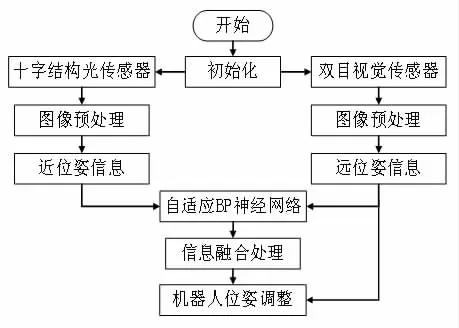

2.2 基于視覺信息融合的位姿估計方法設計

本文采用的是兩個組合式視覺傳感器進行數據采集的,雙目視覺傳感器位于機械臂之外,相對機器人基座是固定的,遠距離測量范圍比較大,處于0.3m-5m 之間。十字結構光傳感器是屬于近距離測量,測量范圍處于0.1m-0.3m 之間。雙目視覺傳感器的作用是預先測量被測物位姿信息引導機器人達到待裝配位置,然后待十字結構光傳感器也測量出待裝配物信息后,結合近測量信息進行信息融合,從而對近距離測量的結果進行一個精度補償。繼續配合十字結構光傳感器對機器人進行姿態調整,直到裝配精度符合預期值。其具體的算法流程如圖1 所示。

圖1 視覺信息融合算法流程圖

3 裝配測量實驗及結果分析

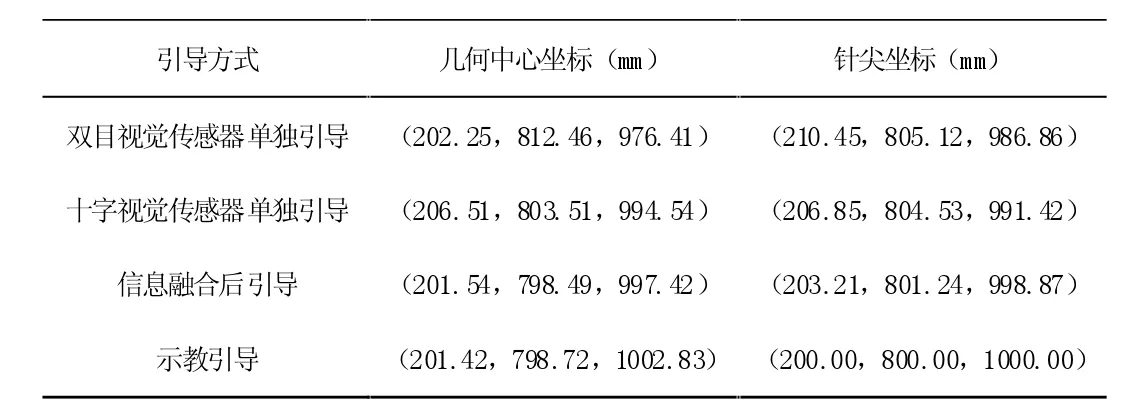

實驗平臺由KUKA 機器人及控制系統、十字結構光傳感器、雙目視覺傳感器、機器人末端工具鉛筆、標準方塊、計算機和三維位移臺組成。實驗的檢測結果如表1 所示,以示教對準結果為真實值,其他方式的引導結果為測量值,并且所有坐標結果都是相對于機器基坐標系而言的。

機器人在不同的引導方式下,從表1 中可以看出雙目視覺單獨引導效果最差,因為受到實驗條件和光線影響使得圖像配準效果欠佳,得到的標準塊的位姿信息不是太精確;十字結構光傳感器單獨引導精度明顯比雙目視覺引導精度要好,因為與雙目視覺傳感器相比,除了實驗條件一樣的情況下,十字結構光傳感器能夠自身打出激光線,形成自己獨有的特征線,有效的降低了外界光線對圖像處理過程中的干擾;信息融合后的引導精度最接近于示教引導效果,這也說明了本文視覺信息融合方法的有效性。

表1 對準實驗數據

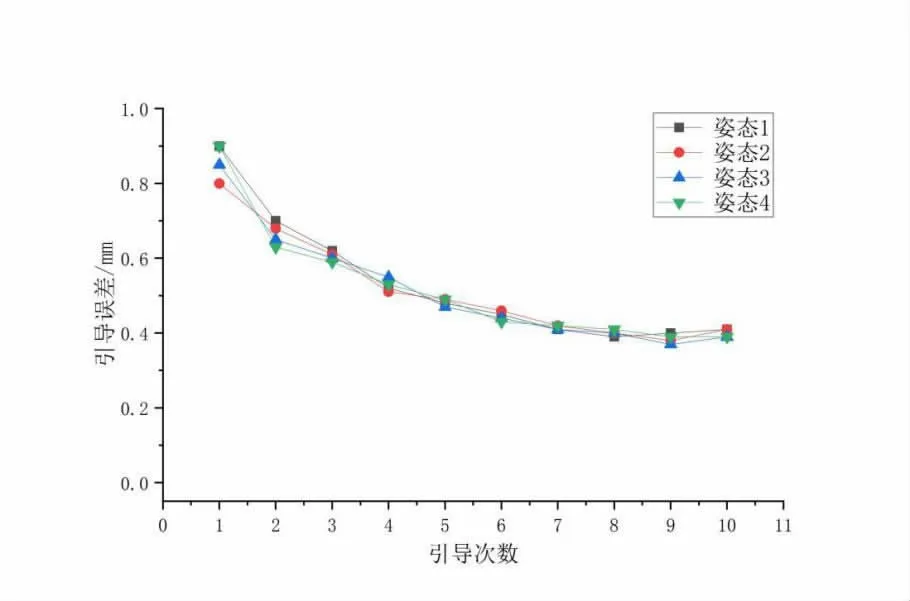

在驗證了視覺信息融合方法有效性的基礎之上,為了更好的說明其性能,再驗證其引導誤差的收斂性。本文利用位移臺對標準塊進行多次位置改變,其幾何中心也會隨之改變,每次改變標準塊姿態之后,用視覺信息融合方法對其對準性進行驗證。記錄標準塊在不同位姿下的引導次數和每次引導對準數據,本次實驗對四種不同姿態下的標準塊進行對準實驗,具體數據如圖2 所示。

把示教的數值當成0 基線數值,那么每次引導的效果都是相對于基線來說的,通過擬合曲線可以看出,隨著擬合引導次數的增加,也就是機器人調整姿態次數的增加,引導誤差越來越趨近于基線,每種姿態下的測量誤差基本都在距離基線0.41mm 處穩定下來。這說明整個系統重復運作引導性能較好,融合算法具有良好的魯棒性能。

圖2 引導誤差曲線

4 結論

本文針對機器人裝配領域一直以來存在的裝配精度不高、裝配效率慢、次品率多等問題,制定了合理的視覺測量系統方案,為機器人提供精確的實時位姿引導信息。為了使視覺信息得到充分利用和提高裝配精度,提出了一種基于自適應BP 神經網絡的視覺信息融合算法。實驗結果表明融合算法引導結果最接近于示教結果,體現了本文提出的視覺信息融合算法的準確性和魯棒性能。