基于深度學(xué)習(xí)的超聲白內(nèi)障檢測算法

王勇

(四川大學(xué)計算機學(xué)院,成都610065)

0 引言

白內(nèi)障是因為眼睛水晶體混濁而造成視力缺損的疾病,可能進犯單眼或雙眼。癥狀包含彩度降低、視線模糊、光源產(chǎn)生光暈、無法適應(yīng)亮光,以及黑暗環(huán)境下視覺障礙。該病為全球半數(shù)眼盲及33%視力受損病例的原因[1],及早發(fā)現(xiàn)和治療可減少白內(nèi)障患者的痛苦并防止視力障礙到眼盲的轉(zhuǎn)變。然而,受過訓(xùn)練的眼科醫(yī)生的專業(yè)知識對于白內(nèi)障臨床檢查至關(guān)重要,由于潛在的成本問題,這可能會使大多數(shù)人都難以得到早期干預(yù)導(dǎo)致眼疾加重。在基層和偏遠(yuǎn)山區(qū)的醫(yī)療機構(gòu)中,傳統(tǒng)的超聲診斷往往具有設(shè)備但沒有人才的困境。由于超聲診斷結(jié)果的主觀性強,可重復(fù)性差,不同機構(gòu),不同人員的評價結(jié)果具有很大的同質(zhì)性和客觀性偏差,所以需要有經(jīng)驗且專業(yè)的超聲專家提供診斷。但是,專家受時間和地域因素的影響,只能為極其有限的少數(shù)病患群體提供超聲診斷服務(wù)。因此,計算機輔助診斷避免了許多此類問題,并且正在作為常規(guī)閱讀的替代和補充方法而受到越來越多的研究者的重視[2]。因此本文著手于超聲圖像,利用深度神經(jīng)網(wǎng)絡(luò)對圖像或圖像中病變進行分類。

1 相關(guān)工作

現(xiàn)有的大量白內(nèi)障檢測系統(tǒng)所使用的特征提取與疾病檢測算法,采用的分類方法都是基于傳統(tǒng)的機器學(xué)習(xí)的方法。主要是采用支持向量機,使用支持向量機分類,適用于樣本量少的訓(xùn)練[3]。因此適用于樣本量小的醫(yī)學(xué)圖像范疇,但需要人工手動提取相關(guān)特征。

目前也有部分是只基于深度學(xué)習(xí)的方法,使用裂隙燈圖像和視網(wǎng)膜圖像等高質(zhì)量圖像進行分類。然而拍攝裂隙燈圖像[4]和視網(wǎng)膜圖像[5]等高質(zhì)量圖像的儀器造價高昂,通常偏遠(yuǎn)地區(qū)和基層醫(yī)院沒有此類裝備。相較于裂隙燈圖像和視網(wǎng)膜圖像等高質(zhì)量圖像,超聲向一定方向傳播,而且可以穿透物體,如果碰到障礙,就會產(chǎn)生回聲,不相同的障礙物就會產(chǎn)生不相同的回聲,人們通過儀器將這種回聲收集并顯示在屏幕上,可以用來了解物體的內(nèi)部結(jié)構(gòu)。并且B 超檢查的價格也比較便宜,又無不良反應(yīng),可反復(fù)檢查,可以獲得比較清晰的眼球不同方向的斷面像,足以用來判別白內(nèi)障的病狀。采用的神經(jīng)網(wǎng)絡(luò)的分類的方法,不需要人工手動提取特征,只需要將大量的樣本送進神經(jīng)網(wǎng)絡(luò)中,讓神經(jīng)網(wǎng)絡(luò)自己學(xué)習(xí),自動地提取特征,來進行分類,分類效果更加準(zhǔn)確。

2 數(shù)據(jù)采集

我們建立一個交互式的共享白內(nèi)障超聲數(shù)據(jù)庫。該數(shù)據(jù)庫包含正常人,白內(nèi)障和各種眼疾患者的高質(zhì)量B 型超聲圖,并在專家的指導(dǎo)下建立多維細(xì)粒度的患者分析數(shù)據(jù)。我們在采集階段通過醫(yī)院采集了“0-7”類8 種眼病的圖片,考慮到收集的數(shù)據(jù)集中許多眼睛樣本都包含多種疾病,因此將收集到的數(shù)據(jù)集進行排列并將其分為三類。

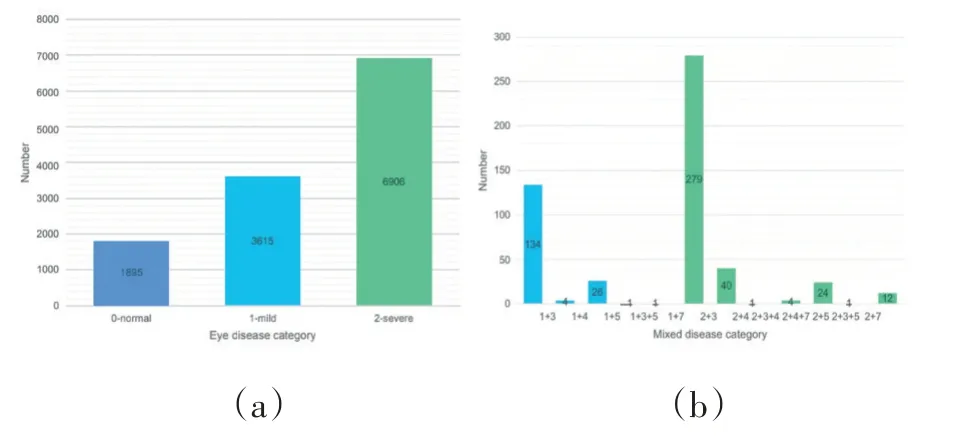

如圖1(a)所示,屬于“0”類別(正常眼睛)的圖像為1,895 張,屬于“1”類別(輕度白內(nèi)障)的圖像為3,615張,屬于“2”類別(為白內(nèi)障)的圖像為6,906 張。圖1(b)顯示了混合疾病類別的分布。“1+3”的值等于134,這意味著有134 例眼睛同時患有1 型白內(nèi)障和3 型玻璃體混濁。為了平衡樣本的正負(fù),我們隨機選擇了1865 只正常眼,1866 例輕度白內(nèi)障眼(包括166 種混合疾病)和1864 例嚴(yán)重白內(nèi)障眼(包括161 種混合疾病)進行訓(xùn)練和測試。

圖1 數(shù)據(jù)集統(tǒng)計

3 白內(nèi)障檢測算法

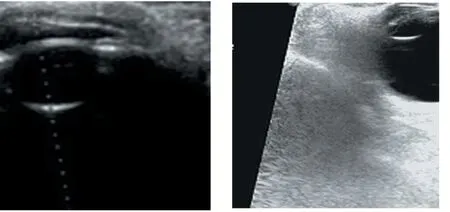

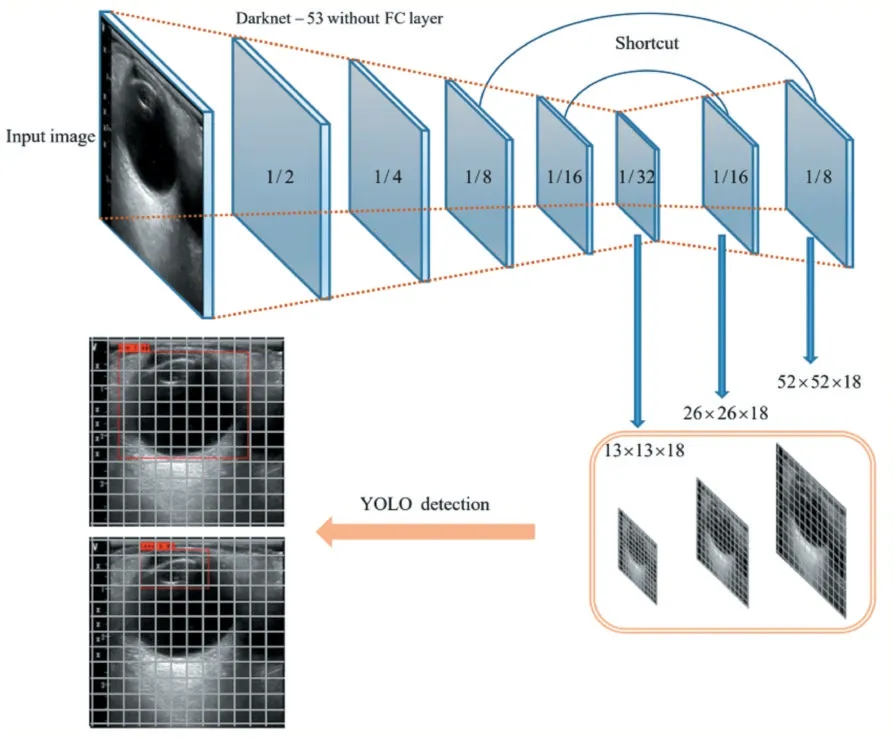

我們提出了一種深度學(xué)習(xí)模型,框架概述圖說明了我們的流程,其中分為兩個模塊(1)區(qū)域選擇模塊,使用YOLOv3[6];(2)分類模塊包含深層網(wǎng)絡(luò)DenseNet-161[7]提取的高層特征。我們的模型需要兩步完成訓(xùn)練:①我們使用YOLOv3 如圖2 所示,檢測出B 超圖片中我們需要的信息——眼球和晶狀體,然后成對將眼球和晶狀體圖像輸入深度學(xué)習(xí)模型。這樣幫助我們同時從成對的白內(nèi)障分類圖片中,學(xué)習(xí)有判別的表示,其中包含相同類別的相似眼球和晶狀體圖像,以及不同類別的不相似圖像;②我們將成對的晶狀體和眼球圖片放入分類模塊中提取他們的深度特征,并訓(xùn)練成一個分類器。

圖2 OpenCV裁剪圖

3.1 基于目標(biāo)檢測的區(qū)域選擇模塊

原始的超聲檢查圖像包含了整個眼部及眼部周圍的數(shù)據(jù),眼部周圍數(shù)據(jù)十分復(fù)雜,噪聲干擾極大,對病狀識別的準(zhǔn)確率有巨大影響,所以識別系統(tǒng)需先對輸入的圖像進行眼球目標(biāo)檢測。最開始我們使用OpenCV 將圖片轉(zhuǎn)化為灰度圖,然后將圖像二值化提取輪廓。再通過最小內(nèi)接矩形裁圖,但是效果極差,無法準(zhǔn)確框定眼球。后來改用目標(biāo)檢測網(wǎng)絡(luò),通過對大量的原始圖像進行邊框標(biāo)注的眼球數(shù)據(jù)來學(xué)習(xí)位置信息。

我們采用YOLOv3 作為目標(biāo)檢測網(wǎng)絡(luò)。如圖3 所示,YOLOv3 對輸入圖片進行了粗、中、細(xì)網(wǎng)格劃分,以便分別實現(xiàn)對大、中和小物體的預(yù)測。特征提取采用DarkNet-53[6],即在全卷積的基礎(chǔ)上,引入Residual 殘差結(jié)構(gòu)[8],在減小深層網(wǎng)絡(luò)訓(xùn)練難度的同時,明顯提升精度。此外,訓(xùn)練前使用K-means 算法[9],對預(yù)處理圖像進行聚類處理,并且獲得較好的先驗框。并且引入RCNN 系列[10]的anchor 錨點機制,YOLOv3 的anchor 幫助網(wǎng)格預(yù)測方法速度更快且穩(wěn)定。然后通過NMS[11]處理,框定準(zhǔn)確度最高的框。YOLOv3 憑借其出色的穩(wěn)定性和高效性,可以在極短的時間內(nèi)快速進行區(qū)域定位,并且容易實現(xiàn)輕量化。

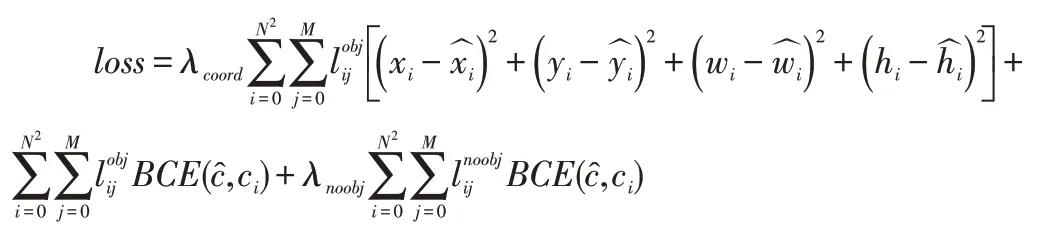

最初我們使用原始YOLOv3 直接同時框定眼球和晶狀體并且實現(xiàn)分類,但是眼球以及晶狀體的框定結(jié)果很差,并且完全無法進行正確分類,所以我們對原始的YOLOv3 進行了小小的改動。我們使用了3773 帶注釋的眼球和晶狀體圖像作為訓(xùn)練輸入,并將所有對象歸為一類,分別訓(xùn)練兩個YOLOv3。首先使用K-means 提取先驗框,然后使用YOLOv3 本身進行學(xué)習(xí)。為了更好地定位學(xué)習(xí)框,在計算損失時省略了類損失,因為只有一類。損失函數(shù)如下所示:

圖3 YOLOv3結(jié)構(gòu)圖

3.2 基于DenseNet-161的分類模塊

DenseNet-161 借用residual 殘差結(jié)構(gòu),將不同層的網(wǎng)絡(luò)稠密連接,確保網(wǎng)絡(luò)中最大的信息流通。DenseNet 這種稠密的連接方式比傳統(tǒng)的卷積網(wǎng)絡(luò)需要更少的參數(shù),并同時改善整個網(wǎng)絡(luò)的信息流和梯度,每個圖層都與損失函數(shù)和原始信號連接,使網(wǎng)絡(luò)更容易訓(xùn)練;此外,DenseNet 密集的連接具有正則化效應(yīng),減少小規(guī)模數(shù)據(jù)集的過擬合。向前:每一層都可以看到所有的之前的輸入,對于網(wǎng)絡(luò)已經(jīng)學(xué)習(xí)到的“知識”(即已有feature map),以及原始輸入,都可以直接連接到,然后再添加自己的“知識”到全局知識庫。鼓勵了特征的重用,特征重用就可以減少不必要的計算量。另外,多層之間可以很好地進行交互,每一層都接受前面所有層的輸出,具有多層特征融合的特性。向后:跳躍結(jié)構(gòu),可以很近地連接到最后的loss,訓(xùn)練起來很容易,直接接受最終loss 的監(jiān)督,深層監(jiān)督,解決梯度消失的問題,并且,能起到正則化的作用緩解過擬合。DenseNet-161 準(zhǔn)確度和效率在分類網(wǎng)絡(luò)中都名列前茅,能夠幫助實現(xiàn)高效精準(zhǔn)判別。

4 實施細(xì)節(jié)及實驗結(jié)果

4.1 實施細(xì)節(jié)

對YOLOv3 輸出帶有bbox 的圖像進行裁剪,然后對短邊進行上下均勻零填充,使圖片正方形化。然后將所有圖片規(guī)范化到128×128 的統(tǒng)一尺度,進行隨機水平翻轉(zhuǎn)、隨機左右翻轉(zhuǎn)0-10 度、亮度調(diào)節(jié)、規(guī)范化操作。將有限的圖片進行10 倍的擴充,同時翻轉(zhuǎn)旋轉(zhuǎn)等操作大大提升了網(wǎng)絡(luò)的魯棒性。一組圖像集的均值和標(biāo)準(zhǔn)差可以很好地概括這組圖像的信息和特征。均值就是一組數(shù)據(jù)的平均水平,而標(biāo)準(zhǔn)差代表的是數(shù)據(jù)的離散程度。規(guī)范化使神經(jīng)網(wǎng)絡(luò)在訓(xùn)練的過程中,梯度對每一張圖片的作用都是平均的,也就是不存在比例不匹配的情況,以保證所有的圖像分布都相似,也就是在訓(xùn)練的時候更容易收斂。

本實驗中使用的數(shù)據(jù)集包括5,595 張圖像。其中5,045 個用于訓(xùn)練,550 個用于測試。為了開發(fā)和評估模型,將總共5,045 只B 超檢查眼隨機分為內(nèi)部訓(xùn)練集和內(nèi)部驗證集。通過隨機提取每個數(shù)據(jù)庫中90%和10%的記錄來生成內(nèi)部訓(xùn)練和驗證集。然后,在YOLOv3 之后,我們可以獲得5,595 個眼球和5,595 個晶狀體圖像。

YOLO-v3 配置如下:img-size 416, batch-size 16,iou-thres 0.5, conf-thres 0.001, nms-thres 0.5, class 1,(SGD)lr 0.01,momentum 0.9,weight-decay 0.0005。由于COCO 和ImageNet 數(shù)據(jù)集類別與此數(shù)據(jù)集無關(guān),因此我們不采用預(yù)訓(xùn)練模型。

來自COCO 和ImageNet 的權(quán)重。眼球的YOLO錨點:121,121,149,149,158,158,164,164,169,169,172,172,175,175,181,181,191,191。鏡頭的YOLO 錨點:47,47,55,75,57,56,65,63,73,70,78,77,83,60,95,65,97,57。

評分標(biāo)準(zhǔn):FN代表正常眼睛、FM輕度白內(nèi)障、FS重度白內(nèi)障、FFinal代表平均準(zhǔn)確率,計算過程如下:

4.2 實驗結(jié)果

最開始我們直接使用原圖放入5 層卷積中訓(xùn)練,發(fā)現(xiàn)準(zhǔn)確率只有56%;后來不斷嘗試AlexNet[12]/VGG-16[13]/ ResNet-18[8]/ ResNet-152/ DenseNet-121/Dense Net-161/DenseNet-201,發(fā)現(xiàn)DenseNet-161 效果最好,準(zhǔn)確率高達(dá)84%。

表1 不同分類器判別原始圖像準(zhǔn)確率

然后,我們使用通過YOLOv3 獲得的晶狀體和眼球圖像,再次通過上述網(wǎng)絡(luò)訓(xùn)練,發(fā)現(xiàn)仍是DenseNet-161 效果最好,準(zhǔn)確率高達(dá)90%。

5 結(jié)語

在本文中,我們提出了一種基于B 超圖像的白內(nèi)障檢測方法。該方法由區(qū)域選擇模塊,特征提取模塊組成。區(qū)域選擇模塊檢測B 超圖像的眼球和晶狀體。為了完全捕獲圖像特征,使用帶有卷積神經(jīng)網(wǎng)絡(luò)的特征提取模塊獲取高級特征。將來,我們將使用更多的特征提取方式,獲得更高的準(zhǔn)確率。同時實現(xiàn)更多種類的眼部疾病檢測,并嘗試使用生成對抗網(wǎng)絡(luò)來擴展我們的輔助訓(xùn)練數(shù)據(jù)集。