孿生網絡框架下融合顯著性和干擾在線學習的航拍目標跟蹤算法

孫 銳 方林鳳梁啟麗 張旭東

(合肥工業大學計算機與信息學院 合肥 230009)

(工業安全與應急技術安徽省重點實驗室 合肥230009)

1 引言

隨著無人機和計算機視覺的快速發展,基于無人機的智能目標跟蹤系統在目標監控、軍事反恐偵察等各個領域均有廣泛應用[1,2]。航拍視頻具有信息量大、背景復雜、視場不確定、跟蹤目標小等特點,而現有目標跟蹤算法沒有完全針對這些特點進行設計和優化,所以在航拍視頻中實現魯棒且實時的跟蹤仍然是一個巨大的挑戰。

現有主流的目標跟蹤算法都是基于深度學習的,它們主要分為兩類[3]:第1類使用用于目標識別任務預先訓練的深度模型來提取特征,將目標跟蹤問題轉化為分類問題。很多研究者在大型分類數據集上(比如ImageNet)直接訓練網絡,并采用預訓練的卷積神經網絡(Convolutional Neural Network,CNN)來提取目標特征,然后基于分類任務的觀察模型得到跟蹤結果。這種深度學習跟蹤方法更多地強調設計有效的觀測模型,雖然對各種觀測模型,如相關濾波器[4]、回歸器[5,6]和分類器[7]進行了廣泛的研究,但對學習有差別的深層特征的關注卻很少。通過分析發現,當使用經過預先訓練的深層特征作為目標表示時,可能會出現許多問題。首先,由于分類任務更多地關注類之間的對象分類,針對分類任務預先訓練的網絡忽略了類內的差異。其次,即使目標對象出現在預先訓練模型的訓練集中,從最后的卷積層中提取的深層特征通常只保留較高層次的視覺信息,而這些信息對于精確定位或尺度估計來說并不那么有效。最后,深度目標跟蹤算法[8]需要較高的計算負荷,因為預先訓練模型的深層特征是高維的。為了縮小這一差距,利用與目標專門相關的深層特征進行航拍視頻跟蹤是非常重要的。

第2類成熟策略是基于匹配的跟蹤策略,將候選樣本與目標模板匹配,不需要在線更新。這種跟蹤算法最顯著的優點是其實時性[9]。最近,基于匹配的跟蹤還可以使用深度模型來提高匹配的泛化能力[3,10,11]。通過學習一個通用的匹配函數,以保持實時響應能力。最近成功的模型有全卷積孿生網絡跟蹤算法[9](Fully-Convolutional Siamese networks,SiamFC),雖然它不僅實現了不錯的跟蹤精度還滿足了實時性,但是SiamFC[9]缺乏一個有效的在線更新模型去捕捉航拍場景下目標、背景或成像條件的時間變化。為了解決這一問題,文獻[12]提出了使用新模板的線性交互來進行模型更新。文獻[13]提出采用雙模板的方式進行跟蹤,使用改進的APECs更新策略進行模板更新,但只在準確性方面稍有提升。為了進一步提高SiamFC[9]的速度,文獻[14]利用深度強化學習訓練策略,在響應置信度足夠高的情況下盡早停止卷積神經網絡(CNN)的前饋計算,從而降低了簡單幀的特征計算成本。這些方法往往具有較高的計算復雜度,且不能很好地克服航拍場景下目標跟蹤的難點。本文模型充分利用視頻序列豐富的上下文信息,可以有效地在線學習無人機下動態目標的外觀干擾變化,實現可靠、有效、實時的自適應匹配跟蹤。

針對以上深度目標跟蹤算法的分析,本文提出了基于航拍目標顯著性和在線自適應匹配的動態孿生網絡跟蹤算法。主要貢獻如下:(1)針對用于分類任務預訓練的網絡很難學習有差別的深層特征進行航拍目標跟蹤的問題,本文設計了一種新的特征通道回歸損失函數來學習目標智能感知的深層特征,從而可以選擇出最有效的卷積濾波器來生成航拍目標顯著性特征,大大減少通道特征量來加速跟蹤過程。(2)針對SiamFC[9]等算法無法在線更新目標模板從而導致目標發生顯著變化時跟蹤失敗的問題,本文采用目標干擾因子在線學習機制來抑制航拍目標顯著變化所帶來的影響,從而實現有效可靠的自適應匹配跟蹤。(3)通過在數據集上的大量實驗證明,在無人機場景下,本文所提出的目標顯著性特征的動態孿生網絡跟蹤算法具有比較有競爭力的性能,在UAV123數據集上跟蹤成功率和準確率分別比孿生網絡基準算法高5.3%和3.6%,同時速度達到平均28.7幀/s,基本滿足航拍目標跟蹤準確性和實時性需求。

2 本文跟蹤算法

視覺目標跟蹤就是在缺少目標先驗知識的前提下,給定某視頻序列初始幀的目標大小與位置,并在后續的視頻幀中預測該目標的位置。基于模板匹配的孿生網絡跟蹤算法是一種監督學習算法,是通過共享權值來實現的。最經典的孿生網絡跟蹤算法SiamFC[9]的表達式為

2.1 預訓練網絡的目標特征

一般視覺識別任務和特定目標跟蹤在卷積神經網絡提取的特征的有效程度是不同的。關于神經網絡解釋的幾種方法證明了卷積濾波器對捕獲類別級對象信息的重要性可以通過相應的梯度[15]來計算,由此本文構建了目標顯著性感知特征模塊,該模塊具有專門針對視覺跟蹤而設計的損失函數。給定具有輸出特征空間的預先訓練的CNN特征提取器,可以根據通道重要性生成目標顯著性感知特征

其中,Fap表示全局平均池化函數,J是設計的損失函數,F i為第i個濾波器的輸出特征。對于航拍視頻的目標跟蹤,本文利用回歸損失函數的梯度來提取針對目標的顯著性特征。

2.2 目標顯著性感知特征

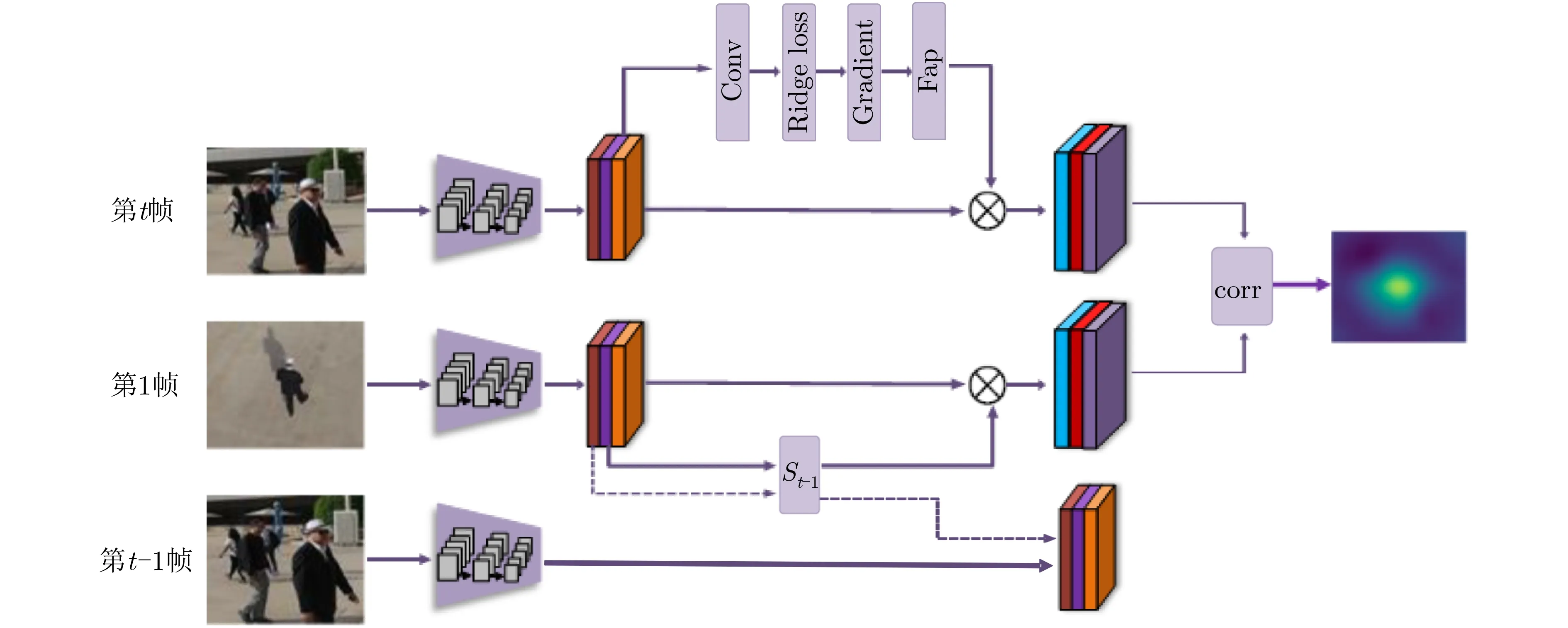

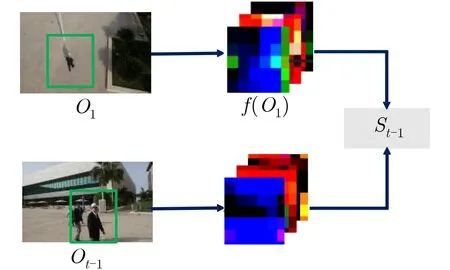

圖1 本文跟蹤算法框架

圖2 可視化跟蹤效果圖

其中,W為回歸權重,每個濾波器的重要性可以根據其對擬合高斯圖的貢獻來計算,關于輸入的特征Xin的損失函數L的推導可以根據鏈式法則和式( 1),回歸損失的梯度由式( 6)計算

2.3 目標干擾因子學習

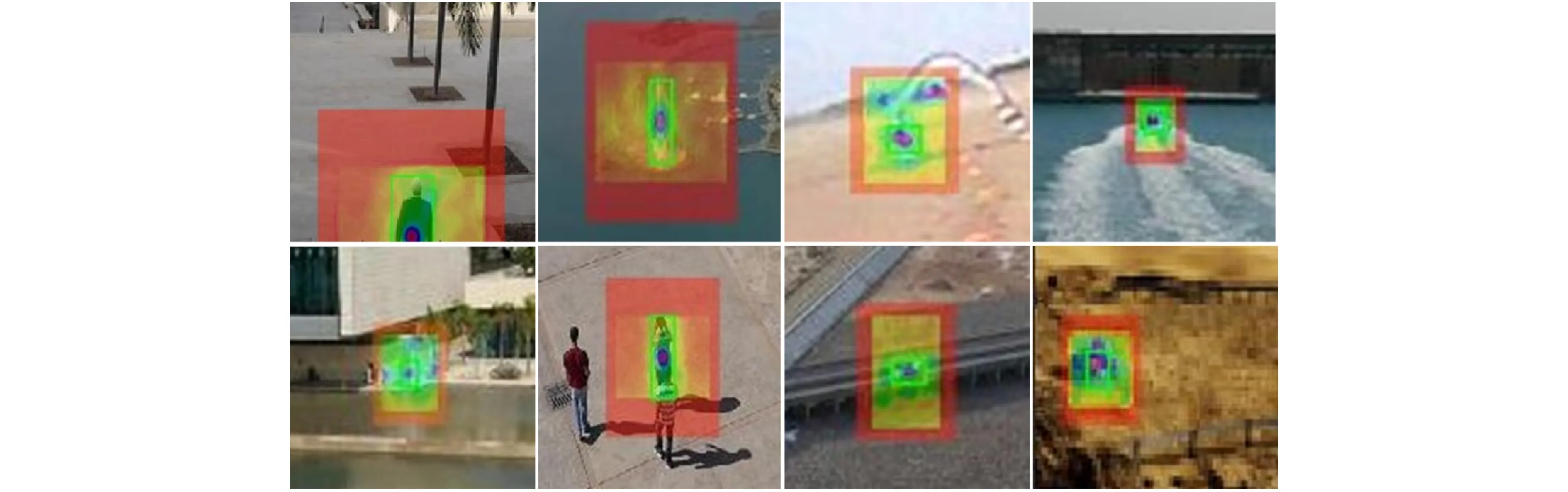

對于單目標跟蹤任務來說,豐富的目標姿勢變化以及不同程度的背景干擾等跟蹤難點都對提取具有辨別力的目標外觀模型提出了更高的要求。然而,航拍視頻中的目標是實時動態變化的,且基本上是俯視或側俯視視角,僅使用第1幀作為固定模板限制了跟蹤準確度的提高。本文在孿生網絡的模板分支上加入動態學習干擾因子模塊,引導在線學習第1幀的目標(O1)與當前幀的前一幀目標(Ot?1)的相似性(如圖3),同時考慮目標的判別力特征和運動變化特征,在實時更新目標模板的同時避免模板漂移問題。

給定X和Y兩個向量,我們的目的是尋找一個最優變換矩陣R,使X與Y相似。使用線性回歸方法有

F是離散傅里葉變換(DFT),F?1是DFT的逆變換,上標*表示的是復共軛。

圖3 目標干擾因子學習

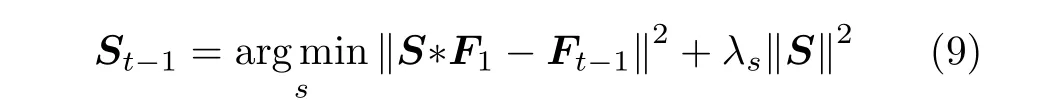

當跟蹤到第t ?1幀圖像時,即可以得到目標X t?1。 與簡單地替換Z和Xt?1不同,本文是學習第1幀Z到當前幀的前一幀Xt?1的外觀變化。本文假設外觀變化在時間上是平滑的。因此,可以將這種變化應用于使f(Z)相 似于f(X t?1),如式( 7)所示。具體而言,本文使用線性回歸計算得到目標干擾因子S t?1

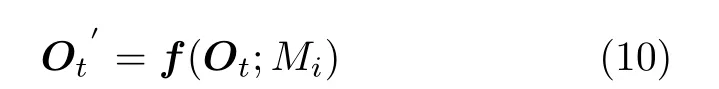

其中,F1=f(Z),Ft?1=f(X t?1);λs為正則化因子可從數據集學習得到。根據式 (3)可知待搜索圖像的目標顯著性特征有

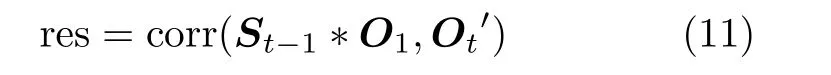

從式 (9)和 式(10)可 知目標跟蹤響應結果可由式(11)計算

2.4 算法實現

本文提出的跟蹤算法流程如表1所示,通過反向傳播分類神經網絡得到的梯度來產生目標顯著性特征,在頻域上快速求解干擾因子。將目標顯著性特征和在線學習干擾因子嵌入孿生網絡中,從而實現有效可靠的自適應匹配跟蹤。首先給定第1幀圖像的目標位置和目標框,以第1幀目標為中心裁剪出比目標框大一點的區域作為目標模板,通過預訓練網絡來提取目標模板的特征。然后,開始進行第t幀跟蹤,將第t幀圖像以第t?1幀目標為中心進行裁剪,再將第t ?1幀 目標區域和第t幀待搜索區域分別經過預訓練網絡進行特征提取,此外還需將第t幀的預訓練特征輸入到目標顯著性感知特征模塊以提取到具有高度判別力的特征。然后將目標模板和第t?1幀 提取的特征以及λs輸入到目標干擾因子在線學習模塊,來求得S t?1,再將目標干擾因子S t?1與目標模板特征卷積得到當前幀的模板。最后將第t幀的目標智能感知特征與第t幀模板進行相似度匹配得到目標的位置。

表1 本文跟蹤算法流程

3 實驗分析

3.1 數據集

實驗部分采用航拍數據集UAV123[16]。UAV123建立了一個低空無人機視角下的高分辨率跟蹤數據集,其中包括123個完整注釋的空中視頻序列,總幀數超過110 k幀。這些航拍視頻具有更全面的目標跟蹤干擾因素,其中包括低像素、相機運動、低分辨率、視角變化,光照變化、尺度變化、遮擋、形變、運動模糊、快速運動、平面內旋轉、平面外旋轉、出視野、背景干擾等航拍難點,由此可以看出用UAV123數據集來衡量一個目標跟蹤算法的優劣更具有普適性和廣泛性。

3.2 實驗結果與分析

本文是在ILSVRC上離線訓練的。采用隨機梯度下降來最優化網絡參數并設置權重衰減為0.0005,學習率以指數衰減方式從10–7到10–9,訓練周期大約為50個周期且每次小批量訓練樣本數為8。首先初始化選擇合適的λs,然后通過離線訓練對其進行更新。實驗平臺為Matlab2016b,使用Mat Conv Net工具箱,使用的實驗設備CPU為Intel Core i7-6700k 4 GHz,GPU為NVIDIA GeForce GTX1080,顯存為8 GB。

3.2.1定量分析

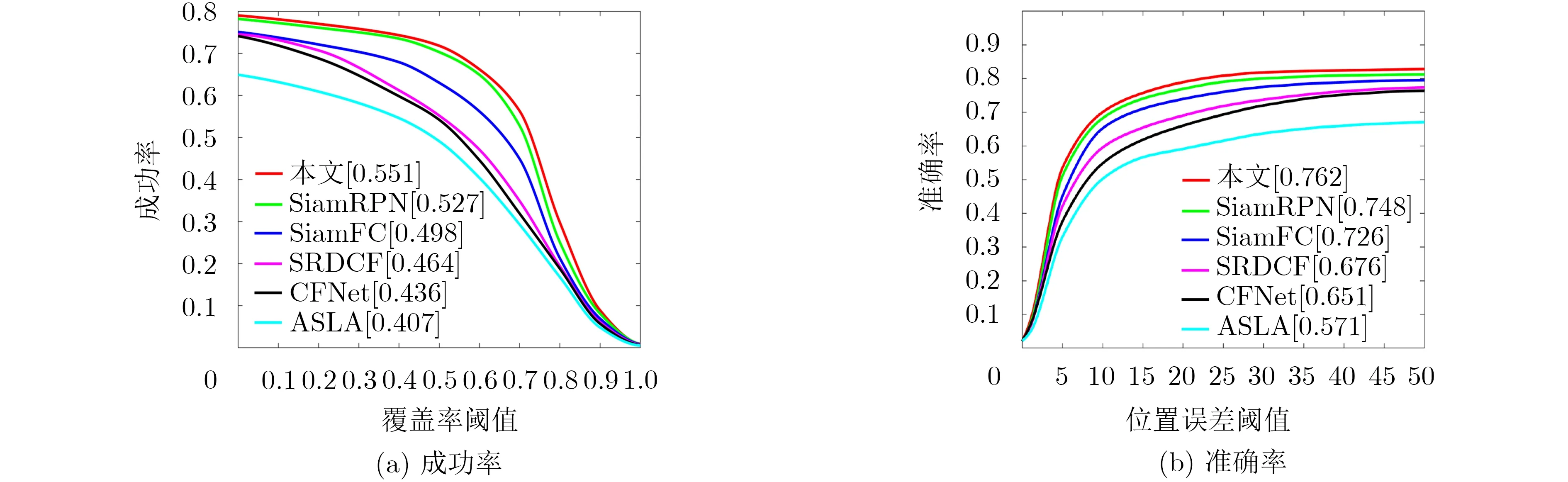

為驗證本文算法的有效性,在廣泛使用的無人機航拍數據集UAV123上進行實驗。同時引入精確度(Precision)、成功率(Sucess)和速度(fps)這3個評價指標,將本文的算法跟蹤結果與K C F[4],SiamFC[9],CSK[17],DSST[18],Struck[19],MEEM[20],MUSTER[21],SAMF[22],ASLA[23],CFNet[24],SRDCF[25]和SiamRPN[26]跟蹤算法中選擇跟蹤效果最好的前5種算法來進行比較,進行定量分析。

圖4是對比算法的成功率和精確度曲線圖。由圖4可以看出,本文算法相對于基準算法SiamFC[9]有很大的提升,成功率從49.8%提高到了55.1%,精確度也從72.6%提高到了76.2%。SiamRPN算法[26]包括用于特征提取的孿生網絡和候選區域生成網絡,其中候選區域生成網絡包括分類和回歸兩條支路,而本文算法設計了一種新的特征通道回歸損失函數來學習目標感知的深層特征,從而可以選擇出選擇最有效的卷積濾波器來生成待搜索目標顯著性感知特征,還采用目標外觀在線動態轉換機制來實現有效可靠的自適應匹配跟蹤,效果比SiamRPN算法[26]在成功率上提升了2.4%,在準確率上提升了1.4%。

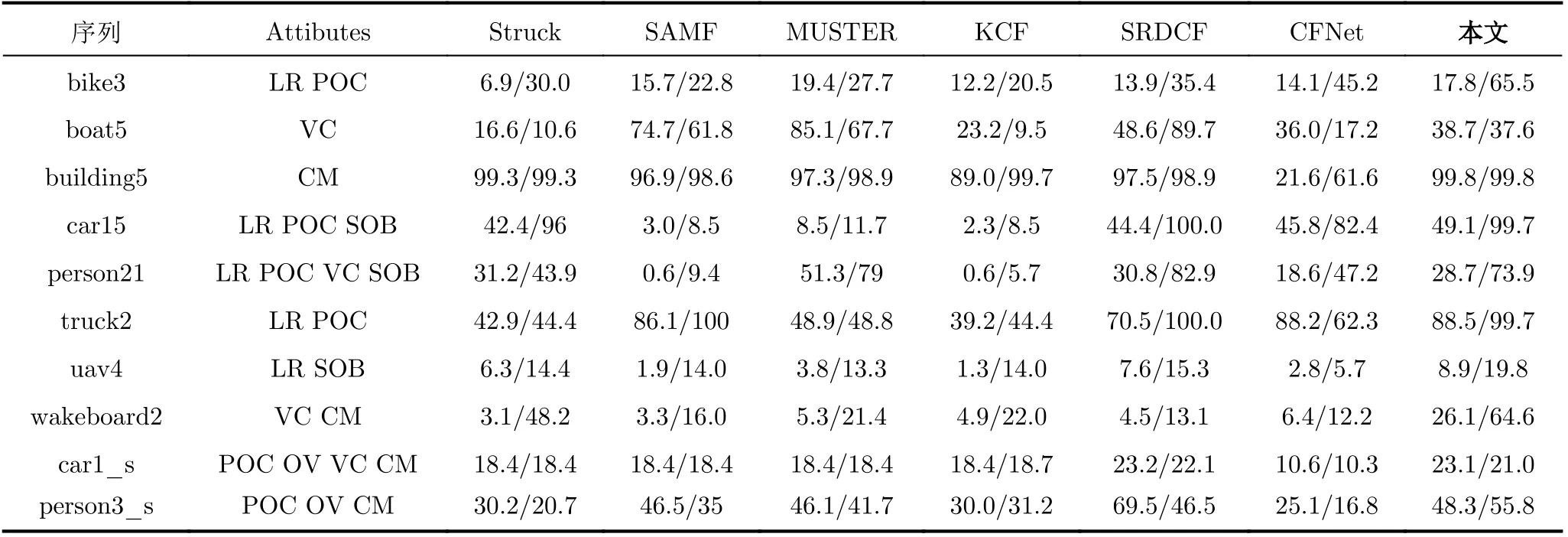

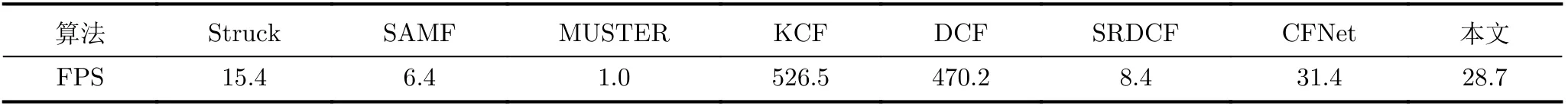

表2展示了本文算法,K CF[4],St r uck[19],MUSTER[21],SAMF[22],CFNet[24]和SRDCF[25]算法在10組代表性序列的成功率和準確率的比較(表2中數據為成功率/準確率)。從該表可以看出,相較于對比算法,本文算法在航拍場景下能夠很好地跟蹤目標。在航拍跟蹤難點較多的building5,car15,truck2,uav4和wakeboard2序列中,本文算法的成功率均為第1,在penson21,car1_s和person3_s序列中,本文算法成功率也位列第2,在bike3,Building5,uav4,Wakeboard2和person3_s序列中,本文算法準確率位列第1,在car15,Person21,truck2,car1_s中本文算法準確率位列第2。表3統計了相關算法在10組視頻序列的速度(fps)比較,雖然基于相關濾波的KCF[4]算法的速度確實很快,fps達到526.5幀/s,但是在視場大、目標小、背景復雜的航拍場景下,跟蹤效果并不是很理想。本文算法速度雖然為28.7幀/s,但足以滿足目標跟蹤的實時性要求。

圖4 成功率和準確率對比

表2 部分視頻的跟蹤成功率和跟蹤準確率比較(%)

表3 算法的速度(fps)比較

3.2.2定性分析

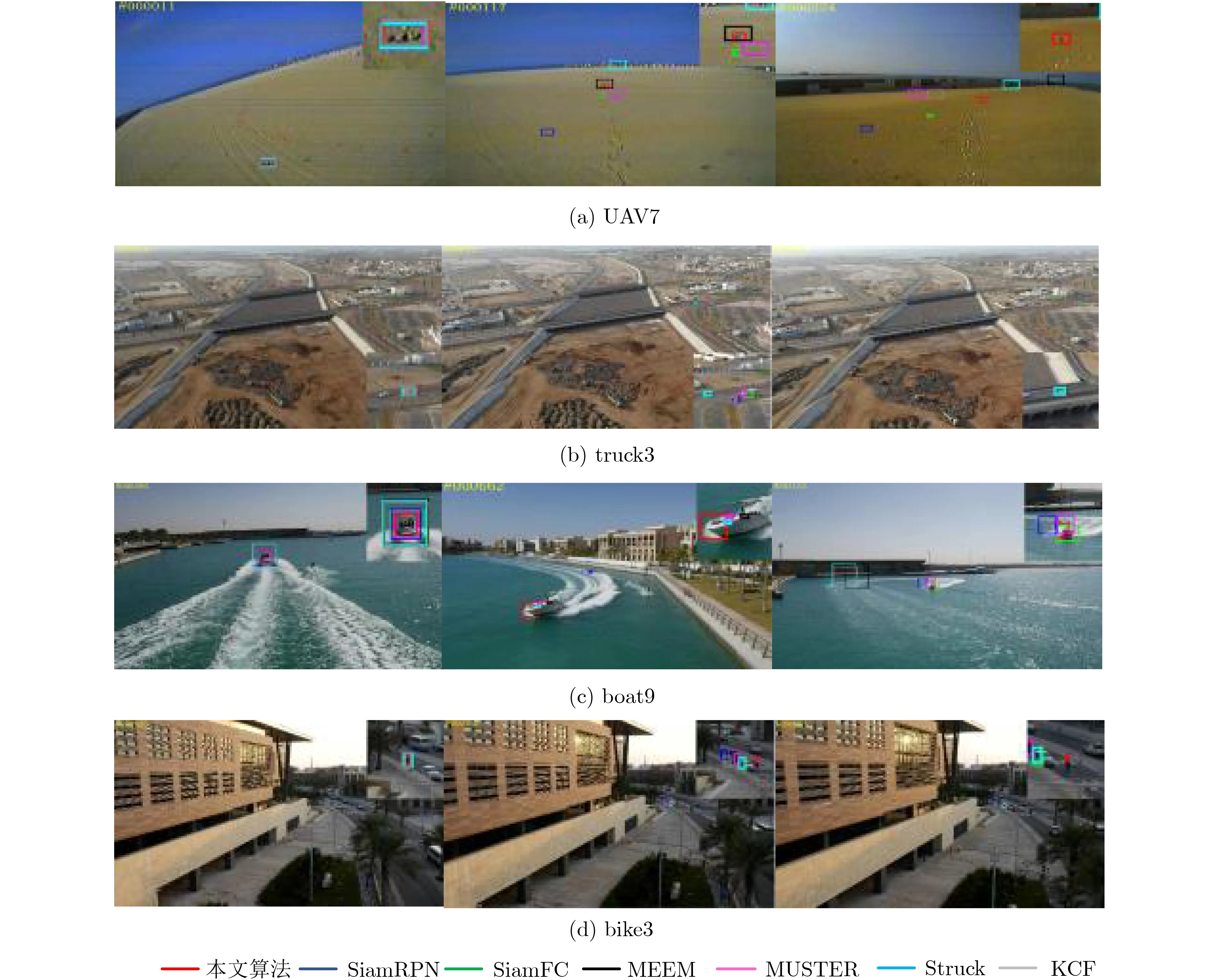

為直接觀察本文算法在航拍場景下的跟蹤效果,選出具有航拍代表性屬性的視頻序列進行定性比較,主要分為5個類型:低分辨率、部分遮擋、出視野、視角變化、相似目標。由于航拍視頻視場大而跟蹤目標過小,為便于看清具體跟蹤效果,全景視頻幀側邊是以本文跟蹤算法目標框為中心的裁剪圖。通過測試視頻效果圖可以證明本文算法具有良好的準確性和魯棒性。

(1)低分辨率:由于無人機場景為俯瞰視角,所以在中高度距離拍攝的視頻中跟蹤目標往往為某個動態點目標,僅由幾個像素組成,而且其大小與噪聲非常相似,如圖5所示。從圖5(a)中可以看出,UAV7是無人機下拍攝的另外一臺無人機的低分辨率視頻序列,這是一種重要的空中跟蹤場景,然而除本文算法外其他算法在后續幀都丟失了跟蹤目標。在背景復雜場景下的bike3中,只有本文算法可以正確跟蹤到目標。此外,在boat9的第96幀、第662幀和第1133幀跟蹤目標出現了由小變大再變小的過程,相比之下本文算法可以更好更精確地框住目標。

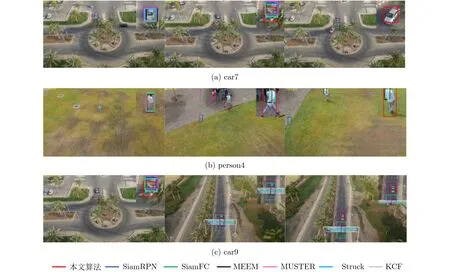

(2)部分遮擋:航拍視頻下的遮擋不同于普通場景,是由于目標僅由幾個像素構成,再出現遮擋使有效特征大大減少就會導致很難進行正確跟蹤。在實際情況下,無人機拍攝的車輛在行駛過程中會受到樹木以及標志牌的短時遮擋,如圖6(a)、圖6(c),若沒有在線更新模板(如SiamFC[9]等)肯定會造成目標丟失,導致再也跟蹤不到正確目標。從car7,car9以及person4被遮擋后的第325幀,第1079幀以及第859幀可以看出本文算法可以魯棒跟蹤。

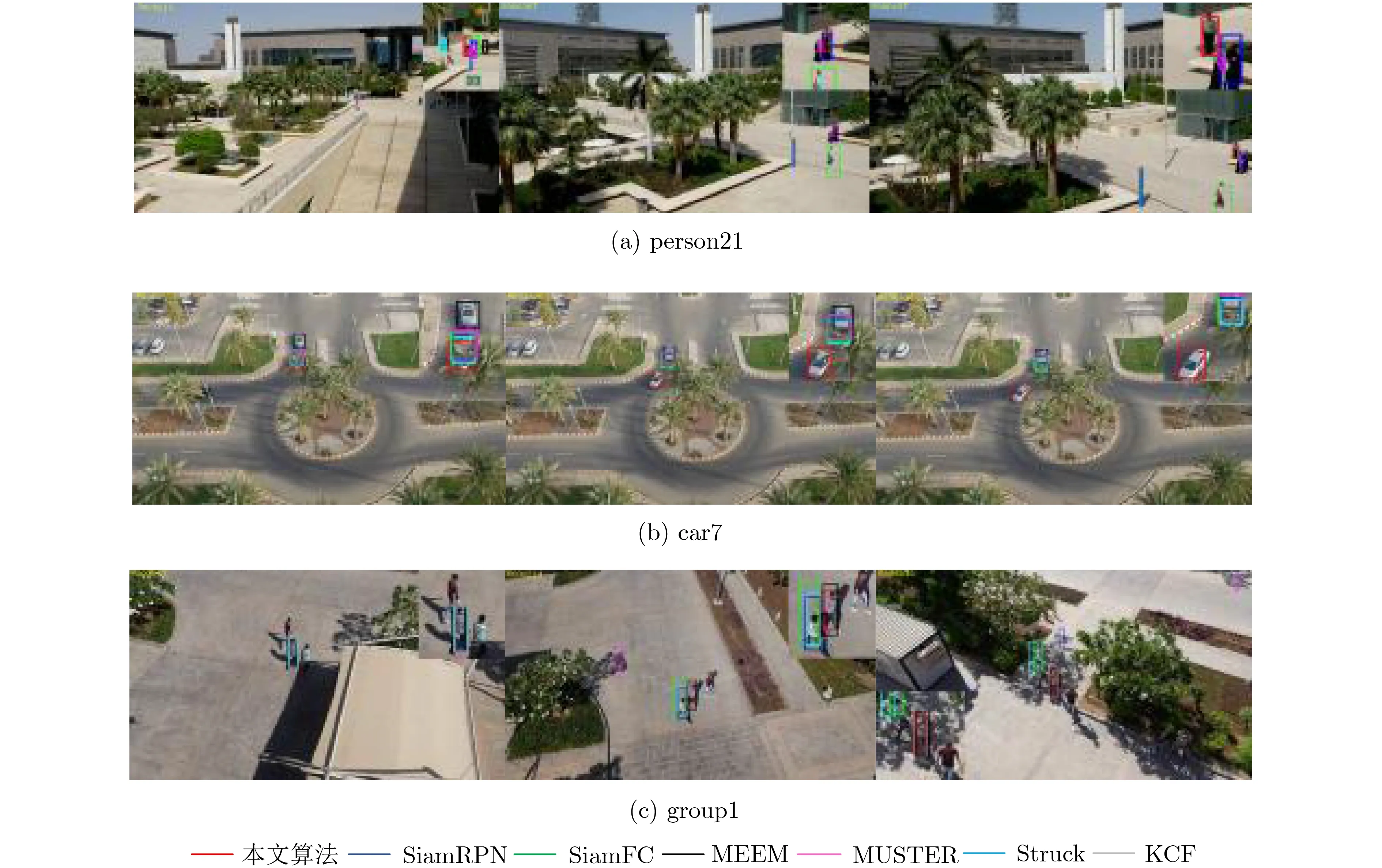

(3)視角變化:空中無人機的任意方向運動會產生跟蹤目標的視角變化,可能第i幀是目標的側面,第j幀卻是目標的背面。如圖7所示,大部分算法在視角變化下還是可以正確跟蹤目標的,但是可以看出本文算法能更有效更準確地框住目標。在bike1中出現了SiamFC[9]和Struck[19]的跟蹤漂移,在person21中除本文算法外,由于出現相似目標其他算法都發生了一定的跟蹤漂移。

(4)相似目標:和遮擋問題類似,航拍場景下的跟蹤出現相似目標也是一大難點。在圖8中展示的是具有代表性的測試幀的跟蹤效果。在person21中還伴隨視角變化、尺度變化和低分辨率,具有很大挑戰性,在其他算法跟蹤漂移的情況下,本文算法在第387幀目標被遮擋后能夠快速調整正確跟蹤。在car7中,在第251幀出現相似車輛時,MEEM[20]隨即跟丟目標。person21跟蹤情況類似,在后續幀中由于再出現遮擋,對比算法都開始陸續跟丟目標,而本文算法可以實現魯棒效果。

4 結束語

圖5 視頻序列測試圖——低分辨率

圖6 視頻序列測試圖——部分遮擋

圖7 視頻序列測試圖——視角變化

圖8 視頻序列測試圖——相似目標

針對航拍視頻下的目標跟蹤,本文提出了一種結合目標顯著性和在線學習干擾變化的跟蹤算法,實現了端到端的前饋式實時在線跟蹤。與現有的跟蹤算法相比,本文算法有3大優勢。第一,本文提出目標感知特征學習,以縮小預訓練的分類深度模型與特定航拍場景的目標跟蹤之間的差距。其主要思想在于,由回歸損失函數引起的梯度表明了相應濾波器在識別目標對象方面的重要性,因此通過從預先訓練的CNN層中選擇最有效的濾波器來學習航拍目標顯著性深度特征。第二,本文模型具有可靠的在線適應能力,通過在線學習目標的干擾因子,來適應前景和背景的時間變化,提高了模型的魯棒性,而不影響實時響應能力。第三,本文將目標顯著性感知特征和在線學習干擾變化與孿生網絡跟蹤框架集成起來,在UAV123數據集上的廣泛實驗結果表明,該算法具有比較有競爭力的跟蹤性能,同時還滿足航拍視頻的實時跟蹤需求。