NSST與改進(jìn)SCM模型相結(jié)合的多聚焦圖像融合算法

魏輝琪,劉增力

(昆明理工大學(xué) 信息工程與自動(dòng)化學(xué)院,云南 昆明 650500)

0 引 言

在平時(shí)的聚焦鏡頭中,由于聚焦受到了限制,因此拍攝的圖像呈現(xiàn)一部分聚焦一部分非聚焦,不利于肉眼觀察和機(jī)器計(jì)算識(shí)別。將兩幅聚焦圖像信息融合起來(lái),可以解決此類(lèi)問(wèn)題。對(duì)兩張或者多張聚焦圖像進(jìn)行融合后的圖像稱為多聚焦融合圖像。融合后的圖像無(wú)論是在主觀觀察還是客觀指標(biāo)方面都有很大的改進(jìn)。多聚焦圖像融合在民用、軍用以及醫(yī)學(xué)領(lǐng)域有廣泛的應(yīng)用。

圖像融合主要分為基于像素層面、特征層面及決策層面的融合3類(lèi)。圖像融合算法主要有基于空間域和基于變換域兩類(lèi)融合算法。空間域算法包括加權(quán)平均法和主成分分析法。變換域的算法也多種多樣,近幾年多尺度變換被越來(lái)越多地運(yùn)用了起來(lái),主 要 有 Curvelet[1]、Contourlet[2-3]、NSCT、Shearlet及NSST等算法。其中,NSST避免了下采樣,在處理圖像時(shí)可以更多地保留圖像信息。丁齋生等人運(yùn)用脈沖發(fā)放皮層模型,在醫(yī)學(xué)圖像的融合中得到了質(zhì)量較高的圖像。然而,傳統(tǒng)的脈沖發(fā)放皮層模型在計(jì)算時(shí)存在邊緣信息保留不完整的缺點(diǎn)。本文提出的自適應(yīng)方法可以很好地和脈沖發(fā)放皮層模型相結(jié)合,提高運(yùn)算速率,保障融合質(zhì)量。

1 相關(guān)概念

1.1 圖像預(yù)處理

在處理圖像之前,需要對(duì)圖片信息進(jìn)行預(yù)處理,讀取相關(guān)數(shù)據(jù)。先采用cvtColor函數(shù)對(duì)圖像進(jìn)行一系列灰度處理[4],再進(jìn)行形態(tài)學(xué)去噪。進(jìn)行形態(tài)學(xué)處理的目的是對(duì)圖像進(jìn)行噪聲濾除,對(duì)圖像進(jìn)行數(shù)據(jù)簡(jiǎn)化,在不改變輸入圖像基本信息的情況下,去除與目標(biāo)圖形沒(méi)有關(guān)系的地方,達(dá)到去噪的效果。具體處理操作包括腐蝕、膨脹、開(kāi)運(yùn)算及閉運(yùn)算等。圖像預(yù)處理是圖像融合的第一步也是至關(guān)重要的一步。去噪后的圖像能為后續(xù)融合步驟提供更為清晰的圖像數(shù)據(jù),提高最終融合的圖像質(zhì)量。預(yù)處理后的源圖像分別定義為源圖像A和源圖像B。

1.2 共享相似性和自適應(yīng)區(qū)域

首先圖像被分割成多個(gè)重疊的方形板塊,搜索相似的板塊。給定一個(gè)以像素r為中心的參考板塊Pr∈Rm×m和區(qū)域W(r)∈Rm×m,任何與Pr相似的候選板塊Pq∈Rm×m定義為:

式中:ηq表示降序排列區(qū)域的所有板塊,這個(gè)板塊的集合表示為L(zhǎng)W(r)=(Pq1,Pq2,…,Pqk)。LWA(r)和LWB(r)共享的相似模塊為:

式中:是融合中自適應(yīng)區(qū)域之一;WA(r)和WB(r)分別表示源圖像A和源圖像B的相同區(qū)域。

1.3 改進(jìn)脈沖發(fā)放皮層模型

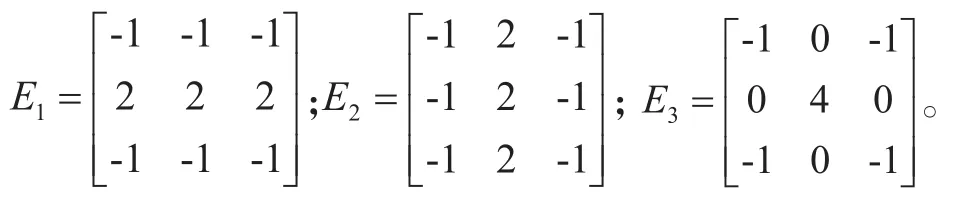

白鑫[6]等人利用IHS變換和自適應(yīng)區(qū)域特征來(lái)對(duì)圖像進(jìn)行融合。SCM的一個(gè)神經(jīng)元由接收區(qū)、調(diào)制區(qū)、脈沖發(fā)放器3部分組成,它的表達(dá)式為:

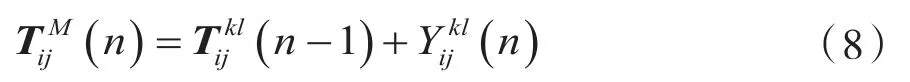

式(3)~式(7)中:n表示迭代次數(shù);(i,j)下標(biāo)表示神經(jīng)元的標(biāo)號(hào);Fij是(i,j)神經(jīng)元在第n次迭代時(shí)的反饋輸入信號(hào);Sij表示外部輸入刺激信號(hào);Lij(n)是連接輸入;VL是震級(jí)標(biāo)度項(xiàng);Uij(n)表示神經(jīng)元內(nèi)部活動(dòng);Wijkl表示神經(jīng)元連接權(quán)重矩陣;Ykl表示神經(jīng)元的輸出信號(hào);Eij(n)表示動(dòng)態(tài)閾值;h表示閾值放大系數(shù);Yij(n)表示神經(jīng)元在第n次迭代時(shí)的輸出信號(hào);f和g是內(nèi)部活動(dòng)和動(dòng)態(tài)閾值的信號(hào)衰減系數(shù)。

最終融合圖像的效果和迭代次數(shù)n有著緊密聯(lián)系。利用與源圖像大小相同的時(shí)間矩陣模型記錄神經(jīng)元的點(diǎn)火信息。時(shí)間矩陣表達(dá)式如式(8)所示。

式中,T是時(shí)間矩陣。在通過(guò)第1次迭代后,SCM中的神經(jīng)元未被激活時(shí),神經(jīng)元能量是0,即Uij和Yij都是0,不發(fā)放脈沖。進(jìn)行第1次迭代后,內(nèi)部活動(dòng)項(xiàng)的值為Sij。往后,每增加1次迭代次數(shù),就會(huì)增大內(nèi)部活動(dòng)項(xiàng)能量。當(dāng)內(nèi)部活動(dòng)能量大于動(dòng)態(tài)閾值時(shí),即Uij(n)>Eij(n),發(fā)放脈沖,輸出點(diǎn)火狀態(tài)。

1.4 自適應(yīng)區(qū)域和改進(jìn)脈沖發(fā)放皮層模型圖像融合

A和B表示的是兩張已匹配好的圖像,融合后的圖像則用F表示。

把源圖像A和B做非下采樣剪切波變換分解,分為3個(gè)步驟:

(1)采用非下采樣金字塔分解將圖像分解為低通圖像和帶通圖像;

(2)對(duì)帶通圖像進(jìn)行方向局部化,獲得不同方向的子帶;

(3)對(duì)每一個(gè)子帶進(jìn)行傅里葉逆變換,獲得非下采樣剪切波系數(shù)。

一般情況下,非下采樣剪切波分解后會(huì)得到表示尺度和方向的系數(shù)Ckl(r)。經(jīng)過(guò)以上分解,得到兩個(gè)系數(shù),分別為CAkl(r)和CBkl(r)。在這個(gè)系數(shù)中,l和k分別表示分解的尺度和方向。當(dāng)l為0時(shí)表示低頻系數(shù),當(dāng)l大于0時(shí)表示高頻系數(shù)。

之后,計(jì)算像素r處的邊緣能量:

式中:Ckl(r)表示NSST分解后的系數(shù);l和k分別表示分解的尺度和方向;r表示像素,r=(i,j);

1.4.1 低頻系數(shù)融合

低頻圖像由非下采樣剪切波對(duì)兩幅源圖像A和B分解得到,分別用表示。本文用邊緣能量衡量每個(gè)自適應(yīng)區(qū)域。在一個(gè)自適應(yīng)區(qū)域內(nèi),如果的邊緣能量比大,那么在的自適應(yīng)區(qū)域內(nèi),γ∈中的所有像素都將獲得一票,即:

式中:νA(γ)為計(jì)數(shù)器,用作位置在(γ)處的表示。最后使用加權(quán)法構(gòu)成像素:

1.4.2 高頻系數(shù)融合

和表示源圖像A和B經(jīng)過(guò)非下采樣剪切波分解后的高頻系數(shù)。所用的融合方法為邊緣能量與脈沖發(fā)放皮層模型相結(jié)合的方法。融合圖像的高頻系數(shù)用來(lái)表示。選擇邊緣能量作為脈沖發(fā)放皮層模型的外部刺激:

式中:ω(r)是加權(quán)因子;D是以像素r為中心的領(lǐng)域窗口。

利用脈沖同步選擇融合圖像的高頻系數(shù)。計(jì)算各個(gè)高頻系數(shù)的總點(diǎn)火時(shí)間在N次迭代后,便可確定高頻系數(shù),見(jiàn)式(13)。

最后,根據(jù)所得的低頻系數(shù)和高頻系數(shù),通過(guò)非下采樣剪切波逆變換便可獲得重建融合圖像F。整個(gè)過(guò)程的流程圖如圖1所示。

圖1 圖像融合流程圖

2 實(shí)驗(yàn)結(jié)果分析

從主觀和客觀兩個(gè)方面,將本文算法與其它3種方法進(jìn)行比較。3種方法分別為基于非下采樣輪廓波與脈沖耦合神經(jīng)網(wǎng)絡(luò)結(jié)合的融合算法(NSCTPCNN)[9]、基于脈沖發(fā)放皮層模型與清晰度相結(jié)合的融合算法(SCM-SF)[10]以及基于非下采樣輪廓波與改進(jìn)的脈沖耦合神經(jīng)網(wǎng)絡(luò)結(jié)合的融合算法(NSCT-IPCNN)[11]。實(shí)驗(yàn)結(jié)果評(píng)價(jià)中的客觀指標(biāo)選用邊緣信息保留量QAB/F和互信息(MI)[12]。

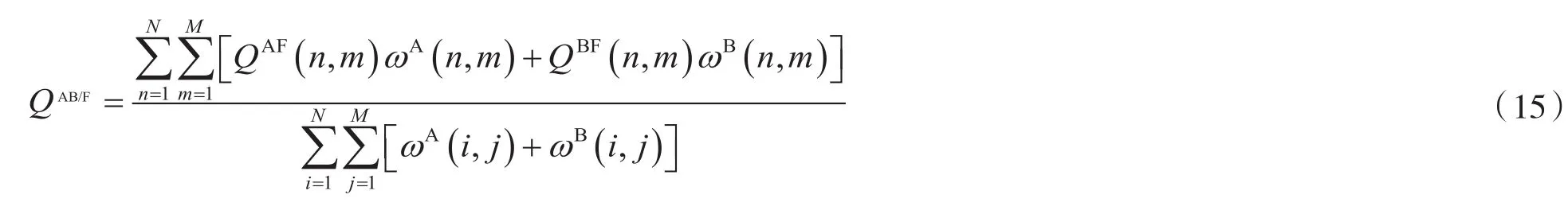

邊緣信息保留量是評(píng)價(jià)融合后圖像邊緣信息量的重要指標(biāo),該值越大,融合效果越好。具體定義為:

式中:M和N是圖像尺寸;QAF(n,m),QBF(n,m)分別是融合圖像相對(duì)于原始圖像A和B的邊緣保持值;ωA(n,m),ωB(n,m)是邊緣強(qiáng)度的函數(shù);QAB/F∈[0,1]表示融合圖像相對(duì)于原始圖像A,B的總體數(shù)據(jù)保留。

互信息是衡量融合后圖像保留源圖像信息量的重要指標(biāo),該值越大,融合效果越好。具體定義為:

式中,IAF、IBF表示源圖像A、B與融合后圖像F之間保留下的信息值大小。

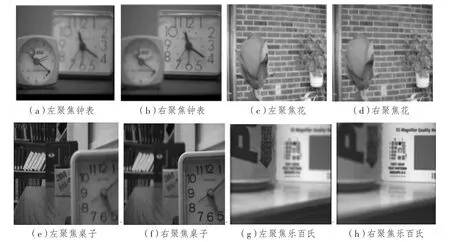

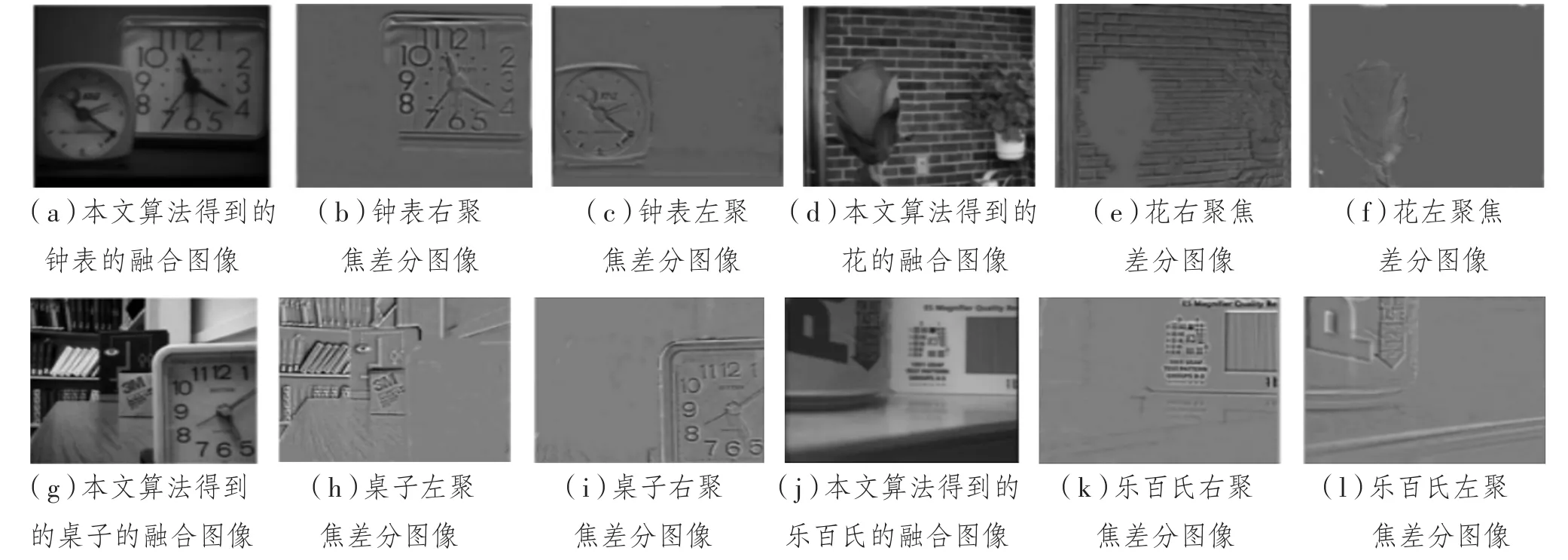

圖2是本文用來(lái)做圖像融合的測(cè)試圖像對(duì)。采用本文算法所得到的融合圖像和差分圖像如圖3所示,其中,圖3(a)、圖3(d)、圖3(g)、圖3(j)為本文算法得到的融合圖像。

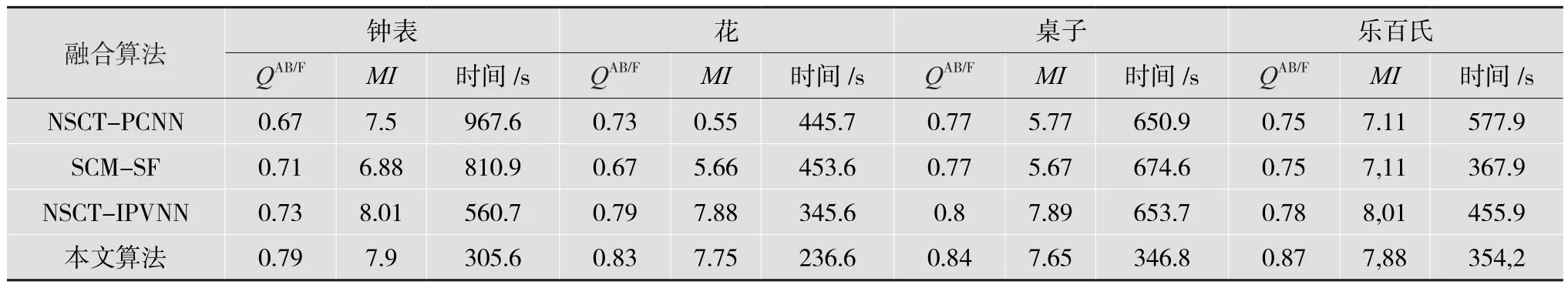

采用不同融合算法對(duì)圖2的圖像對(duì)做圖像融合,客觀評(píng)價(jià)結(jié)果如表1所示。從表1可以看出,本文提出的基于非下采樣剪切波域的自適應(yīng)區(qū)域和脈沖發(fā)放皮層模型相結(jié)合的圖像融合算法無(wú)論是在信息量還是運(yùn)行時(shí)間方面,相較于其他3種算法,都有較大的改善。

圖2 測(cè)試圖像對(duì)

圖3 本文算法的融合圖像和差分圖

表1 不同融合算法的客觀評(píng)價(jià)結(jié)果

3 結(jié) 語(yǔ)

本文算法把邊緣能量和自適應(yīng)區(qū)域相結(jié)合,融合非下采樣剪切波分解后的低頻系數(shù),用于頻域中的低頻系數(shù);高頻系數(shù)融合采用了邊緣能量點(diǎn)火的脈沖發(fā)放皮層模型。可以看出,無(wú)論是主觀視覺(jué)上還是客觀指標(biāo)上,融合后的圖像質(zhì)量都得到了提高。

作為多源圖像融合的重要領(lǐng)域,多聚焦圖像融合具有重要研究意義以及無(wú)可替代的價(jià)值。目前多聚焦圖像融合及相關(guān)技術(shù)已經(jīng)取得了一定的發(fā)現(xiàn)。此外,在動(dòng)態(tài)環(huán)境和強(qiáng)噪聲環(huán)境中的融合算法研究也亟待加強(qiáng)。