基于多模態聯合注意力機制的網民情感分析研究

范濤,吳鵬,王昊,凌晨

(1.南京大學信息管理學院,南京 210023;2.南京理工大學經濟管理學院,南京 210094)

1 引言

輿論是網絡輿情的空間載體,網民情感是輿論的觀點和態度的一種體現[1]。在網絡輿情事件中,網民情感對網絡輿情事件的發展和演化有著極大的影響。例如,在新冠肺炎(COVⅠD-19)疫情中,對“武漢醫生被訓誡談話”“武漢紅十字會物資分發”等事件被徹查的背后,除了客觀因素外,網民的負面輿論和由此折射出來的負面情感對事件的發展都有著推波助瀾的作用。因此,如何在網絡輿情事件中,自動準確識別網民情感是極其重要的。

目前,已有文獻對網民情感分析做了相關研究。例如,Wu等[2]利用OCC(Ortony,Clore,Collins)模型建立文本情感標注規則,并利用卷積神經網絡對文本進行情感分類;Zhang等[3]建立擴展的情感詞典,結合機器學習模型對文本進行情感分類。從上述研究中可以看出,情感分析的對象皆為文本內容。然而,隨著社交媒體平臺的不斷發展,文本不再是網民表達觀點和態度的唯一內容載體。采用文本結合圖片或者短視頻,以一種多模態相結合的形式進行表達,已逐步成為網民傾訴心聲的偏愛方式[4]。雖然通過融合不同模態的情感特征,能夠有效地提升模型情感分析的性能,但這仍是一項具有挑戰性的任務。

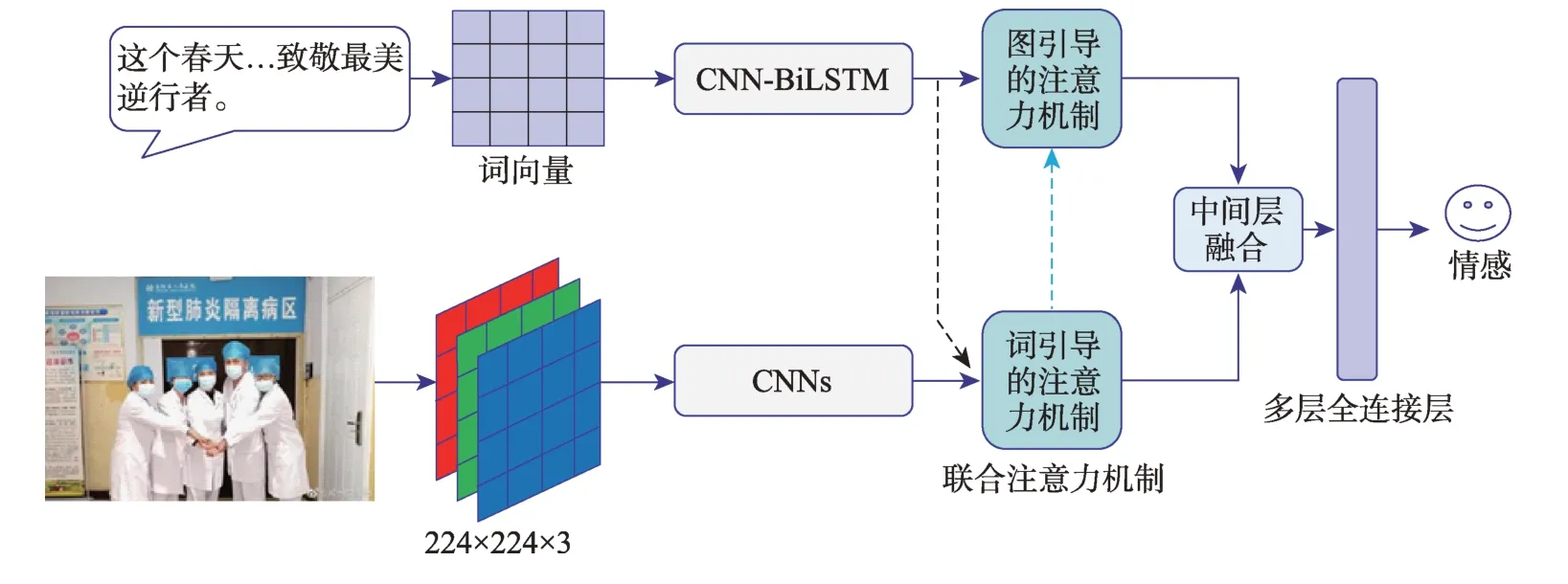

不同的模態本質上是相互異質的,然而在內部特征中,模態之間是相互關聯的。如何有效地捕捉這樣的交互關系,是多模態情感分析的關鍵,并且已有研究做了相關探索。例如,Majumder等[5]提出一種結合上下文的高維融合建模方式,將文本、聲音和圖片等模態多次進行高維融合,從而獲得融合后的特征。然而,基于注意力機制原理,能夠體現文本、圖片或音頻的情感,僅集中于文本中的部分詞或圖片和音頻中的部分區域,融合模態整體信息則會引入噪聲,并造成信息冗余。Huang等[6]基于注意力機制,分別對文本和圖片進行建模后,將生成的具有關鍵特征的文本和圖片向量進行融合,輸入至全連接層中,從而預測情感。然而,在現實中,體現文本情感的某個關鍵詞和圖片中的部分區域存在著對應關系。例如,在圖1中,體現微博情感的“最美逆行者”和圖片中的“醫生形象”相關,和圖片中的其他區域聯系較弱。因此,如果對不同模態內容單獨進行注意力機制建模,那么將無法捕捉這樣的關系。

圖1 多模態數據樣例

為了有效捕捉不同模態之間的交互,充分學習不同模態的特征,減少模型訓練中的冗余信息,從而提升多模態情感分析模型的性能,本文借鑒Zhang等[7]提出的用于命名實體任務中的自適應聯合注意力機制,提出了多模態聯合注意力機制情感分析模型(multimodal co-attention sentiment analysis model,MCSAM)。MCSAM主要由多模態聯合注意力機制和中間層融合策略組成。多模態聯合注意力機制是由詞引導的注意力機制和圖引導的注意力機制構成的。其通過讓文本中的詞來引導圖片區域的情感權重和讓新生成的圖片情感向量引導句子中詞的情感權重,捕捉不同模態之間的關聯和交互關系,并生成具有深度語義的文本和圖片特征向量。然后,利用中間層融合策略融合文本和圖片的表示向量,并輸入至多層全連接中,生成預測的情感標簽。本文的主要貢獻如下:

?本文提出基于多模態聯合注意力機制的網民情感分析模型。該模型能夠充分捕捉到模態交互后的注意力分布,并且有效減少模態中的冗余信息和噪聲。

?本文結合“新冠肺炎疫情”等多模態網絡輿情的數據進行實證研究,并同其他state-of-the-art模型,如MAM(multimodal attention model)、TFN(tensor fusion network)等,進行對比分析。實驗結果驗證了MCSAM的優越性。

本文的其余部分安排如下:第2節介紹了目前的相關研究進展,第3節詳細描述了本文所提出的模型,第4節為實證研究,第5節為總結和展望。

2 相關研究

2.1 網民情感分析研究

網民情感對網絡輿情事件的醞釀、爆發和消解整個過程都具有重要的影響。吳鵬等[8]結合情感詞向量和雙向長短期記憶網絡,對網民的負面情感進行了多分類研究。辜麗瓊等[9]利用詞向量和K-means聚類方法對網民的評論進行了情感追蹤分析。夏一雪等[10]利用仿真的方法對突發事件中網民的負面情感進行了分析。朱曉霞等[11]結合改進的TF-ⅠDF方法和LDA模型提取文本的關鍵情感詞,進行網民情感的演化分析。張鵬等[12]基于構建的突發事件情感詞典,并結合TF-ⅠDF等方法對網民情感進行分析。

從上述研究中可以發現,目前,網民情感分析的研究對象主要基于文本,缺乏結合多模態內容的研究。

2.2 單模態情感分析研究

1)文本情感分析

現有的文本情感識別方法分為基于詞典的方法、基于統計的方法和基于深度學習的方法[13]。基于詞典的方法主要依靠語言學,利用人工構建的情感詞典,從而識別句子中的情感詞或者規則,并以此進行文本情感分析[14]。但是此類方法嚴重依靠情感詞典規模和質量,并且存在擴展性差、遷移性差等問題。基于統計的文本情感識別方法主要是采用機器學習方法,將人工標注的訓練預料作為訓練集,抽取文本情感特征,并利用該模型進行情感分類[15-16]。

深度學習作為機器學習發展的一個研究熱點,被應用至自然語言處理任務中。例如,Kim[17]提出用于文本情感分析的1d-CNN(one-dimensional convolutional neural network),并取得了良好效果。Ma等[18]提出了一種帶有高維注意力機制的擴展的長短期記憶網絡(long short-term memory,LSTM)網絡,該網絡能夠聚合同情感相關的常識知識,并表現優越。

2)圖片情感分析

相較于文本情感分析,圖片情感分析由于受限于人類情感與圖片語義間的“情感鴻溝”,因此其任務更具有挑戰性。傳統的圖片情感分析方法主要利用手工特征,如線條[19]、顏色[20]、亮度[21]等,作為圖片的表示向量,然后將其輸入至分類器中,進行情感分類。

卷積神經網絡(convolutional neural network,CNN)[22]能夠學習圖片中復雜且抽象特征,并在多個計算機的視覺任務中獲得成功,有學者將其應用至圖片情感分析中。例如,Chen等[23]提出一個包含多個CNN的深度神經網絡對圖片情感進行分類,模型性能顯著優于傳統的機器學習模型。Yang等[24]提出一個考慮圖片局部區域信息和整體信息的圖片情感識別模型,并取得了良好的效果。Campos等[25]通過遷移預訓練模型的權重,并對其進行微調操作,從而提升模型性能。

2.3 多模態情感分析研究

從模態融合的視角來看,多模態情感分析研究可分為特征層融合、中間層融合和決策層融合等[26]。

在特征層融合中,通過拼接、相加等方式融合不同模態的特征,形成單一的長向量,并輸入至分類器。例如,Poria等[27]將文本特征、音頻特征以及面部特征相拼接,生成融合后的特征向量,并將其輸入至多核SVM(support vector machine)中,完成情感分類。Pérez Rosas等[28]拼接視頻中,不同模態的特征,輸入至SVM分類器中進行情感分析。然而,特征層融合后生成的多模態融合特征,不能很好地捕捉模態之間的相關關系,并包含冗余特征和噪聲。

中間層融合通常發生于深度神經網絡中,通過對不同模態的特征進行編碼,形成相應的特征表示,并進行融合。例如,Zadeh等[29]提出張量融合模型,通過將編碼后的不同模態的特征進行外積,形成空間上的3維立方體,作為融合后的多模態特征,輸入至全連接層中進行情感分類。Huang等[6]結合注意力機制,對文本和圖片分別進行建模,對新生成的文本和圖片特征向量進行融合,并進行情感分類。雖然基于中間層融合的方法均取得了較好的效果,但是捕捉網絡中模態的交互依然是難點。

在決策層融合中,不同的模態獨立建模,利用基于規則或者投票的方法,對不同模態情感分析模型輸出的情感類別概率進行融合,生成情感標簽[30]。例如,Song等[31]利用不同的網絡輸出不同模態的情感預測概率,并將其融合輸入至人工神經網絡或k最鄰近算法中,產生最終情感標簽。對于決策層融合,不同的模態能夠選擇最優的模型進行情感類別概率預測,然而模態間的關聯和交互沒有被充分考慮。

3 模型設計

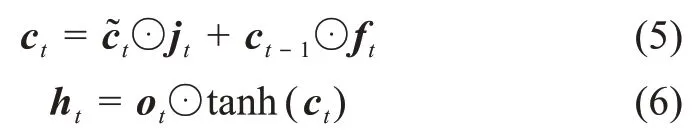

本文提出的基于多模態聯合注意力機制的網民情感分析模型結構如圖2所示,其主要由多模態聯合注意力機制和中間層融合策略組成。多模態聯合注意力機制分為詞引導的注意力機制和圖引導的注意力機制,兩者分別捕捉文本和圖片交互后的注意力分布,從而生成新的特征表示向量;然后,通過中間層融合策略,融合文本和圖片特征,并輸入至多層感知機中,產生最終的情感預測類別。下文將詳細描述提出的算法和模型。

圖2 基于多模態聯合注意力機制的網民情感分析模型

3.1 圖片特征提取

CNN在多個視覺任務中取得了巨大成功,并被應用至圖片情感分析中。對于圖片特征提取,常用的方法有利用預訓練圖片模型中的全連接層提取圖片的特征,或者利用傳統的手工特征。為了獲得圖片中不同區域的空間特征,本文利用在ⅠmageNet[32]中預訓練的VGG16(visual geometry group 16)[33]模型中的最后一層池化層(pool5),提取圖片的空間特征。VGG16網絡中pool5輸出的特征圖大小為7×7×512,其中512為特征向量的維度;7×7為特征圖的數量。令v={v1,v2,v3,…,vi,…,vn}表示與網絡輿情文本相對應的n張圖片。經過pool5層抽取得到的圖片特征,j=1,2,…,N},那么圖片特征中j區域的特征維度為512,區域數量為N=49。

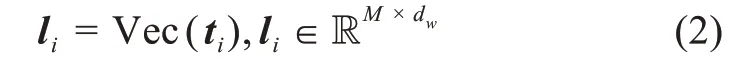

其中,Wv表示全連接層中的權重;bv表示偏置項;d表示輸出維度;tanh為雙曲正切激活函數。

3.2 文本特征提取

本文利用word2vec(word to vector)[34]模型對大規模網絡輿情文本進行無監督訓練,獲得富含句法信息和語義信息的詞向量,作為模型輸入。令t={t1,t2,…,ti,…,tn},其中t表示網絡輿情圖文數據集中的文本。對于每一個文本ti,本文利用在大規模網絡輿情文本中訓練好的詞向量模型Vec對其進行向量化表示,則l={l1,l2,…,li,…,ln},并且

其中,M為句子長度;dw為詞向量的維度。本文將l={l1,l2,…,li,…,ln}作為網絡輿情文本的表示。

3.3 CNN-BiLSTM模型

常用的文本情感分析模型有LSTM[35]、CNN[17]等。例如,吳鵬等[36]提出結合OCC模型和CNN模型分析網民情感,并輸出三種情感類別;金占勇等[37]提出利用LSTM模型,對突發災害事件網絡輿情情感進行識別。LSTM作為RNN的變體,能夠巧妙地控制其獨特的門結構,有效地學習上下文的語義信息,是一種優異的序列模型。通過卷積核在窗口中的滑動,CNN能夠有效的學習句子中的n-gram特征,生成由詞組成的短語向量。不同于上述的研究,本文提出結合CNN和LSTM的CNN-BiLSTM模型,結合了兩種模型的優點,對向量化表示的網絡輿情文本進行特征抽取。對輸入的由詞向量表示的句子,j=1,2,…,M}進行卷積操作,其中M表示句子的長度。令表示卷積核,卷積核數量為z,s表示卷積核(窗口)大小,經過卷積核wk卷積得到的特征圖為

其中,bc為偏置項;fc為非線性激活函數relu。對卷積后得到特征圖譜進行最大池化,用于聚合特征,降低數據敏感度,輸出的最大池化特征圖譜=max(ck)。本文對卷積進行了填充操作,經過卷積池化輸出的句子特征表示為li'。然后,本文將短語特征向量表示的句子特征li'與詞向量表示的句子特征li相拼接,生成富含短語特征和詞特征的句子表示矩陣li'',作為BiLSTM網絡的輸入。BiLSTM是由雙向的LSTM構成的,前向LSTM能夠通過時間順序傳遞序列信息,反向LSTM能夠逆序傳遞序列信息,從而能夠更好地學習上下文信息。LSTM由輸入門、遺忘門、輸出門以及細胞狀態組成,通過結合每個門所用的公式,學習具有時間依賴的句子表示,j=1,2,…,M},其中,d為BiLSTM編碼后的特征維度,M為句子長度,具體公式為

其中,Wl表示權重矩陣;ft、jt、ot分別表示t時刻的遺忘門、輸入門和輸出門;xt為t時刻的輸入;⊙表示點乘操作;σ表示sigmoid激活函數;tanh表示雙曲正切激活函數。

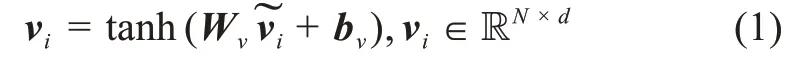

3.4 多模態聯合注意力機制

本文中的多模態聯合注意力機制由詞引導的注意力機制和圖引導注意力機制構成,具體如圖3所示。

圖3 多模態聯合注意力機制

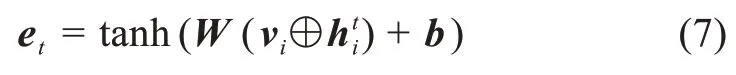

3.4.1 詞引導的注意力機制

在多模態情感分析研究中,已有關于注意力機制的研究。例如,Huang等[6]提出深度多模態注意力融合模型,通過對文本和圖片分別進行注意力機制建模,將提取的文本和圖片注意力權重進行融合,輸入至全連接層中,從而獲得情感標簽。然而,在現實中,體現文本情感的詞僅和圖片中的部分區域相關聯。如果忽略圖片和文本之間的關聯,分別進行注意力機制建模,那么會影響模態間的整體交互。不同于這些已有的研究,本文利用詞引導的注意力機制,通過利用編碼后的詞來引導圖片中各個區域的注意力分布,充分捕獲文本和圖片之間的交互和關聯關系,同時減少冗余信息和噪聲。

其中,W表示全連接層中的權重矩陣;b表示偏置項;⊕表示拼接操作。拼接操作具體是指vi中的每一列向量同相拼接。本文利用softmax函數來計算注意力權重αt:

在注意力機制中,圖片中的每一個區域均會被分配一個介于[0,1]區間的得分αt,j(1≤j≤N)作為注意力權重。最后,基于注意力權重分布,得到新生成的與詞相關的圖片特征向量Zt:

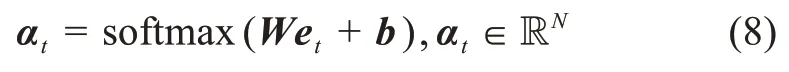

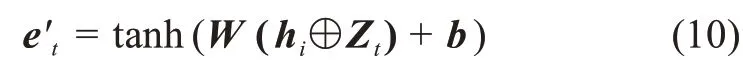

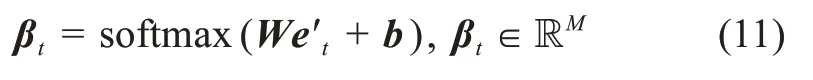

3.4.2 圖引導的注意力機制

通過詞引導的注意力機制,本文獲得圖片的新特征表示。而在文本中,不同的詞與文本情感的相關性是未知的。因此,本文結合圖引導的注意力機制,通過引入新生成的圖片特征Zt來引導文本的詞進行注意力權重計算。經過編碼后的句子特征矩陣為,j=1,2,…,M},M為句子長度,d為編碼后特征維度。將句子特征矩陣hi和對應的圖片特征向量Zt輸入至一層全連接層中,進行非線性激活,得到歸一化后的特征e't:

其中,W表示權重矩陣;b表示偏置項;⊕表示拼接操作。拼接操作具體指hi的每一列向量同Zt相拼接。本文利用softmax函數來計算注意力權重βt:

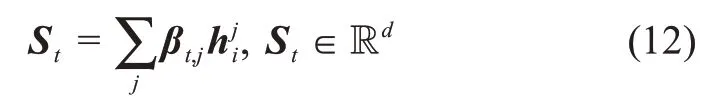

在注意力模型中,句子中的每個詞均會被分配一個介于[0,1]之間的得分βt,j,1≤j≤M,作為注意力權重。最后,基于注意力權重分布,得到新生成的與圖片特征Zt相關的句子特征向量St:

3.5 多模態融合

通過詞引導的注意力機制和圖引導的注意力機制,本文分別得到新的文本和圖片特征St和Zt,利用中間層融合方式,將文本特征St和圖片特征Zt進行融合。

本文將St和Zt融合輸入至多層全連接層中,對融合后的特征進行編碼,用于最終的情感分類:

其中,labelfusion代表模型預測的情感標簽;θfusion代表全連接層中的參數;C代表情感類別數量。

4 實證研究

本節將首先介紹實驗環境及評價指標,然后介紹本文所用的數據集及數據的預處理過程。最后,本文將提出的模型在網絡輿情事件數據集中進行驗證,并同基線模型作對比,報告的結果均為最優結果。

4.1 實驗環境及評價指標

本文所用的編程語言為python 3.6,使用的深度學習框架為pytorch 1.0.1和keras 2.2.4。本文的實驗均在內存為8G、處理器為Ⅰntel Core i7-7700HQ的機器上完成。為了排除其他不必要因素對實驗產生的影響,實驗中每個模型所用的訓練集與測試集均一致。其中,實驗數據集的80%作為訓練集,剩余的20%作為測試集。

本文實驗所用評價指標為宏平均精確率(marco-precision)、宏平均召回率(marco-recall)和宏平均F1值(F1-score)。在本文中,上述指標分別簡稱為P、R及F1值。

4.2 實驗數據集獲取及預處理

1)數據集獲取

本文從新浪微博中搜集了近期發生的網絡輿情事件數據,包括“新冠肺炎疫情”“武漢紅十字會”等網絡輿情事件。搜集的數據集包含2459個文本和圖片對,均為對應關系。數據示例如圖1所示。除此之外,本文還從微博中抓取了近年發生的網絡輿情事件數據,用于訓練詞向量,對數據進行清洗后,獲得總計2911235條文本。

2)數據集預處理

在實驗開始之前,本文對中文數據進行了預處理。首先,本文對微博中的一些無意義符號進行去除,利用python中jieba①https://pypi.org/project/jieba/包并結合本地詞典對文本進行了分詞處理,同時利用停用詞詞典對文本進行了去停用詞處理。對于圖片,本文利用python中的CV2②https://pypi.org/project/opencv-python/讀取圖片,并將圖片的大小調整224×224×3,適應本文所構建的圖片情感識別模型的輸入。

3)數據集標注

本文對實驗數據集進行了雙人標注,標注的情感分別正面、中性和負面。實驗數據集由兩位信息管理與信息系統專業本科生進行情感標注,其有著多年的社交媒體使用經驗,標注結果的kappa系數為0.747,標注結果具有較高的一致性。對于不一致的標注,通過討論產生最終的情感標簽,最終的情感標注結果如表1所示。

表1 情感標注結果

4.3 模型設置

本文利用word2vec中的skip-gram模型訓練詞向量,詞向量維度設置為100。文本長度設置為50,如果文本長度超過50,那么截斷;反之,則補零。卷積層卷積核大小設置為2,數量為256。圖片輸入大小為224×224,帶有RGB三通道。本文利用預訓練VGG16模型中的pool5層提取圖片的空間特征,大小為7×7×512,圖片特征區域數量為7×7,維度大小為512。輸入至一層全連接層中,激活函數為tanh,維度同CNN-BiLSTM輸出維度相一致。融合后的多模態特征輸入至兩層特征維度分別為300和3的全連接層中,激活函數分別tanh和softmax。

在訓練過程中,本文利用adam作為目標函數的優化器,學習率設置為0.001。損失函數為crossentrophy,訓練批次大小為128,訓練輪數設置為100。本文采用earlystopping技術,檢測參數為損失值,當損失值連續10輪不下降,訓練隨即停止。

4.4 基線模型

本節介紹用于與提出的模型相對比的基線模型,其中有些模型在公開數據集中,達到state-ofthe-art效果。T表示文本,V表示圖片。

?BiLSTM-T[8]是一種優異的用于處理文本等輸入的序列模型,常被用于情感分析任務中。

?CNN-BiLSTM-T[38]模型由卷積層、池化層和全連接層組成,能夠很好地捕捉文本空間特征,是一種優異的文本情感分類模型。

?CNN-BiLSTM-attention-T模型是本文提出模型的組成部分,對文本單獨進行注意力機制建模,利用softmax層對新生成文本特征向量進行情感分類。

?CNN-V[33]是利用預訓練的VGG16模型進行圖片特征進行特征提取,輸入至softmax層進行情感分類。

?CNN-attention-V模型是本文提出模型的組成部分,對圖片空間特征單獨進行注意力機制建模,利用softmax層對新生成的圖片特征向量進行情感分類。

?SVM[28]是利用SVM用于對拼接后的文本特征和圖片特征進行情感分類。

?MAM[6]是一個基于注意力機制的多模態融合情感分析模型,通過對不同模態分別進行注意力機制建模,能夠有效地學習多模態情感特征。

?TFN[29]是通過對不同模態的情感特征進行高維融合,能夠較好的捕捉不同模態間內部動態交互。

同時,本文還將僅使用詞引導的注意力機制模型(word-guided attention,WGA)和僅使用圖引導的注意力機制模型(image-guided attention,ⅠGA)進行對比。

4.5 實驗結果及分析

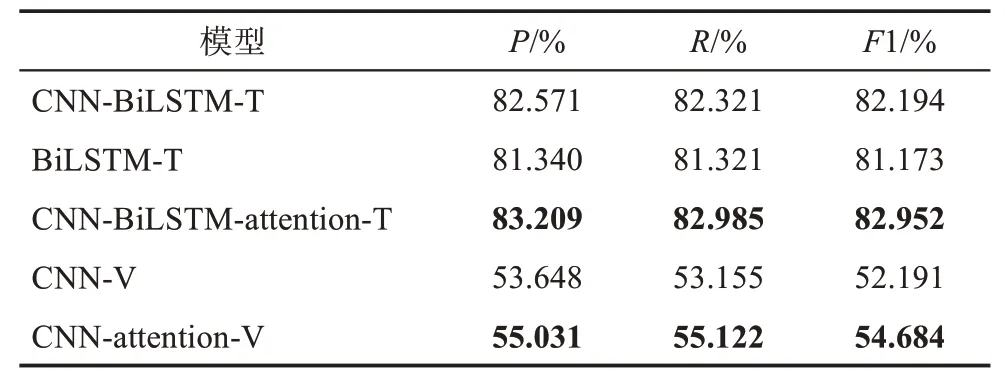

1)單模態

表2呈現的是單模態情感分析結果。在文本模態中,通過對比CNN-BiLSTM和BiLSTM的實驗結果,可以看出CNN-BiLSTM具有一定的優勢。BiLSTM能夠充分學習句子中的序列特征,結合句子中的過去信息和將來信息;CNN能夠通過網絡中卷積核在句子中的滑動充分學習句子的n-gram特征;而CNN-BiLSTM則屬于兩者優勢的結合,這也是CNNBiLSTM表現優越的原因。對比應用了注意力的CNN-BiLSTM-attention和未使用注意力機制的CNNBiLSTM,可以看出引入注意力機制模型的優勢,這同樣也體現在圖片情感分析模型CNN和CNN-attention的對比結果中。因此,引入注意力機制在情感分析中具有一定的優勢,并能夠提升模型性能。

表2 單模態情感分析結果

對比文本模態情感分析結果和圖片模態情感分析結果可以發現,文本情感分析的結果顯著優于圖片情感分析結果。這表明,相較于圖片,文本攜帶了更多富有情感的信息。

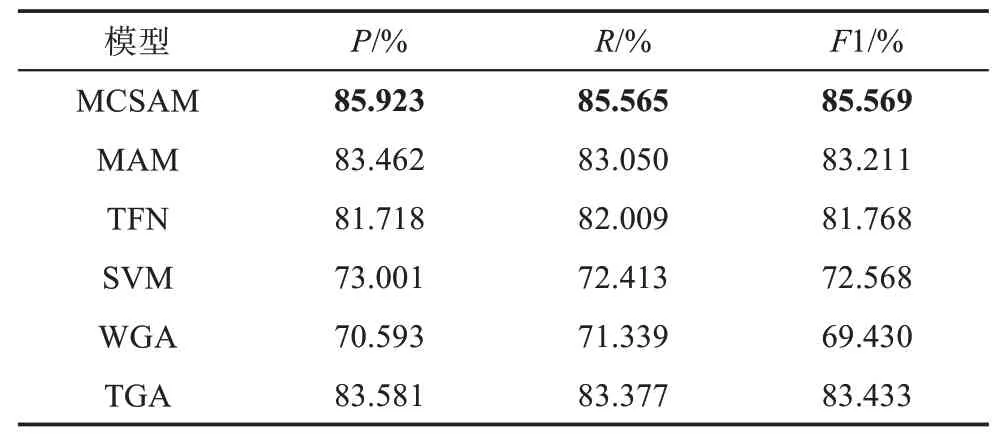

2)多模態

表3呈現的是多模態融合情感分析的實驗結果。對比利用特征層融合的SVM模型結果,本文提出的模型MCSAM在三項評估指標中的結果均優于SVM約13%。這在一定程度上表明深度神經網絡在學習和融合多模態特征上的優勢。與利用高維融合的TFN模型進行對比,MCSAM模型的各項指標均優于TFN模型。雖然高維融合能夠捕捉模態中的全面信息,但是同時也帶來了信息冗余和引入噪聲的風險,導致MCSAM模型達不到最優狀態。而利用注意力機制恰好可以避免這一風險,本文通過為文本中的內容和圖片內的不同區域分配不同的注意力權重,使得MCSAM模型多加關注文本和圖片中富有情感信息的部分,弱化文本和圖片中的噪聲,從而令模型發揮最優。MAM是一種對不同模態分別進行注意力機制的多模態融合模型,在同MAM的對比中,應用了聯合注意力機制的MCSAM依舊優于MAM。在精確率指標中,MCSAM高于MAM約2.46%。應用注意力機制能夠使模型“刻意”關注模態中富含情感信息的區域,但是在多模態中,不同模態間語義是相互關聯的。某一模態富含情感的部分僅和另一模態的某些部分或者區域相對應和聯系。如果對不同模態單獨建模,那么這樣的關系便會被割裂,無法捕捉。而利用聯合注意力機制,通過令文本中的詞來引導圖片區域中的注意力權重分布,生成詞引導的圖片特征向量,再利用新生成的圖片特征向量引導文本中詞的注意力權重分布,生成圖引導的文本特征向量,則可以充分捕捉不同模態間富含情感區域部分的相互關聯關系,這也是MCSAM優于MAM的原因。在同WGA和ⅠGA的對比中可以看出,采用中間層融合后的MCSAM顯著優于WGA和ⅠGA,這充分說明詞引導的注意力機制和圖引導的注意力機制聯合后的優勢,同時,也展現出多模態融合在情感分析中的優勢。

表3 多模態情感分析結果

4.6 參數敏感性分析

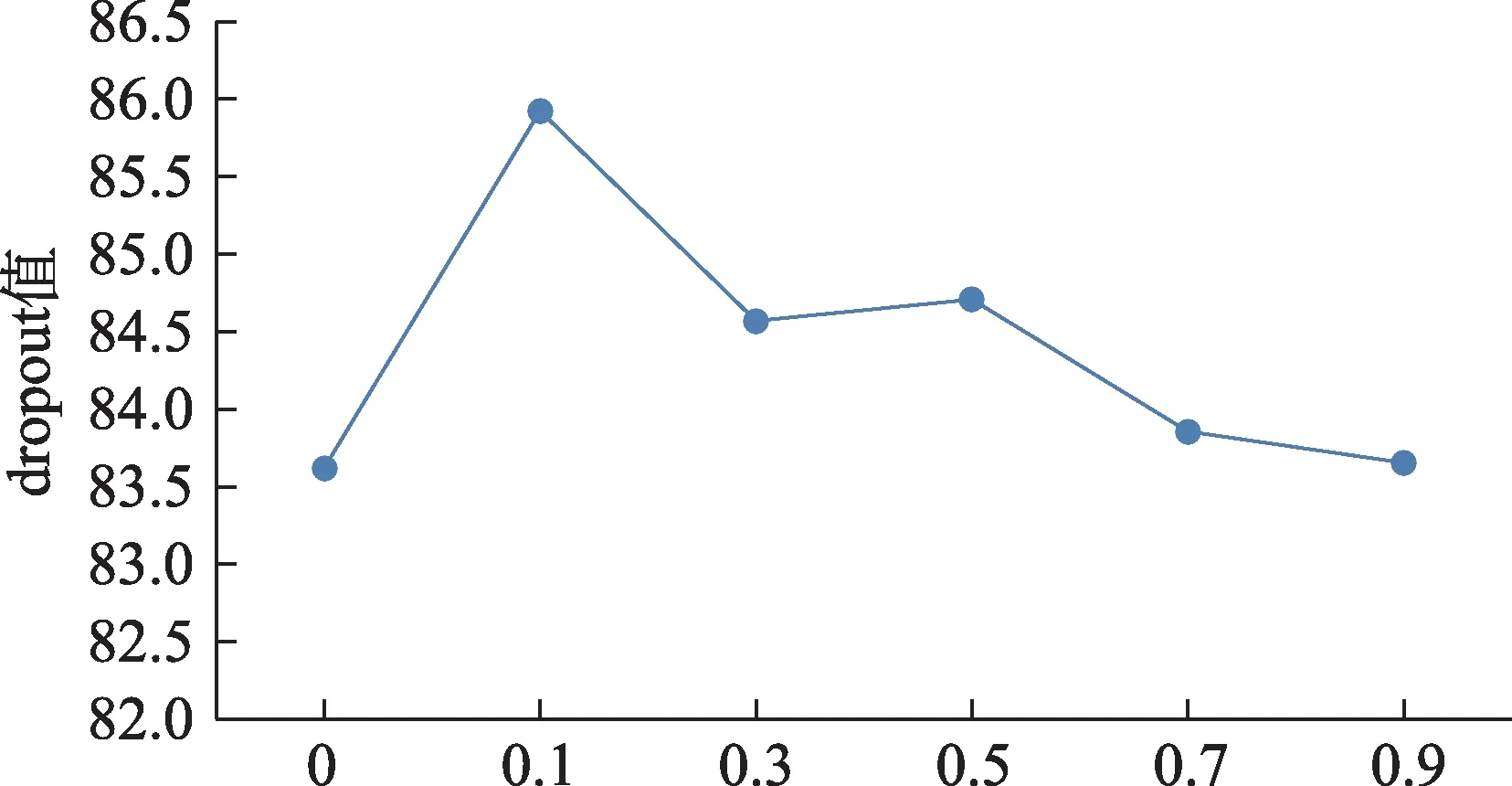

BiLSTM中的隱藏單元數和dropout值是本文提出的模型中的重要參數。因此,下文評估了不同參數的變化給模型帶來的影響。

由圖4可以看出,當模型引入dropout技術后,模型的性能得到了顯著提升。這表明dropout技術在克服模型過擬合中具有優越性。當dropout值的增大,模型的性能總體上呈現下降趨勢;當dropout值達0.1時,模型的性能取得最優。

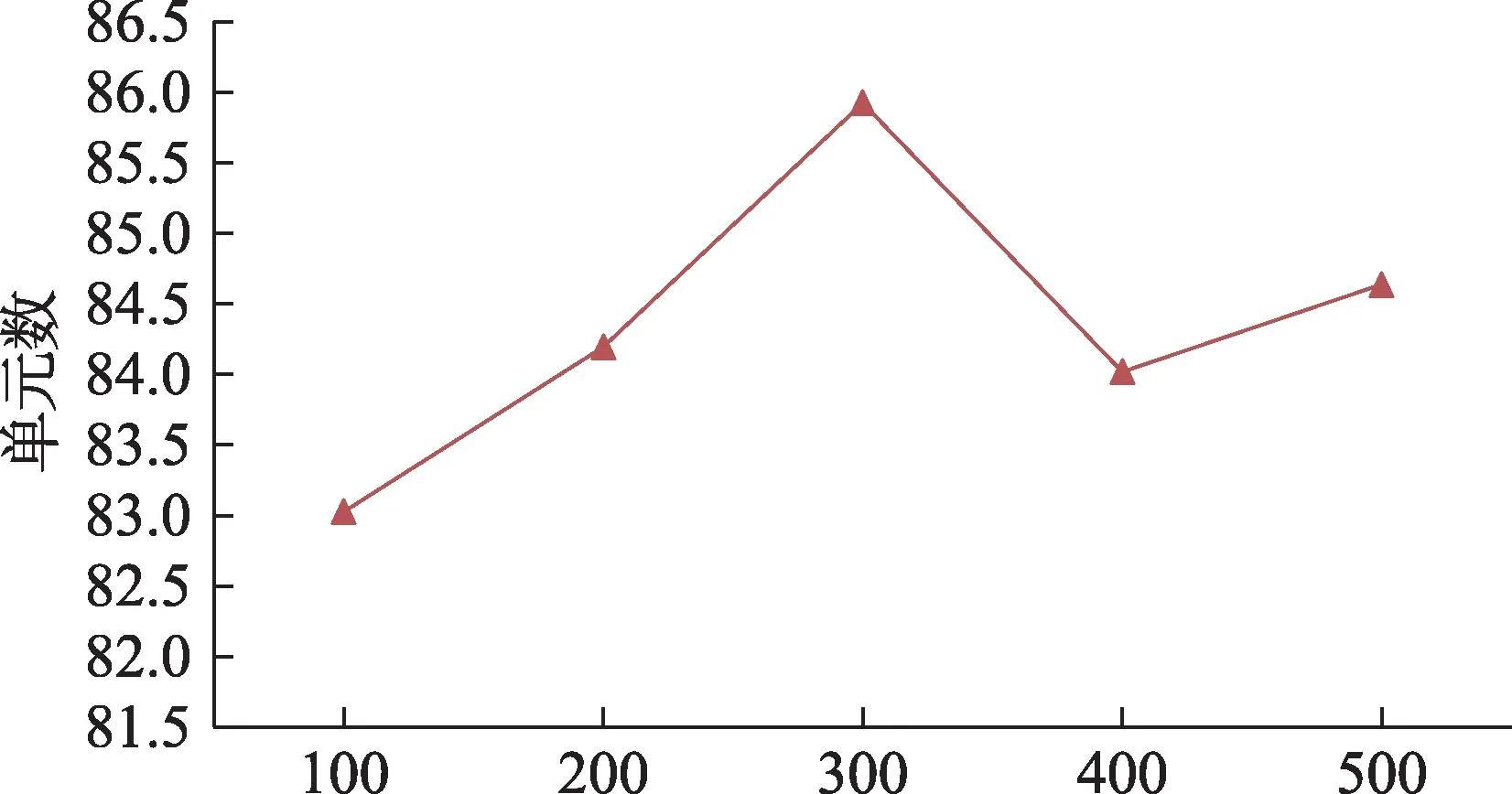

在模型中,為了便于計算,模型中全連接層、文本及圖片特征向量的維度數同CNN-BiLSTM中的輸出維度數相同,即與BiLSTM中的隱藏層單元數相關。由圖5可以看出,不同的隱藏層單元數對模型的性能有著顯著的影響。當隱藏層單元數為300時,模型達到最優。因此,本文所提出的模型中BiLSTM的隱藏層單元數設置為300。

圖4 dropout值對模型性能的影響

圖5 隱藏層單元數對模型性能的影響

5 總結與展望

針對當前網民情感的分析不足,本文引入了一種基于多模態聯合注意力的網民情感分析模型。通過聯合詞引導的注意力機制和圖引導的注意力機制來動態捕捉不同模態之間的關聯關系,減少信息冗余和噪聲,并對新生成的文本和圖片特征向量進行中間層融合,輸入至多層全連接層中,生成預測的情感標簽。本文所提出的模型在真實數據集中進行了實證研究,并與不同的基線模型進行對比分析,實驗結果表明,本文提出的模型具有一定的優勢。

同時,本文也存在一些不足,如所提出的模型僅在中文數據集中進行了驗證。在未來的研究中,將所提出的模型在推特輿情數據集以及公開數據集進行測試,以驗證模型性能。同時,如何更好地捕捉不同模態間的關聯和交互也將是未來研究的重點。