融合深度學習和強化學習的5G無線資源管理*

陳慧敏

(廣東郵電職業技術學院,廣東 廣州 510630)

0 引言

5G時代的到來,超密集組網技術不僅解決小基站密集部署應對熱點區域流量負載分流問題,還解決宏基站的弱覆蓋問題。由于熱點區域上下行業務具有很強突發性,傳統資源配置方法容易產生網絡擁塞問題,不滿足現有網絡無線資源分配需求。因此,面向5G超密集組網的無線資源管理技術備受學者青睞,如:Huang等人[1]通過動態調整小基站的發射功率實現小區級無線網絡資源動態管理;Zhang等人[2]引入遺傳算法實現小區負載均衡和能耗雙目標優化;Tian等人[3]采用遺傳算法實現動態業務子信道和功率分配;劉海燕[4]通過提高邊緣用戶優先級來實現無線資源調度;張月瑩[5]提出了一種基于多優先級信道接入特性的QoE接入控制機制來實現網絡效能優化;楊寧[6]采用深度學習方法來管理多智能體頻譜接入和制定功率分配策略,實現分布式聯合用戶關聯、信道接入和時間幀策略選擇。

綜上所述,無線資源管理策略的研究成果可以歸納為兩方面:(1)最大資源利用率準則無線資源管理策略,以系統最大吞吐量、頻譜資源為目標將資源分配給用戶;(2)公平準則無線資源管理策略,兼顧用戶獲得資源機會的概率和系統性能。在參考學者研究基礎上,本文探討面向5G超密集組網的無線資源管理技術,在保證用戶QoS的情況下,以系統吞吐量最大化為目標,結合信道狀態信息采用強化學習選擇合適信道資源,降低信道資源開銷,有效利用無線網絡頻譜資源。

1 5G超密集組網部署場景及無線資源管理思路

小小區(稱為小基站)是小型低功率節點統稱,發射功率一般在30 dBm左右,其覆蓋范圍在100~1 000 m之間,部署靈活、網絡效率高,特別適用于解決宏基站弱覆蓋的場景,也適用于密集區域熱點分流的場景。小基站密集化部署作為5G超密集組網的重要部署方式,不僅能夠彌補宏基站弱覆蓋場景的覆蓋空洞缺陷,還能分流熱點區域的數據流量,提升整個網絡容量,提高用戶傳輸速率。小基站在3GPP標準化R12中有4種典型的5G超密集組網部署場景,分別是:小基站與宏基站同頻部署、小基站(室外)與宏基站異頻部署、小基站(室內)與宏基站異頻部署以及小基站單獨部署。

超密集組網部署方式給無線資源的管理帶來了新的挑戰:不同回程鏈路的選擇會影響網絡速率和時延性能,如何根據用戶業務使用需求選擇可靠的回程鏈路,提升網絡性能;如何在有效利用小基站資源實現宏基站業務的卸載的情況下降低小基站之間的頻繁切換,提升用戶服務體驗;如何實現宏站和小基站的有效協同,實現無線網絡的負載均衡,合理分流網絡流量,并保障用戶的服務體驗;如何根據用戶業務使用的潮汐效應,對小基站進行動態的開啟和關閉,降低小基站的運營和維護成本;如何在結合業務上下行的使用情況降低宏基站和小基站同頻部署干擾。

本文面向5G超密集組網重點研究以用戶為中心的無線資源管理技術,重點關注信道狀態動態變化情況下如何實現可用信道的有效選擇,確保滿足用戶QoS情況下實現系統吞吐量最大化。

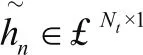

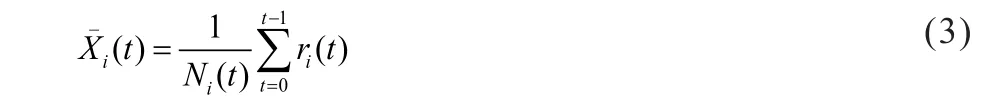

2 基于深度學習的網絡信道狀態感知算法

5G超密集組網架構會利用大規模MIMO技術實現空間復用增益、分集增益以及波束成形的能力,通過在發射端配置多根天線實現多收和多發,能鞏固在不增加頻譜資源的前提下成倍提升信道容量[7]。而實現空間復用增益、分級增益是建立在基站能夠準確、實時掌握上行鏈路和下行鏈路信道狀態信息基礎上,一般來說,上行鏈路可以通過手機端發送訓練導頻來獲得,基站基于手機發送的訓練導頻信息來估計終端側的信道狀態;下行鏈路首先是基站以恒定的功率發送一個下行導頻給終端側,終端側根據基站下發的導頻信息估計下行鏈路的信道相關矩陣,終端側基于信道矩陣的空頻域向量來進行基站下行鏈路信道狀態的估計,并將信道狀態估計信息通過反饋鏈路上報到基站,基站根據終端的評估結果來實現傳輸信道資源分配。

由于上述信道狀態估計的假設是終端側獲取信道狀態數據與基站傳輸數據的時間間隔很小,因此,基于上述假設信道相關調度和鏈路自適應在低移動性的場景下可以獲得很好的效果,一旦終端側發生高速移動,那么從終端側獲得的信道狀態已經過時,基于先驗信道結構特征的信號狀態估計值將會失效,其次,終端側通過反饋鏈路將CSI矩陣中的相關參數反饋給基站,在實際中將會消耗大量資源,增加信道的開銷。因此,相關的研究[8-10]更傾向于提取信道狀態時空相關性特征的思路來反映時變信道狀態。

圖1 基于深度學習的網絡信道特征提取算法圖

3 基于強化學習的信道接入策略選擇算法

3.1 無線資源選擇問題建模

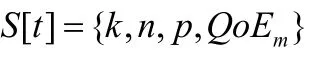

強化學習模型是由Agent、environment、action三部分組成,Agent是一個自主感知信道狀態和學習信道環境能力的系統,在本文中我們定義Agent為用戶終端側,environment是指終端側能夠感受到基站的信道狀態以及同一小區其他用戶信道反饋參數;action信道接入的策略;reward是成功接入某個信道并且滿足業務所需要的最小QoE所獲得的獎勵;state表示系統當前時刻T的信道狀態。基于強化學習的信道接入策略選擇示例圖如圖2所示。

圖2 基于強化學習的信道接入策略選擇示例圖

強化學習的算法主要包括兩種:策略空間搜索和值函數估計,策略空間搜索適用于環境變化比較小的情況;值函數估計的核心是環境狀態的估計。由于本文的信道狀態是一個動態的變量,因此本文采用值函數估計的方法來解決用戶終端接入信道的問題。

考慮到終端側在接入信道時,定義信道狀態為1(即“信道空閑”),而當信道被其他終端占用,定義信道狀態為1(即“信道忙”),那么在信道狀態估計的情況下,t時刻終端側的瞬間吞吐量(或者稱為瞬間回報率)為:

那么基于強化學習的方法終端側對信道進行有限探索之后,截至到t時刻某個小區內海量終端側選擇某一個信道i的次數為Ni(t)后,系統得到的平均吞吐量為:

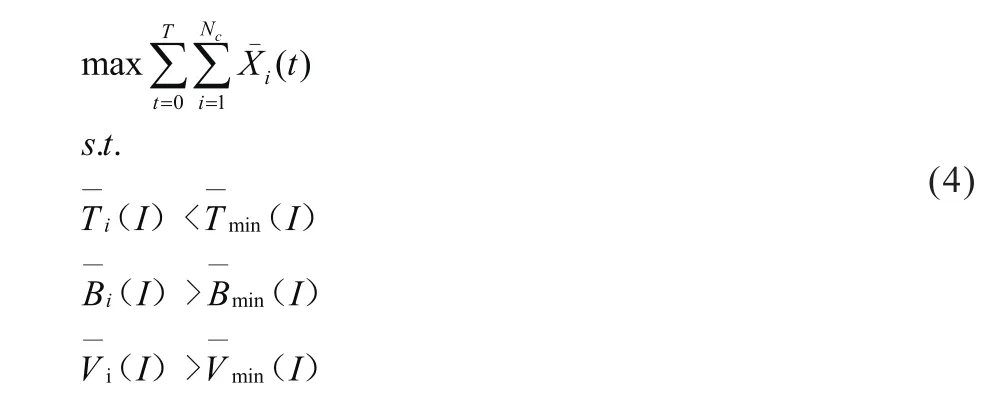

那么,在特定時間周期T內,基于業務QoS約束下吞吐量最大化目標為:

式(4)的第一部分是在特定時間周期T內手機信道選擇各個信道后,系統得到的平均吞吐量;第二部分是指選擇信道i后的業務I的平均時延要小于業務I設定的時延閾值;第三部分是指選擇信道i后的業務I的平均帶寬要大于業務I設定的帶寬閾值;第四部分是指選擇信道i后的業務I的平均速率要大于業務I設定的速度閾值。

系統基于當前信道狀態估計和系統得到的瞬間回報基礎上,結合(式(4))選擇“合適”的信道讓終端側接入無線環境。

3.2 基Q學習無線資源管理方法

本文采用將每一個終端視為一個agent,通過采集信道狀態信息以及相鄰基站信道狀態,然后選擇一種最大化系統吞吐量來實現信道接入。為了實現全局最優,本文定義一個統一管理的資源分配策略表,一旦某一個終端實現無線資源接入,該策略表通過集中控制器進行更新,從而每個終端將會感知到基站的資源分配情況。基于Q學習無線資源管理方法為:

Agent:每個基站作為一個agent;

Action:在t時刻下系統的策略集a[t];

Reward:系統獎勵為系統的最大吞吐量之和,也就是滿足當前用戶QoE約束下agentk選擇空閑信道i的平均吞吐量r[t]。

基于上述定義,Q函數學習的更新過程如下:

β表示上一時刻策略選擇對下一時刻策略選擇的影響系數。每一個agent在信道進行探索,決定繼續探索還是直接接入該信道。首次的信道分配是隨機選擇的,QoEm的實時測量是用于后續無線終端接入中資源分配的標準。在無線終端接入擴張過程中,系統選擇Q值最大的方案進行信道資源的分配,然后結合學習概率不斷迭代,尋找全局最優方案。系統在完成最優策略后,Q表根據當前的狀態以及策略的選擇進行Q值更新;然后每一個Agent將開始觀察觀察下一個狀態,進入下一次無線資源接入策略的選擇,如此不斷迭代。

4 實驗分析

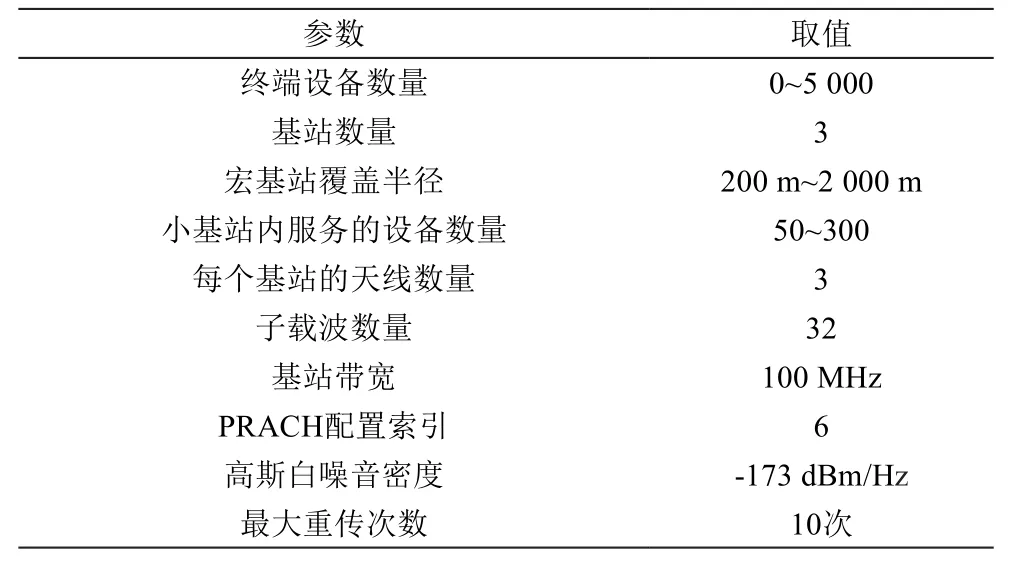

本文在一個空曠小區搭建實驗環境,設置基站數量為3,天線數量為32,子載波數量為256,信道狀態矩陣維度為32×256維。假設終端接入請求服從泊松分布,終端接入數量為0~5 000個,具體仿真參數如表1所示。為了驗證5G超密集組網接入擁塞問題,本文在仿真過程中沒有考慮信道衰落和損耗,而將擁塞的原因歸結為由于信道資源分配不合理導致的接入沖突或者碰撞。為了對信道狀態進行有效估計,本文使用30個批次數據進行多次訓練,其中包括5 000個正常信號樣本和3 000個噪音樣本,最后采用1 000個測試樣本對信道狀態感知算法進行測試。下面將隨機高斯測量矩陣與本文算法在NRSE(歸一化根平均誤差)進行對比,以此來對比采用更少的測量值情況下信道狀態矩陣的恢復精度。

表1 仿真參數

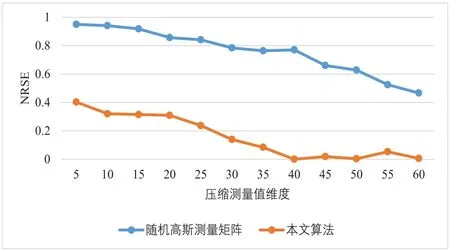

高斯測量矩陣是假設信道數據結構特征滿足高斯分布,而本文算法的測量矩陣是基于空頻域特征和時延域特征進行學習后,引入注意力機制對空頻域特征和時延域特征進行融合后得到的信道數據結構特征。從圖3可知,本文的算法能夠采用更少的測量實現相同水平的恢復精度,在實際中相當于需要更少的資源開銷就能實現信道狀態的估計。

圖3 不同測量矩陣的NRSE性能對比圖

基站側獲取已經成功接入的請求數量以及接入前導的資源情況,但無法獲取其覆蓋范圍下即將接入的請求數量,為了求解接入成功率,我們通常采用隨機前導序列的使用情況來確定當前基站請求的規模。因此,接入成功率=成功接入的請求數量/前導序列請求數量。

當終端側發出無線接入請求時,每個基站/小基站設置信道資源,信道資源數量決定了接入終端設備的數量。海量的終端請求在短時間內發出,但是信道資源分配是有限的,為了簡化計算,本文設置基站分配信道的大小等同于信道的數量。因此,系統平均吞吐量是在一段時間內網絡成功傳輸的信道數量平均值。

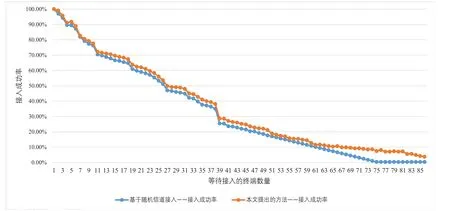

在獲取信道狀態特征的基礎上,本文采用強化學習的方法實現信道選擇,將傳統的隨機信道接入算法與本文提出的算法在接入成功率和系統平均吞吐量兩方面進行比較。

從圖4可知,終端接入成功率隨著接入數量的增加呈現下降的趨勢,這是因為空閑信道的數量是有限的,當等待接入的終端越多時,隨機分配算法很可能將用戶終端分配到同一個信道上,最終導致接入失敗。而本文算法會結合基站的信道狀態以及同一小區其他用戶反饋參數合理分配信道資源,除此之外,本文的信道分配是基于業務QoS約束下進行分配的,因此在一定程度上降低了數據傳輸的失敗率。

圖4 不同算法接入成功率的對比圖

從圖5可知,本文提出算法比現有隨機接入信道算法擁有更高的平均吞吐量,這是因為本文算法是基于業務QoS約束下以吞吐量最大化為目標對可用信道進行選擇,而隨機接入僅僅考慮信道的可用性,沒有結合業務本身的需求以及系統吞吐量等條件的約束,因此在同等條件下,隨機接入信道算法需要更高的頻譜資源才能實現系統平均吞吐量的快速提升。

圖5 不同算法平均吞吐量的對比圖

5 結束語

本文提出一種面向5G超密集組網的無線資源管理策略,通過深度學習的方法獲取信道狀態信息,該方法無需要獲取先驗的信道數據特征,引入注意力機制對空頻域特征和時延域特征進行有效融合,能夠采用更少的測量值實現相同水平的恢復精度,大大降低了信道的資源開銷。除此之外,采用強化學習的方法選擇可用信道,基于現

道狀態估計和在有限探索的基礎上,在業務QoS約束下以系統吞吐量最大化為目標實現可用信道的選擇,會在很大程度上提升了終端側的接入成功率和系統平均吞吐量。實驗表明,本文無線資源管理策略不僅能夠節省信道資源開銷,還能提升頻譜利用的效率,提升用戶滿意度。