結合注意力與多尺度時空信息的行為識別算法

秦宇龍,王永雄,胡川飛,邵 杭

(上海理工大學 光電信息與計算機工程學院,上海 200093)

1 引 言

視頻人體行為識別指的是利用計算機相關算法,對視頻序列進行特征捕獲、提取、分析、處理,并實現對其中的人體動作行為進行正確理解和認知[1].隨著信息技術的發展,視頻行為識別已被廣泛地應用于安防監控、人機交互、異常行為檢測、人機混合增強、自動駕駛、智能服務等領域[2].但是,相比于二維靜態圖像的處理和識別,識別視頻中的人體動作行為不僅要利用視頻序列的空間信息,還需要獲取其時間信息.因此,視頻行為識別在具有廣闊的應用前景的同時,仍面臨著模型參數量較大、時空特征提取效率較低、對視角敏感和識別精度不理想等諸多挑戰[3].

當前,視頻行為識別算法主要可以分為兩個大類:基于手工特征提取的識別方法和基于深度學習的識別方法.傳統的行為識別,需要逐幀地對視頻進行手工特征提取,以獲得相應的特征向量,再基于特定的分類器進行分類[4].這類方法主要包括:基于3D-Harris角點特征的行為識別[5],基于3D梯度直方圖(3DHOG)特征描述子的行為識別[6],基于光流直方圖(HOF)特征描述子的行為識別[7]以及改進的密集軌跡光流算法(iDT)[8]等.但是,這些傳統算法在特征提取過程中的計算量較大且泛化能力較差,通常只適用于在特定、規模較小的視頻數據集上完成識別任務,難以滿足對大規模視頻數據進行高效處理的需求.

得益于深度學習的快速發展,通過卷積層和池化層進行堆疊的卷積神經網絡,已被證明具有優異的特征提取能力.在目標檢測、圖像分割、圖像修復[9]等領域取得到了廣泛的應用和顯著的成果.基于深度學習的行為識別方法,在減少計算成本、提高網絡泛化能力的同時,可以實現端到端的訓練、測試與應用,實現對海量數據的高效處理.

根據卷積核形式的不同,基于深度學習的行為識別方法,可以分為基于2D卷積網絡和基于3D卷積網絡兩大類別.其中,基于2D卷積網絡的算法以Simonyan等人[10]提出的雙流卷積網絡(Two-stream CNN)為代表.該方法提出對雙分支結構,分別使用RGB圖像和相鄰幀之間的光流圖像作為兩個網絡分支模塊的輸入,以此來同時獲取視頻的時間信息和空間信息.網絡對兩部分的分類得分進行融合并得到最終的判別結果.雙流結構的出現,為其后一系列的行為識別算法奠定了基礎.Feichtenhofer等人[11]在雙流主干網絡中,結合特定的VGGNet,研究了信息融合的位置對于識別精度的影響;Wang等人[12]將Bn-Inception應用到雙流結構,提出TSN算法,實現對長時間序列的視頻進行建模分類;Christoph等人[13]提出橫向連接的SlowFast網絡,使用不同速率的視頻序列作為兩個分支的輸入,并通過橫向連接進行識別分類.基于2D卷積網絡的方法,大多采用信息融合的方式,間接實現視頻中時空信息的提取.但是,這樣的做法會破壞視頻中時空信息的完整性,同時采用手工標定的特征作為網絡額外的輸入信息,導致計算開銷仍舊較大,極大影響算法的訓練效率和應用范圍.

相比于2D卷積的方法,基于3D卷積網絡的方法,網絡結構更加簡單高效.可以直接有效地從原始視頻中提取時空特征信息,而無需額外的信息融合,極大提高網絡提取時空特征的效率.Ji等人[14]在傳統2D卷積的基礎上,引入3D卷積對時空維度進行提取,并首次將其應用在行為識別領域.Tran等人[15]通過3D卷積層、3D池化層的堆疊連接,構建了一個簡單高效的網絡架構C3D.該網絡可直接從原始輸入視頻中提取時空特征,證明了3D卷積網絡在時空信息提取方面的優越表現.

此后,以C3D 網絡為基礎的3D卷積神經網絡成為主流方法之一,但其結構復雜、參數量龐大、不易于訓練.針對3D卷積神經網絡和人體行為多樣化等問題,研究者以提高時空特征提取的效率或減少網絡參數為目標,進行更深層次的探索.Tran等人[16]提出Res3D網絡,將殘差思想與3D卷積相結合,來解決網絡中梯度消失的問題.Diba等人[17]和Carreira等人[18]從不同的層面將Inception的思想擴展到3D卷積,提出T3D和I3D網絡.通過不同尺度的卷積,來捕獲豐富的時空信息.但其參數量較大,易造成模型參數的大量冗余.Qiu等人[19]和Tran等人[20]結合時空分割的思想,對經典的3D卷積的結構分解為時間卷積和空間卷積.有效減少網絡參數量同時,增加了卷積內部的非線性關系,提高網絡提取時空特征效果.但其卷積尺寸固定不變,缺乏對不同尺度時空特征的層次結構進行分析,導致其時空感受野單一,對多樣化的人體行為識別的泛化性較差.Tran等人[21]借助分組卷積,在通道維度進行研究,通過通道維度的交互,提高特征提取的效率.Yang等人[22]引入視覺速率(Visual tempo)的概念,對視頻動作的速率快慢進行研究,提出TPN網絡.該網絡通過特征金字塔結構特性,實現多尺度特征的提取與融合,驗證了多尺度的特征提取,有利于網絡識別效果的提升.但是,利用金字塔結構獲取多尺度信息,時間復雜度較高,網絡結構較復雜,在訓練優化方面有一定的難度.

為了更簡潔、有效地實現視頻中的行為識別目標,本文提出一種新穎的多尺度通道分離的時空卷積網絡(MCST-Net)用于人體行為識別.該網絡以MCST模塊為基礎,在特征的通道維度進行分割,特征子集通過不同分支的卷積處理后,得到不同尺度的時空特征并進行多尺度融合.MCST模塊的類殘差結構,在參數量有所降低的前提下,可以有效地獲得多種尺度的時空感受野范圍,充分地利用特征各維度的信息進行訓練.這使網絡在視頻樣本中提取豐富的時空特征,達到提高網絡對視頻對象理解能力的目標.同時,為了優化MCST-Net提出了一種改進的非局部注意力模塊(Improved non-local attention module,INLA).該模塊在Wang等人[23]提出非局部注意力模塊的基礎上,增加了多種尺度的池化模塊進行采樣操作.通過多種尺度的采樣點信息,等效的代替特征圖中的所有位置,在時空維度上降低特征的尺寸大小,有效解決了非局部注意力機制中的時間復雜度高和占用顯存較大的問題.并建立時空特征的全局依賴關系,獲取時空特征中的關鍵信息.本文提出的網絡結構有利于解決人體行為識別中,網絡泛化能力較弱、參數量大、結構復雜等問題,并在公開數據集UCF101[24]和HMDB51[25]上取得了優異的識別效果,分別達到77.4%和45.2%的識別準確率,超過目前主流的行為識別方法.

2 多尺度通道分離的時空卷積網絡MCST-Net

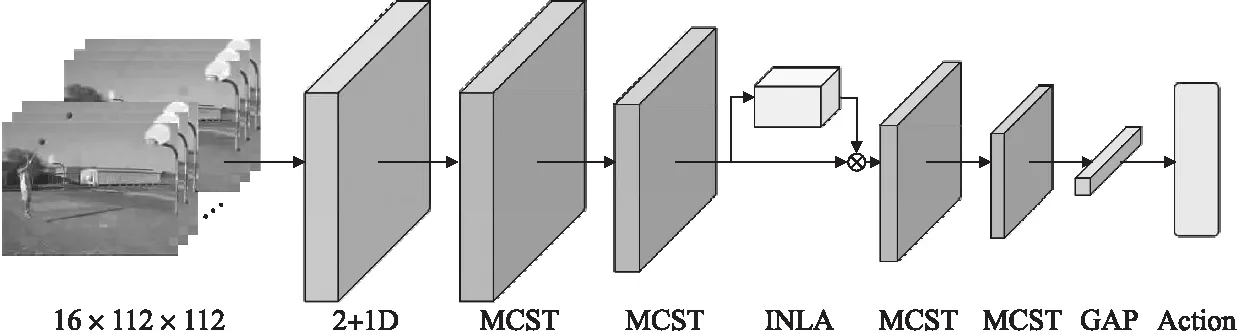

本文提出的網絡架構MCST-Net如圖1所示.使用多個MCST模塊(見圖2)作為網絡的主體卷積層,并在網絡的中段加入INLA模塊(見圖3).該網絡可以有效地提取視頻中的時空特征,具有較優異的視頻理解能力.

圖1 MCST-Net網絡架構圖

2.1 多尺度通道分離的時空卷積模塊MCST

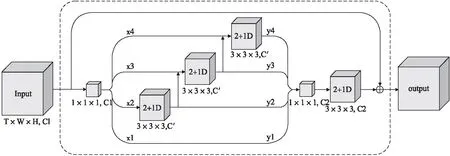

提出的多尺度通道分離的時空卷積模塊(MCST),是MCST-Net的主體部分,用于提高網絡的視頻識別能力.在多尺度時空特征提取的過程中,MCST模塊沒有采用并行時空金字塔的方法,而是借鑒Res2net[26]中圖像特征的提取方式,通過構建層內的類殘差結構,對輸入特征的通道進行分割,獲得多個子集依次進行卷積操作,并將各分支的輸出層次化連接,實現多尺度融合.這樣在不引入額外參數的條件下,依次將一組卷積的輸出特征和另一組卷積的輸入特征相組合,等效地擴大每個卷積的感受野范圍,獲得多尺度的時空特征.MCST模塊充分利用了特征通道維度的信息,獲得更豐富的時空特征,提高網絡的行為識別效果.MCST模塊的結構如圖2所示.

圖2 MCST模塊結構圖

在我們的MCST模塊中,使用時空分割的2+1D卷積塊,代替經典的3×3×3的3D卷積,分別處理特征的時間維度和空間維度,以此控制卷積部分的參數量.然后采用類殘差的結構,將卷積塊組合,等效地獲取多個尺度的時空感受野.具體來講,對于給定的輸入特征X,首先經過1×1×1的卷積處理,完成特征通道維度的交互,并均勻地將輸入特征X的C1個通道分割為S個子集(圖1中尺度參數S=4),記為xi,其中i∈{1,2,…,S}.則每個子集的時空維度大小與輸入特征相同,而通道數C′輸入特征的1/S,即C′=C1/S.然后,除了x1子集外,每個特征子集xi分別經過一個類殘差結構的分支,每個分支都有一組對應的2+1D卷積,記作Ri().一個特征xi經過一組2+1D卷積處理后,提取出一個尺度的時空特征yi.得到的yi通過類殘差結構,與下一組輸入特征xi+1相結合,一起作為下一分支中2+1D卷積Ri+1()的輸入,進行處理.依次重復該過程,使每個子集都經過2+1D卷積的進行特征提取,等效地獲得擴大時空感受野范圍,直到獲得所有分支輸出的時空特征.各分支輸出特征yi的獲取過程,可表示為:

(1)

在分割過程中,通過層次化連接的類殘差結構,重復利用不同卷積組之間的特征,有利于擴大卷積層的時空感受野范圍,實現多尺度時空特征的提取,使網絡獲得更加豐富的視頻信息.此外,在x1子集對應的分支中,MCST模塊省略了卷積操作,直接對該子集特征進行重復利用,一定程度上減少了模塊的參數數量.

獲得各子集的時空特征yi后,將所有的時空特征連接起來,并通過1×1×1的卷積,進行信息融合.通過一個2+1D卷積塊進一步處理,并與殘差結構相結合,避免梯度消失等問題.最后獲得MCST模塊輸出的時空特征,輸出結果的計算如公式(2)所示:

Y=X+F([y1;y2;…;ys])

(2)

其中,X代表MCST模塊的輸入特征,Y代表輸出特征,F()代表最后的2+1D卷積處理操作.

MCST模塊通過控制尺度參數S,調整模塊中時空感受野的范圍.相比于固定感受野的方法,MCST模塊可以學習更豐富的時空特征,參數數量也有一定的降低.

2.2 改進的非局部注意力模塊INLA

注意力機制是一種權重自動配置的機制.通過學習相關特征,對輸入特征的權重重新分配,提高網絡對于相關特征的提取效果.Wang等人提出的非局部注意力模塊(Non-local Black,NL),采用非局部均值設計,通過建立特征圖中所有位置的全局依賴關系,獲取特征的時空上下文關系,進而提高網絡的特征提取能力.在I3D、SlowFast等網絡中已經證明,NL模塊可以有效地提升網絡對于全局特征的表達能力,進一步提高人體行為的識別準確率.

但是,在使用3D卷積網絡對視頻任務進行處理的過程中,采用NL模塊計算特征圖中所有位置的全局依賴關系,會導致注意力機制的計算量較大,占用過多的顯卡內存,降低了網絡的訓練效率.所以本文提出一種改進的非局部注意力模塊(INLA).此模塊在建立特征全局依賴關系的同時,通過采樣操作,降低注意力機制的計算量,減少注意力機制占用的顯存空間,使MCST-Net更加高效的完成人體行為識別任務.

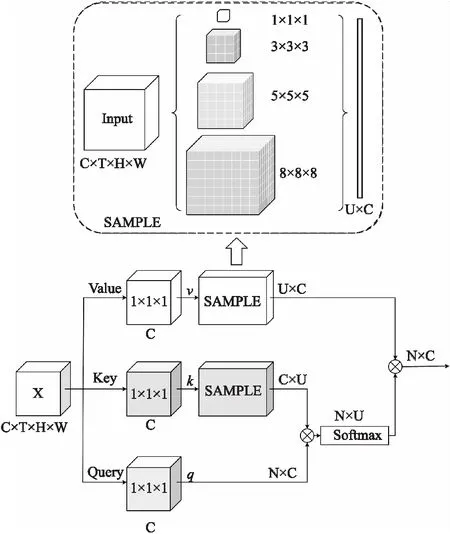

INLA模塊的整體結構如圖3所示.與NL模塊相類似,INLA模塊由Value、Key和Query 3個分支組成.但在Value和Key分支中,增加了采樣操作.采樣的操作過程如圖3中虛線框內所示.具體來講,首先將輸入的特征X∈RC×T×H×W,分別送入3個分支的1×1×1卷積,進行通道維度的重構.然后對Query分支的時空維度進行展開處理,即N=T×H×W.得到該分支的輸出特征q∈RN×C,可由公式(3)表示,其中Wq()代表該分支的卷積和展開過程.

圖3 INLA結構圖

q=Wq(X)

(3)

而對于Value和Key分支,增加了采樣處理的操作.采樣過程參考了空間金字塔池化層的思想,使用多種尺度的3D自適應池化層,對輸入特征進行采樣處理.采樣的尺度分別為[1,3,5,8],將時空特征按照4種尺度進行平均池化,以代表不同時空特征區域的注意力特征.并對輸出的注意力特征,進行展開和拼接處理,則采樣點總數U可通過公式(4)表示.

(4)

兩個分支的輸出特征為v∈RU×C和k∈RC×U,通過公式(5)、公式(6)表示,其中Wv()、Wk()代表兩分支的卷積過程,S()代表各分支的采樣過程.

v=S(Wv(X))

(5)

k=S(Wk(X))

(6)

將輸出特征k和q相乘,并經過softmax函數進行歸一化處理,得到該模塊中的相似矩陣.最后與輸出特征q相乘,得到INLA模塊的最終輸出Y,則INLA模塊獲得注意力權重的過程可通過公式(7)表示:

Y=v×softmax(k×q)

(7)

在NL模塊中,通過計算所有位置的全局依賴關系,獲得注意力權重.其時間復雜度主要來自于3個分支的矩陣乘積部分,可以記作O(CN2).而INLA模塊通過計算采樣點的全局依賴關系,來降低計算量.以U個采樣點代替特征的所有點,則INAL的時間復雜度為O(CNU).當輸入注意力模塊的特征尺寸為8×28×28時,特征的位置點個數N=T×H×W=6272,遠遠大于采樣點U=665,因此INLA模塊可以有效降低模塊的時間復雜度,減少模塊占用的顯存空間.INLA模塊在保留特征的全局依賴關系的前提下,不會改變輸入輸出特征的尺寸,可以與多種網絡結構相結合,具有一定的通用性.同時,該模塊解決了非局部注意力機制中計算量較大的問題,提高MCST-Net在人體行為識別任務中的準確率和訓練效率.

3 實驗結果與分析

為了驗證本文提出的MCST-Net在視頻行為識別任務中的有效性,本文在兩個主流的數據集UCF101和HMDB51進行大量的實驗.所做實驗基于Pytorch 3.0的深度學習框架,使用Nvidia Geforce GTX 1080 GPU硬件平臺來實現.本節首先介紹本文算法中相關細節和參數設定.然后在相關數據集下,對網絡的不同部分的進行消融實驗,研究各部分對網絡識別效果的影響.最后與目前主流識別方法的測試準確率進行比較.

3.1 實驗數據集

為驗證本文所提算法的有效性和普適性,我們使用兩個不同類型的人體行為公開數據集UCF101和HMDB51進行實驗.

UCF101數據集是人體行為識別領域最經典的數據集之一.其數據樣本來源于視頻網站YouTube上的各類行為動作視頻,分為101個動作類別,共13320段視頻.主要包括人-物交互,人-人交互,彈奏樂器等行為.UCF101數據集具有行為動作多樣、背景雜亂和相機抖動等特點,使得樣本內容更貼近現實動作,識別起來更具挑戰性.也是行為識別領域評估網絡效果時,最常使用的數據集之一.

HMDB51數據集由布朗大學發布的一個行為識別數據集.該數據集的樣本主要來源于電影、YouTube和Google視頻等.其中包含了51個動作類別,共6849個視頻片段,每個類別至少包含101個視頻樣本.主要包括面部動作、一般身體動作和對象交互動作等5種類型.由于樣本的來源較廣、視頻場景復雜、光照條件多變等因素,HMDB51是目前最具挑戰性的行為識別數據集之一.

3.2 網絡訓練設置

預處理:首先,參考C3D、Resnet3D等文章的方式,對視頻數據進行預處理.將25fps的視頻樣本,逐幀地分解為若干個視頻段,每段包含16幀連續的RGB視頻幀.在網絡訓練的過程中,數據擴充的方法,可以有效處理過擬合問題.所以本文在訓練網絡時,為了防止出現樣本不足導致過擬合而影響網絡泛化能力的問題,采用隨機翻轉和多尺度偏移隨機裁剪的方法,對數據集的訓練樣本進行數據擴充,來增加數據樣本的多樣性,提高網絡學習特征效果.因為有序的視頻幀之間存在復雜的時空特征信息,所以在進行數據擴充時,同一視頻段的16個視頻幀,需采用相同的處理方式進行處理,避免破壞其時序相關性.對于訓練樣本,將輸入尺寸的320×240像素的視頻幀,按比例縮放為171×128像素大小.再進行隨機裁剪,固定為112×112像素的視頻段,并使用ImageNet dataset標準化系數,對輸入視頻段進行標準化處理,以加快網絡的收斂速度.最后,按50%的概率對數據樣本進行水平翻轉處理.而對于驗證集的樣本,只進行尺寸縮放、中心裁剪和標準化處理.

參數設定和訓練:本實驗在相關數據集下,使用隨機初始化權值的方式訓練網絡模型.經過預處理后,以大小為16×112×112像素的RGB視頻幀作為網絡輸入.訓練過程中,使用隨機梯度下降法和交叉熵損失函數,對模型進行優化訓練,動量設為0.9,權重衰減系數設為0.005.網絡訓練的初始學習率設為0.005,每迭代10次,學習率就減少為原來的1/10,共進行39次迭代.

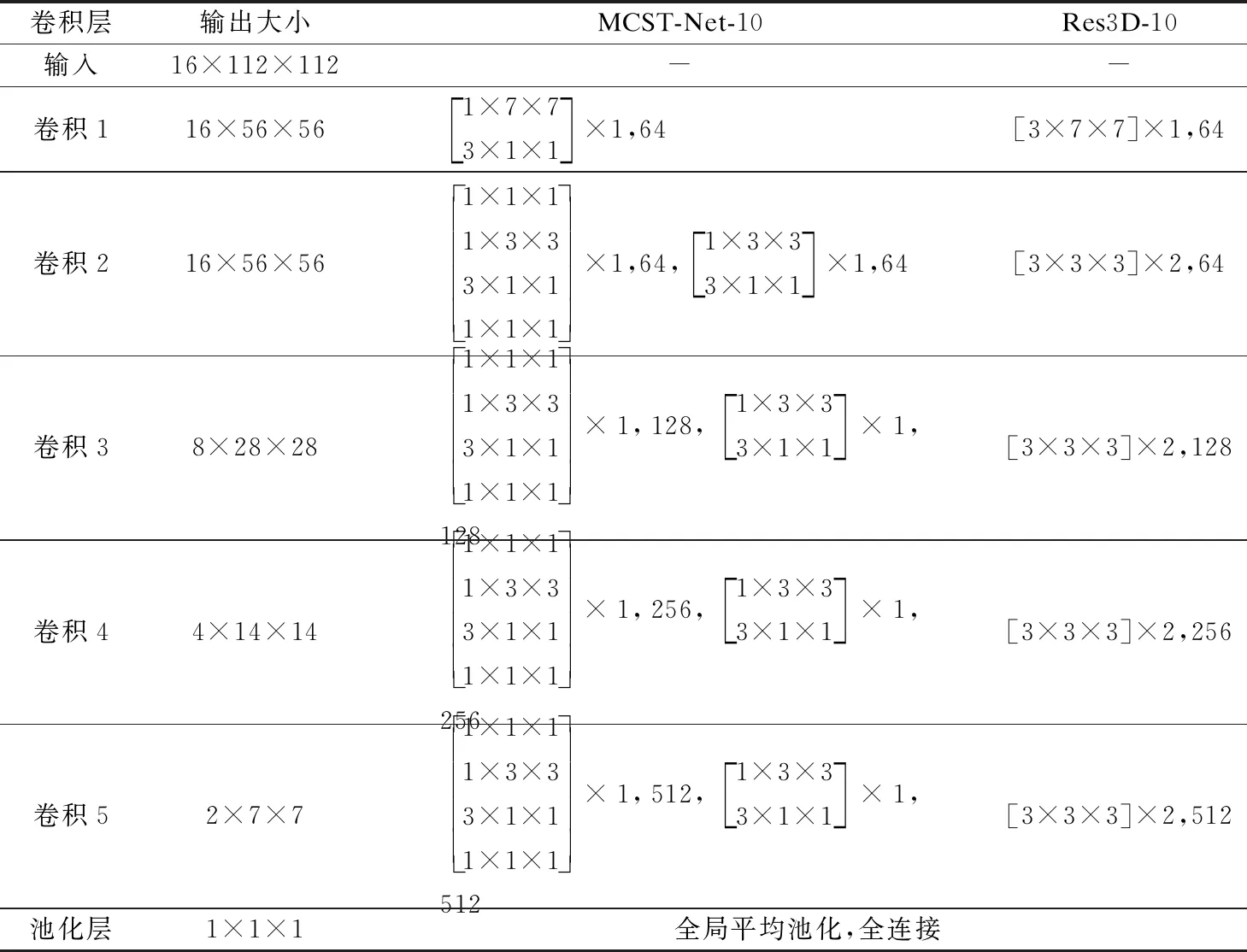

3.3 網絡架構

本文主要使用MCST-Net-10以及Res3D-10的網絡進行實驗,網絡架構的具體設定如表1所示.MCST-Net-10在卷積1后,采用大小為1×2×2,時間步長為1,空間步長為2的3D池化層進行空間下采樣,來縮小特征圖的空間尺度.在網絡的前期,為了保留更多的時序信息,不進行時間下采樣.而在卷積塊3、4、5后,統一使用大小為2×2×2,步長為2的3D池化層,對特征進行時空下采樣,降低特征的時空尺度.網絡模型中,所有時空卷積的步長設為1,并在卷積處理后進行批量歸一化和激活函數(ReLU)操作.最后通過全局平均池化、全連接層以及softmax函數完成網絡的動作分類.

表1 MCST-Net-10和Res3D-10網絡架構

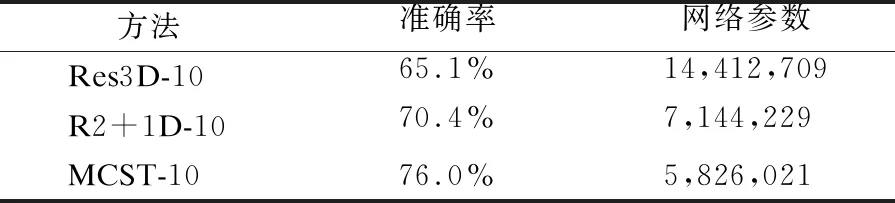

3.4 MCST模塊與基于3D卷積方法的對比實驗與分析

為了驗證本文所提出的MCST模塊的有效性,我們首先對基于3D卷積的兩種經典方法:Res3D網絡和R2+1D網絡進行復現.Res3D網絡在經典的3D卷積結構中,增加殘差結構,解決了梯度消失的問題;而R2+1D網絡將3D卷積進行時空分割,有效降低3D卷積的參數量,提高網絡的提取效率.本文在相同條件下,基于UCF101數據集與未添加注意力模塊的MCST-Net進行對比實驗,從識別準確率和網絡參數兩方面進行分析評估.其中MCST模塊的尺度參數設為4,實驗結果如表2所示.整個訓練過程中,各網絡測試準確率的變化情況如圖4所示.

圖4 基于UCF101數據集的測試準確率

表2 基于UCF101數據集的實驗結果

實驗結果可以看出,本文所提出的MCST-Net在識別準確率和網絡參數方面明顯優于Res3D網絡和R2+1D網絡兩種經典的3D卷積方法.在網絡深度相同的條件下,MCST-Net-10的識別準確率達到了76.0%,比R2+1D-10提高約5.4%,比Res3D-10提高約10.9%.而且MCST-Net-10的網絡參數大約為583萬個,僅為R2+1D-10的81%,Res3D-10的40.4%.參數量的下降,對于網絡的優化與訓練是非常有利的.實驗結果進一步驗證了MCST模塊的優越表現.分析其原因是:MCST模塊采用類殘差的結構對輸入特征進行通道分離,獲得多尺度的時空感受野范圍,可以更充分的利用各維度的特征信息.因此,MCST模塊有利于學習更豐富的時空特征信息,使網絡能夠更全面的完成復雜動作的識別任務,而且識別準確率更高,參數利用更高效.

3.5 不同尺度MCST模塊的對比實驗與分析

MCST模塊的核心思想是通過類殘差的結構,分別對通道的多個子集進行卷積處理,獲得多尺度時空特征.而這種分割的操作就引入了一個尺度參數S.在保證網絡的深度、寬度等條件一致的前提下,本節通過一系列的實驗,評估尺度參數S的改變,對于網絡性能的影響.

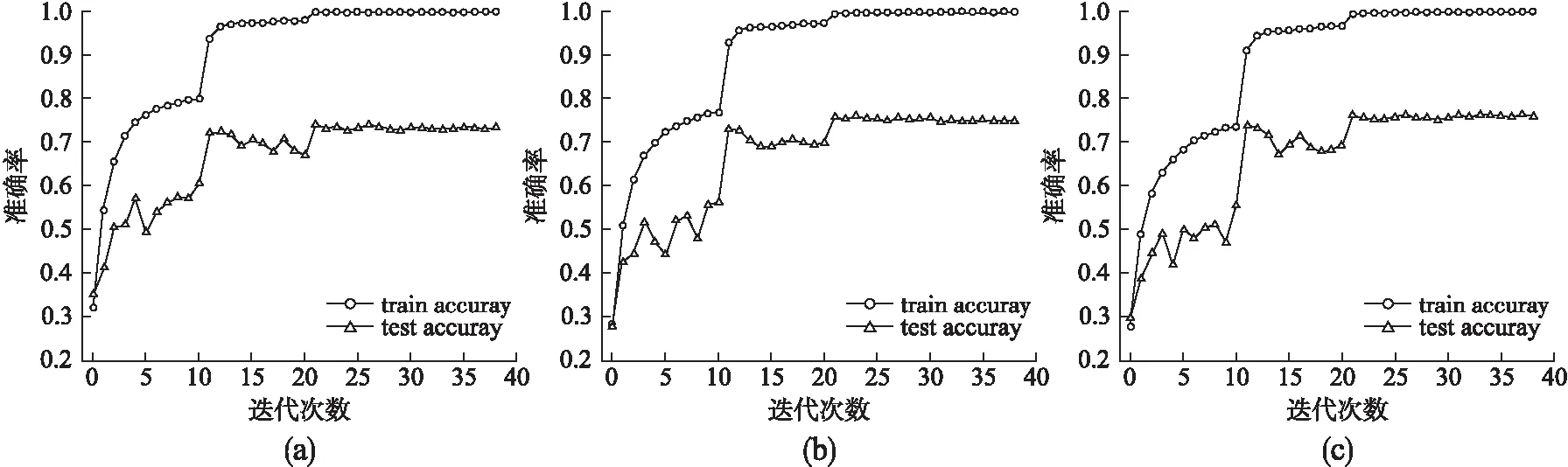

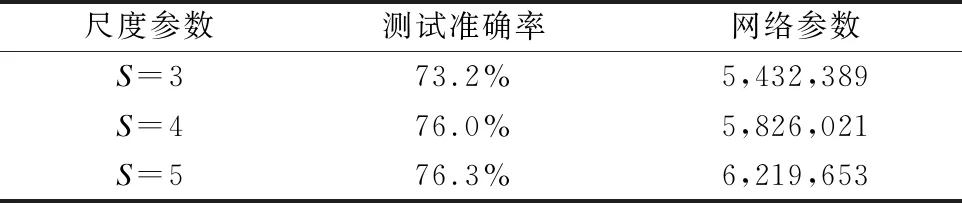

由于S=2時,MCST模塊在特征重利用的比例較高,不利于時空特征提取效果的提升,所以本節未對尺度參數S=2的情況進行研究.本節實驗主要設定了3種尺度參數的方案,分別為S=3、S=4和S=5.在UCF101數據集上進行對比驗證,整個實驗過程中,各種尺度的訓練準確率和測試準確率變化情況如圖5(a)-圖5(c)所示.根據實驗結果可以看出,在實驗前期,隨著尺度參數的增大,訓練準確率的提升速度略微減慢.這是由于尺度的增加,使網絡的參數有所改變,導致網絡的前期的優化效率略微降低.但隨著迭代次數的增加,最終的訓練準確率均可以達到很好的收斂效果.而測試準確率隨著尺度參數的增大而有所提高,且后期測試準確率曲線更加平滑.

圖5 不同尺度MCST-Net的實驗結果

具體的測試準確率和網絡參數結果如表3所示.由于尺度參數的增加,使得x1子集中的通道數下降,進行卷積處理的通道比例上升,所以網絡所需的卷積數量也略有增加,參數量也逐步增加.而測試準確率,卻隨著尺度參數的增加而有所提升.但尺度S=5時,測試準確率的提升是有限的,相比S=4的結果,僅提升了0.3%.本文認為這是由于S=5時等效感受野將達到9×9×9,超出網絡的后期的輸入特征大小,無法進一步提高MCST模塊提取時空特征的效果.所以在考慮測試結果和網絡參數等條件下,尺度參數S=4時,MCST-Net的識別性能更加高效.實驗結果證明了多尺度的時空感受野,有利于網絡學習更豐富的時空特征,來提高網絡在人體行為識別任務中的識別準確率.

表3 不同尺度MCST-Net的實驗結果

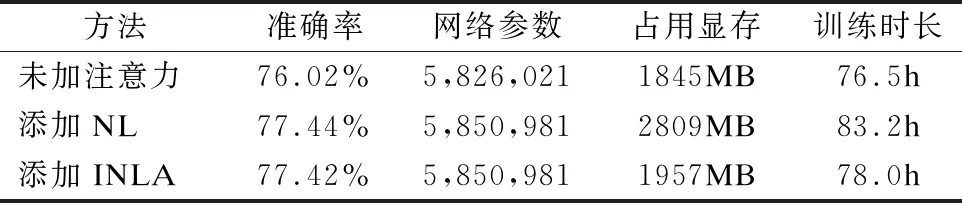

3.6 引入INLA模塊的實驗與分析

為了更有效地實現時空信息的提取,本文還提出了改進的非局部注意力模塊INLA,增強相關特征的全局依賴關系.在相同的實驗條件下,對未加注意模塊、添加NL模塊和添加INLA模塊的3種網絡進行對比實驗.從識別準確率、網絡參數、占用顯存和訓練時長方面進行對比.其中占用顯存的大小是在batch size=1的條件下進行統計的,以避免并行訓練等原因對其數值造成影響.實驗結果如表4所示.

表4 添加注意力機制的實驗結果

通過實驗結果可以發現,添加了注意力模塊的網絡,在識別準確率方面都有所上升,大約提升1.42%~1.44%,而參數量僅增加約0.4%.證明了注意力機制的使用,可以有效地提高網絡提取時空特征信息效果.INLA模塊與NL模塊對于網絡性能的提升效果基本一致,僅相差0.02%,而二者在訓練時長和占用顯存方面有很大差別.相比于添加NL模塊的網絡83.2小時的訓練時長,添加INLA模塊的訓練時長為78.0小時,大約降低了6.25%.間接證明了INLA模塊有效的降低了注意力機制部分的時間復雜度.同時,添加NL模塊的網絡所需顯存為2809MB,而添加INLA模塊的網絡僅需1957MB.大約降低了30.34%.對比實驗的結果,進一步證明了INLA模塊,在保持特征全局依賴關系的前提下,有效地降低了注意力模塊的時間復雜度和占用顯存空間,更有利于網絡的訓練與優化.

3.7 與目前主流方法的對比

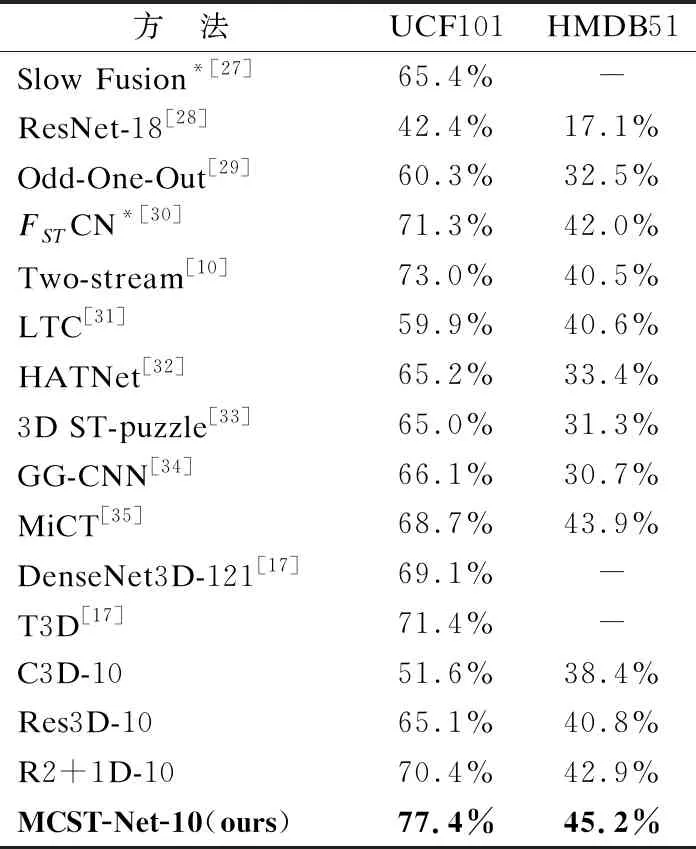

為了進一步驗證MCST-Net在行為識別方面的優越表現,分別在公開的人體行為數據集UCD101和HMDB51上訓練網絡,以RGB視頻作輸入,與目前主流的多種方法進行比較,識別準確率的對比結果如表5所示.

表5 不同方法的識別準確率對比

對比的結果可分為3組,分別為基于2D卷積的方法、基于3D卷積的方法和本文進行復現的方法.基于2D卷積的方法,選取了5個比較具有代表性的方法,以此與3D卷積的方法形成對比,其中*表示該方法需要額外的預訓練或多類別輸入等操作,才能達到的實驗結果.基于3D卷積的幾種方法,從不同角度,對3D卷積網絡進行優化或考慮不同的方式,來處理視頻樣本.本文復現的幾種方法,為了保證實驗的公平性,網絡深度統一設為10層.

通過表5的對比結果可知,本文提出的MCST-Net,在兩個公開數據集中都取得了最好的識別效果,分別達到77.4%和45.2%的測試準確率.相比2D卷積的方法,本文的MCST-Net無需預訓練等額外操作,就能取得更優的識別準確率,比多類別輸入的Two-stream方法,還要提高4.4%和3.2%,較大幅度地提高了網絡的泛化性和普適性.而相比3D卷積的方法,同樣使用UCF101和HMDB51從新開始訓練,MCST-Net獲得了最高的識別準確率,比表中最優的3D卷積方法T3D網絡,還要提高約5%和4%的識別準確率.從表5可以看出,MCST模塊和INLA模塊相結合,可以有效地提取視頻樣本中的時空特征.從而使整個網絡具有較好的泛化能力和識別效果.

4 結 論

本文提出了一種簡單高效的多尺度通道分離的時空卷積網絡(MCST-Net)用于人體行為識別.在網絡中使用類殘差結構的MCST模塊,獲得多尺度的時空特征,使網絡從視頻樣本中提取到的時空信息更加豐富.此外,提出了一種改進的注意力機制INLA模塊,進一步增強時空特征的全局依賴關系,使網絡更加高效的完成人體行為識別任務.所提出的MCST-Net在兩個經典數據集UCF101和HMDB51進行多組實驗評估,識別準確率可以達到77.4%和45.2%.相比目前人體行為識別的幾種主流方法,MCST-Net都取得了更優異的識別效果,具有提取時空信息更豐富、參數量更少、泛化性更強等優點,進一步提高人體行為識別的準確率.