二維線性鑒別分析和協(xié)同表示的面部識(shí)別方法

林克正,鄧 旭,張玉倫

(哈爾濱理工大學(xué) 計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院,哈爾濱 150080)

1 引 言

面部識(shí)別在生物特征識(shí)別技術(shù)中占有重要的位置,同時(shí),在實(shí)際應(yīng)用中面部識(shí)別技術(shù)廣泛地應(yīng)用于交通安全、快捷支付和智能管理等領(lǐng)域內(nèi)[1,2].然而,面部識(shí)別技術(shù)仍存在諸多挑戰(zhàn),如:不同光照、不同角度、變化表情和有無遮擋等.因此,如何更好的提取面部圖像特征來表示圖像成為研究人員研究的熱點(diǎn).

Liu等人提出了基于幾何特征圖像識(shí)別方法[3],該方法提取面部關(guān)鍵器官的位置信息進(jìn)行識(shí)別,如人的眼睛、鼻子等.Gross等人提出基于表象(Appearance-based)的人臉識(shí)別方法[4],該方法將面部圖像看作一個(gè)整體并利用面部的全部信息進(jìn)行面部識(shí)別.主成分分析(Principal Component Analysis,PCA)是基于表象的面部識(shí)別方法之一[5],PCA也稱為K-L變換,它的主要思想是將面部圖像矩陣轉(zhuǎn)換為一維向量.然而,PCA方法可能導(dǎo)致面部圖像部分關(guān)鍵特性丟失,并且算法復(fù)雜度較高.因此Yang等人提出了二維主成分分析方法(Two-Dimensional Principal Component Analysis,2DPCA)[6].2DPCA方法不需要將圖像矩陣轉(zhuǎn)換為一維向量,該方法具有計(jì)算簡(jiǎn)便的顯著特點(diǎn),其計(jì)算代價(jià)遠(yuǎn)小于PCA方法.由于,通過2DPCA方法構(gòu)建協(xié)方差矩陣提取的單一特征不能對(duì)所得圖像都有較好的魯棒性.因此,本文將通過二維線性鑒別分析方法提取兩類特征,將在第2.1部分詳細(xì)介紹.

此外,近年來提出的稀疏表示(Sparse Representation)方法[7]對(duì)于面部識(shí)別非常有效.該方法實(shí)現(xiàn)的主要思想是假設(shè)給定一個(gè)測(cè)試樣本可以由所有類的全體訓(xùn)練樣本線性組合來近似表示,進(jìn)而獲取稀疏表示系數(shù),然后計(jì)算給定的測(cè)試樣本和所有類的訓(xùn)練樣本之間的殘差,即殘差最小的類別是該測(cè)試樣本的類別.Wright等人提出測(cè)試樣本可以由其同類訓(xùn)練樣本線性表示,稀疏表示方法也稱為稀疏表示分類(Sparse Representation based Classification,SRC)[8].SRC方法通過l1范數(shù)求得的稀疏解具有較好的稀疏性,然而,該方法具有較高的計(jì)算代價(jià).為了解決上述這個(gè)問題,Zhang等人通過l2范數(shù)求稀疏解,l2范數(shù)較l1范數(shù)求得的稀疏解具有較弱的稀疏性,但在求解時(shí)可以大大降低其計(jì)算代價(jià),此方法稱為協(xié)同表示分類(Collaborative Representation based Classification,CRC)[9].本文將利用CRC作為分類器,將在第2.2節(jié)詳細(xì)介紹.

Xu等人通常以得分層融合方法、特征層融合方法和決策層融合方法對(duì)兩種特征進(jìn)行融合[10-13].特征層融合方法是將全部生物特征看做一個(gè)樣本進(jìn)行識(shí)別,然而不同生物特征存在較大的差異影響其識(shí)別性能.決策層融合方法是最簡(jiǎn)單的一種融合方法,但是它的融合效果略差于其它兩種融合方法.得分層融合方法[14,15]是將每個(gè)特征得出的各自得分(也稱為距離)進(jìn)行融合.因此,本文采用一種加權(quán)得分融合機(jī)制將類間虛擬圖像、類內(nèi)虛擬圖像和原始圖像[16-18]分別在CRC上的獲得得分并進(jìn)行融合,將在第2.3節(jié)詳細(xì)介紹.為了驗(yàn)證本文方法的識(shí)別性能,分別在ORL、AR、GT不同數(shù)據(jù)庫(kù)上進(jìn)行實(shí)驗(yàn).

本文的主要貢獻(xiàn)如下:

1)本文首次提出對(duì)二維線性鑒別分析的類間散布矩陣和類內(nèi)散布矩陣進(jìn)行特征提取,進(jìn)而得到兩類特征,即類間特征和類內(nèi)特征.有效緩解了單一特征不能很好地表示圖像的問題.

2)本文所提出的類間特征和類內(nèi)特征與原始圖像是互補(bǔ)的.

3)本文采用新穎的加權(quán)得分融合機(jī)制將原始圖像和2)中特征進(jìn)行融合.

本文其余組織如下:第2部分詳細(xì)介紹了提出方法;第3部分展示了提出方法的性能;第4部分提供了實(shí)驗(yàn)結(jié)果;第5部分給出了本文的結(jié)論.

2 提出的方法

本章涉及的基本符號(hào)如表1所示.

表1 符號(hào)表

2.1 類間虛擬圖像和類內(nèi)虛擬圖像

本文通過二維線性鑒別分析構(gòu)建類間散布矩陣和類內(nèi)散布矩陣,并且分別進(jìn)行特征提取.定義類間散布矩陣Sb和類內(nèi)散布矩陣Sw.分別從Sb中求解最優(yōu)投影向量組u和Sw中求解最優(yōu)投影向量組v,從而將所有面部圖像分別對(duì)u和v作投影得到各自的特征向量,具體過程如下:

令樣本類別有M個(gè),第j類樣本有N個(gè)圖像:Aj1,Aj2,…,AjN,每幅圖像均為m×n的矩陣.定義準(zhǔn)則函數(shù)J1(x)=uTSbu,當(dāng)uTSbu取最大時(shí),圖像矩陣對(duì)向量組u作投影獲得特征向量的類別間分散程度最優(yōu).uTSbu最大取值問題可以轉(zhuǎn)化為求解Sb中最大g個(gè)特征值所對(duì)應(yīng)的特征向量問題.類間散布矩陣Sb可以表示為:

(1)

式中P(wj)表示為第j類的先驗(yàn)概率,一般令P(wj)=1/M.讓j表示為第j(1≤j≤M)類樣本圖像矩陣的均值,表示為所有圖像矩陣的均值,具體表現(xiàn)形式如下:

(2)

(3)

令類間散布矩陣Sb的最大g個(gè)特征值對(duì)應(yīng)的特征向量為u(u1,u2,…,ug),圖像樣本A通過特征提取的方式進(jìn)行圖像重構(gòu),利用前g個(gè)特征向量重構(gòu)出類間虛擬圖像Y1,如公式(4)所示.

Y1=Au=A(u1,u2,…,ug)

(4)

同時(shí),定義準(zhǔn)則函數(shù)J2(x)=vTSwv,當(dāng)vTSwv取最大時(shí),圖像矩陣對(duì)向量組v作投影獲得特征向量最優(yōu).vTSwv最大取值問題可以轉(zhuǎn)化為求解Sw中最大g個(gè)特征值所對(duì)應(yīng)的特征向量問題.定義類內(nèi)散布矩陣Sw為:

(5)

Y2=Av=A(v1,v2,…,vg)

(6)

2.2 協(xié)同表示分類

針對(duì)于面部識(shí)別中小樣本問題,稀疏表示方法是解決這個(gè)問題最佳方法之一.稀疏表示方法核心思想是通過給定測(cè)試樣本y由所有訓(xùn)練樣本線性組合表示,并且求出稀疏系數(shù),利用每類訓(xùn)練樣本和稀疏系數(shù)重構(gòu)后與所有測(cè)試樣本進(jìn)行分類.稀疏表示方法具體過程如下:

假設(shè)矩陣Aj表示第j類所有訓(xùn)練樣本,樣本類別個(gè)數(shù)為M.記A=[A1,A2,…,AM],A表示全體訓(xùn)練樣本組成矩陣.給定一個(gè)測(cè)試樣本y可用所有訓(xùn)練樣本線性組合表示,即Aw=y.

一般認(rèn)為w系數(shù)越稀疏,測(cè)試樣本y的類別越容易判定.稀疏解可由下面公式得到,即:

(7)

式中‖ ‖1表示為l1范數(shù),雖然通過l1范數(shù)求解具有較好的稀疏性,但是具有較高算法復(fù)雜度.因此通過l2范數(shù)求稀疏解,此方法也稱為協(xié)同稀疏表示分類方法,即:

(8)

(9)

重建誤差的具體表現(xiàn)形式如公式(10)所示:

(10)

式中Rj(y)可以認(rèn)為是一種距離度量,表示測(cè)試樣本y與第j(1≤j≤M)類訓(xùn)練樣本相似性.求出Rj(y)最小的值即為測(cè)試樣本y的類別(j-1)n+i表示Aj的第(j-1)n+i個(gè)元素.

2.3 得分融合與圖像分類

根據(jù)本文前面介紹的理論,得分融合方法首先獨(dú)立對(duì)待各生物特征,得出各自識(shí)別結(jié)果后再進(jìn)行融合,得分融合方法比其它兩類融合方法往往能取得較優(yōu)鑒別性能.

本文采用一種新的加權(quán)得分融合方法,融合原始圖像、類間虛擬圖像和類內(nèi)虛擬圖像各自的得分,并利用最終得分進(jìn)行分類,具體為:

S=q1R1+q2R2+q3R3

(11)

式中S表示最終的得分,R1表示原始圖像利用CRC獲取的得分,R2表示類間虛擬圖像利用CRC獲取的得分,R3表示類內(nèi)虛擬圖像利用CRC獲取的得分.q1為R1的權(quán)重系數(shù)可以表示為:

(12)

q2為R2的權(quán)重系數(shù)可以表示為:

(13)

q3為R3的權(quán)重系數(shù)可以表示為q3=1-(q1+q2),使得3個(gè)權(quán)重系數(shù)的總和取值為1.

最后通過公式(14)得出的最終得分進(jìn)行分類,測(cè)試樣本y屬于第g個(gè)個(gè)體的類別,即:

g=argminjSj(y)

(14)

3 算法的步驟及性能展示

3.1 算法步驟

根據(jù)第2部分的分析和推導(dǎo),我們以O(shè)RL數(shù)據(jù)集為例,闡述本文方法的主要操作步驟.

步驟1.將ORL數(shù)據(jù)庫(kù)分為訓(xùn)練樣本集和測(cè)試樣本集,如:每個(gè)類別選取前2-5張作為訓(xùn)練樣本,其余作為測(cè)試樣本.并將訓(xùn)練樣本集和測(cè)試樣本集的面部圖像大小統(tǒng)一設(shè)置為50*50像素.

步驟2.利用公式(1)-公式(3)構(gòu)造原始面部圖像訓(xùn)練樣本集的類間散布矩陣,通過特征提取方式提取相應(yīng)特征向量,并且利用公式(4)將訓(xùn)練樣本集和測(cè)試樣本集分別向提取出來的特征向量作投影,得到對(duì)應(yīng)訓(xùn)練樣本的類間虛擬圖像和測(cè)試樣本的類間虛擬圖像.

步驟3.利用公式(2)、公式(5)構(gòu)造原始面部圖像訓(xùn)練樣本集的類內(nèi)散布矩陣,通過特征提取方式提取與之對(duì)應(yīng)的特征向量,并利用公式(6)將訓(xùn)練樣本集和測(cè)試樣本集分別向提取的特征向量作投影,獲得對(duì)應(yīng)訓(xùn)練樣本的類內(nèi)虛擬圖像和測(cè)試樣本的類內(nèi)虛擬圖像.

步驟4.利用稀疏解具體表現(xiàn)公式w=(ATA+γI)-1ATy和公式(10)分別獲取原始面部圖像中測(cè)試樣本y的得分、類間虛擬圖像中測(cè)試樣本y的得分和類內(nèi)虛擬圖像中測(cè)試樣本y的得分,其中γ表示一個(gè)很小的常量,I表示為單位矩陣.

步驟5.分別獲取權(quán)重系數(shù)q1、q2和q3,并通過公式(11)融合原始圖像的得分、類間虛擬圖像的得分和類內(nèi)虛擬圖像的得分.

步驟6.通過公式(14)將融合后最終的得分進(jìn)行面部圖像識(shí)別.

3.2 算法性能展示

為了讓讀者更直觀的了解本文原理,通過圖1展示了本文提出的類間虛擬圖像和類內(nèi)虛擬圖像示意圖.本文通過2DLDA來提取圖像的類間特征和類內(nèi)特征,通過特征提取的方式重構(gòu)類間虛擬圖像和類內(nèi)虛擬圖像,類間虛擬圖像和類內(nèi)虛擬圖像與原始圖像是互補(bǔ)的.在圖1中,第1行展示了原始圖像,第2行展示了類間虛擬圖像,第3行展示了類內(nèi)虛擬圖像.

圖1 在ORL數(shù)據(jù)集上的原始圖像、類間虛擬圖像和類內(nèi)虛擬圖像

通過圖2展示了選取不同特征向量個(gè)數(shù)下對(duì)應(yīng)的識(shí)別錯(cuò)誤率的直觀圖.從圖2中可以看出,本文提出的方法在選取不同特征向量個(gè)數(shù)下,識(shí)別率的總體趨勢(shì)是趨于平穩(wěn)的,具有穩(wěn)定性.當(dāng)特征向量個(gè)數(shù)選為15時(shí),本文方法面部識(shí)別錯(cuò)誤率最低.

圖2 在ORL數(shù)據(jù)集上選取不同特征向量個(gè)數(shù)對(duì)應(yīng)的識(shí)別錯(cuò)誤率

通過圖3展示了不同訓(xùn)練樣本個(gè)數(shù)下對(duì)應(yīng)的識(shí)別錯(cuò)誤率.從圖3中可以看出,本文提出的方法有著較低的錯(cuò)誤識(shí)別率,隨著每類訓(xùn)練樣本個(gè)數(shù)的增加,其面部識(shí)別錯(cuò)誤率越來越低.

圖3 在ORL數(shù)據(jù)集上每個(gè)類別訓(xùn)練樣本數(shù)目對(duì)應(yīng)的識(shí)別錯(cuò)誤率

4 實(shí)驗(yàn)結(jié)果

為了進(jìn)一步測(cè)試本文提出方法的性能,在ORL、AR及GT數(shù)據(jù)庫(kù)上分別設(shè)計(jì)了實(shí)驗(yàn).我們?cè)O(shè)計(jì)了協(xié)同表示分類方法、快速迭代算法(Fast Iterative Shrinkage Thresholding Algorithm,FISTA)、同倫法(Homotopy Method)和增廣拉格朗日乘子法(Primal Augmented Lagrange Multiplier,PALM)來分別作為分類算法.

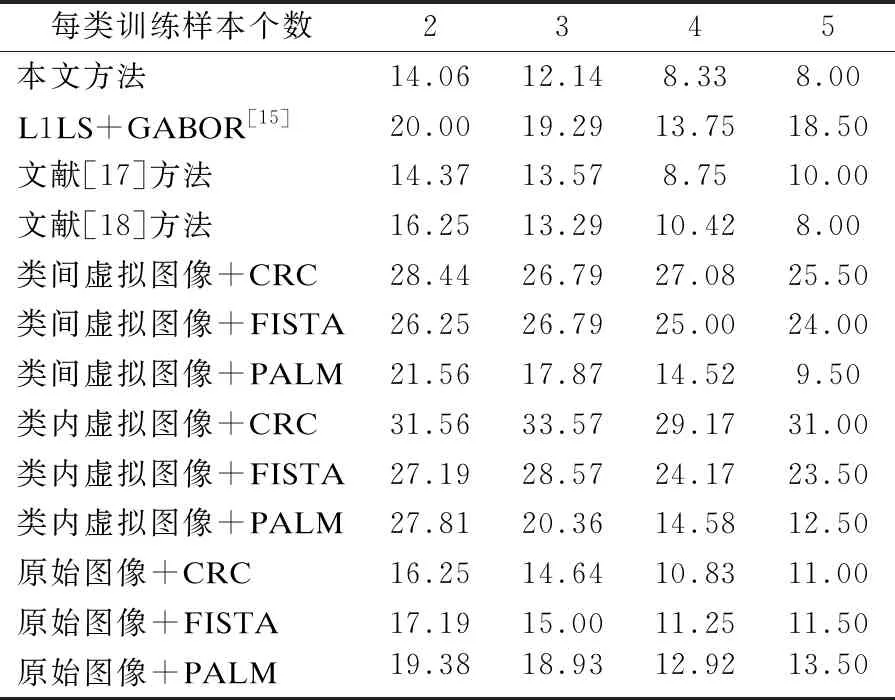

本章采用識(shí)別錯(cuò)誤率來比較算法之間性能的好壞,識(shí)別錯(cuò)誤率越低,算法的性能越好.表2-表4中,“本文方法”表示在ORL、AR和GT面部數(shù)據(jù)庫(kù)上的識(shí)別精度,具體為將原始圖像、類間虛擬圖像和類內(nèi)虛擬圖像分別利用CRC進(jìn)行得分,利用文中公式(11)所示的加權(quán)融合機(jī)制進(jìn)行得分融合,并利用最終得分進(jìn)行面部識(shí)別.“類間虛擬圖像/類內(nèi)虛擬圖像/原始圖像+CRC/FISTA/HOMOTOPY/PALM”分別表示在不同數(shù)據(jù)集上類間虛擬圖像/類內(nèi)虛擬圖像/原始圖像在分類算法為CRC/FISTA/HOMOTOPY/PALM上的識(shí)別結(jié)果;從表2-表4中可以看出,本文提出的方法對(duì)于面部圖像識(shí)別具有較低的識(shí)別錯(cuò)誤率.

表4 在GT數(shù)據(jù)集上的錯(cuò)誤識(shí)別精度

4.1 在ORL面部數(shù)據(jù)上的實(shí)驗(yàn)

本部分將在ORL人臉數(shù)據(jù)庫(kù)進(jìn)行實(shí)驗(yàn).ORL人臉數(shù)據(jù)庫(kù)包含了40個(gè)人,每個(gè)人10幅圖像,共400幅人臉圖像.每幅人臉圖像均在不同的光照、不同的表情變化、不同的角度條件下獲得.在ORL人臉數(shù)據(jù)庫(kù)中圖像包括表情的變化(笑或不笑,睜眼或閉眼)及面部細(xì)節(jié).每幅人臉圖像分辨率均為50像素×50像素,每幅人臉圖像的格式為′.bmp′.圖4顯示ORL人臉數(shù)據(jù)庫(kù)的部分圖像.

圖4 部分ORL數(shù)據(jù)集的圖像

表2展示了在ORL數(shù)據(jù)庫(kù)的識(shí)別錯(cuò)誤率,每個(gè)受試者前2-5幅圖像作為訓(xùn)練樣本,其余圖像作為測(cè)試樣本.從表2中可以看出,本文方法在ORL數(shù)據(jù)庫(kù)上具有較低的錯(cuò)誤率.例如:當(dāng)每類訓(xùn)練樣本個(gè)數(shù)為2-5時(shí),并且分類器選為CRC時(shí),本文方法的識(shí)別錯(cuò)誤率為14.06%,12.14%,8.33%,8.00%.然而,原始圖像利用CRC進(jìn)行分類時(shí),它的識(shí)別錯(cuò)誤率為16.25%,14.64%,10.83%,11.00%.由表2可知,當(dāng)不同訓(xùn)練樣本個(gè)數(shù)由2變化到5時(shí),本文提出的方法也比文獻(xiàn)[18]方法(2DPCA+Original images+CRC)、文獻(xiàn)[17]方法(FFT+Original images+CRC)和文獻(xiàn)[15]中的一般融合方法(Gabor+L1LS)效果要好.

表2 在ORL數(shù)據(jù)集上的錯(cuò)誤識(shí)別精度

4.2 在AR面部數(shù)據(jù)庫(kù)上的實(shí)驗(yàn)

本部分將在AR人臉數(shù)據(jù)庫(kù)進(jìn)行實(shí)驗(yàn).AR人臉數(shù)據(jù)庫(kù)中包含了120個(gè)人,每個(gè)人26幅圖像,共3120幅人臉圖像.圖像在不同光照、不同面部表情、不同角度和有無遮擋物(戴眼鏡或圍巾)條件下獲得.每幅人臉圖像的分辨率均為50像素×40像素,每幅人臉圖像的格式均為′.tif′.圖5顯示AR人臉數(shù)據(jù)庫(kù)的部分圖像.

圖5 部分AR數(shù)據(jù)集的圖像

每個(gè)受試者前9-12幅圖像作為訓(xùn)練樣本,其余圖像作為測(cè)試樣本.例如:分類器選為CRC時(shí),本文提出的方法錯(cuò)誤率為30.74%,32.76%,23.11%,24.88%.然而,使用FISTA對(duì)原始圖像進(jìn)行分類并且每類訓(xùn)練樣本個(gè)數(shù)為9-12時(shí),它的識(shí)別錯(cuò)誤率為44.95%,47.71%,34.33%,35.89%.由表3可知,當(dāng)每個(gè)訓(xùn)練樣本個(gè)數(shù)由9變化到12時(shí),本文提出的方法在AR數(shù)據(jù)庫(kù)上的識(shí)別錯(cuò)誤率低于原始圖像使用FISTA的識(shí)別錯(cuò)誤率.

表3 在AR數(shù)據(jù)集上的錯(cuò)誤識(shí)別精度

4.3 在GT面部數(shù)據(jù)庫(kù)上的實(shí)驗(yàn)

本部分將在GT人臉數(shù)據(jù)庫(kù)進(jìn)行實(shí)驗(yàn).GT人臉數(shù)據(jù)庫(kù)中包含了50個(gè)人,每個(gè)人15幅彩色圖像,共750幅圖像.在GT人臉數(shù)據(jù)庫(kù)中,每個(gè)人的面部細(xì)節(jié)和面部表情都存在著不同程度的變化.將每幅人臉圖像的壓縮為50像素×50像素,實(shí)驗(yàn)中將這些彩色圖像轉(zhuǎn)化為灰度圖像.每幅人臉圖像的格式均為′.jpg′.圖6顯示GT人臉數(shù)據(jù)庫(kù)的部分圖像.

圖6 部分GT數(shù)據(jù)集的圖像

在GT數(shù)據(jù)庫(kù)中,每個(gè)受試者的前9-11幅圖像作為訓(xùn)練樣本,其余圖像作為測(cè)試樣本.通過表4的實(shí)驗(yàn)結(jié)果可知,當(dāng)每類訓(xùn)練樣本個(gè)數(shù)為9-11時(shí)并且分類器選為CRC時(shí),本文提出的面部識(shí)別方法錯(cuò)誤率為28.67%、26.80%、24.00%.文獻(xiàn)[17]方法的識(shí)別錯(cuò)誤率為31.67%、32.00%、27.50%,而文獻(xiàn)[18]方法的識(shí)別錯(cuò)誤率為32.67%、29.60%、29.50%.由表4可知,本文提出的方法與其他經(jīng)典方法相比具有較低的識(shí)別錯(cuò)誤率.

5 結(jié)束語

本文提出了二維線性鑒別分析和協(xié)同表示的面部識(shí)別方法.該方法在不同人臉數(shù)據(jù)庫(kù)中可以獲得較好的識(shí)別性能.在實(shí)際應(yīng)用中,該方法具有有效性和可行性,不需要手動(dòng)調(diào)整參數(shù)并且易于實(shí)現(xiàn).本文方法可以獲取類間虛擬圖像和類內(nèi)虛擬圖像來表示原始圖像,不僅保留了圖像關(guān)鍵特征信息,并且在面部識(shí)別方面與原始圖像具有一定的互補(bǔ)性,降低了圖像識(shí)別錯(cuò)誤率.通過實(shí)驗(yàn)表明,在面部識(shí)別中將類間虛擬圖像、類內(nèi)虛擬圖像和原始圖像的分類結(jié)果進(jìn)行融合可以取得較好的識(shí)別效果.