一種面向對抗攻擊的魯棒性語音情感識別方法

陳港 陳杰 張石清 趙小明

摘? 要:目前,現有的語音情感識別研究主要考慮在實驗環境下收集語音數據進行情感識別,并沒有考慮現實世界中存在各種噪聲的影響。為此,考慮到噪聲的影響,提出一種面向對抗攻擊的魯棒性語音情感識別方法,用于實現帶有噪聲的情感語音的分類。首先采用快速梯度符號法生成對抗數據,然后將真實數據和對抗數據進行混合,再將混合數據輸入防御模塊中進行模型的對抗攻擊訓練。最后,在IEMOCAP數據集上的實驗結果表明,該方法用于語音情感識別能有效提高深度學習模型的魯棒性和識別準確率。

關鍵詞:語音情感識別;魯棒性;對抗攻擊

中圖分類號:TP391? ? ?文獻標識碼:A

A Robust Speech Emotion Recognition Method for Confrontational Attacks

CHEN Gang1,2, CHEN Jie2, ZHANG Shiqing2, ZHAO Xiaoming1,2

(1. Faculty of Mechanical Engineering & Automation, Zhejiang Sci-Tech University, Hangzhou 310018, China;

2. Institute of Intelligent Information Processing, Taizhou University, Taizhou 318000, China)

904699855@qq.com; 1424179695@qq.com; tzczsq@163.com; tzxyzxm@163.com

Abstract: At present, the existing research on speech emotion recognition mainly considers speech data collection in an experimental environment for emotion recognition, without considering the influence of various noises in the real world. For this reason, considering the influence of noise, this paper proposes a robust speech emotion recognition method for confrontational attacks to realize classification of emotional speech with noise. Firstly, fast gradient sign method is used to generate confrontation data which is mixed with the real data. Then the mixed data is input into the defense module to conduct confrontation attack training of the model. Finally, experimental results on the IEMOCAP dataset show that the method used in speech emotion recognition can effectively improve the robustness and recognition accuracy of the deep learning model.

Keywords: speech emotion recognition; robustness; confrontational attack

1? ?引言(Introduction)

語音情感識別技術[1]一直是人機交互領域中重要的研究熱點,但大量的語音情感識別方法主要考慮在實驗環境下對語音進行情感識別,并沒有考慮現實世界中存在各種噪聲的影響,因此,計算機在噪聲的影響下準確地識別出人類的情感[2],有助于實現其與人類進行友好的交互。

為了推動語音情感識別技術的發展,研究者們在每年舉辦一屆的INTERSPEECH會議[3]中進行先進的學術交流和經驗分享。最早的語音情感識別方法主要是根據語音信號設計手工特征[4-6],例如音律特征、譜特征、音質特征及特別設計的聲學特征集[7-8],再將其輸入簡單的分類器進行相應的情感分類。如NWE等人[9]提出采用短時對數頻率功率系數(Log Frequency Power Coefficients, LFPC)表示語音信號,再使用離散隱馬爾科夫模型(Hidden Markov Model, HMM)作為情感分類器;ALEX等人[10]提出分別使用韻律特征和頻譜特征表示語音信號,然后使用注意力機制和特征選擇方法增強模型的性能,再將輸出的特征進行分數級融合,最后預測出語音樣本的情感類別;DANESHFAR等人[11]提出使用頻譜-韻律混合特征向量表示語音信號,再使用基于量子行為的粒子群優化(Quantum-behaved Particle Swarm Optimization, QPSO)算法對特征進行降維,最后利用高斯橢圓基函數(Gaussian Elliptical Basis Function, GEBF)型分類器對特征進行情感分類。雖然上述方法具有不錯的識別性能,但是手工設計的特征屬于低階特征,表示情感信息的判別能力相對較低。

隨著深度學習技術的快速發展,各種深度神經網絡模型[12-14](Deep Neural Networks, DNN)被提出,研究者們開始采用DNN學習語音信號中高階的深度特征。例如,HUANG[13]等人提出將語音信號轉為頻譜圖,再利用CNN從頻譜圖中提取深度語音情感特征,然后使用softmax層進行最后的語音情感分類。ZHAO等人[15]提出使用1-D CNN-LSTM和2-D CNN-LSTM分別從語音信號和對數梅爾頻譜圖(Log-Mel Spectrum)中學習局部和全局情感表示,再將局部和全局情感表示進行融合,最后獲得情感語音樣本的類別。現有的語音情感識別方法主要對在實驗環境下采集的語音數據進行情感分類,沒有考慮現實環境中噪聲的影響。而且,在存在噪聲的情況下,大部分訓練好的模型性能也會顯著下降。針對上述問題,本文提出一種面向對抗攻擊的魯棒性語音情感識別方法。首先采用快速梯度符號法(Fast Gradient Sign Method, FGSM)將真實數據轉為對抗數據,該模塊由模型中的攻擊模塊實現;然后將得到的對抗數據與真實數據一并輸入防御模塊中,并采用對抗訓練的方式訓練模型;最后對語音樣本的情感類別進行預測分類。在IEMOCAP數據集[16]中的實驗結果表明,本文提出的方法能對抗噪聲的干擾,并提高語音情感識別模型的準確率。

2 面向對抗攻擊的語音情感識別模型(Speech emotion recognition model for confrontational attacks)

圖1給出了面向對抗攻擊的魯棒性語音情感識別方法示意圖,該模型由攻擊模塊和防御模塊兩部分組成。本文方法首先將真實數據輸入攻擊模塊中生成對抗數據;然后將對抗數據和真實數據混合輸入防御模塊中,以訓練出一個具有魯棒性的語音情感識別模型;最后實現語音情感分類。

2.1? ?面向攻擊模塊的對抗數據生成

相比于簡單的語音信號,本文采用Log-Mel頻譜圖作為攻擊模塊模型的輸入數據,然后使用FGSM生成對抗數據。該方法將計算得到的梯度作為對抗噪聲,其中損失函數定義為,相應計算的梯度為,對抗數據由如下公式計算得到:

其中,表示一個干擾常量,用于控制噪聲添加量;表示一種幅值裁剪運算操作;表示一個常量,用于控制輸入數據的取值范圍;表示符號函數,生成的對抗數據被用于擴增訓練數據集,并有助于提高模型的魯棒性。圖2給出了對抗數據生成示意圖。例如,某個情感類別為厭惡的Log-Mel頻譜圖在添加對抗噪聲后,輸入模型中會被誤判為高興情感。由此可知,本文提出的對抗數據能影響模型的判別性能。

2.2? ?面向防御模塊的卷積神經網絡模型

為了提取Log-Mel頻譜圖中高階的語音情感特征,本文選取三種深度神經網絡模型來驗證對抗攻擊模型的有效性,三種模型分別為普通卷積神經網絡(CNN-5)、VGG-16和ResNet-50。表1給出詳細的三種網絡結構參數,其中Conv表示卷積層,MP和AP分別表示最大池化操作和平均池化操作,stride表示步長。

2.3? ?對抗訓練

對抗訓練是將對抗數據和真實數據混合后作為訓練模型的數據集,從而提高識別模型的通用魯棒性。相比在真實數據訓練下的損失函數,本文提出的對抗損失函數能同時考慮真實數據和對抗數據的損失值。對抗損失函數定義如下:

2.4? ?情感分類

本文提出在模型的末端嵌入一個softmax層對輸出的特征? ? 進行情感分類,softmax的計算原理如下所示:

3? ?實驗(Experiment)

3.1? ?數據集

本文采用的語音情感數據集為IEMOCAP,該數據集由5 個會話(Sessions)組成,每個會話由一名男演員和一名女演員組成,并且每個會話都由不同的演員參演。該數據集所有音頻文件的時長大約有12 小時。本文實驗僅使用數據集中高興、悲傷、中性和憤怒4 種情感類別樣本,并且采用與人無關的實驗方式,即使用1 個會話作為測試集,其余4 個會話作為訓練集的5 倍交叉驗證方式進行實驗。IEMOCAP數據集中4 種情感類別樣本數量分布狀況如表2所示。

3.2? ?數據預處理

相較于一般的語音信號,Log-Mel頻譜圖的表示方式更接近人類的聽覺系統,因此本文將數據集中語音信號轉為Log-Mel頻譜圖。由于數據集中的音頻文件時長不一致,同時,模型的輸入是固定的,因此將語音信號輸入64 階梅爾濾波器組,并通過重采樣和欠采樣的方式生成維度大小為的Log-Mel頻譜圖,并標注相應的情感類別標簽,以訓練識別模型。

3.3? ?評價指標

為了使模型快速收斂并保持模型的訓練穩定性,初始學習率設置為0.001,每迭代100 次后降低到當前的學習率的90%,迭代訓練到10,000 次結束模型訓練。為了說明對抗數據能降低模型的識別準確率,本文實驗中的干擾常量依次設置為0.0、0.02、0.04、0.06、0.08和0.1,超參數設置為0.5。本文中的模型性能評估標準為無權重平均召回率(Unweighted Average Recall, UAR),由如下公式計算得到:

3.4? ?實驗結果及分析

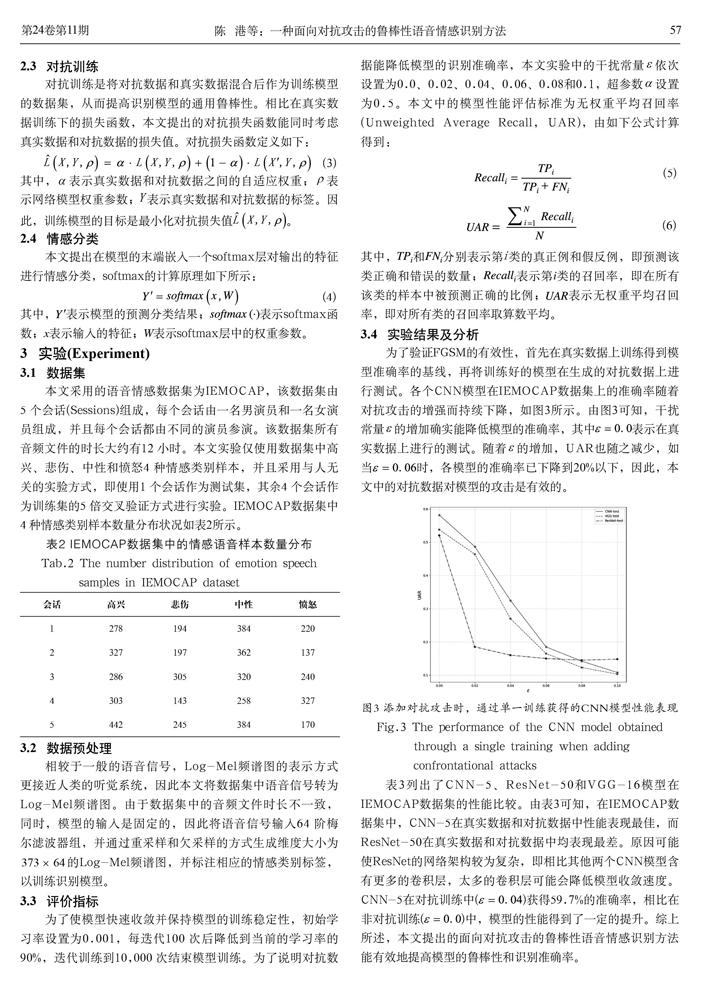

為了驗證FGSM的有效性,首先在真實數據上訓練得到模型準確率的基線,再將訓練好的模型在生成的對抗數據上進行測試。各個CNN模型在IEMOCAP數據集上的準確率隨著對抗攻擊的增強而持續下降,如圖3所示。由圖3可知,干擾常量的增加確實能降低模型的準確率,其中表示在真實數據上進行的測試。隨著的增加,UAR也隨之減少,如當時,各模型的準確率已下降到20%以下,因此,本文中的對抗數據對模型的攻擊是有效的。

表3列出了CNN-5、ResNet-50和VGG-16模型在IEMOCAP數據集的性能比較。由表3可知,在IEMOCAP數據集中,CNN-5在真實數據和對抗數據中性能表現最佳,而ResNet-50在真實數據和對抗數據中均表現最差。原因可能使ResNet的網絡架構較為復雜,即相比其他兩個CNN模型含有更多的卷積層,太多的卷積層可能會降低模型收斂速度。CNN-5在對抗訓練中()獲得59.7%的準確率,相比在非對抗訓練()中,模型的性能得到了一定的提升。綜上所述,本文提出的面向對抗攻擊的魯棒性語音情感識別方法能有效地提高模型的魯棒性和識別準確率。

4? ?結論(Conclusion)

本文提出一種面向對抗攻擊的魯棒性語音情感識別方法實現過程:首先采用快速梯度符號法生成對抗數據,對模型進行攻擊;然后將對抗數據和真實數據進行混合作為模型的訓練數據,以訓練出一個具有對抗攻擊的網絡模型,并在三個卷積網絡模型中驗證了對抗訓練方法的有效性。由于當前工作中提出的攻擊方法較為單一,因此,在未來的工作中需增加更為多樣化的對抗數據或攻擊方式,以訓練出更為健壯的語音情感識別模型。

參考文獻(References)

[1] 韓文靜,李海峰,阮華斌,等.語音情感識別研究進展綜述[J].軟件學報,2014,25(1):37-50.

[2] REN Z, BAIRD A, HAN J, et al. Generating and protecting against adversarial attacks for deep speech-based emotion recognition models[C]// IEEE Signal Processing Society. ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Piscataway, New Jersey, United States: IEEE, 2020:7184-7188.

[3] SCHULLER B, STEIDL S, BATLINER A, et al. The INTERSPEECH 2013 computational paralinguistics challenge: Social signals, conflict, emotion, autism[C]// International Speech Communication Association. Proceedings of the INTERSPEECH 2013—14th Annual Conference of the International Speech Communication Association (ISCA). Amsterdam, Netherlands: ELSEVIER, 2013:148-152.

[4] DEMIRCAN S, KAHRAMANLI H. Application of fuzzy C-means clustering algorithm to spectral features for emotion classification from speech[J]. Neural Computing Applications, 2018, 29(8):59-66.

[5] ZHAO X M, ZHANG S M. Spoken emotion recognition via locality-constrained kernel sparse representation[J]. Neural Computing Applications, 2015, 26(3):735-744.

[6] ZHANG Z X, COUTINHO E, DENG J, et al. Cooperative learning and its application to emotion recognition from speech[J]. IEEE/ACM Transactions on Audio, Speech, Language Processing, 2014, 23(1):115-126.

[7] KAYAOGLU M, EROGLU ERDEM C. Affect recognition using key frame selection based on minimum sparse reconstruction[C]// Association for Computing Machinery. Proceedings of the 2015 ACM on International Conference on Multimodal Interaction. New York, United States: Association for Computing Machinery, 2015:519-524.

[8] VALSTAR M, SCHULLER B, SMITH K, et al. Avec 2013: The continuous audio/visual emotion and depression recognition challenge[C]// Association for Computing Machinery. Proceedings of the 3rd ACM International Workshop on Audio/Visual Emotion Challenge. New York, United States: Association for Computing Machinery, 2013:3-10.

[9] NWE T L, FOO S W, DE SILVA L C. Speech emotion recognition using hidden Markov models[J]. Speech Communication, 2003, 41(4):603-623.

[10] ALEX S B, MARY L, BABU B P. Attention and feature selection for automatic speech emotion recognition using utterance and syllable-level prosodic features[J]. Circuits, Systems, Signal Processing, 2020, 39:5681-5709.

[11] DANESHFAR F, KABUDIAN S J, NEEKABADI A. Speech emotion recognition using hybrid spectral-prosodic features of speech signal/glottal waveform, metaheuristic-based dimensionality reduction, and Gaussian elliptical basis function network classifier[J]. Applied Acoustics, 2020, 166:107360.

[12] MIKOLOV T, KARAFIáT M, BURGET L, et al. Recurrent neural network based language model[C]// International Speech Communication Association. Eleventh Annual Conference of the International Speech Communication Association. Amsterdam, Netherlands: ELSEVIER, 2010:1045-1048.

[13] HUANG Z W, DONG M, MAO Q R, et al. Speech emotion recognition using CNN[C]// Association for Computing Machinery. Proceedings of the 22nd ACM International Conference on Multimedia. New York, United States: Association for Computing Machinery, 2014:801-804.

[14] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6):84-90.

[15] ZHAO J F, MAO X, CHEN L J. Speech emotion recognition using deep 1D & 2D CNN LSTM networks[J]. Biomedical Signal Processing and Control, 2019, 47:312-323.

[16] BUSSO C, BULUT M, LEE C C, et al. IEMOCAP: Interactive emotional dyadic motion capture database[J]. IEEE Transactions on Affective Computing, 2008, 42(4):335-359.

作者簡介:

陳? ?港(1998-),男,碩士生.研究領域:情感計算,模式識別.

陳? ?杰(1999-),男,本科生.研究領域:情感計算.

張石清(1980-),男,博士,教授.研究領域:情感計算,模式識別.

趙小明(1964-),男,碩士,教授.研究領域:情感計算,模式識別.