融合動態機制的改進型Faster R-CNN識別田間棉花頂芽

陳柯屹,朱龍付,宋 鵬,田曉敏,黃成龍,聶新輝,肖愛玲,何良榮

融合動態機制的改進型Faster R-CNN識別田間棉花頂芽

陳柯屹1,朱龍付1,宋 鵬1※,田曉敏2,黃成龍3,聶新輝2,肖愛玲4,何良榮5

(1. 華中農業大學植物科學技術學院,武漢 430070;2. 石河子大學農學院,石河子 832003;3. 華中農業大學工學院,武漢 430070;4. 塔里木大學機械電氣化工程學院,阿拉爾 843300;5. 塔里木大學植物科學學院,阿拉爾 843300)

針對田間密植環境棉花精準打頂時,棉花頂芽因其小體積特性所帶來識別困難問題,該研究提出一種改進型快速區域卷積神經網絡(Faster Region Convolutional Neural Networks,Faster R-CNN)目標檢測算法實現大田環境棉花頂芽識別。以Faster R-CNN為基礎框架,使用 RegNetX-6.4GF作為主干網絡,以提高圖像特征獲取性能。將特征金字塔網絡(Feature Pyramid Network,FPN)和導向錨框定位(Guided Anchoring,GA)機制相融合,實現錨框(Anchor)動態自適應生成。通過融合動態區域卷積神經網絡(Dynamic Region Convolutional Neural Networks,Dynamic R-CNN),實現訓練階段檢測模型自適應候選區域(Proposal)分布的動態變化。最后在目標候選區域(Region of Interest,ROI)中引入目標候選區域提取器(Generic ROI Extractor,GROIE)提高圖像特征融合能力。采集自然環境下7種不同棉花總計4 819張圖片,建立微軟常見物體圖像識別庫2017(Microsoft Common Objects in Context 2017,MS COCO 2017)格式的棉花頂芽圖片數據集進行試驗。結果表明,該研究提出方法的平均準確率均值(Mean Average Precision,MAP)為98.1%,模型的處理幀速(Frames Per Second,FPS)為10.3幀/s。其MAP在交并比(Intersection Over Union,IOU)為0.5時較Faster R-CNN、RetinaNet、Cascade R-CNN和RepPoints網絡分別提高7.3%、78.9%、10.1%和8.3%。該研究算法在田間對于棉花頂芽識別具有較高的魯棒性和精確度,為棉花精準打頂作業奠定基礎。

深度學習;算法;棉花;機制融合;動態適應;頂芽識別;Faster R-CNN

0 引 言

棉花是中國重要的經濟作物和戰略資源,其種植規模日益擴大[1]。作為棉花栽培過程的重要環節,棉花打頂作業正朝著智能化方向發展[2]。棉花打頂即通過去除其主莖生長點來抑制頂端優勢,使其提早結鈴,提高種植效益[3]。田間自然環境進行棉花頂芽的精準識別,是實現棉花頂芽精準去除作業的基礎。

早期研究者主要通過激光、超聲等傳感器檢測棉花頂芽所處高度[4],如孫杰[5]采用并排激光對射傳感器識別棉花頂芽位置;李霞等[6]采用超聲波測距原理測量棉花株高來控制打頂作業,該類方法主要通過檢測棉花植株高度來指導打頂,誤差較大。圖像處理技術的發展為棉花頂芽精準識別提供了新思路,劉俊奇[7]開發了用于棉花打頂高度檢測的棉花頂芽圖像識別系統,驗證了采用人工神經網絡進行棉花頂芽識別的可行性;瞿端陽[8]提出了一種基于機器視覺技術的棉株定位識別方法,該類方法在室內識別精度高,但易受田間環境影響,進而影響棉花頂芽檢測的穩定性。

卷積神經網絡的提出,為田間環境目標準確檢測提供了新思路[9-11],越來越多的學者針對不同農業應用場景研究各種改進算法,來進一步提高檢測精度和效率[12-14]。彭明霞等[15]在Faster R-CNN識別算法中融合特征金字塔網絡來提高算法的圖像特征提取能力,進行復雜棉田雜草識別;姚青等[16]采用基于ResNeXt101的特征提取網絡的RetinaNet作為水稻冠層蟲害檢測模型,通過改進網絡中的特征提取網絡提高了識別算法的識別精度。

本研究以中國新疆田間種植待打頂時期棉花為對象,針對自然環境復雜、棉花田間種植密度大、頂芽區域相對較小等特性,提出一種融合動態機制的改進型Faster R-CNN棉花頂芽識別方法。采用RegNetX-6.4GF作為特征提取模塊,融合導向錨框定位(Guided Anchoring,GA)機制、動態區域卷積神經網絡(Dynamic Region Convolutional Neural Networks,Dynamic R-CNN)方法及目標候選區域提取器(Generic ROI Extractor,GROIE),最終實現田間棉花頂芽的準確識別,以期為棉花精準打頂作業奠定基礎。

1 材料與方法

1.1 棉花頂芽數據集

1.1.1 圖片采集

為建立自然環境下棉花群體中較為完備的棉花頂芽數據集,本研究于2020年7月6日至2020年7月17日期間,在新疆石河子地區采集實際待打頂時期自然環境下的陸地棉()群體圖像。其種植模式為一膜四行,行距(28 +50 +28) cm +55 cm,株距9.5 cm,行長5 m。該群體來源廣泛,其葉片性狀因遺傳變異有所差別[17]。為保證本研究具有代表性,選取該群體中7種葉片形狀有差異的植株,采用具有不同分辨率的智能手機在田間隨機取樣,采集時間為北京時間10:00—18:00。分別在距離棉花冠層30~50 cm處(中距離)及50~100 cm處(遠距離)兩種場景下,在均勻光照、強光斜射、強光直射、光照陰影4種不同光照條件,采集大田中不同類別棉花圖像。采集過程不做任何遮光處理,采集的原始圖片如圖 1所示。

1.1.2 數據集制作

本文選取包含以上各場景的棉花樣本圖片總計4 819 張,其中分辨率為2 592×1 944(像素)像素的圖片3 000張,分辨率為8 000×6 000(像素)的圖片1 819張。圖片集中對應圖 1a中的不同棉花的圖片數量分別為2 175、406、408、301、448、468和613張。使用開源標注工具Labelimg對圖片進行標注。選取兩種不同距離拍攝場景下的1 300 張棉花樣本圖片作為測試集,其中包括中距離場景圖片966張及遠距離場景圖片334張。將余下的3 519張圖片按照4∶1的比例隨機劃分為訓練集和驗證集。數據集格式為MS COCO 2017。

1.2 改進型Faster R-CNN田間棉花頂芽識別模型

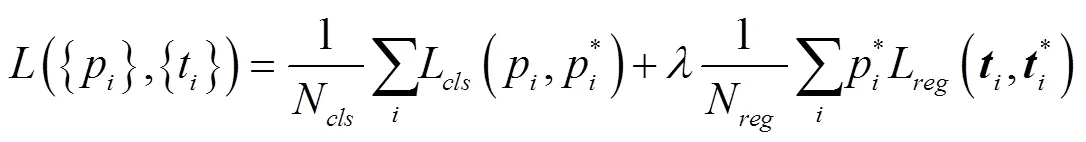

Faster R-CNN[18]是兩階段目標檢測框架的主流框架,兩個階段可以視為兩次以分類為基礎的目標檢測。在采用Faster R-CNN進行棉花頂芽識別時,檢測器通過卷積神經網絡對輸入的棉花頂芽圖片進行特征提取并生成特征圖(Feature Maps),之后特征圖輸入區域生成網絡(Region Proposal Network,RPN),生成多尺寸多比例的錨框(Anchor)網格,形成諸多候選目標區域,并對這些目標候選區域進行前景和背景的分類計算及網格邊框回歸計算,通過比較計算得分,生成目標候選區(Region of Interest,ROI),最后在檢測器的第二階段,對ROI進行進一步分類和邊框回歸來預測棉花頂芽類別的置信度及其所在位置的邊框。

考慮大田密植環境棉花頂芽小區域特性,針對Faster R-CNN算法難以有效動態適應復雜環境小目標識別問題,本文對Faster R-CNN算法進行優化。采用RegNetX-6.4GF作為特征提取模塊,改善棉花圖片特征提取能力。在RPN中使用FPN并融合Guided Anchoring機制,使RPN可以根據棉花頂芽特征圖信息動態生成相應的Anchor,形成以棉花頂芽圖片特征為基礎的候選區域Proposals。同時在其訓練階段融合Dynamic R-CNN機制,使識別算法在第二階段根據基于棉花特征信息的Proposal動態變化過程來改變IOU閾值,獲得高質量的Proposals來提高模型的訓練效果,同時引入GROIE機制,使其在ROI階段有效提取FPN中的特征信息。改進型Faster R-CNN網絡結構見圖2。

1.2.1 RegNetX-6.4GF卷積網絡

卷積神經網絡從圖片中獲取不同層次特征的能力決定著模型的性能。其中,層數深淺則影響著網絡的特征提取能力[20-21]。針對棉花頂芽在復雜背景情況下的圖像特征,本文選取RegNetX-6.4GF[22]作為卷積神經網絡替換Faster R-CNN原本采用的VGG-16,其結構如圖3所示,該網絡結構中輸入特征圖的長度和寬度均為,為特征圖的通道數,w=[168, 392, 784, 1 624]。

RegNet網絡結構使用神經結構搜索(Neural Architecture Search,NAS)技術實現。給定設計空間(Designed Search Space)通過搜索算法去搜索出一組最佳參數組合。本文采取RegNetX-6.4GF網絡結構作為骨干網絡來提取圖像特征。該網絡中殘差結構的引入解決了網絡深度增加所帶來的梯度消失的問題,具有更強的特征提取能力,其在ImageNet數據集上的Top-1 Error相較于VGG-16的28.07%和ResNeXt-50的21.9%下降為20.8%[22]。

1.2.2 Guided Anchoring-FPN模塊

RPN依據卷積神經網絡提取到的特征圖生成棉花頂芽的前景目標候選框。此階段目標候選區域的質量高低直接影響檢測器的性能,目標候選區域的質量高低表現為兩個方面,即在更高的IOU閾值下是否有更多的目標候選區域和錨框(Anchor)形狀與目標形狀匹配。為解決上述問題,本文通過在RPN中將FPN與Guided Anchoring相融合,來改變原有Anchor生成機制。

FPN[23]通過搭建一條自頂向下的路徑將各層次特征圖進行連接,實現了淺層特征和深層特征的融合。在生成的每一特征圖層上,Faster R-CNN 按照特定的步長以滑框(Sliding Window)的方式生成的Anchor。在棉花頂芽識別中,這種方式會帶來兩個問題,一是棉花頂芽所在區域過小,而生成Anchor則是在全圖均勻分布,這樣會造成多數Anchor分布于背景之中從而引起正負樣本不均衡進而影響分類器的計算速度。二是生成的Anchor均是固定尺度和比例,不適用于自然狀態下非固定尺度的棉花頂芽。故對于棉花頂芽的識別,需要形狀位置動態可變的Anchor生成機制。

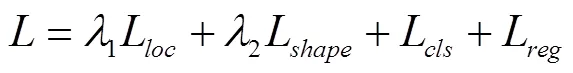

為解決上述問題,在FPN中引入Guided Anchoring機制[24]。Anchor 的概率分布被分解為兩個條件概率分布,即給定圖像特征之后 Anchor 中心點的概率分布和給定圖像特征和中心點之后的形狀概率分布(圖4)。

式中,,,分別表示Anchor的中心點坐標和寬高。

對于Anchor的中心點坐標的確定,采用1×1卷積對特征圖進行處理,獲得每點處是否含有物體的得分,與設定預設的閾值比較,本文將預設閾值設置為0.01,將可能含有物體的位置作為中心點。在確定中心點坐標之后,使用Bounded IOU Loss對邊框長寬進行回歸計算,以獲得最佳的長和寬。最后使用3×3的可變形卷積修正原始的特征圖,使得特征圖適應每個Anchor的形狀。

1.2.3 Generic ROI Extractor模塊

傳統Faster R-CNN中通過式(9)從RPN選取特征圖來提取ROI。

式中為所選取特征圖,0表示最高層次特征圖,224則是ImageNet中與訓練卷積神經網絡的圖片尺寸。w、h代表ROI的寬度和高度。這種選擇單一特征圖層的方法對于棉花頂芽識別會引起特征信息損失。為了綜合多尺度特征,本文引入目標候選區域提取器(Generic ROI Extractor)[25]來對改進型Faster R-CNN中的RPN信息進行綜合提取。

如圖5所示,Generic ROI Extractor首先使用目標候選區域對齊[26]將ROI映射到經Guided Anchoring-FPN處理的每層特征圖對應位置處,之后再對每一層進行預處理,將不同尺寸的特征信息進行消融,最后使用注意力機制提取全局特征,最終經過分類回歸計算得到棉花頂芽的識別結果。

1.2.4 Dynamic R-CNN 機制

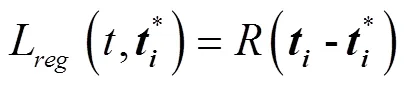

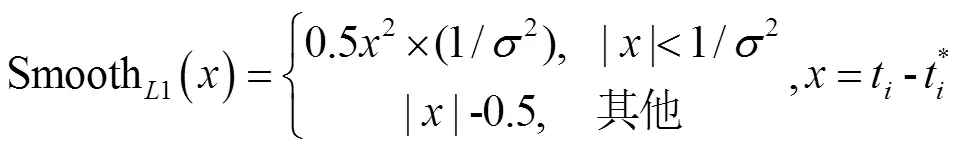

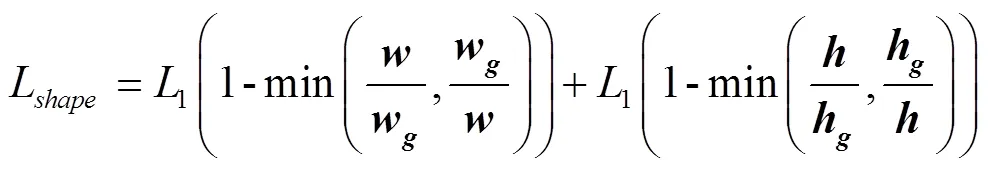

Faster R-CNN中Guided Anchoring-FPN的引入,使得生成的Anchor可以根據棉花頂芽的特征信息進行動態調整,這一機制的改變使得訓練過程中產生的候選區域在不同IOU閾值下的分布也在動態變化,而Faster R-CNN中只有閾值為0.5的IOU。針對此問題,本文在Faster R-CNN中融合Dynamic R-CNN[27],使得算法在第二階段的分類器(Classifier)和回歸計算器(Regressor)能動態適應Proposal的分布變化。在分類器中使用動態標注分類(Dynamic Label Assignment,DLA),見式(10)。

1.3 模型訓練與評估

1.3.1 軟硬件平臺

本文方法所基于的軟件平臺:系統軟件為Ubuntu18.04,Python3.7.9,Pytorch1.7.1深度學習模型框架基于香港中文大學的OpenMMLab開源框架MMdetection2.8。試驗所用服務器硬件平臺配置:處理器Intel Core i9-9900k,主頻為3.6 GHz,內存32 G,顯卡NVIDIA GeForce RTX 3080(10 GB)。

1.3.2 模型訓練方法

算法模型使用MS COCO2017格式的棉花頂芽數據集,使用訓練集2 815張圖片對算法模型參數進行訓練,在驗證集704張圖片中比較不同算法性能,并在測試集1 300張圖片測試本算法實際識別效果。

在MMdetection框架平臺中對模型進行訓練,使用隨機梯度下降法訓練模型,權值衰減系數為0.000 05,動量參數為0.9,基于單RTX 3080顯卡的Batch大小為3。采用多尺度訓練方案,輸入圖片尺寸長邊像素大小為1 333,短邊像素尺寸每輪訓練中從[640,672,704,736,768,800]中隨機挑選。學習率大小為0.002 5,設定訓練36期(Epochs),學習率采用動態變化機制,初始學習率為0.001,學習率在訓練迭代500次中線性增加,在訓練迭代到500次時增加到0.002 5并保持不變,之后學習率在第28和第34期減少為原來的1/10,來對模型參數進行精細調整。

1.3.3 模型評估方法

本文采用驗證集來測試訓練好模型的性能,并在在測試集測試改進后的算法實際識別效果。以交并比(Intersection Over Union,IOU)來評價模型精度,采用平均精度均值(Mean Average Precision,MAP),召回率(Recall)和準確率(Precision)進行模型評價[13]。通常情況MAP數值越高越好,本文只識別棉花頂芽,類別數為一,故本文采用召回率(Recall)和準確率(Precision)作為評價指標,取值區間為[0,1]。

2 試驗結果與分析

2.1 模型訓練結果

算法模型在訓練集2 815張圖片中進行訓練,在36期中共迭代35 000次,改進型Faster R-CNN由于引入了Guided Anchoring 機制,如式(1)所示,其Loss函數在原有基礎上增加了Anchor 的位置損失和形狀損失函數,使得訓練過程能獲得更多高質量的Anchor。圖 6b,6c分別表示訓練過程Anchor位置損失及形狀損失曲線,圖6d表示訓練過程正負樣本的分類損失曲線,由圖可知,Anchor位置損失、形狀損失及分類損失在迭代30 000次之后均收斂到穩定值。基于此機制生成Anchor的位置和形狀能與數據集圖像特征相契合,提升了模型對棉花頂芽區域的學習能力和識別效果,進而表現為總體損失函數值下降較快(圖6a),總體損失函數值在迭代30 000次之后達到穩定,此時模型參數達到預期訓練效果。

2.2 模型識別效果

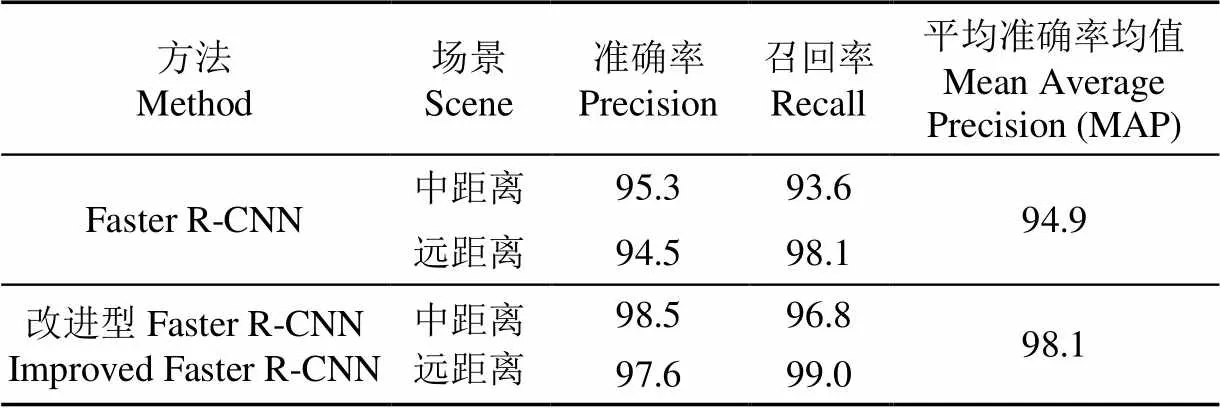

為了驗證模型的識別精度,將訓練好的模型應用于測試集,對測試集中兩種不同場景下的棉花圖片進行檢測,場景一為中距離拍攝場景不同光照條件下的識別效果,包含966張圖片,1 314個棉花頂芽。場景二為遠距離拍攝場景識別效果,包含334張圖片764個棉花頂芽。統計結果如表1所示。

表1 棉花頂芽識別結果

通過對模型在測試集上的統計結果可以看出,改進后的Faster R-CNN模型在大田自然環境下對棉花頂芽有較高的識別準確度。由表1可以看出,本文所提方法的識別準確率在中距離和遠距離場景下,較Faster R-CNN分別提高了3.2和3.1百分點。針對所有樣本識別的平均準確率均值可達98.1%,較Faster R-CNN高3.2個百分點。這是因為將Faster R-CNN中的卷積網絡替換為RegNetX-6.4GF,提高了模型對目標信息的提取能力,同時Guided Anchoring和GROIE機制的融合使得Anchor能夠動態適應目標位置及大小變化,增強了模型對于圖像中棉花頂芽特征信息的識別能力。針對不同拍攝距離、不同光照條件的棉花頂芽識別效果如圖7所示。

2.3 不同網絡架構性能比較

目前在深度學習領域,以卷積神經網絡為基礎的目標識別模型主要有兩大分支。一是Anchor-based分支,其內部又分為單階段、雙階段及多階段模型框架。二是Anchor-free分支,其主要通過確定特征點的方式來形成最終的識別框。

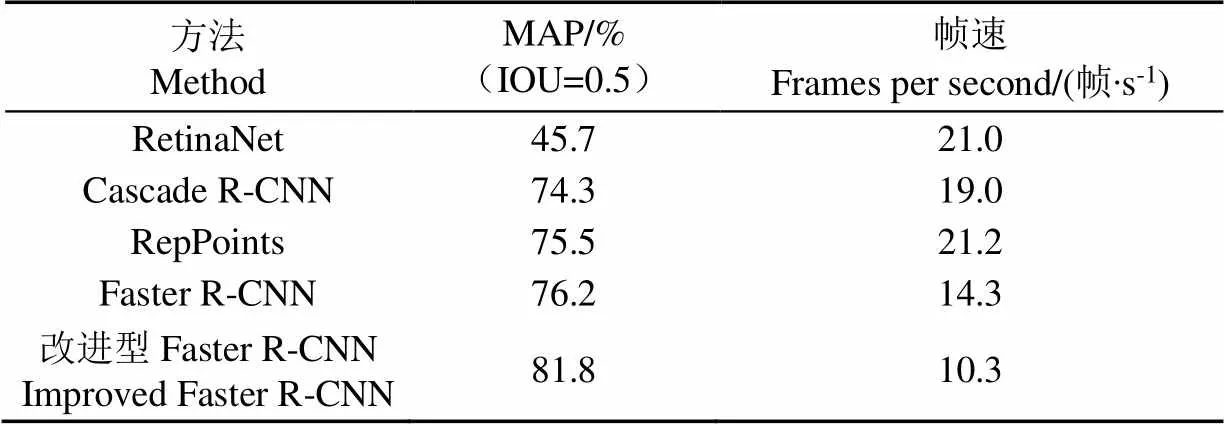

為驗證本文算法的有效性,選取目前主流的識別算法在棉花頂芽數據集上進行訓練,并在驗證集上將其和本文提出的算法進行性能比較。本文選用Anchor-based中的基于單步多目標檢測器(Single Shot MultiBox Detector,SSD)改進的單階段模型RetinaNet、雙階段模型Faster R-CNN和多階段模型中采用級聯檢測器結構的Cascade R-CNN[28]以及Anchor-free中的RepPoints[29]模型框架進行對比分析。計算IOU值在0.5情況下的準確率[13],并計算模型處理幀速(Frames Per Second,FPS),結果如表2所示。

表2 不同算法在驗證集上的測試結果

注:IOU為交并比。Note:IOU is intersection over union.

通過表2可知,針對棉花頂芽數據集,本文提出的改進型Faster R-CNN在IOU=0.5時,其MAP相較于Faster R-CNN提高7.3%,較RetinaNet、Cascade R-CNN和RepPoints分別提高78.9%、10.1%和8.3%。改進后的Faster R-CNN對圖像信息具有更好的感知和學習能力,具有較高的精度。處理速度為10.3幀/s,滿足棉花精準打頂實時識別速度需求。

3 結 論

本文針對大田環境下棉花精準打頂作業過程的棉花頂芽識別問題,在Faster R-CNN算法框架中基于棉花頂芽的小目標在復雜背景下的特點對算法進行的改進,提出一種針對棉花頂芽識別的改進型Faster R-CNN識別算法,主要結論如下:

1)本文將Faster R-CNN中的卷積神經網絡替換為RegNetX-6.4GF,并將Guided Anchoring和GROIE機制進行融合,增強了模型對棉花頂芽的識別能力。所提方法在中距離和遠距離場景下的識別準確率較Faster R-CNN分別提高3.2和3.1個百分點。

2)將本文提出方法與主流識別算法RetinaNet、Cascade R-CNN和RepPoints進行比較,結果表明,本文方法檢測的MAP在交并比為0.5時相比Faster R-CNN提高7.3%,較RetinaNet、Cascade R-CNN和RepPoints分別提高78.9%、10.1%和8.3%。

3)本文提出的改進型Faster R-CNN對棉花識別的平均準確率均值達98.1%,處理幀速為10.3幀/s,滿足棉花打頂作業對于精確度和實時性的要求,可為棉花精準打頂裝備的研發奠定基礎。

[1] 李繼福,何俊峰,陳佛文,等. 中國棉花生產格局與施肥研究現狀—基于CNKI數據計量分析[J]. 中國棉花,2019,46(4):17-24,28.

[2] 盧秀茹,賈肖月,牛佳慧. 中國棉花產業發展現狀及展望[J]. 中國農業科學,2018,51(1):26-36.

Lu Xiuru, Jia Xiaoyue, Niu Jiahui, et al. The present situation and prospects of cotton industry development in China[J], Scientia Agricultura Sinica, 2018, 51(1): 26-36. (in Chinese with English abstract)

[3] 劉照啟,張蔚然,劉海濤,等. 棉花打頂技術應用現狀與發展趨勢[J]. 現代農村科技,2020(7):16.

[4] 鄧勁松,石媛媛,陳利蘇,等. 基于近紅外傳感器和面向對象光譜分割技術的田間棉株識別與提取[J]. 光譜學與光譜分析,2009,29(7):1754-1758.

Deng Jinsong, Shi Yuanyuan, Chen Lisu, et al. Cotton identification and extraction using near infrared sensor and object-oriented spectral segmentation technique[J], Spectroscopy and Spectral Analysis, 2009, 29(7): 1754-1758. (in Chinese with English abstract)

[5] 孫杰. 棉花打頂機打頂高度自動控制系統的設計與試驗研究[D]. 烏魯木齊:新疆農業大學,2015.

Sun Jie. Design and Experimental Research of An Automatic Height Control System for Topping of Cotton Top-cutting Machine[D]. Urumqi: Xinjiang Agricultural University, 2015. (in Chinese with English abstract)

[6] 李霞,王維新,張若宇. 超聲波測高技術在棉花打頂中的應用[J]. 石河子大學學報:自然科學版,2009,27(3):358-360.

Li Xia, Wang Weixin, Zhang Ruoyu. Application of cotton altitude automation measurement based on ultrasonic technology[J], Journal of Shihezi University: Natural Science, 2009, 27(3): 358-360. (in Chinese with English abstract)

[7] 劉俊奇. 棉花株頂識別系統的研究[D]. 石河子:石河子大學,2009.

Liu Junqi. The Research of Automatic Recognition of Cotton’s Top[D]. Shihezi: Shihezi University, 2009. (in Chinese with English abstract)

[8] 瞿端陽. 基于機器視覺技術的棉株識別系統研究[D]. 石河子:石河子大學,2013.

Qu Duanyang. Cotton Plant Recognition System based on the Machine Vision Technology[D]. Shihezi: Shihezi University, 2013. (in Chinese with English abstract)

[9] Alotaibi A, Mahmood A. Deep face liveness detection based on nonlinear diffusion using convolution neural network[J]. Signal, Image and Video Processing, 2017, 11(4): 713-720.

[10] Bautista C M, Dy C A, Ma?alac M I, et al. Convolutional neural network for vehicle detection in low resolution traffic videos[C]. 2016 IEEE Region 10 Symposium (TENSYMP). Bali, Indonesia, IEEE, 2016: 277-281.

[11] Tajbakhsh N, Shin J Y, Gurudu S R, et al. Convolutional neural networks for medical image analysis: Full training or fine tuning[J]. IEEE Transactions on Medical Imaging, 2016, 35(5): 1299-1312.

[12] 張領先,陳運強,李云霞,等. 基于卷積神經網絡的冬小麥麥穗檢測計數系統[J]. 農業機械學報,2019,50(3) :144-150.

Zhang Lingxian, Chen Yunqiang, Li Yunxia, et al. Detection and counting system for winter wheat ears based on convolutional neural network[J], Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(3): 144-150. (in Chinese with English abstract)

[13] 熊俊濤,劉振,湯林越,等. 自然環境下綠色柑橘視覺檢測技術研究[J]. 農業機械學報,2018,49(4):45-52.

Xiong Juntao, Liu Zhen, Tang Linyue, et al. Visual detection technology of green citrus under natural environment[J], Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(4): 45-52. (in Chinese with English abstract)

[14] Nazki H, Yoon S, Fuentes A, et al. Unsupervised image translation using adversarial networks for improved plant disease recognition[J]. Computers and Electronics in Agriculture, 2020, 168: 105-117.

[15] 彭明霞,夏俊芳,彭輝. 融合FPN的Faster R-CNN復雜背景下棉田雜草高效識別方法[J]. 農業工程學報,2019,35(20):202-209.

Peng Mingxia, Xia Junfang, Peng Hui. Efficient recognition of cotton and weed in field based on Faster R-CNN by integrating FPN[J], Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(20): 202-209. (in Chinese with English abstract)

[16] 姚青,谷嘉樂,呂軍,等. 改進RetinaNet的水稻冠層害蟲為害狀自動檢測模型[J]. 農業工程學報,2020,36(15):182-188.

Yao Qing, Gu Jiale, Lyu Jun, et al. Automatic detection model for pest damage symptoms on rice canopy based on improved RetinaNet[J], Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(15): 182-188. (in Chinese with English abstract)

[17] 雷杰杰,邵盤霞,郭春平,等. 新疆陸地棉經濟性狀優異等位基因位點的遺傳解析[J]. 棉花學報,2020,32(3):185-198.

Lei Jiejie, Shao Panxia, Guo Chunping, et al. Genetic dissection of allelic loci associated with economic traits of upland cottons in Xinjiang[J]. Cotton Science, 2020, 32(3): 185-198. (in Chinese with English abstract)

[18] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149.

[19] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(2): 318-327.

[20] Simonyan K, Zisserman, A. Very deep convolutional networks for large-scale image recognition[C]. International Conference on Learning Representations, San Diego, CA, USA, 2015: 1-14.

[21] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Boston, MA, USA, 2015: 1-9.

[22] Radosavovic I, Kosaraju R P, Girshick R, et al. Designing network design spaces[C]. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Seattle, WA, USA, 2020: 10425-10433.

[23] Lin T, Dollar P, Girshick R, et al. Feature pyramid networks for object detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, Hawaii, USA, 2017: 936-944.

[24] Wang J, Chen K, Yang S, et al. Region proposal by guided anchoring[C]. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Long Beach, CA, USA, 2019: 2960-2969.

[25] Rossi L, Karimi A, Prati A. A novel region of interest extraction Layer for Instance Segmentation[C]. International Conference on Pattern Recognition, Milan, Italy, 2021: 2203-2209.

[26] He K, Gkioxari G, Dollar P, et al. Mask R-CNN[C]. IEEE International Conference on Computer Vision, Venice, Italy, 2017: 2980-2988.

[27] Zhang H, Chang H, Ma B, et al. Dynamic R-CNN: Towards high quality object detection via dynamic training[C]. European Conference on Computer Vision, Glasgow, UK, 2020: 260-275.

[28] Cai Z, Vasconcelos N. Cascade R-CNN: Delving into high quality object detection[C]. Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA, 2018: 6154-6162.

[29] Yang Z, Liu S, Hu H, et al. Reppoints: Point set representation for object detection[C]. International Conference on Computer Vision, Seoul, Korea, 2019: 9656-9665.

Recognition of cotton terminal bud in field using improved Faster R-CNN by integrating dynamic mechanism

Chen Keyi1, Zhu Longfu1, Song Peng1※, Tian Xiaomin2, Huang Chenglong3, Nie Xinhui2, Xiao Ailing4, He Liangrong5

(1.,,430070,; 2.,832003,; 3.,,430070,; 4.,843300,;5.,843300,)

Accurate identification of cotton top bud is important for cotton topping operation to detect cotton terminal bud accurately in field, a recognition method using Faster R-CNN (Faster Region Convolutional Neural Networks, Faster R-CNN) by integrating dynamic mechanism was proposed to solve the recognition difficulties caused by the small size of cotton terminal bud when it is topped in densely planted fields. The RegNetX-6.4GF model was used as the backbone network to improve its image feature extractor capabilities. Due to number of proposals under a higher IOU(Intersection Over Union, IOU) as well as the matching degree between anchor and the target shape affect the performance of the detector, the method proposed in this paper changed the original anchor generation mechanism by combining FPN (Feature Pyramid Network, FPN) and Guided Anchoring in RPN (Region Proposal Network, RPN), which will cause the distribution of the proposals generated by the RPN of the algorithm under different IOUs dynamically change during the training process. To adapt the dynamic change of proposals distribution, we integrated Dynamic Region Convolutional Neural Networks ( Dynamic R-CNN) in Faster R-CNN, which can dynamically adjust the value of IOU to obtain high quality proposals. And the GROIE (Generic ROI Extractor, GROIE) mechanism was inducted to extract ROI (Region of Interest, ROI) to improve the feature fusion capability. In this paper, 4 819 images ofpopulation which contain seven leaf types were taken from the top of cotton plant at distance of 30-50 cm (medium distance) and 50-100 cm (long distance) under uniform light, oblique strong light, direct strong light, and shadows. Those images were processed as MS COCO 2017 format dataset and assigned to the training set, validation set, and test set, which contained 2 815, 704, and 1 300 pictures respectively. The experimental results demonstrated that FPS (Frames Per Second, FPS) of proposed model was up to 10.3 frames/s and the Mean Average Precision (MAP) of bud identification reached to 98.1% which was 3.2 percentage points higher than original Faster R-CNN model. The validation set were used to compare performance of mainstream recognition algorithm and proposed method. Results showed that the improved Faster R-CNN's MAP was 7.3% higher than original Faster R-CNN, which was also higher than RetinaNet, Cascade R-CNN (Cascade Region Convolutional Neural Networks, Cascade R-CNN) and RepPoints by 78.9%, 10.1% and 8.3% when IOU was set to 0.5. The improved Faster R-CNN proposed in this paper meets the accuracy and real-time requirements of cotton topping operation.

deep learning; algorithm; cotton; mechanism fusion; dynamic adaptation; terminal bud recognition; Faster R-CNN

10.11975/j.issn.1002-6819.2021.16.020

TP274;TP391.41

A

1002-6819(2021)-16-0161-08

陳柯屹,朱龍付,宋鵬,等. 融合動態機制的改進型Faster R-CNN識別田間棉花頂芽[J]. 農業工程學報,2021,37(16):161-168.doi:10.11975/j.issn.1002-6819.2021.16.020 http://www.tcsae.org

Chen Keyi, Zhu Longfu, Song Peng, et al. Recognition of cotton terminal bud in field using improved Faster R-CNN by integrating dynamic mechanism[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(16): 161-168. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.16.020 http://www.tcsae.org

2021-05-31

2021-08-10

中央高校基本科研基金(2662019QD053)

陳柯屹,研究方向為農業信息感知及農業機器人技術。Email:davidchan_n1@outlook.com

宋鵬,博士,副教授,碩士生導師,研究方向為農業信息技術及裝備。Email:songp@mail.hzau.edu.cn

中國農業工程學會會員:宋鵬(E041201229S)