多特征融合神經網絡的眼底血管分割算法

宋姝潔,崔振超+,陳麗萍,陳向陽

1.河北大學 網絡空間安全與計算機學院,河北 保定 071002

2.河北省機器視覺研究中心(河北大學),河北 保定 071002

視網膜血管自動分割是醫學圖像處理領域的重點研究任務之一。視網膜血管的結構檢測,可為糖尿病和高血壓的診斷提供重要臨床信息,對輔助醫師診斷身體疾病有著重要意義[1]。目前,視網膜分割標注是以專業醫師手工標注為主,但人工標注存在無法批處理及主觀因素影響的弊端。因此,計算機輔助的視網膜血管分割是該領域的重要發展方向。

目前,視網膜血管自動分割方法可劃分為兩類——非監督學習方法和監督學習方法[2]。非監督學習方法是根據已存在的特征對圖像編碼,然后對編碼后的特征圖檢索,得到目標圖像分割結果。最早在1989年,Chaudhuri等[3]利用高斯函數對血管圖像進行編碼得到眼底圖像分割圖。接著,根據眼底視網膜血管的結構特點,血管追蹤法[4]、形態學處理法[5]、圖方法[6]、形變模型[7]等方法相繼提出。但非監督學習方法對血管特征編碼方式不全,造成視網膜結構特點檢測不充分,導致分割準確率下降。基于監督學習的分割方法是通過對手工標注的血管訓練得到分類器,再利用分類器對圖像進行模型分類,區別出前景像素和背景像素。基于監督學習的視網膜分割模型方法有貝葉斯分類器、支持向量機(support vector machine,SVM)、馬氏距離分類器等。Ricci 等[8]對圖像進行綠色通道預處理,并根據血管寬度采用SVM 分割。孟琳等[9]提出將Frangi濾波器和大津法融合對視網膜圖像分割。

近年來深度學習在圖像處理方面表現出色,基于神經網絡的視網膜血管分割方法迅速成為研究熱點。Liskowski 等[10]使用深度神經網絡分割視網膜血管。2015 年MICCAI中提出U-Net[11],U-Net網絡中的跳躍連接將編碼器與解碼器特征連接,利用豐富的細節特征來提升邊緣血管的分割精確度,在視網膜數據集上訓練結果優異。因此,大量視網膜血管分割方法基于U-Net 網絡提出。薛文渲等[12]在U-Net中引入二次循環殘差卷積及多通道注意模型,改善細小血管分割效果。Li等[13]采用新型的殘差結構,將注意力機制與跳躍連接結合提高分割性能。Dongye等[14]提出基于U-Net 改進的卷積網絡,目的是獲取具有高分辨率特征圖,有效捕捉血管的細節信息。Hu等[15]提出空洞殘差U 型網絡,利用殘差網絡和空洞卷積結合分割視網膜血管,獲得了較好的分割結果。這些深度學習方法雖表現出一定的醫學分割性能,但由于視網膜血管和背景區域之間特征不明顯,算法對細小血管特征描述不足,引發在血管分叉處不易區分、丟失復雜曲度形態血管的問題。

針對目前血管分割存在的問題,提出了一種基于U-Net 的多模塊融合視網膜血管分割方法,該方法設計了由殘差路徑傳遞信息的非線性連接模塊和殘差連接的基于U-Net 的多模塊殘差神經網絡(multiblock residual neural network,MbResU-Net)。首先,在編碼器與解碼器連接時,將跳躍連接(shortcut connect)改為殘差路徑,減少橋接高低級語義信息之間的語義差距。其次,在網絡結構中引入殘差連接,將多特征連接模塊鏈接成多模塊網絡,緩解由網絡層數加深而造成的信息丟失,使深層網絡模型變得簡單,解決卷積神經網絡對視網膜毛細血管特征表達不充分的問題。最后設計符合視網膜分割前景與背景的損失函數,使自動化分割技術更好地應用于臨床診斷中。

1 基于MbResU-Net的眼底血管分割

1.1 殘差路徑

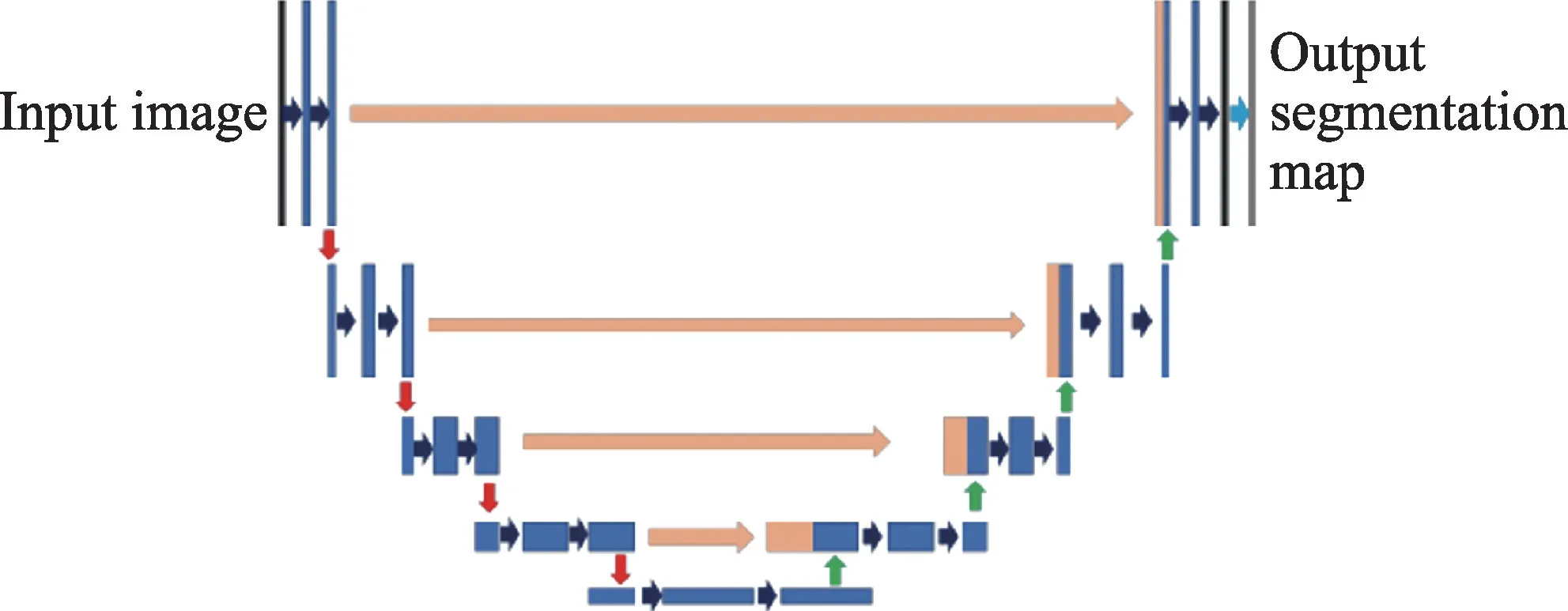

U-Net 網絡是一種編碼-解碼結構型的網絡。在編碼階段,U-Net 在卷積操作的基礎上,對特征層進行4 次最大池化后得到編碼結果。U-Net網絡巧妙的設計是引入了跳躍連接,編碼器卷積層的輸出在進入4 次池化前被送到解碼器中,將特征圖和解碼器上采樣操作后的輸出特征圖連接起來,將合成的特征圖傳遞到后續卷積網絡中,跳躍連接操作匯集了網絡在卷積過程中丟失的空間信息。在解碼階段,在卷積操作的基礎上,對特征層進行4 次上采樣操作后得到分割結果。如圖1 所示。

Fig.1 U-Net network structure圖1 U-Net網絡結構

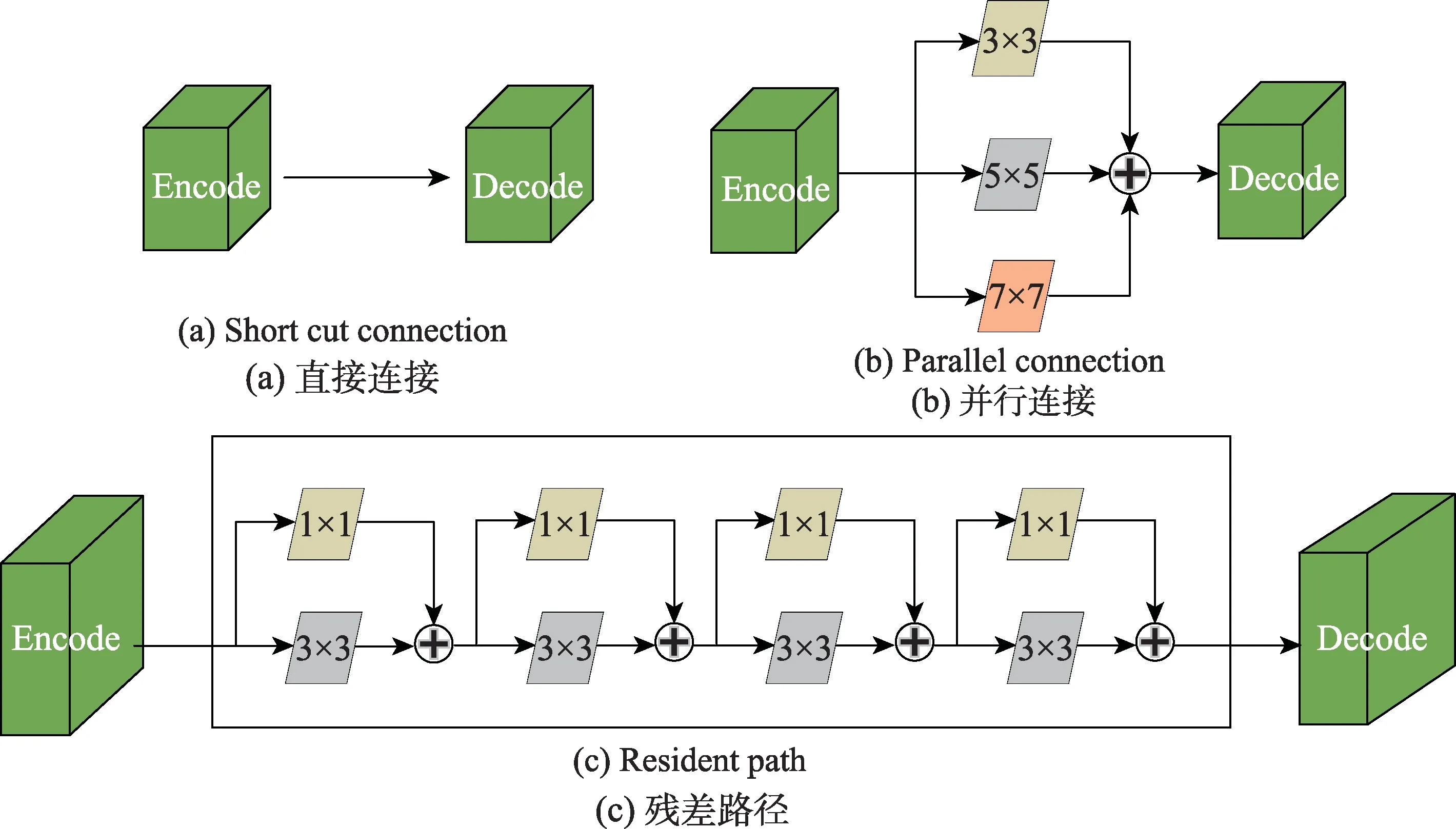

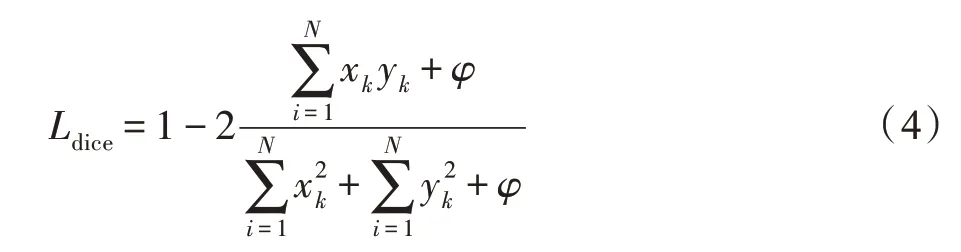

在U-Net 網絡中,編碼器特征經過卷積操作得到低級語義特征。相反,解碼器特征經過卷積、下采樣和上采樣操作得到高級語義特征。因此,編碼器和解碼器同一層之間存在語義差距,如圖2(a)所示,直接連接影響分割結果。為彌補編碼器與解碼器同一層之間語義差距,Szegedy 等[16]在每個下采樣之前和上采樣之后使用了多個3×3 卷積,并證明兩個3×3 卷積運算類似于5×5 卷積運算,且為了使U-Net 網絡具有多分辨率分析能力,將3×3、5×5 及7×7 卷積運算并行合并,如圖2(b)所示,用類似Inception 的卷積層使U-Net 網絡獲取不同尺度的特征。但并行卷積層極大地增加內存需求,因此使用3×3 卷積對5×5 及7×7卷積進行分解。如圖2(c)所示,本網絡使用融合殘差路徑組成級聯結構,每塊由3×3 卷積和1×1 卷積以殘差的方式組合,經過額外的非線性變化的編碼器特征可平衡與解碼器語義鴻溝。這種修改不僅降低了內存需求,而且由于1×1 卷積層的加入,不改變UNet 在醫學圖像分割的優秀性能,同時獲取視網膜血管更廣的空間信息。殘差網絡在醫學圖像分析中具有巨大的潛力[17],使用殘差連接代替直接連接,并根據特征差距的大小調節殘差路徑長度,使學習變得更容易。將這條快捷連接路徑稱為“Res Path”。3×3濾波器用于卷積層,1×1 濾波器作為殘差連接,融合形成殘差路徑放入U-Net網絡中。

1.2 基于殘差路徑的U-Net

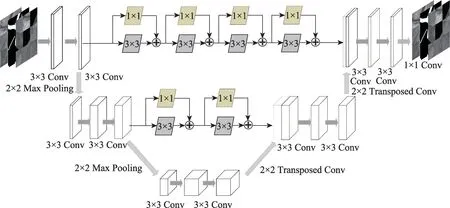

根據U 型網絡的結構特點,Nabil 等[18]提出隨著U-Net 卷積操作的向下移動,編碼器與解碼器特征映射差距強度逐步減小。為了進一步提升特征的學習能力:一方面選取U-Net 編碼結構與解碼結構中的兩次卷積操作及上下采樣,通過減少神經網絡層數,減少由神經網絡操作帶來的語義鴻溝,同時訓練參數的減少,避免圖像過擬合提升網絡的泛化能力。另一方面針對不同的語義鴻溝設置不同長度的殘差路徑,沿著兩個Res Path 分別使用包含4 個3×3 卷積的濾波器以及1×1卷積的殘差連接Res Path1和兩個3×3卷積的濾波器以及1×1 卷積的殘差連接Res Path2,且為使編碼器與解碼器中的特征數量平衡,設置與編碼器相同的濾波器,根據視網膜經過預處理后像素小的特點,改進后的U-Net 每一層的卷積核數目分別為32 和64,對應的兩個殘差路徑濾波器選擇為32 和64。改進后的U型網絡魯棒性更強,模塊結構圖如圖3所示。編碼器和解碼器分別包括兩個3×3 卷積運算和一個池化大小為2×2,步長為2 的最大池化運算。這個序列循環兩次,每次下采樣之后,卷積層中的濾波器數量加倍。每次上采樣后特征通道減少一半。在上采樣之前,使用Res Path1 和Res Path2 將編碼器的特征輸出傳送到解碼器,然后將這些特征圖與上采樣操作后的輸出連接起來,傳入到后續卷積層中。該網絡結構中輸出層使用Sigmoid 激活函數,其他卷積層使用ReLU 激活函數,將此結構稱為ResUNet塊。

Fig.2 Res Path structure diagram圖2 Res Path 結構圖

Fig.3 ResU-Net module diagram圖3 ResU-Net模塊圖

1.3 多模塊殘差神經網絡模型

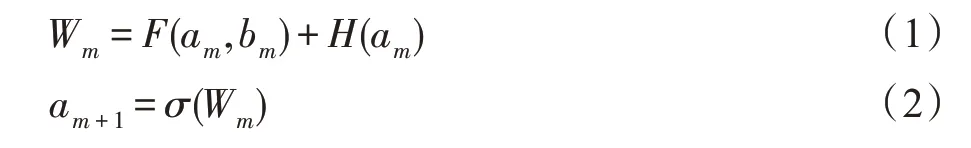

在眼底視網膜血管圖像中,視網膜圖像照明不均勻,血管與背景在顏色、紋理上的差別較小,微小或復雜血管結構難以分辨。加深網絡深度更能有效提高眼底血管特征表達,但深層網絡會造成梯度爆炸和梯度消失的問題[18]。為了提升本文ResU-Net 細化分割目標血管能力,采用以殘差連接形成MbResUNet 模型。殘差映射可有效解決網絡退化的問題。He 等[19]提出ResNet 解決了由于網絡深度加深造成網絡性能下降問題,其結果對數據的變化更加敏感。MbResU-Net 將ResU-Net 引入主干網絡中,通過跳躍的殘差連接方式形成多模塊、多殘差塊結構,加強卷積神經網絡的信息傳遞和特征傳播,獲取相對較少的噪聲圖像和更多的特征信息。通過殘差模塊的設計,提取豐富的圖像特征,為之后的血管分割奠定了基礎。每個殘差塊的連接結果由式(1)表示。

其中,am和bm表示ResU-Net 塊的輸入和輸出;F(am,bm)表示殘差函數;H(am)表示特征映射函數,通常F(am)=bm。式(2)中,σ(Wm)表示激活函數,將連接結果通過ReLU(rectified linear units)激活函數后結果作為下一個模塊的輸入。最終得到每一塊殘差連接的輸出結果Wr={n∈N|Wm,Wm+1,…,Wn},并將每一次的輸出結果激活后作為下一個ResU-Net塊輸入。

MbResU-Net 網絡融合遞進的思想,設計了三個特征提取模塊用以加深網絡,在模塊中分別將淺層特征與深層特征融合,使更深的U 型網絡充分利用淺層特征對血管進行學習分割。在模塊輸入前設計了Concat層,在下個模塊輸入之前將所有局部特征和全局特征融合,實現特征重用,使參數更少,計算效率更高,以此達到細化分割的效果,解決視網膜圖像中細小血管不易分割的問題。首塊ResU-Net 輸入采用1×1 卷積操作作為輸出,和特征提取模塊最大池化后的輸出連接形成下一模塊的輸入,在每一模塊輸入之前采用ReLU 激活函數將非線性特征引入網絡,同時將輸入映射到輸出。ReLU 函數計算簡單,但解決梯度消失和梯度爆炸的問題。在最后一層,使用1×1卷積來生成最終的分割圖。MbResU-Net 結構圖如圖4 所示。

1.4 損失函數設計

Fig.4 MbResU-Net network structure general diagram圖4 MbResU-Net網絡結構總圖

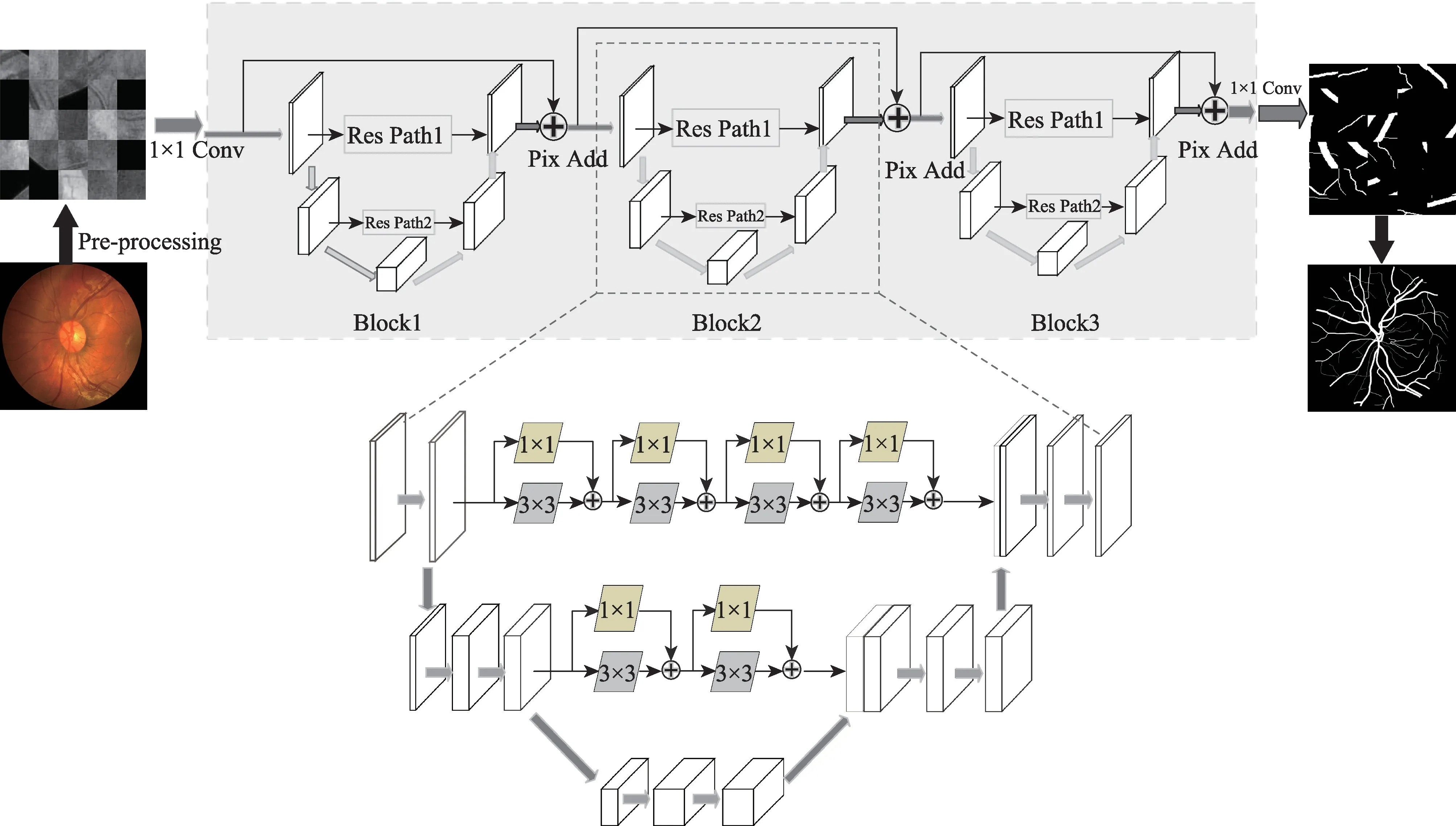

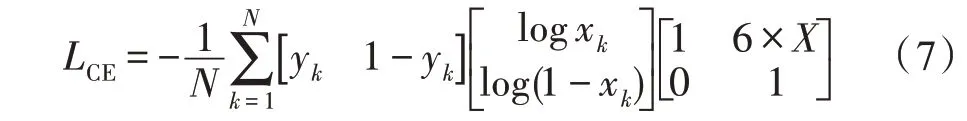

在圖像分割任務中,提升模型分割的另一個關鍵因素是損失函數的設計。損失函數用于測量預測值與真實值的一致性,并且良好的損失函數可以加快網絡訓練速度,提高泛化能力。在深度學習中定義了許多損失函數來訓練網絡,例如均方差、分類交叉熵、二進制交叉熵、余弦正弦等。在本實驗中,像素分為血管像素和背景像素,根據統計顯示,DRIVE數據集中的血管像素大約為453 800,背景像素大約為6 599 200。眼底圖像中只有6.8%的像素是血管,對于二進制分割問題,交叉熵損失函數可以寫為:

其中,N是像素的數量,xk表示輸入像素k預測為前景像素概率,yk表示像素k的真實值,在此任務中血管像素為1,非血管像素為0。此類損失函數在平衡分類任務中可以發揮極好的作用,但是在視網膜血管分割任務中,損失函數設計沒有充分考慮眼底圖像的特征,使學習過程中傾向分割背景區域,血管像素容易丟失或僅被部分識別。受Wang 等[20]的啟發,使用基于Dice 損失函數(Ldice)和交叉熵損失函數(LCE),并向損失函數中增加代價敏感矩陣(C)。

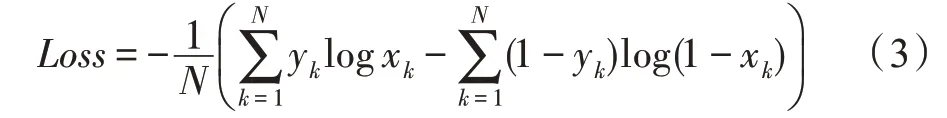

對于二進制分類任務,Dice 損失函數可以考慮到數據的不平衡,Dice損失函數可以表示為:

其中,φ表示拉普拉斯平滑因子,用于避免數值問題并加速訓練中的收斂速度。但是優化后的Dice 損失函數容易導致梯度消失問題,不適用于深度神經網絡。另外設計了代價敏感矩陣,當模型對視網膜血管分類錯誤時代價增加,并且增加血管的關注度。代價敏感矩陣C如式(5)所示:

在公式C中,用于將血管類型預測為血管類型以及將背景預測為背景的懲罰系數都設置為1。用于預測血管的懲罰系數設置為6。將背景識別為血管不會影響結果,因此懲罰系數設置為0。在神經網絡訓練中,并未根據相對于背景的視網膜像素數來進行不平衡調整,預測血管類別為背景類別的懲罰系數始終為6。指標函數X表示為:

因此,所提出的融合代價交叉熵損失函數公式如式(7)所示:

最后,結合Dice 損失函數和代價交叉熵損失函數的優勢,將此函數結合引入到血管分割任務中,MbResU-Net的損失函數公式如式(8)所示:

這種方法可以加快網絡的融合,并且經過一定次數的迭代后,本網絡模型的參數收斂到最佳值,達到最優分割效果。

2 實驗

2.1 數據集及實驗平臺

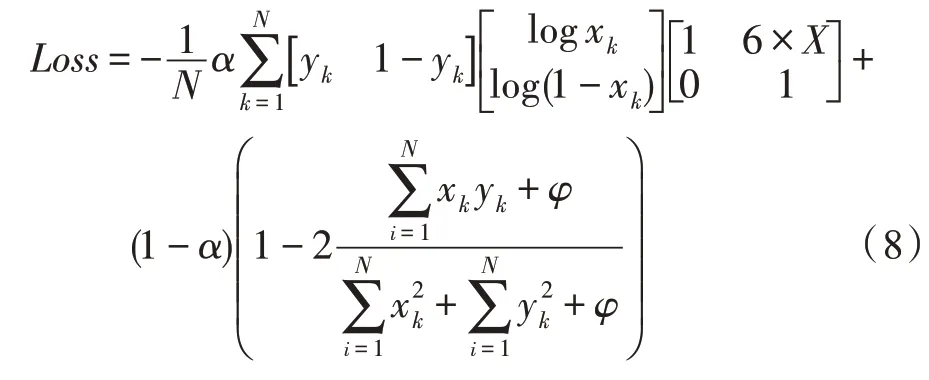

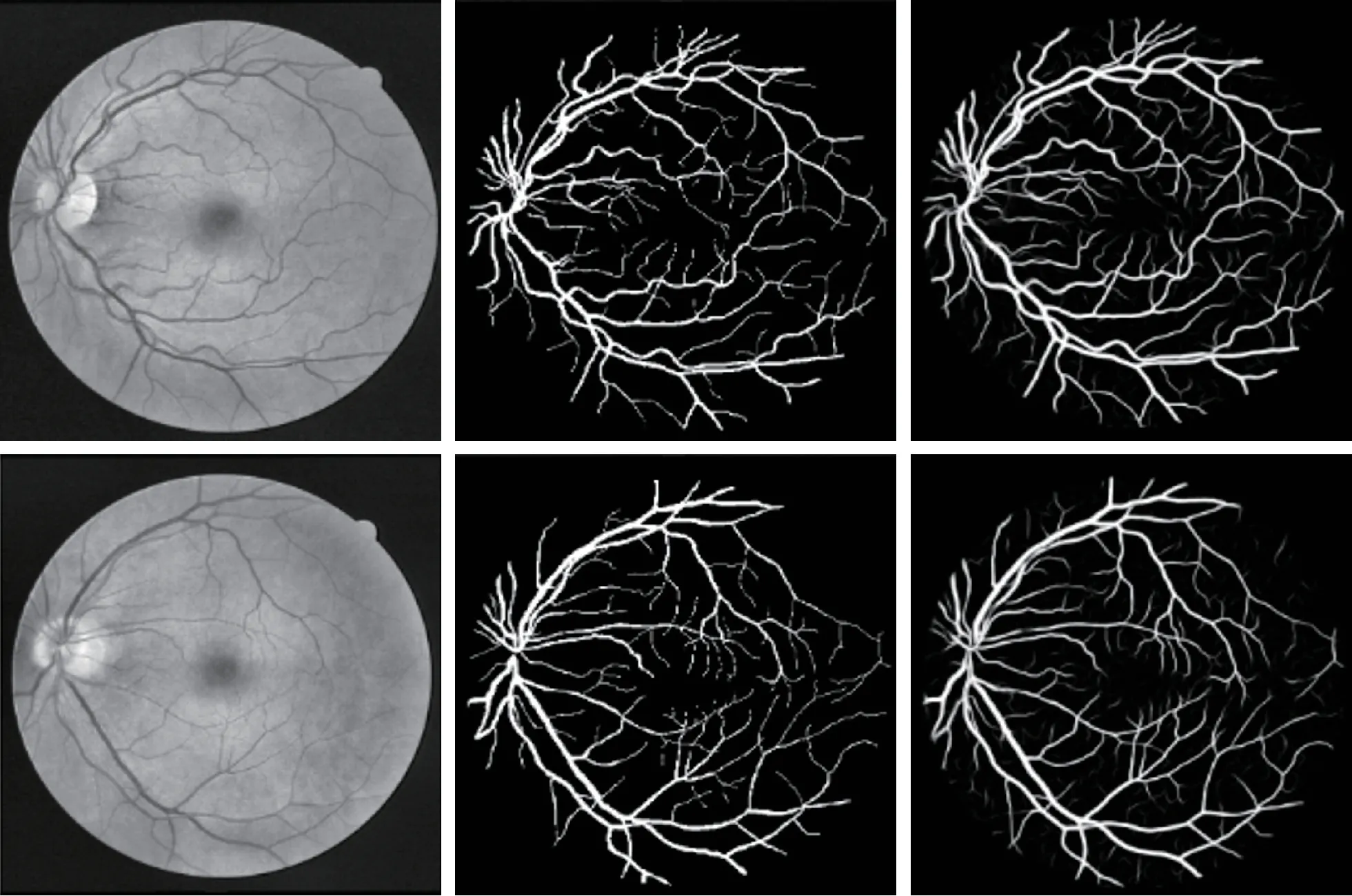

本文實驗所用數據集為開源眼底視網膜血管數據集DRIVE 和CHASE DB1。DRIVE 數據集包含40幅數字視網膜RGB 圖像,每幅圖像剪裁后的分辨率為565×584 像素。由官方劃分為20 幅訓練集圖像和20 幅測試集圖像,數據集中包含2 名專家手工分割結果,并存在對應的掩膜,具有很強的可信度。CHASE DB1數據集包含28幅視網膜圖像,每幅圖像的分辨率為999×960 像素。在本實驗中,14 幅圖像用于訓練,14 幅圖像用于測試。該數據集中每幅圖片由一名專業醫師分割得到手工結果圖像,但是無對應掩膜,需要手動設置。CHASE DB1 手動設置的二值掩碼結果如圖5 所示。本文所用實驗平臺為:64 位Win10 操作系統,使用Intel?CoreTMi7-4160 GPU@ 3.60 GHz 處理器,顯卡為NVIDA 1660Ti。該方法基于TensorFlow框架實現。

Fig.5 Images of CAHSE DB1 database圖5 CHASE DB1 數據庫圖片

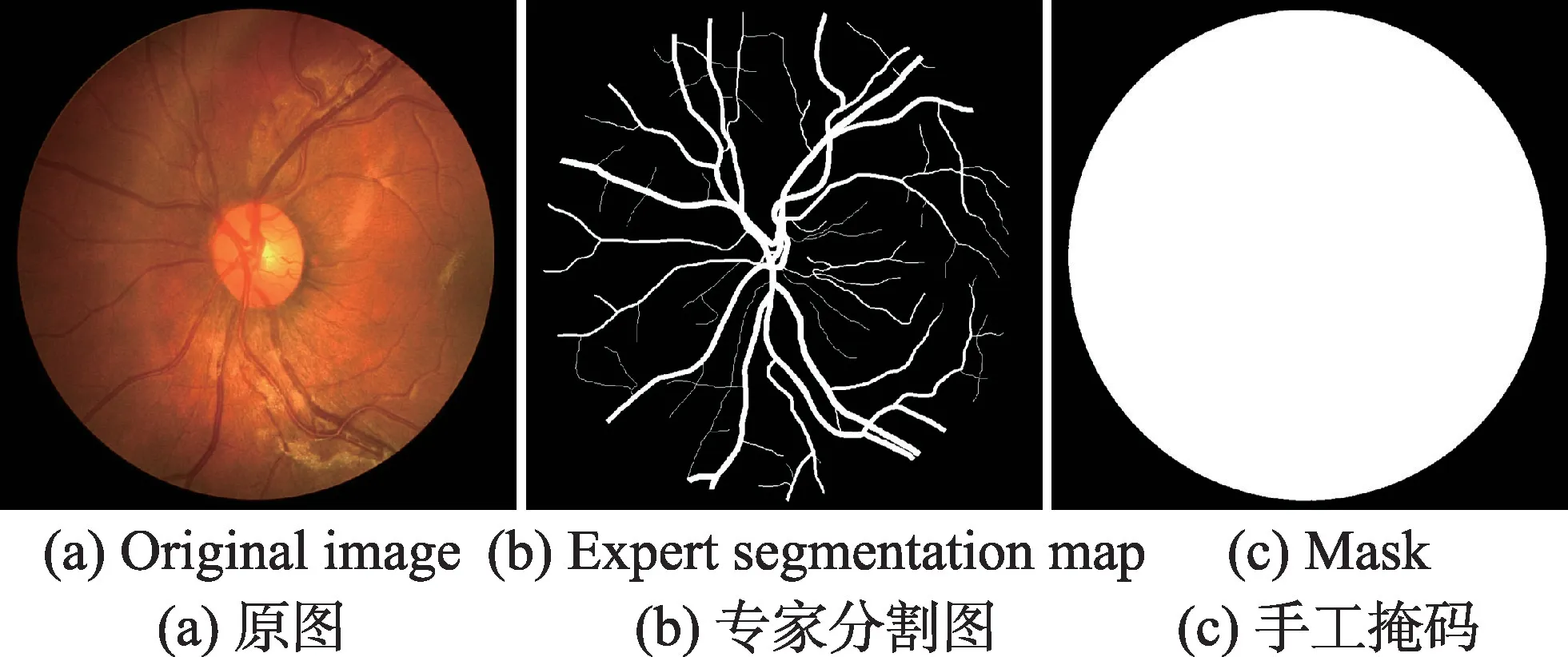

2.2 數據預處理

兩個數據庫的眼底圖像均為RGB 圖像,單通道圖像比RGB 圖像可顯示更好的血管背景對比度。因此,如圖6 所示,將原始圖像通過G 通道完成圖像的灰度轉化,接著將視網膜灰度圖像歸一化[21];采用對比度受限的自適應直方圖均衡化(contrast limited adaptive histogram equalization,CLAHE),在不放大眼底視網膜圖像的情況下增強視網膜血管與背景之間的對比度,使血管結構特征更清晰;最后采用伽馬變化(gamma conversion)在不影響視網膜圖像中高亮血管區域的同時增亮對比度較低的血管區域。預處理后的視網膜圖像對比度高,血管輪廓與背景差距大且噪聲減少,更有利于血管分割。

Fig.6 Retina image preprocessing results圖6 視網膜圖像預處理結果

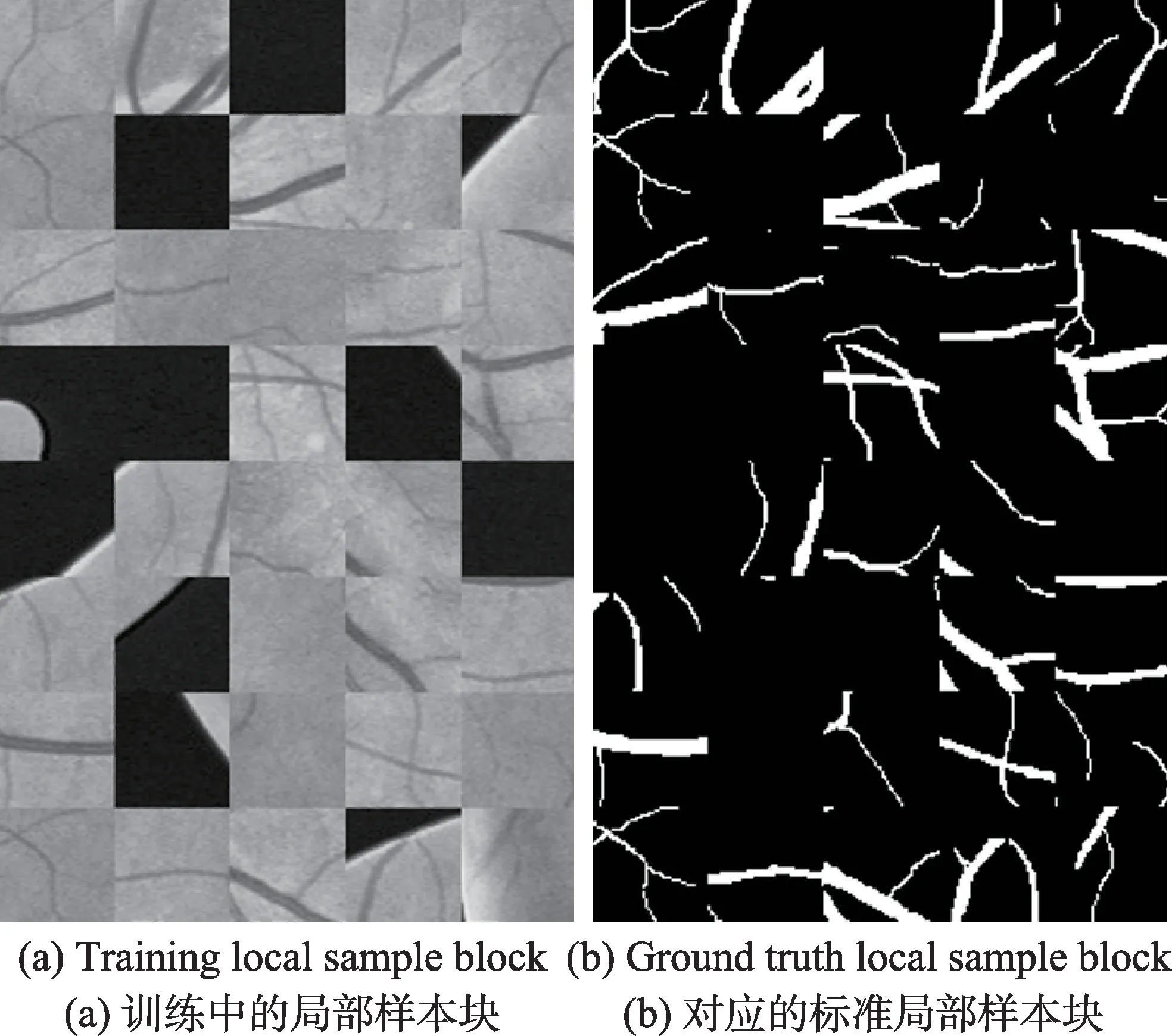

由于DRIVE 和CHASE DB1 均為小數據集,在網絡訓練中容易過擬合,在訓練模型時對數據進行增強和擴充。在訓練模型之前對兩個數據集圖像進行90°、120°、270°和鏡像翻轉擴充到原來的12 倍。與此同時,從DRIVE 和CHASE DB1 數據集的輸入圖像中分別提取9 到574 像素、20 到980 像素,圖片像素分別變為560×560、960×960,再隨機裁剪48×48 的局部分割樣本圖像,樣本塊包含數據庫中的所有圖像,用以擴大數據量。網絡訓練時,分別從DRIVE 和CHASE DB1 隨機抽取190 000 和200 000 個補丁塊。其中,隨機選取90%用于訓練,10%用于驗證。測試集不做旋轉裁剪及數據擴充處理。局部樣本塊如圖7(a)所示,圖7(b)所示為手工標注的標準裁剪拼接處與訓練集相對應的圖像。

Fig.7 Local sample block圖7 局部樣本塊

2.3 評價指標

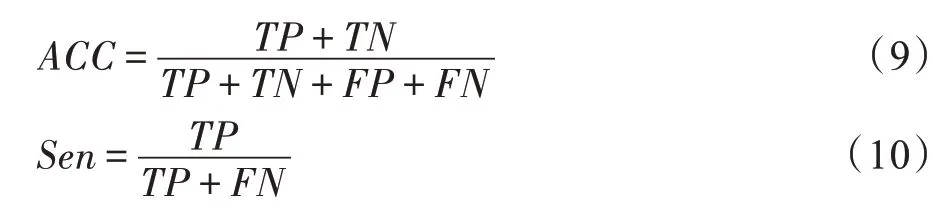

為了定量評估模型,使用了準確率(accuracy,ACC)、靈敏度(sensitivity,Sen)、特異性(specificity,Spe)和F1-Score來評價模型的性能[22]。在該模型中,陽性是指血管,陰性是指背景。基于視網膜血管圖像真實值,每個像素在分割過程中分為正確或不正確分割,因此有四種視網膜血管分割結果。TP表示血管像素已正確檢測為血管;TN表示背景像素已正確檢測為背景;FP表示背景像素被錯誤地檢測為血管;FN表示血管像素被錯誤地檢測為背景。各指標表達式如式(9)~(14)所示:

其中,ACC是正確檢測到的血管和背景像素數量與非血管總像素之比;Sen是正確檢測到的視網膜血管像素與血管總像素之比;Spe是正確檢測的非血管像素與非血管總像素之比;Pre是正確檢測到的血管像素與所有檢測到血管像素之比;Rcall是正確檢測到的血管像素與所有實際檢測到血管像素之比;F1-score用來衡量模型與專家分割結果的相似度。

為了進一步評估本模型的性能,利用了ROC 下的曲線面積(area under curve,AUC),ROC 是衡量圖像語義綜合性能分割結果的重要方法。AUC 值范圍為0~1,若AUC=1,表示非常貼合的分類器;0.5~1.0,表示優于隨機分類器;0~0.5 表示差于隨機分類器。

2.4 實驗結果與分析

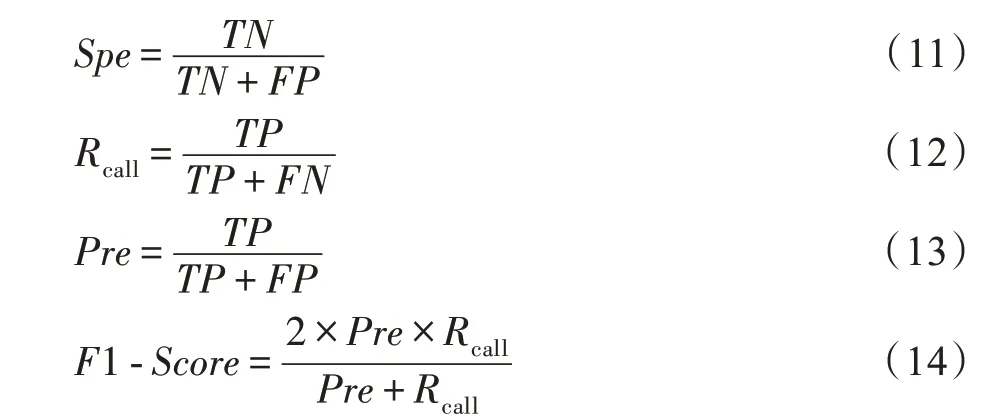

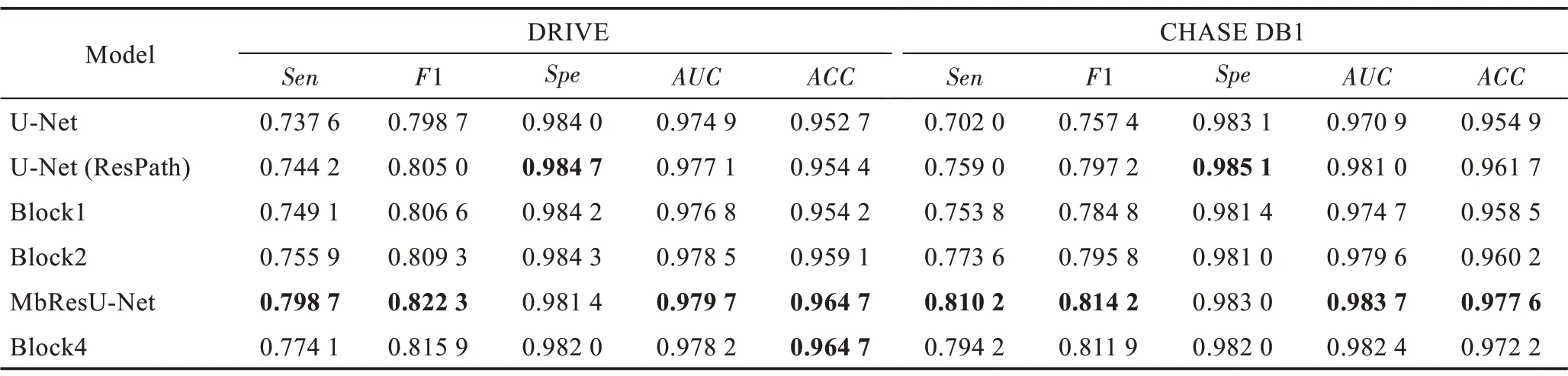

2.4.1 算法改進前后對比

為了檢測模塊改進后算法性能,實驗分為兩部分。首先,將本網絡模塊MbResU-Net 與增加殘差路徑的U-Net 進行對比實驗。其次,對MbResU-Net 進行消融實驗。將MbResU-Net、U-Net、U-Net(Res Path)、單冗余塊-Block1、雙冗余塊-Block2 及四冗余塊-Block4 分別在DRIVE 和CHASE 數據集上進行實驗,并將實驗結果對比。對于每組實驗,迭代次數設置為100 次,所得結果如表1 所示。

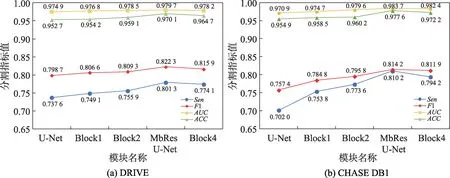

從表1中可以看出,MbResU-Net 在DRIVE 及CHASE DB1 數據集上Sen、F1、AUC、ACC值均優于使用殘差路徑的U-Net,實驗證明使用殘差網絡串行連接各模塊,解決了由深度網絡之間特征融合而產生的特征差距,更有效分割視網膜圖像。在消融實驗中,單冗余塊-Block1 實驗效果優于U-Net 模塊。在DRIVE 數據集上,MbResU-Net 模塊比單模塊的Sen、F1、AUC、ACC值分別高0.049 6、0.015 7、0.002 6、0.010 5;在CHASE DB1 數據集上,MbResUNet 模塊比單模塊的Sen、F1、AUC、ACC值分別高0.056 4、0.029 4、0.009 0、0.019 1,且均在三模塊融合時各項指標最佳。但相比較四模塊的實驗結果分析,如圖8 所示,Block4 各項分割指標均比Block1 及Block2 高,但比MbResU-Net 各項分割指標略低或持平,且四個模塊的訓練時間遠多于MbResU-Net,效果與MbResU-Net 差距微小。可以看出,三模塊殘差網絡,即MbResU-Net,從分割統計結果上優于其他四種網絡。

Table 1 Segmentation indicators of different modules表1 不同模塊的分割指標

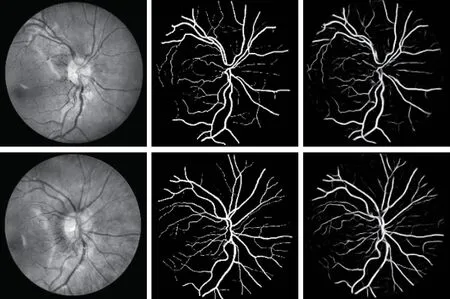

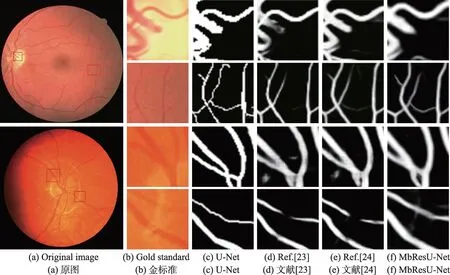

通過與專家手工標準的分割結果進行測試和對比,本文方法可以清楚地將血管與背景區域分開。圖9 為DRIVE 數據 庫中的03_test 圖和11_test 圖 的分割結果,圖10 為CHASE DB1 數據庫中的Image_02L和Image_07R 圖的分割結果。驗證了本文方法在血管復雜形態下的分割效果,尤其是血管分叉處分割效果優異。以DRIVE 數據集為例,第一列為DRIVE數據集原始視網膜預處理圖,第二列為手工標注分割圖,第三列為本實驗分割圖。從實驗對比圖來看,本文算法分割結果基本和專家手工標準圖相仿,并在復雜曲度形態血管分割上有明顯的分割效果。

Fig.8 Comparison of evaluation indicators for redundancy modules圖8 各冗余模塊評價指標對比

Fig.9 Comparison of experimental segmentation of DRIVE dataset圖9 DRIVE 數據集實驗分割對比圖

Fig.10 Comparison of experimental segmentation of CHASE DB1 dataset圖10 CHASE DB1 數據集實驗分割對比圖

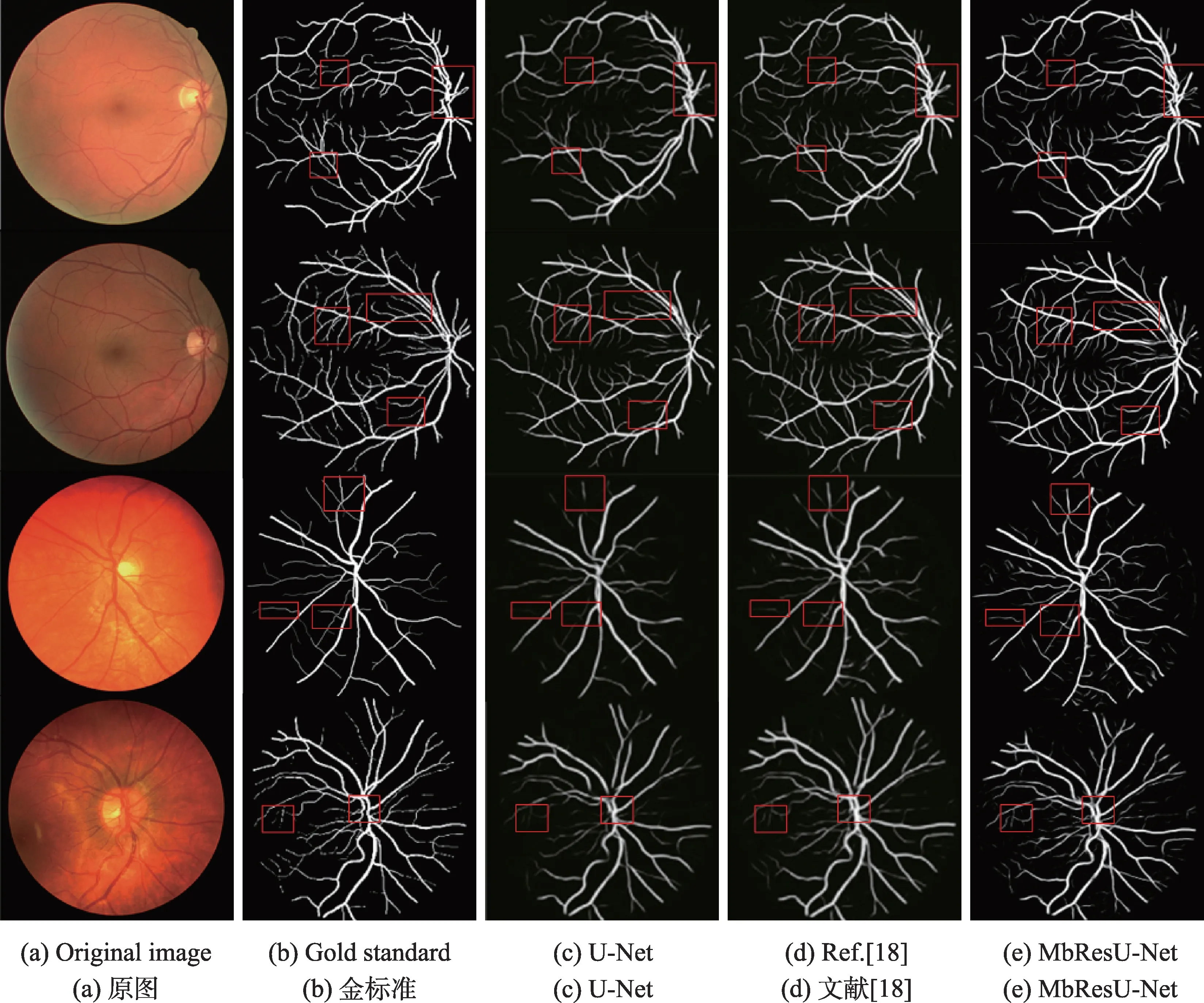

2.4.2 不同算法的性能評估

此外,為了更有效地分析MbResU-Net 的分割效果,將MbResU-Net 與 文 獻[23]、文 獻[24]算 法 在DRIVE 和CHASE DB1 數據集上的分割進行定性和定量分析。如圖11 所示,在對比圖中前兩行為DRIVE 視網膜對比圖像,后兩行為CHASE DB1 視網膜對比圖像。圖11 中(a)~(b)表示數據集彩色圖、手工標注圖,(c)表示U-Net 網絡分割結果,(d)表示文獻[18]分割結果圖,(e)為本文算法分割結果圖。圖11 第一行和第四行顯示出,由于光照強度不一致的影響,其他文獻均出現主血管細節分割混亂,尤其是血管與血管之間空隙模糊,而MbResU-Net 較好地解決了這個問題,由于冗余網絡的加入讓圖像特征訓練得更充分,使復雜結構血管分支更清楚。本文方法在有效解決血管合并問題的同時也提升了小細血管的分割精度。圖12 顯示了兩個數據集的分割細節。如圖12(b)的第一行與第三行局部細節圖所示,主血管區域的血管相互交錯并且彼此相鄰,精確分割此類血管對網絡結構的要求嚴格,但文獻[23]與文獻[24]針對復雜交錯血管分割不清楚且有分割噪聲,而本文方法對復雜曲度細節分割具有較好的效果,由圖12 的第二行和第四行所示,文獻[23]僅用U-Net中的普通卷積層,特征提取能力弱,隨著網絡深度的增加,不斷的池化操作導致損失大量的局部細節信息。相比之下,本文方法使用殘差路徑加深網絡深度,捕獲各種視網膜細小形狀的能力更強。MbResUNet 在某些連接區域中提取的血管細節比文獻[24]更多,在細小血管分割中獲得更理想的分割結果。因此,基于初始模塊的多模塊融合提取卷積神經網絡能夠使細小的視網膜血管特征更具區分性。

Fig.11 Comparison of segmentation of different algorithms on DRIVE and CHASE DB1 datasets圖11 不同算法在DRIVE 和CHASE DB1 數據集上的分割對比圖

Fig.12 Detail comparison of segmentation results圖12 局部細節分割對比圖

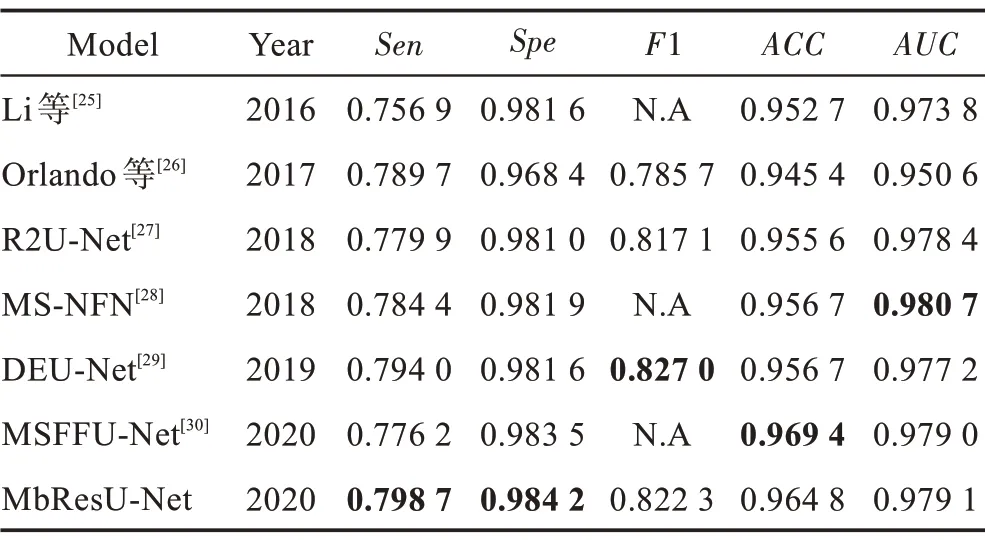

Table 2 Performance indicators of different algorithms on DRIVE dataset表2 DRIVE 數據集不同算法的性能指標

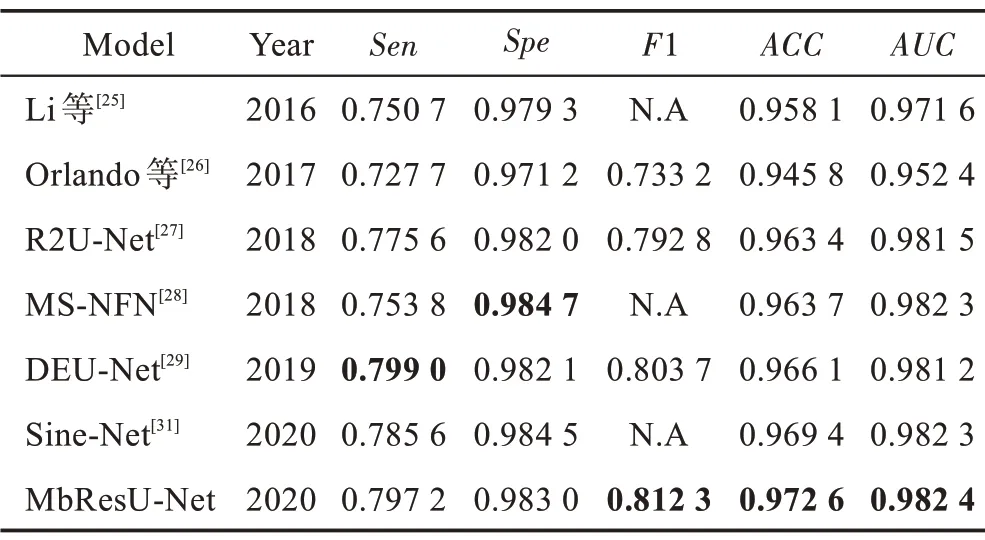

Table 3 Performance indicators of different algorithms on CHASE DB1 dataset表3 CHASE DB1 數據集不同算法的性能指標

為了綜合測試MbResU-Net 在視網膜血管分割領域的性能,將本文網絡與文獻[25-31]在各項指標下進行比較,統計結果如表2 和表3 所示。基于DRIVE 數據集進行對比,本文準確率ACC達到了0.964 8,Sen值為0.798 7,F1 值為0.822 3,AUC值為0.979 1;基于CHASE DB1 數據集進行對比,本文準確率ACC達到0.972 6,Sen值為0.797 2,F1 值為0.812 3,AUC值為0.982 4。各項指標均優于文獻[31]。對于CHASE DB1 數據集,本文模型訓練得到的AUC和F1 值最高,Sen比文獻[29]低0.001 8,Spe值比文獻[31]低0.001 5。但綜合表中各項指標結果來看,本文所提出的MbResU-Net 網絡,可以有效完成眼底圖像的血管分割任務,獲得較高的性能指標,有良好的穩定性和抗干擾能力。具體來說,Li 等[25]提取大小為16×16 樣本塊,在訓練過程中會大量檢測到無血管區域,影響最終的訓練效果。Orlando等[26]在網絡中使用全連接條件隨機場模型,但標記血管時仍是一個挑戰。近些年提出應用于視網膜分割的卷積神經網絡方法,Alom 等[27]在U-Net 的每個3×3 卷積操作后增加循環殘差塊,Wu 等[28]采用多尺度級聯的U-Net 網絡模塊訓練網絡。Wang 等[29]在U-Net 網 絡中增加inception 進行特 征融合。Dan 等[30]在U-Net 網絡中使用多尺度特征融合的方式對視網膜進行分割。雖然這些方法性能有所提高,但訓練過程復雜。盡管在部分指標上達到先進的性能,但在實際應用中并不實用。本模型可以實現高精確度的自動化分割,為眼科提供例如彎曲度、交叉病變結構、軟硬滲出液等重要信息。該模型可有效提升醫生對患者進行早期診斷的效率。MbResU-Net 有利于細小血管分割,因此,在糖尿病性視網膜分級檢測上有一定的發展前景,但需要針對不同糖尿病視網膜血管病變程度對網絡進行改進,旨在提升醫學圖像更準確的分割結果。

3 結論

本文提出了一種用于激光掃描眼底鏡圖像的視網膜血管分割的殘差神經網絡。一方面在快捷連接中添加殘差路徑,語義差距是由低層次的編碼器與更深層次的解碼器連接處理引起的,因此將殘差路徑引入到網絡中,使特征表達更精準。另一方面,為了減少語義差距,縮短卷積操作次數用以減少噪聲,平衡編碼操作與解碼操作后的語義特征,由此提高特征傳播的魯棒性。利用多模塊連接傳遞特征減少參數數量并使特征重用。將改進后的U-Net 網絡作為一個殘差模塊,將殘差網絡與多個U-Net 網絡模塊結合建立多特征融合機制加強信息傳播,并減少參數數量實現特征重用,充分利用ResNet 的跳躍連接,提高深度網絡結構的信息傳播能力,針對視網膜血管前后對背景像素占比設計損失函數,加快網絡收斂,提升圖像分割的準確度。實驗表明,本文算法在DRIVE 和CHASE DB1 這兩個眼底數據庫上能分割出細小血管和復雜曲度血管,相較U-Net 分割方法有一定程度的提升,展示出較好的醫學圖像分割性能。