基于加權分類和樣本合成的卷煙圖像精細識別

韋泰丞 劉雁兵 陳浩 趙弘胤

摘要:為解決采集的卷煙圖像數據類別分布不均衡、樣本數量少帶來的識別率低的問題,提出了一種基于加權分類損失和樣本合成的卷煙圖像精細識別模型。針對類別數量長尾分布問題,設計了一種新型的加權分類損失函數,用于增強對不同卷煙類別的學習能力;針對部分卷煙類別樣本數量少,在不增加采集成本情況下提出了一種高質量卷煙虛擬樣本生成方法,極大地緩解了某些卷煙數據量不足、識別精度低下的問題。模型在大規模真實測試集上進行測試,卷煙的識別平均精確率達到95%。證明對于不同的復雜場景,模型的魯棒性強,可以在圖像翻轉、倒置的情況下準確識別出不同卷煙類別,能夠滿足零售終端卷煙自動化識別的需求,為建設終端評價系統提供了算法與模型支持。

關鍵詞:深度學習;神經網絡;目標檢測;卷煙識別;數據擴增;長尾分布

中圖分類號:TP391.4文獻標志碼:A文章編號:1008-1739(2022)23-65-8

0引言

零售終端是零售產業鏈的重要組成部分,是零售商品實現最終銷售的關鍵環節。零售終端對于零售商品的品牌培育、產品銷售的作用愈發凸顯,了解自主品牌和其他工業公司品牌在零售終端的陳列狀況,根據零售終端總體情況針對性實施營銷策略,對促進品牌培育、擴大品牌銷售和影響力十分重要。

近年來,人工智能技術在零售行業發展迅速,以圖像識別為代表的人工智能技術,給零售行業帶來了巨大的變動與機遇。生鮮超市、智能便利店、無人貨架、自助售貨機等新概念遍地開花,這些都離不開以圖像識別為基礎的技術支撐,通過店鋪內安裝攝像頭設備,實現客流統計、客流分析,同時準確地把握顧客的年齡、性別和喜好,識別新老顧客,實現精準的營銷推廣活動;通過店鋪陳列與客流停留時長的分析,優化店鋪布局和產品陳列方式,實現店鋪銷售額的提升。

在煙草零售行業中,傳統人工方式進行在銷商品統計時面臨統計效率低、識別誤差大、人工成本高等問題,每次統計需要較長的統計周期,往往沒有辦法即時得到銷售信息等關鍵內容,而通過人工智能等前沿技術對卷煙零售店中在銷的卷煙信息進行采集和分析,可以幫助煙草工商企業更高效、及時地獲取卷煙在銷品類、規格以及不同卷煙的銷售情況。本文針對卷煙零售終端統計在銷商品時所面臨的統計效率低、數據長尾分布、識別誤差大、人工成本高等問題,通過計算機視覺和人工智能技術,構建了一種加權分類和樣本合成的精細識別模型,主要貢獻有以下3點:

①為了更好地提取圖像中物體的特征信息,對網絡結構的Backbone部分進行了修改,使用分組級聯的結構替換了網絡中的殘差模塊,增大了模型的感受野,幫助更好地提取物體的細節特征。

②提出一種針對樣本分布不均衡的分類損失函數,在訓練過程中動態地根據分類器對不同類別的正負梯度和得分調節損失的權重,有效提升數量稀少類別的識別精度。

③針對訓練中樣本數量少的類別,提出高質量虛擬樣本生成技術,在數據預處理階段生成大量多樣化的稀少類別虛擬樣本,緩解了樣本不均衡問題。

1相關工作

1.1相關背景

目標檢測任務是計算機視覺領域的一個基礎任務,其目的是對輸入的圖像或視頻中出現的物體進行分類和定位。目標檢測作為場景理解的重要組成部分,廣泛應用于現代生活的許多領域,如安全領域、軍事領域、交通領域、醫療領域和生活領域。當前的目標檢測方法可以劃分為三大類:基于傳統方法的目標檢測方法、基于深度學習的雙階段目標檢測方法和基于深度學習的單階段目標檢測方法。

傳統目標檢測算法主要基于手工方式提取特征,該方法用于從指定區域中提取特征,再把得到的特征輸入線性SVM分類器進行檢測。由于傳統方法需要通過滑動窗口來獲取候選區域,且特征提取算法往往需要通過手工設計,這類方法存在識別效果不佳、準確率不高、計算量較大、運算速度慢等缺陷,所以一直沒有很好地應用。

以YOLO[1-3]系列為代表的單階段目標檢測算法不需要區域候選框生成,而是將檢測任務視為一個回歸問題,直接通過卷積神經網絡預測物體的類別和位置坐標值,并對檢測的性能進行了優化[4]。隨后提出的RetinaNet[5],SSD[6]等模型,加入了多尺度融合機制,提升了不同尺度下的物體和小目標的檢測精度。這類方法的特點是檢測速度快、模型參數量小,但是受限于輸入尺寸無法在卷煙密集場景下取得很好的檢測效果。

而雙階段模型近年來大部分基于Faster-RCNN[7],Cascade-RCNN[8]等,雙階段目標檢測器主要由以下2個階段構成:從圖中生成候選區域,對候選區域提取特征經過分類和回歸層得到最終的分類和回歸結果。這類方法利用滑動窗口和錨框生成手段,對圖像中密集出現的卷煙目標可以有很好的檢測效果,但是面對長尾分布的數據,會由于不均衡的數據分布導致對樣本數量少的類別檢測效果不佳,影響整體性能表現。

1.2卷煙圖像識別的技術現狀

近年來,人工智能技術[9]在煙草行業發展迅速。其中,洪金華等[10]使用YOLOv3模型對煙蟲進行檢測;高震宇等[11]使用卷積神經網絡檢測煙絲物質組成;肖雷雨等[12]利用深度學習技術檢測煙梗形態;鄧超等[13]利用深度學習構建卷煙投放預測模型。在卷煙零售端,也有利用深度學習方法進行場景文本識別[14-15],梁冬等[16]提出了基于圖像識別技術的卷煙零售數據采集方法;單宇翔等[17]提出了基于深度學習的復雜場景中卷煙煙盒檢測與識別方法,這些方法利用關鍵點檢測與分割方法進行了探索并取得了一定的效果,但對于大規模多類別的卷煙識別效果仍有待提高。在國外,卷煙識別任務主要關注于吸煙行為的檢測[18],對于卷煙種類識別任務還處于探索階段。

卷煙識別任務需要對零售店鋪中出現的卷煙煙盒進行定位和識別,該任務目前仍面臨許多挑戰。由于零售終端行業在各個城市發展各不相同,卷煙零售店鋪可能包含了超市、便利店、直營店鋪等各種類型,店鋪條件的差異導致采集的煙盒圖像差異巨大。同時,由于沒有統一的行業采集標準,采集圖片受到采集人員、采集設備、光照等因素的影響,使得采集圖像規格各異,其中出現的遮擋、過曝、過暗、拍攝角度不同等都會使得同一個類別卷煙煙盒的外在特征產生很大差異。另外,由于卷煙品牌數量眾多,新品迭代更新快,部分品牌的卷煙外觀差異非常小,對檢測器性能提出了更高的要求。如何在密集出現、相鄰擺放的場景中很好地區分不同品種的卷煙是一個很大的挑戰。此外,由于卷煙種類繁多,在采集時很難均衡地對每個類別進行采樣,而受限于人工標注的成本,如何在數據量不充分且存在不均衡卷煙種類分布的情況下,得到對所有類別良好的檢測性能是該任務面臨的第二個挑戰。

2基于加權分類損失和樣本生成的卷煙精細識別方法

2.1整體模型架構

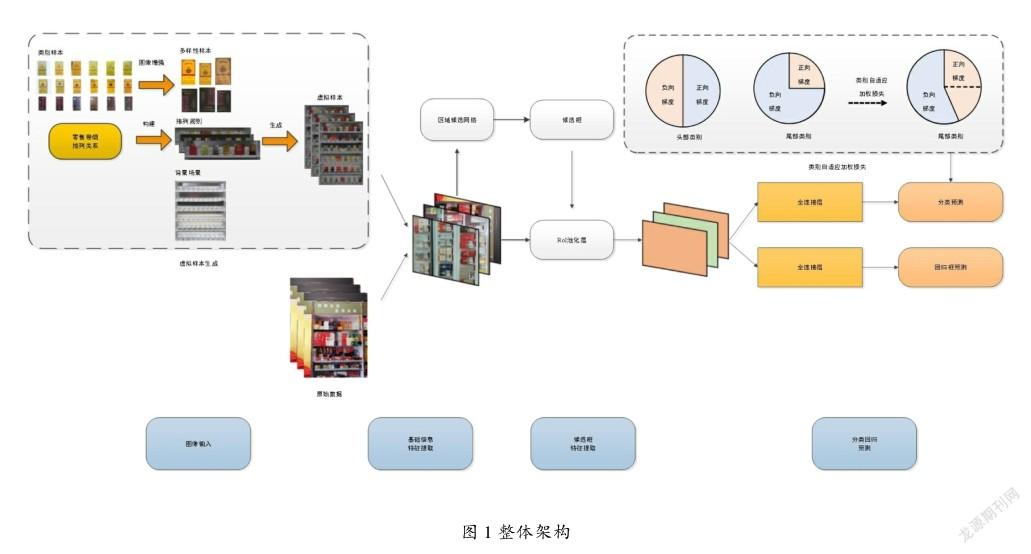

由于卷煙識別需要在復雜多樣的環境下對多種類別的卷煙進行識別,對于網絡的特征提取能力有很大的要求,傳統Faster-RCNN網絡使用的特征提取模塊的卷積核感受野較小,對圖像中某些細節特征提取能力不足,因此本文利用分組級聯的Res2net[19]模塊替換了原始網絡中的卷積模塊,增強了網絡的特征提取能力。針對卷煙數據類別存在的樣本不均衡問題,從數據與模型2個角度出發,設計了可以根據梯度自適應調節損失權重的類別自適應加權損失,以提升稀少類別的分類性能;同時提出卷煙虛擬樣本生成技術,對稀少的數據類別進行擴增,有效改善了樣本分布不均衡的問題。模型的整體架構如圖1所示。

首先使用虛擬樣本生成技術,抽取樣本數量少的類別,經過隨機數據增強后得到多樣化的樣本,通過一定的排列規則與背景場景構造虛擬樣本,并和原始數據一起送入模型進行訓練。隨后模型會將輸入圖片經過卷積神經網絡得到特征圖,特征圖通過區域候選網絡得到大量可能包含目標的候選框,并經過RoI池化層進一步壓縮特征得到候選框的特征圖。最后在得到的特征圖后連接2個全連接層對物體類別和位置進行預測。模型在訓練過程中使用類別自適應加權損失動態調節各個類別的正負梯度,使得每個類別都可以得到較好的訓練,經過多個輪次的訓練后,得到最終的卷煙精細識別模型。

2.2分組級聯特征提取模塊

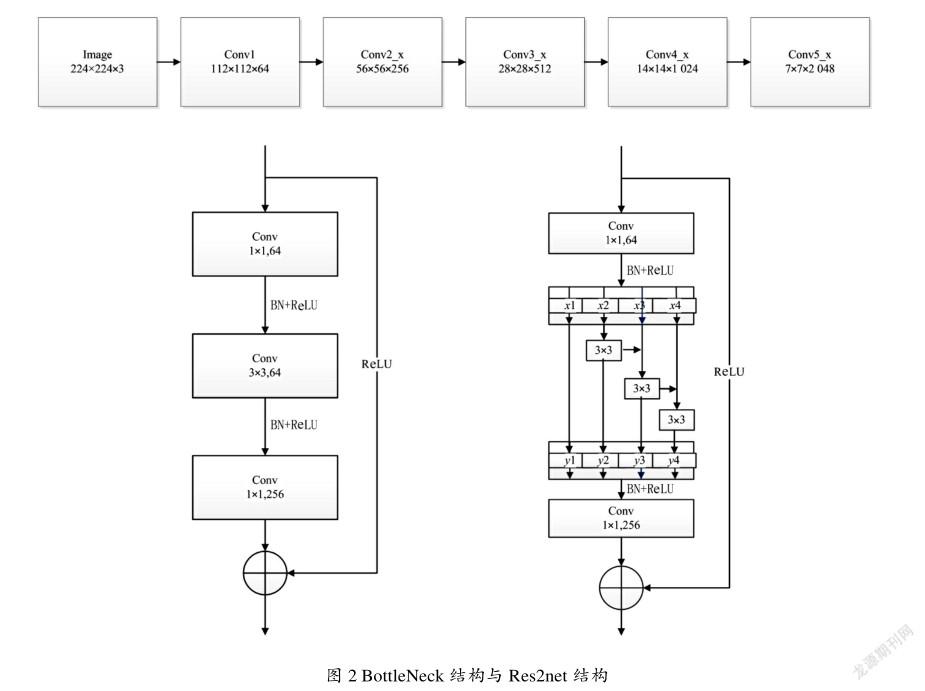

為了使Faster-RCNN模型更好地契合卷煙檢測場景,解決對于多種不同卷煙類別的精確識別,需要更好地提取圖像中卷煙煙盒的外在特征信息。針對上述問題,本文使用分組級聯的方式重新設計了網絡Backbone模塊中的殘差模塊。圖2展示了Backbone網絡結構,圖像依次經過幾個卷積模塊,得到包含目標特征的特征圖,其中每個卷積模塊由若干個BottleNeck殘差模塊堆疊而成。通過引入殘差結構,解決了隨著網絡深度增加,而性能下降的“退化”問題;另一方面,利用2個1×1卷積進行降維與升維操作,有效降低了卷積操作的計算量。

為了進一步增強網絡對于圖像中物體細節特征的提取能力,使用Res2net模塊替換了Conv1,Conv2_x,Conv3_x,Conv4_x,Conv5_x中所有的BottleNeck結構。將通過原有的3×3卷積替換為了更細粒度的按照通道維度分組的3×3卷積核結構,通道的不同組之間會進行信息的交互,4的輸出中包含了2,3,4維度的所有信息,同時由于經過了多個3×3卷積核,使得網絡輸出相較于原始的BottleNeck結構擁有更大的感受野,從而能夠更好地提取圖像中豐富的細節特征信息。

2.3類別自適應加權損失

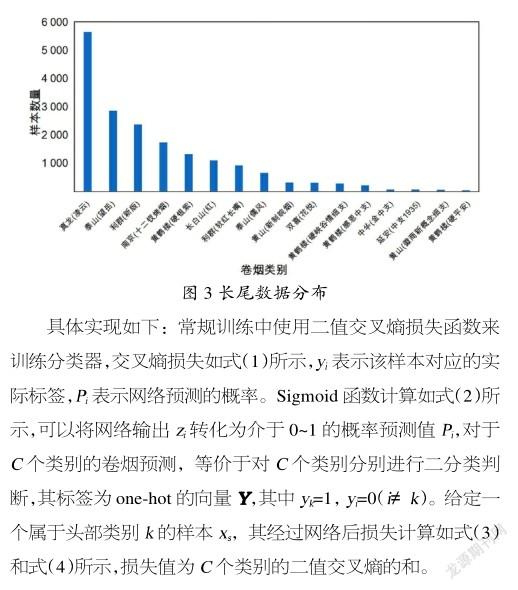

由于不同品牌、規格卷煙的上架率不同,采集到的數據集存在嚴重的類別不均衡問題。不同類別樣本數目的不均衡會影響模型對于該類別的識別效果,進而影響模型整體精度。經過對數據集的分析,發現卷煙圖像樣本的數據分布符合長尾分布,如圖3所示。這是一種數據分布不均衡的問題,少數的幾個卷煙類別占據數據集中很大的比重,而許多類別只有很少的數據量,導致訓練過程中大量來自頭部類別的負向梯度淹沒尾部類別的正向梯度,從而導致檢測模型在尾部類別上的精度下降嚴重。

為了解決這一問題,本文設計了類別自適應加權損失來解決卷煙數據集中的類別不均衡問題。類別自適應加權損失通過保留網絡對于容易混淆類別之間的抑制梯度來保留網絡對于易混淆類別的判別力,同時在訓練過程中減小頭部類別對于尾部類別過多的負向抑制梯度。損失函數通過動態加權的方式在訓練中自適應地調節權重的大小,使得網絡可以在訓練過程中根據不同類別的學習狀況自適應地進行調整。

2.4高質量卷煙虛擬樣本生成

由于采集的卷煙種類繁多,部分卷煙類別由于上柜率較低,在采集到的圖像中涵蓋這些類別的圖像數量較少,導致在模型訓練時該類別無法得到充分的訓練,影響到模型檢測的效果。為緩解該問題,加入了卷煙虛擬樣本生成技術,對采集數量較少的卷煙類別圖像進行數據擴增。由于在銷卷煙圖像排列有規律、場景固定,基于以上特點,利用Copy-and-Paste方法,將卷煙樣本依照類別間關系粘貼到背景圖像上,得到人工生成的虛擬樣本,并將其加入到數據集中訓練模型,從而提高對于真實圖像中數量少的卷煙類別的識別能力和性能,如圖4所示。

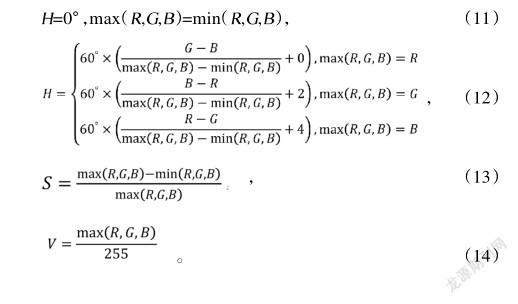

考慮到人工收集的數據遠少于真實數據集中的數據,為了增強虛擬樣本方法生成圖像的多樣性,在每一次擴充過程中加入了圖像尺度隨機抖動、基于HSV顏色空間的數據增強、隨機翻轉等圖像增強手段,增加圖像的豐富度:①尺度隨機抖動,將收集到的待擴增的圖像大小隨機在0.5~1.5的倍率選擇一個系數進行放縮變化。②基于HSV空間的數據增強,將圖像從RGB空間轉為HSV空間,隨后從色相、飽和度、亮度這3個維度值對圖像進行微調,調節范圍保持在0.8~1.2,模仿不同光照下的采集圖像,為了不生成過于失真的圖像,在較小的范圍內進行調節,從而進一步增強了擴增圖像的多樣性,RGB到HSV轉換如式(11)~式(14)所示,其中R,G,B代表紅綠藍3個顏色通道,每種亮度各分為256階亮度。H代表色相,用角度度量取值為0°~360°,從紅色開始按逆時針方向計算,紅色為0°,綠色為120°,藍色為240°,轉換如式(11)和式(12)所示;S代表飽和度,表示顏色接近光譜色的程度,取值為0%~100%,值越大代表顏色越飽和,其轉換如式(13)所示;V代表亮度,表示顏色的明亮程度,通常取值為0%(黑),100%(白),其轉換如式(14)所示。③隨機翻轉,隨機對擴增卷煙的實例進行水平翻轉操作,增強模型的魯棒性。以上所有增強操作都取=0.5的概率,隨機對圖像進行擴增組合,使每一次生成的圖像都是不同數據增強方法的隨機組合。因此,即使僅通過少量采集圖像,也能擴增出大量多樣化的虛擬樣本,有效解決某些類別樣本數量少的問題。

3數據與評價指標

3.1實驗數據

實驗數據使用山東泰安卷煙零售終端采集到的前柜、背柜圖像。圖像中包含店鋪在銷的不同品牌卷煙煙盒陳列圖像,其中包含的卷煙種類共計207。對1 200家店鋪進行了數據采樣,通過手機、相機等設備對經營店鋪的前柜、背柜進行拍攝采樣。采樣時采取正面俯拍的角度進行拍攝,減少大角度傾斜的拍攝情況,對每家店鋪不重復地采集前柜數據2~3張,背柜數據2~3張。按要求匯總后經過數據清洗,去除部分拍攝質量低(模糊、過曝、過暗)的圖像,最終得到用于訓練與測試的卷煙圖像共計5 000張。

3.2實驗方法

實驗使用采集到的店鋪前柜、背柜圖像共5 000張,將其劃分為訓練集和測試集,訓練集包含圖像4 500張,測試集包含圖像500張。訓練集作為訓練數據用于訓練卷煙精細識別模型。測試集用于評估模型的精確率以及各類別的識別效果。本文基于目標檢測雙階段模型Faster R-CNN,以原始Faster R-CNN訓練結果作為基線,通過實驗對比驗證了分組級聯特征提取模塊的有效性,對本文提出的類別自適應加權損失、高質量虛擬樣本在長尾分布下尾部類別數據的作用進行了驗證。

3.3實驗評價指標

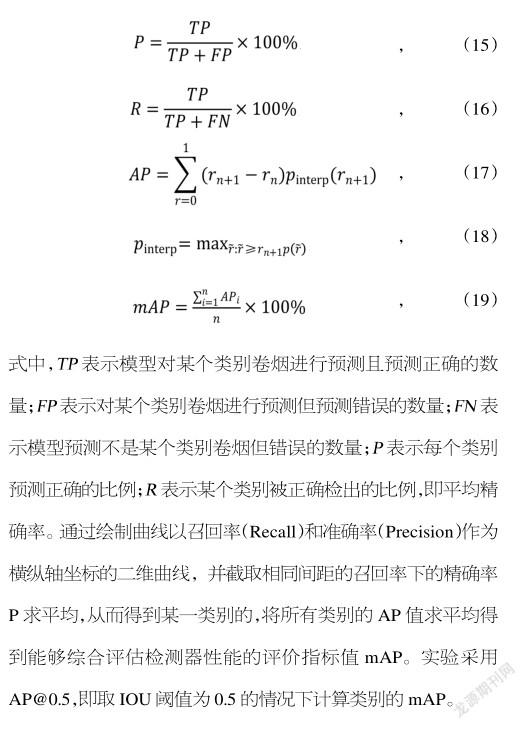

針對卷煙圖像識別效果的評價,需要根據模型對卷煙的類別信息和位置信息進行綜合評價。為了更好地評價模型性能,依據單類別識別平均精確率(AveragePrecision,AP)和全部類別平均精確率(mean Average Precision,mAP)對煙盒識別模型進行評估,計算如下:

4實驗結果

4.1實驗設計

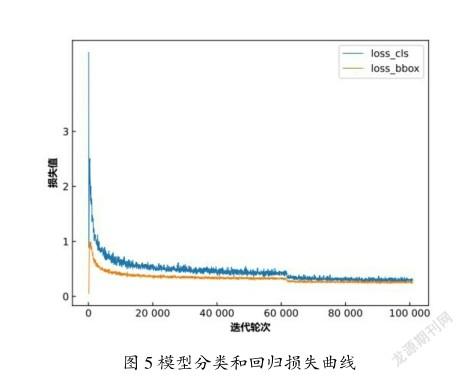

實驗采用Faster-RCNN模型為基礎,加入特征金字塔結構從而更好地提取圖像中的語義信息,采用2.3節的類別自適應加權損失函數和2.4節中高質量卷煙虛擬樣本生成方法增強后的數據集進行模型的訓練。為了增強模型的魯棒性,在訓練中加入了多尺度訓練和隨機旋轉的數據增強,模型共經過72個訓練周期的迭代,使用隨機梯度下降法對模型進行優化,初始學習率設置為0.01,在第44和第60個訓練周期時將學習率縮放為原來的1/10。實驗運行使用的顯卡為4塊GeForce GTX 1080 Ti。模型訓練的損失曲線如圖5所示。可以看出,當迭代輪次為70 000時,損失值趨于穩定收斂。

4.2測試結果分析

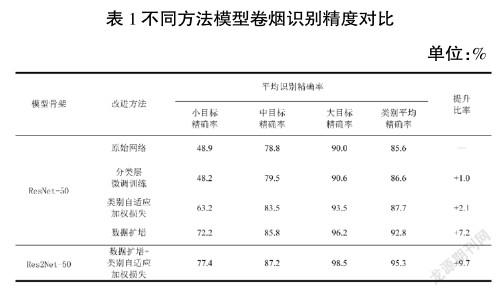

選取原始Faster-RCNN模型作為基準進行對比測試,結果如表1所示。由表1可以看出,在相同的模型骨架和不使用數據擴增的情況下,相對比基準網絡與分類層微調訓練的方法,加入類別自適應加權損失后,模型取得了最優的效果,可以在原始模型上提高平均識別精確率2.1個百分點。而使用數據擴增后數據集進行訓練的方式可以使模型性能進一步提升,相對于原始數據訓練,取得了7.2個百分點的提升。最終,加入替換模型骨架為具有更強特征提取能力的Res2net網絡結構,綜合使用數據擴增和類別自適應加權損失取得了最優效果,可以在200余類卷煙種類下,達到95%的模型識別精度,同時具有較強的泛化性,可以應對密集場景和旋轉、顛倒圖像的卷煙識別。