群體行為識別深度學習方法研究綜述

裴利沈,趙雪專

1.河南財經政法大學 計算機與信息工程學院,鄭州450046

2.鄭州航空工業管理學院 智能工程學院,鄭州450046

群體行為的識別與理解是計算機視覺領域的熱點問題,它是一個多學科交叉融合的研究方向,涉及了模式識別、人工智能、機器學習、計算機視覺等眾多學科的研究技術。該方向是國家自然科學基金委員會設立的重大研究計劃“視聽覺信息的認知計算”的重要研究內容,是“國家中長期科學和技術發展規劃綱要”中前沿技術類智能感知技術方向的重點研究對象。

群體行為識別的研究不僅具有重要的理論價值及科學意義,在公共安全保障方面,亦具有非常重要的應用價值。隨著城市化建設的大舉推進,城市人口急劇增加,國際恐怖主義日益猖獗,社會公共場所中因群體行為異常引發的擁堵及踩踏事件頻頻發生,造成了社會財產的巨大損失,對公共安全產生了巨大損害。對人群行為實時分析,及時發現異常行為能夠有效地阻止事態的惡化,甚至避免安全事故的發生。中國工業和信息化部在“中華人民共和國國民經濟和社會發展第十三個五年規劃綱要”中亦提出健全公共安全體系,為實現應對重大公共風險從被動應付型向主動防范型的重大轉變、從傳統經驗型向現代高科技型的戰略轉變提供了支撐。

目前,群體行為識別技術廣泛應用于智能監控、基于內容的視頻檢索、視頻自動分析與標注、運動分析等應用領域,對交通、公安刑偵等眾多行業也都有積極的推動作用。對視頻中的群體行為進行分析識別是一項非常重要且意義重大的科學任務。

長期以來,科研人員對群體行為識別進行了各種各樣的探索。群體行為是人與人、人與物及人與環境交互的集合,具有多元性、動態性和集體性等多重特征。鑒于這些特征,群體行為的分析識別涉及到了場景分割、目標檢測、目標跟蹤、個體行為識別等眾多視覺處理技術。此外,由于群體行為識別對圖像序列進行分析,該問題從時間域與空間域對信息進行處理。這導致了群體行為識別存在算法復雜度高、處理的數據規模大等問題。這為科研工作者嘗試新思路、研究新技術解決時序問題提供了更為開闊的空間。

隨著技術的發展及對該問題認識的不斷深入,群體行為識別算法層出不窮。根據群體行為識別算法的建模模型,現有方法大致可以分為兩大類,即基于傳統的概率統計模型的方法和基于深度網絡模型的方法。傳統的概率統計模型主要有概率圖模型(graphical models)和語法模型(grammar models)等。深度網絡模型則主要包括了卷積神經網絡模型(convolutional neural network,CNN)、雙流網絡模型(two stream network)、長短時記憶神經網絡(long short-term memory,LSTM)模型等。這些模型涵蓋了視覺處理技術從傳統機器學習向深度神經網絡學習演化的過程中各種主流的群體行為識別方法。這些模型各有其特色,亦衍生出了這些模型之間的交叉融合。下面主要對基于深度學習的群體行為識別方法進行分析介紹。

目前,大部分群體行為識別的研究都采用了深度神經網絡模型,亦或在深度網絡架構下結合語法模型或圖模型的方法。鑒于群體行為識別的這種研究現狀,首先給出了群體行為識別問題的定義描述,介紹了群體行為識別通用的識別流程;然后,概括總結了群體行為識別所面臨的主要挑戰;繼而,重點歸類梳理了在深度學習架構下,群體行為識別常用的主流的深度網絡模型,對其進行了對比和討論;最后,對常用的公共的群體行為數據庫進行了介紹和對比之后,總結展望了未來可以探索的研究方向和研究思路。

1 群體行為識別問題定義

Moeslund 等人和Poppe將人體行為分為了3個層次,即基本動作Action Primitive、行為Action 與活動Activity。Turaga 等人指出,行為Action 是由一個人執行的持續一段時間的簡單的運動模式,活動Activity 是由多人在某種環境或條件限制下執行的可以交互的復雜的行為Action 序列。新華字典定義群體行為是團體行為的一種特殊形式,由兩個或更多的個體為了實現某個特定的目標,而形成的相互影響、相互作用、相互依賴的人群集合體。后續介紹中,活動Activity 特指群體行為。

隨著目標檢測、跟蹤等計算機視覺相關技術的發展,群體行為識別得到了進一步的深化。大量的群體行為識別方法,除了對群體行為類別的識別,還涵蓋了一些對群體行為識別有輔助作用的相關任務去識別群體行為,如人體檢測、跟蹤等。目前,對群體行為的識別與理解包含了對參與個體的檢測、個體級別的行為識別與場景級別的行為識別。該類群體行為的識別可以定義為,對于給定的視頻序列={,,…,x,…,x},經過一系列的檢測分類等技術的處理,獲得了參與群體行為的各人體所在位置的矩形區域[,;,],及主要的參與人體的個體行為類別a∈和群體行為類別A∈。其中指群體行為中涉及到的個體行為類別的集合,是群體行為類別的集合。

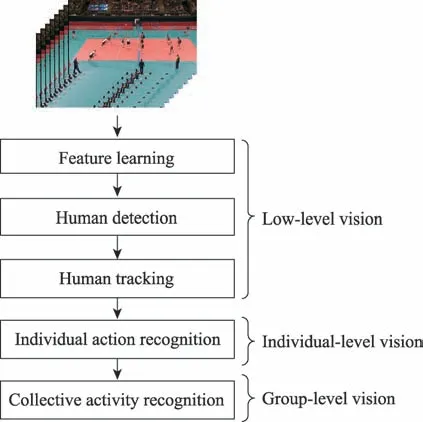

調研發現,目前基于深度學習的群體行為識別算法大都經歷了3 個階段的處理分析。如圖1 所示,首先通過各種網絡架構進行特征學習和提取,對群體行為場景中的人體進行檢測;然后,基于檢測到的人體,采用多目標跟蹤技術對人體進行跟蹤處理,并利用獲得的人體跟蹤序列,對其進行個體行為表征,并識別其行為;在識別了各群體行為的參與者的個體行為類別以后,結合群體行為所處的場景信息及人體與人體、人體與場景的交互信息對群體行為進行識別。在該通用群體行為識別流程框架中,人體檢測與跟蹤在群體行為識別中屬于低級的信息處理,個體行為識別屬于中級的信息處理,群體行為識別屬于高級的信息處理。

圖1 群體行為深度識別流程Fig.1 Workflow of deep recognition of collective activity

2 挑戰

群體行為識別,作為計算機視覺領域一個比較高層級的語義分析問題,它除了要面對人體檢測、多人體跟蹤、個體行為識別等所面臨的挑戰,還要解決該問題本身所涉及的眾多挑戰。群體行為涉及到了稀疏至高密度場景等各種情景下的人與人、人與活動場景的交互,群體活動場景相對來說比較復雜,比較容易受到群體行為活動以外事物的影響,例如經過的汽車的遮擋、建筑物上動態廣告屏的干擾等。本文總結了群體行為識別所面臨的一些主要挑戰。

(1)群體行為所處環境異常混亂,或存在較為嚴重的遮擋問題。

(2)群體行為視頻為手持設備所拍攝,且存在較為嚴重的抖動及頻繁的畫面切換。

(3)群體行為由于個體行為習慣問題存在較大的類內差異及類間相似性。

(4)群體行為的精確定位識別任務,涉及到人體檢測、人體跟蹤、個體行為識別等眾多視覺問題,由于對象為三維視頻數據,識別任務復雜度高、計算工作量大。

(5)現有的群體行為識別數據庫還沒有形成體系規模,行為種類紛繁雜亂,行為類別定義及標簽信息的標注沒有統一的規范,限制了相關研究工作的開展。

3 基于深度架構的群體行為識別模型

近年來,深度網絡模型在圖像處理領域快速發展,科研工作者基于深度架構模型對群體行為識別進行了大量的探索,并獲得了顯著的識別效果。按照使用的深度神經網絡的架構的不同,現有的群體行為識別方法大致可以分為四類,即基于卷積神經網絡(CNN)的識別模型、基于雙流網絡的算法模型、基于循環神經網絡(RNN)或長短時記憶神經網絡(LSTM)從時序角度對群體行為進行處理的識別模型和基于Transformer從時序角度對群體行為識別的算法模型。各模型的大部分算法直接從RGB 視頻序列中學習行為特征,亦有部分算法基于骨架序列信息對行為進行表征。下面從網絡架構、算法模型的優缺點、實驗效果等方面對這些算法模型展開論述。

3.1 基于CNN/3DCNN 的群體行為識別模型

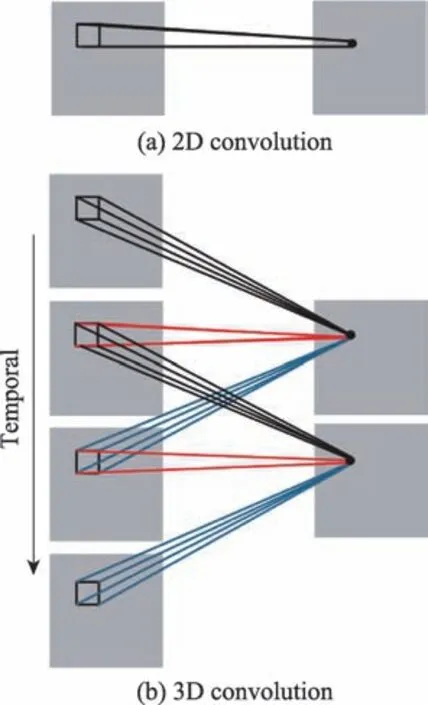

卷積神經網絡由于其在空間域優越的特征表征能力,在圖像的分類、檢測與分割等任務中取得了顯著的效果。Ji等人克服了其不能利用時序特征的缺陷,將其從2D 卷積擴展為3D 卷積,讓其能夠從時空兩個維度對三維的行為視頻數據進行處理。如圖2所示,展示了2D 卷積模型與3D 模型的對比,圖2(b)中卷積核的時間維度為3,共享權重采用了相同顏色的連接線標示。從該圖中可以發現,3D 卷積模型不僅能夠提取空間域的信息,亦能夠捕捉到連續的視頻幀中的時序運動信息,它更適用于行為識別等時序問題。基于CNN/3DCNN 網絡,產生了一系列群體行為識別網絡架構,如C3D(convolutional three dimensional)模 型、GCN(graph convolutional network)模型、HRN(hierarchical relational networks)模型、CRM(convolutional relational machine)模型等。

圖2 2D 卷積與3D 卷積的對比Fig.2 Comparison of 2D and 3D convolutions

繼3D 卷積模型之后,Tran 等人提出了C3D 模型,他們通過實驗驗證了3D 卷積深度網絡模型學習提取的時空特征具有非常好的識別效果;并通過在一系列網絡架構上的實驗,經驗性地發現利用3×3×3的卷積核提取的特征識別效果最好;此外,C3D 架構僅僅使用簡單的線性模型就能在眾多公用數據庫上取得優越的識別效果;最終得出了3D 卷積神經網絡具有通用、緊湊、易于實現和高效等特點的結論。3D卷積網絡利用三維卷積核提取時空特征,在一定程度上降低了混亂環境中遮擋問題對行為識別的影響。此后,3DCNN 以其優異的時空特征提取性能被廣泛應用于行為識別中。

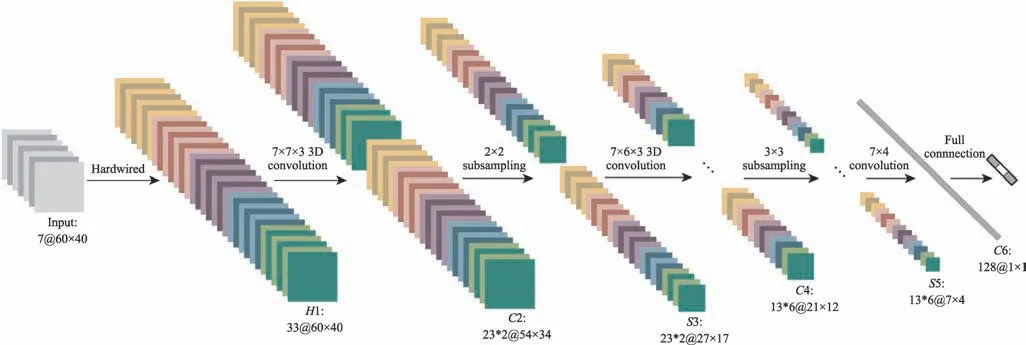

目前許多群體行為識別算法涉及了對個體行為的識別和對群體行為的識別,許多深度模型會先用CNN 對行為人體進行特征表征,然后利用圖模型或時序處理網絡對人體行為或群體行為進行推理識別。早期,用于群體行為識別的3DCNN 架構大多采用類似于圖3 所示架構僅對群體行為進行分類識別。隨著深度神經網絡架構的發展及對群體行為分析識別的深入,后續產生了許多基于CNN 網絡結合其他網絡架構對群體行為進行深度分析的算法。

圖3 行為識別的3DCNN 架構Fig.3 3DCNN architecture for activity recognition

Ibrahim 等人利用CNN 對視頻幀中的行為人體進行特征表征,然后基于人體序列的特征向量采用兩層LSTM 網絡對群體行為中的個體行為和群體行為進行識別。Bagautdinov 等人利用全卷積網絡FCN 對視頻序列進行表征,并對群體行為中的多個人體目標同時進行檢測,繼而使用RNN 進行時序處理,對個體行為和群體行為進行識別。

Wu 等人提出了圖卷積網絡(GCN)模型,該方法利用CNN 對邊界框標定的actor 進行特征表征,然后利用多個Actor Relation Graphs 來捕捉actor 之間的關系信息,繼而通過GCN 對個體行為和群體行為進行識別。受該工作啟發,Gavrilyuk 等人亦利用2D 姿態網絡和3DCNN 對群體行為中的個體進行actor 層級的特征表征,然后基于自注意力機制選擇性地突出actor 和群體行為之間的關系,對群體行為進行識別。

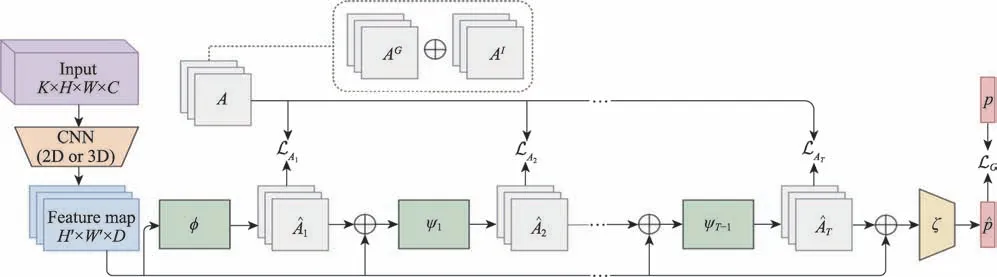

Ibrahim 等人提出了HRN(hierarchical relational networks)群體行為識別模型,該方法利用CNN 對群體行為中的個體進行初始表征,然后通過多個關系層網絡來學習個體行為的關系圖,以識別群體行為。受其啟發,Azar等人提出了CRM模型,利用2DCNN或3DCNN 從視頻幀序列中計算的特征圖來學習人體活動圖和群體活動圖,用其表示人體行為的空間關系,然后整合卷積特征圖和優化的活動圖對群體行為的類別進行識別預測,其網絡架構如圖4 所示。該方法通過實驗證實,利用卷積網絡去學習高層的關系特征非常困難,提出了利用活動圖來表征群體中各行為個體之間關系的方法,并在Vollyball 和Collective Activity 數據庫上獲得了93.04%和85.75%的平均識別率。

圖4 群體行為識別的CRM 架構Fig.4 CRM architecture for group activity recognition

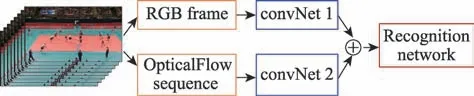

3.2 基于雙流網絡的群體行為識別模型

基于雙流網絡Two-Stream Network 的行為識別網絡模型一般都采用如圖5 所示的網絡結構,分別利用空間流網絡和時間流網絡對行為視頻空間域的靜態信息與時間域的動態信息進行提取,并利用信息融合的方法進行特征表征,然后利用分類識別網絡對行為的這些特征表征進行分類識別。時間流網絡一般對視頻的光流數據進行處理,在一定程度上降低了手持設備拍攝數據的抖動問題對行為識別的影響。伴隨著群體行為分析識別的深化及識別粒度的細化,群體行為的分析識別在該架構的基礎上結合了個體級別、群體級別或場景級別的分析。有些算法則直接利用雙流網絡或多流網絡對群體行為或群體中的個體行為進行特征表征,然后對提取的特征進行分析識別。

圖5 雙流網絡架構Fig.5 Two-stream network architecture

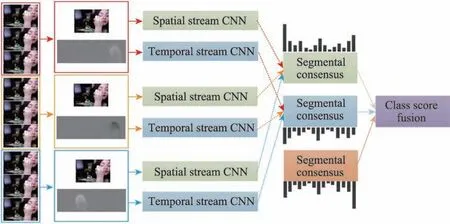

Li等人利用雙流網絡架構提取的特征,提出了基于特征融合的時序分割網絡模型。該模型針對主流網絡輸入數據為RGB 圖像和光流圖像的局限,結合了低層細節信息和深度網絡學習的高層語義信息對行為進行識別,該方法可用于對群體行為進行分類識別。時序分割網絡結構如圖6 所示。

圖6 時序分割網絡結構Fig.6 Temporal segment network

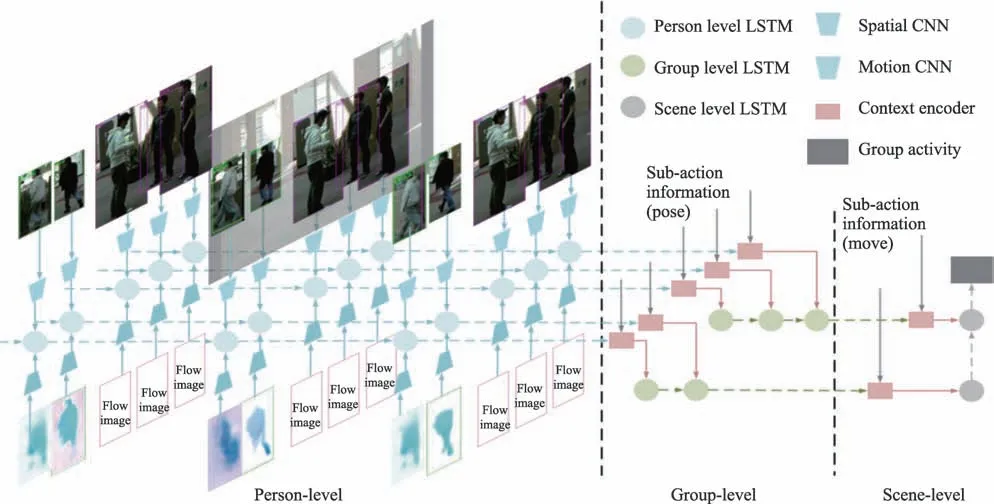

Wang 等人基于雙流網絡進行特征提取,提出了一種基于交互上下文編碼的層級性的群體行為識別方法。該方法基于跟蹤獲取的群體行為中的個體跟蹤序列,利用AlexNet網絡從對應的RGB 視頻幀中提取空間特征,利用GoogleNet從相應的光流圖像序列中提取運動特征,然后利用二者對人體上下文信息進行編碼,進行個體級別的行為識別,最后結合提取的空間域特征、時間域特征和人體上下文特征編碼對群體行為進行識別。該模型的網絡架構如圖7 所示。該方法利用對雙流網絡提取的特征以再編碼的方式,對群體行為進行了多級分析,在The Collective Activity Dataset上進行了實驗驗證,獲得了89.4%的平均識別率。

圖7 基于交互上下文編碼的層級性的循環網絡架構Fig.7 Hierarchical recurrent interactional context encoding framework

Zalluhoglu 等人考慮到群體行為中涉及到眾多行為個體及其行為,且人體活動區域內的場景信息對群體行為識別具有重要意義,擴展了雙流網絡,引入了空間區域流網絡sRCNN 和時間區域流網絡tRCNN。該群體行為識別模型被稱為基于區域的多流網絡架構。該方法不僅對群體行為進行了分類識別,還對群體行為中活動個體所在的區域進行了檢測,在The Volleyball Dataset 和The Collective Activity Dataset上進行了實驗驗證,分別獲得了72.4%和88.9%的識別率。

3.3 基于RNN/LSTM 的群體行為識別模型

RNN和LSTM首先在自然語言處理、語音識別等時序數據處理方面獲得了巨大的成功。基于其優秀的信息學習表征能力和對數據時序關系的強大建模能力,二者在圖像標題生成方面和行為識別方面取得了巨大進展,尤其在對變長的行為視頻的處理方面體現了其優越的性能。大部分基于RNN 或LSTM 的群體行為識別算法,大都采用如圖8所示的流程。

圖8 行為識別循環網絡架構Fig.8 Recurrent neural network architecture of action recognition

Ramanathan 等人基于注意力機制利用RNN 來學習隨時間變化的注意力權重,對行為個體的運動信息以跟蹤特征的方式進行表征,實現了對群體行為的檢測和識別。Shu 等人擴展了該工作,在循環網絡的基礎上增加了能量層來獲取更可靠的區域來實現群體行為識別。Qi 等人為了利用群體行為場景中的各行為個體間的空間關系,提出了注意力語義RNN 來識別群體行為。

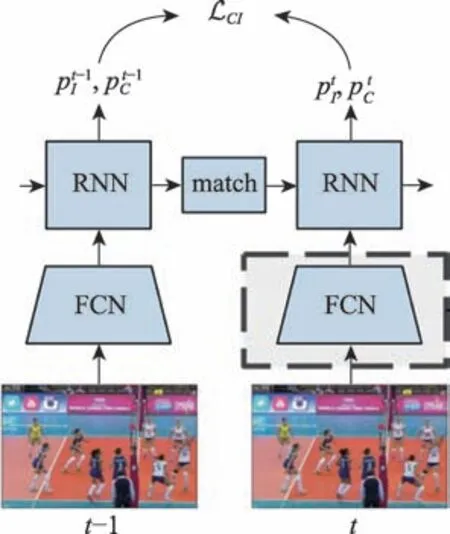

Deng 等人利用RNN 來學習群體行為中眾多活動個體和環境之間的豐富的語義關系信息,結合圖模型推理對群體行為進行識別,該方法利用環境信息識別群體行為,一定程度上降低了個體行為習慣對行為識別的影響。Bagautdinov 等人則利用RNN來實現群體行為中多行為個體的時序一致性匹配問題,然后基于匹配的結果利用深度網絡提取的特征對個體行為和群體行為進行分類識別,其網絡架構如圖9 所示。

圖9 基于時序一致性檢測的群體行為識別框架Fig.9 Collective activity recognition framework based on temporal consistency detection

相比于RNN,由于LSTM 更易于處理需要深度表征的時序問題,LSTM 在群體行為識別領域得到了更為廣泛的應用。Ibrahim 等人認為,群體行為時序動態特征可以從群體中個體行為的動態特征中推理出來,他們利用LSTM 模型的堆疊提出了包含兩個層次的深度時序模型。第一層LSTM 用來學習表征各個體行為的動態時序特征,第二層LSTM 整合這些特征對群體行為進行表征,最后利用Softmax 分類層對群體行為進行識別。

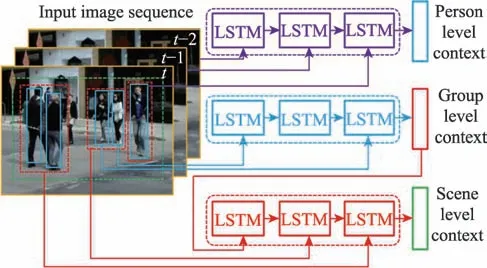

Wang 等人利用LSTM 建模了高階的交互上下文信息,該模型框架如圖10 所示。該模型利用多級LSTM 分別對行為個體的動態信息、行為群體內部的交互信息和行為群體之間的交互信息進行建模表征,產生了對群體行為識別更有區分性的高階交互特征。該模型可以靈活地解決場景中有不同數目的行為群體,和群體中有不同數目的行為個體的群體行為的識別問題。而且,該模型對高階上下文建模問題極易進行線性擴展。該算法利用高階特征對行為進行識別,能夠有效降低環境嘈雜、遮擋等因素對行為效果的影響。

圖10 交互上下文的層級性循環建模模型架構Fig.10 Hierarchical recurrent interactional context modeling framework

3.4 基于Transformer 的群體行為識別模型

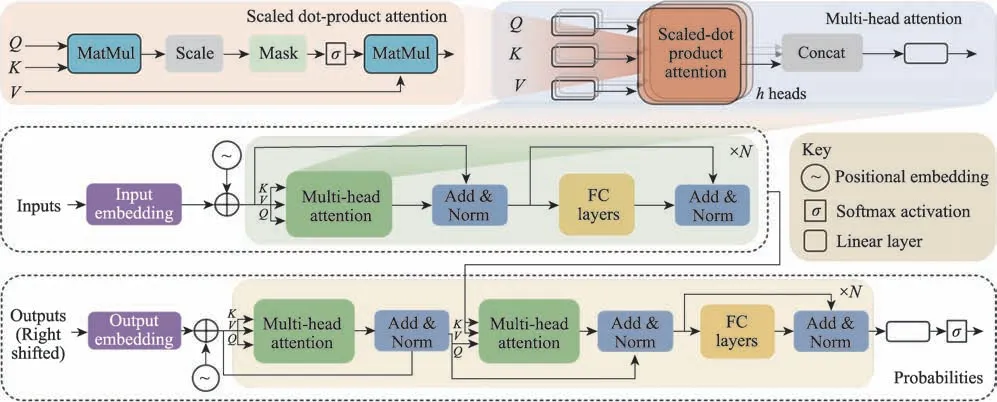

在Transformer 架構出現以前,對時序數據的處理主要依賴于以循環神經網絡為基礎的網絡模型。自2017 年谷歌提出Transformer以后,它迅速成為自然語言處理領域的主流模型,并應用于其他領域。Transformer 模型的網絡架構如圖11 所示,該模型利用自注意力機制和位置編碼對序列信息進行處理。2020 年谷歌提出了Vision Transformer,該模型可以不需要卷積,直接利用Transformer 對圖像塊序列進行分類,且取得了與當前最優的卷積網絡相媲美的結果,但其訓練所需的計算資源大大減少,一定程度上解決了群體行為識別任務復雜度高、計算工作量大的挑戰。

圖11 Transformer 模型架構Fig.11 Architecture of Transformer model

近來出現了大量將Transformer 應用于計算機視覺領域的研究。有部分工作將Transformer 用于行為識別。相比于以串行方式按時間順序對數據進行處理的RNN、LSTM 等循環神經網絡,Transformer 架構的最大特點在于它依賴于自注意力機制的并行化處理能力。Transformer 模型可以在同一時間對所有的特征進行分析,而無須考慮特征序列的先后次序。這種并行處理機制大大加快了其訓練速度,從而使其能夠在更大的數據集上進行訓練。

基于迅速發展的Vision Transformer模型,Neimark等人提出了Video Transformer 網絡模型,該模型擯棄了一般的行為識別所依賴的3D 卷積網絡,介紹了一種基于注意力機制編碼和位置編碼,對視頻行為進行端對端的識別方法。該工作通過實驗統計發現,在保證獲得與現有最先進的算法同等的識別效果的情況下,該模型的訓練速度要快16.1 倍,其推理識別速度快5.1 倍,其時間性能明顯優于其他算法。

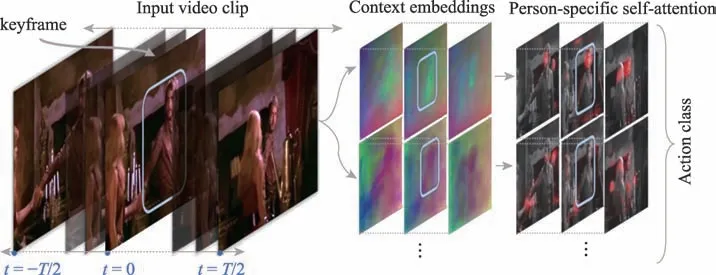

Girdhar 等人提出了Action Transformer 網絡模型,該模型利用Transformer 類的架構從行為主體的時空上下文中去整合學習特征對行為進行識別。該模型的行為識別流程如圖12 所示。該模型能夠同時對行為個體進行跟蹤,從場景中其他人的行為中提取語義上下文信息。其實驗證明,該方法獲得了明顯優于其他主流方法的識別效果。

圖12 行為識別的Action Transformer 模型Fig.12 Action Transformer in action recognition

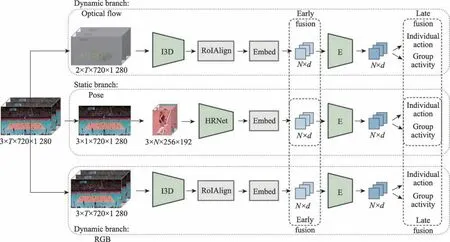

近來,Gavrilyuk 等人提出了用于群體行為識別的Actor Transformers 模型,該模型能夠學習并選擇性地提取與群體行為識別相關的有效信息,對群體活動中的個體行為和群體行為進行識別。該模型架構如圖13 所示,從圖中可以看出,該模型采用了與基于卷積神經網絡的I3D 相結合的方法進行群體行為識別,沒有發揮Transformer 模型不必借助卷積即可進行分類識別的特性,Transformer 在群體行為識別中的應用有待進一步發展。該算法在The Volleyball Dataset 和The Collective Activity Dataset 上分別獲得了94.4%和92.8%的平均識別率,實驗證明Actor Transformer 相比其他方法獲得了比較好的識別效果。

圖13 群體行為識別中的Actor Transformers網絡架構Fig.13 Actor Transformers architecture in group activity recognition

3.5 算法對比分析

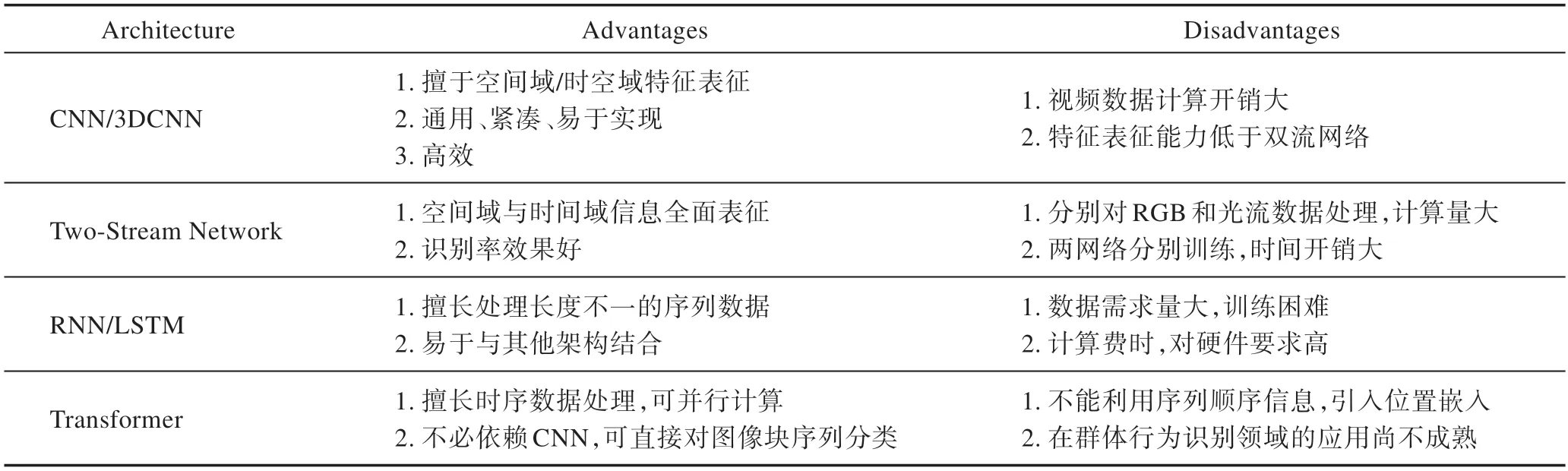

通過前面對深度學習架構在群體行為識別中的應用模型的介紹發現,群體行為識別算法大多融合了多個網絡架構,去解決涉及到的活動個體檢測、個體行為識別、群體行為識別等多項任務的群體行為識別。所列舉算法都適用于現實中非密集的群體行為識別場景。通過對上述四類神經網絡架構模型涉及到的群體行為識別算法的分析,總結了各網絡架構的優缺點,如表1 所示。

如表1 所示,CNN/3DCNN 和Two-Stream Network網絡架構擅長對低級底層特征進行表征。相對而言,CNN/3DCNN 網絡架構更為通用、緊湊、易于實現,而雙流網絡從時間域與空間域對信息進行全面表征,其特征的識別效果更好一些。3DCNN 和雙流網絡都能夠對數據進行時空特征的表征,相比于CNN,3DCNN 用于視頻數據的處理,其計算開銷比較大,而雙流網絡要分別對RGB 視頻序列和光流數據分別進行處理,并分別訓練兩個網絡,計算開銷則更大。

如表1 所示,RNN/LSTM 和Transformer 網絡架構擅長對時序數據的識別處理。RNN/LSTM 對時序數據采用串行的處理方式,網絡架構訓練較為困難,對訓練數據的需求量比較大,對硬件要求也比較高。Transformer 采用并行計算的方式,能有效降低計算時間,然而該架構不能利用序列數據中的順序信息,需要引入位置編碼信息。目前,Transformer 在群體行為識別領域的應用較少,技術尚不成熟,有較大的發展空間。

表1 深度學習架構比較Table 1 Comparison of deep learning architectures

卷積網絡和雙流網絡的特征表征能力比較強大,然而其計算復雜度限制了其在視頻處理領域的發展,而Transformer 可以在不進行卷積處理的情況下,直接對時序數據進行分析識別,該特性將促進Transformer在群體行為識別領域的發展。

為了對深度網絡架構下典型的群體行為識別算法進行比較,將各算法所依賴的神經網絡架構及其在兩公共數據集上的平均識別率展示于表2 中。從表中可以發現,幾乎現有的算法都依賴于卷積神經網絡類的網絡架構對群體行為進行特征表征,大部分算法都采用了時序處理網絡RNN、LSTM 等架構進行后續處理。雖然這些算法都采用卷積網絡進行特征表征,但卷積網絡架構的差異以及對特征進行處理分類的網絡模型的不同,造成了這些算法在識別效果上具有很大的差異。

大部分經典的群體行為識別算法都在公共數據集The Volleyball Dataset 和The Collective Activity Dataset 上進行了實驗驗證。為了客觀地對各算法的識別效果進行對比,在表2 中展示了各算法在兩個公共數據庫The Volleyball Dataset 和The Collective Activity Dataset 上的平均識別率。通過對比可以發現,識別率比較高的算法都采用了卷積的方式進行特征表征,LSTM 也展現了其對時序數據進行處理的優越性。識別效果比較突出的是Gavrilyuk 等人提出的Actor Transformers網絡模型。目前,采用Transformer 進行群體行為識別的算法比較少,作為一個擅長對時序數據進行處理的網絡架構,Transformer 模型在群體行為識別中具有較大的潛力。

表2 各算法平均識別率的比較Table 2 Average recognition accuracy comparison of algorithms

4 常用公共數據集

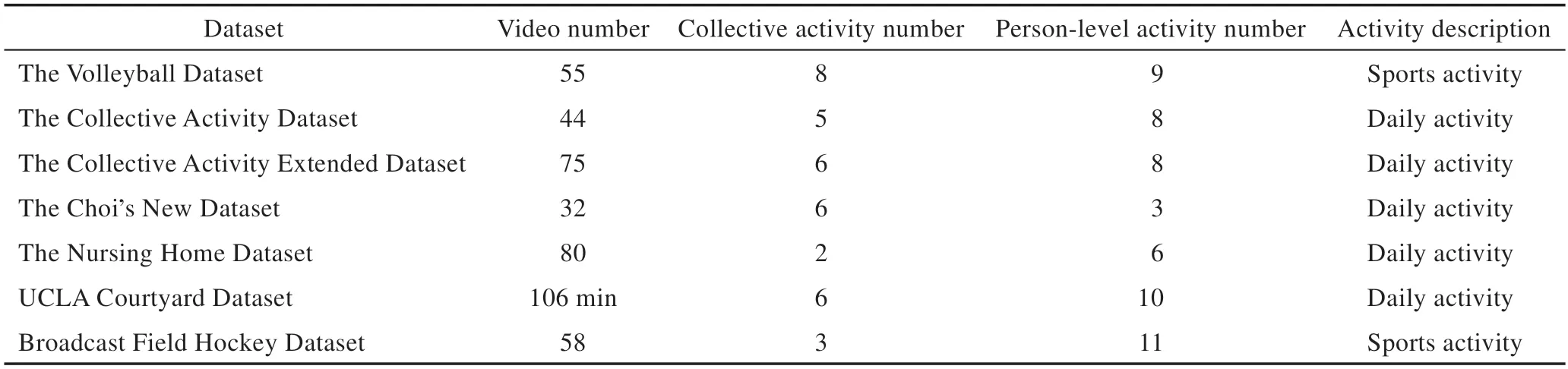

對群體行為的深度分析識別涉及到了多級標簽,群體行為數據庫的建立需要消耗大量的人力、物力。目前最常用的群體行為數據庫為The Volleyball Dataset和The Collective Activity Dataset。下面對這兩個最常用的數據庫和The Collective Activity Extended Dataset、The Choi's New Dataset、The Nursing Home Dataset、UCLA Courtyard Dataset及Broadcast Field Hockey Dataset進行了介紹,并簡要地進行了對比說明。

The Volleyball Dataset是一個大規模的群體行為識別數據集,該數據集包含了多層次的樣本標簽。該數據庫包含了55 個排球視頻,其中有4 830 個標注好的視頻幀。標注信息包含3 種類型的標簽。對每一個足球運動員,該數據庫通過一個矩形框標注了其位置標簽信息,并給其分配了一個個體行為類別標簽,該數據庫共涉及到9 種個體行為類別,分別為spiking、blocking、setting、jumping、digging、standing、falling、waiting 和moving。對每個視頻中的整個排球活動場景,亦給其分配了群體活動類別標簽,共涉及到8 種群體活動類別,分別為left pass、right pass、left set、right set、left spike、right spike、left winpoint、right winpoint。

The Collective Activity Dataset是一個被廣泛應用的群體行為識別數據庫。該數據庫共包含44 個視頻序列,其中有些視頻是通過手持數字信息采集設備在動態視角下拍攝的。該數據庫共包含5 種集體行為類別,并標定了8 種個體級別的人體姿態標簽。5 種集體行為是crossing、waiting、queuing、walking 和talking。8種姿態標簽為Right、Front-right、Front、Frontleft、Left、Back-left、Back 和Back-right。每個視頻每隔10 幀標注了集體行為類別、人體姿態類別和人體邊界框信息。

The Collective Activity Extended Dataset包含了75 個行為視頻,它擴展了The Collective Activity Dataset,在原數據庫的基礎上增加了dancing 和jogging 兩個群體行為類別,并將原來的群體行為類別walking改為了個體行為。該數據庫共包含6 類群體行為和8類個體行為。

The Choi's New Dataset由32 個視頻序列組成,共包含6 種集體行為、9 種交互行為、3 種基本動作和8 種人體姿態。6 種集體行為類別分別為gathering、talking、dismissal、walking together、chasing 和queueing。3 種基本動作類別為walking、standing still 和running。

The Nursing Home Dataset拍攝于養老院,由80個視頻序列組成,包含了兩大類具有極大類內差異的群體行為fall與non-fall和6 種基本行為。6 種基本行為是walking、standing、sitting、bending、squatting 和falling。

UCLA Courtyard Dataset以鳥瞰的角度拍攝于加州大學洛杉磯分校的校園里,包含了106 min 的高分辨率的視頻,共涉及到6 種群體行為和10 類個體行為。群體行為分別為Walking-together、Standingin-line、Discussing-in-group、Sitting-together、Waitingin-group、Guided-tour。

Broadcast Field Hockey Dataset包含了58個視頻序列,涉及到了3 類場景級別的行為attack play、free hit 和penalty corner和11種個體行為類別,即pass、dribble、shot、receive、tackle、prepare、stand、jog、run、walk 和save。為了探索社會角色對群體行為的影響,該數據還定義了5 種社會角色。

通過對各數據庫的介紹可以發現,這些公用數據庫都包含了多層級的樣本標簽,除了群體行為的類別標簽以外,還標注了個體行為的類別,甚至于人體所在的位置信息,各數據庫的視頻數目、各級行為類別的數目如表3 所示。The Volleyball Dataset 創建的時間比較晚,標注信息比較全面,涉及了排球運動的8 種群體行為,識別難度較大,目前應用最為廣泛。該數據庫和The Collective Activity Dataset 不僅包含了群體、個體行為類別的標注,還標注了人體的邊界框信息,大量算法在該群體運動行為庫和日常行為庫上進行了測試。

表3 公共數據集描述Table 3 Public dataset description

The Collective Activity Extended Dataset 對The Collective Activity Dataset 進行了擴展,The Choi's New Dataset 為Choi所在團隊繼上述兩個數據庫之后提出的新的日常行為數據庫。這些數據庫拍攝于真實場景,存在各種干擾,在行為識別處理具有一定的難度,應用的廣泛程度略遜于The Volleyball Dataset 和The Collective Activity Dataset。The Nursing Home Dataset 只涉及了兩類群體行為的鑒別,它與UCLA Courtyard、Broadcast Field Hockey 數據庫標注信息相對較少,分別是養老院、校園和運動場景,其應用比較少。

表4 展示了各數據庫的發布時間及其獲得的最好的識別效果。由于The Volleyball Dataset 標注的信息較為詳細,The Collective Activity Dataset 發布的時間比較早,標注信息也較為詳備,且二者在數據量方面都具有一定的規模,目前這兩個數據庫得到了廣泛的應用,以驗證群體行為識別算法的效果。

表4 群體行為分析識別數據集Table 4 Datasets of collective activity analysis and recognition

5 總結與展望

本文對目前主流的基于深度學習的群體行為分析識別算法進行了歸類與梳理,將其分為了四種類型,通過對各類的對比分析,得出了如下結論。目前,大部分算法都基于卷積神經網絡對群體行為或活動場景進行描述;部分算法在卷積神經網絡的基礎上,引入了光流神經網絡對群體行為中的運動信息進行學習。這些方法在特征刻畫方面都取得了非常好的效果。群體行為識別是一個可變長度的時序數據分析問題,大部分算法都采用循環神經網絡RNN 和長短時記憶神經網絡LSTM 群體行為進行分析識別。

近來,科研人員對群體行為多層級的分析識別問題的研究取得了一定的進展。結合現存問題及新技術的不斷涌現,未來群體行為分析識別問題可能會在以下幾方面獲得進一步的發展:

(1)大規模通用數據庫

目前,存在大量的群體行為識別數據庫,但這些數據庫大都屬于某一類特定場景,群體行為的組成比較簡單,僅限于幾類相關的行為。行為識別領域缺乏大規模的、具有統一規范標準的、多實際應用場景的、行為類別及組成標注更為詳細豐富的通用數據庫。鑒于群體行為視頻數據量比較大,信息比較豐富,群體行為本身亦涉及到目標檢測、目標跟蹤、場景識別、個體行為識別等多個計算機視覺問題,信息標注涉及大量的人力、物力資源,大規模通用數據庫的創建將需要眾多科研團隊的協作。

(2)多模態特征的提取問題

大部分群體行為識別算法僅通過RGB 或光流序列數據對行為進行識別,這限制了行為識別精度的提升。伴隨著深度學習網絡架構的大力發展,語音識別得到了長足發展。由于人工智能物聯網硬件的快速發展,深度視覺信息及其他傳感信息的采集變得更為低廉。此外,深度神經網絡的發展,給多模態多特征信息的融合提供了有利的支撐。未來視頻、音頻及其他傳感信息等多模態特征的提取和融合將獲得一定的發展。

(3)Transformer模型的應用

Transformer 模型是繼LSTM 以后出現的解決時序問題的網絡模型,該模型引入了Attention 和Positional Encoding 機制,在翻譯任務、語音識別等方面取得了比較好的效果。此外,該模型并行能力強,相比于RNN、LSTM 等模型,計算速度快。行為識別作為時序問題,可以使用Transformer 模型來解決,目前已存在少量利用該模型識別行為的算法,但Transformer 在行為識別問題中的應用,應該得到進一步的發展。